Dentro da Mente do Llama 3.3 70B Versatile 128k como um Agente de IA

Explore as capacidades avançadas do Llama 3.3 70B Versatile 128k como um Agente de IA. Esta análise aprofundada examina suas habilidades de raciocínio, resoluçã...

Automação de IA

Explore como o Jamba 3B, da AI21, combina atenção de transformadores com modelos de espaço de estados para alcançar eficiência sem precedentes e capacidades de contexto longo em dispositivos de borda, remodelando o futuro dos grandes modelos de linguagem.

O cenário dos grandes modelos de linguagem passou por uma transformação dramática nos últimos anos, com pesquisadores e empresas buscando constantemente maneiras de melhorar a eficiência sem sacrificar o desempenho. A introdução do Jamba 3B pela AI21 representa um marco significativo nessa evolução—um modelo híbrido que combina as forças dos mecanismos de atenção de transformers com modelos de espaço de estados para alcançar ganhos de eficiência sem precedentes. Esse avanço chega em um momento crítico, quando as demandas computacionais para treinar e implantar grandes modelos de linguagem se tornaram um importante gargalo para organizações em todo o mundo. Neste guia abrangente, vamos explorar as inovações técnicas por trás do Jamba 3B, entender por que as arquiteturas híbridas representam o futuro dos modelos de linguagem e examinar como essa abordagem está remodelando as possibilidades de deployment de IA em ambientes computacionais diversos.

A AI21 foi fundada há mais de sete anos por Ori Levy, Yoav Shoham e Amnon Shashua com um princípio visionário que guiaria todo o seu trabalho subsequente: deep learning, apesar de incrivelmente poderoso e útil, não é suficiente por si só. A filosofia da empresa desde o início era unir a inteligência artificial clássica com abordagens modernas de deep learning, criando sistemas que pudessem aproveitar as forças de ambos os paradigmas. Essa missão se mostrou precisa, já que a empresa iniciou suas atividades pouco antes do lançamento do GPT-3, posicionando-se perfeitamente para observar e participar das mudanças revolucionárias que redefiniriam toda a indústria de IA. Desde seus primeiros dias em 2018, a AI21 comprometeu-se a treinar modelos mantendo um foco duplo tanto no rigor científico quanto nas aplicações práticas. Essa abordagem equilibrada tornou-se uma característica marcante do trabalho da empresa, distinguindo-a de concorrentes que frequentemente priorizavam apenas a pesquisa pura ou a comercialização imediata.

Ao longo de sua história, a AI21 manteve esse compromisso de unir pesquisa de ponta com aplicações reais. A empresa desenvolveu o Wordtune, um aplicativo que trouxe tração de mercado valiosa e serviu como campo de testes para sua pesquisa em modelos de linguagem. Quando o GPT-3 surgiu, a AI21 respondeu treinando seu próprio modelo, o Jurassic-1, que alcançou métricas de desempenho comparáveis ou ligeiramente superiores à oferta da OpenAI. Esse sucesso inicial estabeleceu a AI21 como um player sério no espaço dos grandes modelos de linguagem, mas as ambições da empresa iam muito além de simplesmente igualar modelos existentes. A equipe reconheceu que o futuro da IA exigiria não apenas modelos maiores, mas arquiteturas mais inteligentes que pudessem entregar melhor desempenho com maior eficiência. Essa percepção levaria, eventualmente, ao desenvolvimento do Jamba, sua linha de modelos híbridos inovadores que desafiaram o senso comum sobre como modelos de linguagem devem ser construídos.

Modelos de linguagem híbridos representam uma ruptura fundamental com a arquitetura puramente transformer que dominou o campo desde o lançamento do GPT-2 e modelos subsequentes. Modelos tradicionais baseados em transformer dependem inteiramente de mecanismos de atenção, nos quais cada token em uma sequência pode prestar atenção a todos os outros tokens. Embora essa abordagem tenha se mostrado extremamente eficaz para compreensão e geração de linguagem, ela traz um custo computacional significativo: o mecanismo de atenção tem complexidade quadrática em relação ao comprimento da sequência, ou seja, dobrar a janela de contexto quadruplica os requisitos computacionais. Além disso, o cache de chave-valor exigido pela atenção cresce linearmente com o tamanho da sequência, criando gargalos de memória cada vez mais problemáticos à medida que as janelas de contexto se expandem. Essas limitações se tornaram restrições críticas para aplicações modernas, especialmente aquelas que exigem processamento de contexto longo, personalização, retenção de memória e raciocínio agente.

Modelos híbridos abordam essas limitações combinando atenção de transformer com modelos de espaço de estados, notadamente o Mamba, que oferece complexidade linear em relação ao comprimento da sequência. Em vez de substituir completamente a atenção—o que sacrificaria as capacidades de raciocínio que tornam os transformers tão eficazes—as arquiteturas híbridas utilizam a atenção de forma seletiva, tipicamente numa proporção de 1:8, onde apenas uma de cada oito camadas emprega atenção total enquanto as demais utilizam a abordagem mais eficiente de espaço de estados. Essa combinação estratégica preserva a capacidade do modelo de realizar tarefas complexas de raciocínio que requerem a consciência global de contexto proporcionada pela atenção, ao mesmo tempo em que reduz drasticamente os custos computacionais e as exigências de memória para a maior parte do processamento do modelo. O resultado é um modelo que mantém ou até mesmo melhora o desempenho na maioria dos benchmarks, consumindo significativamente menos recursos computacionais durante o treinamento e a inferência. Esse ganho de eficiência não é apenas uma melhoria marginal—representa uma mudança fundamental no que passa a ser possível para deployment de IA, permitindo que modelos rodem em dispositivos de borda, em ambientes com restrição de memória e em escalas antes consideradas impraticáveis.

O caminho até a arquitetura híbrida do Jamba não foi predeterminado, mas surgiu por meio de experimentação cuidadosa e disposição para explorar abordagens não convencionais. A equipe da AI21 estava inicialmente trabalhando no J3, a terceira versão da linha de modelos Jurassic, com planos de implementar uma arquitetura mixture-of-experts (MoE). A principal motivação para o MoE era simples: reduziria significativamente os custos de treinamento ao distribuir o processamento entre múltiplas redes especializadas, tornando o orçamento de treinamento mais viável. No entanto, a equipe também queria garantir que seu modelo pudesse ser implantado de forma eficiente na inferência, então projetaram o J3 com múltiplas versões—uma capaz de caber em uma única GPU de 80 gigabytes de memória (como uma A100 ou H100) e uma versão maior para rodar em um pod. Esse foco em eficiência de inferência desde o início seria crucial para o avanço que viria.

Durante a fase de estudos de ablação, Barak Lenz, CTO da AI21, se deparou com o artigo do Mamba, recomendado por diversos colegas. Diferente de trabalhos anteriores com modelos de espaço de estados, que mostraram pouco potencial, o artigo do Mamba se destacou pelo rigor na comparação e avaliação. Ao invés de comparar com baselines desatualizados, os autores compararam o Mamba diretamente com as arquiteturas de atenção mais recentes, especialmente as inovações introduzidas pelo Llama, que trouxe otimizações relevantes em normalização de camadas, funções de ativação e outros detalhes arquiteturais que preveniam instabilidades de treinamento. O artigo do Mamba não só comparou de forma justa com esses baselines de ponta, como também liberou kernels e códigos customizados, demonstrando compromisso genuíno com a implementação prática. Intrigado por esse rigor, Lenz incentivou sua equipe de engenharia a experimentar o Mamba e avaliar seu desempenho em relação ao painel de benchmarks já estabelecido, que naquela altura já continha centenas de tarefas e benchmarks diversos.

Os resultados iniciais foram promissores, mas revelaram limitações importantes. O Mamba teve desempenho competitivo em métricas de perplexidade e na maioria das tarefas, mas apresentou deficiências em tarefas few-shot, que exigem adaptação rápida a novos padrões. Após investigação, a equipe concluiu que essas deficiências vinham da ausência de mecanismos de atenção—certos tipos de raciocínio e tarefas de reconhecimento de padrões se beneficiam da consciência global de contexto proporcionada pela atenção. Em vez de aceitar essa limitação, a equipe passou a experimentar arquiteturas híbridas, intercalando camadas de atenção e Mamba para tentar capturar os benefícios de ambas as abordagens. Os resultados superaram as expectativas: não apenas a abordagem híbrida eliminou a degradação de desempenho observada nos modelos puros de Mamba, como também mostrou melhorias em relação às arquiteturas transformer convencionais. Essa descoberta foi o catalisador para o desenvolvimento do Jamba.

O desenvolvimento do Jamba exigiu a solução de inúmeros desafios técnicos nunca antes enfrentados em tal escala. Quando a AI21 começou o treinamento do Jamba Mini, o primeiro modelo da linha híbrida, o Mamba nunca havia sido escalado além de 3 bilhões de parâmetros. O modelo híbrido da equipe, por outro lado, chegaria a 13 bilhões de parâmetros ativos, com aproximadamente 52 bilhões de parâmetros totais ao considerar os componentes mixture-of-experts. Isso representou um enorme desafio de escala, exigindo que a equipe depurasse e otimizasse a arquitetura do modelo de maneiras inéditas. O próprio processo de otimização tornou-se um desafio de engenharia fascinante—a equipe teve que dissecar cuidadosamente o comportamento do modelo, identificar gargalos e implementar soluções que permitissem o treinamento eficiente da arquitetura híbrida nessa escala inédita.

Uma das decisões mais críticas na arquitetura do Jamba foi determinar a proporção ideal entre camadas de atenção e de espaço de estados, e onde essas camadas deveriam ser posicionadas no modelo. Através de extensos estudos de ablação, a AI21 descobriu que a proporção de 1:8—onde uma de cada oito camadas usa atenção e as outras sete utilizam Mamba—oferecia o melhor equilíbrio entre desempenho e eficiência. Curiosamente, a posição das camadas de atenção também era muito relevante. A equipe testou posicionar camadas de atenção no início, meio e fim do modelo, descobrindo que colocá-las no meio da arquitetura trouxe resultados substancialmente melhores do que posicioná-las nas extremidades. Embora proporções ainda mais agressivas, como 1:6, mostrassem melhorias marginais, esses ganhos estavam dentro da variação padrão dos resultados e não justificavam o custo computacional adicional de mais camadas de atenção, especialmente considerando que cada camada transformer adiciona custos quadráticos ao cache de chave-valor durante o processamento de contexto longo.

Os ganhos de eficiência dessa arquitetura são substanciais e multifacetados. Durante o treinamento, a abordagem híbrida reduz as exigências computacionais em comparação com modelos puramente transformer, tornando mais viável treinar modelos em larga escala. Na inferência, os benefícios se tornam ainda mais evidentes, especialmente para aplicações de contexto longo. Embora o Mamba tenha um custo fixo maior para sequências curtas em relação à atenção, essa desvantagem desaparece e se inverte à medida que o comprimento da sequência aumenta. Para aplicações que exigem contexto longo—incluindo casos agente, sistemas empresariais de geração aumentada por recuperação, personalização com memória e várias outras aplicações emergentes—a arquitetura híbrida proporciona características de desempenho dramaticamente melhores. O escalonamento linear de memória do Mamba significa que dobrar a janela de contexto dobra o requisito de memória, enquanto em atenção pura, dobrar o contexto quadruplica o requisito de memória. Essa diferença fundamental se torna cada vez mais importante à medida que as aplicações demandam contextos mais longos para manter raciocínio coerente e memória ao longo de interações estendidas.

À medida que organizações adotam modelos avançados como o Jamba 3B, o desafio de integrar esses modelos aos fluxos de produção torna-se essencial. O FlowHunt responde a esse desafio ao fornecer uma plataforma completa para automação de fluxos de IA, abrangendo desde a seleção e testes do modelo até deployment e monitoramento. Os ganhos de eficiência proporcionados por modelos híbridos como o Jamba 3B são plenamente realizados apenas quando pareados com automação inteligente de fluxos que otimize como esses modelos são implantados, testados e monitorados em ambientes de produção. O FlowHunt permite que equipes construam sistemas de IA sofisticados aproveitando modelos como o Jamba 3B, mantendo visibilidade e controle sobre todo o pipeline. Ao automatizar aspectos rotineiros do deployment e monitoramento, o FlowHunt permite que as equipes foquem nos aspectos estratégicos da integração de IA, garantindo que os ganhos computacionais das arquiteturas avançadas se traduzam em valor real para o negócio.

A combinação de modelos eficientes e automação inteligente de fluxos cria uma sinergia poderosa. As equipes podem implantar o Jamba 3B em dispositivos de borda ou ambientes com restrição de memória com confiança, sabendo que as ferramentas de monitoramento e otimização do FlowHunt garantirão desempenho consistente. Para empresas que constroem sistemas de IA que exigem processamento de contexto longo, personalização e raciocínio agente, o FlowHunt fornece a infraestrutura para gerenciar esses fluxos complexos com eficiência. A capacidade da plataforma de automatizar testes, deployment e monitoramento significa que as organizações podem iterar rapidamente em seus sistemas de IA, experimentando diferentes configurações e estratégias de deployment sem sobrecarga manual. Isso é especialmente valioso para organizações que exploram as possibilidades dos modelos híbridos, pois permite comparar arquiteturas e configurações para encontrar o equilíbrio ideal para seus casos de uso.

O lançamento do Jamba 3B representa um marco importante ao tornar capacidades avançadas de IA acessíveis a uma gama mais ampla de aplicações e cenários de deployment. Diferente dos modelos anteriores da linha Jamba, desenhados para máximo desempenho em grande escala, o Jamba 3B é otimizado especificamente para dispositivos de borda e ambientes com restrição de memória. O “3B” refere-se ao tamanho do modelo—aproximadamente 3 bilhões de parâmetros—tornando-o pequeno o suficiente para rodar em hardware de consumo, mantendo os benefícios de eficiência da arquitetura híbrida. Esse é um desenvolvimento crucial porque democratiza o acesso a capacidades avançadas de modelos de linguagem, viabilizando aplicações antes impossíveis devido a restrições computacionais. Desenvolvedores agora podem implantar modelos sofisticados em dispositivos móveis, IoT, sistemas embarcados e outras plataformas de edge computing sem sacrificar as capacidades de raciocínio e processamento de contexto longo dos modelos modernos.

A característica mais significativa do Jamba 3B é sua habilidade de lidar com janelas de contexto longas permanecendo implantável em dispositivos de borda. Essa combinação era impossível com arquiteturas puramente transformer—a complexidade quadrática da atenção fazia com que estender as janelas de contexto em dispositivos de borda rapidamente esgotasse a memória disponível. A arquitetura híbrida do Jamba 3B muda completamente essa equação. A complexidade linear das camadas Mamba permite ampliar o contexto sem o crescimento exponencial de memória que afeta os modelos puros de atenção. Para aplicações que exigem personalização, retenção de memória, geração aumentada por recuperação e raciocínio agente, essa capacidade é transformadora. Um dispositivo de borda rodando o Jamba 3B pode manter contexto coerente em interações estendidas, viabilizando aplicações sofisticadas antes possíveis apenas com modelos em nuvem. Essa mudança tem impactos profundos em privacidade, latência e custo—aplicações podem processar dados sensíveis localmente, responder a consultas com mínima latência e operar sem custos computacionais de nuvem.

Ao examinar o cenário de mini modelos disponíveis no mercado, o Jamba 3B se destaca como o único modelo híbrido em sua categoria de tamanho. A maioria dos mini modelos existentes depende de arquiteturas puramente transformer, o que significa que enfrentam as mesmas limitações de eficiência de seus equivalentes maiores. A abordagem híbrida do Jamba 3B confere a ele uma vantagem significativa em capacidades de contexto longo e eficiência computacional. O modelo alcança essa distinção não por compromissos arquiteturais que reduzam capacidade, mas pelos ganhos fundamentais de eficiência da abordagem híbrida. Isso posiciona o Jamba 3B como escolha ideal para aplicações que precisam equilibrar tamanho de modelo com capacidade, especialmente aquelas que requerem processamento de contexto longo em dispositivos de borda.

Apesar das claras vantagens dos modelos híbridos, permanecem obstáculos significativos à sua adoção em larga escala. A indústria de IA gastou anos otimizando hardware e software especificamente para mecanismos de atenção de transformer. Todo grande fabricante de hardware—de GPUs NVIDIA a aceleradores de IA especializados—possui kernels e otimizações customizadas para operações de atenção. Essas otimizações são fruto de anos de engenharia e representam investimentos substanciais para tornar a atenção o mais eficiente possível em plataformas específicas. Em contraste, modelos de espaço de estados como o Mamba são relativamente novos e, embora já existam kernels customizados, essas otimizações não são tão maduras ou amplamente distribuídas em diferentes hardwares. Isso cria o que Barak Lenz chama de “a loteria do hardware”—as vantagens de eficiência dos modelos híbridos podem ser significativamente reduzidas se a plataforma de hardware não tiver implementações otimizadas das operações dos modelos de espaço de estados.

Essa lacuna de otimização de hardware é um obstáculo real, mas não intransponível e tende a diminuir com o tempo. À medida que mais empresas reconhecem o valor dos modelos híbridos e das arquiteturas de espaço de estados, fabricantes de hardware terão mais incentivos para investir em otimizações para essas operações. A NVIDIA já começou a lançar modelos híbridos, e outras empresas seguiram o exemplo, sugerindo que a indústria está reconhecendo a importância dessas arquiteturas no longo prazo. Além disso, as vantagens de eficiência dos modelos híbridos são tão substanciais que, mesmo sem otimização de hardware perfeita, frequentemente superam os modelos puros de atenção. A complexidade quadrática da atenção é uma limitação fundamental que, mesmo com anos de otimização, não pode competir com a complexidade linear dos modelos de espaço de estados para aplicações de contexto longo. À medida que os comprimentos de sequência aumentam—uma tendência inevitável à medida que as aplicações exigem mais contexto para melhor raciocínio e personalização—as vantagens dos modelos híbridos se tornarão cada vez mais inegáveis.

Além do trabalho da AI21 em modelos híbridos, uma tendência mais ampla está surgindo na indústria em direção ao uso mais seletivo da atenção, em vez de em todas as camadas. Mesmo empresas que não adotam arquiteturas híbridas completas reconhecem que atenção total em cada camada é desnecessária e ineficiente. Muitos modelos recentes empregam atenção com janela deslizante, na qual cada token só pode prestar atenção a uma janela limitada de tokens vizinhos em vez da sequência inteira. Essa abordagem reduz a complexidade da atenção de quadrática para linear em relação ao tamanho da janela, embora ainda exija mais computação do que modelos de espaço de estados. O fato de pesquisadores como Noam Shazir terem chegado independentemente a conclusões semelhantes sobre proporções ótimas de atenção—em particular a relação de 1:8 entre atenção local e global—sugere que este não é um achado isolado, mas sim uma propriedade fundamental de como modelos de linguagem devem ser estruturados.

Essa convergência de resultados entre diferentes grupos de pesquisa e empresas indica que a indústria caminha para um novo consenso sobre arquitetura ideal de modelos. Em vez da abordagem puramente transformer que dominou desde o GPT-2, o futuro provavelmente envolverá modelos que usam atenção de forma seletiva, seja através de arquiteturas híbridas como o Jamba ou por abordagens como atenção com janela deslizante. Os detalhes de implementação podem variar, mas o princípio subjacente é consistente: atenção total em todas as camadas é ineficiente e desnecessária. Essa mudança representa uma maturação do campo, indo além do sucesso inicial dos transformers para uma compreensão mais refinada de quando e onde a atenção é realmente necessária. Para profissionais e organizações que constroem sistemas de IA, isso tem implicações importantes—sugere que os modelos que construirão e implantarão no futuro tendem a ser mais eficientes que os atuais, viabilizando novas aplicações e casos de uso que hoje são impraticáveis devido a restrições computacionais.

Veja como o FlowHunt automatiza seus fluxos de IA e SEO — do research e geração de conteúdo à publicação e análise — tudo em um só lugar.

Além dos modelos individuais, a AI21 vem pioneirando o desenvolvimento de sistemas de IA que vão além da simples inferência de modelos de linguagem. A empresa lançou o Jarvis, um sistema de IA inicial que buscava usar ferramentas e recursos externos para aumentar as capacidades dos modelos de linguagem. Esse trabalho antecedeu a adoção generalizada do uso de ferramentas em modelos de linguagem e foi influente ao inspirar frameworks posteriores, como o LangChain. O insight fundamental por trás dos sistemas de IA é que modelos de linguagem isolados, embora poderosos, não são suficientes para muitas aplicações do mundo real. Para preencher a lacuna entre deep learning e IA clássica, sistemas precisam ser capazes de acionar ferramentas externas, acessar bancos de dados, executar códigos e realizar outras operações que exigem mais rigor e determinismo do que a inferência puramente neural pode fornecer.

O Maestro, oferta empresarial da AI21, representa a evolução desse pensamento para um sistema pronto para produção desenhado para aplicações de negócios. Em vez de simplesmente implantar um modelo de linguagem esperando que ele produza resultados úteis, o Maestro oferece um framework para construir sistemas de IA que conseguem executar tarefas complexas de maneira confiável, combinando capacidades de modelos de linguagem com uso de ferramentas, busca e outras técnicas de IA clássica. Essa abordagem é especialmente importante em aplicações empresariais onde confiabilidade, precisão e auditabilidade são requisitos críticos. Um modelo de linguagem pode gerar informações plausíveis, mas incorretas, enquanto um sistema de IA que pode verificar suas saídas contra dados externos e usar ferramentas para tarefas específicas pode fornecer muito mais confiabilidade. A adoção de sistemas de IA em ambientes empresariais tem sido mais lenta do que alguns previram, mas isso está mudando à medida que as organizações reconhecem o valor da IA para automatizar fluxos de trabalho e processos decisórios complexos.

O momento dessa mudança em direção a sistemas de IA é importante. Quando a IA generativa surgiu como tecnologia mainstream, muitas organizações focaram em aplicações simples como geração de conteúdo e chatbots de atendimento ao cliente. Essas aplicações podiam ser atendidas adequadamente por um modelo de linguagem com mínima infraestrutura adicional. No entanto, à medida que as organizações ganharam experiência com IA e identificaram casos de uso mais sofisticados, as limitações dos modelos de linguagem puros ficaram evidentes. Aplicações que exigem processamento de contexto longo, personalização, retenção de memória e raciocínio agente se beneficiam da abordagem estruturada dos sistemas de IA. Além disso, os ganhos de eficiência de modelos como o Jamba 3B tornam cada vez mais viável implantar sistemas de IA sofisticados em dispositivos de borda e ambientes restritos. A convergência de modelos mais eficientes e arquiteturas de sistema mais sofisticadas está criando novas possibilidades de deployment de IA em todo o setor empresarial.

Para desenvolvedores e organizações que consideram como aproveitar modelos avançados de linguagem em suas aplicações, o surgimento do Jamba 3B e das arquiteturas híbridas traz várias implicações importantes. Primeiro, sugere que a era dos modelos puramente transformer pode estar chegando ao fim, ao menos para novos desenvolvimentos. Enquanto modelos transformer existentes continuarão a ser usados e aprimorados, novos modelos tendem cada vez mais a incorporar arquiteturas híbridas ou mecanismos de atenção seletiva. Isso significa que desenvolvedores devem começar a se familiarizar com essas novas arquiteturas e entender suas características, vantagens e limitações. Segundo, os ganhos de eficiência dos modelos híbridos tornam viável implantar modelos sofisticados em cenários antes impossíveis—em dispositivos de borda, aplicativos móveis e outros ambientes restritos. Isso abre novas possibilidades para aplicações que podem processar dados localmente, manter privacidade e responder com mínima latência.

Terceiro, as capacidades de contexto longo de modelos como o Jamba 3B permitem novos padrões de aplicação antes impraticáveis. Agora, aplicações podem manter contexto coerente em interações estendidas, possibilitando personalização mais sofisticada, retenção de memória e raciocínio agente. Isso é especialmente valioso para aplicações empresariais onde manter contexto entre múltiplas interações e integrar-se a sistemas externos é fundamental. Quarto, a combinação de modelos eficientes e plataformas inteligentes de automação de fluxos como o FlowHunt cria novas possibilidades de iteração rápida e experimentação. Organizações podem testar diferentes configurações de modelo, estratégias de deployment e arquiteturas de sistema sem incorrer em custos computacionais proibitivos. Essa democratização da experimentação em IA tende a acelerar a inovação e levar a novas aplicações e casos de uso ainda não imaginados.

As evidências sugerem cada vez mais que modelos híbridos não são uma tendência temporária, mas representam o caminho futuro do desenvolvimento de modelos de linguagem. As vantagens de eficiência são simplesmente grandes demais para serem ignoradas, e as características de desempenho são competitivas ou superiores aos modelos puramente transformer na maior parte dos benchmarks. À medida que fabricantes de hardware investem em otimizações para modelos de espaço de estados e outras arquiteturas eficientes, as vantagens práticas dos modelos híbridos só aumentarão. Além disso, a tendência mais ampla do setor para atenção seletiva—seja via arquiteturas híbridas, atenção com janela deslizante ou outras abordagens—indica uma mudança fundamental na forma como o campo pensa arquitetura de modelos. A abordagem puramente transformer que dominou nos últimos anos está dando lugar a arquiteturas mais refinadas, que usam mecanismos diferentes para propósitos diferentes.

Para organizações que constroem sistemas de IA, essa mudança tem implicações estratégicas importantes. Investir agora em entender e trabalhar com modelos híbridos posiciona as organizações para aproveitar os ganhos de eficiência e capacidade que esses modelos proporcionam. A combinação de modelos eficientes como o Jamba 3B com sistemas de IA sofisticados e automação inteligente de fluxos cria uma base poderosa para construir aplicações de IA de próxima geração. À medida que o campo continua a evoluir, as organizações que investirem em compreender essas novas arquiteturas e construir sistemas em torno delas estarão melhor posicionadas para capitalizar as oportunidades que surgirem. O futuro da IA não trata apenas de modelos maiores ou mais dados—trata de arquiteturas mais inteligentes, que entregam melhor desempenho com maior eficiência, viabilizando novas aplicações e casos de uso antes impossíveis.

O desenvolvimento do Jamba 3B e o movimento mais amplo em direção a modelos híbridos representam uma maturação do campo dos grandes modelos de linguagem. Em vez de simplesmente escalar arquiteturas existentes, pesquisadores e profissionais agora pensam com mais cuidado sobre como projetar modelos que sejam ao mesmo tempo poderosos e eficientes. Essa abordagem reflexiva ao design de arquitetura, combinada com avaliação rigorosa e disposição para desafiar o senso comum, tende a impulsionar avanços significativos em IA nos próximos anos. Os modelos híbridos que a AI21 e outras empresas estão desenvolvendo hoje provavelmente se tornarão a abordagem padrão para construção de modelos de linguagem no futuro, assim como os transformers se tornaram padrão após sua introdução. Para quem trabalha ou tem interesse em modelos de linguagem, compreender essas novas arquiteturas e suas implicações é essencial para se manter atualizado em um campo em rápida evolução.

Um LLM híbrido combina mecanismos de atenção de transformers com modelos de espaço de estados como o Mamba. Diferente dos modelos puros de transformer, que dependem totalmente da atenção (com complexidade computacional quadrática), modelos híbridos utilizam a atenção de forma seletiva—tipicamente numa proporção de 1:8—e aproveitam a complexidade linear dos modelos de espaço de estados na maioria das camadas. Essa abordagem mantém a qualidade de desempenho enquanto reduz significativamente os custos computacionais e as exigências de memória.

O Jamba 3B é otimizado para dispositivos de borda porque alcança capacidades de processamento de contexto longo mantendo um tamanho pequeno o suficiente para rodar em ambientes com restrição de memória. A eficiência da arquitetura híbrida permite que o modelo caiba em GPUs únicas ou dispositivos de borda sem sacrificar a capacidade de lidar com janelas de contexto estendidas, tornando-o ideal para aplicações de IA embarcada.

Através de extensos estudos de ablação, a AI21 descobriu que usar atenção em apenas 1 de cada 8 camadas (com Mamba nas outras 7 camadas) oferece o equilíbrio ideal entre desempenho e eficiência. As camadas de atenção são estrategicamente posicionadas no meio do modelo, em vez de no início ou no fim, o que empiricamente mostrou melhores resultados. Essa proporção minimiza o custo quadrático da atenção enquanto preserva a capacidade do modelo de lidar com tarefas de raciocínio complexo.

Modelos híbridos oferecem várias vantagens: custos de treinamento significativamente menores devido à redução dos requisitos computacionais, melhor eficiência para aplicações de contexto longo, escalabilidade linear de memória em vez de quadrática, e desempenho mantido ou superior na maioria dos benchmarks. Eles também permitem deployment em dispositivos de borda e ambientes com restrição de memória, preservando as capacidades de raciocínio que tornam os grandes modelos de linguagem valiosos.

Arshia é Engenheira de Fluxos de Trabalho de IA na FlowHunt. Com formação em ciência da computação e paixão por IA, ela se especializa em criar fluxos de trabalho eficientes que integram ferramentas de IA em tarefas do dia a dia, aumentando a produtividade e a criatividade.

Otimize o deployment, testes e a otimização dos seus modelos de IA com a plataforma inteligente de automação do FlowHunt.

Explore as capacidades avançadas do Llama 3.3 70B Versatile 128k como um Agente de IA. Esta análise aprofundada examina suas habilidades de raciocínio, resoluçã...

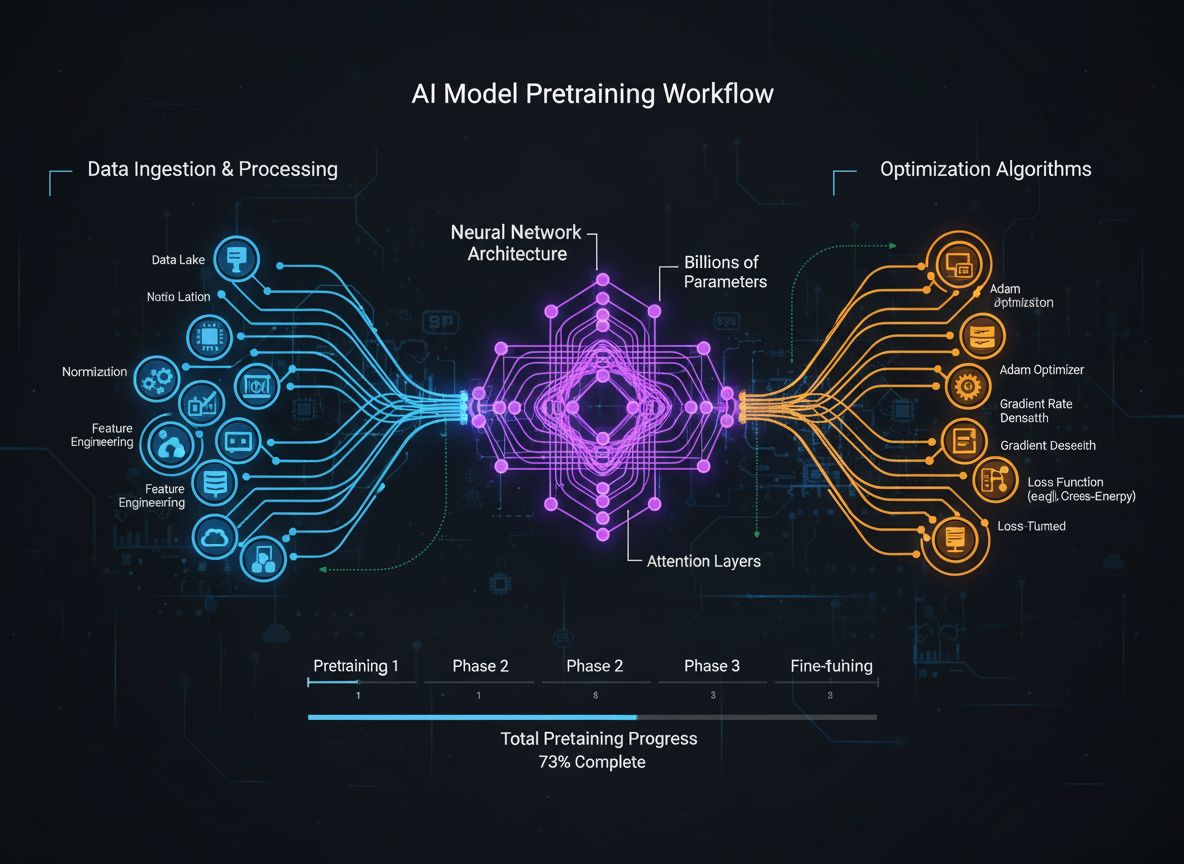

Um guia abrangente sobre estratégias modernas de pré-treinamento de modelos de linguagem, técnicas de curadoria de dados e métodos de otimização usados pela Hug...

Explore os melhores grandes modelos de linguagem (LLMs) para programação em junho de 2025. Este guia educacional completo traz insights, comparações e dicas prá...

Consentimento de Cookies

Usamos cookies para melhorar sua experiência de navegação e analisar nosso tráfego. See our privacy policy.