Guia de Desenvolvimento para Servidores MCP

Aprenda como construir e implantar um servidor Model Context Protocol (MCP) para conectar modelos de IA a ferramentas e fontes de dados externas. Guia passo a p...

Automação de IA

Aprenda a desenvolver um servidor Model Context Protocol (MCP) que se integra perfeitamente com a API do OpenAI, permitindo execução poderosa de ferramentas baseadas em IA e automação inteligente.

O Model Context Protocol (MCP) representa uma mudança de paradigma em como sistemas de inteligência artificial interagem com ferramentas externas e fontes de dados. Quando combinado com os poderosos modelos de linguagem do OpenAI, um servidor MCP torna-se um portal para a automação inteligente, permitindo que sistemas de IA executem operações complexas, obtenham dados em tempo real e se integrem perfeitamente à sua infraestrutura existente. Este guia completo conduz você por todo o processo de desenvolvimento de um servidor MCP que conecta ao OpenAI, dos conceitos fundamentais até a implementação pronta para produção.

Seja você responsável por construir uma plataforma de automação para atendimento ao cliente, um sistema inteligente de processamento de dados ou uma sofisticada ferramenta de business intelligence, entender como arquitetar e implementar um servidor MCP é essencial para o desenvolvimento moderno em IA. A integração entre servidores MCP e OpenAI cria um ecossistema poderoso, onde modelos de IA podem raciocinar sobre problemas, decidir quais ferramentas usar e executá-las com precisão—tudo isso mantendo segurança, confiabilidade e escalabilidade.

O Model Context Protocol é um padrão aberto que define como modelos de IA podem descobrir e interagir com ferramentas, serviços e fontes de dados externas. Em vez de incorporar toda a funcionalidade diretamente em um modelo de IA, o MCP permite que desenvolvedores criem servidores especializados que expõem capacidades por meio de uma interface padronizada. Essa separação de responsabilidades proporciona melhor modularidade, segurança e escalabilidade em aplicações de IA.

Em essência, o MCP opera sobre um princípio simples: o modelo de IA (neste caso, o GPT do OpenAI) atua como um orquestrador inteligente, capaz de entender quais ferramentas estão disponíveis, determinar quando utilizá-las e interpretar seus resultados. O servidor MCP atua como fornecedor dessas ferramentas, expondo-as por meio de uma API bem definida que o modelo de IA pode descobrir e invocar. Isso cria um contrato limpo entre o sistema de IA e sua lógica de negócios personalizada.

A beleza do MCP está em sua flexibilidade. Seu servidor pode expor ferramentas para qualquer finalidade—consultas a bancos de dados, chamadas de API para serviços de terceiros, processamento de arquivos, cálculos ou até mesmo acionar fluxos de trabalho complexos. O modelo de IA aprende sobre essas capacidades e as utiliza de forma inteligente dentro das conversas, decidindo quais ferramentas invocar com base no pedido do usuário e no contexto da conversa.

A integração de servidores MCP com o OpenAI resolve uma limitação fundamental dos grandes modelos de linguagem: eles possuem um limite de conhecimento e não podem interagir diretamente com sistemas em tempo real ou dados proprietários. Ao implementar um servidor MCP, você expande as capacidades dos modelos do OpenAI muito além de seu treinamento base, permitindo-lhes acessar informações atuais, executar lógica de negócios e integrar-se aos seus sistemas existentes.

Considere estes cenários práticos onde servidores MCP se mostram indispensáveis:

A arquitetura também oferece vantagens significativas para equipes de desenvolvimento. Diversas equipes podem desenvolver e manter seus próprios servidores MCP de forma independente, que podem ser compostos para criar aplicações de IA sofisticadas. Esta abordagem modular escala bem à medida que sua organização cresce e suas capacidades de IA tornam-se mais complexas.

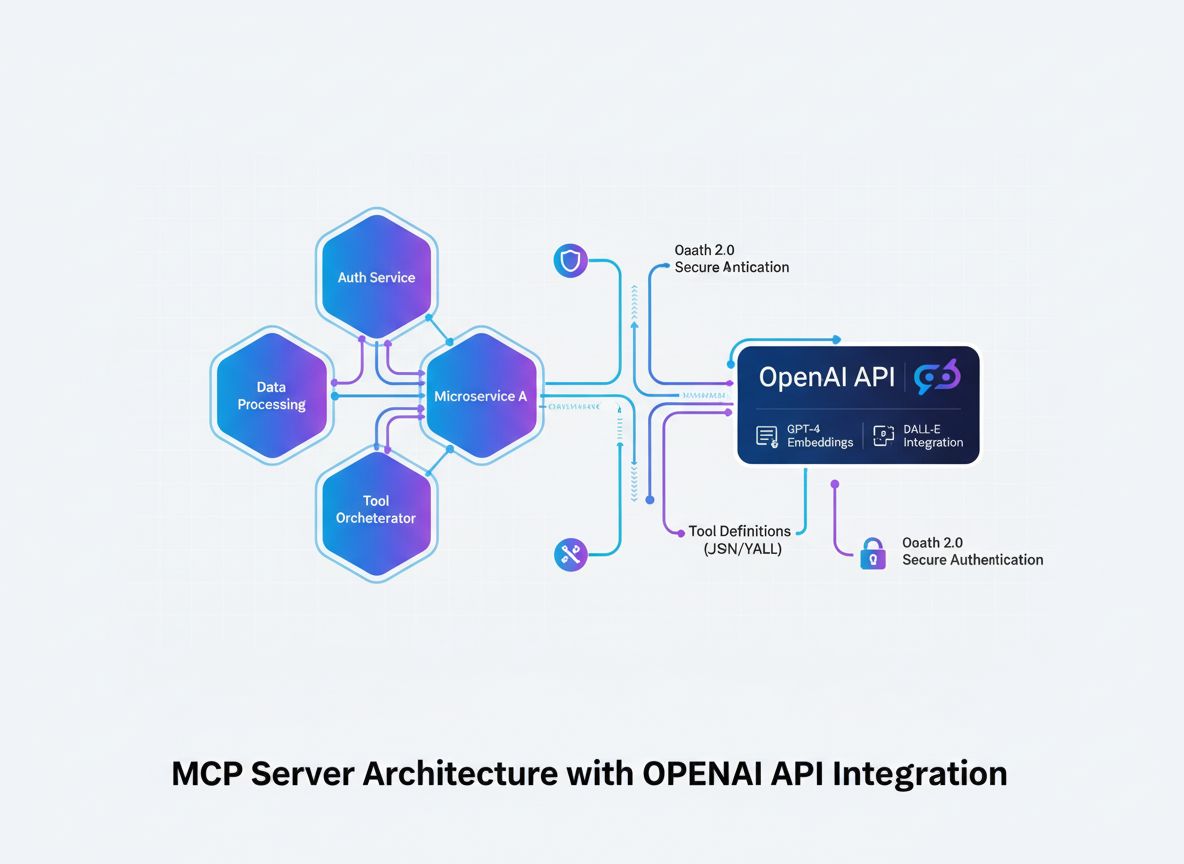

Antes de mergulhar nos detalhes da implementação, é fundamental compreender o fluxo arquitetural de como um servidor MCP se integra ao OpenAI. O processo envolve vários componentes-chave trabalhando em conjunto:

O Modelo de IA (OpenAI) inicia conversas e toma decisões sobre quais ferramentas invocar. Quando o modelo determina que uma chamada de ferramenta é necessária, ele gera uma solicitação estruturada contendo o nome da ferramenta e os parâmetros.

O Cliente MCP atua como tradutor e intermediário. Ele recebe as solicitações de invocação de ferramentas do OpenAI, traduz para o formato esperado pelo seu servidor MCP, envia a solicitação ao servidor apropriado e retorna os resultados ao OpenAI no formato que o modelo espera.

O Servidor MCP é sua aplicação personalizada que expõe ferramentas e capacidades. Ele recebe solicitações do cliente MCP, executa as operações requisitadas (que podem envolver consultas a bancos de dados, chamadas de API ou cálculos complexos) e retorna resultados estruturados.

Definições de Ferramentas são os contratos que definem quais ferramentas estão disponíveis, quais parâmetros aceitam e o que retornam. Essas definições são descobertas pelo cliente MCP e registradas no OpenAI para que o modelo saiba o que está disponível.

Esta arquitetura cria uma separação clara de responsabilidades: o OpenAI cuida do raciocínio e tomada de decisão, seu servidor MCP lida com a lógica de domínio e acesso a dados, e o cliente MCP cuida do protocolo de comunicação entre eles.

A base de qualquer servidor MCP bem-sucedido é uma definição clara das ferramentas que você deseja expor. Isso não é apenas um exercício técnico—é uma decisão estratégica sobre quais capacidades seu sistema de IA precisa para atingir seus objetivos.

Comece identificando os problemas específicos que seu sistema de IA precisa resolver. Você está construindo um chatbot de atendimento ao cliente que precisa consultar informações de pedidos? Um assistente de análise de dados que precisa fazer consultas em bancos de dados? Uma ferramenta de criação de conteúdo que acessa a base de conhecimento da sua empresa? Cada caso de uso terá necessidades diferentes de ferramentas.

Para cada ferramenta, defina:

get_customer_order_history, search_knowledge_base, execute_sql_query)Veja um exemplo de especificações bem definidas:

| Nome da Ferramenta | Propósito | Parâmetros de Entrada | Formato de Saída | Caso de Uso |

|---|---|---|---|---|

get_customer_info | Recuperar detalhes do cliente | customer_id (string) | Objeto JSON com nome, e-mail, status da conta | Consultas de atendimento |

search_orders | Buscar pedidos por critérios | customer_id, date_range, status | Array de objetos de pedido | Consulta e histórico de pedidos |

create_support_ticket | Abrir novo chamado | customer_id, issue_description, priority | Objeto de ticket com ID e confirmação | Escalonamento de problemas |

check_inventory | Verificar disponibilidade | product_id, warehouse_location | Quantidade em estoque e localização | Consultas de estoque |

process_refund | Iniciar reembolso | order_id, amount, reason | Confirmação de transação com referência | Processamento de reembolso |

Esta abordagem baseada em tabela ajuda você a pensar em todo o ecossistema de ferramentas antes de escrever qualquer código. Ela garante consistência, clareza e completude nas definições das suas ferramentas.

Criar um servidor MCP exige uma base de desenvolvimento sólida. Embora servidores MCP possam ser construídos em várias linguagens, vamos focar nas abordagens mais populares: TypeScript/Node.js e Python, pois possuem as bibliotecas MCP mais maduras e amplo suporte da comunidade.

Para Desenvolvimento em TypeScript/Node.js:

Comece criando um novo projeto Node.js e instalando as dependências necessárias:

mkdir mcp-server-openai

cd mcp-server-openai

npm init -y

npm install @modelcontextprotocol/sdk openai dotenv express cors

npm install --save-dev typescript @types/node ts-node

Crie um arquivo tsconfig.json para configurar o TypeScript:

{

"compilerOptions": {

"target": "ES2020",

"module": "commonjs",

"lib": ["ES2020"],

"outDir": "./dist",

"rootDir": "./src",

"strict": true,

"esModuleInterop": true,

"skipLibCheck": true,

"forceConsistentCasingInFileNames": true

}

}

Para Desenvolvimento em Python:

Crie um ambiente virtual e instale as dependências:

python -m venv venv

source venv/bin/activate # No Windows: venv\Scripts\activate

pip install mcp openai python-dotenv fastapi uvicorn

Independente da linguagem escolhida, você precisará de:

.env para armazenar credenciais sensíveis com segurançaO núcleo do seu servidor MCP é a aplicação que expõe suas ferramentas através do protocolo MCP. Isso envolve criar endpoints para descoberta e execução de ferramentas.

Implementação em TypeScript/Node.js:

Crie uma estrutura básica para o servidor MCP:

import { Server } from "@modelcontextprotocol/sdk/server/index.js";

import { StdioServerTransport } from "@modelcontextprotocol/sdk/server/stdio.js";

import {

CallToolRequestSchema,

ListToolsRequestSchema,

} from "@modelcontextprotocol/sdk/types.js";

const server = new Server({

name: "openai-mcp-server",

version: "1.0.0",

});

// Defina suas ferramentas

const tools = [

{

name: "get_customer_info",

description: "Recupera informações do cliente pelo ID",

inputSchema: {

type: "object",

properties: {

customer_id: {

type: "string",

description: "Identificador único do cliente",

},

},

required: ["customer_id"],

},

},

// Adicione mais ferramentas aqui

];

// Lida com solicitações de listagem de ferramentas

server.setRequestHandler(ListToolsRequestSchema, async () => {

return { tools };

});

// Lida com solicitações de execução de ferramentas

server.setRequestHandler(CallToolRequestSchema, async (request) => {

const { name, arguments: args } = request.params;

if (name === "get_customer_info") {

// Implemente a lógica da ferramenta aqui

const customerId = args.customer_id;

// Consulte seu banco de dados ou API

return {

content: [

{

type: "text",

text: JSON.stringify({

id: customerId,

name: "John Doe",

email: "john@example.com",

}),

},

],

};

}

return {

content: [{ type: "text", text: `Ferramenta desconhecida: ${name}` }],

isError: true,

};

});

// Inicia o servidor

const transport = new StdioServerTransport();

server.connect(transport);

Implementação em Python:

from mcp.server import Server

from mcp.types import Tool, TextContent, ToolResult

import json

app = Server("openai-mcp-server")

# Defina suas ferramentas

TOOLS = [

Tool(

name="get_customer_info",

description="Recupera informações do cliente pelo ID",

inputSchema={

"type": "object",

"properties": {

"customer_id": {

"type": "string",

"description": "Identificador único do cliente"

}

},

"required": ["customer_id"]

}

)

]

@app.list_tools()

async def list_tools():

return TOOLS

@app.call_tool()

async def call_tool(name: str, arguments: dict):

if name == "get_customer_info":

customer_id = arguments.get("customer_id")

# Implemente a lógica da ferramenta

result = {

"id": customer_id,

"name": "John Doe",

"email": "john@example.com"

}

return ToolResult(

content=[TextContent(type="text", text=json.dumps(result))]

)

return ToolResult(

content=[TextContent(type="text", text=f"Ferramenta desconhecida: {name}")],

isError=True

)

if __name__ == "__main__":

import uvicorn

uvicorn.run(app, host="0.0.0.0", port=8000)

O verdadeiro poder do seu servidor MCP está na implementação efetiva das suas ferramentas. É aqui que você conecta bancos de dados, chama APIs externas, processa dados e executa lógica de negócios.

Exemplo de Integração com Banco de Dados:

import { Pool } from "pg"; // Exemplo com PostgreSQL

const pool = new Pool({

connectionString: process.env.DATABASE_URL,

});

async function getCustomerInfo(customerId: string) {

try {

const result = await pool.query(

"SELECT id, name, email, account_status FROM customers WHERE id = $1",

[customerId]

);

if (result.rows.length === 0) {

return {

error: "Cliente não encontrado",

status: 404,

};

}

return result.rows[0];

} catch (error) {

return {

error: "Falha na consulta ao banco de dados",

details: error.message,

status: 500,

};

}

}

Exemplo de Integração com API Externa:

import axios from "axios";

async function searchExternalDatabase(query: string) {

try {

const response = await axios.get(

"https://api.external-service.com/search",

{

params: { q: query },

headers: {

Authorization: `Bearer ${process.env.EXTERNAL_API_KEY}`,

},

}

);

return response.data;

} catch (error) {

return {

error: "Falha na chamada à API externa",

details: error.message,

};

}

}

Tratamento de Erros e Validação:

Um tratamento de erros robusto é fundamental para servidores MCP em produção. Implemente validação abrangente e tratamento de erros:

function validateInput(args: any, schema: any): { valid: boolean; error?: string } {

// Valide campos obrigatórios

for (const required of schema.required || []) {

if (!(required in args)) {

return { valid: false, error: `Parâmetro obrigatório ausente: ${required}` };

}

}

// Valide tipos de campos

for (const [key, property] of Object.entries(schema.properties || {})) {

if (key in args) {

const value = args[key];

const expectedType = (property as any).type;

if (typeof value !== expectedType) {

return {

valid: false,

error: `O parâmetro ${key} deve ser do tipo ${expectedType}`,

};

}

}

}

return { valid: true };

}

O cliente MCP é a ponte entre o OpenAI e seu servidor MCP. Ele cuida da tradução entre o formato de chamada de função do OpenAI e o protocolo do seu servidor MCP.

Cliente MCP em TypeScript/Node.js:

import { Client } from "@modelcontextprotocol/sdk/client/index.js";

import { StdioClientTransport } from "@modelcontextprotocol/sdk/client/stdio.js";

import OpenAI from "openai";

class MCPOpenAIBridge {

private mcpClient: Client;

private openaiClient: OpenAI;

private availableTools: any[] = [];

constructor() {

this.openaiClient = new OpenAI({

apiKey: process.env.OPENAI_API_KEY,

});

}

async initialize() {

// Conecta ao servidor MCP

const transport = new StdioClientTransport({

command: "node",

args: ["dist/server.js"],

});

this.mcpClient = new Client({

name: "openai-mcp-client",

version: "1.0.0",

});

await this.mcpClient.connect(transport);

// Descobre ferramentas disponíveis

const toolsResponse = await this.mcpClient.listTools();

this.availableTools = toolsResponse.tools;

}

async executeWithOpenAI(userMessage: string) {

const messages = [{ role: "user" as const, content: userMessage }];

// Converte ferramentas MCP para formato de função OpenAI

const tools = this.availableTools.map((tool) => ({

type: "function" as const,

function: {

name: tool.name,

description: tool.description,

parameters: tool.inputSchema,

},

}));

let response = await this.openaiClient.chat.completions.create({

model: "gpt-4",

messages,

tools,

});

// Lida com chamadas de ferramenta em loop

while (response.choices[0].finish_reason === "tool_calls") {

const toolCalls = response.choices[0].message.tool_calls || [];

for (const toolCall of toolCalls) {

const toolName = toolCall.function.name;

const toolArgs = JSON.parse(toolCall.function.arguments);

// Executa ferramenta no servidor MCP

const toolResult = await this.mcpClient.callTool({

name: toolName,

arguments: toolArgs,

});

// Adiciona resultado da ferramenta às mensagens

messages.push({

role: "assistant",

content: response.choices[0].message.content || "",

});

messages.push({

role: "tool",

content: JSON.stringify(toolResult),

tool_call_id: toolCall.id,

});

}

// Obtém próxima resposta do OpenAI

response = await this.openaiClient.chat.completions.create({

model: "gpt-4",

messages,

tools,

});

}

return response.choices[0].message.content;

}

}

// Uso

const bridge = new MCPOpenAIBridge();

await bridge.initialize();

const result = await bridge.executeWithOpenAI(

"Qual é o histórico de pedidos do cliente 12345?"

);

console.log(result);

Segurança é fundamental ao construir servidores MCP que interagem com dados sensíveis e APIs externas. Implemente múltiplas camadas de segurança:

Gerenciamento de Chaves de API:

import crypto from "crypto";

class APIKeyManager {

private validKeys: Set<string> = new Set();

constructor() {

// Carregue as chaves de API válidas do ambiente ou armazenamento seguro

const keys = process.env.VALID_API_KEYS?.split(",") || [];

this.validKeys = new Set(keys);

}

validateRequest(apiKey: string): boolean {

return this.validKeys.has(apiKey);

}

generateNewKey(): string {

return crypto.randomBytes(32).toString("hex");

}

}

Assinatura e Verificação de Solicitações:

import crypto from "crypto";

function signRequest(payload: any, secret: string): string {

return crypto

.createHmac("sha256", secret)

.update(JSON.stringify(payload))

.digest("hex");

}

function verifySignature(payload: any, signature: string, secret: string): boolean {

const expectedSignature = signRequest(payload, secret);

return crypto.timingSafeEqual(

Buffer.from(signature),

Buffer.from(expectedSignature)

);

}

Limitação de Taxa:

import rateLimit from "express-rate-limit";

const limiter = rateLimit({

windowMs: 15 * 60 * 1000, // 15 minutos

max: 100, // limita cada IP a 100 solicitações por janela

message: "Muitas solicitações deste IP, tente novamente mais tarde.",

});

app.use("/api/", limiter);

Sanitização de Entrada:

function sanitizeInput(input: string): string {

// Remove caracteres potencialmente perigosos

return input

.replace(/[<>]/g, "")

.trim()

.substring(0, 1000); // Limita tamanho

}

function validateCustomerId(customerId: string): boolean {

// Permite apenas alfanuméricos e hífens

return /^[a-zA-Z0-9-]+$/.test(customerId);

}

Testes abrangentes garantem que seu servidor MCP funcione corretamente e lide com casos extremos de forma adequada.

Exemplo de Testes Unitários (Jest):

import { getCustomerInfo } from "../tools/customer";

describe("Ferramentas de Cliente", () => {

test("deve retornar info do cliente para ID válido", async () => {

const result = await getCustomerInfo("cust_123");

expect(result).toHaveProperty("id");

expect(result).toHaveProperty("name");

expect(result).toHaveProperty("email");

});

test("deve retornar erro para ID inválido", async () => {

const result = await getCustomerInfo("invalid");

expect(result).toHaveProperty("error");

});

test("deve lidar graciosamente com erros do banco de dados", async () => {

// Simula erro de banco

const result = await getCustomerInfo("cust_error");

expect(result).toHaveProperty("error");

expect(result.status).toBe(500);

});

});

Testes de Integração:

describe("Integração do Servidor MCP", () => {

let server: Server;

beforeAll(async () => {

server = new Server({ name: "test-server", version: "1.0.0" });

// Inicializa o servidor

});

test("deve listar todas as ferramentas disponíveis", async () => {

const tools = await server.listTools();

expect(tools.length).toBeGreaterThan(0);

expect(tools[0]).toHaveProperty("name");

expect(tools[0]).toHaveProperty("description");

});

test("deve executar ferramenta e retornar resultado", async () => {

const result = await server.callTool({

name: "get_customer_info",

arguments: { customer_id: "cust_123" },

});

expect(result).toBeDefined();

});

});

O FlowHunt oferece uma plataforma completa para automatizar todo o ciclo de vida do desenvolvimento, teste e implantação de servidores MCP. Em vez de gerenciar manualmente cada etapa do seu fluxo de trabalho MCP, o FlowHunt permite criar fluxos de automação inteligente que lidam com tarefas repetitivas e garantem consistência em todo o processo de desenvolvimento.

Testes e Validações Automatizadas:

O FlowHunt pode orquestrar seu pipeline de testes, executando testes unitários, de integração e de ponta a ponta automaticamente sempre que você faz commit de código. Isso garante que as ferramentas do seu servidor MCP estejam sempre funcionando corretamente antes de irem para produção.

Integração e Implantação Contínuas:

Configure fluxos no FlowHunt para criar, testar e implantar seu servidor MCP automaticamente sempre que alterações forem enviadas ao repositório. Isso elimina etapas manuais de implantação e reduz o risco de erro humano.

Monitoramento e Alertas:

O FlowHunt pode monitorar a saúde do seu servidor MCP, rastrear tempos de resposta da API e alertá-lo sobre qualquer problema. Se uma ferramenta começar a falhar ou o desempenho piorar, você será notificado imediatamente para tomar providências.

Geração de Documentação:

Gere automaticamente a documentação de API das ferramentas do seu servidor MCP, mantendo suas documentações sincronizadas com a implementação real. Assim, desenvolvedores sempre terão informações precisas e atualizadas sobre as ferramentas disponíveis.

Otimização de Desempenho:

As análises do FlowHunt ajudam a identificar gargalos na execução das suas ferramentas. Você pode ver quais ferramentas são mais chamadas, quais têm maior latência e onde os esforços de otimização terão mais impacto.

Implantar um servidor MCP em produção exige planejamento e execução cuidadosos. Considere estas estratégias de implantação:

Containerização com Docker:

Crie um Dockerfile para seu servidor MCP:

FROM node:18-alpine

WORKDIR /app

COPY package*.json ./

RUN npm ci --only=production

COPY dist ./dist

EXPOSE 8000

CMD ["node", "dist/server.js"]

Construa e envie para um registro de containers:

docker build -t my-mcp-server:1.0.0 .

docker push myregistry.azurecr.io/my-mcp-server:1.0.0

Implantação com Kubernetes:

Implante seu servidor MCP containerizado no Kubernetes:

apiVersion: apps/v1

kind: Deployment

metadata:

name: mcp-server

spec:

replicas: 3

selector:

matchLabels:

app: mcp-server

template:

metadata:

labels:

app: mcp-server

spec:

containers:

- name: mcp-server

image: myregistry.azurecr.io/my-mcp-server:1.0.0

ports:

- containerPort: 8000

env:

- name: OPENAI_API_KEY

valueFrom:

secretKeyRef:

name: openai-secrets

key: api-key

- name: DATABASE_URL

valueFrom:

secretKeyRef:

name: db-secrets

key: connection-string

resources:

requests:

memory: "256Mi"

cpu: "250m"

limits:

memory: "512Mi"

cpu: "500m"

Configuração de Ambiente:

Use variáveis de ambiente para todas as configurações:

# .env.production

OPENAI_API_KEY=sk-...

DATABASE_URL=postgresql://user:pass@host:5432/db

MCP_SERVER_PORT=8000

LOG_LEVEL=info

ENABLE_METRICS=true

À medida que seu servidor MCP cresce em complexidade, considere estes padrões avançados:

Composição de Ferramentas:

Crie ferramentas de alto nível que componham várias ferramentas de baixo nível:

async function processCustomerRefund(customerId: string, orderId: string, amount: number) {

// Obtem info do cliente

const customer = await getCustomerInfo(customerId);

// Obtem detalhes do pedido

const order = await getOrderDetails(orderId);

// Verifica se o pedido pertence ao cliente

if (order.customerId !== customerId) {

throw new Error("O pedido não pertence ao cliente");

}

// Processa reembolso

const refund = await createRefund(orderId, amount);

// Envia notificação

await sendNotification(customer.email, `Reembolso de R$${amount} processado`);

return refund;

}

Estratégia de Cache:

Implemente cache para reduzir latência e chamadas a APIs:

import NodeCache from "node-cache";

const cache = new NodeCache({ stdTTL: 600 }); // TTL de 10 minutos

async function getCustomerInfoWithCache(customerId: string) {

const cacheKey = `customer_${customerId}`;

// Verifica o cache primeiro

const cached = cache.get(cacheKey);

if (cached) {

return cached;

}

// Busca no banco de dados

const customer = await getCustomerInfo(customerId);

// Armazena no cache

cache.set(cacheKey, customer);

return customer;

}

Processamento Assíncrono de Jobs:

Para operações longas, implemente processamento assíncrono de jobs:

import Bull from "bull";

const jobQueue = new Bull("mcp-jobs");

jobQueue.process(async (job) => {

const { toolName, arguments: args } = job.data;

// Executa ferramenta

const result = await executeTool(toolName, args);

return result;

});

async function executeToolAsync(toolName: string, args: any) {

const job = await jobQueue.add(

{ toolName, arguments: args },

{ attempts: 3, backoff: { type: "exponential", delay: 2000 } }

);

return job.id;

}

Servidores MCP em produção requerem monitoramento e logging abrangentes:

Logging Estruturado:

import winston from "winston";

const logger = winston.createLogger({

format: winston.format.json(),

transports: [

new winston.transports.File({ filename: "error.log", level: "error" }),

new winston.transports.File({ filename: "combined.log" }),

],

});

logger.info("Ferramenta executada", {

toolName: "get_customer_info",

customerId: "cust_123",

duration: 145,

status: "success",

});

Coleta de Métricas:

import prometheus from "prom-client";

const toolExecutionDuration = new prometheus.Histogram({

name: "mcp_tool_execution_duration_ms",

help: "Duração da execução da ferramenta em milissegundos",

labelNames: ["tool_name", "status"],

});

const toolExecutionCounter = new prometheus.Counter({

name: "mcp_tool_executions_total",

help: "Número total de execuções de ferramentas",

labelNames: ["tool_name", "status"],

});

async function executeToolWithMetrics(toolName: string, args: any) {

const startTime = Date.now();

try {

const result = await executeTool(toolName, args);

const duration = Date.now() - startTime;

toolExecutionDuration.labels(toolName, "success").observe(duration);

toolExecutionCounter.labels(toolName, "success").inc();

return result;

} catch (error) {

const duration = Date.now() - startTime;

toolExecutionDuration.labels(toolName, "error").observe(duration);

toolExecutionCounter.labels(toolName, "error").inc();

throw error;

}

}

Construir um servidor MCP que conecta ao OpenAI representa um grande avanço na criação de aplicações inteligentes e integradas de IA. Seguindo os padrões arquiteturais, estratégias de implementação e melhores práticas apresentadas neste guia, você poderá criar servidores MCP robustos e escaláveis, ampliando as capacidades do OpenAI muito além do seu treinamento base.

O segredo do sucesso está no planejamento cuidadoso das definições das suas ferramentas, implementação rigorosa de medidas de segurança, testes abrangentes e monitoramento contínuo em produção. Comece com um conjunto simples de ferramentas, valide seu funcionamento com o OpenAI e expanda gradualmente as capacidades do seu servidor à medida que ganha confiança e experiência.

Lembre-se que seu servidor MCP não é um artefato estático—é um sistema vivo que evoluirá conforme as necessidades do seu negócio mudam e você descobre novas formas de aproveitar a IA em suas operações. Construa pensando em modularidade e extensibilidade, documente suas ferramentas cuidadosamente e mantenha uma separação clara entre sua lógica de negócios e a implementação do protocolo MCP.

A combinação de servidores MCP e os poderosos modelos de linguagem do OpenAI cria oportunidades inéditas para automação, inteligência e integração. Ao dominar essa tecnologia, você posiciona a si mesmo e sua organização na vanguarda da inovação movida por IA.

Automate your MCP server development, testing, and deployment workflows. From continuous integration to production monitoring, FlowHunt streamlines every step of your AI development lifecycle.

O Model Context Protocol é um framework padronizado que permite que modelos de IA como o GPT do OpenAI descubram, compreendam e executem ferramentas e funções fornecidas por servidores externos. Ele atua como uma ponte entre modelos de IA e lógica de negócios personalizada.

Você precisa de uma chave de API OpenAI válida com as permissões apropriadas. O próprio servidor MCP não exige permissões especiais do OpenAI—ele se comunica através de chamadas de API padrão. Entretanto, você deve implementar autenticação e autorização adequadas no seu servidor MCP.

Servidores MCP podem ser construídos em qualquer linguagem que suporte APIs HTTP/REST ou conexões WebSocket. As opções populares incluem Python, TypeScript/Node.js, Java, C#/.NET e Go. A escolha da linguagem depende da sua infraestrutura existente e da experiência da equipe.

Implemente limitação de taxa no lado do seu servidor MCP, faça cache de resultados solicitados com frequência, use recuo exponencial para tentativas e monitore o uso da API do OpenAI. Considere implementar um sistema de filas para as solicitações de ferramentas a fim de gerenciar a carga de forma eficaz.

Arshia é Engenheira de Fluxos de Trabalho de IA na FlowHunt. Com formação em ciência da computação e paixão por IA, ela se especializa em criar fluxos de trabalho eficientes que integram ferramentas de IA em tarefas do dia a dia, aumentando a produtividade e a criatividade.

Otimize o desenvolvimento, testes e implantação do seu servidor MCP com a plataforma de automação inteligente do FlowHunt.

Aprenda como construir e implantar um servidor Model Context Protocol (MCP) para conectar modelos de IA a ferramentas e fontes de dados externas. Guia passo a p...

Explore exemplos abrangentes de servidores MCP e aprenda como construir, implantar e integrar servidores Model Context Protocol para aprimorar as capacidades de...

Descubra o que são servidores MCP (Model Context Protocol), como funcionam e por que estão revolucionando a integração de IA. Veja como o MCP simplifica a conex...

Consentimento de Cookies

Usamos cookies para melhorar sua experiência de navegação e analisar nosso tráfego. See our privacy policy.