Introdução

A jornada de construir um protótipo funcional de IA até implantar um sistema em produção sempre foi um dos aspectos mais desafiadores do desenvolvimento de inteligência artificial. O que muitas vezes parece um processo simples em demonstrações — recuperar informações relevantes, complementar prompts e gerar respostas — torna-se exponencialmente mais complexo quando levado para ambientes de produção. Essa complexidade levou muitos na indústria a descreverem o processo como “alquimia” em vez de engenharia: um processo misterioso onde desenvolvedores ajustam configurações, alteram parâmetros e torcem para que seus sistemas continuem funcionando de forma confiável. O surgimento da engenharia de contexto como disciplina representa uma mudança fundamental em como abordamos a construção de sistemas de IA, migrando dessa metodologia de tentativa e erro para uma abordagem mais sistemática e engenheirada. Nesta exploração abrangente, vamos examinar como bancos de dados vetoriais modernos e princípios de engenharia de contexto estão transformando o cenário do desenvolvimento de aplicações de IA, permitindo que equipes construam sistemas não apenas funcionais, mas verdadeiramente confiáveis e sustentáveis em escala.

O que é Engenharia de Contexto e Por que Ela é Importante

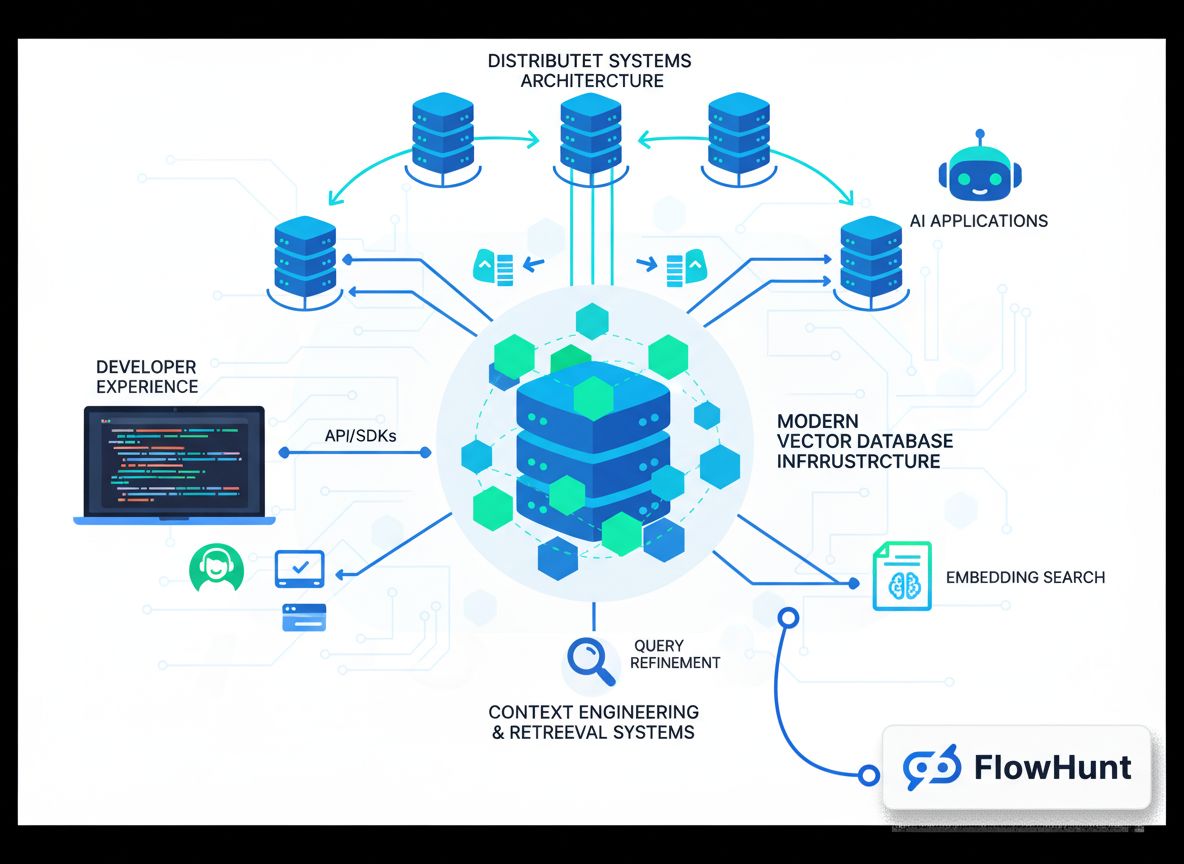

A engenharia de contexto surgiu como uma das disciplinas mais críticas no desenvolvimento de IA moderno, mas ainda é pouco compreendida por muitos desenvolvedores que entram na área. Em sua essência, engenharia de contexto é a prática de gerenciar, organizar e otimizar sistematicamente as informações contextuais que sistemas de IA usam para tomar decisões e gerar resultados. Diferente da tradicional Geração com Recuperação (RAG), que foca de forma restrita na recuperação de documentos relevantes para complementar um prompt antes de enviá-lo a um modelo de linguagem, a engenharia de contexto tem uma visão muito mais ampla de todo o pipeline. Ela inclui como os dados fluem pelo sistema, como as informações são armazenadas e indexadas, como ocorre a recuperação, como os resultados são ranqueados e filtrados e, por fim, como esse contexto é apresentado ao modelo. Essa perspectiva holística reconhece que a qualidade da saída de um sistema de IA é fundamentalmente limitada pela qualidade e relevância do contexto que recebe. Quando o contexto é mal gerenciado — quando informações irrelevantes são recuperadas, detalhes importantes são ignorados ou a mesma informação é processada várias vezes — todo o sistema se degrada. A engenharia de contexto resolve esses desafios tratando o gerenciamento de contexto como uma preocupação de engenharia de primeira classe, digna do mesmo rigor e atenção que aplicamos a outros componentes críticos de infraestrutura.

A importância da engenharia de contexto fica imediatamente aparente quando consideramos a escala na qual sistemas de IA modernos operam. Um modelo de linguagem pode ser solicitado a processar centenas de milhares de documentos, sintetizar informações de múltiplas fontes e gerar respostas coerentes a partir dessa síntese. Sem uma engenharia de contexto adequada, esse processo se torna caótico. Documentos irrelevantes poluem a janela de contexto, informações importantes se perdem no ruído e o desempenho do modelo se degrada. Além disso, à medida que os sistemas de IA se tornam mais sofisticados e são implantados em aplicações críticas — de atendimento ao cliente à diagnósticos médicos e análise financeira — as consequências de uma má engenharia de contexto aumentam drasticamente. Um sistema que ocasionalmente retorna informações irrelevantes pode ser aceitável para fins de entretenimento, mas se torna inaceitável quando está tomando decisões que afetam vidas ou meios de subsistência. A engenharia de contexto garante que a informação que flui pelo sistema não seja apenas abundante, mas realmente relevante, devidamente organizada e otimizada para a tarefa específica em questão.

Pronto para expandir seu negócio?

Comece seu teste gratuito hoje e veja resultados em dias.

A Evolução do Demo à Produção: O Problema da Alquimia

Um dos desafios mais persistentes no desenvolvimento de IA é o que veteranos da indústria chamam de “gap entre demo e produção”. Construir um protótipo funcional que demonstre capacidades de IA é relativamente simples. Um desenvolvedor pode rapidamente montar um modelo de linguagem, conectá-lo a um sistema de recuperação simples e criar algo que impressiona em um ambiente controlado. No entanto, no momento em que esse sistema precisa lidar com dados do mundo real em escala, manter confiabilidade ao longo do tempo e se adaptar a requisitos em constante mudança, tudo se torna dramaticamente mais difícil. Historicamente, esse gap era superado através do que só pode ser descrito como alquimia — uma combinação misteriosa de ajustes de configuração, mudanças de parâmetros e empirismo que, de alguma forma, resulta em um sistema funcional. O problema dessa abordagem é que ela não é reproduzível, escalável nem sustentável. Quando algo quebra em produção, muitas vezes não se sabe o motivo e consertar exige repetir todo o processo misterioso.

A causa raiz desse problema de alquimia está no fato de que a maioria das infraestruturas de IA não foi projetada pensando em sistemas de produção. Os primeiros bancos de dados vetoriais e sistemas de recuperação foram construídos principalmente para demonstrar a viabilidade da busca semântica e da recuperação baseada em embeddings. Funcionavam bem em ambientes controlados, com pequenos conjuntos de dados e padrões de consulta previsíveis. Mas quando você escala esses sistemas para lidar com milhões de documentos, milhares de usuários simultâneos e padrões de consulta imprevisíveis, eles frequentemente falham. Consistência dos dados se torna um problema. O desempenho das consultas degrada. O sistema se torna difícil de depurar e monitorar. Os desenvolvedores se veem gerenciando um artefato complexo e frágil que funciona através de uma combinação de sorte e intervenção constante, e não realmente engenheirando um sistema. É aí que entram a engenharia de contexto moderna e infraestrutura dedicada. Ao tratar a jornada do demo à produção como um desafio de engenharia legítimo, e construir sistemas especificamente desenhados para lidar com cargas de trabalho de produção, conseguimos transformar essa alquimia misteriosa em prática genuína de engenharia.

Entendendo a Infraestrutura de Busca Moderna para IA

A infraestrutura de busca tradicional, aquela que alimenta o Google e outros motores de busca, foi projetada com suposições específicas sobre como a busca seria usada. Esses sistemas foram feitos para lidar com consultas baseadas em palavras-chave de usuários humanos, que revisam os resultados e decidem quais links seguir. A infraestrutura foi otimizada para esse caso: correspondência rápida de palavras-chave, algoritmos de ranqueamento voltados para julgamento humano de relevância e apresentação dos resultados em forma de “dez links azuis” que humanos podem facilmente examinar. No entanto, sistemas de IA têm requisitos fundamentalmente diferentes. Quando um modelo de linguagem consome resultados de busca, ele não olha para dez links — pode processar ordens de magnitude mais informações. O modelo não precisa de resultados formatados para humanos; ele precisa de dados estruturados para raciocinar. As consultas não são baseadas em palavras-chave; são semânticas, baseadas em embeddings e similaridade vetorial. Essas diferenças fundamentais significam que a infraestrutura de busca tradicional é pouco adaptada para aplicações de IA.

A infraestrutura de busca moderna para IA aborda essas diferenças de várias maneiras. Primeiro, as ferramentas e tecnologias utilizadas são fundamentalmente diferentes. Em vez de índices de palavras-chave e algoritmos de ranqueamento otimizados para relevância humana, sistemas modernos usam embeddings vetoriais e medidas de similaridade semântica. Em vez de depender de palavras-chave explícitas, entendem o significado e a intenção por trás das consultas. Segundo, os padrões de carga de trabalho são diferentes. Sistemas de busca tradicionais lidam com consultas relativamente simples que retornam poucos resultados. Sistemas de IA frequentemente precisam recuperar grandes quantidades de documentos e processá-los de formas sofisticadas. Terceiro, os desenvolvedores que usam esses sistemas têm necessidades diferentes. Desenvolvedores de IA precisam de sistemas fáceis de integrar às suas aplicações, que ofereçam boa experiência de desenvolvedor e que não exijam profundo conhecimento em infraestrutura de busca para serem usados de forma eficaz. Por fim, e talvez mais importante, os consumidores dos resultados de busca são diferentes. Na busca tradicional, humanos fazem o trabalho final — decidem o que é relevante, abrem novas abas, sintetizam informações. Em sistemas de IA, o modelo de linguagem faz esse trabalho e pode lidar com muito mais informação do que humanos. Essa mudança fundamental em como os resultados são consumidos muda tudo sobre como a infraestrutura deve ser projetada.

Junte-se à nossa newsletter

Receba gratuitamente as últimas dicas, tendências e ofertas.

FlowHunt e o Futuro da Automação de Fluxos de Trabalho de IA

À medida que as organizações reconhecem a importância da engenharia de contexto e da infraestrutura de busca moderna, o desafio passa a ser como integrar essas capacidades aos fluxos de trabalho e processos de desenvolvimento existentes. É aí que plataformas como o FlowHunt entram, oferecendo um ambiente unificado para construir, testar e implantar aplicações de IA que dependem de gerenciamento sofisticado de contexto e sistemas de recuperação. O FlowHunt entende que engenharia de contexto não se resume a ter o banco de dados certo — trata-se de ter as ferramentas e fluxos de trabalho corretos para gerenciar o contexto ao longo de todo o ciclo de desenvolvimento de IA. Desde a ingestão e indexação inicial dos dados, passando pela recuperação e ranqueamento, até a inferência final do modelo e a geração das saídas, cada etapa do pipeline precisa ser cuidadosamente orquestrada e monitorada. O FlowHunt oferece capacidades de automação que tornam essa orquestração fluida, permitindo que desenvolvedores foquem na construção de ótimas aplicações de IA em vez de lidar com detalhes de infraestrutura.

A abordagem da plataforma para automação da engenharia de contexto é especialmente valiosa para equipes que constroem múltiplas aplicações de IA ou precisam gerenciar pipelines de recuperação complexos e em múltiplas etapas. Em vez de construir infraestrutura personalizada para cada aplicação, as equipes podem aproveitar componentes e fluxos de trabalho prontos do FlowHunt para acelerar o desenvolvimento. A plataforma cuida das tarefas tediosas de ingestão de dados, geração de embeddings, gerenciamento de índices e orquestração de recuperação, liberando os desenvolvedores para focar nos aspectos únicos de suas aplicações. Além disso, o FlowHunt oferece visibilidade e monitoramento que facilitam entender como o contexto está fluindo pelo sistema, identificar gargalos e otimizar o desempenho. Essa combinação de automação e visibilidade transforma a engenharia de contexto de um processo misterioso e experimental em uma disciplina sistemática e mensurável.

A Arquitetura de Bancos de Dados Vetoriais Prontos para Produção

Construir um banco de dados vetorial que funcione em uma demonstração é uma coisa; construir um que atenda cargas de trabalho de produção de forma confiável é outra bem diferente. Bancos de dados vetoriais prontos para produção precisam lidar com múltiplos usuários simultâneos, manter consistência dos dados, fornecer persistência confiável e escalar de forma eficiente à medida que o volume de dados cresce. Devem ser depuráveis quando algo sai errado, monitoráveis para que seja possível entender o comportamento do sistema, e sustentáveis para que as equipes possam evoluir o sistema ao longo do tempo. Essas exigências levaram ao desenvolvimento de arquiteturas modernas de bancos de dados vetoriais que incorporam princípios de sistemas distribuídos comprovados ao longo de décadas de uso real.

Um dos princípios arquiteturais mais importantes nos bancos de dados vetoriais modernos é a separação entre armazenamento e computação. Em bancos de dados monolíticos tradicionais, armazenamento e computação são fortemente acoplados — o mesmo servidor que armazena os dados também processa as consultas. Esse acoplamento gera problemas em escala. Se você precisa de mais poder de processamento, tem que adicionar mais armazenamento. Se precisa de mais capacidade de armazenamento, tem que adicionar mais computação. Essa ineficiência leva ao desperdício de recursos e a custos mais altos. Separando armazenamento e computação, bancos de dados vetoriais modernos permitem que cada componente escale de forma independente. O armazenamento pode ser gerenciado por soluções econômicas como o Amazon S3, enquanto recursos de computação podem ser ajustados conforme a demanda das consultas. Essa arquitetura oferece enorme flexibilidade e eficiência de custos. Outro princípio crítico é a multi-tenancy, que permite a uma única instância do banco de dados atender com segurança múltiplas aplicações ou equipes independentes. Multi-tenancy requer isolamento cuidadoso para garantir que os dados e as consultas de um cliente não interfiram nos de outro, mas quando implementada corretamente, melhora drasticamente a utilização dos recursos e reduz a complexidade operacional.

Bancos de dados vetoriais modernos também incorporam princípios de sistemas distribuídos que se tornaram padrão na última década. Isso inclui separação de leitura e escrita, onde operações de leitura e escrita são tratadas por componentes otimizados para suas cargas respectivas; replicação assíncrona, que assegura durabilidade dos dados sem comprometer o desempenho das escritas; e mecanismos de consenso distribuído que mantêm a consistência entre múltiplos nós. Esses princípios, combinados com linguagens modernas como Rust, que oferecem desempenho e segurança, permitem que bancos de dados vetoriais alcancem a confiabilidade e o desempenho exigidos por sistemas de produção. O resultado é uma infraestrutura que não parece alquimia — realmente parece engenharia.

A Abordagem do Chroma para a Experiência do Desenvolvedor

Quando o Chroma foi fundado, a equipe tinha uma tese clara: o gap entre construir um demo funcional de IA e implantar um sistema em produção parecia mais alquimia do que engenharia, e esse gap precisava ser superado. A abordagem da equipe foi começar com um foco obsessivo na experiência do desenvolvedor. Em vez de tentar construir o sistema mais robusto ou escalável possível, focaram em facilitar ao máximo o início do uso de bancos de dados vetoriais e busca semântica pelos desenvolvedores. Isso levou a uma das características mais marcantes do Chroma: a possibilidade de instalá-lo com um único comando pip e começar a usar imediatamente, sem configuração ou instalação de infraestrutura complexa. Essa simplicidade foi revolucionária no universo dos bancos de dados vetoriais. A maioria exige configurações e instalações significativas até que se possa rodar uma consulta básica. O Chroma eliminou essa fricção, tornando possível aos desenvolvedores experimentar bancos de dados vetoriais e busca semântica em minutos, não horas ou dias.

O compromisso com a experiência do desenvolvedor foi além da configuração inicial. A equipe do Chroma investiu pesado para garantir que o sistema funcionasse de forma confiável em diferentes arquiteturas e ambientes de implantação. Nos primeiros dias, usuários relatavam rodar o Chroma desde servidores Linux comuns até Arduinos e arquiteturas Power PC. Em vez de ignorar esses casos como exceções, a equipe do Chroma foi além para garantir que o sistema funcionasse de maneira confiável em todos eles. Esse compromisso com compatibilidade universal e confiabilidade construiu confiança na comunidade de desenvolvedores e contribuiu para a rápida adoção do Chroma. A equipe reconheceu que experiência do desenvolvedor não é só facilidade de uso — é confiabilidade, consistência e a confiança de que o sistema funcionará como esperado em diferentes ambientes e casos de uso.

À medida que o Chroma evoluiu e a equipe começou a construir o Chroma Cloud, enfrentaram uma decisão crítica. Poderiam ter lançado rapidamente uma versão hospedada do produto single-node, aproveitando o momento e a demanda por serviços gerenciados de bancos de dados vetoriais. Muitas empresas do setor fizeram essa escolha, o que lhes permitiu captar grandes investimentos e gerar impacto no mercado. No entanto, a equipe do Chroma tomou uma decisão diferente. Reconheceram que simplesmente hospedar o produto single-node como serviço não atenderia ao seu padrão de experiência do desenvolvedor. Um produto cloud realmente excelente precisava ser projetado do zero, com princípios nativos de nuvem em mente. Precisava oferecer a mesma facilidade de uso e confiabilidade do produto single-node, mas com a escalabilidade e robustez que sistemas de produção exigem. Essa decisão significou levar mais tempo para construir o Chroma Cloud, mas resultou em um produto que realmente cumpre a promessa de fazer a engenharia de contexto parecer engenharia e não alquimia.

As Quatro Dimensões do “IA” na Infraestrutura de Busca Moderna

Ao discutir a infraestrutura de busca moderna para IA, é importante reconhecer que “IA” significa coisas diferentes em contextos distintos. Na verdade, há quatro dimensões principais em que a infraestrutura moderna de busca difere dos sistemas tradicionais, e entender essas dimensões é crucial para construir aplicações de IA eficazes. A primeira dimensão é tecnológica. As ferramentas e tecnologias usadas na infraestrutura de busca moderna são fundamentalmente diferentes das utilizadas em sistemas tradicionais. Em vez de índices invertidos e correspondência por palavra-chave, os sistemas modernos usam embeddings vetoriais e similaridade semântica. Em vez de algoritmos de ranqueamento TF-IDF, usam redes neurais e funções de ranqueamento aprendidas. Essas diferenças tecnológicas refletem a natureza distinta dos problemas resolvidos e das capacidades dos sistemas de IA modernos.

A segunda dimensão são os padrões de carga de trabalho. Sistemas de busca tradicionais foram projetados para lidar com consultas simples, sem estado, que retornam poucos resultados. Sistemas modernos de IA frequentemente precisam lidar com pipelines de recuperação complexos e em múltiplas etapas, envolvendo várias rodadas de ranqueamento, filtragem e re-ranqueamento. Podem precisar recuperar milhares de documentos e processá-los de forma sofisticada. Os padrões de carga de trabalho são fundamentalmente diferentes, o que exige infraestrutura projetada para lidar com essas demandas de forma eficiente. A terceira dimensão é o desenvolvedor. Sistemas tradicionais de busca eram geralmente construídos e mantidos por engenheiros especializados em busca e recuperação de informação. Desenvolvedores modernos de IA, por outro lado, geralmente são generalistas que podem não ter conhecimento profundo em infraestrutura de busca, mas precisam construir aplicações que dependem de capacidades sofisticadas de recuperação. Isso significa que a infraestrutura moderna de busca precisa ser desenhada para facilidade de uso e acessibilidade, não apenas para poder e flexibilidade.

A quarta e talvez mais importante dimensão é o consumidor dos resultados da busca. Em sistemas tradicionais, humanos são os consumidores dos resultados. Humanos só podem digerir um número limitado de itens — tipicamente dez links — e fazem o trabalho final de determinar relevância e sintetizar informação. Em sistemas modernos de IA, modelos de linguagem são os consumidores dos resultados e podem processar ordens de magnitude mais informação do que humanos. Um modelo pode facilmente digerir centenas ou milhares de documentos e sintetizar informações de todos eles. Essa diferença fundamental no consumidor dos resultados muda tudo sobre como a infraestrutura deve ser desenhada. Significa que algoritmos de ranqueamento podem ser otimizados para consumo por máquinas em vez de humanos. Significa que a apresentação dos resultados pode ser otimizada para processamento por máquina e não para leitura humana. Significa que todo o pipeline pode ser desenhado assumindo que um sistema sofisticado de IA fará o trabalho final.

Construindo e Mantendo Visão em um Mercado Barulhento

O mercado de bancos de dados vetoriais em 2023 foi uma das categorias mais disputadas em infraestrutura de IA. Empresas levantavam enormes quantias de capital, faziam grandes anúncios e competiam para construir os sistemas mais completos possíveis. Nesse ambiente, seria fácil para o Chroma perder o foco, seguir cada tendência e tentar ser tudo para todos. Em vez disso, a equipe fez uma escolha deliberada de manter o foco em sua visão principal: construir um motor de recuperação para aplicações de IA que ofereça uma experiência excepcional ao desenvolvedor e realmente preencha o gap entre demo e produção. Esse foco exigiu disciplina e convicção, especialmente quando outras empresas captavam rodadas maiores e faziam anúncios mais impactantes.

O segredo para manter esse foco foi ter uma tese clara e contrária sobre o que realmente importava. A equipe do Chroma acreditava que o que realmente fazia a diferença não era a quantidade de recursos ou capital, mas sim a qualidade da experiência do desenvolvedor e a confiabilidade do sistema. Eles acreditavam que, fazendo uma coisa — construir um ótimo motor de recuperação — em nível mundial, ganhariam o direito de fazer mais coisas depois. Essa filosofia de foco maníaco em uma única competência central não é exclusiva do Chroma, mas se tornou cada vez mais rara no mundo das startups de venture capital, onde a pressão por crescimento rápido e grandes rodadas muitas vezes leva as empresas a se dispersarem demais. O compromisso da equipe do Chroma com essa filosofia, mesmo quando significou demorar mais para lançar o Chroma Cloud e eventualmente perder oportunidades de mercado de curto prazo, acabou se mostrando a escolha certa.

Manter a visão também exige atenção cuidadosa à contratação e formação de equipe. As pessoas que você traz moldam a cultura da organização, e a cultura determina o que e como você constrói. A equipe do Chroma reconheceu isso e optou por contratar de forma lenta e ser muito seletiva na escolha dos novos membros. Em vez de tentar crescer o mais rápido possível, focaram em contratar pessoas alinhadas com a visão, apaixonadas por qualidade e capazes de executar com independência e excelência. Essa abordagem significou um crescimento mais lento, mas garantiu que todos no time estavam realmente comprometidos com a missão e capazes de contribuir de forma significativa. Esse tipo de alinhamento cultural é difícil de alcançar em startups de crescimento rápido, mas é essencial para manter o foco e a visão no longo prazo.

A Importância do Ofício e da Qualidade na Infraestrutura

Um dos aspectos mais marcantes da abordagem da equipe do Chroma é a ênfase no ofício e na qualidade. No universo de infraestrutura, é fácil cair na armadilha de achar que mais recursos, desempenho ou escala são sempre melhores. Mas a equipe do Chroma percebeu que o que realmente importa é construir sistemas que funcionem de forma confiável, sejam fáceis de usar e realmente resolvam os problemas dos desenvolvedores. Essa ênfase em ofício e qualidade se manifesta de várias formas. Está na decisão de escrever o Chroma em Rust, uma linguagem que oferece desempenho e segurança, em vez de uma linguagem mais conveniente porém menos confiável. Está no compromisso de fazer o sistema funcionar em diferentes arquiteturas e ambientes de implantação, mesmo quando esses ambientes são incomuns ou exóticos. Está na decisão de levar mais tempo para construir o Chroma Cloud corretamente do que apressar um produto inferior para o mercado.

Essa ênfase em ofício e qualidade também se estende à forma como a equipe pensa sobre o problema. Em vez de ver a engenharia de contexto como um desafio técnico restrito a ser resolvido com algoritmos inteligentes, a equipe a enxerga como um desafio mais amplo, que abrange experiência do desenvolvedor, confiabilidade, escalabilidade e sustentabilidade. Essa perspectiva holística leva a melhores soluções porque reconhece que um sistema é tão bom quanto seu elo mais fraco. Um sistema pode ter os algoritmos de recuperação mais sofisticados do mundo, mas se é difícil de usar ou pouco confiável em produção, não está realmente resolvendo o problema. Ao focar em ofício e qualidade em todas as dimensões do sistema, o Chroma construiu algo que realmente serve aos desenvolvedores e realmente preenche o gap entre demo e produção.

Implicações Práticas para Equipes de Desenvolvimento de IA

Para equipes que constroem aplicações de IA, as lições da abordagem do Chroma trazem várias implicações práticas. Primeiro, é importante reconhecer que engenharia de contexto não é uma tarefa paralela no desenvolvimento de IA — é parte da tarefa principal. A qualidade do seu sistema de IA é fundamentalmente limitada pela qualidade do contexto que ele recebe, então investir em infraestrutura adequada de engenharia de contexto não é opcional. É essencial. Segundo, vale a pena ser cético em relação a sistemas que prometem fazer tudo. Os sistemas mais confiáveis e eficazes geralmente são aqueles que fazem uma coisa muito bem e a partir daí evoluem. Se você está avaliando bancos de dados vetoriais ou sistemas de recuperação, procure aqueles com um foco claro e compromisso em fazer uma coisa em nível mundial. Terceiro, experiência do desenvolvedor importa. Um sistema teoricamente mais poderoso, mas difícil de usar, será no fim das contas menos valioso que um sistema um pouco menos poderoso, porém fácil de usar. Isso porque desenvolvedores realmente usarão o sistema fácil e construirão ótimas soluções com ele, enquanto terão dificuldades ou desistirão do sistema difícil.

Quarto, confiabilidade e consistência importam mais do que você imagina. Nos estágios iniciais do desenvolvimento de IA, é tentador priorizar recursos e desempenho em detrimento da confiabilidade. Mas à medida que seus sistemas vão para produção e passam a lidar com cargas reais, a confiabilidade se torna fundamental. Um sistema 95% confiável pode parecer aceitável, mas se você executa milhões de consultas por dia, essa taxa de falha de 5% significa centenas de milhares de consultas com erro. Investir em confiabilidade desde o início é muito mais barato do que tentar remediar depois. Por fim, é importante pensar na trajetória de longo prazo dos seus sistemas. A infraestrutura que você escolhe hoje moldará o que poderá construir amanhã. Escolher infraestruturas desenhadas para produção desde o início, que escalam de forma eficiente e oferecem boa visibilidade e monitoramento, trará grandes benefícios à medida que seus sistemas crescem e evoluem.

{{ cta-dark-panel

heading=“Impulsione Seu Fluxo de Trabalho com o FlowHunt”

description=“Veja como o FlowHunt automatiza seus fluxos de conteúdo e SEO em IA — da pesquisa e geração de conteúdo à publicação e análise — tudo em um só lugar.”

ctaPrimaryText=“Agende uma Demonstração”

ctaPrimaryURL=“https://calendly.com/liveagentsession/flowhunt-chatbot-demo"

ctaSecondaryText=“Experimente FlowHunt Grátis”

ctaSecondaryURL=“https://app.flowhunt.io/sign-in"

gradientStartColor="#123456”

gradientEndColor="#654321”

gradientId=“827591b1-ce8c-4110-b064-7cb85a0b1217”

}}

O Papel do Open Source na Construção de Confiança e Comunidade

Uma das decisões mais importantes da equipe do Chroma foi tornar o produto principal open source. Essa decisão teve várias implicações relevantes. Primeiro, construiu confiança com a comunidade de desenvolvedores. Quando os desenvolvedores podem ver o código, entender como o sistema funciona e contribuir com melhorias, é muito mais provável que confiem e adotem o sistema. O código aberto também cria um ciclo virtuoso, onde contribuições da comunidade melhoram o produto, atraindo mais usuários, o que leva a mais contribuições. Segundo, abrir o produto gerou uma comunidade forte em torno do Chroma. Desenvolvedores que usam o produto se envolvem em seu sucesso, tornando-se mais propensos a contribuir, dar feedback e recomendar o produto a outros. Essa comunidade se torna um ativo valioso, difícil de ser replicado por concorrentes.

Terceiro, o open source proporciona um caminho natural para monetização através de serviços hospedados. Ao tornar o produto principal open source, o Chroma criou uma situação em que desenvolvedores podem usar o produto gratuitamente se quiserem operar por conta própria, mas muitos preferem usar a versão gerenciada, que cuida de operações, escalabilidade e manutenção. Esse é o modelo representado pelo Chroma Cloud. Ao oferecer uma experiência hospedada superior e mantendo o produto principal aberto, o Chroma atende tanto a comunidade self-hosted quanto o mercado de serviços gerenciados. Essa abordagem tem se mostrado mais sustentável e mais alinhada com as preferências dos desenvolvedores do que manter o produto fechado e proprietário.

Medindo Sucesso: Métricas que Importam

Ao avaliar o sucesso de projetos de infraestrutura como o Chroma, é importante focar em métricas que realmente refletem o valor entregue. O Chroma conquistou métricas impressionantes sob qualquer padrão: mais de 21.000 estrelas no GitHub, mais de 5 milhões de downloads mensais e mais de 60-70 milhões de downloads no total. Esses números refletem a ampla adoção do projeto pela comunidade de desenvolvedores. Mas além desses números de destaque, o que realmente importa é se o projeto está resolvendo os problemas enfrentados pelos desenvolvedores. Está tornando mais fácil construir aplicações de IA? Está reduzindo o tempo e o esforço do demo à produção? Está permitindo que desenvolvedores construam sistemas mais confiáveis? A resposta para todas essas perguntas parece ser sim, com base no feedback da comunidade e na rápida adoção do projeto.

Outra métrica relevante é a qualidade da comunidade e a natureza das contribuições. O Chroma atraiu contribuições de desenvolvedores de toda a indústria, incluindo integrações com frameworks populares como LangChain e Llama Index. Essa ampla adoção e integração com outras ferramentas do ecossistema é sinal de que o Chroma resolve problemas reais e gera valor genuíno. O fato de o Chroma ter se tornado a escolha padrão para funcionalidade de banco de dados vetorial em muitos frameworks populares de IA é um testemunho da qualidade do produto e da força da comunidade. Essas métricas qualitativas — adoção pela comunidade, integração com outras ferramentas e feedback positivo dos usuários — muitas vezes são mais relevantes do que números brutos de downloads.

O Futuro da Engenharia de Contexto e da Infraestrutura de IA

À medida que sistemas de IA se tornam mais sofisticados e amplamente implantados, a importância da engenharia de contexto só tende a aumentar. Os sistemas que estão sendo construídos hoje são apenas o começo. No futuro, provavelmente veremos abordagens ainda mais sofisticadas de gerenciamento de contexto, incluindo sistemas que ajustam dinamicamente o contexto para a tarefa específica, que aprendem com feedback para melhorar a qualidade da recuperação e que lidam com múltiplas modalidades de dados (texto, imagem, áudio, vídeo) de forma integrada. A infraestrutura para sustentar esses sistemas avançados precisará ser ainda mais sofisticada do que a existente, mas os princípios permanecerão os mesmos: foco na experiência do desenvolvedor, compromisso com confiabilidade e qualidade, e visão clara dos problemas que se busca resolver.

O papel de plataformas como o FlowHunt também se tornará cada vez mais importante. À medida que a engenharia de contexto se torna central no desenvolvimento de IA, as equipes precisarão de ferramentas que facilitem construir, testar e implantar pipelines sofisticados de gerenciamento de contexto. A abordagem do FlowHunt de oferecer automação e visibilidade ao longo de todo o ciclo de desenvolvimento de IA o posiciona muito bem para atender essa demanda. Ao abstrair a complexidade da infraestrutura de engenharia de contexto e fornecer ferramentas de alto nível para construção de aplicações de IA, plataformas como o FlowHunt permitem que desenvolvedores foquem em construir ótimas aplicações, em vez de lidar com detalhes de infraestrutura.

Conclusão

A engenharia de contexto representa uma mudança fundamental em como abordamos a construção de sistemas de IA, migrando de uma abordagem baseada em tentativa e erro e alquimia para uma disciplina sistemática e engenheirada. Bancos de dados vetoriais modernos como o Chroma, construídos sobre princípios de separação entre armazenamento e computação, multi-tenancy e arquitetura de sistemas distribuídos, fornecem a base para essa mudança. Ao combinar essas melhorias de infraestrutura com compromisso com experiência do desenvolvedor, confiabilidade e excelência, as equipes podem construir sistemas de IA que realmente funcionam em produção e escalam de forma sustentável conforme crescem as demandas. As lições da abordagem do Chroma — manter o foco na visão central, contratar para alinhamento cultural, priorizar qualidade em vez de recursos e construir comunidade através do open source — oferecem um roteiro para outros projetos de infraestrutura e para equipes que desenvolvem aplicações de IA. À medida que o campo da IA continua a evoluir e amadurecer, a importância de acertar na engenharia de contexto só aumentará, tornando este um dos focos mais críticos para quem constrói sistemas de IA.