Transformers da Hugging Face

Hugging Face Transformers é uma biblioteca Python open-source líder que facilita a implementação de modelos Transformer para tarefas de machine learning em PLN,...

Automação de IA

Um guia abrangente sobre estratégias modernas de pré-treinamento de modelos de linguagem, técnicas de curadoria de dados e métodos de otimização usados pela HuggingFace para construir modelos open-source eficientes e de alto desempenho.

O cenário do desenvolvimento de modelos de linguagem passou por uma mudança fundamental nos últimos anos. Enquanto grandes empresas de tecnologia continuam a expandir os limites do tamanho dos modelos, a comunidade open-source descobriu que desempenho excepcional não exige modelos com trilhões de parâmetros. Este guia abrangente explora as técnicas e estratégias de ponta usadas por pesquisadores da HuggingFace para construir modelos de linguagem eficientes e de alto desempenho por meio de metodologias rigorosas de pré-treinamento. Vamos examinar como SmolLM 3, FineWeb e FinePDF representam um novo paradigma no desenvolvimento de modelos—focado em maximizar o desempenho dentro de restrições computacionais práticas, mantendo rigor científico e reprodutibilidade. Os insights aqui compartilhados representam meses de pesquisa e experimentação, oferecendo uma masterclass sobre como abordar o pré-treinamento de modelos na era moderna.

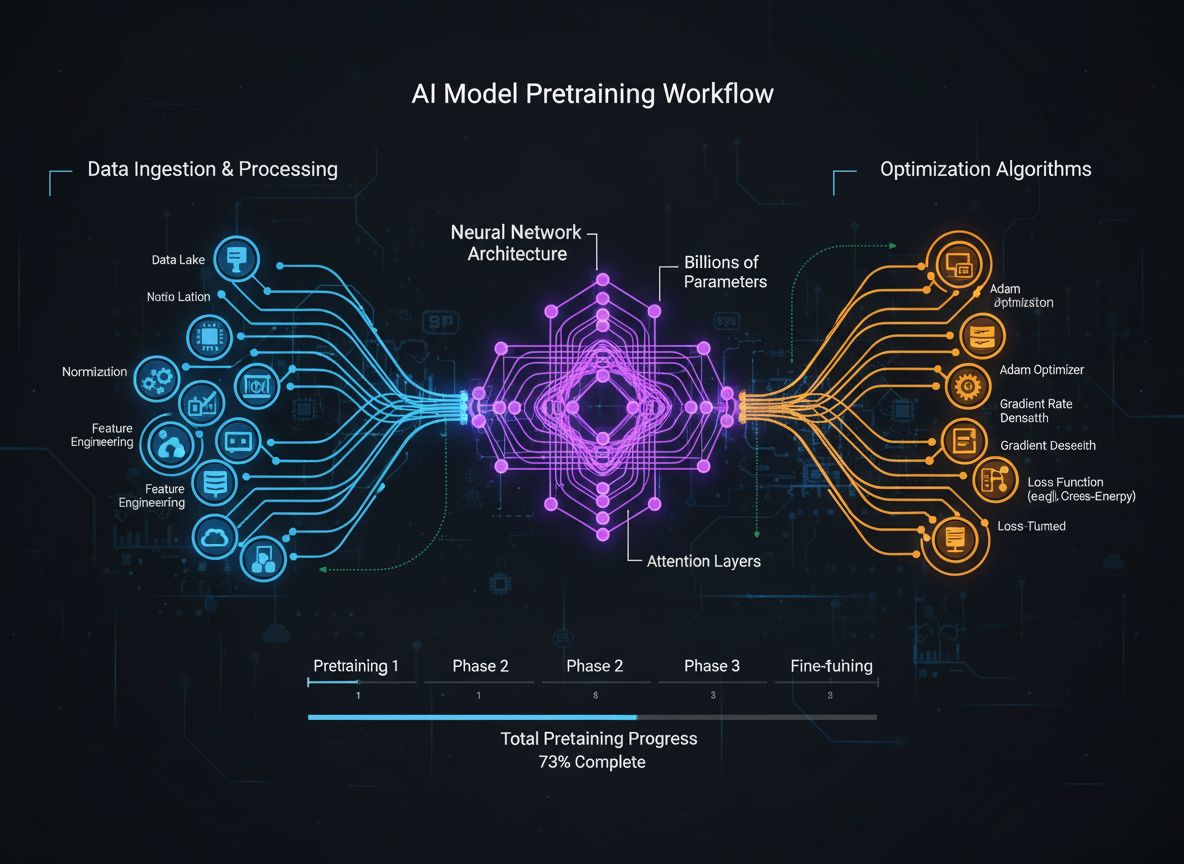

O pré-treinamento de modelos de linguagem evoluiu de um processo relativamente simples de alimentar redes neurais com texto bruto para uma disciplina sofisticada envolvendo múltiplos objetivos de otimização interconectados. Em essência, o pré-treinamento expõe o modelo a grandes quantidades de dados de texto, permitindo que ele aprenda padrões estatísticos da linguagem por aprendizado auto-supervisionado. No entanto, a abordagem moderna reconhece que simplesmente escalar dados e computação é insuficiente. Em vez disso, os pesquisadores precisam orquestrar cuidadosamente múltiplas dimensões do processo de treinamento—da seleção e curadoria de dados às escolhas arquiteturais e algoritmos de otimização. O campo amadureceu a ponto de entender que esses detalhes separam modelos de ponta de modelos medianos. Essa evolução reflete uma compreensão mais profunda de que o desempenho do modelo não é determinado por um único fator, mas pela orquestração cuidadosa de múltiplos objetivos, em certa medida ortogonais, que podem ser otimizados em paralelo. A comunidade de pesquisa tem reconhecido cada vez mais que o “ingrediente secreto” do desenvolvimento de modelos bem-sucedidos está nas escolhas inteligentes de design em todas as etapas do pipeline de treinamento, e não apenas na escala bruta.

Uma das lições mais importantes das pesquisas recentes é que a qualidade e a diversidade dos dados de treinamento determinam fundamentalmente o desempenho do modelo, mais do que a quantidade absoluta de dados. Este princípio, frequentemente resumido como “lixo entra, lixo sai”, tem sido cada vez mais validado por pesquisas empíricas e pela experiência prática. Quando modelos são treinados em dados mal curados, duplicados ou de baixa qualidade, eles aprendem padrões espúrios e falham em generalizar para novas tarefas. Por outro lado, conjuntos de dados cuidadosamente selecionados, deduplicados e filtrados permitem que os modelos aprendam de forma mais eficiente e alcancem melhores desempenhos com menos etapas de treinamento. As implicações deste insight são profundas: significa que organizações e pesquisadores devem investir pesadamente em curadoria e garantia de qualidade dos dados, em vez de simplesmente acumular mais dados brutos. Essa mudança de perspectiva levou ao surgimento de equipes e ferramentas especializadas inteiramente voltadas para criação e refinamento de conjuntos de dados. O FineWeb, com mais de 18,5 trilhões de tokens de dados web em inglês limpos e deduplicados, exemplifica essa abordagem. Em vez de usar dados brutos do CommonCrawl, a equipe do FineWeb implementou filtragem sofisticada, deduplicação e técnicas de avaliação de qualidade para criar um conjunto de dados que supera consistentemente alternativas maiores e não processadas. Isso representa uma realização fundamental no campo: o caminho para modelos melhores passa por dados melhores, não necessariamente por mais dados.

O pré-treinamento moderno de modelos pode ser compreendido por meio de cinco objetivos interconectados, mas em certa medida ortogonais, que os pesquisadores devem otimizar simultaneamente. Compreender esses pilares fornece uma estrutura para pensar sobre todo o processo de treinamento e identificar onde melhorias podem ser feitas. O primeiro pilar envolve maximizar a relevância e a qualidade das informações brutas nos dados de treinamento. Isso abrange tanto a qualidade dos pontos de dados individuais quanto a diversidade do conjunto de dados como um todo. Um modelo treinado com dados de alta qualidade e diversidade aprenderá padrões mais generalizáveis do que um treinado em dados restritos ou de baixa qualidade, independentemente de outras otimizações. O segundo pilar foca no design arquitetural do modelo, que determina o quão eficientemente ele processa informações e quais restrições computacionais deve respeitar. As escolhas arquiteturais afetam a velocidade de inferência, consumo de memória, requisitos de cache KV e a capacidade do modelo de rodar em diferentes configurações de hardware. O terceiro pilar envolve maximizar a informação extraída dos dados de treinamento em cada etapa. Isso inclui técnicas como destilação de conhecimento, onde modelos menores aprendem com modelos maiores, e previsão multi-token, onde o modelo prevê vários tokens futuros simultaneamente. O quarto pilar aborda a qualidade dos gradientes e as dinâmicas de otimização, incluindo a escolha do otimizador, agendamento da taxa de aprendizado e técnicas para manter a estabilidade do treinamento. O quinto pilar envolve ajuste de hiperparâmetros e estratégias de escalabilidade para garantir que o treinamento permaneça estável à medida que os modelos crescem e evitar problemas como explosão de gradientes ou divergência de ativações. Esses cinco pilares não são independentes—eles interagem de formas complexas—mas pensá-los separadamente ajuda a identificar quais áreas precisam de atenção e onde as melhorias mais impactantes podem ser feitas.

O FineWeb representa um divisor de águas na criação de conjuntos de dados para pré-treinamento de modelos de linguagem. Em vez de aceitar o resultado bruto de rastreadores web como o CommonCrawl, a equipe da HuggingFace implementou um pipeline abrangente para limpar, filtrar e deduplicar dados web em escala massiva. O conjunto resultante contém mais de 18,5 trilhões de tokens de texto em inglês de alta qualidade, tornando-o um dos maiores conjuntos curados disponíveis para a comunidade open-source. A criação do FineWeb envolveu múltiplas etapas de processamento, cada uma projetada para remover conteúdo de baixa qualidade enquanto preserva informações valiosas. A equipe implementou algoritmos sofisticados de deduplicação para eliminar conteúdo redundante, filtros de qualidade para remover spam e páginas ruins, e detecção de idioma para garantir que o conjunto seja majoritariamente em inglês. O que torna o FineWeb particularmente valioso não é apenas seu tamanho, mas a validação empírica de que produz melhor desempenho de modelos do que alternativas maiores e não processadas. Quando misturado a outros conjuntos, o FineWeb supera consistentemente conjuntos de dados brutos muito maiores, demonstrando que qualidade realmente supera quantidade. As curvas de desempenho mostram que modelos treinados no FineWeb alcançam melhores resultados em benchmarks padrão em comparação a modelos treinados em conjuntos de tamanho semelhante de outras fontes. Esse sucesso inspirou a comunidade de pesquisa a investir mais na curadoria de dados, reconhecendo que é aí que ganhos significativos podem ser obtidos. O FineWeb está disponível gratuitamente para pesquisadores, democratizando o acesso a dados de treinamento de alta qualidade e permitindo que pequenas organizações e equipes acadêmicas treinem modelos competitivos.

Enquanto o FineWeb focou em dados web, a equipe da HuggingFace reconheceu que outra fonte massiva de texto de alta qualidade havia sido largamente negligenciada: documentos PDF. PDFs contêm grandes volumes de informações estruturadas e de alta qualidade, incluindo artigos acadêmicos, documentação técnica, livros e relatórios profissionais. No entanto, extrair texto de PDFs é tecnicamente desafiador, e abordagens anteriores não exploraram sistematicamente essa fonte em escala. O FinePDF representa o primeiro esforço abrangente para extrair, limpar e curar dados de PDF para pré-treinamento de modelos de linguagem. A equipe implementou um pipeline sofisticado que aborda os desafios únicos do processamento de PDFs, incluindo lidar com layouts complexos, extrair texto com precisão de documentos com múltiplas colunas e tratar imagens e tabelas embutidas. Um aspecto particularmente inovador do pipeline FinePDF é a etapa de “refetch from internet”, que resolve um problema crítico: PDFs armazenados no CommonCrawl frequentemente são mal extraídos ou desatualizados. Ao recuperar os PDFs de suas fontes originais na internet, a equipe garante acesso às versões de maior qualidade dos documentos. Os resultados são impressionantes—quando misturado a outros conjuntos, o FinePDF demonstra desempenho muito forte em comparação a baselines recentes como o NeoTron B2. O conjunto fornece uma nova fonte de dados de alta qualidade que complementa os dados web e permite que os modelos aprendam a partir de informações mais diversas e estruturadas. Este trabalho abre novas possibilidades para criação de conjuntos de dados, sugerindo que outras fontes pouco exploradas podem trazer benefícios semelhantes. O pipeline FinePDF está sendo documentado em detalhes por meio de posts e documentação técnica, permitindo que outros pesquisadores construam sobre este trabalho e apliquem técnicas similares a outras fontes de dados.

O SmolLM 3 representa o ápice da aplicação dessas técnicas de curadoria de dados e otimização de treinamento para criar um modelo de linguagem altamente eficiente. Com 3 bilhões de parâmetros, o SmolLM 3 é significativamente menor do que muitos modelos contemporâneos, mas alcança desempenho competitivo graças à otimização cuidadosa em todos os cinco pilares do treinamento de modelos. O modelo suporta raciocínio em dois modos, capacidades multilíngues em seis idiomas e compreensão de longo contexto, tornando-o notavelmente versátil apesar de seu tamanho modesto. O desenvolvimento do SmolLM 3 envolveu escolhas arquiteturais precisas para maximizar a eficiência. A equipe selecionou uma arquitetura transformer que equilibra eficiência computacional e capacidade de modelagem, implementando técnicas como grouped query attention para reduzir consumo de memória e latência de inferência. O modelo foi treinado em três estágios progressivos que aumentam o desempenho em diferentes domínios, permitindo otimizar capacidades específicas em cada fase. O que torna o SmolLM 3 particularmente significativo é que ele demonstra que a comunidade open-source agora pode produzir modelos que rivalizam com modelos proprietários muito maiores em várias tarefas. Isso desafia a suposição de que maior é sempre melhor e sugere que o campo pode ter atingido um platô em relação aos benefícios do puro aumento de escala. Em vez disso, o foco está mudando para eficiência, interpretabilidade e capacidades práticas de implantação. O SmolLM 3 pode rodar em hardwares de consumidor, dispositivos de borda e ambientes restritos em recursos, tornando capacidades avançadas de IA acessíveis a um público muito mais amplo. Suas capacidades multilíngues e de longo contexto mostram que eficiência não exige sacrificar recursos importantes.

A destilação de conhecimento é uma técnica poderosa que permite que modelos menores se beneficiem do conhecimento aprendido por modelos maiores. Em vez de treinar um modelo pequeno do zero com dados brutos, a destilação envolve treinar o modelo pequeno para imitar as saídas de um modelo maior e mais capaz. Essa abordagem é particularmente valiosa no pré-treinamento porque permite que o modelo menor aprenda padrões que o modelo maior já descobriu, acelerando o aprendizado e melhorando o desempenho final. A mecânica da destilação envolve treinar o modelo estudante (o menor) para igualar as distribuições de probabilidade produzidas pelo modelo professor (o maior). Isso é feito tipicamente minimizando a divergência entre as distribuições de saída do estudante e do professor, frequentemente usando técnicas como a divergência KL. O parâmetro de temperatura controla o quão “suaves” são as distribuições de probabilidade—temperaturas mais altas tornam as distribuições mais suaves, fornecendo mais informação sobre a confiança relativa entre diferentes previsões. A destilação de conhecimento tem se mostrado especialmente eficaz no contexto de pré-treinamento de modelos de linguagem porque permite transferir o conhecimento de modelos grandes para modelos menores e mais eficientes. Isso é valioso especialmente para organizações que querem implantar modelos em dispositivos de borda ou ambientes restritos, mas ainda desejam se beneficiar das capacidades dos modelos maiores. A técnica tem se tornado cada vez mais sofisticada, com pesquisadores explorando métodos como transferência de atenção, onde o estudante aprende também a imitar os padrões de atenção do professor, e destilação baseada em características, onde representações intermediárias de camadas são equiparadas.

O treinamento tradicional de modelos de linguagem foca na previsão do próximo token—o modelo aprende a prever o próximo token com base em todos os anteriores. No entanto, pesquisas recentes mostram que treinar modelos para prever múltiplos tokens futuros simultaneamente pode melhorar significativamente o desempenho, especialmente em tarefas de programação e problemas de raciocínio complexo. A previsão multi-token força o modelo a aprender dependências de longo alcance e desenvolver uma compreensão mais profunda dos padrões subjacentes nos dados. A abordagem envolve adicionar múltiplas cabeças de previsão ao modelo, cada uma responsável por prever um token em posições futuras diferentes. Durante o treinamento, o modelo recebe sinais de perda de todas essas cabeças simultaneamente, incentivando-o a aprender representações úteis para prever vários passos à frente. Isso é mais desafiador do que a previsão do próximo token, mas resulta em representações aprendidas melhores. Os benefícios da previsão multi-token vão além do desempenho no objetivo de treinamento. Modelos treinados dessa forma frequentemente mostram melhor desempenho em tarefas posteriores, melhor generalização para novos domínios e capacidades de raciocínio aprimoradas. A técnica é especialmente eficaz para geração de código, onde entender dependências de longo alcance é crucial para gerar código sintaticamente e semanticamente correto. Pesquisas mostram que a previsão multi-token pode melhorar o desempenho dos modelos em 5-15% em vários benchmarks, tornando-a uma das técnicas de treinamento mais impactantes descobertas nos últimos anos. A abordagem é relativamente simples de implementar, mas exige ajuste cuidadoso do número de cabeças de previsão e do peso das perdas de cada cabeça.

Durante anos, o otimizador AdamW foi a escolha padrão para treinamento de grandes modelos de linguagem. O AdamW combina atualizações de gradiente baseadas em momento com decaimento de peso, proporcionando treinamento estável e boa convergência. No entanto, pesquisas recentes mostram que o AdamW pode não ser o ideal para todos os cenários de treinamento, especialmente ao escalar para modelos muito grandes. Novos otimizadores como Muon e King K2 exploram abordagens alternativas que podem fornecer dinâmicas de treinamento melhores e desempenho superior. O principal insight desses novos otimizadores é que a matriz Hessiana—que capta informações sobre a curvatura da superfície de perda—pode ser melhor aproximada usando técnicas como os métodos de Newton-Schulz. Mantendo uma melhor aproximação da Hessiana, esses otimizadores podem fornecer atualizações de gradiente mais informativas, levando a convergência mais rápida e melhor desempenho final. O Muon, por exemplo, usa uma técnica chamada iteração de Newton-Schulz para ortogonalizar a matriz de gradientes, o que espalha o aprendizado por mais dimensões do que abordagens baseadas em momento tradicionais. Isso resulta em treinamento mais estável e incentiva o modelo a explorar novas regiões do espaço de parâmetros, em vez de seguir a mesma trajetória de otimização do AdamW. O King K2 segue uma abordagem diferente, rastreando quantidades como o log máximo por cabeça e usando essa informação para ajustar de forma adaptativa taxas de aprendizado e clipping de gradientes. As implicações da inovação em otimizadores são significativas. Muitos praticantes continuam usando o AdamW com hiperparâmetros otimizados para modelos muito menores, mesmo quando treinam modelos com ordens de magnitude mais parâmetros. Isso sugere que ganhos significativos de desempenho podem ser alcançados apenas atualizando escolhas de otimizadores e hiperparâmetros para modelos modernos e de grande escala. A comunidade de pesquisa reconhece cada vez mais que a escolha do otimizador não é um problema resolvido e que a inovação contínua nessa área pode gerar melhorias substanciais na eficiência do treinamento e no desempenho final dos modelos.

Manter gradientes de alta qualidade durante todo o treinamento é essencial para alcançar bom desempenho de modelo. À medida que os modelos escalam para bilhões ou trilhões de parâmetros, o treinamento se torna cada vez mais instável, com gradientes propensos à explosão ou desaparecimento. Enfrentar esses problemas exige atenção cuidadosa à qualidade dos gradientes e implementação de técnicas que mantenham a estabilidade do treinamento em todo o processo. Uma abordagem para melhorar a qualidade dos gradientes envolve técnicas como clipping de gradientes, que previnem que eles se tornem grandes demais e desestabilizem o treinamento. No entanto, o clipping ingênuo pode descartar informações valiosas. Abordagens mais sofisticadas envolvem normalizar gradientes de formas que preservam informação enquanto previnem instabilidade. Outra consideração importante é a escolha das funções de ativação e técnicas de normalização de camadas. Diferentes funções de ativação possuem propriedades diferentes quanto ao fluxo de gradientes, e escolhas cuidadosas podem impactar significativamente a estabilidade do treinamento. A normalização de camadas, que normaliza ativações ao longo da dimensão de recursos, tornou-se padrão em transformers pois fornece melhor fluxo de gradientes do que batch normalization. O agendamento da taxa de aprendizado também é crucial para manter a qualidade dos gradientes. Uma taxa de aprendizado alta demais pode causar explosão de gradientes, enquanto uma muito baixa pode resultar em convergência lenta ou travamento em mínimos locais. O treinamento moderno frequentemente usa schedules que começam com fase de aquecimento, aumentando gradualmente a taxa de aprendizado para deixar o modelo se estabilizar em uma boa região do espaço de parâmetros, seguida de uma fase de decaimento para reduzir a taxa à medida que o treinamento avança. Entender e otimizar esses aspectos é crucial para treinar modelos grandes com sucesso, e representa uma área onde ainda há muita pesquisa em andamento.

A complexidade do pré-treinamento moderno de modelos—com seus múltiplos objetivos de otimização, pipelines sofisticados de dados e ajuste cuidadoso de hiperparâmetros—cria desafios significativos para equipes que desejam implementar essas técnicas. O FlowHunt resolve esses desafios ao fornecer uma plataforma para automatizar e orquestrar fluxos complexos de treinamento de modelos. Em vez de gerenciar manualmente processamento de dados, treinamento e avaliação de modelos, equipes podem usar o FlowHunt para definir fluxos que cuidam automaticamente dessas tarefas, reduzindo erros e melhorando a reprodutibilidade. As capacidades de automação do FlowHunt são especialmente valiosas para as etapas de curadoria e processamento de dados, tão críticas para o desempenho do modelo. A plataforma pode implementar automaticamente pipelines sofisticados como os usados no FineWeb e FinePDF, incluindo deduplicação, filtragem de qualidade e conversão de formatos. Isso permite que as equipes foquem nas decisões estratégicas sobre quais dados incluir e como processá-los, em vez de se perderem nos detalhes de implementação. Além disso, o FlowHunt pode ajudar no gerenciamento do ajuste de hiperparâmetros e experimentação necessários para otimizar o treinamento dos modelos. Automatizando o processo de execução de múltiplos experimentos de treinamento com diferentes hiperparâmetros e coleta de resultados, o FlowHunt permite explorar o espaço de parâmetros com mais eficiência e identificar configurações ideais mais rapidamente. A plataforma também oferece ferramentas para monitorar o progresso do treinamento, detectar problemas como explosão ou divergência de gradientes e ajustar automaticamente parâmetros para manter a estabilidade. Para organizações que constroem seus próprios modelos de linguagem ou fazem fine-tuning de modelos existentes, o FlowHunt pode reduzir significativamente o tempo e esforço necessários, melhorando a qualidade dos resultados.

Um dos aspectos mais desafiadores do treinamento de modelos é entender como escalar de modelos pequenos para grandes mantendo estabilidade e desempenho. A relação entre tamanho do modelo e hiperparâmetros ideais não é linear—hiperparâmetros que funcionam bem em modelos pequenos frequentemente precisam ser ajustados para modelos maiores. Isso é especialmente verdadeiro para taxas de aprendizado, que geralmente precisam ser reduzidas conforme os modelos aumentam. Compreender leis de escala é crucial para prever como os modelos vão performar em diferentes escalas e para tomar decisões sobre alocação de recursos. Pesquisas mostram que o desempenho dos modelos segue leis de escala previsíveis, onde o desempenho melhora como uma função de potência do tamanho do modelo, tamanho do conjunto de dados e orçamento computacional. Essas leis permitem prever quanto ganho se pode esperar ao aumentar o tamanho do modelo ou do conjunto de dados, permitindo decisões mais informadas sobre onde investir recursos. No entanto, as leis de escala não são universais—dependem da arquitetura, procedimento de treinamento e conjunto de dados usados. Isso significa que equipes precisam conduzir seus próprios experimentos de escala para entender como sua configuração específica se comporta. O processo de escalar de modelos pequenos para grandes também exige atenção cuidadosa à estabilidade do treinamento. À medida que crescem, modelos tornam-se mais propensos a instabilidades como explosão de gradientes ou divergência. Lidar com esses problemas requer técnicas como clipping de gradientes, agendamento cuidadoso da taxa de aprendizado e, potencialmente, mudanças na arquitetura ou otimizador. A comunidade de pesquisa reconhece cada vez mais que escalabilidade não é apenas aumentar modelos, mas gerenciar cuidadosamente o processo de treinamento para garantir que modelos maiores possam ser treinados efetivamente.

Aprendizagem de características refere-se ao processo pelo qual modelos aprendem a extrair características úteis de dados brutos durante o treinamento. No contexto do pré-treinamento de modelos de linguagem, envolve o modelo aprender a representar conceitos linguísticos, relações semânticas e padrões sintáticos em suas representações internas. Maximizar a aprendizagem de características—garantindo que o modelo extraia o máximo de informação útil dos dados em cada etapa—é um dos principais objetivos do treinamento moderno de modelos. Uma forma de pensar a aprendizagem de características é em termos de quanto as representações do modelo mudam em resposta a atualizações de gradiente. Se o modelo está aprendendo efetivamente, cada atualização deve resultar em mudanças significativas nas representações, melhorando sua capacidade de prever tokens futuros. Caso contrário, as atualizações podem resultar apenas em mudanças pequenas ou que não melhoram o desempenho. Técnicas para melhorar a aprendizagem de características incluem inicialização cuidadosa dos pesos do modelo, o que pode impactar significativamente a rapidez com que ele aprende características úteis no início do treinamento. Outra técnica importante é o uso de schedules de taxa de aprendizado que permitem que o modelo aprenda rapidamente no início, quando está aprendendo características fundamentais, e depois desacelere conforme o treinamento avança e o modelo refina padrões mais sutis. O conceito de aprendizagem de características está intimamente relacionado à ideia de “colapso de características”, quando modelos aprendem a ignorar certas características ou dimensões da entrada. Isso pode ocorrer quando o modelo encontra um atalho que permite obter bom desempenho sem aprender todas as características necessárias. Técnicas como regularização e design cuidadoso da função de perda podem ajudar a evitar o colapso de características e garantir que os modelos aprendam características diversas e úteis.

{{ cta-dark-panel heading=“Turbine Seu Fluxo de Trabalho com FlowHunt” description=“Descubra como o FlowHunt automatiza seus fluxos de conteúdo de IA e SEO — do estudo e geração de conteúdo à publicação e análise — tudo em um só lugar.” ctaPrimaryText=“Agende uma Demonstração” ctaPrimaryURL=“https://calendly.com/liveagentsession/flowhunt-chatbot-demo" ctaSecondaryText=“Experimente FlowHunt Grátis” ctaSecondaryURL=“https://app.flowhunt.io/sign-in" gradientStartColor="#123456” gradientEndColor="#654321” gradientId=“827591b1-ce8c-4110-b064-7cb85a0b1217” }}

Por vários anos, a narrativa dominante na pesquisa em IA era de que modelos maiores são melhores. Isso levou a uma corrida para construir modelos cada vez maiores, com empresas competindo para anunciar modelos com mais parâmetros. No entanto, desenvolvimentos recentes sugerem que essa narrativa está mudando. O sucesso do SmolLM 3 e de outros modelos eficientes demonstra que desempenho excepcional pode ser alcançado com modelos que são ordens de magnitude menores do que os maiores disponíveis. Essa mudança reflete uma compreensão mais profunda de que o desempenho do modelo é determinado por múltiplos fatores além da contagem de parâmetros. Um modelo de 3 bilhões de parâmetros treinado com dados de alta qualidade e técnicas de otimização sofisticadas pode superar um modelo muito maior treinado com dados de menor qualidade e otimização menos cuidadosa. Essa realização tem implicações profundas para o campo. Sugere que a pesquisa mais impactante pode não estar em construir modelos maiores, mas sim em melhorar a qualidade dos dados, desenvolver melhores técnicas de treinamento e criar arquiteturas mais eficientes. Também democratiza o desenvolvimento de IA, tornando possível que organizações menores e equipes acadêmicas construam modelos competitivos sem acesso aos enormes recursos computacionais exigidos por modelos com trilhões de parâmetros. A mudança de foco da escala pura também traz implicações práticas para implantação. Modelos menores podem rodar em dispositivos de borda, em ambientes restritos e com menor latência e consumo de energia. Isso torna capacidades avançadas de IA acessíveis a uma gama muito mais ampla de aplicações e usuários. A comunidade de pesquisa reconhece cada vez mais que o futuro do desenvolvimento de IA pode envolver um portfólio de modelos em diferentes escalas, cada um otimizado para casos de uso e cenários de implantação específicos, em vez de um foco único em construir o maior modelo possível.

O ajuste de hiperparâmetros é o processo de selecionar os valores dos parâmetros que controlam o processo de treinamento, como taxa de aprendizado, tamanho do batch e decaimento de peso. Esses parâmetros têm impacto significativo no desempenho do modelo, e encontrar valores ótimos é crucial para bons resultados. No entanto, o ajuste de hiperparâmetros frequentemente é tratado como arte, não ciência, com praticantes confiando em intuição e tentativa-e-erro em vez de abordagens sistemáticas. Abordagens modernas envolvem exploração mais sistemática do espaço de hiperparâmetros. Técnicas como otimização bayesiana podem explorar eficientemente o espaço de valores possíveis, identificando regiões promissoras e concentrando esforços ali. Grid search e random search são alternativas mais simples que também podem ser eficazes, especialmente quando combinadas com computação paralela para avaliar várias configurações ao mesmo tempo. Um insight importante de pesquisas recentes é que hiperparâmetros ótimos geralmente dependem do modelo, conjunto de dados e configuração de treinamento usados. Isso significa que hiperparâmetros que funcionam bem para um modelo podem não funcionar para outro, mesmo que eles sejam semelhantes em tamanho e arquitetura. Isso levou à prática de executar varreduras de hiperparâmetros para cada novo modelo ou conjunto de dados, o que pode ser caro computacionalmente, mas muitas vezes é necessário para desempenho ótimo. Compreender a relação entre hiperparâmetros e desempenho também é importante para depuração de problemas de treinamento. Se o treinamento está instável ou convergindo devagar, o problema pode ser escolhas subótimas de hiperparâmetros, e não questões fundamentais do modelo ou dados. Explorando sistematicamente o espaço de hiperparâmetros, muitas vezes é possível identificar e corrigir esses problemas.

Os insights da pesquisa moderna em pré-treinamento de modelos têm implicações práticas significativas para organizações que constroem seus próprios modelos de linguagem ou fazem fine-tuning de modelos existentes. Antes de tudo, as organizações devem investir fortemente em curadoria e garantia de qualidade dos dados. As evidências mostram que dados de alta qualidade são mais valiosos do que grandes volumes de dados de baixa qualidade. Isso significa implementar pipelines sofisticados que incluam deduplicação, filtragem de qualidade e padronização de formatos. Em segundo lugar, as organizações devem considerar cuidadosamente seus objetivos de otimização e garantir que estão otimizando para as métricas corretas. Diferentes aplicações podem exigir diferentes trade-offs entre tamanho do modelo, velocidade de inferência e acurácia. Definindo claramente esses trade-offs desde o início, é possível tomar decisões mais informadas sobre arquitetura e procedimentos de treinamento. Em terceiro lugar, as organizações devem se manter atualizadas sobre avanços recentes em técnicas de treinamento e design de otimizadores. O campo avança rapidamente, e técnicas consideradas de ponta há um ano podem ter sido superadas por abordagens melhores. Revisar regularmente artigos recentes e experimentar novas técnicas ajuda a manter a competitividade. Quarto, é importante investir em ferramentas e infraestrutura que facilitem a implementação de procedimentos sofisticados de treinamento. Isso pode incluir o uso de plataformas como o FlowHunt para automatizar processamento de dados e fluxos de treinamento, ou investir em infraestrutura própria para experimentação eficiente e ajuste de hiperparâmetros. Por fim, as organizações devem reconhecer que desenvolvimento de modelos não é apenas treinamento—envolve avaliação cuidadosa, depuração e iteração. Construir bons modelos exige uma abordagem sistemática, com avaliação regular em benchmarks diversos, análise de casos de falha e melhorias iterativas baseadas nos aprendizados.

O campo do pré-treinamento de modelos está evoluindo rapidamente, com novas técnicas e insights surgindo regularmente. Algumas tendências sinalizam para onde o campo pode estar indo. Primeiro, a tendência é de foco contínuo na qualidade e curadoria dos dados. À medida que se reconhece que a qualidade é mais importante que a quantidade, espera-se pipelines de processamento mais sofisticados e mais pesquisas sobre o que torna os dados “bons” para treinamento. Segundo, provavelmente veremos inovação contínua em design de otimizadores e dinâmicas de treinamento. O sucesso de novos otimizadores como Muon e King K2 indica que ainda há espaço significativo para melhorar a otimização do treinamento de modelos. Terceiro, haverá mais foco em eficiência e implantação prática. À medida que os modelos se tornam mais capazes, cresce o interesse em torná-los menores, mais rápidos e eficientes, incluindo pesquisa em compressão, quantização e técnicas de destilação. Quarto, a interpretabilidade dos modelos deve ganhar mais atenção conforme eles se tornam mais poderosos—entender como funcionam e por que tomam certas decisões é cada vez mais importante. Por fim, deve continuar a democratização do desenvolvimento de modelos, com mais ferramentas e técnicas disponíveis para permitir que pequenas organizações e equipes acadêmicas construam modelos competitivos.

A abordagem moderna ao pré-treinamento de modelos de linguagem representa uma evolução significativa em relação a métodos anteriores e mais simples. Em vez de apenas escalar dados e computação, o desenvolvimento bem-sucedido de modelos exige hoje orquestração cuidadosa de múltiplos objetivos de otimização, técnicas sofisticadas de curadoria de dados e inovação contínua em métodos de treinamento e design de otimizadores. SmolLM 3, FineWeb e FinePDF exemplificam esse novo paradigma, demonstrando que desempenho excepcional pode ser alcançado com rigor na qualidade dos dados, eficiência arquitetural e otimização do treinamento. A mudança do foco exclusivo na escala para eficiência e qualidade representa a maturidade do campo e abre novas possibilidades para democratizar o desenvolvimento de IA. Organizações que entendem e implementam esses princípios estarão melhor posicionadas para construir modelos competitivos, seja desenvolvendo novos modelos do zero ou fazendo fine-tuning de existentes. A comunidade de pesquisa continua a expandir os limites do possível, com novas técnicas e insights surgindo regularmente. Ao se manter informado sobre esses desenvolvimentos e investir nas ferramentas e infraestrutura certas, as organizações podem garantir que estão construindo modelos que representam o estado da arte em desenvolvimento de modelos.

O SmolLM 3 é um modelo com 3 bilhões de parâmetros projetado para maximizar a eficiência mantendo um desempenho forte em múltiplos idiomas e tarefas de raciocínio de longo contexto. Ao contrário dos modelos maiores, o SmolLM 3 foca em desempenho ideal dentro de restrições computacionais, tornando-o ideal para implantação em dispositivos de borda e ambientes com recursos limitados.

O princípio 'lixo entra, lixo sai' é fundamental no aprendizado de máquina. Dados de alta qualidade e diversidade impactam diretamente o desempenho do modelo mais do que simplesmente ter mais dados. FineWeb e FinePDF demonstram que a curadoria cuidadosa, deduplicação e filtragem dos dados de treinamento proporcionam resultados significativamente melhores do que conjuntos de dados brutos e não processados.

A destilação de conhecimento é uma técnica onde um modelo menor aprende com um modelo maior e mais capaz. Durante o pré-treinamento, essa abordagem permite que modelos menores extraiam o máximo de informação dos dados de treinamento ao aprender padrões que modelos maiores já descobriram, resultando em melhor desempenho com menos parâmetros.

A previsão multi-token treina os modelos para prever vários tokens futuros simultaneamente, em vez de apenas o próximo token. Essa abordagem é especialmente eficaz para tarefas de programação e melhora a capacidade do modelo de entender dependências de longo alcance, levando a melhor desempenho em tarefas de raciocínio complexas.

Otimizadores modernos como o Muon vão além do tradicional AdamW ao usar técnicas como métodos de Newton-Schulz para melhor aproximar a matriz Hessiana. Isso resulta em treinamento mais estável, melhor qualidade de gradientes e dinâmicas de aprendizado aprimoradas, especialmente ao escalar modelos para contagens maiores de parâmetros.

Arshia é Engenheira de Fluxos de Trabalho de IA na FlowHunt. Com formação em ciência da computação e paixão por IA, ela se especializa em criar fluxos de trabalho eficientes que integram ferramentas de IA em tarefas do dia a dia, aumentando a produtividade e a criatividade.

O FlowHunt ajuda equipes a simplificar pipelines de pré-treinamento de modelos, processamento de dados e otimização com automação inteligente.

Hugging Face Transformers é uma biblioteca Python open-source líder que facilita a implementação de modelos Transformer para tarefas de machine learning em PLN,...

Explore como o Jamba 3B, da AI21, combina atenção de transformadores com modelos de espaço de estados para alcançar eficiência sem precedentes e capacidades de ...

Explore os melhores grandes modelos de linguagem (LLMs) para programação em junho de 2025. Este guia educacional completo traz insights, comparações e dicas prá...