Sora 2: Geração de Vídeo com IA para Criadores de Conteúdo

Explore as capacidades revolucionárias do Sora 2 na geração de vídeos com IA, desde recriação realista de personagens até simulação de física, e descubra como e...

Automação de IA

Explore as capacidades revolucionárias do Sora 2 na geração de vídeos por IA, desde a recriação realista de personagens até a simulação de física, e descubra como essa tecnologia está transformando a criação e automação de conteúdo.

O Sora 2 representa um avanço significativo na tecnologia de geração de vídeos por inteligência artificial. A mais recente iteração do modelo de geração de vídeo da OpenAI traz capacidades inéditas para criadores de conteúdo, profissionais de marketing e empresas que desejam otimizar seus fluxos de produção de vídeo. Este guia abrangente explora as funcionalidades notáveis do Sora 2, suas aplicações práticas e as implicações para o futuro da criação de conteúdo. Desde a recriação de personagens fictícios queridos até a geração de performances humanas realistas, o Sora 2 demonstra o potencial transformador da IA generativa na produção de mídia visual. Seja você interessado nas capacidades técnicas, nas possibilidades criativas ou nas aplicações empresariais, este artigo oferece uma análise aprofundada do que torna o Sora 2 uma tecnologia tão inovadora.

A geração de vídeo por inteligência artificial representa uma das fronteiras mais empolgantes da tecnologia de IA generativa. Diferente da produção tradicional de vídeos, que exige câmeras, atores, equipamentos de iluminação e muito trabalho de pós-produção, a geração de vídeo por IA cria vídeos diretamente a partir de descrições ou prompts em texto. A tecnologia utiliza modelos de deep learning treinados com vastas quantidades de dados de vídeo para entender a relação entre descrições em linguagem natural e o conteúdo visual. Esses modelos aprendem a reconhecer padrões de como objetos se movem, como a luz interage com superfícies, como pessoas gesticulam e expressam emoções, e como as cenas transitam naturalmente. Quando um usuário fornece um prompt de texto, o modelo de IA processa essas informações e gera um vídeo quadro a quadro, garantindo consistência na aparência dos personagens, nos movimentos e nos detalhes do ambiente ao longo de toda a sequência. A tecnologia por trás envolve modelos de difusão e arquiteturas de transformers adaptados especificamente para geração de vídeo, permitindo ao sistema manter coerência temporal—ou seja, objetos e personagens se movem naturalmente e de forma consistente entre os quadros, em vez de parecerem teletransportar-se ou piscar.

A importância da geração de vídeo por IA vai muito além da simples novidade. Essa tecnologia resolve desafios fundamentais na produção de conteúdo: tempo, custo e escalabilidade. A produção tradicional de vídeo pode levar semanas ou meses e exigir equipes de profissionais, incluindo diretores, cinegrafistas, editores e especialistas em efeitos visuais. A geração de vídeo por IA pode produzir resultados comparáveis em minutos, tornando-a acessível para pequenas empresas, criadores independentes e organizações que antes não podiam arcar com a produção profissional de vídeo. A democratização da criação de vídeos pela IA tem impactos profundos no marketing, na educação, no entretenimento e nas comunicações corporativas. À medida que esses sistemas se tornam mais sofisticados e acessíveis, eles estão redefinindo como as organizações pensam sobre estratégia de conteúdo visual e fluxos de produção.

O argumento de negócio para a geração de vídeo por IA é convincente e multifacetado. No cenário digital atual, o conteúdo em vídeo domina as métricas de engajamento em todas as plataformas. Segundo dados do setor, vídeos geram taxas de engajamento significativamente maiores do que imagens estáticas ou texto, com plataformas como TikTok, YouTube e Instagram priorizando vídeos em seus algoritmos. No entanto, produzir vídeos de alta qualidade em escala sempre foi proibitivamente caro para a maioria das organizações. A geração de vídeo por IA resolve essa limitação ao permitir que empresas produzam variações ilimitadas de vídeos para testes A/B, personalização e iteração rápida. Equipes de marketing podem gerar dezenas de vídeos de demonstração de produtos em diferentes estilos e formatos sem regravar. Instituições de ensino podem criar conteúdo personalizado em escala. Departamentos de atendimento ao cliente podem gerar vídeos de treinamento para novos procedimentos em tempo real. O impacto econômico é substancial: empresas podem reduzir os custos de produção de vídeos em 70-90%, aumentando simultaneamente o volume de produção em várias ordens de magnitude.

Além da redução de custos, a geração de vídeo por IA permite novas formas de criatividade e experimentação. Criadores de conteúdo podem testar ideias ousadas sem comprometer grandes recursos. Podem gerar múltiplas versões de um conceito para ver qual ressoa com o público. Podem criar conteúdo em diferentes estilos, tons e formatos para adequar-se a diferentes segmentos de audiência ou requisitos de plataforma. Essa flexibilidade transforma o vídeo de um recurso escasso e cuidadosamente planejado em um meio abundante e experimental. As implicações para a estratégia de conteúdo são profundas. Em vez de planejar algumas produções de vídeo de alto risco por trimestre, as organizações podem adotar um modelo de criação contínua, tornando o vídeo tão rotineiro quanto a publicação de postagens em blogs. Essa mudança permite conteúdos mais responsivos, oportunos e personalizados, que atendem melhor às necessidades do público e aos objetivos do negócio. Além disso, a geração de vídeo por IA abre possibilidades para conteúdos interativos e dinâmicos que se adaptam ao espectador individual, criando oportunidades inéditas de engajamento e conversão.

O Sora 2 aprimora modelos anteriores de geração de vídeo com melhorias substanciais em diversas dimensões. O aprimoramento mais perceptível é o aumento dramático na fidelidade visual e no realismo. Os vídeos gerados pelo Sora 2 exibem iluminação significativamente melhor, gradação de cor mais natural, detalhes de textura aprimorados e propriedades de materiais mais convincentes. Ao assistir a um vídeo do Sora 2, a qualidade visual se aproxima dos padrões de cinematografia profissional em muitos casos. O modelo é excelente em renderizar cenas complexas com múltiplos objetos, mantendo iluminação consistente em todo o quadro e criando reflexos e sombras realistas. Esse nível de qualidade visual é crucial para aplicações profissionais, onde resultados de má qualidade comprometeriam a credibilidade e a percepção da marca.

A simulação de física representa outro grande avanço no Sora 2. Modelos anteriores de geração de vídeo frequentemente tinham dificuldades com a consistência física—objetos se moviam de forma irreal, a gravidade era incoerente ou colisões não eram registradas adequadamente. O Sora 2 demonstra compreensão substancialmente melhor das leis físicas e de como objetos interagem com o ambiente. Quando uma bola é lançada, segue uma trajetória realista. Quando uma pessoa caminha, sua distribuição de peso e padrões de movimento parecem naturais. Quando objetos colidem, a interação é fisicamente plausível. Essa melhoria é especialmente importante para aplicações onde a precisão física é essencial, como demonstrações de produtos, conteúdos educacionais ou entretenimento, onde o público perceberia facilmente física irreal. O entendimento aprimorado de física do modelo também possibilita cenas mais complexas e dinâmicas, que seriam impossíveis com gerações anteriores.

A consistência temporal e a coerência representam melhorias críticas que fazem com que vídeos do Sora 2 pareçam gravações genuínas, e não coleções de quadros desconexos. O modelo mantém a identidade dos personagens ao longo dos vídeos, garantindo que as pessoas mantenham a mesma aparência do início ao fim, sem mudanças ou distorções. Detalhes do ambiente permanecem constantes—se uma planta está ao fundo no início do vídeo, ela permanece na mesma posição e aparência durante toda a sequência. Essa consistência é essencial para aplicações profissionais e cria uma experiência de visualização natural e imersiva. O modelo também demonstra melhor compreensão de movimento e sequências de ação, gerando movimentos suaves e naturais em vez de transições bruscas ou irreais entre poses.

Uma das funcionalidades mais impressionantes do Sora 2 é sua capacidade de recriar com precisão rostos e aparências humanas através da tecnologia de escaneamento facial. Usuários que realizam um escaneamento facial relatam que o modelo atinge cerca de 90% de precisão ao reproduzir traços faciais, expressões e detalhes sutis como textura da pele e reflexos de luz. Esse nível de precisão é realmente notável e abre possibilidades antes restritas à ficção científica. Ao assistir a um vídeo gerado pelo Sora 2 com a própria imagem, a experiência é estranhamente realista—claramente é você, mas em situações nunca vividas, realizando ações jamais feitas. O modelo capta não apenas características faciais estáticas, mas também os aspectos dinâmicos de como o rosto se movimenta e expressa emoções. A iluminação no rosto parece realista, reflexos aparecem nos olhos e detalhes sutis como textura da pele e movimento do cabelo são renderizados de forma convincente.

As implicações dessa tecnologia são tanto empolgantes quanto preocupantes. Pelo lado positivo, criadores agora podem gerar conteúdo com sua própria imagem sem precisar estar fisicamente presentes para gravação. Um youtuber pode gerar dezenas de variações de vídeos sem gravar múltiplas tomadas. Um educador pode criar conteúdo personalizado aparecendo como instrutor. Um executivo pode gerar vídeos de treinamento ou comunicados sem agendar sessões de gravação. As economias de tempo e custo são substanciais. Contudo, essa capacidade também levanta questões importantes sobre consentimento, autenticidade e possíveis usos indevidos. A tecnologia poderia ser usada para criar deepfakes ou conteúdos enganosos com pessoas reais sem sua permissão. A OpenAI implementou salvaguardas, incluindo a possibilidade do usuário controlar se sua imagem pode ser usada por outros, mas o potencial de uso indevido da tecnologia permanece uma preocupação significativa que a sociedade precisará enfrentar com políticas e regulação.

O Sora 2 possibilita aplicações criativas antes impossíveis ou proibitivamente caras. Um dos usos mais divertidos é a recriação de personagens fictícios queridos em novos cenários. Usuários já geraram vídeos do Bob Esponja fazendo rap, com design de personagem, estilo de animação e síntese de voz fiéis ao original. O modelo capta o estilo visual distintivo do personagem e mantém a consistência ao longo do vídeo. Da mesma forma, usuários recriaram cenas clássicas de videogame com notável precisão, incluindo o icônico Halo, com seu estilo visual, elementos de interface e narração característicos. Essas aplicações demonstram a capacidade do Sora 2 de entender e replicar estilos visuais específicos, designs de personagens e convenções estéticas.

As possibilidades de entretenimento se estendem à criação de conteúdo totalmente novo no estilo de franquias existentes. Usuários já geraram episódios completos do Bob Esponja encadeando múltiplos clipes do Sora 2, criando narrativas coerentes que mantêm a consistência visual e dos personagens. Essa capacidade sugere futuros em que a IA poderá auxiliar na produção de animações, gerando cenas-chave ou variações que animadores humanos depois aprimoram. A tecnologia pode democratizar a produção de animação, permitindo que criadores independentes produzam conteúdo animado sem equipes de animadores. A recriação de videogames representa outra aplicação fascinante, com personagens inseridos em ambientes do Minecraft ou recriações de jogos clássicos como Mario Kart em estilo fotorrealista. Essas aplicações evidenciam a flexibilidade do modelo e sua capacidade de se adaptar a diferentes estilos visuais e contextos.

Embora o Sora 2 represente um grande avanço, é importante entender suas limitações atuais e áreas que ainda precisam de melhorias. Testes mostram que, embora a recriação facial seja geralmente precisa, há casos em que o modelo enfrenta dificuldades com consistência. Ao gerar vários vídeos com o mesmo prompt, os resultados podem variar significativamente. Às vezes, o rosto está quase perfeito; em outras, ocorrem efeitos sutis de distorção ou inconsistências nos traços faciais. Essa variação sugere que a qualidade dos resultados do modelo ainda não é completamente determinística, e os usuários podem precisar gerar múltiplas versões para encontrar uma que atenda ao padrão desejado. A inconsistência é especialmente perceptível em casos-limite ou cenários complexos.

Destreza manual e manipulação de objetos representam uma limitação significativa nos vídeos atuais do Sora 2. Em vídeos que envolvem movimentos detalhados das mãos ou manipulação de objetos, os resultados frequentemente não convencem. Mãos podem aparecer distorcidas, dedos podem não se mover naturalmente ou objetos podem não ser segurados de maneira realista. Essa limitação se destaca especialmente em vídeos que envolvem habilidades motoras finas ou gestos manuais complexos. O modelo tem dificuldades para entender e replicar a biomecânica complexa do movimento humano, em especial das mãos e dedos. Melhorar a renderização e manipulação das mãos é um foco ativo de pesquisa na área.

Erros de física ocasionalmente aparecem em vídeos do Sora 2, principalmente em cenários complexos com múltiplos objetos ou forças. Em alguns vídeos, carros andam para trás quando deveriam ir para frente, objetos flutuam quando deveriam cair, ou colisões não são registradas corretamente. Esses erros de física são menos comuns que em modelos anteriores, mas ainda ocorrem com frequência suficiente para serem notados. Normalmente, aparecem em casos-limite ou quando o prompt descreve interações físicas complexas que o modelo não encontrou com frequência nos dados de treinamento. A síntese de voz também precisa de aprimoramentos em alguns casos, com vozes geradas às vezes soando artificiais ou com artefatos digitais. A qualidade da geração de voz varia conforme a voz sintetizada e a complexidade da fala.

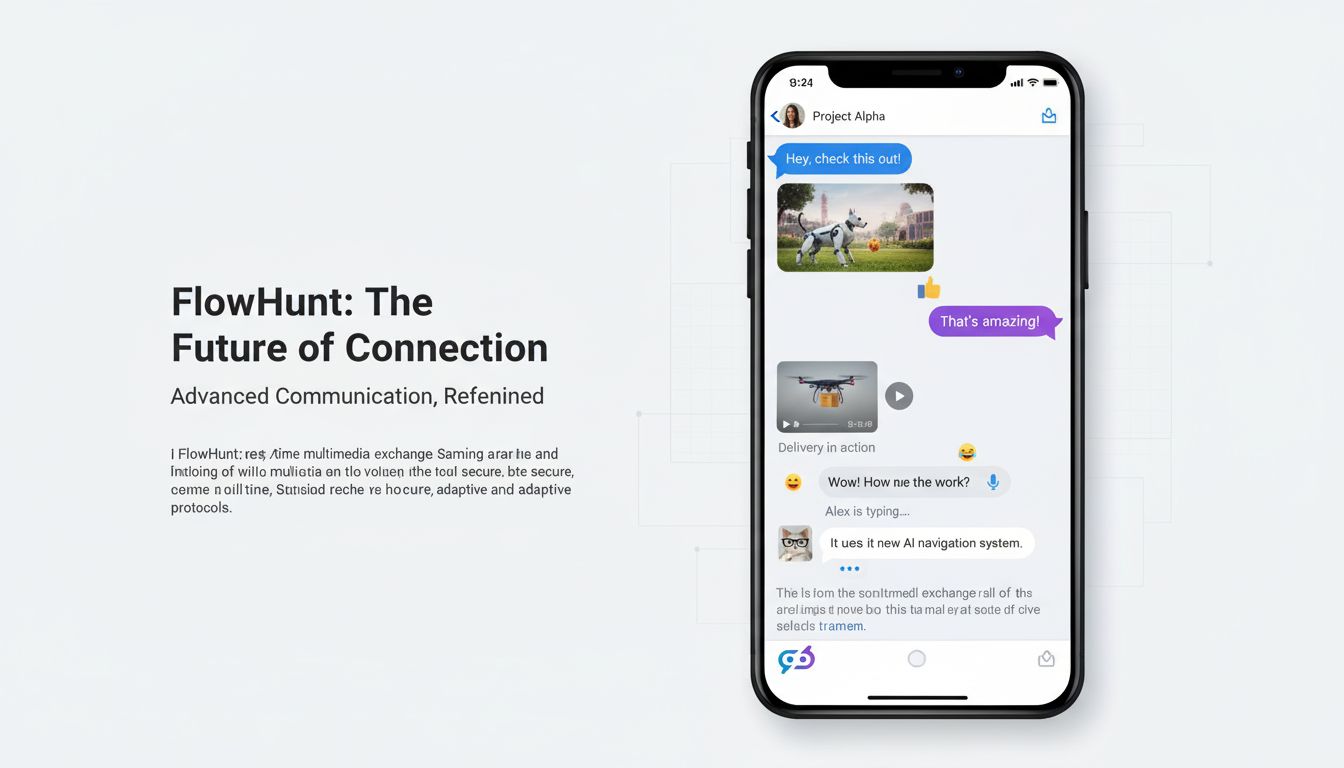

O FlowHunt reconhece o potencial transformador da geração de vídeo por IA e está integrando essas capacidades à sua plataforma de automação para ajudar empresas a otimizar seus fluxos de criação de conteúdo. Em vez de tratar a geração de vídeo como uma ferramenta isolada, o FlowHunt posiciona a geração de vídeo por IA como parte de um ecossistema abrangente de automação de conteúdo. Essa abordagem permite criar fluxos de trabalho de ponta a ponta, combinando geração de vídeo com outras funções de criação, distribuição e análise de conteúdo. Por exemplo, uma equipe de marketing pode criar um fluxo que gera vídeos de demonstração de produtos, adiciona legendas e branding automaticamente, publica em múltiplas plataformas e acompanha métricas de engajamento—tudo sem intervenção manual.

A integração do Sora 2 e de modelos similares na plataforma do FlowHunt possibilita cenários de automação poderosos. Equipes de conteúdo podem agendar tarefas recorrentes de geração de vídeo para criar novos conteúdos periodicamente. Empresas de e-commerce podem gerar automaticamente vídeos de produtos para novos itens do estoque. Equipes de marketing podem criar variações personalizadas de vídeos para diferentes segmentos de público. Instituições de ensino podem gerar treinamentos sob demanda. Departamentos de atendimento ao cliente podem criar vídeos explicativos para dúvidas comuns. Ao combinar geração de vídeo com automação de fluxos do FlowHunt, organizações alcançam escala e eficiência inéditas na produção de vídeos. A plataforma gerencia orquestração, agendamento e integração com outros sistemas, permitindo que equipes foquem em estratégia e direção criativa em vez de tarefas manuais.

As aplicações práticas do Sora 2 abrangem praticamente todos os setores e funções de negócio. Em marketing e publicidade, o Sora 2 permite criar vídeos de demonstração de produtos, depoimentos e campanhas promocionais em escala. Marcas podem gerar múltiplas variações de anúncios para testar diferentes mensagens, estilos visuais e chamadas para ação. E-commerces podem criar vídeos de produtos para milhares de itens sem gravações individuais. Corretores de imóveis podem gerar tours virtuais de propriedades. Empresas de turismo podem criar vídeos de destinos. As reduções de custo e aumento de velocidade são transformadores para equipes de marketing que antes enfrentavam gargalos na produção de vídeo.

Em educação e treinamento, o Sora 2 possibilita a criação de conteúdo personalizado, vídeos instrutivos e materiais de treinamento. Instituições de ensino podem gerar vídeos com professores em diferentes cenários, explicando conceitos de formas variadas ou demonstrando procedimentos. Departamentos de treinamento corporativo podem criar vídeos de integração, segurança e desenvolvimento profissional. A capacidade de gerar conteúdo sob demanda permite atualizar rapidamente materiais de treinamento quando procedimentos mudam ou novas informações surgem. A personalização em escala se torna viável—alunos diferentes podem receber vídeos adaptados ao seu estilo, ritmo e conhecimentos prévios.

No entretenimento e produção de mídia, o Sora 2 abre possibilidades para animação, efeitos visuais e criação de conteúdo antes limitados por orçamento e tempo. Criadores independentes podem produzir animações sem equipes de animadores. Produções de cinema e TV podem usar conteúdos gerados por IA para efeitos visuais, elementos de fundo ou até cenas inteiras. Videoclipes podem ser gerados para acompanhar músicas. Plataformas de streaming podem criar conteúdo original com mais eficiência. A tecnologia democratiza a produção de entretenimento, permitindo que criadores com poucos recursos produzam conteúdos de qualidade profissional.

Em comunicações corporativas e operações internas, o Sora 2 permite criar comunicados executivos, anúncios, vídeos de treinamento e documentação interna. Executivos podem gerar mensagens personalizadas para colaboradores sem precisar gravar. Departamentos de RH podem criar treinamentos sobre novas políticas. Equipes de TI podem gerar vídeos explicativos sobre sistemas. A capacidade de produzir conteúdo rapidamente e a baixo custo permite que organizações comuniquem-se com mais frequência e eficácia com colaboradores e partes interessadas.

O cenário atual da geração de vídeo por IA é frequentemente descrito como um “velho oeste dos direitos autorais”. O Sora 2 pode gerar vídeos com personagens protegidos por direitos autorais, celebridades e propriedade intelectual sem permissão explícita dos detentores de direitos. Usuários podem criar vídeos do Bob Esponja, Mario, Zelda e outros personagens registrados. Podem gerar vídeos com celebridades e figuras públicas. Essa capacidade levanta questões legais e éticas importantes sobre direitos autorais, consentimento e uso apropriado de conteúdo gerado por IA. A precisão com que a tecnologia recria personagens e imagens aumenta consideravelmente o potencial de uso indevido.

A OpenAI implementou algumas salvaguardas, incluindo a possibilidade de usuários controlarem se sua imagem pode ser usada por outros por meio de configurações de cameo. No entanto, essas proteções são limitadas e não abordam a questão mais ampla de se sistemas de IA deveriam poder gerar conteúdo com personagens protegidos ou celebridades sem permissão. O cenário legal ainda está em evolução, com tribunais e órgãos reguladores debatendo questões sobre uso justo, infração de direitos autorais e os limites apropriados para conteúdo gerado por IA. Alguns argumentam que gerar conteúdo com personagens protegidos para uso pessoal está protegido pelo uso justo, enquanto outros defendem que qualquer uso comercial deveria exigir permissão dos detentores de direitos. A situação é ainda mais complexa, pois diferentes jurisdições têm leis de direitos autorais e interpretações de uso justo distintas.

As questões éticas vão além dos direitos autorais e envolvem autenticidade, consentimento e possível uso indevido. Quando espectadores veem um vídeo com uma celebridade, podem assumir que é autêntico, a menos que informado o contrário. Isso cria potencial para engano e desinformação. A tecnologia pode ser usada para criar deepfakes que prejudiquem reputações ou disseminem informações falsas. Embora as limitações atuais do Sora 2 dificultem a criação de deepfakes totalmente convincentes de indivíduos específicos em situações específicas, a tecnologia está evoluindo rapidamente. A sociedade precisará desenvolver normas, regulações e salvaguardas técnicas para evitar abusos e, ao mesmo tempo, preservar os benefícios legítimos da tecnologia.

As melhorias do Sora 2 em relação a modelos anteriores refletem avanços em diversas áreas técnicas. O modelo utiliza arquiteturas aprimoradas baseadas em difusão, que entendem melhor a relação entre descrições em texto e conteúdo visual. O processo de treinamento incorpora dados de vídeo mais diversos e de melhor qualidade, permitindo ao modelo aprender padrões mais sutis sobre o funcionamento do mundo. O entendimento de física, iluminação e propriedades de materiais foi aprimorado com melhores dados de treinamento e funções de perda que penalizam resultados fisicamente implausíveis. As melhorias na consistência temporal vêm de mecanismos aperfeiçoados para manter o estado entre quadros e mecanismos de atenção aprimorados para compreender dependências de longo prazo em sequências de vídeo.

As capacidades de digitalização facial e recriação de personagens dependem de componentes especializados capazes de codificar traços faciais e informações de identidade de forma que sejam preservadas durante a geração de vídeo. Esses componentes provavelmente utilizam técnicas similares às usadas em sistemas de reconhecimento facial, mas adaptadas ao contexto de geração de vídeo. O modelo aprende a associar informações de identidade a padrões visuais específicos e mantém essa associação durante todo o processo de geração. Os aprimoramentos na síntese de voz vêm de modelos de texto-para-fala mais avançados e melhor integração entre os componentes de geração de vídeo e áudio. O modelo agora pode gerar áudio que corresponde melhor aos movimentos labiais e expressões do vídeo gerado, criando resultados mais convincentes.

Embora o Sora 2 represente um avanço significativo, é importante entender como ele se compara a outros modelos de geração de vídeo disponíveis. Outros modelos como Runway, Synthesia e alternativas open-source têm seus próprios pontos fortes e limitações. O Runway, por exemplo, foca em fornecer ferramentas acessíveis para criadores e construiu uma comunidade forte em torno da plataforma. O Synthesia se especializa em geração de vídeos com avatares para comunicações corporativas. Modelos open-source como Stable Video Diffusion oferecem flexibilidade e opções de personalização para desenvolvedores. O Sora 2 se destaca pela qualidade visual superior, melhor simulação de física e recriação mais precisa de personagens. A capacidade de gerar vídeos mais longos e lidar com cenas complexas dá vantagem ao modelo em muitas aplicações.

No entanto, o Sora 2 também apresenta limitações em relação a algumas alternativas. Alguns modelos oferecem geração em tempo real ou exigem menor poder computacional. Outros permitem controle mais granular sobre aspectos específicos do vídeo gerado. Alguns têm integração melhor com plataformas ou fluxos específicos. A escolha do modelo depende dos requisitos, casos de uso e restrições de cada aplicação. Para aplicações que exigem máxima qualidade visual e realismo, o Sora 2 provavelmente é a melhor escolha. Para casos que exigem geração em tempo real ou opções específicas de personalização, outros modelos podem ser mais adequados. À medida que o campo evolui, podemos esperar melhorias contínuas em todos os modelos e o surgimento de modelos especializados para diferentes finalidades.

Experimente como o FlowHunt automatiza seus fluxos de geração de conteúdo e vídeo por IA — da pesquisa e criação à publicação e análise — tudo em um só lugar.

A trajetória da tecnologia de geração de vídeo por IA indica que estamos apenas no início do que é possível. Futuras versões do Sora e de modelos concorrentes provavelmente abordarão limitações atuais em destreza manual, simulação de física e consistência. Podemos esperar melhorias no tempo de duração dos vídeos, resolução e capacidade de lidar com cenas cada vez mais complexas. Os modelos devem se tornar mais eficientes, exigindo menos poder computacional para gerar vídeos. A integração com outros sistemas de IA permitirá fluxos de trabalho mais sofisticados, em que a geração de vídeo é combinada com outras formas de criação e análise de conteúdo.

As implicações para a criação de conteúdo são profundas. À medida que a geração de vídeo por IA se torna mais capaz e acessível, o vídeo se tornará tão rotineiro quanto o texto na comunicação digital. Organizações vão passar a enxergar o vídeo não como um recurso escasso e planejado, mas como um meio abundante e experimental. Isso permitirá conteúdos mais responsivos, personalizados e envolventes. No entanto, também criará desafios em torno de autenticidade, desinformação e a necessidade de novas normas e regulações sobre conteúdo gerado por IA. A tecnologia provavelmente provocará mudanças significativas nas indústrias criativas, podendo substituir alguns papéis, mas criando novas oportunidades para quem souber direcionar e curar conteúdo gerado por IA.

Para organizações que desejam aproveitar o Sora 2 na criação de conteúdo, algumas boas práticas podem ajudar a maximizar os resultados. Primeiro, entenda os pontos fortes e limitações do modelo. O Sora 2 se destaca na geração de cenas realistas com boa iluminação e física, mas tem dificuldades com movimentos complexos das mãos e às vezes produz resultados inconsistentes. Elabore prompts que explorem esses pontos fortes. Segundo, gere múltiplas variações do mesmo prompt e selecione os melhores resultados. O modelo varia nas saídas, então rodar o mesmo prompt várias vezes geralmente traz resultados superiores aos da primeira tentativa. Terceiro, utilize o escaneamento facial para recriação de personagens quando a precisão for importante. O recurso melhora significativamente a precisão da recriação facial em comparação com descrições apenas em texto.

Quarto, divida vídeos complexos em vários clipes e os encadeie, em vez de tentar gerar cenas complexas de uma só vez. Essa abordagem oferece mais controle e, geralmente, resultados melhores do que tentar gerar tudo em um único prompt. Quinto, forneça prompts detalhados e específicos, descrevendo não apenas o que deve acontecer, mas também o estilo visual, iluminação e clima desejados. Prompts vagos geram resultados medianos, enquanto prompts detalhados sobre elementos visuais, ângulos de câmera e preferências estéticas resultam em saídas significativamente melhores. Sexto, integre a geração de vídeo a fluxos de conteúdo mais amplos com ferramentas como o FlowHunt, que automatizam desde a geração até a publicação e análise. Assim, é possível maximizar a eficiência e escalar a produção de vídeos a níveis inéditos.

À medida que a geração de vídeo por IA se torna mais comum, preocupações com autenticidade, desinformação e substituição de empregos são legítimas e merecem atenção séria. Organizações que usam conteúdo gerado por IA devem ser transparentes quanto ao uso da tecnologia, especialmente em contextos em que o público pode assumir que o conteúdo é autêntico. Divulgar que o conteúdo é gerado por IA constrói confiança e ajuda o público a compreender o que está assistindo. Essa transparência é especialmente importante em conteúdos que podem influenciar decisões importantes ou crenças. Em setores regulados como saúde, finanças ou jurídico, pode haver exigências específicas para divulgação de conteúdo gerado por IA.

O potencial de uso indevido com deepfakes e desinformação é real e exige medidas proativas. Salvaguardas técnicas como marca d’água em conteúdos gerados por IA podem ajudar a identificar mídia sintética. Políticas e regulações deverão evoluir para coibir abusos. A educação midiática ajudará o público a entender como funciona o conteúdo gerado por IA e desenvolver pensamento crítico para avaliar a autenticidade. Organizações devem considerar políticas internas sobre usos apropriados de geração de vídeo por IA e comprometer-se com o uso responsável da tecnologia. O objetivo deve ser aproveitar os benefícios legítimos da geração de vídeo por IA, evitando abusos e mantendo a confiança pública na mídia e nas comunicações.

O Sora 2 representa um marco na tecnologia de geração de vídeos por IA, oferecendo capacidades antes restritas à ficção científica. A habilidade do modelo de gerar vídeos realistas e fisicamente plausíveis, com recriação precisa de personagens, abre possibilidades inéditas para criadores de conteúdo, profissionais de marketing, educadores e empresas de todos os setores. Embora persistam limitações atuais como destreza manual, consistência física e variação dos resultados, a trajetória de evolução é clara. A tecnologia continuará avançando, tornando-se mais capaz, eficiente e acessível. Organizações que entendem as capacidades e limitações do Sora 2 e o integram em seus fluxos de criação de conteúdo conquistarão importantes vantagens competitivas, com redução de custos, aumento do volume de produção e possibilidade de experimentar em escala. No entanto, esse poder traz responsabilidade—o potencial de uso indevido da tecnologia exige consideração ética, comunicação transparente sobre conteúdo gerado por IA e medidas proativas para evitar danos. À medida que o Sora 2 e tecnologias similares remodelam a criação de conteúdo, as organizações bem-sucedidas serão aquelas que aproveitarem o potencial da tecnologia mantendo autenticidade, transparência e padrões éticos elevados.

Sora 2 é o mais recente modelo de geração de vídeo da OpenAI que cria vídeos realistas e fisicamente precisos a partir de prompts de texto. Ele aprimora sistemas anteriores com melhor simulação de física, maior fidelidade visual, capacidade de gerar vídeos mais longos e controles criativos mais avançados para os usuários.

Sim, o Sora 2 pode recriar a aparência de pessoas reais com alta precisão por meio da tecnologia de escaneamento facial. Usuários relatam que o modelo atinge aproximadamente 90% de precisão na reprodução de traços faciais, expressões e até mesmo elementos de fundo quando fornecidos os dados de referência adequados.

Embora impressionante, o Sora 2 ainda possui limitações, incluindo mudanças ocasionais entre múltiplos sujeitos, destreza manual inconsistente, erros de física em cenas complexas e variação na qualidade do resultado ao gerar o mesmo prompt várias vezes. A síntese de voz também precisa de aprimoramentos em alguns casos.

Empresas podem usar o Sora 2 para criar vídeos de marketing, demonstrações de produtos, conteúdos de treinamento, clipes para redes sociais e entretenimento. A tecnologia pode reduzir significativamente o tempo e o custo de produção ao automatizar a criação de vídeos a partir de descrições de texto, tornando-se valiosa para os setores de marketing, educação e entretenimento.

Arshia é Engenheira de Fluxos de Trabalho de IA na FlowHunt. Com formação em ciência da computação e paixão por IA, ela se especializa em criar fluxos de trabalho eficientes que integram ferramentas de IA em tarefas do dia a dia, aumentando a produtividade e a criatividade.

Integre a geração de vídeo por IA em sua cadeia de produção de conteúdo e otimize desde o conceito até a publicação.

Explore as capacidades revolucionárias do Sora 2 na geração de vídeos com IA, desde recriação realista de personagens até simulação de física, e descubra como e...

Descubra tudo o que você precisa saber sobre o aplicativo Sora-2 — seus recursos, casos de uso e como ele se compara aos principais geradores de vídeo com IA. A...

A atualização de outubro de 2025 do FlowHunt traz os revolucionários modelos Wan 2.2 e 2.5 para geração de vídeo a partir de texto, imagem para vídeo e animação...

Consentimento de Cookies

Usamos cookies para melhorar sua experiência de navegação e analisar nosso tráfego. See our privacy policy.