Como Transformar a Criação de Conteúdo com a Geração de Vídeos Wan 2.2 & 2.5?

A FlowHunt agora oferece suporte aos modelos de geração de vídeo Wan 2.2 e 2.5 para texto para vídeo, imagem para vídeo, substituição de persona e animação. Tra...

Automação de IA

Wan 2.1 é um poderoso modelo open-source de geração de vídeo por IA da Alibaba, entregando vídeos com qualidade de estúdio a partir de texto ou imagens, livre para todos usarem localmente.

O Wan 2.1 (também chamado WanX 2.1) está inovando como um modelo de geração de vídeo por IA totalmente open-source desenvolvido pelo Tongyi Lab da Alibaba. Diferente de muitos sistemas proprietários de geração de vídeo que exigem assinaturas caras ou acesso via API, o Wan 2.1 entrega qualidade comparável ou superior, permanecendo completamente gratuito e acessível para desenvolvedores, pesquisadores e profissionais criativos.

O que torna o Wan 2.1 realmente especial é sua combinação de acessibilidade e desempenho. A variante menor, T2V-1.3B, requer apenas ~8,2 GB de memória de GPU, tornando-o compatível com a maioria das GPUs modernas de consumo. Enquanto isso, a versão maior, com 14 bilhões de parâmetros, oferece desempenho de ponta que supera tanto alternativas open-source quanto muitos modelos comerciais em benchmarks padrão.

O Wan 2.1 não se limita apenas à geração de texto para vídeo. Sua arquitetura versátil suporta:

Essa flexibilidade significa que você pode começar com um prompt de texto, uma imagem estática ou até mesmo um vídeo existente e transformá-lo conforme sua visão criativa.

Como o primeiro modelo de vídeo capaz de renderizar texto legível em inglês e chinês dentro dos vídeos gerados, o Wan 2.1 abre novas possibilidades para criadores de conteúdo internacional. Esse recurso é especialmente valioso para criar legendas ou textos em cena em vídeos multilíngues.

No coração da eficiência do Wan 2.1 está seu Autoencoder Variacional de Vídeo 3D causal. Essa inovação tecnológica comprime informações espaço-temporais de forma eficiente, permitindo ao modelo:

O modelo menor de 1.3B requer apenas 8,19 GB de VRAM e pode produzir um vídeo de 5 segundos em 480p em aproximadamente 4 minutos em uma RTX 4090. Apesar dessa eficiência, sua qualidade rivaliza ou supera a de modelos muito maiores, sendo o equilíbrio perfeito entre velocidade e fidelidade visual.

Em avaliações públicas, o Wan 14B atingiu a maior pontuação geral nos testes Wan-Bench, superando concorrentes em:

Diferente de sistemas proprietários como o Sora da OpenAI ou o Gen-2 da Runway, o Wan 2.1 está disponível gratuitamente para rodar localmente. Ele geralmente supera modelos open-source anteriores (como CogVideo, MAKE-A-VIDEO e Pika) e até muitas soluções comerciais em benchmarks de qualidade.

Uma pesquisa recente do setor destacou que “entre muitos modelos de vídeo por IA, Wan 2.1 e Sora se destacam” – Wan 2.1 por sua abertura e eficiência, e Sora pela inovação proprietária. Em testes da comunidade, usuários relataram que a capacidade de imagem para vídeo do Wan 2.1 supera concorrentes em clareza e aspecto cinematográfico.

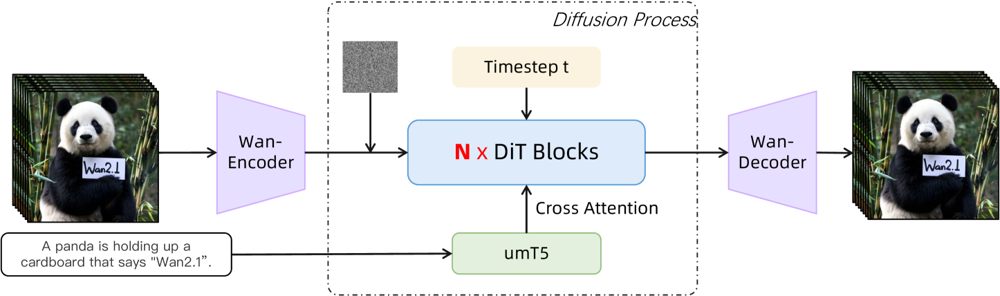

O Wan 2.1 é baseado em um backbone diffusion-transformer com um VAE espaço-temporal inovador. Veja como funciona:

Figura: Arquitetura de alto nível do Wan 2.1 (caso texto para vídeo). Um vídeo (ou imagem) é primeiro codificado pelo encoder Wan-VAE em um latente. Esse latente passa então por N blocos de transformer de difusão, que atendem ao embedding de texto (do umT5) via cross-attention. Por fim, o decoder Wan-VAE reconstrói os quadros do vídeo. Esse design – apresentando um “encoder/decoder VAE 3D causal ao redor de um diffusion transformer” (ar5iv.org ) – permite compressão eficiente de dados espaço-temporais e suporta saída de vídeo em alta qualidade.

Essa arquitetura inovadora — apresentando um “encoder/decoder VAE 3D causal ao redor de um diffusion transformer” — permite compressão eficiente de dados espaço-temporais e suporta saída de vídeo em alta qualidade.

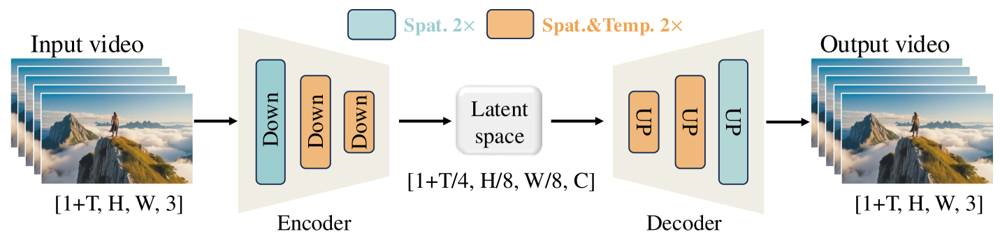

O Wan-VAE foi especialmente projetado para vídeos. Ele comprime a entrada por fatores impressionantes (temporal 4× e espacial 8×) em um latente compacto antes de decodificá-lo de volta para o vídeo completo. O uso de convoluções 3D e camadas causais (preservando o tempo) garante movimento coerente ao longo do conteúdo gerado.

Figura: Framework Wan-VAE do Wan 2.1 (encoder-decoder). O encoder Wan-VAE (à esquerda) aplica uma série de camadas de downsampling (“Down”) ao vídeo de entrada (formato [1+T, H, W, 3] quadros) até alcançar um latente compacto ([1+T/4, H/8, W/8, C]). O decoder Wan-VAE (à direita) faz o upsampling (“UP”) desse latente simetricamente de volta para os quadros originais do vídeo. Blocos azuis indicam compressão espacial e blocos laranja indicam compressão espacial+temporal combinada (ar5iv.org

). Ao comprimir o vídeo em 256× (em volume espaço-temporal), o Wan-VAE torna viável o modelamento de vídeo em alta resolução para o modelo de difusão subsequente.

Pronto para experimentar o Wan 2.1 você mesmo? Veja como começar:

Clone o repositório e instale as dependências:

git clone https://github.com/Wan-Video/Wan2.1.git

cd Wan2.1

pip install -r requirements.txt

Baixe os pesos do modelo:

pip install "huggingface_hub[cli]"

huggingface-cli login

huggingface-cli download Wan-AI/Wan2.1-T2V-14B --local-dir ./Wan2.1-T2V-14B

Gere seu primeiro vídeo:

python generate.py --task t2v-14B --size 1280*720 \

--ckpt_dir ./Wan2.1-T2V-14B \

--prompt "Uma skyline futurista de cidade ao pôr do sol, com carros voadores cruzando o céu."

--offload_model True --t5_cpu para descarregar partes do modelo para a CPU--size (ex: 832*480 para 16:9 480p)Como referência, uma RTX 4090 pode gerar um vídeo de 5 segundos em 480p em cerca de 4 minutos. Configurações multi-GPU e várias otimizações de desempenho (FSDP, quantização, etc.) são suportadas para uso em larga escala.

Como uma potência open-source desafiando os gigantes na geração de vídeo por IA, o Wan 2.1 representa uma mudança significativa em acessibilidade. Sua natureza livre e aberta significa que qualquer pessoa com uma GPU razoável pode explorar geração de vídeo de ponta sem taxas de assinatura ou custos de API.

Para desenvolvedores, a licença open-source permite personalização e aprimoramento do modelo. Pesquisadores podem estender suas capacidades, enquanto profissionais criativos podem prototipar conteúdo em vídeo de forma rápida e eficiente.

Em uma era em que modelos de IA proprietários estão cada vez mais trancados atrás de paywalls, o Wan 2.1 mostra que desempenho de ponta pode ser democratizado e compartilhado com toda a comunidade.

Wan 2.1 é um modelo de geração de vídeo por IA totalmente open-source desenvolvido pelo Tongyi Lab da Alibaba, capaz de criar vídeos de alta qualidade a partir de prompts de texto, imagens ou vídeos existentes. É gratuito, suporta múltiplas tarefas e roda de maneira eficiente em GPUs de consumo.

O Wan 2.1 suporta geração de vídeo multi-tarefa (texto para vídeo, imagem para vídeo, edição de vídeo, etc.), renderização de texto multilíngue em vídeos, alta eficiência com seu VAE de Vídeo 3D causal e supera muitos modelos comerciais e open-source em benchmarks.

Você precisa de Python 3.8+, PyTorch 2.4.0+ com CUDA e uma GPU NVIDIA (8GB+ de VRAM para o modelo menor, 16-24GB para o modelo grande). Clone o repositório do GitHub, instale as dependências, baixe os pesos do modelo e utilize os scripts fornecidos para gerar vídeos localmente.

O Wan 2.1 democratiza o acesso à geração de vídeo de última geração por ser open-source e gratuito, permitindo que desenvolvedores, pesquisadores e criadores experimentem e inovem sem barreiras de pagamento ou restrições proprietárias.

Diferente de alternativas proprietárias como Sora ou Runway Gen-2, o Wan 2.1 é totalmente open-source e pode ser executado localmente. Ele geralmente supera modelos open-source anteriores e iguala ou supera muitas soluções comerciais em benchmarks de qualidade.

Arshia é Engenheira de Fluxos de Trabalho de IA na FlowHunt. Com formação em ciência da computação e paixão por IA, ela se especializa em criar fluxos de trabalho eficientes que integram ferramentas de IA em tarefas do dia a dia, aumentando a produtividade e a criatividade.

Comece a criar suas próprias ferramentas de IA e fluxos de trabalho para geração de vídeo com o FlowHunt ou agende uma demonstração para ver a plataforma em ação.

A FlowHunt agora oferece suporte aos modelos de geração de vídeo Wan 2.2 e 2.5 para texto para vídeo, imagem para vídeo, substituição de persona e animação. Tra...

Aprenda a usar o WAN 2.2 Animate Replace para criar vídeos profissionais com troca de rostos e animação por IA. Descubra o fluxo de trabalho completo, técnicas ...

A atualização de outubro de 2025 do FlowHunt traz os revolucionários modelos Wan 2.2 e 2.5 para geração de vídeo a partir de texto, imagem para vídeo e animação...