Muralhas

Na IA, uma 'muralha' é uma vantagem competitiva sustentável—como economias de escala, efeitos de rede, tecnologia proprietária, altos custos de troca e muralhas...

Automação de IA

Explore a infraestrutura oculta por trás dos sistemas de IA. Entenda como funcionam os data centers, suas demandas de energia, sistemas de refrigeração, cronogramas de construção e o enorme investimento que está remodelando a infraestrutura global.

Quando você abre o ChatGPT, digita um prompt e aperta enter, não está apenas conectando-se a uma nuvem misteriosa. Por trás dessa interação simples está uma das infraestruturas mais complexas, caras e intensivas em energia já construídas pela humanidade. Cada resposta de IA que você recebe é alimentada por enormes data centers — instalações bilionárias resfriadas por ar e água, consumindo eletricidade suficiente para abastecer cidades inteiras. Esses não são conceitos abstratos flutuando em algum lugar do ciberespaço; são prédios físicos repletos de hardware especializado, sistemas sofisticados de refrigeração e segurança digna de fortalezas. Entender o que há dentro desses data centers é essencial para compreender como a IA moderna realmente funciona e por que empresas como OpenAI, Google, Microsoft e Meta estão investindo trilhões de dólares em sua construção. Este artigo explora a espinha dorsal oculta da revolução da IA, desde a arquitetura básica dos data centers até os complexos desafios de engenharia que enfrentam, as impressionantes demandas de eletricidade que geram e a corrida global para construir a infraestrutura que alimentará a próxima geração da inteligência artificial.

{{ < youtubevideo videoID=“WNt_1bSODIo” title=“O que há dentro de um Data Center de IA?” class=“rounded-lg shadow-md” > }}

Data centers são essencialmente fábricas de computação. Enquanto o termo “nuvem” se tornou onipresente no marketing tecnológico, é um equívoco — não existe nuvem. O que realmente existe são enormes edifícios físicos repletos de equipamentos de computação especializados, infraestrutura de rede, sistemas de energia e mecanismos de resfriamento. Um data center pode ser visto como uma versão extremamente ampliada de um computador pessoal. Assim como seu notebook contém CPU, GPU, memória, armazenamento e fonte de alimentação, um data center hiperescalável contém esses mesmos componentes, porém multiplicados por bilhões. A instalação gerencia e serve dados através de sistemas interconectados de servidores, aceleradores de IA, arranjos de armazenamento e equipamentos de rede. Esses prédios operam como pequenas cidades, com seus próprios sistemas de geração e distribuição de energia, geradores de backup, infraestrutura de segurança e controles ambientais. O objetivo fundamental permanece constante, seja o data center equipado com CPUs para tarefas de computação geral ou GPUs para cargas de trabalho de inteligência artificial — processar, armazenar e entregar dados em grande escala. No entanto, o design, a arquitetura e as exigências operacionais específicas dos data centers voltados para IA tornaram-se dramaticamente diferentes dos data centers tradicionais, exigindo abordagens totalmente novas para gestão de energia, refrigeração e planejamento de infraestrutura.

O surgimento da IA generativa transformou fundamentalmente a indústria de data centers de maneiras que vão muito além de simplesmente ampliar a infraestrutura existente. Antes do final de 2022, quando o ChatGPT foi lançado ao mundo, os data centers eram focados principalmente em tarefas gerais de computação — hospedagem de sites, gerenciamento de bancos de dados, execução de aplicações corporativas e fornecimento de serviços em nuvem. As demandas computacionais eram relativamente previsíveis e gerenciáveis. No entanto, o crescimento explosivo dos grandes modelos de linguagem e sistemas de IA generativa criou uma nova categoria de carga de trabalho computacional que opera sob restrições completamente diferentes. Esses sistemas de IA dependem de multiplicação de matrizes — uma operação matematicamente simples que precisa ser realizada bilhões de vezes por segundo. Essa exigência direcionou toda a indústria para hardware especializado de GPU, especialmente os chips avançados da Nvidia, desenvolvidos especificamente para executar essas operações de forma eficiente. A mudança foi tão dramática que criou uma verdadeira escassez de capacidade de GPU, com empresas incapazes de adquirir hardware suficiente para atender à demanda. Isso desencadeou o que só pode ser descrito como uma corrida armamentista tecnológica, com todas as grandes empresas de tecnologia investindo centenas de bilhões de dólares para garantir o fornecimento de GPUs e construir infraestrutura de data center otimizada para IA. A escala desse desenvolvimento é inédita — apenas o projeto Stargate da OpenAI, Oracle e SoftBank visa investir trilhões de dólares em infraestrutura de IA nos Estados Unidos. Isso não é simplesmente uma atualização incremental dos sistemas existentes; representa uma reestruturação fundamental da infraestrutura global de computação para suportar um novo paradigma tecnológico.

A restrição mais crítica para a expansão dos data centers de IA é a eletricidade. Diferente dos data centers tradicionais, que podem consumir 10-15 quilowatts por rack, os data centers modernos de IA já atingem 80-120 quilowatts por rack atualmente, com sistemas da próxima geração da Nvidia (era Ruben) previstos para alcançar 600 quilowatts por rack ainda nesta década. Isso representa um aumento de cinco a dez vezes na densidade de energia, criando desafios inéditos para geração, distribuição e gerenciamento de energia. Para contextualizar, o Departamento de Energia dos EUA estima que data centers consumiram 4,4% de toda a eletricidade em 2023, e esse número pode chegar a 7-12% até 2028. O Conselho de Confiabilidade Elétrica do Texas (ERCOT) e outros operadores de rede projetam cerca de 30 gigawatts de nova demanda de pico até 2030, em grande parte impulsionada pela expansão dos data centers. Para ilustrar, 30 gigawatts equivalem aproximadamente ao consumo de eletricidade de 25-30 milhões de residências, ou à produção de cerca de 30 grandes usinas nucleares. Isso cria um enorme desafio para companhias elétricas e redes regionais, que foram projetadas para uma era completamente diferente de demanda energética. O problema é agravado pelo fato de que o consumo de eletricidade dos data centers de IA não é distribuído uniformemente pelo país ou ao longo do tempo. Essas instalações exigem cargas constantes e densas de energia, próximas de subestações específicas, o que gera pressão localizada sobre a infraestrutura elétrica. Empresas como Google, Microsoft e OpenAI agora precisam tomar decisões estratégicas sobre a localização dos data centers com base principalmente na disponibilidade de eletricidade, não apenas em fatores tradicionais como custo do imóvel ou proximidade dos usuários. Isso levou a uma concentração geográfica do desenvolvimento de data centers em regiões com abundante capacidade de geração de energia, como o centro-norte dos EUA, os países nórdicos e áreas com geração significativa de energia hidrelétrica ou nuclear. A restrição energética tornou-se tão relevante que hoje é o principal fator limitante para expansão da infraestrutura de IA, mais importante do que terreno, mão de obra ou até mesmo disponibilidade de GPU.

Um data center moderno de IA é organizado em diversos sistemas interconectados, cada um desempenhando uma função crítica. No núcleo estão os racks — estruturas metálicas que abrigam as GPUs e aceleradores de IA responsáveis pelo processamento. Esses racks são conectados por switches de rede de alta velocidade, permitindo comunicação em largura de banda extremamente alta. O data center também contém matrizes de armazenamento que guardam petabytes de informações — dados de treinamento, pesos dos modelos e dados de usuários necessários aos sistemas de IA. Além do hardware computacional, a instalação exige sofisticada infraestrutura elétrica, incluindo transformadores, painéis de distribuição, no-breaks (UPS) e geradores de backup. Os sistemas de energia precisam ser projetados para suportar não apenas a carga média, mas também os picos de uso quando todos os sistemas estão operando em máxima capacidade. Igualmente importante é a infraestrutura de refrigeração, que tornou-se um dos aspectos mais críticos e complexos do design moderno de data centers. Os sistemas de refrigeração devem remover o calor gerado pelo equipamento e manter temperaturas ideais de operação para o hardware. Isso envolve uma combinação de unidades de tratamento de ar, circuitos de resfriamento líquido, sistemas de água gelada e, em alguns casos, refrigeração líquida direta, onde o líquido refrigerante passa diretamente sobre os chips. A instalação também exige ampla infraestrutura de segurança, incluindo barreiras físicas, sistemas de controle de acesso, câmeras de vigilância e medidas de cibersegurança para proteção contra invasões físicas e digitais. Por fim, o data center precisa de sistemas redundantes para funções críticas — energia, refrigeração e rede de backup — para garantir a continuidade operacional mesmo em caso de falha de componentes individuais.

Embora a FlowHunt seja especializada em automatizar fluxos de trabalho de conteúdo de IA, e não em gerenciar infraestrutura física, os princípios de eficiência e otimização que regem o design dos data centers aplicam-se diretamente a como as organizações podem agilizar suas operações de IA. Assim como os data centers otimizam o consumo de energia, a eficiência da refrigeração e o throughput computacional, as empresas que usam ferramentas de IA devem otimizar seus fluxos de trabalho para maximizar o valor extraído dos sistemas de IA, minimizando o desperdício de recursos. A FlowHunt automatiza processos de pesquisa, geração e publicação de conteúdo que normalmente exigiriam muito esforço manual e coordenação. Automatizando esses processos, as organizações podem reduzir a sobrecarga computacional de suas operações de conteúdo, de maneira semelhante a como os data centers otimizam sua infraestrutura. A plataforma ajuda as equipes a entender e acompanhar a eficiência de seus fluxos de trabalho de IA, fornecendo visibilidade sobre o uso de recursos — assim como os operadores de data centers monitoram o consumo de energia e a eficiência da refrigeração. Para organizações que desenvolvem produtos ou serviços baseados em IA, compreender os requisitos e restrições de infraestrutura dos data centers é crucial para tomar decisões embasadas sobre implantação, escalabilidade e gestão de custos. As capacidades de automação da FlowHunt ajudam equipes a trabalharem de forma mais eficiente dentro dessas limitações, permitindo gerar mais conteúdo, realizar mais pesquisas e publicar com mais frequência sem aumentar proporcionalmente a demanda computacional ou a sobrecarga operacional.

Um dos aspectos mais subestimados da operação dos data centers de IA é a refrigeração. A densidade de computação nesses data centers modernos gera quantidades enormes de calor que precisam ser removidas dos chips para evitar danos térmicos e manter o desempenho ideal. Sem refrigeração eficaz, o silício literalmente derreteria e toda a instalação seria desligada. Esse desafio de refrigeração levou a uma mudança fundamental na filosofia de design dos data centers, migrando da tradicional refrigeração por ar para sistemas líquidos mais sofisticados. A refrigeração por ar, onde ventiladores sopram ar frio sobre os equipamentos, é a abordagem tradicional usada na maioria dos data centers. No entanto, o ar tem condutividade térmica relativamente baixa em comparação com líquidos, o que o torna menos eficiente para remover calor de equipamentos densamente agrupados. Com o aumento da densidade de energia, a refrigeração por ar tornou-se cada vez mais insuficiente. Sistemas de refrigeração líquida, nos quais água ou líquidos especiais fluem diretamente sobre ou próximos aos chips, são muito mais eficazes para remoção de calor. Existem várias abordagens para refrigeração líquida: sistemas de circuito fechado, em que o líquido circula pelo equipamento e retorna ao resfriador sem contato com o ambiente, e sistemas de circuito aberto, em que o líquido pode ser exposto a condições ambientais. Sistemas de circuito fechado são mais eficientes no uso da água, mas podem consumir mais eletricidade para o resfriamento. Sistemas de circuito aberto podem ser mais eficientes em termos de eletricidade, porém consomem mais água. A escolha entre essas abordagens depende da disponibilidade local de água, custos de eletricidade, condições climáticas e regulamentações ambientais. A efetividade do uso de água (WUE) é um indicador-chave para medir a eficiência do data center, calculada em litros de água por quilowatt-hora de energia consumida pelo equipamento de TI. No setor, o valor típico de WUE gira em torno de 1,9 litros por kWh, mas instalações que usam sistemas totalmente fechados podem se aproximar de zero uso de água. O data center do Google em Council Bluffs, Iowa, por exemplo, consumiu aproximadamente um bilhão de galões de água em 2023, destacando as demandas massivas de água dessas instalações de IA em larga escala. Algumas instalações inovadoras estão explorando abordagens alternativas, incluindo o uso do calor residual para aquecimento distrital (como faz a Meta na Dinamarca, exportando 100-165 GWh de calor por ano para redes de aquecimento locais), refrigeração gratuita com ar ambiente em climas frios e até sistemas de refrigeração à base de hidrogênio. A infraestrutura de refrigeração representa uma parte significativa do investimento de capital em um data center e, muitas vezes, é o desafio de engenharia mais complexo na fase de projeto.

Construir um data center de IA hiperescalável é um empreendimento gigantesco que exige planejamento cuidadoso, investimento significativo de capital e coordenação com múltiplas partes interessadas. O cronograma típico, do conceito inicial até a operação completa, abrange de 18 a 30 meses, dividido em várias fases distintas. A primeira fase é o planejamento e avaliação de viabilidade, que geralmente leva de 3 a 6 meses. Nessa etapa, as empresas identificam possíveis locais, avaliam a disponibilidade e capacidade local de energia, recursos hídricos, revisam regulamentações e zoneamento, e promovem engajamento com a comunidade. Encontrar terreno adequado não é trivial — a instalação precisa de acesso abundante à eletricidade, conexões de fibra óptica de alta velocidade para internet, água suficiente para refrigeração e apoio do governo local. A segunda fase é o projeto e a engenharia, com duração de 6 a 12 meses. Nessa etapa, arquitetos e engenheiros desenvolvem planos detalhados para a instalação, incluindo a disposição dos racks e equipamentos, sistema de distribuição de energia, infraestrutura de refrigeração, sistemas de segurança e todos os outros sistemas prediais. Essa fase envolve modelagem e simulação extensivas para otimizar a eficiência e garantir que todos os sistemas funcionem de forma integrada. A terceira fase é de permissões e aprovações, que se sobrepõe ao projeto e engenharia e geralmente leva de 6 a 18 meses. Isso inclui obtenção de alvarás de construção, licenças ambientais, acordos de conexão com concessionárias e outras autorizações exigidas pelas autoridades locais, estaduais e federais. Esta etapa pode ser especialmente demorada em áreas com regulamentação ambiental rigorosa ou oposição da comunidade ao projeto. A quarta fase é a construção propriamente dita, que leva de 1 a 2 anos. Inclui a edificação da estrutura física, instalação de todo o equipamento, montagem dos sistemas elétricos e de refrigeração e implementação da infraestrutura de segurança. A fase final é de testes e comissionamento, com duração de 3 a 6 meses. Todos os sistemas são testados para garantir que funcionam corretamente, o software é configurado e a instalação é gradualmente colocada em operação. A exceção mais famosa a esse cronograma é o projeto Colossus da XAI, concluído em apenas 122 dias — um feito inédito que exigiu coordenação, pré-planejamento e recursos extraordinários. A maioria dos projetos, porém, segue o cronograma padrão de 18 a 30 meses. O investimento de capital nesses projetos é impressionante. O campus Fairwater Supercomputer da Microsoft, por exemplo, se espalha por centenas de acres, requer quilômetros de fundações e envolve a instalação de milhares de GPUs com sistemas sofisticados de refrigeração líquida. O investimento total desses projetos pode facilmente chegar a dezenas de bilhões de dólares. Esse investimento massivo reflete a importância estratégica da infraestrutura de IA para essas empresas e a pressão competitiva para garantir capacidade de GPU e construir capacidades de IA o mais rápido possível.

Depois de construídos, os data centers de IA operam com segurança digna de fortalezas e procedimentos operacionais sofisticados. Essas instalações abrigam equipamentos avaliados em bilhões de dólares e executam sistemas críticos para as operações de grandes empresas de tecnologia. Segurança física é prioridade máxima. As instalações são cercadas por cercas altas e barreiras para impedir acesso não autorizado de veículos. Os pontos de entrada são rigorosamente controlados, com múltiplas camadas de segurança, incluindo leitores de crachá, scanners biométricos e seguranças. Visitantes são raros e precisam de pré-aprovação; as salas de servidores são restritas, só sendo acessadas com escolta autorizada. Câmeras monitoram todas as áreas da instalação continuamente. A infraestrutura de segurança é projetada para prevenir tanto roubos quanto sabotagem. A cibersegurança é igualmente importante. Os sistemas operando nesses data centers contêm propriedade intelectual valiosa, dados de usuários e modelos treinados que representam anos de pesquisa e bilhões de dólares em investimento. As medidas de cibersegurança empregadas estão entre as mais sofisticadas disponíveis, incluindo segmentação de rede, sistemas de detecção de intrusão, criptografia e monitoramento contínuo de atividades suspeitas. Cada rack geralmente fica trancado em uma gaiola, e o acesso a sistemas críticos é restrito a pessoal autorizado. A complexidade operacional para manter essas instalações é enorme. Operadores de data center devem monitorar continuamente o consumo de energia, eficiência da refrigeração, saúde dos equipamentos, desempenho da rede e segurança. Devem gerenciar o agendamento das cargas de trabalho para balancear o consumo de energia na instalação e evitar sobrecarga em qualquer setor. É preciso coordenar atividades de manutenção para minimizar o tempo de inatividade. Também é necessário responder a falhas de equipamentos e executar reparos. Uma grande instalação pode empregar dezenas ou até centenas de profissionais em diversos papéis, embora, quando totalmente automatizado, um único data center possa ser administrado por uma equipe relativamente pequena. Os procedimentos operacionais são altamente padronizados e documentados, com protocolos claros para situações comuns e procedimentos de emergência para eventos incomuns.

A localização dos data centers de IA tornou-se uma decisão estratégica para as grandes empresas de tecnologia, impulsionada principalmente pela disponibilidade de eletricidade, mas também influenciada por recursos hídricos, clima, conectividade por fibra óptica, regulamentações locais e fatores comunitários. A Virgínia do Norte tornou-se o maior mercado de data center do mundo, com taxas de vacância próximas de zero e gigawatts de nova capacidade sendo construídos. O Condado de Loudoun, Virgínia, tornou-se tão dependente da receita de data centers que o orçamento do condado informa explicitamente que eles geram cerca de 38% do fundo geral local. Isso permitiu ao condado reduzir impostos sobre propriedades para os residentes, demonstrando o significativo benefício econômico que data centers podem trazer às comunidades locais. No entanto, outras regiões estão surgindo como alternativas atraentes. Phoenix, Chicago, Oregon e Ohio estão recebendo investimentos significativos em data centers devido à combinação de disponibilidade de terrenos, capacidade adequada de geração de energia e recursos hídricos. O centro-norte dos EUA, especialmente áreas próximas a hidrelétricas ou usinas nucleares, é especialmente atraente devido à abundância de energia limpa. Os países nórdicos, especialmente Islândia e Noruega, tornaram-se polos de data centers devido à grande oferta de energia hidrelétrica e clima frio, que reduz os custos de refrigeração. O impacto econômico do desenvolvimento de data centers é complexo. Durante a fase de construção, gera-se muito emprego — operários, engenheiros e gerentes de projeto. Porém, uma vez operacional, o impacto no emprego é bem menor. Um grande data center pode empregar apenas algumas dezenas de pessoas na operação e manutenção, muito menos do que na construção. Isso é algo que governos locais devem considerar ao avaliar projetos. A receita tributária gerada pode ser substancial, como mostra a experiência do Condado de Loudoun, mas os benefícios de emprego são limitados. Além disso, data centers podem gerar preocupações ambientais relativas ao consumo de água, demanda de eletricidade e geração de calor. Os melhores projetos de data center são transparentes quanto ao impacto ambiental, trabalham em conjunto com concessionárias para garantir o fornecimento de energia, implementam medidas de conservação de água e se integram à comunidade local ao invés de atuarem de forma isolada.

A infraestrutura elétrica que sustenta os data centers de IA é tão complexa quanto a infraestrutura computacional em si. Data centers exigem não apenas fornecimento adequado de energia, mas energia confiável e consistente, capaz de suportar picos de demanda sem interrupção. A maioria dos grandes data centers está conectada à rede elétrica regional, mas também mantém geração de energia de backup para garantir a continuidade operacional em caso de falha da rede. Praticamente todos os grandes data centers dos EUA possuem enormes geradores a diesel como backup emergencial. Esses geradores podem fornecer eletricidade suficiente para manter a instalação funcionando por longos períodos se a rede falhar. Embora raramente sejam usados, quando ativados, geram poluição e emissões. O impacto ambiental dos geradores a diesel tem levado operadores a buscar alternativas. Algumas instalações estão testando sistemas de baterias conectadas à rede, capazes de armazenar eletricidade e liberá-la durante falhas. Outras exploram turbinas a gás no local, que podem gerar energia de forma mais limpa do que geradores a diesel. Alguns centros de ponta estão experimentando células a combustível de hidrogênio como fonte de energia de backup. Olhando para o futuro, alguns operadores consideram a possibilidade de geração nuclear no local, embora isso ainda seja em grande parte teórico. O relacionamento entre data centers e concessionárias é fundamental. Data centers representam cargas enormes e constantes na rede, e as concessionárias precisam planejar sua geração e distribuição para acomodar essas cargas. Empresas como Google, Microsoft e OpenAI trabalham em estreita colaboração com concessionárias para coordenar o fornecimento, frequentemente firmando contratos de compra de energia de longo prazo que garantem eletricidade a preços negociados. Algumas empresas também investem em projetos de energia renovável — fazendas solares, eólicas e hidrelétricas — para gerar sua própria energia e reduzir a dependência da rede. As decisões relativas à infraestrutura elétrica tomadas por operadores de data center têm efeitos em cascata em todo o sistema elétrico regional e podem influenciar políticas e investimentos em nível estadual e nacional.

A trajetória do desenvolvimento de data centers de IA é clara: a expansão continuará em ritmo acelerado, impulsionada pelo crescimento explosivo das aplicações de IA e pela pressão competitiva para garantir capacidade computacional. A demanda por eletricidade continuará crescendo, criando desafios para geração e distribuição de energia. Os requisitos de refrigeração continuarão a impulsionar inovação em tecnologias térmicas. As exigências de segurança continuarão a aumentar à medida que cresce o valor dos sistemas e dos dados abrigados nessas instalações. Várias tendências devem moldar o futuro da infraestrutura de data centers de IA. Primeiro, haverá diversificação geográfica, com data centers se espalhando para novas regiões que possam oferecer energia, água e conectividade adequadas. Segundo, haverá inovação contínua em tecnologias de refrigeração, com a refrigeração líquida tornando-se padrão e novas abordagens como imersão e refrigeração bifásica sendo exploradas. Terceiro, haverá foco crescente em sustentabilidade, com operadores buscando minimizar o consumo de água, reduzir emissões de carbono e integrar energias renováveis. Quarto, haverá consolidação e especialização, com algumas instalações otimizadas para treinamento de modelos e outras para inferência. Quinto, haverá automação crescente nas operações dos data centers, com a própria IA sendo usada para otimizar consumo de energia, eficiência de refrigeração e uso de equipamentos. A escala de investimento em infraestrutura de data centers de IA é inédita e reflete a importância estratégica da IA para a economia global. Essas instalações representam a manifestação física da revolução da IA, a espinha dorsal oculta que torna possíveis todas as aplicações e serviços de IA que estão transformando indústrias e a sociedade.

{{ < cta-dark-panel heading=“Turbine seu fluxo de trabalho com a FlowHunt” description=“Veja como a FlowHunt automatiza seus fluxos de conteúdo de IA e SEO — da pesquisa e geração de conteúdo à publicação e análise — tudo em um só lugar.” ctaPrimaryText=“Agende uma demonstração” ctaPrimaryURL=“https://calendly.com/liveagentsession/flowhunt-chatbot-demo" ctaSecondaryText=“Experimente a FlowHunt grátis” ctaSecondaryURL=“https://app.flowhunt.io/sign-in" gradientStartColor="#123456” gradientEndColor="#654321” gradientId=“827591b1-ce8c-4110-b064-7cb85a0b1217”

}}

A escala financeira do investimento em data centers de IA é impressionante e reflete o enorme valor que as empresas acreditam obter das capacidades de IA. O projeto Stargate da OpenAI, Oracle e SoftBank pretende investir trilhões de dólares na expansão de infraestrutura de IA nos EUA. A Nvidia prometeu contribuir com US$ 100 bilhões para esse objetivo. Google, Microsoft, Meta e outras grandes empresas de tecnologia estão investindo centenas de bilhões de dólares em suas próprias expansões de data centers. Esses investimentos estão sendo feitos apesar de grande incerteza quanto ao retorno, refletindo a importância estratégica da IA e a pressão competitiva para garantir capacidade computacional. A economia da operação de data centers é complexa. Os custos de capital são enormes — dezenas de bilhões de dólares para uma grande instalação. Os custos operacionais também são substanciais, impulsionados principalmente pelo consumo de eletricidade. Um grande data center de IA pode consumir continuamente 100-300 megawatts de energia, o que, a taxas típicas de eletricidade de US$ 50-100 por megawatt-hora, representa US$ 50-300 milhões por ano só em eletricidade. Some-se a isso custos de refrigeração, manutenção, segurança e pessoal, e os custos operacionais anuais podem facilmente ultrapassar US$ 500 milhões para uma grande instalação. Esses custos precisam ser recuperados por meio da receita gerada — seja vendendo capacidade computacional para clientes ou usando a capacidade internamente para gerar receitas via serviços de IA. A precificação da capacidade computacional é competitiva, com empresas oferecendo acesso a GPUs a preços que refletem os custos subjacentes mais uma margem de lucro. À medida que mais capacidade entra em operação, a pressão sobre preços pode aumentar, comprimindo margens e dificultando a recuperação do investimento. No entanto, a demanda por capacidade computacional de IA parece crescer mais rápido que a oferta, sugerindo que os preços podem permanecer altos no futuro próximo. O retorno sobre o investimento para operadores de data center depende de sua capacidade de manter a instalação plenamente utilizada, gerenciar custos operacionais de forma eficaz e manter poder de precificação em um mercado competitivo. Empresas que possuem seus próprios data centers e os usam internamente para gerar receita com serviços de IA podem ter uma dinâmica econômica diferente de empresas que operam data centers como negócio, vendendo capacidade para clientes.

O impacto ambiental da expansão dos data centers de IA é significativo e multifacetado. O impacto mais visível é o consumo de eletricidade. À medida que os data centers consomem parcela crescente da geração total de energia, contribuem para emissões de carbono (a menos que operem com energia renovável ou nuclear) e pressionam as redes elétricas. O consumo de água também é substancial, especialmente em instalações que usam refrigeração à base de água. O calor gerado pelos data centers, embora às vezes seja reaproveitado (como na instalação da Meta na Dinamarca), geralmente é simplesmente dissipado no ambiente. O impacto ambiental tem levado a um foco maior em sustentabilidade. Muitos operadores estão assumindo compromissos de carbono neutro ou emissões líquidas zero, o que normalmente envolve a compra ou o investimento em energia renovável. Alguns implementam medidas de conservação de água, incluindo sistemas de refrigeração em circuito fechado e refrigeração a seco quando viável. Outros buscam formas de reutilizar o calor residual para aquecimento distrital ou outros usos. O impacto ambiental também está impulsionando debates políticos em nível estadual e nacional. Algumas jurisdições estão implementando regulamentações sobre uso de água, emissões de carbono ou exigindo estudos de impacto ambiental para novos projetos. Outras oferecem incentivos para desenvolvimento de data centers em regiões com abundante energia renovável. O equilíbrio entre a necessidade de capacidade computacional de IA e o impacto ambiental da expansão dos data centers provavelmente será uma questão relevante nos próximos anos. Encontrar formas de atender à crescente demanda por IA minimizando o impacto ambiental será um dos principais desafios do setor.

Os data centers de IA representam um dos maiores empreendimentos de infraestrutura da história da humanidade, rivalizando em escala e complexidade com a construção de redes elétricas, telecomunicações e sistemas de transporte. Essas enormes instalações, alimentadas por bilhões de dólares em investimento e engenharia de ponta, formam a espinha dorsal oculta da revolução da IA. Do momento em que você digita um prompt no ChatGPT até o instante em que recebe uma resposta, ocorre uma complexa dança de computação, distribuição de energia, refrigeração e movimentação de dados nessas instalações. Os desafios enfrentados pelo setor são imensos: garantir fornecimento de eletricidade suficiente, gerenciar o calor extremo, construir instalações em velocidade inédita e fazer tudo isso minimizando o impacto ambiental. Mesmo assim, os investimentos continuam fluindo, impulsionados pela importância estratégica da IA e pela competição entre empresas para garantir capacidade computacional. Entender o que há dentro desses data centers — os racks de GPUs, sistemas sofisticados de refrigeração, infraestrutura de energia, medidas de segurança — fornece insights cruciais sobre como a IA moderna realmente funciona e por que as exigências de infraestrutura são tão altas. À medida que a IA evolui e se torna ainda mais central para a economia global, os data centers que sustentam esses sistemas ganharão importância, e os desafios de construir, operar e manter essas instalações só se tornarão mais complexos.

Os data centers de IA são otimizados especificamente para operações de multiplicação de matrizes exigidas por modelos de aprendizado de máquina. Eles apresentam maior densidade de energia (até 600 kW por rack), sistemas avançados de refrigeração líquida e infraestrutura especializada de GPU, em comparação com data centers tradicionais que lidam com tarefas gerais de computação com requisitos energéticos menores (10-15 kW por rack).

Em 2023, data centers usaram 4,4% de toda a eletricidade dos EUA, com projeções de atingir 7-12% até 2028. Uma única consulta ao ChatGPT consome aproximadamente 2,9 watt-hora, enquanto sistemas de IA generativa consomem de 10 a 30 vezes mais eletricidade do que IA de tarefas específicas. Espera-se que os EUA precisem de 30 gigawatts de nova demanda de pico de eletricidade até 2030, em grande parte devido aos data centers.

Data centers de IA modernos empregam sistemas de refrigeração por ar e por líquido. A refrigeração líquida direta é mais eficiente e economiza eletricidade, mas usa água. Sistemas de líquido em circuito fechado minimizam o uso de água mantendo a eficiência. A efetividade do uso de água (WUE) normalmente é em média 1,9 litro por quilowatt-hora, com sistemas totalmente em circuito fechado se aproximando de zero uso de água.

A construção padrão de um data center hiperescalável leva de 18 a 30 meses, do conceito à operação, incluindo planejamento (3-6 meses), projeto e engenharia (6-12 meses), permissões e aprovações (6-18 meses), construção (1-2 anos) e testes (3-6 meses). O projeto mais rápido já registrado foi o Colossus da XAI, concluído em apenas 122 dias.

Arshia é Engenheira de Fluxos de Trabalho de IA na FlowHunt. Com formação em ciência da computação e paixão por IA, ela se especializa em criar fluxos de trabalho eficientes que integram ferramentas de IA em tarefas do dia a dia, aumentando a produtividade e a criatividade.

Descubra como a FlowHunt simplifica a geração de conteúdo de IA, pesquisa e publicação — aproveitando os mesmos princípios de infraestrutura que impulsionam os data centers modernos.

Na IA, uma 'muralha' é uma vantagem competitiva sustentável—como economias de escala, efeitos de rede, tecnologia proprietária, altos custos de troca e muralhas...

Descubra os melhores construtores de chatbots de IA em 2025. Compare FlowHunt, Botpress, Chatbase e outras plataformas líderes com recursos detalhados, preços e...

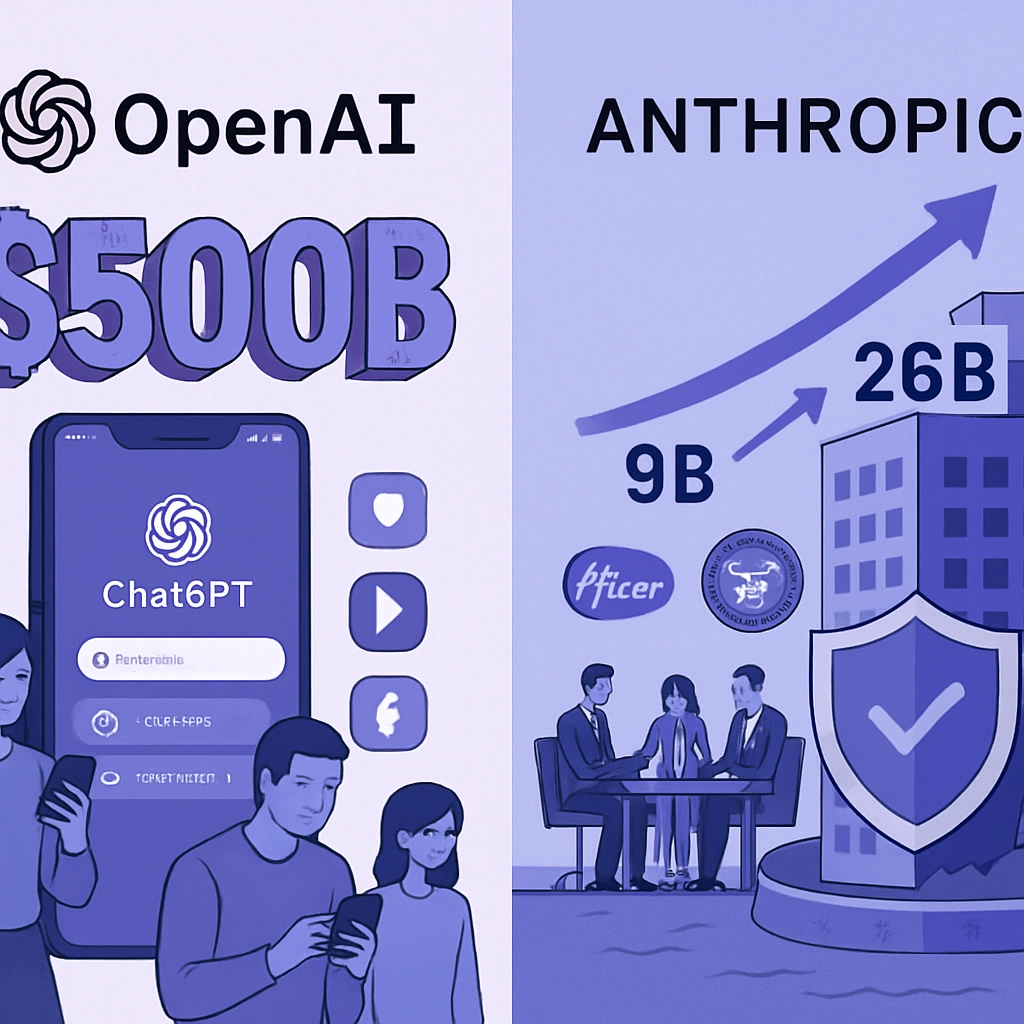

A avaliação de $500 bilhões da OpenAI está sob escrutínio, já que modelos de IA commoditizados e alternativas open source nivelam o mercado. Descubra por que a ...

Consentimento de Cookies

Usamos cookies para melhorar sua experiência de navegação e analisar nosso tráfego. See our privacy policy.