Como Construir um Chatbot de IA: Guia Completo Passo a Passo

Aprenda a construir um chatbot de IA do zero com nosso guia abrangente. Descubra as melhores ferramentas, frameworks e o passo a passo para criar sistemas intel...

Descubra como chatbots de IA processam linguagem natural, entendem a intenção do usuário e geram respostas inteligentes. Aprenda sobre PLN, aprendizado de máquina e arquitetura de chatbots com profundidade técnica.

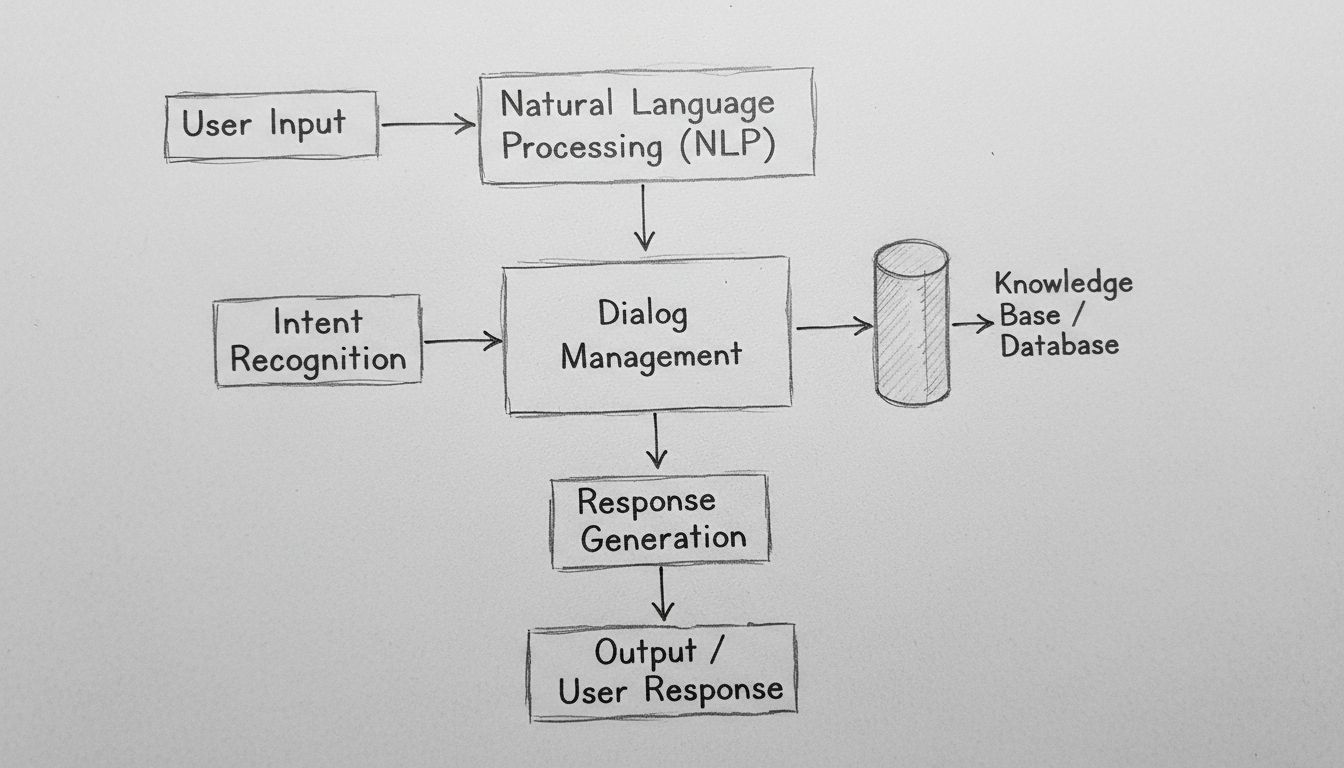

Chatbots de IA funcionam processando entradas em linguagem natural através de algoritmos de PLN, reconhecendo a intenção do usuário, acessando bases de conhecimento e gerando respostas contextuais relevantes usando modelos de aprendizado de máquina. Chatbots modernos combinam tokenização, extração de entidades, gerenciamento de diálogo e redes neurais para simular conversas humanas em escala.

Chatbots de IA representam uma sofisticada convergência de processamento de linguagem natural, aprendizado de máquina e sistemas de gerenciamento de diálogo trabalhando em conjunto para simular conversas humanas. Ao interagir com um chatbot moderno, você está se conectando a um sistema tecnológico em camadas que processa sua entrada por várias etapas distintas antes de entregar uma resposta. A arquitetura por trás desses sistemas evoluiu dramaticamente, indo de simples árvores de decisão baseadas em regras para redes neurais complexas capazes de entender contexto, nuances e até sentimentos. Compreender como esses sistemas funcionam exige examinar cada componente do pipeline e reconhecer como eles interagem para criar experiências conversacionais fluidas.

A jornada de qualquer mensagem do usuário por um chatbot de IA começa com o processamento da entrada, uma fase crítica que transforma texto bruto em dados estruturados que o sistema pode analisar. Ao digitar uma mensagem como “Preciso redefinir minha senha”, o chatbot não entende imediatamente sua intenção — primeiro, ele precisa decompô-la em componentes gerenciáveis. Esse processo, chamado tokenização, quebra sua frase em palavras individuais ou unidades significativas chamadas tokens. O sistema converte “Preciso redefinir minha senha” em tokens: [“Preciso”, “redefinir”, “minha”, “senha”]. Esse passo aparentemente simples é fundamental porque permite ao chatbot analisar cada elemento linguístico de forma independente, mantendo a noção das relações dentro da estrutura da frase.

Após a tokenização, o sistema aplica a normalização, padronizando o texto ao converter para minúsculas, remover pontuação e corrigir variações comuns de ortografia. Isso garante que “Redefinição de Senha”, “redefinição de senha” e “redefiniçao de senha” sejam reconhecidas como o mesmo conceito. O chatbot também remove stop words — palavras comuns como “o”, “é”, “e” e “para”, que têm pouco significado semântico. Ao filtrar essas palavras, o sistema foca os recursos computacionais nas palavras que realmente transmitem significado. Adicionalmente, o sistema realiza a marcação de classe gramatical, identificando se cada palavra é um substantivo, verbo, adjetivo ou outra categoria gramatical. Esse entendimento gramatical ajuda o chatbot a perceber que “redefinir” é um verbo de ação na sua mensagem, crucial para determinar o que você realmente deseja realizar.

O Processamento de Linguagem Natural (PLN) representa a base tecnológica que permite aos chatbots compreenderem a linguagem humana em nível semântico. O PLN engloba múltiplas técnicas interconectadas que trabalham juntas para extrair significado do texto. Reconhecimento de Entidades Nomeadas (NER) identifica entidades específicas em sua mensagem — nomes próprios, datas, locais, nomes de produtos e outras informações importantes. No exemplo de redefinição de senha, o NER identificaria “senha” como uma entidade do sistema relevante para a base de conhecimento do chatbot. Essa capacidade torna-se ainda mais poderosa em cenários complexos: se você escrever “Quero reservar um voo de São Paulo para Lisboa em 15 de dezembro”, o NER extrai a cidade de origem, destino e a data — todas informações críticas para atender ao seu pedido.

A análise de sentimento é outro componente essencial do PLN, permitindo que chatbots detectem o tom emocional subjacente à sua mensagem. Um cliente dizendo “Estou esperando há três horas e ainda não recebi meu pedido” expressa frustração, que o chatbot deve reconhecer para ajustar o tom da resposta e priorizar o caso adequadamente. A análise de sentimento moderna utiliza modelos de aprendizado de máquina treinados em milhares de exemplos para classificar o texto como positivo, negativo ou neutro e, cada vez mais, para detectar emoções mais sutis como frustração, confusão ou satisfação. Essa inteligência emocional permite que os chatbots respondam com empatia e urgência apropriadas, melhorando significativamente os índices de satisfação do cliente.

Após processar o texto bruto, o chatbot precisa determinar o que o usuário realmente deseja — sua intenção. O reconhecimento de intenção é uma das funções mais críticas na arquitetura de chatbots, pois faz a ponte entre o que os usuários dizem e o que querem realizar. O sistema utiliza classificadores de aprendizado de máquina treinados em milhares de conversas exemplo para mapear as falas dos usuários para intenções predefinidas. Por exemplo, as frases “Esqueci minha senha”, “Como redefino minha senha?”, “Não consigo fazer login” e “Minha conta está bloqueada” podem ser mapeadas para a mesma intenção de “redefinir_senha”, mesmo que sejam ditas de formas diferentes.

Simultaneamente, o sistema realiza a extração de entidades, identificando dados específicos na mensagem do usuário relevantes para cumprir o pedido. Se o cliente diz “Quero fazer upgrade do meu plano para o nível premium”, o sistema extrai duas entidades-chave: a ação (“upgrade”) e o alvo (“nível premium”). Essas entidades extraídas tornam-se parâmetros que guiam a geração da resposta do chatbot. Chatbots avançados usam análise de dependência para entender as relações gramaticais entre as palavras, reconhecendo quais substantivos são sujeitos, quais são objetos e como se relacionam com verbos e modificadores. Esse entendimento sintático mais profundo permite ao chatbot lidar com frases complexas, de múltiplas cláusulas e redações ambíguas que confundiriam sistemas mais simples.

O gerenciamento de diálogo representa o “cérebro” do chatbot, responsável por manter o contexto da conversa e determinar respostas apropriadas. Diferentemente de sistemas simples de busca, gerenciadores de diálogo sofisticados mantêm um estado de conversa que rastreia o que foi discutido, quais informações foram coletadas e qual o objetivo atual do usuário. Essa consciência de contexto permite conversas naturais e fluidas, onde o chatbot lembra de interações anteriores e pode referenciá-las adequadamente. Se você pergunta “Como está o tempo em Lisboa?” e depois segue com “E amanhã?”, o gerenciador de diálogo entende que “amanhã” refere-se à previsão para Lisboa, não para outro lugar.

O gerenciador de diálogo implementa o gerenciamento de contexto armazenando informações relevantes de forma estruturada ao longo da conversa. Isso pode incluir informações de conta do usuário, solicitações anteriores, preferências e o tópico atual. Sistemas avançados usam máquinas de estado ou redes hierárquicas de tarefas para modelar fluxos conversacionais, definindo quais estados são alcançáveis a partir de outros e quais transições são válidas. Por exemplo, um chatbot de atendimento pode ter estados de “saudação”, “identificação do problema”, “solução de problemas”, “escalação” e “resolução”. O gerenciador de diálogo garante que a conversa progrida logicamente por esses estados, em vez de pular aleatoriamente entre eles.

Chatbots modernos de IA não geram respostas apenas a partir de seus dados de treinamento — eles acessam bases de conhecimento contendo informações atuais e precisas específicas da organização. Essa integração é fundamental para manter precisão e relevância. Quando um cliente pergunta “Qual é o meu saldo?”, o chatbot deve consultar o sistema bancário real para recuperar o saldo atual, em vez de gerar um número plausível. Da mesma forma, ao ser questionado “Qual o horário de funcionamento da loja?”, o chatbot acessa o banco de dados de informações comerciais para fornecer horários atualizados.

A Geração Aumentada por Recuperação (RAG) representa uma abordagem sofisticada para integração de conhecimento que se tornou cada vez mais importante em 2025. Sistemas RAG primeiro recuperam documentos ou informações relevantes da base de conhecimento com base na consulta do usuário e, em seguida, utilizam essas informações para gerar uma resposta contextualmente adequada. Esse processo em duas etapas melhora dramaticamente a precisão em comparação com abordagens puramente generativas. Por exemplo, se um cliente pergunta sobre um recurso específico de um produto, o sistema RAG recupera a documentação do produto, extrai a seção relevante e gera uma resposta baseada naquele conteúdo real, em vez de depender de informações possivelmente inventadas. Essa abordagem tem se mostrado especialmente valiosa em ambientes corporativos onde precisão e conformidade são essenciais.

Após entender a intenção do usuário e reunir as informações necessárias, o chatbot deve gerar uma resposta apropriada. A geração de respostas pode seguir diferentes abordagens, cada uma com vantagens e limitações distintas. A geração baseada em templates usa modelos de respostas pré-definidos com espaços para variáveis que são preenchidos com informações específicas. Por exemplo, um template pode ser “Seu pedido #[ID_PEDIDO] chegará em [DATA_ENTREGA].” Essa abordagem é altamente confiável e previsível, porém limitada em flexibilidade e naturalidade.

A geração baseada em regras aplica regras linguísticas específicas para construir respostas com base na intenção e nas entidades extraídas. Essas regras podem determinar que, para a intenção “redefinir_senha”, a resposta deve incluir uma mensagem de confirmação, um link para redefinição e instruções para os próximos passos. Essa abordagem oferece mais flexibilidade do que templates, mantendo confiabilidade, embora exija engenharia de regras extensiva para cenários complexos.

A geração baseada em redes neurais, impulsionada por grandes modelos de linguagem (LLMs), representa o estado da arte em tecnologia de geração de respostas. Esses sistemas usam arquiteturas de aprendizado profundo como Transformers para gerar respostas inéditas, contextuais e com tom humano. LLMs modernos são treinados com bilhões de tokens de texto, aprendendo padrões estatísticos sobre o funcionamento da linguagem e a relação entre conceitos. Ao gerar uma resposta, esses modelos predizem a palavra mais provável dada todas as anteriores, repetindo o processo até formar frases completas. A vantagem da geração neural é sua flexibilidade e naturalidade; a desvantagem é que esses sistemas podem ocasionalmente “alucinar” — gerando informações plausíveis, porém incorretas.

O aprendizado de máquina representa o mecanismo pelo qual chatbots melhoram com o tempo. Em vez de serem sistemas estáticos com regras fixas, chatbots modernos aprendem com cada interação, refinando gradualmente seu entendimento de padrões linguísticos e intenções do usuário. O aprendizado supervisionado envolve treinar o chatbot com exemplos rotulados, nos quais humanos anotaram a intenção correta e entidades em milhares de mensagens. O algoritmo de aprendizado de máquina aprende padrões que distinguem intenções, construindo um modelo capaz de classificar novas mensagens com alta precisão.

O aprendizado por reforço permite que chatbots otimizem respostas com base no feedback dos usuários. Quando um usuário indica satisfação com uma resposta (através de feedback explícito ou sinais implícitos, como continuar a conversa), o sistema reforça os padrões que levaram àquela resposta. Por outro lado, quando usuários demonstram insatisfação ou abandonam a conversa, o sistema aprende a evitar padrões semelhantes no futuro. Esse ciclo de feedback cria um ciclo virtuoso de melhoria contínua do desempenho do chatbot. Sistemas avançados implementam aprendizado com humano no loop, onde agentes humanos revisam conversas desafiadoras e fornecem correções que o sistema aprende, acelerando dramaticamente a melhoria em comparação com aprendizado totalmente automatizado.

Grandes Modelos de Linguagem (LLMs) transformaram fundamentalmente as capacidades dos chatbots desde 2023. Esses modelos, treinados com centenas de bilhões de tokens de texto, desenvolvem compreensão sofisticada de linguagem, contexto e conhecimento de domínio. Modelos como GPT-4, Claude e Gemini podem participar de conversas nuançadas, entender instruções complexas e gerar respostas coerentes e apropriadas em diversos tópicos. O poder dos LLMs vem de sua arquitetura transformer, que usa mecanismos de atenção para entender relações entre palavras distantes em uma frase, permitindo ao modelo manter o contexto em conversas longas.

No entanto, os LLMs têm limitações que as organizações precisam endereçar. Eles podem alucinar — gerar informações falsas com confiança. Podem ter dificuldades com informações muito recentes fora de seus dados de treinamento. Podem apresentar vieses presentes nos dados. Para mitigar essas limitações, organizações usam cada vez mais fine-tuning para adaptar LLMs a domínios específicos e engenharia de prompts para guiar os modelos ao comportamento desejado. A abordagem do FlowHunt para construção de chatbots aproveita esses modelos avançados, fornecendo mecanismos de controle e integração com fontes de conhecimento para garantir precisão e confiabilidade.

| Aspecto | Chatbots Baseados em Regras | Chatbots com IA | Chatbots com LLM |

|---|---|---|---|

| Tecnologia | Árvores de decisão, correspondência de padrões | PLN, algoritmos de AM, reconhecimento de intenção | Grandes modelos de linguagem, transformers |

| Flexibilidade | Limitada a regras predefinidas | Adapta-se a variações de fraseado | Altamente flexível, lida com entradas inéditas |

| Precisão | Alta para cenários definidos | Boa com treinamento adequado | Excelente, mas requer controles |

| Aprendizado | Sem capacidade de aprendizado | Aprende com interações | Aprende com fine-tuning e feedback |

| Risco de Alucinação | Nenhum | Mínimo | Requer estratégias de mitigação |

| Tempo de Implementação | Rápido | Moderado | Rápido com plataformas como o FlowHunt |

| Manutenção | Alta (atualização de regras) | Moderada | Moderada (atualização de modelo, monitoramento) |

| Custo | Baixo | Moderado | Moderado a alto |

| Melhores Casos de Uso | FAQs simples, roteamento básico | Atendimento ao cliente, qualificação de leads | Raciocínio complexo, geração de conteúdo |

Chatbots modernos utilizam a arquitetura Transformer, um design de rede neural que revolucionou o processamento de linguagem natural. Transformers usam mecanismos de atenção que permitem ao modelo focar em partes relevantes da entrada ao gerar cada palavra da saída. Ao processar “O gerente do banco estava preocupado com a erosão da margem do rio”, o mecanismo de atenção ajuda o modelo a entender que o primeiro “banco” refere-se a instituição financeira e o segundo à margem do rio, com base no contexto. Esse entendimento contextual é muito superior às abordagens antigas, que processavam o texto sequencialmente sem esse tipo de consciência contextual.

A atenção multi-cabeça amplia esse conceito, permitindo ao modelo focar em diferentes aspectos da entrada simultaneamente. Uma cabeça de atenção pode focar em relações gramaticais, outra em relações semânticas, outra na estrutura do discurso. Esse processamento paralelo de fenômenos linguísticos permite ao modelo construir representações ricas e nuançadas de significado. O codificador posicional nos Transformers permite ao modelo entender a ordem das palavras, mesmo processando todas em paralelo, uma capacidade crucial para entender uma linguagem onde a ordem das palavras importa.

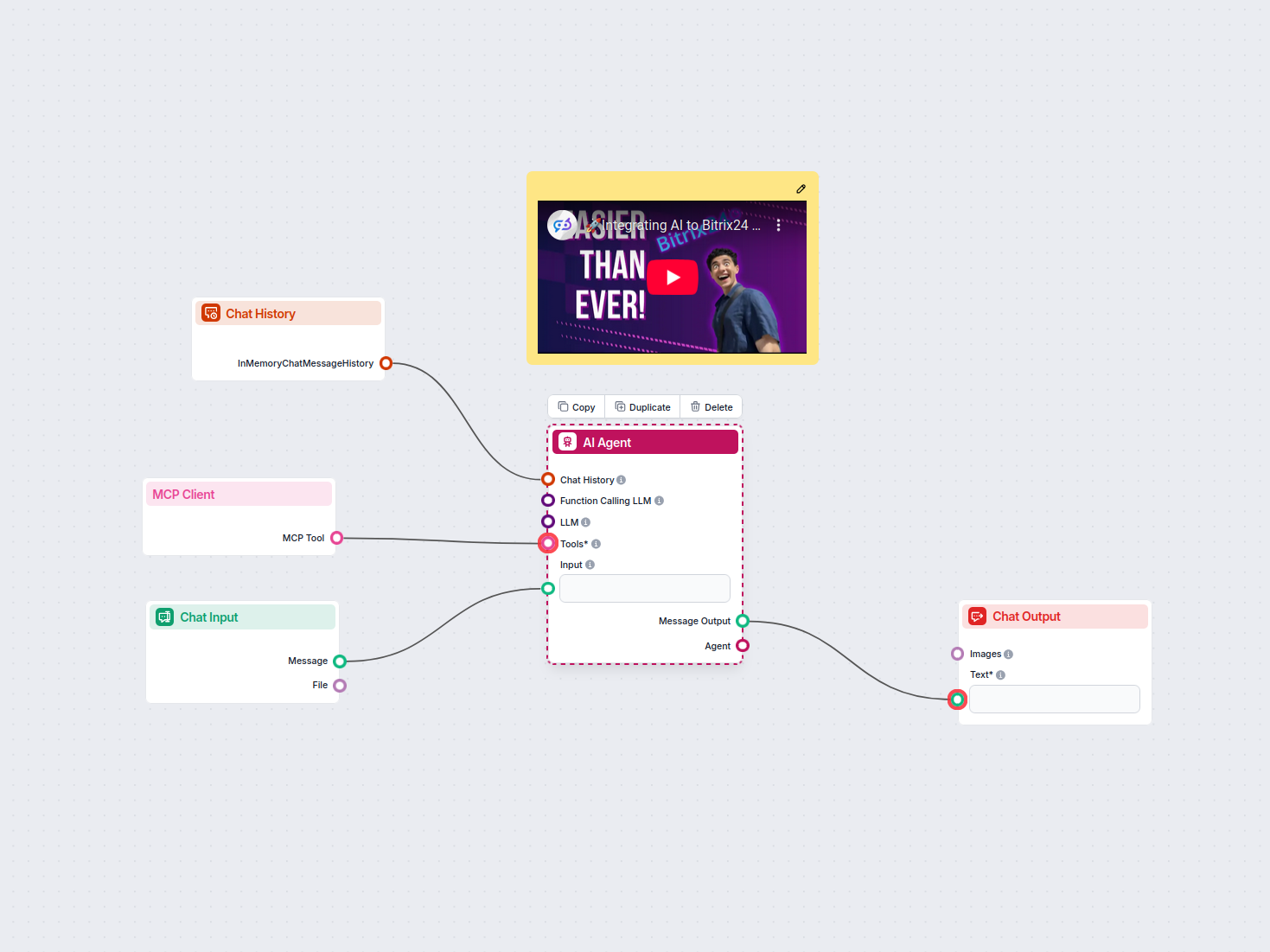

O FlowHunt representa uma abordagem moderna para desenvolvimento de chatbots que abstrai grande parte da complexidade técnica, mantendo o acesso a poderosas capacidades de IA. Em vez de exigir que equipes construam infraestrutura do zero, o FlowHunt oferece um construtor visual onde usuários não técnicos podem desenhar fluxos conversacionais conectando componentes que representam diferentes funções do chatbot. A plataforma gerencia o PLN, reconhecimento de intenção e geração de respostas, permitindo que as equipes foquem no design da experiência conversacional e na integração com sistemas do negócio.

O recurso Fontes de Conhecimento do FlowHunt permite que chatbots acessem informações em tempo real de documentos, sites e bancos de dados, implementando princípios de RAG para garantir precisão. A funcionalidade de Agentes de IA possibilita construir sistemas autônomos capazes de executar ações além da conversa — atualizar bancos de dados, enviar e-mails, agendar compromissos ou disparar fluxos de trabalho. Isso representa uma evolução significativa em relação a chatbots tradicionais, que apenas fornecem informações; sistemas baseados no FlowHunt podem de fato realizar tarefas em nome dos usuários. As capacidades de integração da plataforma conectam chatbots a sistemas de CRM, help desk e aplicativos do negócio, permitindo fluxo de dados e execução de ações sem interrupções.

Uma implantação eficaz de chatbot requer o monitoramento de métricas-chave que indicam se o sistema está cumprindo os objetivos de negócio. Precisão de reconhecimento de intenção mede a porcentagem de mensagens do usuário corretamente classificadas na categoria pretendida. Precisão de extração de entidades mede se o sistema identifica corretamente os dados relevantes. Índices de satisfação do usuário, obtidos por pesquisas após a conversa, indicam se os usuários acharam a interação útil. Taxa de conclusão de conversa mede a porcentagem de conversas em que o problema do usuário é resolvido sem necessidade de encaminhamento a um agente humano.

A latência de resposta mede a rapidez com que o chatbot gera respostas — fator crítico para a experiência do usuário, pois atrasos acima de alguns segundos reduzem significativamente a satisfação. Taxa de escalonamento indica a porcentagem de conversas que precisam ser transferidas para agentes humanos, com taxas mais baixas geralmente indicando melhor desempenho do chatbot. Custo por conversa avalia a eficiência econômica do chatbot, comparando o custo do processamento de IA com o custo de atendimento humano. As organizações devem estabelecer métricas de referência antes da implantação, monitorando-as continuamente para identificar oportunidades de melhoria e garantir que o chatbot continue agregando valor à medida que o uso evolui.

Chatbots frequentemente lidam com informações sensíveis, incluindo dados pessoais, financeiros e detalhes confidenciais do negócio. Criptografia de dados garante que informações transmitidas entre usuários e sistemas de chatbot estejam protegidas contra interceptação. Mecanismos de autenticação verificam se os usuários são quem dizem ser antes de permitir acesso a informações sensíveis. Controles de acesso asseguram que chatbots acessem apenas os dados necessários para cumprir sua função, seguindo o princípio do menor privilégio. As organizações devem implementar logs de auditoria para manter registros de todas as interações com o chatbot para conformidade e segurança.

Princípios de privacidade desde a concepção devem guiar o desenvolvimento do chatbot, garantindo que a coleta de dados pessoais seja minimizada, a retenção seja limitada ao necessário e que os usuários tenham visibilidade sobre quais dados estão sendo coletados e como são usados. Conformidade com regulamentações como GDPR, CCPA e requisitos específicos de setores como HIPAA ou PCI-DSS é essencial. As organizações devem realizar avaliações de segurança de seus sistemas de chatbot para identificar vulnerabilidades e implementar as devidas correções. A responsabilidade pela segurança vai além da plataforma do chatbot, incluindo as bases de conhecimento, integrações e sistemas de backend acessados pelo chatbot.

A evolução da tecnologia de chatbots segue acelerando. Chatbots multimodais que processam e geram texto, voz, imagens e vídeo simultaneamente representam a próxima fronteira. Em vez de interações apenas por texto, os usuários interagirão cada vez mais com chatbots pelo canal de sua preferência — voz para cenários sem uso das mãos, imagens para dúvidas visuais de produto, vídeo para demonstrações complexas. A inteligência emocional nos chatbots avançará além da simples detecção de sentimento para o entendimento nuançado do estado emocional do usuário e respostas emocionais adequadas. Chatbots reconhecerão quando os usuários estão frustrados, confusos ou satisfeitos e ajustarão seu estilo de comunicação conforme necessário.

A assistência proativa é outra capacidade emergente, na qual chatbots antecipam necessidades do usuário antes de pedidos explícitos. Em vez de esperar que clientes façam perguntas, chatbots identificarão padrões que indicam potenciais problemas e oferecerão assistência proativamente. A personalização será cada vez mais sofisticada, com chatbots adaptando estilo de comunicação, recomendações e assistência com base nas preferências, histórico e contexto do usuário. A integração com sistemas autônomos permitirá que chatbots coordenem com automação robótica de processos, dispositivos IoT e outros sistemas automatizados para realizar tarefas complexas que abrangem múltiplos sistemas e exigem orquestração.

Entender como chatbots de IA funcionam revela por que eles se tornaram ferramentas essenciais para negócios em todos os setores. A sofisticada interação entre processamento de linguagem natural, aprendizado de máquina, gerenciamento de diálogo e integração de conhecimento permite que chatbots lidem com tarefas cada vez mais complexas, mantendo interações naturais e humanizadas. Organizações que implementam chatbots de forma eficaz — usando plataformas como o FlowHunt, que abstraem a complexidade técnica mantendo poderosas capacidades — conquistam vantagens competitivas significativas por meio de maior satisfação do cliente, redução de custos operacionais e respostas mais ágeis.

A tecnologia segue evoluindo rapidamente, com avanços em grandes modelos de linguagem, capacidades multimodais e agentes autônomos expandindo o que é possível. As organizações devem enxergar a implementação de chatbots não como um projeto pontual, mas como uma capacidade contínua que melhora ao longo do tempo com aprendizado, otimização e aprimoramento constantes. As implementações mais bem-sucedidas combinam tecnologia de IA avançada com design cuidadoso de conversação, controles adequados para garantir precisão e segurança, e integração com sistemas de negócio que permitem ao chatbot agir de forma significativa. À medida que avançamos por 2025 e além, os chatbots se tornarão cada vez mais a interface primária entre clientes, colaboradores e organizações, tornando o investimento nessa tecnologia estrategicamente fundamental para o sucesso empresarial.

Pare de gerenciar manualmente perguntas repetitivas de clientes. O construtor de chatbots de IA sem código do FlowHunt permite criar chatbots inteligentes e autônomos que atendem clientes, geram leads e oferecem suporte 24/7. Implemente em minutos, não em semanas.

Aprenda a construir um chatbot de IA do zero com nosso guia abrangente. Descubra as melhores ferramentas, frameworks e o passo a passo para criar sistemas intel...

Aprenda a construir um chatbot de IA para Discord com instruções passo a passo, métodos de integração de API, tratamento de erros, melhores práticas de seguranç...

Este fluxo de trabalho utiliza um Agente de IA integrado à Ferramenta Cliente MCP para processar entradas de chat dos usuários, utilizar o histórico de conversa...

Consentimento de Cookies

Usamos cookies para melhorar sua experiência de navegação e analisar nosso tráfego. See our privacy policy.