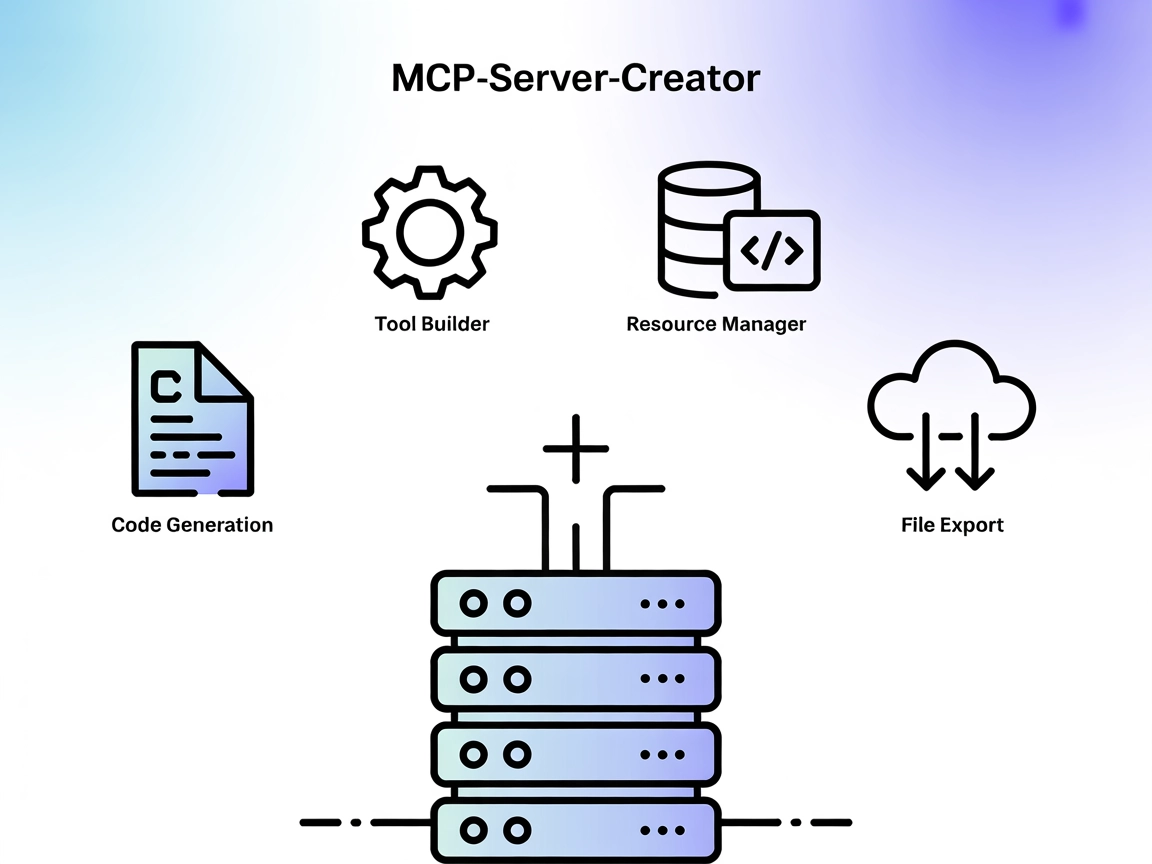

Servidor MCP-Server-Creator MCP

O MCP-Server-Creator é um meta-servidor que possibilita a rápida criação e configuração de novos servidores Model Context Protocol (MCP). Com geração de código ...

Automação de IA

Execute código Python, instale dependências e gerencie ambientes isolados diretamente em seus fluxos FlowHunt com o MCP Code Executor MCP Server.

O FlowHunt fornece uma camada de segurança adicional entre seus sistemas internos e ferramentas de IA, dando-lhe controle granular sobre quais ferramentas são acessíveis a partir de seus servidores MCP. Os servidores MCP hospedados em nossa infraestrutura podem ser perfeitamente integrados com o chatbot do FlowHunt, bem como com plataformas de IA populares como ChatGPT, Claude e vários editores de IA.

O MCP Code Executor é um servidor MCP (Model Context Protocol) que permite que modelos de linguagem (LLMs) executem código Python em um ambiente Python designado, como Conda, virtualenv ou UV virtualenv. Ao conectar assistentes de IA a ambientes Python reais e executáveis, capacita-os a realizar uma ampla gama de tarefas de desenvolvimento que exigem execução de código, gerenciamento de bibliotecas e configuração dinâmica de ambientes. Este servidor suporta geração incremental de código para superar limitações de tokens, permite instalação de dependências sob demanda e facilita a configuração do ambiente de execução em tempo de execução. Desenvolvedores podem aproveitar esta ferramenta para automatizar avaliação de código, experimentar novos pacotes e gerenciar computação em um ambiente controlado e seguro.

Não há templates de prompt explícitos listados no repositório ou documentação.

Não há recursos específicos descritos no repositório ou documentação.

{

"mcpServers": {

"mcp-code-executor": {

"command": "node",

"args": [

"/path/to/mcp_code_executor/build/index.js"

],

"env": {

"CODE_STORAGE_DIR": "/path/to/code/storage",

"ENV_TYPE": "conda",

"CONDA_ENV_NAME": "your-conda-env"

}

}

}

}

{

"mcpServers": {

"mcp-code-executor": {

"env": {

"CODE_STORAGE_DIR": "/path/to/code/storage",

"ENV_TYPE": "conda",

"CONDA_ENV_NAME": "your-conda-env",

"MY_SECRET_API_KEY": "${MY_SECRET_API_KEY}"

},

"inputs": {

"apiKey": "${MY_SECRET_API_KEY}"

}

}

}

}

{

"mcpServers": {

"mcp-code-executor": {

"command": "node",

"args": [

"/path/to/mcp_code_executor/build/index.js"

],

"env": {

"CODE_STORAGE_DIR": "/path/to/code/storage",

"ENV_TYPE": "conda",

"CONDA_ENV_NAME": "your-conda-env"

}

}

}

}

{

"mcpServers": {

"mcp-code-executor": {

"command": "node",

"args": [

"/path/to/mcp_code_executor/build/index.js"

],

"env": {

"CODE_STORAGE_DIR": "/path/to/code/storage",

"ENV_TYPE": "conda",

"CONDA_ENV_NAME": "your-conda-env"

}

}

}

}

{

"mcpServers": {

"mcp-code-executor": {

"command": "node",

"args": [

"/path/to/mcp_code_executor/build/index.js"

],

"env": {

"CODE_STORAGE_DIR": "/path/to/code/storage",

"ENV_TYPE": "conda",

"CONDA_ENV_NAME": "your-conda-env"

}

}

}

}

Nota: Você também pode usar Docker. O Dockerfile fornecido é testado para o tipo de ambiente

venv-uv:

{

"mcpServers": {

"mcp-code-executor": {

"command": "docker",

"args": [

"run",

"-i",

"--rm",

"mcp-code-executor"

]

}

}

}

Usando MCP no FlowHunt

Para integrar servidores MCP ao seu workflow no FlowHunt, comece adicionando o componente MCP ao seu fluxo e conectando-o ao seu agente de IA:

Clique no componente MCP para abrir o painel de configuração. Na seção de configuração do sistema MCP, insira os detalhes do seu servidor MCP usando este formato JSON:

{

"mcp-code-executor": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

Uma vez configurado, o agente de IA poderá utilizar este MCP como ferramenta, com acesso a todas as suas funções e capacidades. Lembre-se de alterar “mcp-code-executor” para o nome real do seu servidor MCP e substituir a URL pela URL do seu próprio servidor MCP.

| Seção | Disponibilidade | Detalhes/Observações |

|---|---|---|

| Visão geral | ✅ | |

| Lista de Prompts | ⛔ | Nenhum template de prompt encontrado |

| Lista de Recursos | ⛔ | Nenhum recurso explícito descrito |

| Lista de Ferramentas | ✅ | execute_code, install_dependencies, check_installed_packages |

| Proteção de Chaves de API | ✅ | Exemplo fornecido com env inputs |

| Suporte a Sampling (menos relevante na avaliação) | ⛔ | Não especificado |

Este servidor MCP oferece funcionalidades essenciais e robustas para execução de código com integração LLM, além de instruções de configuração claras e ferramentas. No entanto, faltam templates de prompt, recursos explícitos e informações sobre roots ou suporte a sampling. Para um MCP focado em execução de código, é muito sólido, pontuando alto em utilidade prática e facilidade de integração, mas perde alguns pontos pela ausência de recursos MCP avançados e completude de documentação.

| Possui uma LICENSE | ✅ (MIT) |

|---|---|

| Possui pelo menos uma ferramenta | ✅ |

| Número de Forks | 25 |

| Número de Stars | 144 |

É um servidor Model Context Protocol (MCP) que permite que modelos de linguagem executem código Python em ambientes seguros e isolados (como Conda ou venv), gerenciem dependências e configurem ambientes de execução. Ideal para avaliação de código, ciência de dados, workflows automatizados e configuração dinâmica de ambientes com FlowHunt.

Ele fornece ferramentas para executar código Python (`execute_code`), instalar dependências sob demanda (`install_dependencies`) e verificar pacotes instalados (`check_installed_packages`).

Adicione o MCP Code Executor como um componente MCP no seu fluxo e, em seguida, configure-o com a URL do seu servidor e o método de transporte. Isso permite que seus agentes de IA usem as capacidades de execução de código e gerenciamento de ambiente dentro do FlowHunt.

Sim, o servidor suporta execução de código em ambientes isolados Conda ou virtualenv, garantindo reprodutibilidade e evitando conflitos entre dependências.

Sim, o servidor pode executar código de forma incremental, o que é útil para lidar com códigos que excedem os limites de tokens do LLM.

Sim, você pode usar o Dockerfile fornecido e configurar o servidor MCP para rodar dentro de um container Docker para isolamento adicional.

Potencialize seus fluxos com execução de código Python segura e automatizada. Integre o MCP Code Executor MCP Server e desbloqueie workflows dinâmicos para ciência de dados, automação e muito mais.

O MCP-Server-Creator é um meta-servidor que possibilita a rápida criação e configuração de novos servidores Model Context Protocol (MCP). Com geração de código ...

O Servidor Coda MCP fornece uma forma padronizada para assistentes de IA interagirem com a plataforma da Coda, possibilitando consultas a documentos, automação ...

O CodeLogic MCP Server conecta o FlowHunt e assistentes de programação com IA aos dados detalhados de dependências de software da CodeLogic, possibilitando anál...

Consentimento de Cookies

Usamos cookies para melhorar sua experiência de navegação e analisar nosso tráfego. See our privacy policy.