Ghid de dezvoltare pentru servere MCP

Învață cum să construiești și să implementezi un server Model Context Protocol (MCP) pentru a conecta modele AI cu instrumente externe și surse de date. Ghid pa...

Învață cum să dezvolți un server Model Context Protocol (MCP) care se integrează perfect cu API-ul OpenAI, permițând execuția de instrumente AI puternice și automatizare inteligentă.

Model Context Protocol (MCP) reprezintă o schimbare de paradigmă în modul în care sistemele de inteligență artificială interacționează cu instrumente și surse de date externe. Atunci când este combinat cu modelele lingvistice puternice de la OpenAI, un server MCP devine o poartă către automatizare inteligentă, permițând sistemelor AI să execute operațiuni complexe, să recupereze date în timp real și să se integreze perfect cu infrastructura ta existentă. Acest ghid cuprinzător te conduce prin întregul proces de dezvoltare a unui server MCP care se conectează la OpenAI, de la concepte de bază la implementare gata de producție.

Indiferent dacă construiești o platformă de automatizare pentru servicii clienți, un sistem inteligent de procesare a datelor sau un instrument sofisticat de business intelligence, înțelegerea modului de a arhitectura și implementa un server MCP este esențială pentru dezvoltarea AI modernă. Integrarea dintre serverele MCP și OpenAI creează un ecosistem puternic în care modelele AI pot raționa asupra problemelor, decide ce instrumente să folosească și să le execute cu precizie—totul menținând securitatea, fiabilitatea și scalabilitatea.

Model Context Protocol este un standard deschis care definește modul în care modelele AI pot descoperi și interacționa cu instrumente, servicii și surse de date externe. În loc să integreze toată funcționalitatea direct într-un model AI, MCP permite dezvoltatorilor să creeze servere specializate care expun capabilități printr-o interfață standardizată. Această separare a responsabilităților permite o modularitate, securitate și scalabilitate mai bune în aplicațiile AI.

În esență, MCP funcționează pe un principiu simplu: modelul AI (în acest caz, GPT de la OpenAI) acționează ca un orchestrator inteligent care poate înțelege ce instrumente sunt disponibile, decide când să le folosească și interpretează rezultatele acestora. Serverul MCP acționează ca furnizor al acestor instrumente, expunându-le printr-un API bine definit pe care modelul AI îl poate descoperi și invoca. Acest lucru creează un contract clar între sistemul AI și logica ta de business personalizată.

Frumusețea MCP constă în flexibilitatea sa. Serverul tău poate expune instrumente pentru orice—interogări de baze de date, apeluri API către servicii terțe, procesare de fișiere, calcule sau chiar declanșarea de fluxuri de lucru complexe. Modelul AI învață despre aceste capabilități și le folosește inteligent în cadrul conversațiilor, luând decizii despre ce instrumente să invoce în funcție de cererea utilizatorului și de contextul discuției.

Integrarea serverelor MCP cu OpenAI rezolvă o limitare fundamentală a marilor modele lingvistice: acestea au o dată de tăiere a cunoștințelor și nu pot interacționa direct cu sisteme în timp real sau date proprietare. Prin implementarea unui server MCP, extinzi capabilitățile modelelor OpenAI mult dincolo de antrenamentul lor de bază, permițându-le accesul la informații actuale, execuția logicii de business și integrarea cu sistemele tale existente.

Iată câteva scenarii practice în care serverele MCP devin de neprețuit:

Arhitectura oferă avantaje semnificative și pentru echipele de dezvoltare. Mai multe echipe pot dezvolta și menține independent propriile servere MCP, care sunt apoi combinate pentru a crea aplicații AI sofisticate. Această abordare modulară se scalează bine pe măsură ce organizația ta crește și capabilitățile AI devin mai complexe.

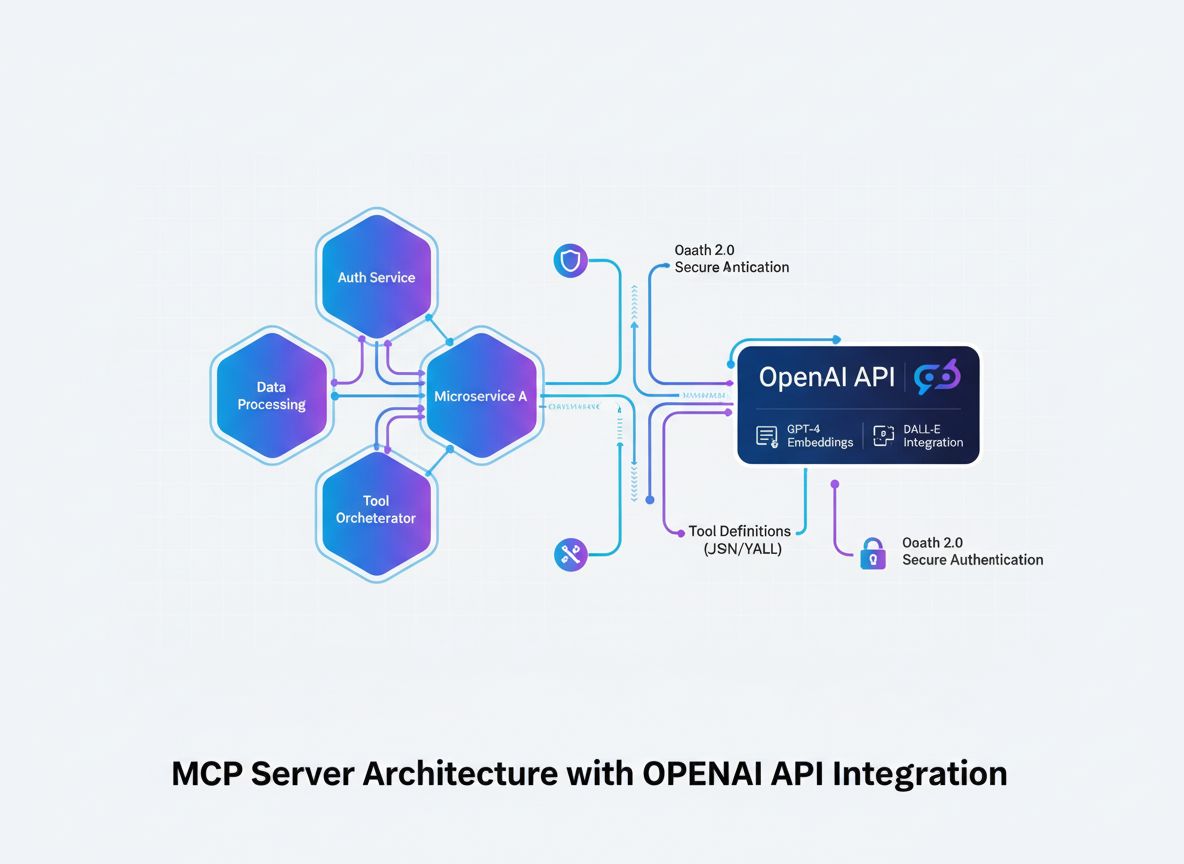

Înainte de a intra în detalii de implementare, este esențial să înțelegi fluxul arhitectural al integrării unui server MCP cu OpenAI. Procesul implică mai multe componente cheie care lucrează împreună:

Modelul AI (OpenAI) inițiază conversații și ia decizii despre ce instrumente să invoce. Când modelul determină că este necesar un apel de instrument, generează o cerere structurată care conține numele instrumentului și parametrii.

Clientul MCP acționează ca translator și intermediar. Primește cereri de invocare a instrumentelor de la OpenAI, le traduce în formatul așteptat de serverul tău MCP, trimite cererea către serverul potrivit și returnează rezultatele înapoi la OpenAI în formatul așteptat de model.

Serverul MCP este aplicația ta personalizată care expune instrumente și capabilități. Primește cereri de la clientul MCP, execută operațiunile solicitate (care pot implica interogări de baze de date, apeluri API sau calcule complexe) și returnează rezultate structurate.

Definițiile instrumentelor sunt contractele care definesc ce instrumente sunt disponibile, ce parametri acceptă și ce returnează. Aceste definiții sunt descoperite de clientul MCP și înregistrate la OpenAI astfel încât modelul să știe ce e disponibil.

Această arhitectură creează o separare clară a responsabilităților: OpenAI se ocupă de raționament și luarea deciziilor, serverul tău MCP de logica specifică domeniului și acces la date, iar clientul MCP de protocolul de comunicare dintre ele.

Baza oricărui server MCP de succes este o definiție clară a instrumentelor pe care vrei să le expui. Aceasta nu este doar o exercițiu tehnic—este o decizie strategică despre ce capabilități are nevoie sistemul tău AI pentru a-și atinge obiectivele.

Începe prin a identifica problemele specifice pe care sistemul tău AI trebuie să le rezolve. Construiești un chatbot pentru servicii clienți care trebuie să caute informații despre comenzi? Un asistent de analiză de date care trebuie să interogheze baze de date? Un instrument de creație de conținut care accesează baza de cunoștințe a companiei? Fiecare caz de utilizare va avea cerințe diferite pentru instrumente.

Pentru fiecare instrument, definește:

get_customer_order_history, search_knowledge_base, execute_sql_query)Exemplu de specificații bine definite pentru instrumente:

| Nume Instrument | Scop | Parametri de Intrare | Format Ieșire | Caz de utilizare |

|---|---|---|---|---|

get_customer_info | Recuperează detalii despre client | customer_id (string) | Obiect JSON cu nume, email, account_status | Interogări servicii clienți |

search_orders | Găsește comenzi după criterii | customer_id, date_range, status | Array de obiecte comandă | Căutare și istoric comenzi |

create_support_ticket | Deschide un tichet de suport | customer_id, issue_description, priority | Obiect tichet cu ID și confirmare | Escaladare incidente |

check_inventory | Verifică disponibilitatea produselor | product_id, warehouse_location | Stoc și detalii locație | Interogări stocuri |

process_refund | Inițiază rambursare | order_id, amount, reason | Confirmare tranzacție cu număr de referință | Procesare rambursări |

Această abordare tabelară te ajută să gândești ecosistemul complet de instrumente înainte de a scrie cod. Asigură consistență, claritate și completitudine în definițiile instrumentelor.

Crearea unui server MCP necesită o bază de dezvoltare solidă. Deși serverele MCP pot fi construite în mai multe limbaje, ne vom concentra pe cele mai populare: TypeScript/Node.js și Python, deoarece acestea au cele mai mature biblioteci MCP și suport comunitar.

Pentru dezvoltare TypeScript/Node.js:

Începe prin a crea un nou proiect Node.js și instalează dependențele necesare:

mkdir mcp-server-openai

cd mcp-server-openai

npm init -y

npm install @modelcontextprotocol/sdk openai dotenv express cors

npm install --save-dev typescript @types/node ts-node

Creează un fișier tsconfig.json pentru a configura TypeScript:

{

"compilerOptions": {

"target": "ES2020",

"module": "commonjs",

"lib": ["ES2020"],

"outDir": "./dist",

"rootDir": "./src",

"strict": true,

"esModuleInterop": true,

"skipLibCheck": true,

"forceConsistentCasingInFileNames": true

}

}

Pentru dezvoltare Python:

Creează un mediu virtual și instalează dependențele:

python -m venv venv

source venv/bin/activate # Pe Windows: venv\Scripts\activate

pip install mcp openai python-dotenv fastapi uvicorn

Indiferent de limbajul ales, vei avea nevoie de:

.env pentru a stoca în siguranță credențialele sensibileNucleul serverului tău MCP este aplicația care expune instrumentele prin protocolul MCP. Aceasta implică crearea de endpointuri pentru descoperirea și execuția instrumentelor.

Implementare TypeScript/Node.js:

Creează structura de bază pentru serverul MCP:

import { Server } from "@modelcontextprotocol/sdk/server/index.js";

import { StdioServerTransport } from "@modelcontextprotocol/sdk/server/stdio.js";

import {

CallToolRequestSchema,

ListToolsRequestSchema,

} from "@modelcontextprotocol/sdk/types.js";

const server = new Server({

name: "openai-mcp-server",

version: "1.0.0",

});

// Definește instrumentele tale

const tools = [

{

name: "get_customer_info",

description: "Recuperează informații despre client după ID",

inputSchema: {

type: "object",

properties: {

customer_id: {

type: "string",

description: "Identificatorul unic al clientului",

},

},

required: ["customer_id"],

},

},

// Adaugă mai multe instrumente aici

];

// Gestionează cererile de listare a instrumentelor

server.setRequestHandler(ListToolsRequestSchema, async () => {

return { tools };

});

// Gestionează cererile de execuție a instrumentelor

server.setRequestHandler(CallToolRequestSchema, async (request) => {

const { name, arguments: args } = request.params;

if (name === "get_customer_info") {

// Implementează logica instrumentului aici

const customerId = args.customer_id;

// Interoghează baza de date sau API-ul tău

return {

content: [

{

type: "text",

text: JSON.stringify({

id: customerId,

name: "John Doe",

email: "john@example.com",

}),

},

],

};

}

return {

content: [{ type: "text", text: `Instrument necunoscut: ${name}` }],

isError: true,

};

});

// Pornește serverul

const transport = new StdioServerTransport();

server.connect(transport);

Implementare Python:

from mcp.server import Server

from mcp.types import Tool, TextContent, ToolResult

import json

app = Server("openai-mcp-server")

# Definește instrumentele

TOOLS = [

Tool(

name="get_customer_info",

description="Recuperează informații despre client după ID",

inputSchema={

"type": "object",

"properties": {

"customer_id": {

"type": "string",

"description": "Identificatorul unic al clientului"

}

},

"required": ["customer_id"]

}

)

]

@app.list_tools()

async def list_tools():

return TOOLS

@app.call_tool()

async def call_tool(name: str, arguments: dict):

if name == "get_customer_info":

customer_id = arguments.get("customer_id")

# Implementează logica instrumentului

result = {

"id": customer_id,

"name": "John Doe",

"email": "john@example.com"

}

return ToolResult(

content=[TextContent(type="text", text=json.dumps(result))]

)

return ToolResult(

content=[TextContent(type="text", text=f"Instrument necunoscut: {name}")],

isError=True

)

if __name__ == "__main__":

import uvicorn

uvicorn.run(app, host="0.0.0.0", port=8000)

Puterea reală a serverului tău MCP vine din implementarea efectivă a instrumentelor. Aici te conectezi la baze de date, apelezi API-uri externe, procesezi date și execuți logica de business.

Exemplu de integrare cu baza de date:

import { Pool } from "pg"; // Exemplu PostgreSQL

const pool = new Pool({

connectionString: process.env.DATABASE_URL,

});

async function getCustomerInfo(customerId: string) {

try {

const result = await pool.query(

"SELECT id, name, email, account_status FROM customers WHERE id = $1",

[customerId]

);

if (result.rows.length === 0) {

return {

error: "Clientul nu a fost găsit",

status: 404,

};

}

return result.rows[0];

} catch (error) {

return {

error: "Interogarea bazei de date a eșuat",

details: error.message,

status: 500,

};

}

}

Exemplu de integrare cu API-uri externe:

import axios from "axios";

async function searchExternalDatabase(query: string) {

try {

const response = await axios.get(

"https://api.external-service.com/search",

{

params: { q: query },

headers: {

Authorization: `Bearer ${process.env.EXTERNAL_API_KEY}`,

},

}

);

return response.data;

} catch (error) {

return {

error: "Apelul către API-ul extern a eșuat",

details: error.message,

};

}

}

Gestionarea erorilor și validarea:

Gestionarea robustă a erorilor este esențială pentru serverele MCP de producție. Implementează validare și tratare completă a erorilor:

function validateInput(args: any, schema: any): { valid: boolean; error?: string } {

// Validare câmpuri obligatorii

for (const required of schema.required || []) {

if (!(required in args)) {

return { valid: false, error: `Parametru obligatoriu lipsă: ${required}` };

}

}

// Validare tipuri de câmpuri

for (const [key, property] of Object.entries(schema.properties || {})) {

if (key in args) {

const value = args[key];

const expectedType = (property as any).type;

if (typeof value !== expectedType) {

return {

valid: false,

error: `Parametrul ${key} trebuie să fie de tip ${expectedType}`,

};

}

}

}

return { valid: true };

}

Clientul MCP este puntea dintre OpenAI și serverul tău MCP. El se ocupă de traducerea între formatul de apelare a funcțiilor OpenAI și protocolul serverului MCP.

Client MCP TypeScript/Node.js:

import { Client } from "@modelcontextprotocol/sdk/client/index.js";

import { StdioClientTransport } from "@modelcontextprotocol/sdk/client/stdio.js";

import OpenAI from "openai";

class MCPOpenAIBridge {

private mcpClient: Client;

private openaiClient: OpenAI;

private availableTools: any[] = [];

constructor() {

this.openaiClient = new OpenAI({

apiKey: process.env.OPENAI_API_KEY,

});

}

async initialize() {

// Conectare la serverul MCP

const transport = new StdioClientTransport({

command: "node",

args: ["dist/server.js"],

});

this.mcpClient = new Client({

name: "openai-mcp-client",

version: "1.0.0",

});

await this.mcpClient.connect(transport);

// Descoperă instrumentele disponibile

const toolsResponse = await this.mcpClient.listTools();

this.availableTools = toolsResponse.tools;

}

async executeWithOpenAI(userMessage: string) {

const messages = [{ role: "user" as const, content: userMessage }];

// Conversie instrumente MCP în format de funcție OpenAI

const tools = this.availableTools.map((tool) => ({

type: "function" as const,

function: {

name: tool.name,

description: tool.description,

parameters: tool.inputSchema,

},

}));

let response = await this.openaiClient.chat.completions.create({

model: "gpt-4",

messages,

tools,

});

// Gestionare apeluri de instrumente într-o buclă

while (response.choices[0].finish_reason === "tool_calls") {

const toolCalls = response.choices[0].message.tool_calls || [];

for (const toolCall of toolCalls) {

const toolName = toolCall.function.name;

const toolArgs = JSON.parse(toolCall.function.arguments);

// Execută instrumentul pe serverul MCP

const toolResult = await this.mcpClient.callTool({

name: toolName,

arguments: toolArgs,

});

// Adaugă rezultatul instrumentului la mesaje

messages.push({

role: "assistant",

content: response.choices[0].message.content || "",

});

messages.push({

role: "tool",

content: JSON.stringify(toolResult),

tool_call_id: toolCall.id,

});

}

// Obține următorul răspuns de la OpenAI

response = await this.openaiClient.chat.completions.create({

model: "gpt-4",

messages,

tools,

});

}

return response.choices[0].message.content;

}

}

// Utilizare

const bridge = new MCPOpenAIBridge();

await bridge.initialize();

const result = await bridge.executeWithOpenAI(

"Care este istoricul comenzilor pentru clientul 12345?"

);

console.log(result);

Securitatea este esențială când construiești servere MCP care interacționează cu date sensibile și API-uri externe. Implementează mai multe niveluri de securitate:

Gestionarea cheilor API:

import crypto from "crypto";

class APIKeyManager {

private validKeys: Set<string> = new Set();

constructor() {

// Încarcă cheile API valide din mediu sau stocare securizată

const keys = process.env.VALID_API_KEYS?.split(",") || [];

this.validKeys = new Set(keys);

}

validateRequest(apiKey: string): boolean {

return this.validKeys.has(apiKey);

}

generateNewKey(): string {

return crypto.randomBytes(32).toString("hex");

}

}

Semnarea și verificarea cererilor:

import crypto from "crypto";

function signRequest(payload: any, secret: string): string {

return crypto

.createHmac("sha256", secret)

.update(JSON.stringify(payload))

.digest("hex");

}

function verifySignature(payload: any, signature: string, secret: string): boolean {

const expectedSignature = signRequest(payload, secret);

return crypto.timingSafeEqual(

Buffer.from(signature),

Buffer.from(expectedSignature)

);

}

Limitarea ratei:

import rateLimit from "express-rate-limit";

const limiter = rateLimit({

windowMs: 15 * 60 * 1000, // 15 minute

max: 100, // max 100 cereri per IP per fereastră

message: "Prea multe cereri de la acest IP, te rugăm să încerci mai târziu.",

});

app.use("/api/", limiter);

Sanitizarea inputului:

function sanitizeInput(input: string): string {

// Elimină caracterele potențial periculoase

return input

.replace(/[<>]/g, "")

.trim()

.substring(0, 1000); // Limitează lungimea

}

function validateCustomerId(customerId: string): boolean {

// Permite doar alfanumeric și cratimă

return /^[a-zA-Z0-9-]+$/.test(customerId);

}

Testarea cuprinzătoare asigură că serverul tău MCP funcționează corect și gestionează cazurile limită cu grație.

Exemplu de teste unitare (Jest):

import { getCustomerInfo } from "../tools/customer";

describe("Instrumente client", () => {

test("ar trebui să returneze info client pentru ID valid", async () => {

const result = await getCustomerInfo("cust_123");

expect(result).toHaveProperty("id");

expect(result).toHaveProperty("name");

expect(result).toHaveProperty("email");

});

test("ar trebui să returneze eroare pentru ID invalid", async () => {

const result = await getCustomerInfo("invalid");

expect(result).toHaveProperty("error");

});

test("ar trebui să gestioneze elegant erorile de bază de date", async () => {

// Mock eroare db

const result = await getCustomerInfo("cust_error");

expect(result).toHaveProperty("error");

expect(result.status).toBe(500);

});

});

Teste de integrare:

describe("Integrare server MCP", () => {

let server: Server;

beforeAll(async () => {

server = new Server({ name: "test-server", version: "1.0.0" });

// Inițializează serverul

});

test("ar trebui să listeze toate instrumentele disponibile", async () => {

const tools = await server.listTools();

expect(tools.length).toBeGreaterThan(0);

expect(tools[0]).toHaveProperty("name");

expect(tools[0]).toHaveProperty("description");

});

test("ar trebui să execute instrumentul și să returneze rezultat", async () => {

const result = await server.callTool({

name: "get_customer_info",

arguments: { customer_id: "cust_123" },

});

expect(result).toBeDefined();

});

});

FlowHunt oferă o platformă completă pentru automatizarea întregului ciclu de viață al dezvoltării, testării și implementării serverului MCP. În loc să gestionezi manual fiecare pas al fluxului serverului MCP, FlowHunt îți permite să creezi fluxuri de automatizare inteligentă care gestionează sarcinile repetitive și asigură consistență în procesul de dezvoltare.

Testare și validare automată:

FlowHunt poate orchestra pipeline-ul tău de testare, rulând automat teste unitare, de integrare și end-to-end ori de câte ori faci commit de cod. Astfel, te asiguri că instrumentele serverului MCP funcționează corect înainte de a fi implementate în producție.

Integrare și implementare continuă:

Configurează fluxuri FlowHunt pentru a construi, testa și implementa automat serverul MCP când apar modificări în repository. Elimini pașii manuali și reduci riscul de erori umane.

Monitorizare și alertare:

FlowHunt poate monitoriza sănătatea serverului MCP, urmări timpii de răspuns ai API-ului și te poate alerta la orice problemă. Dacă un instrument începe să eșueze sau performanța scade, vei primi notificare imediat pentru a lua măsuri.

Generare automată de documentație:

Generează automat documentație API pentru instrumentele serverului MCP, menținând documentația sincronizată cu implementarea reală. Astfel, dezvoltatorii au mereu informații actualizate despre instrumentele disponibile.

Optimizare performanță:

Analizele FlowHunt te ajută să identifici blocajele în execuția instrumentelor. Poți vedea ce instrumente sunt folosite cel mai des, care au cea mai mare latență și unde merită să optimizezi.

Implementarea unui server MCP în producție necesită planificare și execuție atentă. Ia în considerare următoarele strategii:

Containerizare Docker:

Creează un Dockerfile pentru serverul tău MCP:

FROM node:18-alpine

WORKDIR /app

COPY package*.json ./

RUN npm ci --only=production

COPY dist ./dist

EXPOSE 8000

CMD ["node", "dist/server.js"]

Construiește și publică imaginea într-un registry:

docker build -t my-mcp-server:1.0.0 .

docker push myregistry.azurecr.io/my-mcp-server:1.0.0

Implementare Kubernetes:

Implementează serverul MCP containerizat în Kubernetes:

apiVersion: apps/v1

kind: Deployment

metadata:

name: mcp-server

spec:

replicas: 3

selector:

matchLabels:

app: mcp-server

template:

metadata:

labels:

app: mcp-server

spec:

containers:

- name: mcp-server

image: myregistry.azurecr.io/my-mcp-server:1.0.0

ports:

- containerPort: 8000

env:

- name: OPENAI_API_KEY

valueFrom:

secretKeyRef:

name: openai-secrets

key: api-key

- name: DATABASE_URL

valueFrom:

secretKeyRef:

name: db-secrets

key: connection-string

resources:

requests:

memory: "256Mi"

cpu: "250m"

limits:

memory: "512Mi"

cpu: "500m"

Configurare de mediu:

Folosește variabile de mediu pentru toate setările:

# .env.production

OPENAI_API_KEY=sk-...

DATABASE_URL=postgresql://user:pass@host:5432/db

MCP_SERVER_PORT=8000

LOG_LEVEL=info

ENABLE_METRICS=true

Pe măsură ce serverul tău MCP devine mai complex, ia în considerare următoarele pattern-uri avansate:

Compoziție de instrumente:

Creează instrumente de nivel superior care compun instrumente de bază:

async function processCustomerRefund(customerId: string, orderId: string, amount: number) {

// Obține info client

const customer = await getCustomerInfo(customerId);

// Obține detalii comandă

const order = await getOrderDetails(orderId);

// Verifică dacă comanda aparține clientului

if (order.customerId !== customerId) {

throw new Error("Comanda nu aparține clientului");

}

// Procesează rambursarea

const refund = await createRefund(orderId, amount);

// Trimite notificare

await sendNotification(customer.email, `Rambursare de $${amount} procesată`);

return refund;

}

Strategie de cache:

Implementează cache pentru a reduce latența și numărul de apeluri API:

import NodeCache from "node-cache";

const cache = new NodeCache({ stdTTL: 600 }); // TTL 10 minute

async function getCustomerInfoWithCache(customerId: string) {

const cacheKey = `customer_${customerId}`;

// Caută mai întâi în cache

const cached = cache.get(cacheKey);

if (cached) {

return cached;

}

// Ia din baza de date

const customer = await getCustomerInfo(customerId);

// Salvează în cache

cache.set(cacheKey, customer);

return customer;

}

Procesare asincronă a joburilor:

Pentru operațiuni de lungă durată, implementează procesare asincronă:

import Bull from "bull";

const jobQueue = new Bull("mcp-jobs");

jobQueue.process(async (job) => {

const { toolName, arguments: args } = job.data;

// Execută instrumentul

const result = await executeTool(toolName, args);

return result;

});

async function executeToolAsync(toolName: string, args: any) {

const job = await jobQueue.add(

{ toolName, arguments: args },

{ attempts: 3, backoff: { type: "exponential", delay: 200

Model Context Protocol este un cadru standardizat care permite modelelor AI precum GPT de la OpenAI să descopere, să înțeleagă și să execute instrumente și funcții oferite de servere externe. Acționează ca o punte între modelele AI și logica de business personalizată.

Ai nevoie de o cheie API OpenAI validă cu permisiuni adecvate. Serverul MCP în sine nu necesită permisiuni speciale de la OpenAI—comunică prin apeluri API standard. Totuși, ar trebui să implementezi autentificare și autorizare corespunzătoare pe serverul tău MCP.

Serverele MCP pot fi construite în orice limbaj care suportă API-uri HTTP/REST sau conexiuni WebSocket. Alegeri populare includ Python, TypeScript/Node.js, Java, C#/.NET și Go. Alegerea limbajului depinde de infrastructura existentă și de expertiza echipei tale.

Implementează limitarea ratei pe partea serverului MCP, cache-uiește rezultatele solicitate frecvent, folosește backoff exponențial pentru reîncercări și monitorizează utilizarea API-ului OpenAI. Ia în considerare implementarea unui sistem de cozi pentru cererile către instrumente, pentru a gestiona eficient încărcarea.

Arshia este Inginer de Fluxuri AI la FlowHunt. Cu o pregătire în informatică și o pasiune pentru inteligența artificială, el este specializat în crearea de fluxuri eficiente care integrează instrumente AI în sarcinile de zi cu zi, sporind productivitatea și creativitatea.

Simplifică dezvoltarea, testarea și implementarea serverului MCP cu platforma de automatizare inteligentă FlowHunt.

Învață cum să construiești și să implementezi un server Model Context Protocol (MCP) pentru a conecta modele AI cu instrumente externe și surse de date. Ghid pa...

Explorați exemple detaliate de servere MCP și învățați cum să construiți, să implementați și să integrați servere Model Context Protocol pentru a îmbunătăți cap...

Află ce sunt serverele MCP (Model Context Protocol), cum funcționează și de ce revoluționează integrarea AI. Descoperă cum MCP simplifică conectarea agenților A...

Consimțământ Cookie

Folosim cookie-uri pentru a vă îmbunătăți experiența de navigare și a analiza traficul nostru. See our privacy policy.