Introducere

Ingineria contextului a apărut ca una dintre cele mai critice discipline în construirea agenților AI eficienți. Pe măsură ce modelele de limbaj devin mai puternice și agenții abordează sarcini tot mai complexe, cu mai mulți pași, provocarea nu mai constă doar în a avea un model capabil—ci în a gestiona strategic informațiile furnizate acelui model. Fiecare token contează. În acest ghid cuprinzător, vom explora ce este ingineria contextului, de ce este esențială pentru performanța agenților AI și tehnicile specifice folosite de organizațiile de cercetare de top și de platforme pentru a construi agenți optimi. Indiferent dacă realizezi boți de suport clienți, agenți de analiză de date sau fluxuri autonome, înțelegerea ingineriei contextului va îmbunătăți fundamental modul în care performează sistemele tale AI.

Ce este ingineria contextului?

Ingineria contextului reprezintă o schimbare fundamentală în modul în care gândim construcția cu modele mari de limbaj. În loc să privim LLM-ul ca pe o cutie neagră care are nevoie doar de instrucțiuni bune, ingineria contextului tratează modelul ca pe un sistem cu resurse cognitive finite care trebuie gestionate cu grijă. În esență, ingineria contextului este practica de a ști exact ce context să oferi unui agent AI—gândindu-te deliberat la fiecare token care trece prin fiecare apel LLM pentru a crea condițiile optime ca agentul să reușească.

Acest concept a fost popularizat de cercetători precum Andrej Karpathy și a devenit tot mai important pe măsură ce agenții AI au evoluat de la simpli chatboți la sisteme sofisticate, capabile de raționament și acțiune autonomă. Observația de bază este că LLM-urile, asemenea oamenilor, au o memorie de lucru și o capacitate de atenție limitată. La fel cum un om poate procesa doar o anumită cantitate de informație odată înainte de a se confuza sau de a pierde detalii importante, modelele de limbaj își degradează abilitățile de raționament când primesc prea mult context. Asta înseamnă că importanța calității contextului depășește cu mult cantitatea.

Ingineria contextului depășește ingineria prompturilor tradițională, care se concentra în principal pe crearea promptului sau instrucțiunilor ideale de sistem. În schimb, ea include întregul ecosistem de informații disponibil unui agent pe parcursul mai multor interacțiuni—prompturi de sistem, definiții de unelte, exemple, istoric de mesaje, date recuperate și informații încărcate dinamic. Scopul este să menții o fereastră de context suplă, cu semnal ridicat, care îi oferă agentului exact ce are nevoie pentru a lua decizii bune, fără a-l supraîncărca cu informații irelevante.

Pregătit să îți dezvolți afacerea?

Începe perioada de probă gratuită astăzi și vezi rezultate în câteva zile.

De ce contează ingineria contextului pentru construirea agenților AI capabili

Importanța ingineriei contextului nu poate fi supraestimată atunci când construim agenți AI de uz producție. Cercetările au arătat constant că LLM-urile experimentează ceea ce se numește “context rot”—o degradare măsurabilă a performanței pe măsură ce fereastra de context devine mai mare. Studii folosind benchmark-uri „needle-in-a-haystack” au demonstrat că, pe măsură ce numărul de tokeni din context crește, abilitatea modelului de a rechema și raționa corect asupra informației scade. Nu este un efect minor, ci o limitare arhitecturală fundamentală a modului în care funcționează modelele de limbaj bazate pe transformere.

Motivul acestei degradări stă în arhitectura transformer-ului. În transformere, fiecare token poate „fi atent” la oricare alt token din context, creând n² relații pereche pentru n tokeni. Pe măsură ce lungimea contextului crește, mecanismul de atenție al modelului este suprasolicitat, încercând să mențină aceste relații într-un spațiu tot mai mare. În plus, modelele de limbaj sunt antrenate în principal pe secvențe scurte, deci au mai puțină experiență și mai puțini parametri specializați pentru a gestiona dependențe pe distanță foarte lungă. Aceasta creează o tensiune naturală între dimensiunea contextului și capacitatea de raționament—modelele rămân funcționale la contexte lungi, dar arată o precizie redusă pentru regăsirea informației și raționamentul pe distanță lungă comparativ cu performanța pe contexte mai scurte.

Dincolo de limitările arhitecturale, există și o realitate practică: LLM-urile au un „buget de atenție” care se diminuează cu fiecare token nou introdus. Fiecare informație adăugată contextului consumă din acest buget, crescând sarcina cognitivă a modelului. De aceea, ingineria atentă a contextului este esențială. Prin selectarea cu grijă a informațiilor care ajung la model, nu doar optimizezi eficiența—ci îmbunătățești direct calitatea raționamentului și a deciziilor agentului. Un agent cu o fereastră de context suplă, bine organizată, va lua decizii mai bune, va recupera mai eficient din erori și va menține performanță constantă pe interacțiuni mai lungi, spre deosebire de un agent „înecat” în informații irelevante.

Înțelegerea diferenței dintre ingineria contextului și ingineria prompturilor

Deși ingineria contextului și cea a prompturilor sunt concepte înrudite, ele reprezintă niveluri diferite de abstractizare în construcția cu modele de limbaj. Ingineria prompturilor, care a dominat perioada timpurie a aplicațiilor LLM, se axează specific pe cum să scrii prompturi și instrucțiuni de sistem eficiente. Preocuparea principală este formularea cuvintelor și expresiilor potrivite pentru a obține comportamentul dorit de la model pentru o anumită sarcină. Această abordare funcționează bine pentru sarcini discrete, cu un singur pas, precum clasificare, rezumat sau generare de text punctuală.

Ingineria contextului, în schimb, reprezintă evoluția naturală a ingineriei prompturilor pentru era agenților autonomi multi-turn. Dacă ingineria prompturilor întreabă „Cum scriu instrucțiunea perfectă?”, ingineria contextului pune întrebarea mai amplă: „Care este configurația optimă a tuturor informațiilor disponibile pentru a genera comportamentul dorit?” Aceasta include nu doar promptul de sistem, ci și uneltele disponibile agentului, exemplele furnizate, istoricul mesajelor din rundele anterioare, orice date recuperate și metadatele care ajută agentul să își înțeleagă mediul.

Trecerea de la ingineria prompturilor la ingineria contextului reflectă o schimbare fundamentală în modul în care sunt construite aplicațiile AI. În trecut, majoritatea cazurilor de utilizare (în afara chatului cotidian) necesitau prompturi optimizate pentru sarcini one-shot. Astăzi, domeniul se îndreaptă spre agenți mai capabili, care operează pe parcursul mai multor runde de inferență și pe intervale de timp mai lungi. Acești agenți generează tot mai multe date care ar putea fi relevante pentru decizii viitoare, iar această informație trebuie rafinată și selectată ciclic. Ingineria contextului este disciplina gestionării întregului acestui ecosistem de informații aflat în continuă evoluție, asigurând ca la fiecare pas al raționamentului agentului, acesta să aibă acces la exact informația potrivită pentru a lua decizii bune.

Abonează-te la newsletter-ul nostru

Primește cele mai recente sfaturi, tendințe și oferte gratuit.

Cele patru tehnici de bază ale ingineriei contextului

Organizațiile de cercetare AI de top și platformele au convergent spre patru tehnici principale pentru ingineria contextului eficientă. Fiecare abordează un aspect diferit al provocării de a gestiona ferestrele de context limitate menținând totodată performanța agentului. Înțelegerea acestor tehnici și modul lor de aplicare este esențială pentru construirea agenților AI de uz producție.

Tehnica 1: Offloading – Rezumare și gestionare a referințelor

Offloading-ul reprezintă practica de a rezuma informația și a stoca datele complete ca referințe externe, permițând agentului să acceseze detaliile doar la nevoie. Când un agent AI face un apel către o unealtă—de exemplu, interoghează o bază de date sau apelează un API extern—primește un răspuns care poate fi foarte mare. În loc să introduci întregul răspuns în fereastra de context, offloading-ul implică rezumarea informațiilor cheie și furnizarea unei referințe pe care agentul o poate folosi pentru a recupera datele complete dacă este necesar.

Un exemplu practic al acestei abordări vine de la Manus AI, o organizație de cercetare care lucrează la agenți AI avansați. Când agentul lor efectuează un apel de unealtă și primește un răspuns, nu includ răspunsul integral în context. În schimb, oferă un rezumat concis al răspunsului și stochează rezultatul complet al apelului într-un fișier sau o bază de date cu un pointer de referință. Dacă agentul consideră ulterior că are nevoie de mai multe detalii, poate accesa datele stocate fără a consuma tokeni suplimentari în conversația principală. Această abordare reflectă modul în care funcționează și oamenii—nu memorăm fiecare detaliu al fiecărei conversații, ci păstrăm note și referințe la care putem apela la nevoie.

Cognition, o altă organizație de cercetare AI de top, a implementat o abordare similară, dar cu un sistem propriu de rezumare. În loc să se bazeze pe rezumate generice, au construit o logică de rezumare specializată care extrage cele mai relevante informații pentru cazurile lor de utilizare specifice. Acest lucru demonstrează un principiu important: cea mai bună strategie de offloading este adesea specifică sarcinii. Ce înseamnă un rezumat util depinde de scopul agentului. Personalizând rezumarea pentru domeniul și sarcina respectivă, poți menține un context cu semnal puternic, reducând dramatic consumul de tokeni.

Tehnica 2: Reducere – Compactarea contextului în timp

Reducerea este tehnica de a compacta și condensa contextul pentru a reduce numărul total de tokeni, păstrând totodată informațiile esențiale. Pe măsură ce un agent operează pe mai multe runde, istoricul conversației crește. Fără gestionare activă, acest istoric poate consuma rapid întreaga fereastră de context, lăsând puțin spațiu pentru informații noi sau raționament. Reducerea adresează această problemă prin compactarea periodică a conversației într-o formă mai concisă.

Anthropic a implementat acest lucru printr-o tehnică numită „compactarea” conversației. În loc să păstreze istoricul complet al fiecărui schimb de mesaje, rezumă sau comprimă periodic istoricul conversației într-o formă mai condensată. Acest lucru este deosebit de important deoarece cercetările au arătat că un context lung face de fapt mai dificil raționamentul agenților AI. Prezența contextului excesiv poate duce la ceea ce se numește „context poisoning”—un fenomen în care procesul de raționament al agentului este deviat de informații irelevante din context, ceea ce îl face să se abată de la calea optimă de raționament.

Tehnica de reducere se bazează pe o concluzie fundamentală privind modul de funcționare al modelelor de limbaj: acestea nu raționează neapărat mai bine cu mai multă informație. De fapt, opusul este adesea adevărat. Un context suplu, bine organizat, care conține doar cele mai relevante informații, duce de obicei la un raționament mai bun și un comportament mai fiabil al agentului. De aceea multe organizații de top lucrează activ la reducerea dimensiunii contextului în timp, chiar dacă, teoretic, ar putea exista mai multe informații disponibile. Menținând fereastra de context concentrată și gestionabilă, păstrează abilitatea agentului de a raționa clar și de a lua decizii bune.

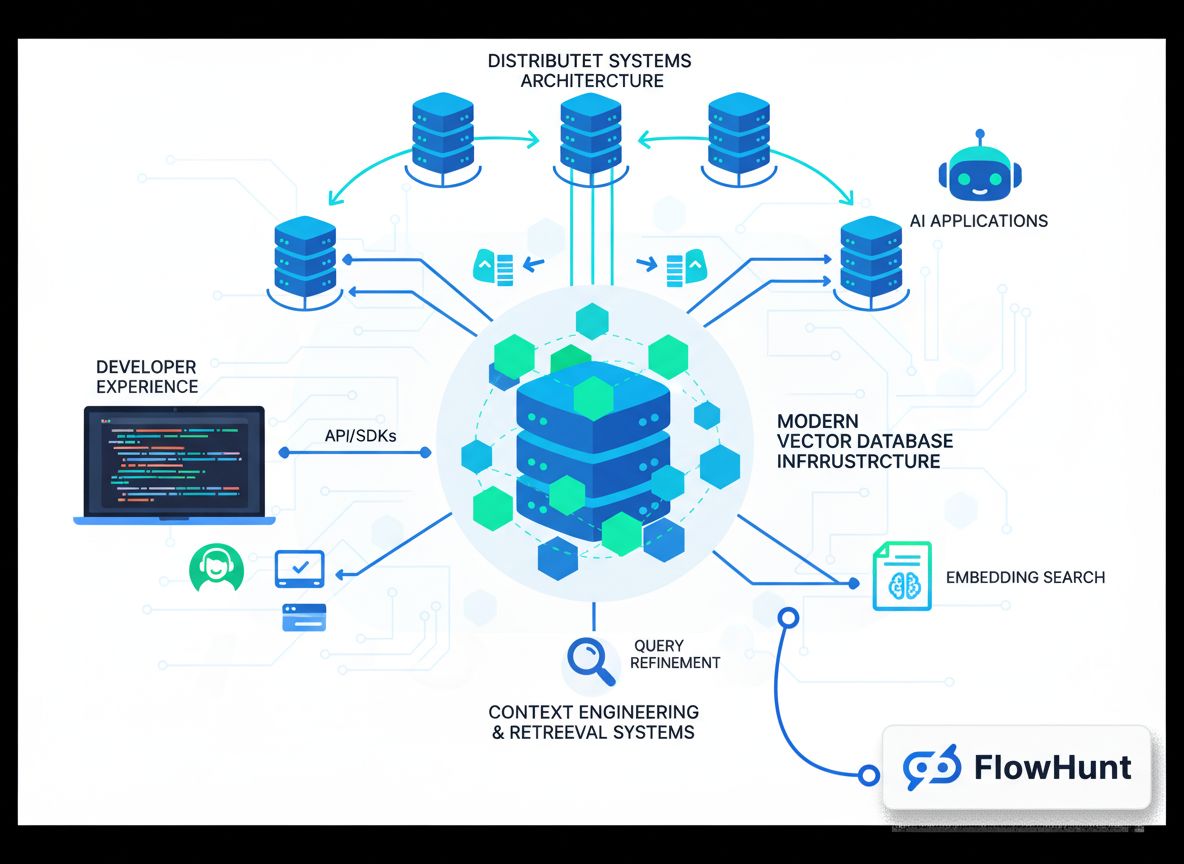

Tehnica 3: Recuperare (RAG) – Încărcare dinamică a contextului

Retrieval-Augmented Generation, sau RAG, este o tehnică în care informația relevantă este adusă și încărcată dinamic în context la rulare, în loc să fie preîncărcată de la început. Această abordare a devenit tot mai populară pe măsură ce agenții au devenit mai sofisticați. În loc să încerci să anticipezi toată informația de care ar putea avea nevoie agentul și să o încarci din start, sistemele RAG permit agenților să caute activ și să recupereze informații pe măsură ce decid că le sunt necesare.

Avantajul acestei abordări este semnificativ. În primul rând, reduce dramatic povara contextului inițial—agentul pornește cu o fereastră de context suplă și aduce informații doar când este necesar. În al doilea rând, permite dezvăluirea progresivă, agentul descoperind incremental contextul relevant prin explorare. Fiecare interacțiune aduce informații noi care informează decizia următoare. De exemplu, un agent poate începe prin a căuta fișiere relevante, descoperă că anumite fișiere sunt mai importante pe baza numelor sau a datei, apoi recuperează acele fișiere pentru analiză detaliată. Această abordare stratificată a descoperirii contextului este mult mai eficientă decât încărcarea tuturor datelor de la început.

Claude Code de la Anthropic este un exemplu excelent de RAG în practică. În loc să încarce întregul cod sursă în context, Claude Code menține identificatori ușori, precum căile către fișiere, și folosește unelte precum grep și glob pentru a recupera dinamic fișierele relevante la nevoie. Agentul poate scrie interogări țintite, stoca rezultate și utiliza unelte de linie de comandă pentru a analiza volume mari de date fără a încărca vreodată obiectele de date complete în context. Această abordare reflectă cogniția umană—nu memorăm întregi corpuri de informație, ci folosim sisteme externe de organizare precum fișiere și unelte de căutare pentru a recupera informațiile relevante la cerere.

Tehnica 4: Izolare – Sub-agenți și separarea sarcinilor

Izolarea este practica de a folosi sub-agenți pentru a gestiona sarcini specifice, asigurând că agenți diferiți lucrează la probleme separate fără suprapunere de context. Această tehnică recunoaște că uneori cea mai bună modalitate de a gestiona contextul este divizarea problemelor complexe în subprobleme mai mici, mai concentrate, fiecare gestionată de un agent dedicat cu propria fereastră de context.

Există două paradigme principale în ceea ce privește izolarea. Cognition, o organizație de cercetare AI de top, descurajează utilizarea sub-agenților, cu excepția cazurilor în care sarcinile sunt complet separate, fără suprapunere. Filosofia lor este că sub-agenții adaugă complexitate și potențiale puncte de eșec, deci ar trebui folosiți doar când este absolut necesar. Alte organizații, precum Cloud Code, au îmbrățișat sub-agenții ca parte centrală a arhitecturii lor. În Cloud Code, poți crea sub-agenți pentru diferite aspecte ale unei sarcini mai mari, cu un agent manager care coordonează între ei.

Ideea principală cu izolarea este că reprezintă un compromis. Pe de o parte, utilizarea sub-agenților poate ajuta la gestionarea contextului prin divizarea spațiului de problemă—fiecare agent are o fereastră de context concentrată, relevantă pentru sarcina sa. Pe de altă parte, sub-agenții introduc costuri de coordonare și potențiale puncte de eșec, unde informația trebuie transmisă între agenți. Abordarea potrivită depinde de cazul tău specific. Pentru sarcini foarte complexe, cu subprobleme clar separate, izolarea poate fi foarte eficientă. Pentru sarcini unde aspectele sunt strâns corelate, un singur agent cu context bine gestionat poate fi mai potrivit.

Implementarea ingineriei contextului în FlowHunt

FlowHunt oferă o platformă no-code completă pentru implementarea tuturor acestor tehnici de inginerie a contextului. În loc să fie nevoie ca dezvoltatorii să construiască soluții custom, FlowHunt permite echipelor să aplice strategii sofisticate de gestionare a contextului printr-o interfață vizuală intuitivă. Astfel, ingineria contextului devine accesibilă echipelor fără expertiză profundă de machine learning.

În FlowHunt, poți implementa izolarea prin echipe autogestionate. O astfel de echipă este formată din mai mulți agenți AI cu un agent manager care coordonează între ei. Agentul manager primește sarcina inițială, o împarte în sub-sarcini și le deleagă agenților specializați. Fiecare agent păstrează propria fereastră de context, concentrată pe responsabilitatea sa specifică. Odată ce sub-agenții și-au încheiat activitatea, agentul manager sintetizează rezultatele. Această abordare îți permite să abordezi probleme complexe împărțindu-le în părți gestionabile, fiecare cu context optimizat.

FlowHunt suportă și fluxuri de sarcini secvențiale, unde mai mulți agenți lucrează pe o problemă în succesiune, rezultatul fiecărui agent devenind input pentru următorul. Acest lucru este util mai ales pentru fluxuri unde sarcinile au dependențe clare. De exemplu, într-un flux de generare de conținut, un agent poate face cercetarea subiectului, un al doilea agent poate crea structura conținutului, iar un al treilea agent poate scrie efectiv materialul final. Fiecare agent are o fereastră de context concentrată, conținând doar informațiile relevante pentru pasul său specific.

În plus, FlowHunt îți permite să construiești sisteme inteligente de recuperare direct în fluxurile tale. În loc să încarci toate informațiile de la început, poți configura agenții să aducă dinamic date relevante la nevoie. Acest lucru poate presupune interogarea bazelor de date, căutarea în baze de cunoștințe sau recuperarea fișierelor pe baza raționamentului agentului despre ce informație îi este necesară. Combinând aceste capabilități, FlowHunt îți permite să implementezi inginerie a contextului la nivel enterprise fără a scrie o singură linie de cod.

Strategii avansate de inginerie a contextului și aplicații reale

Dincolo de cele patru tehnici de bază, există mai multe strategii avansate pe care organizațiile de top le folosesc pentru a împinge limitele ingineriei contextului. Aceste abordări combină adesea mai multe tehnici și necesită ajustare atentă pentru cazurile de utilizare specifice.

O strategie avansată este gestionarea hibridă a contextului, unde se folosește o combinație între context preîncărcat și recuperare la cerere. În loc să alegi între a încărca totul din start sau a recupera totul dinamic, abordările hibride încarcă informațiile critice pentru viteză și fiabilitate, menținând capacitatea de a recupera suplimentar la nevoie. Claude Code folosește această strategie—fișierele CLAUDE.md sunt introduse în context din start deoarece sunt mici și conțin informații importante de configurare, în timp ce fișierele mari și datele sunt recuperate la cerere cu grep și glob.

O altă strategie avansată implică selecția contextului bazată pe metadate. În loc să se uite doar la conținutul informațiilor, sistemele sofisticate folosesc metadate precum denumirea fișierului, data, ierarhii de foldere și alte semnale organizaționale pentru a decide inteligent ce informații sunt relevante. Un agent care operează într-un sistem de fișiere, de exemplu, poate deduce multe din existența unui fișier „test_utils.py” în folderul „tests” versus același fișier în „src/core_logic/”. Aceste semnale ajută agenții să înțeleagă cum și când să folosească informațiile, reducând nevoia de a încărca și parsa conținutul complet.

Mitigarea context poisoning-ului este o altă strategie avansată critică. După cum am discutat anterior, context poisoning apare când informația irelevantă din context face ca raționamentul agentului să devieze de la calea optimă. Sistemele avansate lucrează activ pentru a identifica și elimina contextul potențial toxic. Acest lucru poate implica analiza lanțului de raționament al agentului pentru a identifica unde a deviat, apoi eliminarea sau reformularea contextului care a cauzat abaterea. În timp, acest lucru creează un feedback loop care îmbunătățește continuu calitatea contextului.

Viitorul ingineriei contextului și dezvoltării agenților AI

Pe măsură ce agenții AI devin tot mai sofisticați și sunt implementați în scenarii reale tot mai complexe, importanța ingineriei contextului va crește. Domeniul evoluează rapid, cu noi tehnici și bune practici apărând constant. Mai multe tendințe vor modela viitorul ingineriei contextului.

În primul rând, probabil vom vedea sisteme automate de selecție a contextului tot mai sofisticate. În loc să decizi manual ce context să incluzi, sistemele viitoare vor folosi machine learning pentru a determina automat contextul optim pentru fiecare agent și fiecare sarcină. Aceste sisteme pot învăța din datele de performanță ale agentului pentru a identifica care bucăți de context sunt cele mai valoroase și care pot cauza poisoning.

În al doilea rând, ingineria contextului se va integra tot mai mult în proiectarea arhitecturii agenților. În loc să tratezi gestionarea contextului ca pe o etapă ulterioară, sistemele viitoare vor fi concepute de la zero cu eficiența contextului în minte. Acest lucru poate presupune noi arhitecturi de agenți care sunt intrinsec mai bune la gestionarea ferestrelor de context limitate sau noi moduri de reprezentare a informației, mai eficiente din punct de vedere al tokenilor.

În al treilea rând, vom vedea probabil apariția ingineriei contextului ca disciplină profesională distinctă, cu unelte specializate, framework-uri și bune practici. Așa cum ingineria prompturilor a evoluat dintr-o practică ad-hoc într-o disciplină recunoscută cu tehnici consacrate, și ingineria contextului urmează aceeași traiectorie. Organizațiile vor investi în echipe și instrumente dedicate optimizării contextului.

{{ cta-dark-panel

heading=“Accelerează-ți fluxul de lucru cu FlowHunt”

description=“Experimentează cum FlowHunt automatizează conținutul AI și fluxurile SEO—de la cercetare și generare de conținut la publicare și analiză—totul într-un singur loc.”

ctaPrimaryText=“Programează un demo”

ctaPrimaryURL=“https://calendly.com/liveagentsession/flowhunt-chatbot-demo"

ctaSecondaryText=“Încearcă FlowHunt gratuit”

ctaSecondaryURL=“https://app.flowhunt.io/sign-in"

gradientStartColor="#123456”

gradientEndColor="#654321”

gradientId=“827591b1-ce8c-4110-b064-7cb85a0b1217”

}}

Implementare practică: Construiește primul tău agent cu inginerie a contextului

Pentru a te ajuta să începi cu ingineria contextului, să parcurgem un exemplu practic de construire a unui agent pentru un caz uzual: cercetare și generare de conținut. Acest exemplu demonstrează cum să aplici tehnicile discutate într-un scenariu real.

Începe prin a defini clar responsabilitatea principală a agentului tău. În acest caz, agentul trebuie să cerceteze un subiect și să genereze un articol complex. În loc să faci totul într-un singur agent cu o fereastră de context uriașă, vei folosi izolarea pentru a crea un sistem multi-agent. Primul agent este un cercetător care strânge informații despre subiect. Al doilea agent este un scriitor care folosește cercetarea pentru a redacta articolul. Un agent manager coordonează între ei.

Pentru agentul cercetător, implementează gestionarea contextului bazată pe recuperare. În loc să încarci toate informațiile disponibile despre subiect de la început, agentul cercetător va avea unelte să caute în baze de date, să interogheze API-uri și să recupereze documente relevante. Pe măsură ce descoperă informații, rezumă punctele cheie și stochează referințe către sursele complete. Astfel, fereastra de context a cercetătorului rămâne suplă, dar agentul are acces la toate informațiile necesare.

Pentru agentul scriitor, implementează offloading. Cercetătorul transmite un rezumat al descoperirilor către scriitor, împreună cu referințe către sursele complete. Contextul scriitorului include rezumatul și posibilitatea de a recupera materialul sursă integral la nevoie. Asta îi permite să lucreze eficient fără a fi copleșit de date brute din cercetare.

Pe tot parcursul procesului, monitorizează context poisoning-ul. Dacă observi că agentul ia decizii slabe sau deviază, analizează-i raționamentul pentru a identifica care bucăți de context pot cauza problema. Elimină sau reformulează acel context și testează din nou. În timp, vei dezvolta o intuiție pentru ce context funcționează cel mai bine pentru cazul tău de utilizare.

Măsurarea și optimizarea performanței ingineriei contextului

Ingineria contextului eficientă necesită măsurare și optimizare continuă. Trebuie să stabilești metrici care să te ajute să înțelegi dacă eforturile de inginerie a contextului chiar îmbunătățesc performanța agentului. Există câteva metrici cheie de urmărit.

În primul rând, măsoară eficiența tokenilor—raportul dintre outputul util și tokenii consumați. Un agent care produce rezultate de calitate cu un consum redus de tokeni este mai eficient. Urmărește această metrică în timp pe măsură ce implementezi tehnici de inginerie a contextului. Ar trebui să vezi îmbunătățiri odată cu aplicarea strategiilor de offloading, reducere și recuperare.

În al doilea rând, măsoară calitatea raționamentului. Poate presupune analiza lanțurilor de raționament ale agentului pentru coerență și logică sau compararea calității outputului cu un standard de referință. Pe măsură ce îmbunătățești ingineria contextului, ar trebui să vezi o creștere a calității raționamentului, deoarece agentul are mai puține informații irelevante care să-l distragă.

În al treilea rând, măsoară capacitatea de recuperare după erori. Cât de bine își revine agentul când face o greșeală? O mai bună inginerie a contextului ar trebui să conducă la recuperare mai bună, deoarece agentul are informații mai clare despre ce nu a mers bine și ce trebuie să facă în continuare.

În al patrulea rând, măsoară latența și costul. Deși ingineria contextului vizează în primul rând calitatea, aduce și beneficii de eficiență. Agenții cu ferestre de context mai bine gestionate au de obicei latență mai mică (procesând mai puțini tokeni) și cost mai redus (consumând mai puțini tokeni). Urmărește aceste metrici pentru a înțelege impactul complet al eforturilor tale de inginerie a contextului.

Capcane frecvente și cum să le eviți

La implementarea ingineriei contextului, există câteva capcane comune. Fii atent la ele pentru a evita greșeli costisitoare.

Prima capcană este suprasolicitarea optimizării. E tentant să încerci să scoți fiecare token posibil din fereastra de context, dar asta poate duce la un context prea sărac pentru a fi util. Ține minte că scopul este să găsești echilibrul optim—suficiente informații ca agentul să raționeze eficient, dar nu atât de multe încât să se confuzeze. Începe cu o cantitate rezonabilă de context și reduce doar dacă observi că agentul performează bine.

A doua capcană este ignorarea cerințelor specifice sarcinii. Ingineria contextului nu este universală. Ce funcționează pentru un agent de suport clienți s-ar putea să nu funcționeze pentru un agent de analiză de date. Înțelege-ți cazul specific și adaptează-ți abordarea de inginerie a contextului în consecință.

A treia capcană este neglijarea monitorizării și iterării. Ingineria contextului nu este o activitate unică.