Createve AI Nexus

Conectați FlowHunt cu Createve AI Nexus pentru a unifica agenții AI, a automatiza fluxurile de lucru la nivel de întreprindere și a permite integrarea în timp r...

Un ghid cuprinzător pentru integrarea inteligenței artificiale cu aplicații externe prin API-uri și webhooks, incluzând autentificare, comunicare în timp real și strategii practice de implementare.

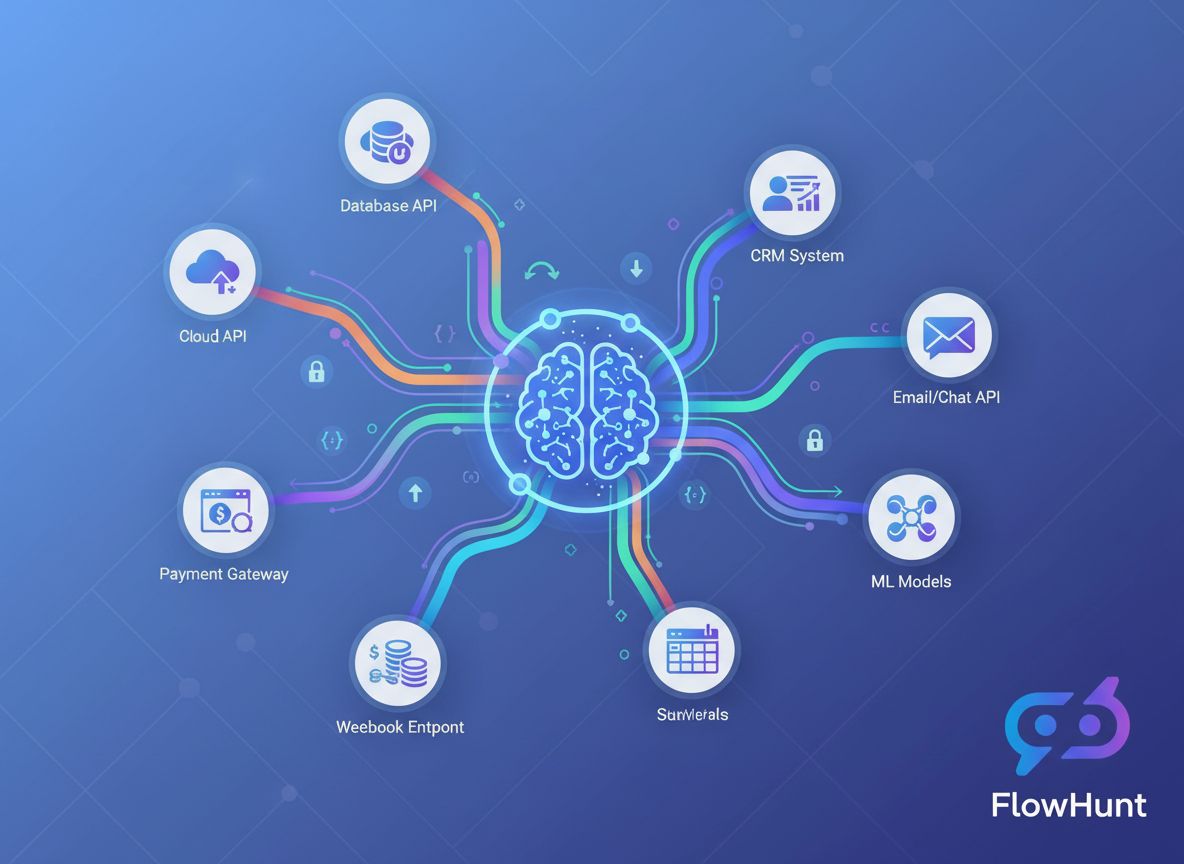

Convergența dintre inteligența artificială și aplicațiile externe a transformat fundamental modul în care operează companiile. Întreprinderile de azi nu mai lucrează cu sisteme AI izolate—ci orchestrează integrări sofisticate care conectează modele AI cu platforme CRM, gateway-uri de plăți, instrumente de comunicare și nenumărate alte servicii. Acest ghid cuprinzător explorează abordările tehnice și strategice pentru integrarea AI cu instrumente externe folosind API-uri și webhooks, oferindu-ți cunoștințele necesare pentru a construi fluxuri de lucru AI robuste, scalabile și sigure.

Fie că ești dezvoltator la primul tău proiect de integrare AI sau arhitect de întreprindere care proiectează sisteme complexe de automatizare, înțelegerea nuanțelor integrării AI bazate pe API-uri sau webhooks este esențială. Acest articol te va ghida prin întregul proces, de la conceptele de bază la modelele avansate de implementare, astfel încât să poți conecta cu încredere capabilitățile AI la infrastructura tehnologică existentă.

Înainte să analizăm strategiile de integrare, este esențial să înțelegem diferența fundamentală dintre aceste două paradigme de comunicare. Un API (Application Programming Interface) este un set de protocoale și instrumente care permite diferitelor aplicații software să comunice între ele. API-urile operează pe un model pull, ceea ce înseamnă că aplicația ta solicită activ date sau servicii de la un sistem extern. Când ai nevoie de informații, inițiezi cererea, aștepți răspunsul și procesezi datele returnate.

În contrast, un webhook funcționează pe un model push. În loc ca aplicația ta să ceară constant actualizări, webhooks permit sistemelor externe să trimită proactiv date către aplicația ta când apar anumite evenimente. Gândește-te la diferența dintre a verifica căsuța poștală de mai multe ori pe zi versus a primi scrisorile direct la ușă când sosesc.

API-urile sunt folosite de obicei pentru operațiuni la cerere—preluarea informațiilor despre utilizatori, procesarea plăților, generarea de predicții AI sau extragerea de date în timp real. Webhooks, pe de altă parte, excelează în scenarii evențiale unde ai nevoie de notificare imediată: când se procesează o plată, se trimite un formular, se încarcă un fișier sau un utilizator efectuează o acțiune specifică.

Alegerea între API-uri și webhooks depinde adesea de cazul tău de utilizare. Multe integrări sofisticate folosesc de fapt ambele: API-uri pentru interogarea datelor și webhooks pentru notificări în timp real. Această abordare hibridă oferă flexibilitatea și reactivitatea cerute de aplicațiile moderne.

Cazul de business pentru integrarea AI cu instrumente externe este convingător și multifacetic. Organizațiile care implementează cu succes aceste integrări dobândesc avantaje competitive semnificative pe mai multe planuri.

Eficiență operațională și reducerea costurilor: Când sistemele AI sunt izolate de instrumentele existente, apar silozuri de date și puncte de predare manuală. Integrarea directă a AI cu CRM-ul, platforma de e-mail, instrumentele de management de proiect și alte aplicații elimină aceste fricțiuni. În loc să copiezi manual date între sisteme, AI poate procesa automat informațiile, genera insight-uri și declanșa acțiuni pe tot stack-ul tehnologic. Această automatizare reduce costurile operaționale, minimizează erorile umane și permite echipei să se concentreze pe activități strategice cu valoare adăugată.

Decizii în timp real: Webhook-urile permit sistemelor AI să răspundă instant la evenimente de business. Când un client trimite un tichet de suport, sistemul AI poate analiza imediat sentimentul și direcționa către echipa potrivită. Când datele de vânzări se actualizează, AI poate recalcula instant previziunile. Când stocul scade sub prag, AI poate genera automat comenzi. Această reactivitate în timp real transformă viteza cu care organizațiile pot răspunde la schimbările pieței și la nevoile clienților.

Experiență îmbunătățită pentru clienți: Sistemele AI integrate oferă experiențe personalizate și fără întreruperi. Un chatbot AI integrat cu CRM-ul poate accesa istoricul clientului și oferi răspunsuri relevante contextual. Un motor de recomandare AI integrat cu platforma de e-commerce poate oferi sugestii personalizate de produse. Un asistent AI de programări integrat cu sistemul de calendar poate găsi automat ore libere. Aceste integrări creează experiențe fără fricțiuni care cresc loialitatea clienților.

Insight-uri bazate pe date la scară: Prin conectarea AI la multiple surse de date prin API-uri, organizațiile pot construi sisteme analitice cuprinzătoare care procesează informații din întreaga operațiune. Această perspectivă unificată permite predicții mai exacte, recunoașterea modelelor și insight-uri imposibil de obținut cu date izolate.

Iată câteva beneficii cheie:

API-urile sunt coloana vertebrală a majorității integrărilor AI. Pentru a integra eficient AI cu instrumente externe, trebuie să înțelegi cum funcționează API-urile și cum să interacționezi programatic cu ele.

API-urile moderne vin în mai multe variante, fiecare cu caracteristici distincte. REST (Representational State Transfer) APIs sunt cel mai des întâlnite. Folosesc metode HTTP standard (GET, POST, PUT, DELETE) pentru a efectua operațiuni asupra resurselor identificate prin URL-uri. API-urile REST sunt stateless, fiecare cerere conținând toate informațiile necesare procesării, ceea ce le face ușor de înțeles și de implementat.

GraphQL APIs oferă o alternativă mai flexibilă, permițând clienților să solicite exact datele de care au nevoie, fără a primi structuri de răspuns fixe. Pot fi mai eficiente pentru interogări complexe, dar necesită implementări de client mai sofisticate.

SOAP (Simple Object Access Protocol) APIs sunt protocoale mai vechi, bazate pe XML, încă utilizate în mediile enterprise. Sunt mai complexe decât REST, dar oferă funcționalități robuste pentru integrare la nivel enterprise.

RPC (Remote Procedure Call) APIs permit apelarea funcțiilor pe servere remote ca și cum ar fi locale. Unele API-uri blockchain și criptomonede folosesc acest model.

Pentru majoritatea integrărilor AI vei lucra cu API-uri REST, care oferă un echilibru excelent între simplitate și funcționalitate.

Fiecare interacțiune cu API-ul necesită autentificare pentru a verifica dacă aplicația ta are permisiune de acces. Înțelegerea mecanismelor de autentificare este critică pentru integrare AI sigură.

Cheile API sunt cea mai simplă metodă de autentificare. Primești o cheie unică la înregistrare și o incluzi în cereri. Deși ușor de implementat, au limitări—nu expiră automat și oferă acces total. Sunt potrivite pentru dezvoltare sau operațiuni mai puțin sensibile, dar nu trebuie să fie singurul strat de securitate în producție.

OAuth 2.0 este standardul industriei pentru autorizare delegată. În loc să partajezi credențiale direct, OAuth permite utilizatorilor să autorizeze aplicația ta să le acceseze datele. Apare atunci când o aplicație cere permisiunea de a „accesa contul tău Google” sau „conecta la workspace-ul Slack”. OAuth este mai complex de implementat, dar oferă securitate și control superior.

Bearer Tokens și JWT (JSON Web Tokens) combină simplitatea cheilor API cu funcții adiționale de securitate. JWT-urile sunt token-uri semnate criptografic ce conțin informații despre utilizator sau aplicație. Pot include timpi de expirare, permisiuni specifice și alte metadate, fiind ideale pentru microservicii și sisteme distribuite.

Mutual TLS (mTLS) folosește certificate atât pentru client cât și pentru server, oferind cel mai înalt nivel de securitate. Este des utilizat în mediile enterprise și pentru operațiuni sensibile.

Interacțiunea cu API-urile implică construirea de cereri HTTP cu headere, parametri și conținut de tip body adecvate. Iată un exemplu practic de apel către un API AI:

import requests

import json

# Configurare autentificare

headers = {

'Authorization': 'Bearer YOUR_API_KEY',

'Content-Type': 'application/json',

}

# Pregătirea payload-ului

data = {

'model': 'gpt-4',

'messages': [

{

'role': 'user',

'content': 'Analizează acest feedback de la clienți pentru sentiment'

}

],

'temperature': 0.7,

'max_tokens': 500,

}

# Efectuarea apelului API

response = requests.post(

'https://api.openai.com/v1/chat/completions',

headers=headers,

json=data

)

# Procesarea răspunsului

if response.status_code == 200:

result = response.json()

ai_response = result['choices'][0]['message']['content']

print(f"Analiză AI: {ai_response}")

else:

print(f"Eroare: {response.status_code} - {response.text}")

Acest exemplu ilustrează modelul fundamental: autentificare, construire cerere, trimitere către endpoint-ul API și procesarea răspunsului. Majoritatea integrărilor API AI urmează această structură, deși parametrii și formatele de răspuns variază în funcție de serviciu.

Dacă API-urile extrag date la cerere, webhook-urile permit comunicare push în timp real. Înțelegerea arhitecturii webhook-urilor este esențială pentru a construi sisteme AI reactive.

Un webhook este, practic, un mecanism de callback. Înregistrezi o adresă URL la un serviciu extern, iar când au loc evenimente specifice, acel serviciu trimite o cerere HTTP POST către URL-ul tău cu datele evenimentului. Aplicația ta primește aceste date, le procesează și acționează în consecință.

Fluxul arată astfel:

Construirea unui receptor webhook presupune crearea unui endpoint HTTP care poate primi cereri POST. Iată un exemplu practic cu Flask:

from flask import Flask, request, jsonify

import hmac

import hashlib

import json

app = Flask(__name__)

WEBHOOK_SECRET = 'your_webhook_secret_key'

def verify_webhook_signature(payload, signature):

"""Verifică dacă webhook-ul provine din sursa așteptată"""

expected_signature = hmac.new(

WEBHOOK_SECRET.encode(),

payload,

hashlib.sha256

).hexdigest()

return hmac.compare_digest(signature, expected_signature)

@app.route('/webhook/payment', methods=['POST'])

def handle_payment_webhook():

# Preluare payload brut pentru verificare semnătură

payload = request.get_data()

signature = request.headers.get('X-Signature')

# Verificare autentificitate webhook

if not verify_webhook_signature(payload, signature):

return jsonify({'error': 'Semnătură invalidă'}), 401

# Parsarea datelor JSON

data = request.json

# Procesarea evenimentului webhook

try:

if data['event_type'] == 'payment.completed':

# Declanșare analiză AI a tranzacției

analyze_transaction(data['transaction_id'], data['amount'])

# Actualizare în baza de date

update_payment_status(data['transaction_id'], 'completed')

# Trimitere confirmare

send_confirmation_email(data['customer_email'])

# Returnează mereu 200 pentru a confirma recepția

return jsonify({'status': 'received'}), 200

except Exception as e:

# Logare eroare dar returnează 200 pentru a preveni retry-uri

log_error(f"Eroare procesare webhook: {str(e)}")

return jsonify({'status': 'received'}), 200

if __name__ == '__main__':

app.run(port=5000)

Acest exemplu demonstrează câteva bune practici esențiale pentru webhook-uri: verificarea semnăturii pentru autenticitate, tratare corectă a erorilor și returnarea mereu a unui răspuns de succes pentru a preveni retry-urile serviciilor externe.

Webhooks introduc provocări specifice de securitate, deoarece serviciile externe trimit date către aplicația ta. Sunt esențiale câteva măsuri:

Verificarea semnăturii: Majoritatea furnizorilor de webhook includ o semnătură în headerele cererii, calculată cu un secret comun. Verifică mereu această semnătură pentru a te asigura că webhook-ul provine din sursa așteptată și nu a fost modificat.

Doar HTTPS: Folosește întotdeauna HTTPS pentru endpoint-urile webhook. Criptează datele în tranzit și previne atacurile man-in-the-middle.

Whitelistare IP: Dacă este posibil, permite doar IP-urile cunoscute de la care se vor trimite webhooks. Aceasta previne cereri neautorizate către endpoint-ul tău.

Limitarea ratei: Implementează rate limiting pe endpoint-urile webhook pentru a preveni abuzul sau flood-ul accidental.

Idempotentă: Proiectează handler-ele pentru webhook ca idempotente—procesarea aceluiași webhook de mai multe ori trebuie să aibă același rezultat. Este important deoarece furnizorii pot reîncerca livrările eșuate.

După ce am înțeles bazele, să vedem cum integrăm efectiv modele AI cu servicii externe. Aici apare adevărata putere a integrării AI.

Peisajul AI oferă numeroase opțiuni, fiecare cu capabilități, modele de preț și metode de integrare diferite. API-ul OpenAI oferă acces la GPT-4, GPT-3.5 și alte modele pentru procesare limbaj natural, generare de cod și raționament. Google Cloud AI pune la dispoziție servicii precum Vertex AI, Document AI și Vision AI. AWS oferă SageMaker pentru modele custom și alte servicii AI. API-ul Claude de la Anthropic este specializat pe AI sigur și interpretabil. Hugging Face pune la dispoziție modele open-source și un hub de modele.

Alegerea depinde de: capabilitățile AI necesare, buget, cerințe de latență, confidențialitatea datelor și preferința pentru servicii gestionate sau self-hosted.

Un pipeline tipic de integrare AI implică: colectare date din surse externe prin API-uri, preprocesare și îmbogățire, inferență model AI, procesare rezultate și declanșare acțiuni. Iată un exemplu practic care integrează mai multe componente:

import requests

import json

from datetime import datetime

import logging

class AIIntegrationPipeline:

def __init__(self, ai_api_key, crm_api_key):

self.ai_api_key = ai_api_key

self.crm_api_key = crm_api_key

self.logger = logging.getLogger(__name__)

def fetch_customer_data(self, customer_id):

"""Preia date client din API-ul CRM"""

headers = {'Authorization': f'Bearer {self.crm_api_key}'}

response = requests.get(

f'https://api.crm.example.com/customers/{customer_id}',

headers=headers

)

return response.json()

def analyze_with_ai(self, text_content):

"""Trimite conținut către API AI pentru analiză"""

headers = {

'Authorization': f'Bearer {self.ai_api_key}',

'Content-Type': 'application/json'

}

payload = {

'model': 'gpt-4',

'messages': [

{

'role': 'system',

'content': 'Ești un analist de customer service. Analizează următoarea interacțiune cu clientul și oferă insight-uri.'

},

{

'role': 'user',

'content': text_content

}

],

'temperature': 0.5,

'max_tokens': 1000

}

response = requests.post(

'https://api.openai.com/v1/chat/completions',

headers=headers,

json=payload

)

if response.status_code == 200:

return response.json()['choices'][0]['message']['content']

else:

self.logger.error(f"Eroare API AI: {response.status_code}")

raise Exception("Analiza AI a eșuat")

def update_crm_with_insights(self, customer_id, insights):

"""Actualizează CRM cu insight-uri generate de AI"""

headers = {

'Authorization': f'Bearer {self.crm_api_key}',

'Content-Type': 'application/json'

}

payload = {

'ai_insights': insights,

'last_analyzed': datetime.now().isoformat(),

'analysis_status': 'completed'

}

response = requests.put(

f'https://api.crm.example.com/customers/{customer_id}',

headers=headers,

json=payload

)

return response.status_code == 200

def process_customer(self, customer_id):

"""Pipeline complet: preluare, analiză, actualizare"""

try:

# Preluare date client

customer_data = self.fetch_customer_data(customer_id)

# Pregătire conținut pentru analiză AI

content_to_analyze = f"""

Client: {customer_data['name']}

Interacțiuni recente: {customer_data['recent_interactions']}

Istoric achiziții: {customer_data['purchase_history']}

"""

# Obține analiză AI

insights = self.analyze_with_ai(content_to_analyze)

# Actualizează CRM cu insight-uri

success = self.update_crm_with_insights(customer_id, insights)

if success:

self.logger.info(f"Client {customer_id} procesat cu succes")

return {'status': 'success', 'insights': insights}

else:

self.logger.error(f"Actualizare CRM eșuată pentru clientul {customer_id}")

return {'status': 'error', 'message': 'Actualizare CRM eșuată'}

except Exception as e:

self.logger.error(f"Eroare pipeline: {str(e)}")

return {'status': 'error', 'message': str(e)}

Acest exemplu ilustrează un pipeline complet de integrare care preia date din CRM, le trimite pentru analiză AI și actualizează CRM-ul cu rezultate. Acest model poate fi adaptat pentru nenumărate scenarii de business.

Scenariile diferite de integrare necesită abordări arhitecturale diferite. Înțelegerea compromisurilor te ajută să alegi strategia potrivită.

| Abordare | Ideală pentru | Avantaje | Dezavantaje | Latență |

|---|---|---|---|---|

| Apeluri API sincrone | Operațiuni în timp real, funcții pentru utilizatorii finali | Simplu, feedback imediat, ușor de depanat | Poate fi lent dacă modelul AI e lent, blochează execuția | Mică - Medie |

| Asincron cu webhooks | Fluxuri evențiale, procesare volum mare | Ne-blocant, scalabil, reactiv | Mai complex, consistență eventuală | Medie - Mare |

| Cozi de mesaje | Sisteme decuplate, procesare batch | Livrare fiabilă, load balancing, retry logic | Infrastructură suplimentară, consistență eventuală | Medie - Mare |

| Job-uri programate | Analiză periodică, procesare batch | Simplu, utilizare previzibilă a resurselor | Nu e în timp real, pot lipsi evenimente urgente | Mare |

| Integrare streaming | Procesare date în timp real, analiză continuă | Insight-uri imediate, gestionează volum mare | Infrastructură complexă, necesită instrumente specializate | Foarte mică |

Fiecare abordare are locul său. Un sistem de suport clienți poate folosi apeluri API sincrone pentru răspunsuri imediate ale chatbot-ului, dar procesare asincronă pentru analiză de sentiment mai detaliată. O platformă e-commerce poate folosi webhooks pentru evenimente de comandă, dar job-uri programate pentru analiză stocuri peste noapte.

Gestionarea manuală a mai multor integrări API și webhook-uri devine rapid copleșitoare pe măsură ce sistemul crește. Aici intervine FlowHunt și transformă strategia ta de integrare.

FlowHunt este o platformă completă de automatizare a fluxurilor de lucru, proiectată special pentru integrări AI. În loc să construiești și să menții cod custom de integrare, FlowHunt oferă o interfață vizuală pentru conectarea modelelor AI cu instrumente externe, gestionarea autentificării, tratarea erorilor și monitorizarea performanței.

Constructor vizual de fluxuri: Proiectezi fluxuri complexe de integrare fără să scrii cod. Conectezi modele AI, API-uri și webhooks prin drag-and-drop. FlowHunt gestionează cererile HTTP, autentificarea și transformarea datelor.

Conectori predefiniți: FlowHunt include conectori pentru servicii AI populare (OpenAI, Google Cloud AI, Anthropic) și sute de instrumente externe (Salesforce, HubSpot, Slack, Stripe etc.). Acești conectori se ocupă de autentificare și detalii specifice API-urilor, astfel încât te poți concentra pe logică de business.

Gestionare webhook-uri: FlowHunt simplifică configurarea și gestionarea webhook-urilor. Înregistrezi webhook-uri la servicii externe, primești evenimente și declanșezi analiză AI—totul din interfața FlowHunt. Nu mai trebuie să construiești și să menții receptoare webhook custom.

Gestionare erori și retry-uri: Retry automat pentru apeluri API eșuate cu backoff exponențial. Notificări de eroare și fluxuri de fallback configurabile. FlowHunt asigură reziliența și fiabilitatea integrărilor tale.

Transformare date: Transformi datele între formate și structuri diferite. Mapare câmpuri din CRM către input-uri pentru modelul AI, transformarea răspunsurilor AI în formate acceptate de alte instrumente.

Monitorizare și jurnalizare: Monitorizezi fiecare apel API, eveniment webhook și execuție de flux. Identifici blocaje, depanezi rapid și optimizezi performanța cu loguri și analytics detaliate.

Limitare rată și throttling: FlowHunt gestionează automat limitele de rată API, pune cererile în coadă și le distribuie astfel încât să rămâi în limitele serviciilor.

Imaginează-ți că vrei să analizezi automat feedback-ul clienților din sistemul de suport, să categorizezi sentimentul și să actualizezi CRM-ul. În FlowHunt, acest flux arată astfel:

Ce ar necesita zeci de linii de cod și gestiune atentă a erorilor într-o soluție custom devine un flux vizual în FlowHunt. Poți modifica workflow-ul, adăuga pași sau schimba modelele AI fără să atingi codul.

Pe măsură ce nevoile de integrare AI devin mai sofisticate, câteva modele avansate și bune practici devin esențiale.

Majoritatea API-urilor impun rate limiting—număr maxim de cereri pe minut sau oră. Depășirea acestor limite duce la erori sau suspendarea serviciului. Gestionarea eficientă a ratei este crucială pentru integrare fiabilă.

Implementează backoff exponențial: când atingi limita, aștepți înainte de retry, crescând timpul la fiecare încercare. Majoritatea răspunsurilor API includ informații despre limite în headere, permițând gestionarea proactivă a ratelor.

import time

import requests

def call_api_with_backoff(url, headers, data, max_retries=5):

"""Apelează API cu backoff exponențial pentru limitarea ratei"""

for attempt in range(max_retries):

try:

response = requests.post(url, headers=headers, json=data)

# Verifică dacă am atins limita

if response.status_code == 429:

# Extrage header-ul retry-after dacă există

retry_after = int(response.headers.get('Retry-After', 2 ** attempt))

print(f"Limitare rată. Aștept {retry_after} secunde...")

time.sleep(retry_after)

continue

# Alte erori

response.raise_for_status()

return response.json()

except requests.exceptions.RequestException as e:

if attempt == max_retries - 1:

raise

wait_time = 2 ** attempt

print(f"Cerere eșuată: {e}. Retry în {wait_time} secunde...")

time.sleep(wait_time)

raise Exception("Număr maxim de retry-uri depășit")

Unele operațiuni AI durează mult. Folosește modele asincrone unde serviciul AI returnează un job ID, iar tu verifici periodic rezultatul sau primești webhook la finalizare.

def submit_async_ai_job(content):

"""Trimite conținut pentru procesare AI asincronă"""

headers = {'Authorization': f'Bearer {AI_API_KEY}'}

response = requests.post(

'https://api.ai.example.com/async-analyze',

headers=headers,

json={'content': content}

)

job_data = response.json()

return job_data['job_id']

def check_job_status(job_id):

"""Verifică statusul jobului asincron"""

headers = {'Authorization': f'Bearer {AI_API_KEY}'}

response = requests.get(

f'https://api.ai.example.com/jobs/{job_id}',

headers=headers

)

job_data = response.json()

if job_data['status'] == 'completed':

return {'status': 'completed', 'result': job_data['result']}

elif job_data['status'] == 'failed':

return {'status': 'failed', 'error': job_data['error']}

else:

return {'status': 'processing'}

Apelarea API-urilor AI cu aceiași parametri de mai multe ori consumă resurse și crește costurile. Implementează caching pentru rezultate comune.

import hashlib

import json

from functools import wraps

import redis

# Conectare la Redis cache

cache = redis.Redis(host='localhost', port=6379, db=0)

def cache_ai_result(ttl=3600):

"""Decorator pentru cache la rezultatele AI API"""

def decorator(func):

def wrapper(content, *args, **kwargs):

# Creează key de cache din hash-ul conținutului

content_hash = hashlib.md5(content.encode()).hexdigest()

cache_key = f"ai_result:{content_hash}"

# Verifică cache-ul

cached_result = cache.get(cache_key)

if cached_result:

return json.loads(cached_result)

# Apelează API-ul AI

result = func(content, *args, **kwargs)

# Stochează în cache

cache.setex(cache_key, ttl, json.dumps(result))

return result

return wrapper

return decorator

@cache_ai_result(ttl=86400) # Cache pentru 24h

def analyze_sentiment(text):

"""Analizează sentimentul cu caching"""

# Apelează API-ul AI aici

pass

Integrările de producție necesită monitorizare completă. Monitorizează timpii de răspuns API, ratele de eroare și succesul livrării webhook-urilor. Configurează alerte pentru anomalii.

import logging

from datetime import datetime

import json

class IntegrationMonitor:

def __init__(self, log_file='integration.log'):

self.logger = logging.getLogger(__name__)

handler = logging.FileHandler(log_file)

formatter = logging.Formatter(

'%(asctime)s - %(name)s - %(levelname)s - %(message)s'

)

handler.setFormatter(formatter)

self.logger.addHandler(handler)

def

API-urile sunt sisteme de tip pull unde soliciți date de la un serviciu extern, în timp ce webhooks sunt sisteme de tip push unde serviciile externe trimit date către aplicația ta atunci când apar evenimente specifice. API-urile sunt ideale pentru extragerea de date la cerere, pe când webhooks excelează în notificări de evenimente în timp real.

Stochează cheile API în variabile de mediu, folosește instrumente dedicate de gestionare a secretelor precum HashiCorp Vault sau AWS Secrets Manager, nu salva niciodată cheile în controlul versiunilor, rotește cheile periodic și implementează principiul celui mai mic privilegiu, limitând permisiunile cheilor doar la operațiunile necesare.

Metodele comune de autentificare includ chei API (bazate pe token simplu), OAuth 2.0 (autorizare delegată), Bearer tokens (bazate pe JWT) și mutual TLS (bazate pe certificat). Alegerea depinde de cerințele de securitate ale furnizorului de API și de nevoile aplicației tale.

Implementează strategii de retry cu backoff exponențial, monitorizează headerele de limitare a ratei din răspunsurile API, folosește sisteme de coadă pentru cereri, cachează răspunsurile când este posibil și ia în considerare trecerea la planuri API de nivel superior dacă atingi frecvent limitele. Multe biblioteci oferă mecanisme de retry integrate.

Arshia este Inginer de Fluxuri AI la FlowHunt. Cu o pregătire în informatică și o pasiune pentru inteligența artificială, el este specializat în crearea de fluxuri eficiente care integrează instrumente AI în sarcinile de zi cu zi, sporind productivitatea și creativitatea.

FlowHunt simplifică integrarea AI cu instrumente externe, automatizând apelurile API, gestionarea webhook-urilor și procesarea datelor într-o singură platformă unificată.

Conectați FlowHunt cu Createve AI Nexus pentru a unifica agenții AI, a automatiza fluxurile de lucru la nivel de întreprindere și a permite integrarea în timp r...

Integrează WayStation de la FlowHunt cu instrumentele tale preferate de productivitate și cu principalii clienți AI pentru automatizări fără cod, sigure și flui...

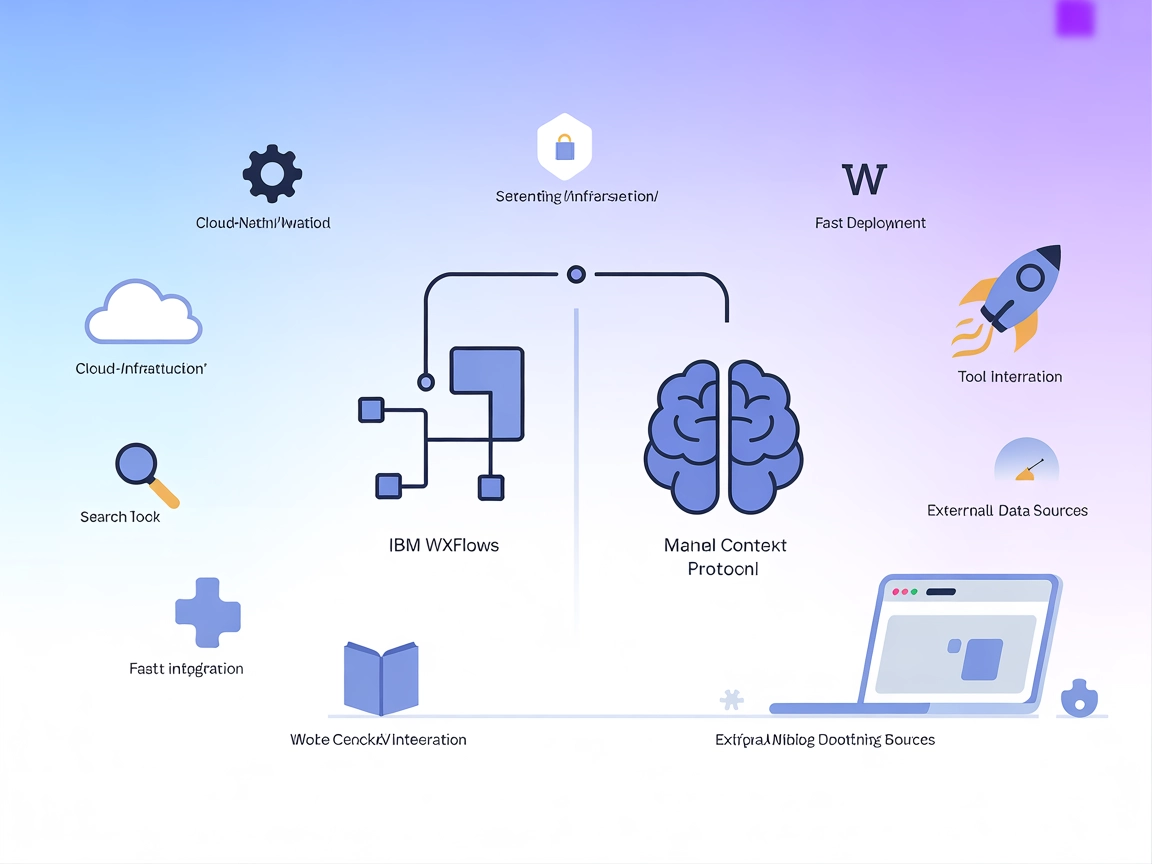

Conectați FlowHunt cu IBM wxflows prin Model Context Protocol (MCP) pentru a implementa, gestiona și automatiza fluxuri de lucru alimentate de AI. Profitați de ...

Consimțământ Cookie

Folosim cookie-uri pentru a vă îmbunătăți experiența de navigare și a analiza traficul nostru. See our privacy policy.