Decodificarea modelelor de agenți AI: Analiza comparativă supremă

Explorează lumea modelelor de agenți AI printr-o analiză cuprinzătoare a 20 de sisteme de ultimă generație. Descoperă cum gândesc, raționează și performează în ...

O analiză detaliată a modelului de raționament EXAONE Deep 32B de la LG testat în comparație cu DeepSeek R1 și QwQ de la Alibaba, examinând pretențiile de performanță superioară și capacitățile reale de raționament.

Peisajul modelelor de raționament în inteligența artificială a devenit din ce în ce mai competitiv, diverse organizații pretinzând performanțe revoluționare pe sarcini complexe de raționament matematic și logic. Recentele lansări ale modelului EXAONE Deep de la LG, cu 32 de miliarde de parametri, au atras atenția cu afirmații că depășește concurenți consacrați precum DeepSeek R1. Totuși, testarea în condiții reale dezvăluie o imagine mai nuanțată decât cea sugerată de marketing. Acest articol oferă o analiză detaliată a performanței reale a modelului EXAONE Deep comparativ cu alte modele de raționament de top, examinând diferența dintre scorurile declarate în benchmarks și funcționalitatea practică. Prin testare practică și comparație detaliată, vom explora ce pot face cu adevărat aceste modele, cum abordează sarcinile complexe de raționament și ce înseamnă acest lucru pentru organizațiile care iau în calcul folosirea lor în producție.

Apariția modelelor de raționament reprezintă o schimbare fundamentală în modul în care inteligența artificială abordează rezolvarea problemelor complexe. Spre deosebire de modelele lingvistice tradiționale care generează răspunsuri într-o singură trecere, modelele de raționament folosesc o tehnică numită decodare la timpul testării, care alocă resurse computaționale importante în timpul inferenței pentru a gândi pas cu pas. Această abordare reflectă raționamentul uman, unde de multe ori trebuie să analizăm problema din mai multe unghiuri înainte de a ajunge la o soluție. Conceptul a devenit notoriu odată cu modelul o1 de la OpenAI și a fost ulterior adoptat de organizații precum DeepSeek, Alibaba și, mai nou, LG. Aceste modele generează așa-numiții “tokeni de gândire” sau “raționament”, pe care utilizatorii nu îi văd în rezultatul final, dar care reflectă procesul intern de deliberare al modelului. Tokenii de gândire sunt esențiali pentru că permit modelului să exploreze diferite căi de soluționare, să corecteze erori și să-și rafineze abordarea înainte de a oferi un răspuns final. Acest lucru este valoros mai ales pentru problemele matematice, sarcinile de raționament logic și scenariile complexe cu mai mulți pași, unde o singură trecere poate rata detalii importante sau poate duce la concluzii greșite.

Pentru organizațiile care implementează sisteme AI, modelele de raționament reprezintă un progres semnificativ în ceea ce privește fiabilitatea și acuratețea pe sarcinile complexe. Modelele lingvistice tradiționale întâmpină adesea dificultăți la probleme matematice cu mai mulți pași, deducție logică și scenarii ce necesită o analiză atentă a constrângerilor și condițiilor. Modelele de raționament adresează aceste limitări prin faptul că își arată explicit modul de lucru, ceea ce oferă și transparență asupra modului în care modelul a ajuns la concluzie. Această transparență este deosebit de importantă în mediile enterprise, unde deciziile bazate pe recomandările AI trebuie să fie auditate și explicabile. Totuși, există un compromis între costul computațional și latență. Deoarece modelele de raționament generează mulți tokeni de gândire înainte de răspunsul final, au nevoie de mai multă putere de procesare și răspund mai lent decât modelele lingvistice standard. De aceea, selecția modelului este critică — organizațiile trebuie să înțeleagă nu doar scorurile de benchmark, ci și performanța reală pe cazurile lor specifice de utilizare. Proliferarea modelelor de raționament de la diferiți furnizori, fiecare pretinzând performanță superioară, face ca testarea și comparația independentă să fie esențiale pentru a lua decizii informate.

Intrarea LG pe piața modelelor de raționament cu EXAONE Deep a generat mult interes, mai ales datorită capacităților de cercetare ale companiei și dimensiunii relativ modeste de 32 de miliarde de parametri a modelului. Materialele de marketing LG au prezentat rezultate impresionante de benchmark, susținând că EXAONE Deep a atins 90% acuratețe la competiția AIME (American Invitational Mathematics Examination) cu doar 64 de încercări și 95% la problemele MATH-500. Aceste cifre, dacă sunt reale, ar plasa modelul la nivel competitiv sau chiar superior față de DeepSeek R1 și QwQ de la Alibaba. Compania a lansat și versiuni de diferite dimensiuni, inclusiv una cu 2,4 miliarde de parametri destinată folosirii ca model de schiță în decodarea speculativă — o tehnică ce utilizează modele mai mici pentru a prevedea tokenii generați de cele mai mari, accelerând astfel inferența. Totuși, la testare practică pe probleme standard de raționament, EXAONE Deep a prezentat comportamente îngrijorătoare care contrazic afirmațiile din benchmarks. Modelul a manifestat tendința de a intra în bucle extinse de gândire fără a ajunge la concluzii logice, generând mii de tokeni repetitivi sau lipsiți de sens, în loc de raționament productiv. Acest comportament sugerează posibile probleme cu antrenamentul modelului, metodologia de evaluare a benchmark-ului sau modul în care modelul gestionează anumite tipuri de prompturi.

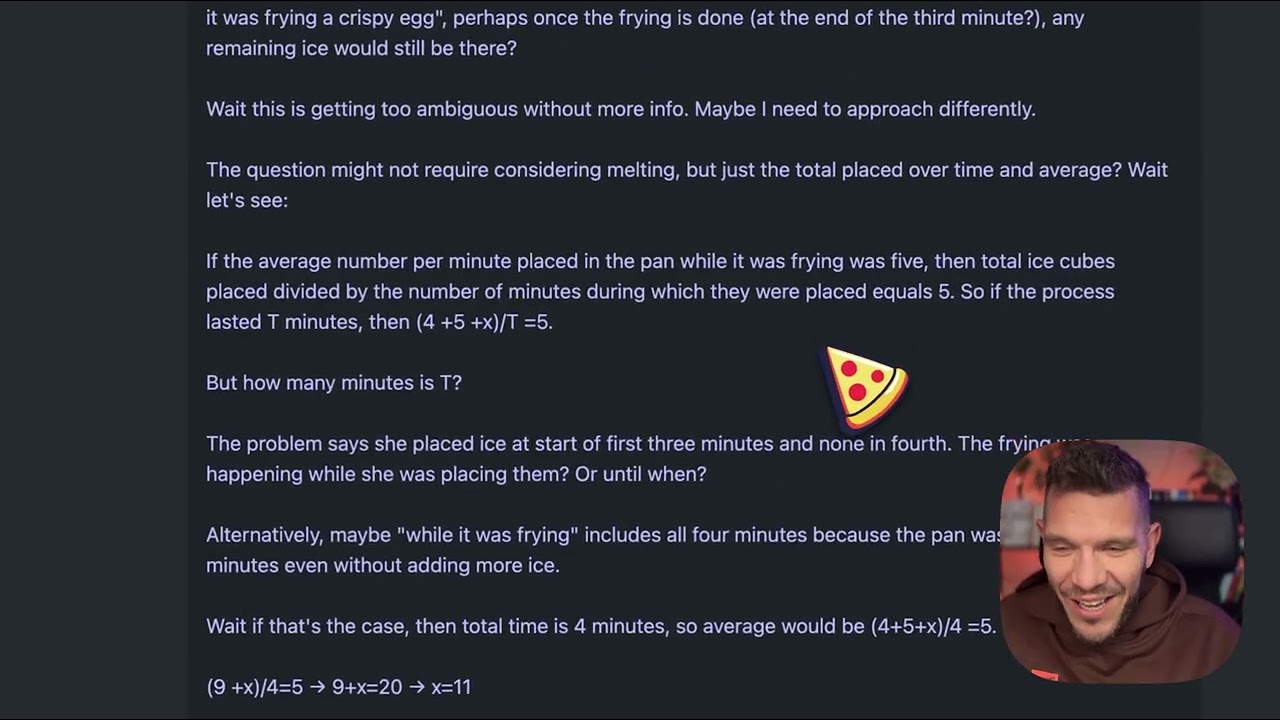

Pentru a înțelege diferențele practice dintre modelele de raționament, să luăm o problemă aparent simplă, devenită standard pentru testarea calității raționamentului: “Beth pune câteva cuburi întregi de gheață într-o tavă. După un minut, sunt 20 de cuburi de gheață. După două minute, sunt 10 cuburi. După trei minute, sunt 0 cuburi. Câte cuburi întregi de gheață se găsesc în tavă la sfârșitul celui de-al treilea minut?” Răspunsul corect este zero, deoarece întrebarea cere explicit cuburile întregi de la finalul minutului trei, iar problema precizează că atunci sunt zero. Totuși, această întrebare este concepută să păcălească modelele care supra-analizează sau se lasă derutate de contextul cu topirea cuburilor. Unele modele ar putea raționa că gheața se topește în timp și ar încerca să calculeze ratele de topire, ceea ce le poate abate de la răspunsul direct. La testarea EXAONE Deep cu această problemă, modelul a generat în jur de 5.000 de tokeni de gândire fără a ajunge la o concluzie coerentă. Procesul de raționament a părut să deraieze, textul generat devenind tot mai incoerent și nereușind să demonstreze o rezolvare logică. Tokenii generați conțineau fragmente fără sens și modelul nu a articulat niciodată clar un raționament sau un răspuns final. Această performanță contrastează puternic cu modul în care problema ar trebui tratată — un model de raționament ar trebui să identifice capcana, să parcurgă logic problema și să ajungă eficient la răspuns.

Când aceeași problemă cu cuburile de gheață a fost testată pe DeepSeek R1 și QwQ de la Alibaba, ambele au avut performanțe semnificativ mai bune. DeepSeek R1 a generat un proces de gândire clar, a parcurs problema metodic și a ajuns la răspunsul corect: zero. Raționamentul modelului a fost transparent și logic, arătând cum a analizat problema, a identificat capcana și a ajuns la răspunsul corect. QwQ a avut de asemenea o performanță solidă, deși a generat și el un proces de gândire extins. Interesant este că QwQ a considerat inițial dacă gheața are nevoie de timp pentru a se topi și dacă problema este de fizică sau matematică, dar în final a ajuns la răspunsul corect. Diferența cheie a fost că ambele modele au prezentat raționamente coerente pe tot parcursul procesului, chiar și când au explorat mai multe unghiuri. Au demonstrat capacitatea de a recunoaște când au suficiente informații pentru răspuns și de a se angaja la o concluzie finală. EXAONE Deep, în schimb, nu a ajuns niciodată aici. Modelul a continuat să genereze tokeni fără scop aparent, fără să se oprească la un răspuns sau să prezinte o progresie logică clară. Acest lucru sugerează probleme fundamentale cu modul în care modelul abordează sarcinile de raționament, în ciuda scorurilor impresionante din benchmarks.

Un aspect tehnic interesant al lansării EXAONE Deep este includerea mai multor dimensiuni de model proiectate să funcționeze împreună prin decodare speculativă. Versiunea cu 2,4 miliarde de parametri poate acționa ca model de schiță, prezicând tokenii pe care îi va genera modelul principal, cel de 32 de miliarde de parametri. Când predicțiile modelului de schiță coincid cu generarea modelului principal, sistemul poate sări peste calculul modelului mare și să folosească predicția schiței, accelerând astfel inferența. Este o tehnică sofisticată de optimizare ce poate reduce semnificativ latența și cerințele computaționale. În testare, implementarea decodării speculative a indicat tokeni verzi ce sugerau predicții de schiță reușite, ceea ce arată că tehnica funcționează conform așteptărilor. Totuși, această optimizare nu rezolvă problema fundamentală a calității raționamentului modelului principal. O inferență rapidă cu raționament slab rămâne o inferență slabă. Prezența acestei funcționalități ridică și întrebări privind posibilitatea ca rezultatele de benchmark ale LG să fi fost obținute cu configurații sau tehnici ce nu se aplică ușor în utilizarea reală.

Pentru organizațiile care se confruntă cu evaluarea și compararea mai multor modele AI, FlowHunt oferă o platformă completă de automatizare care eficientizează procesul de testare și benchmarking. În loc să ruleze manual teste pe diferite modele și să compare rezultatele, FlowHunt permite echipelor să configureze fluxuri automate care evaluează sistematic performanța modelelor pe mai multe dimensiuni. Acest lucru este deosebit de valoros la compararea modelelor de raționament, unde performanța poate varia semnificativ în funcție de tipul și complexitatea problemei sau de formularea promptului. Capabilitățile de automatizare ale FlowHunt permit testarea modelelor pe seturi standardizate de probleme, urmărirea metricilor în timp și generarea de rapoarte comparative complete. Platforma se poate integra cu mai mulți furnizori și API-uri de modele, făcând posibilă evaluarea acestora într-un flux unificat. Pentru echipele care iau în calcul implementarea unor modele precum EXAONE Deep, DeepSeek R1 sau QwQ, FlowHunt oferă infrastructura necesară pentru decizii bazate pe date reale și nu doar pe afirmațiile furnizorilor. Capacitatea de a automatiza sarcinile repetitive de testare eliberează resurse de inginerie pentru integrare și optimizare, nu pentru benchmarking manual.

Discrepanța dintre performanța declarată a EXAONE Deep și comportamentul său real la testare scoate în evidență o lecție esențială pentru adopția AI: benchmark-urile furnizorilor trebuie întotdeauna verificate prin testare independentă. Rezultatele de benchmark pot fi influențate de mulți factori, inclusiv setul de testare folosit, metodologia de evaluare, configurația hardware și parametrii de inferență ai modelului. Un model poate avea rezultate bune la un anumit benchmark, dar să întâmpine dificultăți cu alte tipuri de probleme sau scenarii reale. De aceea, organizații precum Weights & Biases și cercetătorii independenți joacă un rol important în ecosistemul AI — oferă testare și analiză imparțială care ajută comunitatea să înțeleagă ce pot face cu adevărat modelele. La evaluarea modelelor de raționament pentru implementare, organizațiile ar trebui să facă teste proprii pe seturi de probleme reprezentative pentru domeniul lor. Un model care excelează la raționament matematic poate avea dificultăți la deducție logică sau generare de cod. Problema cuburilor de gheață, deși pare simplă, este un test diagnostic util tocmai pentru că arată dacă un model poate gestiona întrebări capcană și poate evita supra-analiza. Modelele care eșuează la astfel de probleme probabil vor avea dificultăți și cu sarcini de raționament mai complexe.

Buclele extinse de gândire observate la testarea EXAONE Deep pot avea mai multe cauze posibile. Una ar fi că procesul de antrenament al modelului nu l-a învățat suficient când să se oprească din gândit și să ofere un răspuns. Modelele de raționament necesită calibrare atentă în antrenament pentru a echilibra avantajele gândirii extinse cu riscul de supra-analiză și generare de tokeni neproductivi. Dacă antrenamentul nu a inclus suficiente exemple de oprire, modelul poate genera tokeni până atinge limita maximă. O altă cauză posibilă este modul în care modelul gestionează prompturile, mai ales interpretarea unor întrebări sau instrucțiuni. Unele modele sunt sensibile la formularea promptului și pot reacționa diferit în funcție de formulare. Faptul că EXAONE Deep a generat secvențe incoerente de tokeni sugerează că modelul poate intra într-o stare în care generează tokeni fără conținut semantic relevant, ceea ce ar putea indica probleme cu mecanismele de atenție sau logica de predicție a tokenilor. O a treia posibilitate este ca metodologia de benchmark să fi folosit configurații sau strategii de prompt diferite față de testarea reală, ducând la o diferență mare între rezultatele raportate și cele reale.

Problemele de performanță observate la EXAONE Deep au implicații mai largi pentru piața modelelor de raționament. Pe măsură ce tot mai multe organizații lansează astfel de modele, piața riscă să se satureze cu modele care afișează scoruri impresionante la benchmark-uri, dar performanță discutabilă în realitate. Acest lucru complică selecția pentru organizațiile care doresc să le folosească în producție. Soluția este accentuarea testării independente, a metodologiilor standardizate de evaluare și transparența privind limitările modelelor. Domeniul ar beneficia de standarde industriale pentru evaluarea și compararea acestor modele, așa cum s-a întâmplat și cu alte benchmark-uri AI. De asemenea, organizațiile ar trebui să fie precaute cu modelele care pretind depășirea netă a competitorilor consacrați, mai ales când diferența de performanță nu se reflectă în arhitectura sau abordarea de antrenament. DeepSeek R1 și QwQ au demonstrat performanță consistentă în mai multe scenarii de testare, ceea ce le conferă credibilitate. Performanța inconsistentă a EXAONE Deep — scoruri excelente la benchmark, dar rezultate slabe în practică — sugerează fie probleme ale modelului, fie neconcordanțe în modul de realizare a benchmark-ului.

Descoperă cum FlowHunt automatizează fluxurile tale AI de conținut și SEO — de la cercetare și generare de conținut, la publicare și analiză — totul într-un singur loc.

Organizațiile care iau în calcul implementarea modelelor de raționament ar trebui să urmeze un proces structurat de evaluare. În primul rând, să stabilească un set de teste reprezentativ care să includă probleme din domeniul sau cazul lor de utilizare specific. Benchmarks generice pot să nu reflecte performanța reală pe problemele proprii. În al doilea rând, să testeze mai multe modele pe aceleași probleme pentru comparație directă. Acest lucru presupune standardizarea mediului de testare, inclusiv hardware, parametri de inferență și formularea prompturilor. În al treilea rând, să evalueze nu doar acuratețea, ci și metrici de eficiență precum latența și generarea de tokeni. Un model care oferă răspunsuri corecte dar necesită 10.000 de tokeni de gândire poate fi nepractic pentru utilizare în timp real. În al patrulea rând, să analizeze procesul de raționament al modelului, nu doar răspunsul final. Un model care ajunge la răspunsul corect printr-un raționament defectuos poate eșua la probleme similare cu parametri diferiți. În al cincilea rând, să testeze cazuri limită și întrebări capcană pentru a vedea cum gestionează modelul scenariile concepute să-l inducă în eroare. În final, să ia în calcul costul total de proprietate, incluzând nu doar costul licenței sau API-ului modelului, ci și resursele computaționale necesare pentru inferență și efortul de integrare.

Dimensiunea de 32 de miliarde de parametri a EXAONE Deep este semnificativ mai mică decât a unor modele concurente, ceea ce ridică întrebări dacă problemele modelului provin dintr-o capacitate insuficientă. Totuși, doar dimensiunea nu determină capacitatea de raționament. QwQ, care funcționează într-un interval similar de parametri, demonstrează raționament solid. Asta sugerează că problemele EXAONE Deep țin mai degrabă de metodologia de antrenament, designul arhitecturii sau configurarea inferenței, nu de limitări fundamentale de mărime. Includerea unui model de schiță cu 2,4 miliarde de parametri arată că LG are în vedere eficiența, ceea ce este de apreciat. Totuși, câștigurile de eficiență sunt valoroase doar dacă modelul de bază produce rezultate corecte. Un răspuns rapid greșit este mai puțin util decât un răspuns corect lent în majoritatea scenariilor de producție. Piața modelelor de raționament probabil va pune tot mai mult accent pe eficiență, pe măsură ce organizațiile caută să le implementeze la scară, dar această optimizare nu trebuie să afecteze calitatea raționamentului.

Domeniul modelelor de raționament este încă la început, iar în lunile și anii următori ne putem aștepta la evoluții semnificative. Pe măsură ce tot mai multe organizații lansează modele și are loc testare independentă, piața se va consolida în jurul modelelor care dovedesc performanță constantă și fiabilă. Organizații precum DeepSeek și Alibaba și-au construit credibilitatea prin rezultate consistente, în timp ce noi veniți ca LG vor trebui să rezolve problemele de performanță evidențiate de testare pentru a câștiga acceptarea pieței. Ne putem aștepta și la inovații continue în antrenarea și evaluarea modelelor de raționament. Actuala abordare de generare a multor tokeni de gândire este eficientă dar costisitoare computațional. Modelele viitoare ar putea dezvolta mecanisme de raționament mai eficiente, care să atingă aceeași acuratețe cu mai puțini tokeni. De asemenea, vom vedea probabil specializare crescută, cu modele de raționament optimizate pentru domenii precum matematică, generare de cod sau raționament logic. Integrarea modelelor de raționament cu alte tehnici AI, precum generarea augmentată cu căutare sau utilizarea de instrumente, le va extinde la rândul lor capabilitățile și aplicabilitatea.

EXAONE Deep de la LG reprezintă o încercare ambițioasă de intrare pe piața modelelor de raționament, însă testarea reală relevă diferențe majore între performanța declarată și capabilitățile reale ale modelului. Deși rezultatele de benchmark sugerează o performanță competitivă cu DeepSeek R1 și QwQ de la Alibaba, testarea practică pe probleme standard de raționament arată că EXAONE Deep are dificultăți cu sarcini de bază, generând un număr excesiv de tokeni fără a ajunge la concluzii coerente. DeepSeek R1 și QwQ au demonstrat ambele o performanță superioară pe aceleași probleme, ajungând la răspunsuri corecte prin procese logice și clare de raționament. Pentru organizațiile care evaluează modele de raționament pentru implementare, această analiză subliniază importanța critică a testării și verificării independente. Benchmark-urile furnizorilor ar trebui tratate ca punct de plecare pentru evaluare, nu ca măsură definitivă a capabilității. Piața modelelor de raționament va beneficia de mai multă transparență, metodologii standardizate de evaluare și testare independentă continuă din partea comunității de cercetare. Pe măsură ce această tehnologie evoluează, organizațiile care investesc în procese riguroase de evaluare și comparație vor fi mai bine poziționate să aleagă și să implementeze modele de raționament care oferă valoare reală pentru cazurile lor specifice de utilizare.

EXAONE Deep este un model de raționament cu 32 de miliarde de parametri dezvoltat de LG, care folosește decodare la timpul testării pentru a rezolva probleme complexe. Spre deosebire de modelele lingvistice standard, acesta alocă resurse computaționale suplimentare în timpul inferenței pentru a gândi pas cu pas, similar cu modelele DeepSeek R1 și QwQ de la Alibaba.

În testele practice pe sarcini de raționament, precum problema cu cuburile de gheață, EXAONE Deep a prezentat probleme semnificative de supra-gândire și a generat un număr excesiv de tokeni fără a ajunge la concluzii logice. Atât DeepSeek R1 cât și QwQ au avut rezultate mai bune, ajungând la răspunsuri corecte mai eficient.

Decodarea la timpul testării este o tehnică prin care modelele AI alocă mai multe resurse computaționale în timpul inferenței pentru a raționa prin probleme complexe. Aceasta permite modelelor să își arate procesul de gândire și să ajungă la răspunsuri mai corecte, deși necesită o calibrare atentă pentru a evita supra-gândirea.

FlowHunt automatizează fluxul de testare, comparație și evaluare a mai multor modele AI, permițând echipelor să evalueze sistematic performanța, să urmărească metrici și să ia decizii bazate pe date privind ce modele să folosească pentru diferite cazuri de utilizare.

Arshia este Inginer de Fluxuri AI la FlowHunt. Cu o pregătire în informatică și o pasiune pentru inteligența artificială, el este specializat în crearea de fluxuri eficiente care integrează instrumente AI în sarcinile de zi cu zi, sporind productivitatea și creativitatea.

Folosește FlowHunt pentru a eficientiza fluxurile de testare, comparație și urmărire a performanței modelelor AI cu ajutorul automatizării inteligente.

Explorează lumea modelelor de agenți AI printr-o analiză cuprinzătoare a 20 de sisteme de ultimă generație. Descoperă cum gândesc, raționează și performează în ...

Descoperă de ce Gemini 3 Flash de la Google revoluționează IA prin performanțe superioare, costuri reduse și viteze mai mari—depășind chiar Gemini 3 Pro la sarc...

Descoperă cum un model minuscul cu 7 milioane de parametri reușește să depășească Gemini, DeepSeek și Claude folosind raționament recursiv și supervizare profun...

Consimțământ Cookie

Folosim cookie-uri pentru a vă îmbunătăți experiența de navigare și a analiza traficul nostru. See our privacy policy.