Introducere

Tranziția de la construirea unui prototip AI funcțional la implementarea unui sistem pregătit pentru producție a reprezentat mult timp una dintre cele mai provocatoare etape ale dezvoltării inteligenței artificiale. Ceea ce pare adesea un proces simplu în demo-uri — regăsirea informațiilor relevante, completarea prompturilor și generarea răspunsurilor — devine exponențial mai complex când este extins la mediile de producție. Această complexitate a dus la ceea ce mulți din industrie descriu ca fiind „alchimie” mai degrabă decât inginerie: un proces misterios în care dezvoltatorii ajustează configurații, modifică parametri și speră ca sistemele lor să continue să funcționeze fiabil. Apariția ingineriei contextului ca disciplină marchează o schimbare fundamentală în modul în care abordăm construirea sistemelor AI, îndepărtându-ne de această metodologie de tip încercare-și-eroare și îndreptându-ne spre o abordare sistematică, inginerească. În această analiză cuprinzătoare, vom explora cum bazele de date vectoriale moderne și principiile ingineriei contextului transformă peisajul dezvoltării aplicațiilor AI, permițând echipelor să construiască sisteme care nu sunt doar funcționale, ci cu adevărat fiabile și ușor de întreținut la scară.

Ce este Ingineria Contextului și De Ce Contează

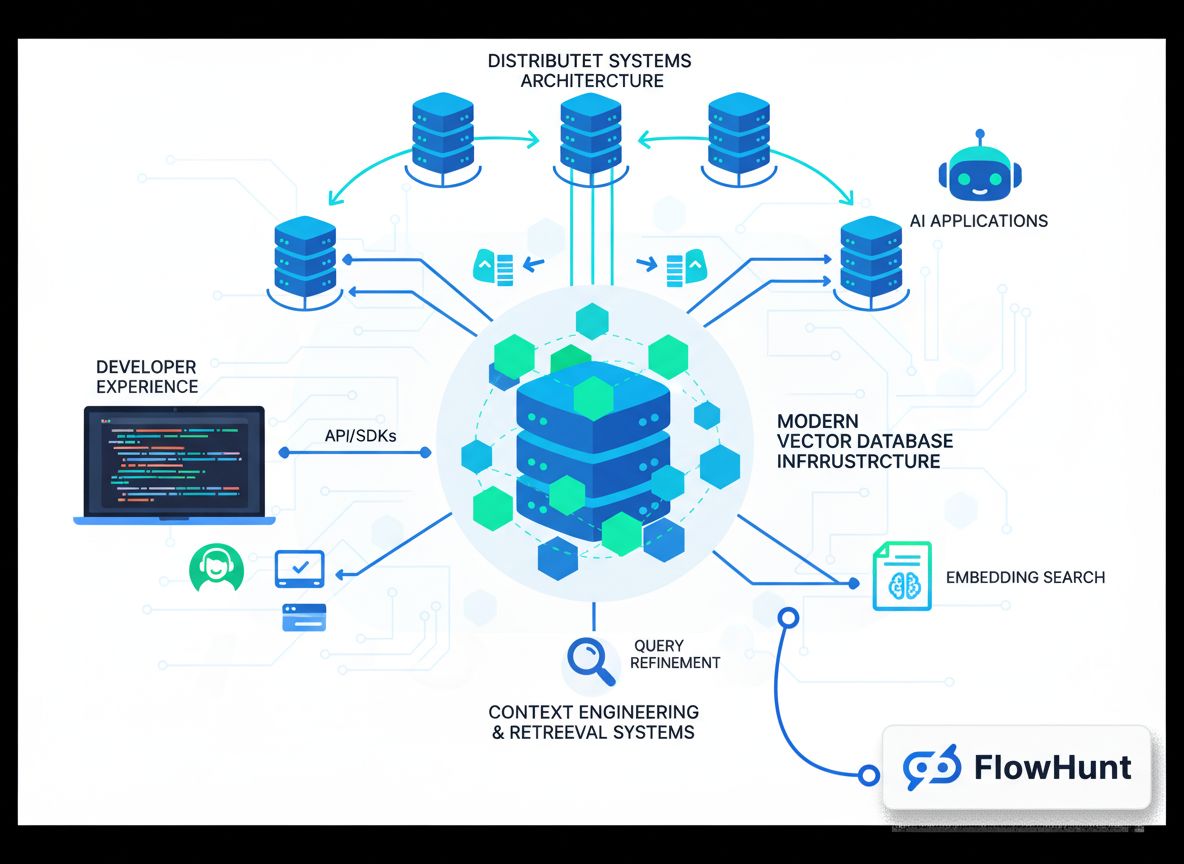

Ingineria contextului a apărut ca una dintre cele mai critice discipline în dezvoltarea AI modernă, însă rămâne puțin înțeleasă de mulți dezvoltatori care pășesc în acest domeniu. În esență, ingineria contextului este practica gestionării, organizării și optimizării sistematice a informațiilor contextuale pe care sistemele AI le folosesc pentru a lua decizii și a genera rezultate. Spre deosebire de Retrieval-Augmented Generation (RAG) tradițional, care se concentrează strict pe regăsirea documentelor relevante pentru completarea unui prompt înainte de a-l trimite la un model de limbaj, ingineria contextului are o perspectivă mult mai largă asupra întregului flux. Aceasta include modul în care datele circulă prin sistem, cum este stocată și indexată informația, cum are loc regăsirea, cum sunt clasate și filtrate rezultatele și, în final, cum este prezentat contextul către model. Această perspectivă holistică recunoaște că calitatea rezultatului unui sistem AI este fundamental limitată de calitatea și relevanța contextului pe care îl primește. Când contextul este gestionat slab — când sunt regăsite informații irelevante, când detalii importante sunt omise, sau când aceeași informație este procesată de mai multe ori — întregul sistem are de suferit. Ingineria contextului abordează aceste provocări tratând managementul contextului ca pe o preocupare inginerească de prim rang, demnă de același nivel de rigoare și atenție acordate altor componente critice de infrastructură.

Importanța ingineriei contextului devine imediat evidentă atunci când iei în considerare scala la care operează sistemele AI moderne. Un model de limbaj poate fi solicitat să proceseze sute de mii de documente, să sintetizeze informații din surse multiple și să genereze răspunsuri coerente bazate pe această sinteză. Fără o inginerie adecvată a contextului, acest proces devine haotic. Documentele irelevante aglomerează fereastra de context, informațiile importante se pierd în zgomot, iar performanța modelului scade. Mai mult, pe măsură ce sistemele AI devin tot mai sofisticate și sunt implementate în aplicații critice — de la servicii pentru clienți la diagnostic medical sau analiză financiară — riscurile unei inginerii contextuale deficitare cresc dramatic. Un sistem care returnează ocazional informații irelevante poate fi acceptabil în scopuri de divertisment, însă devine inacceptabil când ia decizii care afectează viețile sau bunăstarea oamenilor. Ingineria contextului asigură că informațiile care circulă prin sistem nu sunt doar abundente, ci cu adevărat relevante, bine organizate și optimizate pentru sarcina specifică.

Pregătit să îți dezvolți afacerea?

Începe perioada de probă gratuită astăzi și vezi rezultate în câteva zile.

Evoluția de la Demo la Producție: Problema Alchimiei

Una dintre cele mai persistente provocări în dezvoltarea AI a fost ceea ce veteranii din industrie numesc „prăpastia între demo și producție”. Construirea unui prototip funcțional care demonstrează capabilitățile AI este relativ simplă. Un dezvoltator poate asambla rapid un model de limbaj, îl poate conecta la un sistem de regăsire simplu și poate crea ceva ce impresionează într-un mediu controlat. Totuși, în momentul în care acel sistem trebuie să gestioneze date reale la scară, să își mențină fiabilitatea în timp și să se adapteze la cerințe în schimbare, totul devine dramatic mai dificil. Această prăpastie a fost, istoric, traversată prin ceea ce nu poate fi numit decât alchimie — o combinație misterioasă de ajustări de configurații, modificări de parametri și încercări empirice care, cumva, duc la un sistem funcțional. Problema acestei abordări este că nu este reproductibilă, nu se scalează și nu este ușor de întreținut. Atunci când ceva se strică în producție, adesea nu este clar de ce și remedierea necesită același proces misterios de la început.

Cauza principală a acestei probleme a alchimiei constă în faptul că majoritatea infrastructurilor AI nu au fost proiectate cu gândul la sisteme de producție. Primele baze de date vectoriale și sisteme de regăsire au fost construite în principal pentru a demonstra fezabilitatea căutării semantice și a regăsirii pe bază de embedding-uri. Acestea funcționau bine în medii controlate cu seturi mici de date și tipare de interogare previzibile. Dar când aceste sisteme sunt scalate pentru a gestiona milioane de documente, mii de utilizatori concurenți și tipare de interogare imprevizibile, adesea cedează. Consistența datelor devine o problemă. Performanța interogărilor scade. Sistemul devine greu de depanat și monitorizat. Dezvoltatorii ajung să nu mai construiască un sistem — ci să gestioneze un artefact complex, fragil, care funcționează din noroc și intervenție constantă. Aici intervin ingineria contextului modernă și infrastructura dedicată. Tratând tranziția de la demo la producție ca pe o provocare inginerească legitimă și construind sisteme special proiectate pentru sarcini de producție, putem transforma această alchimie misterioasă într-o practică inginerească autentică.

Înțelegerea Infrastructurii Moderne de Căutare pentru AI

Infrastructura de căutare tradițională, cea care alimentează Google și alte motoare de căutare, a fost proiectată cu anumite presupuneri despre modul în care va fi folosită. Aceste sisteme au fost construite pentru a gestiona interogări pe bază de cuvinte cheie de la utilizatori umani care urmau să analizeze rezultatele și să decidă asupra linkurilor pe care să le acceseze. Infrastructura a fost optimizată pentru acest caz de utilizare: potrivire rapidă de cuvinte cheie, algoritmi de clasificare concepuți pentru judecăți umane de relevanță și prezentarea rezultatelor sub forma „zece linkuri albastre” pe care oamenii le pot scana ușor. Însă sistemele AI au cerințe fundamental diferite. Când un model de limbaj consumă rezultate de căutare, nu analizează zece linkuri — poate procesa cu ordine de mărime mai multă informație. Modelul nu are nevoie de rezultate formatate pentru consum uman; îi trebuie date structurate pe care să le poată procesa logic. Interogările nu sunt bazate pe cuvinte cheie, ci sunt semantice, bazate pe embedding-uri și similaritate vectorială. Aceste diferențe fundamentale fac ca infrastructura de căutare tradițională să fie nepotrivită pentru aplicațiile AI.

Infrastructura modernă de căutare pentru AI abordează aceste diferențe în mai multe moduri cheie. În primul rând, uneltele și tehnologiile utilizate sunt fundamental diferite. În loc de indici pe cuvinte cheie și algoritmi de clasificare optimizați pentru relevanță umană, sistemele moderne folosesc embedding-uri vectoriale și măsuri de similaritate semantică. În loc să se bazeze pe cuvinte cheie explicite, ele înțeleg sensul și intenția din spatele interogărilor. În al doilea rând, modelele de lucru sunt diferite. Sistemele de căutare tradiționale gestionează interogări relativ simple care returnează un număr mic de rezultate. Sistemele AI au adesea nevoie să regăsească un număr mare de documente și să le proceseze în moduri sofisticate. În al treilea rând, dezvoltatorii care folosesc aceste sisteme au nevoi diferite. Dezvoltatorii AI au nevoie de sisteme ușor de integrat în aplicațiile lor, care să ofere o experiență bună a dezvoltatorului și care să nu necesite expertiză profundă în infrastructura de căutare. În fine, și poate cel mai important, consumatorii rezultatelor căutării sunt diferiți. În căutarea tradițională, oamenii fac munca finală — decid ce rezultate sunt relevante, deschid noi tab-uri, sintetizează informația. În sistemele AI, modelul de limbaj face această muncă și poate procesa mult mai multă informație decât oamenii. Această schimbare fundamentală a modului în care sunt consumate rezultatele de căutare schimbă totul despre modul în care infrastructura ar trebui proiectată.

Abonează-te la newsletter-ul nostru

Primește cele mai recente sfaturi, tendințe și oferte gratuit.

FlowHunt și Viitorul Automatizării Fluxurilor AI

Pe măsură ce organizațiile recunosc tot mai mult importanța ingineriei contextului și a infrastructurii moderne de căutare, provocarea devine integrarea acestor capabilități în fluxurile și procesele lor de dezvoltare existente. Aici intervin platforme precum FlowHunt, oferind un mediu unificat pentru construirea, testarea și implementarea aplicațiilor AI care se bazează pe managementul sofisticat al contextului și sisteme de regăsire. FlowHunt recunoaște că ingineria contextului nu înseamnă doar a avea baza de date potrivită — ci a avea uneltele și fluxurile potrivite pentru a gestiona contextul de-a lungul întregului ciclu de dezvoltare AI. De la ingestia și indexarea inițială a datelor, prin regăsire și clasificare, până la inferența finală a modelului și generarea rezultatelor, fiecare pas din acest flux trebuie orchestrat și monitorizat atent. FlowHunt oferă capabilități de automatizare care fac această orchestrare fără efort, permițând dezvoltatorilor să se concentreze pe construirea de aplicații AI excelente, nu pe detaliile infrastructurii.

Abordarea platformei privind automatizarea ingineriei contextului este deosebit de valoroasă pentru echipele care construiesc mai multe aplicații AI sau care trebuie să gestioneze fluxuri complexe de regăsire în mai multe etape. În loc să construiască infrastructură personalizată pentru fiecare aplicație, echipele pot folosi componentele și fluxurile pre-construite ale FlowHunt pentru a accelera dezvoltarea. Platforma se ocupă de sarcinile plictisitoare de ingestie a datelor, generarea embedding-urilor, administrarea indicilor și orchestrarea regăsirii, eliberând dezvoltatorii să se concentreze pe aspectele unice ale aplicațiilor lor. Mai mult, FlowHunt oferă vizibilitate și capabilități de monitorizare care fac ușor de înțeles cum circulă contextul prin sistem, să identifice blocajele și să optimizeze performanța. Această combinație de automatizare și vizibilitate transformă ingineria contextului dintr-un proces misterios, de tip încercare-și-eroare, într-o disciplină sistematică și măsurabilă.

Arhitectura Bazelor de Date Vectoriale Gata de Producție

Construirea unei baze de date vectoriale care funcționează într-un demo este una, construirea uneia care să deservească fiabil sarcini de producție este cu totul altceva. Bazele de date vectoriale pregătite pentru producție trebuie să gestioneze utilizatori concurenți multipli, să mențină consistența datelor, să ofere persistență fiabilă și să scaleze grațios pe măsură ce volumul de date crește. Trebuie să poată fi depanate când apar probleme, monitorizate pentru a înțelege comportamentul sistemului și ușor de întreținut pentru ca echipele să poată evolua sistemul în timp. Aceste cerințe au condus la dezvoltarea unor arhitecturi moderne pentru bazele de date vectoriale care încorporează principii din sistemele distribuite dovedite în decenii de utilizare reală.

Unul dintre cele mai importante principii arhitecturale în bazele de date vectoriale moderne este separarea stocării de procesare. În bazele de date monolitice tradiționale, stocarea și procesarea sunt strâns legate — același server care stochează datele procesează și interogările. Această legătură creează probleme la scală. Dacă ai nevoie de mai multă putere de procesare a interogărilor, trebuie să adaugi și mai multă stocare. Dacă ai nevoie de mai multă capacitate de stocare, trebuie să adaugi și procesare. Această ineficiență duce la risipă de resurse și costuri mai mari. Prin separarea stocării de procesare, bazele de date vectoriale moderne permit scalarea independentă a fiecăreia. Stocarea poate fi gestionată prin soluții eficiente de stocare pe obiecte precum Amazon S3, iar resursele de procesare pot fi scalate în funcție de cerințele interogărilor. Această arhitectură oferă flexibilitate și eficiență de cost remarcabile. Un alt principiu critic este multi-tenancy, care permite unei singure instanțe de bază de date să deservească în siguranță aplicații sau echipe independente multiple. Multi-tenancy necesită izolare atentă pentru a asigura că datele și interogările unui chiriaș nu interferează cu ale altuia, dar atunci când este implementat corect îmbunătățește dramatic utilizarea resurselor și reduce complexitatea operațională.

Bazele de date vectoriale moderne încorporează, de asemenea, principii din sistemele distribuite care au devenit standard în ultimul deceniu. Acestea includ separarea operațiunilor de citire și scriere (read-write separation), unde citirile și scrierile sunt gestionate de componente diferite optimizate pentru sarcinile lor; replicare asincronă, care asigură durabilitatea datelor fără a sacrifica performanța la scriere; și mecanisme de consens distribuit care mențin consistența între noduri multiple. Aceste principii, combinate cu limbaje moderne de programare precum Rust care oferă atât performanță cât și siguranță, permit bazelor de date vectoriale să atingă fiabilitatea și performanța cerute de sistemele de producție. Rezultatul este o infrastructură care nu mai pare alchimie — ci inginerie autentică.

Abordarea Chroma privind Experiența Dezvoltatorului

Când a fost fondată Chroma, echipa avea o teză clară: diferența dintre construirea unui demo AI funcțional și implementarea unui sistem de producție părea mai mult alchimie decât inginerie și această prăpastie trebuia eliminată. Abordarea echipei a fost să înceapă cu un accent obsesiv pe experiența dezvoltatorului. În loc să construiască cel mai complex sau scalabil sistem posibil, s-au concentrat pe a face cât mai ușor pentru dezvoltatori să înceapă să folosească baze de date vectoriale și căutare semantică. Aceasta a condus la una dintre cele mai distinctive funcționalități ale Chroma: abilitatea de a o instala cu o singură comandă pip și de a o folosi imediat, fără configurații complexe sau setup de infrastructură. Această simplitate a fost revoluționară în spațiul bazelor de date vectoriale. Majoritatea bazelor de date necesită configurări și setup semnificative înainte de a putea rula o interogare de bază. Chroma a eliminat această fricțiune, făcând posibil ca dezvoltatorii să experimenteze cu baze de date vectoriale și căutare semantică în câteva minute, nu ore sau zile.

Angajamentul față de experiența dezvoltatorului a mers dincolo de setup-ul inițial. Echipa Chroma a investit masiv pentru a se asigura că sistemul funcționează fiabil pe diferite arhitecturi și medii de implementare. În primele zile, utilizatorii raportau că rulează Chroma pe orice, de la servere Linux standard la Arduino sau arhitecturi Power PC. În loc să respingă aceste cazuri ca fiind marginale, echipa Chroma a făcut eforturi suplimentare pentru a se asigura că sistemul funcționează fiabil peste tot. Acest angajament față de compatibilitate universală și fiabilitate a construit încredere în comunitatea dezvoltatorilor și a contribuit la adoptarea rapidă a Chroma. Echipa a recunoscut că experiența dezvoltatorului nu înseamnă doar ușurința de utilizare — ci fiabilitate, consistență și încrederea că sistemul va funcționa așa cum te aștepți, în orice mediu și caz de utilizare.

Pe măsură ce Chroma a evoluat și echipa a început să construiască Chroma Cloud, au avut de luat o decizie critică. Ar fi putut lansa rapid o versiune găzduită a produsului single-node, ajungând rapid pe piață și profitând de cererea pentru servicii gestionate de baze de date vectoriale. Multe companii din domeniu au făcut această alegere, ceea ce le-a permis să atragă capital și să aibă vizibilitate mare pe piață. Însă echipa Chroma a decis altceva. Au recunoscut că găzduirea simplă a produsului single-node ca serviciu nu ar fi satisfăcut standardul lor pentru experiența dezvoltatorului. Un produs cloud cu adevărat grozav trebuia proiectat de la zero cu principii cloud-native, să ofere aceeași ușurință și fiabilitate ca produsul single-node, dar cu caracteristicile de scalare și fiabilitate cerute de sistemele de producție. Această decizie a însemnat să aloce mai mult timp pentru dezvoltarea Chroma Cloud, dar a rezultat într-un produs care chiar livrează promisiunea de a transforma ingineria contextului din alchimie în inginerie autentică.

Cele Patru Dimensiuni ale „AI” în Infrastructura Modernă de Căutare

Când discutăm despre infrastructura modernă de căutare pentru AI, este important să recunoaștem că „AI” înseamnă lucruri diferite în contexte diferite. De fapt, există patru dimensiuni distincte pe care infrastructura modernă de căutare diferă de sistemele tradiționale, iar înțelegerea acestor dimensiuni este esențială pentru construirea de aplicații AI eficiente. Prima dimensiune este cea tehnologică. Uneltele și tehnologiile folosite în infrastructura modernă de căutare sunt fundamental diferite față de cele din sistemele de căutare tradiționale. În loc de indici inverși și potrivire de cuvinte cheie, sistemele moderne folosesc embedding-uri vectoriale și similaritate semantică. În loc de algoritmi de clasificare TF-IDF, folosesc rețele neuronale și funcții de clasificare învățate. Aceste diferențe tehnologice reflectă natura diferită a problemelor abordate și capabilitățile diferite ale sistemelor AI moderne.

A doua dimensiune este modelul de lucru. Sistemele tradiționale de căutare au fost proiectate pentru a gestiona interogări simple, fără stare, care returnează un număr mic de rezultate. Sistemele AI moderne trebuie adesea să gestioneze fluxuri complexe de regăsire în mai multe etape, cu mai multe runde de clasificare, filtrare și reclasificare. Pot fi nevoite să regăsească mii de documente și să le proceseze sofisticat. Modelele de lucru sunt fundamental diferite, deci infrastructura trebuie proiectată diferit pentru a le gestiona eficient. A treia dimensiune este dezvoltatorul. Sistemele tradiționale de căutare erau construite și întreținute de ingineri specializați cu expertiză în regăsirea informațiilor și infrastructură de căutare. Dezvoltatorii AI moderni, în schimb, sunt adesea generalisti, care poate nu au expertiză profundă în infrastructura de căutare dar au nevoie de aplicații cu capabilități sofisticate de regăsire. Astfel, infrastructura modernă trebuie să fie ușor de folosit și accesibilă, nu doar puternică și flexibilă.

A patra, și poate cea mai importantă dimensiune, este consumatorul rezultatelor de căutare. În sistemele tradiționale, oamenii sunt consumatorii rezultatelor. Ei pot digera un număr limitat de rezultate — de obicei în jur de zece linkuri — și fac munca finală de a determina relevanța și de a sintetiza informația. În sistemele AI moderne, modelele de limbaj sunt consumatorii rezultatelor și pot procesa cu ordine de mărime mai multă informație. Un model de limbaj poate digera fără probleme sute sau mii de documente și sintetiza informații din toate. Această diferență fundamentală a consumatorului de rezultate schimbă totul despre modul în care ar trebui proiectată infrastructura. Înseamnă că algoritmii de clasificare pot fi optimizați pentru consum de către mașini, nu de către oameni. Prezentarea rezultatelor poate fi optimizată pentru procesare automată, nu pentru lizibilitate umană. Întregul flux poate fi proiectat presupunând că un sistem AI sofisticat va face munca finală.

Construirea și Menținerea Viziunii într-o Piață Zgomotoasă

Piața bazelor de date vectoriale în 2023 a fost una dintre cele mai fierbinți categorii din infrastructura AI. Companiile atrăgeau sume uriașe de capital, făceau valuri pe piață și concurau pentru a construi cele mai bogate în funcționalități sisteme. În acest mediu, ar fi fost ușor pentru Chroma să-și piardă concentrarea, să urmărească fiecare trend, să încerce să fie totul pentru toți. Totuși, echipa a ales deliberat să rămână concentrată pe viziunea lor de bază: construirea unui motor de regăsire pentru aplicații AI care oferă o experiență excepțională dezvoltatorilor și chiar acoperă prăpastia dintre demo și producție. Această concentrare a cerut disciplină și convingere, mai ales când alte companii din domeniu atrăgeau finanțări mai mari și aveau lansări mai spectaculoase.

Cheia menținerii acestei concentrări a fost asumarea unei teze clare, contrariante, despre ce contează cu adevărat. Echipa Chroma a crezut că nu numărul de funcționalități sau suma capitalului atras contează, ci calitatea experienței dezvoltatorului și fiabilitatea sistemului. Au crezut că făcând un singur lucru — construirea unui motor de regăsire grozav — la un nivel de clasă mondială, vor câștiga dreptul de a face mai multe lucruri ulterior. Această filozofie a concentrării maniacale pe o singură competență de bază nu este unică pentru Chroma, dar devine tot mai rară în lumea startup-urilor finanțate de venture capital, unde presiunea pentru creștere rapidă și atragere masivă de capital duce adesea companiile să se întindă prea mult. Angajamentul echipei Chroma față de această filozofie, chiar dacă a însemnat să lanseze Chroma Cloud mai târziu și să rateze oportunități de piață pe termen scurt, s-a dovedit în final alegerea corectă.

Menținerea viziunii presupune și atenție la angajări și construirea echipei. Oamenii pe care îi angajezi modelează cultura organizației, iar cultura determină ce și cum construiești. Echipa Chroma a recunoscut asta și a ales deliberat să angajeze lent și să fie foarte selectivă. În loc să crească cât mai rapid, s-au concentrat pe a aduce oameni aliniați la viziune, pasionați de calitate și capabili să execute independent la nivel înalt. Această abordare a dus la o creștere mai lentă, însă a asigurat că fiecare membru era dedicat misiunii și capabil să contribuie semnificativ. Acest tip de aliniere culturală este greu de obținut în startup-uri cu creștere rapidă, dar este esențială pentru menținerea concentrării și viziunii pe termen lung.

Importanța Măiestriei și Calității în Infrastructură

Unul dintre cele mai pregnante aspecte ale abordării echipei Chroma este accentul pus pe măiestrie și calitate. În infrastructură, e ușor să cazi în capcana de a crede că mai multe funcționalități, performanță sau scalare înseamnă automat mai bine. Însă echipa Chroma a recunoscut că ceea ce contează cu adevărat este să construiești sisteme care funcționează fiabil, sunt ușor de folosit și rezolvă cu adevărat problemele dezvoltatorilor. Acest accent pe măiestrie și calitate se reflectă în multe feluri. Se vede în decizia de a scrie Chroma în Rust, un limbaj care oferă atât performanță cât și siguranță, nu într-un limbaj mai comod dar mai puțin fiabil. Se vede în angajamentul de a face sistemul să funcționeze pe diferite arhitecturi și medii, chiar și când acestea sunt neobișnuite sau exotice. Se vede în decizia de a investi mai mult timp pentru a construi corect Chroma Cloud, în loc să grăbească un produs slab pe piață.

Acest accent pe măiestrie și calitate se extinde și la modul în care echipa gândește problema. În loc să considere ingineria contextului ca pe o problemă tehnică îngustă ce trebuie rezolvată cu algoritmi ingenioși, echipa o vede ca pe o provocare largă ce ține de experiența dezvoltatorului, fiabilitate, scalabilitate și mentenanță. Această perspectivă holistică duce la soluții mai bune, pentru că recunoaște că un sistem este la fel de bun ca cea mai slabă verigă a sa. Un sistem poate avea cei mai sofisticați algoritmi de regăsire din lume, dar dacă este greu de folosit sau nesigur în producție, nu rezolvă de fapt problema. Punând accent pe măiestrie și calitate pe toate dimensiunile sistemului, Chroma a construit ceva ce chiar funcționează pentru dezvoltatori și acoperă cu adevărat prăpastia dintre demo și producție.

Implicații Practice pentru Echipele de Dezvoltare AI

Pentru echipele care construiesc aplicații AI, lecțiile din abordarea Chroma au mai multe implicații practice. În primul rând, este important să recunoști că ingineria contextului nu este un „side quest” în dezvoltarea AI — este parte din misiunea principală. Calitatea sistemului AI este limitată fundamental de calitatea contextului primit, deci investiția în infrastructură adecvată de inginerie a contextului nu este opțională. Este esențială. În al doilea rând, merită să fii sceptic față de sistemele care promit să facă totul. Cele mai fiabile și eficiente sisteme sunt adesea cele care fac un singur lucru foarte bine, apoi construiesc de acolo. Dacă evaluezi baze de date vectoriale sau sisteme de regăsire, caută-le pe cele cu focus clar și angajament față de excelență la acel unic lucru. În al treilea rând, experiența dezvoltatorului contează. Un sistem teoretic mai puternic dar greu de folosit va fi în final mai puțin valoros decât unul ușor de folosit, chiar dacă are funcționalități ușor mai reduse. Asta pentru că dezvoltatorii vor folosi efectiv sistemul ușor și vor construi lucruri grozave cu el, în timp ce cu cel dificil se vor lupta sau vor renunța.

În al patrulea rând, fiabilitatea și consistența contează mai mult decât crezi. În fazele incipiente ale dezvoltării AI, e tentant să prioritizezi funcționalități și performanță în detrimentul fiabilității. Dar pe măsură ce sistemele ajung în producție și gestionează sarcini reale, fiabilitatea devine esențială. Un sistem cu 95% fiabilitate poate părea acceptabil, dar dacă rulezi milioane de interogări pe zi, acel 5% rată de eșec înseamnă sute de mii de interogări eșuate. Investiția în fiabilitate de la început este mult mai ieftină decât să o adaugi ulterior. În fine, este important să gândești pe termen lung. Infrastructura pe care o alegi azi va determina ce poți construi mâine. Alegerea infrastructurii proiectate pentru producție de la început, care scalează grațios și oferă vizibilitate și monitorizare, va aduce beneficii pe măsură ce sistemele tale cresc și evoluează.

{{ cta-dark-panel