Introducere

Peisajul dezvoltării modelelor de limbaj a suferit o schimbare fundamentală în ultimii ani. În timp ce marile companii tehnologice continuă să împingă limitele dimensiunii modelelor, comunitatea open-source a descoperit că performanța excepțională nu necesită modele cu un trilion de parametri. Acest ghid cuprinzător explorează tehnicile și strategiile de ultimă oră folosite de cercetătorii HuggingFace pentru a construi modele de limbaj eficiente și performante prin metodologii riguroase de preinstrucție. Vom analiza cum SmolLM 3, FineWeb și FinePDF reprezintă o nouă paradigmă în dezvoltarea modelelor—una axată pe maximizarea performanței în limite computaționale practice, menținând în același timp rigoarea științifică și reproductibilitatea. Informațiile prezentate aici reflectă luni de cercetare și experimentare, oferind un masterclass despre abordarea corectă a preinstrucției modelelor în era modernă.

Înțelegerea Preinstrucției Modelelor de Limbaj în Epoca Modernă

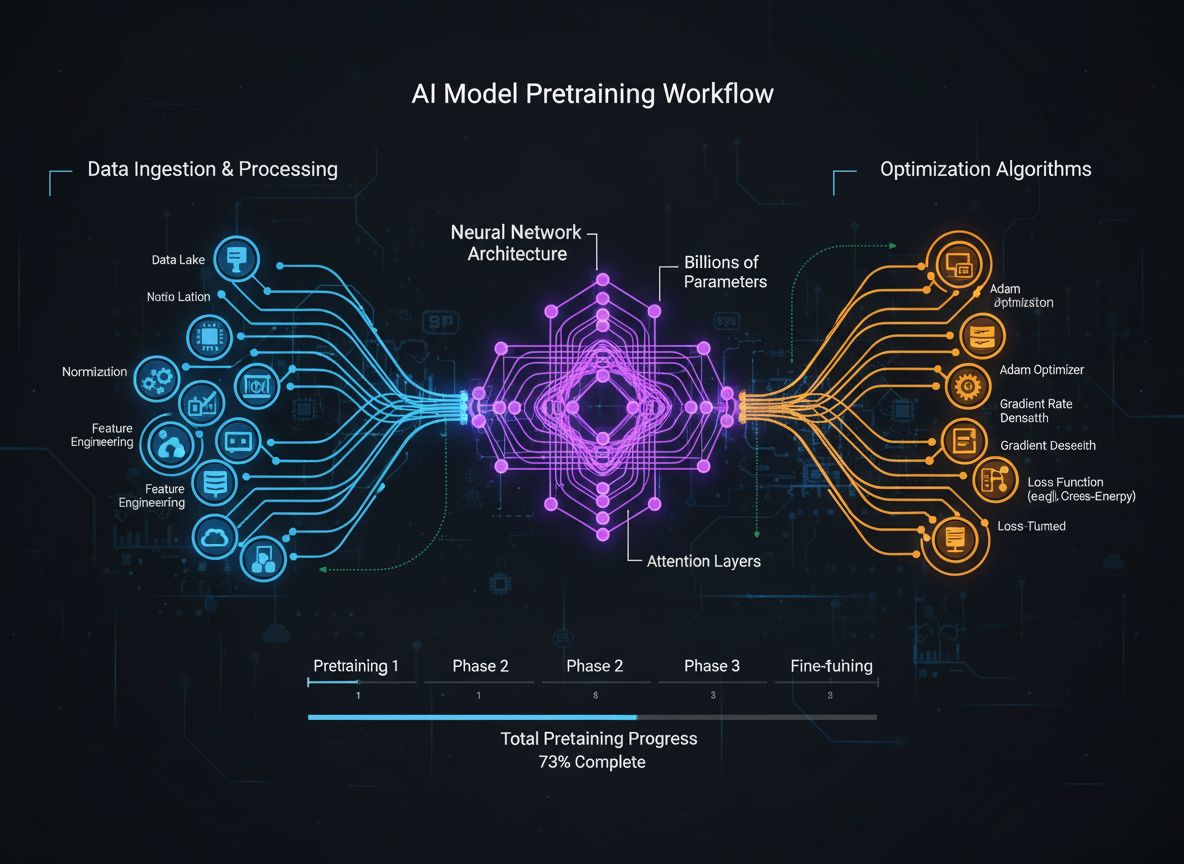

Preinstrucția modelelor de limbaj a evoluat de la un proces relativ simplu de alimentare cu date brute text către rețele neuronale, la o disciplină sofisticată ce implică obiective multiple și interconectate de optimizare. În esență, preinstrucția presupune expunerea unui model la cantități uriașe de date text, permițându-i să învețe tipare statistice despre limbaj prin învățare auto-supervizată. Totuși, abordarea modernă recunoaște că simpla scalare a datelor și puterii de calcul nu este suficientă. În schimb, cercetătorii trebuie să orchestreze cu grijă multiple dimensiuni ale procesului de antrenare—de la selecția și curatarea datelor, la alegerile arhitecturale și algoritmii de optimizare. Domeniul a ajuns la maturitatea la care înțelegerea acestor nuanțe separă modelele de ultimă generație de cele mediocre. Această evoluție reflectă o înțelegere mai profundă că performanța modelului nu este determinată de un singur factor, ci de orchestrarea atentă a mai multor obiective oarecum ortogonale, care pot fi optimizate în paralel. Comunitatea de cercetare recunoaște din ce în ce mai mult că “ingredientul secret” al dezvoltării de succes a modelelor nu stă în scalare brută, ci în alegeri inteligente la fiecare nivel al fluxului de antrenament.

Pregătit să îți dezvolți afacerea?

Începe perioada de probă gratuită astăzi și vezi rezultate în câteva zile.

De ce Calitatea Datelor Este Mai Importantă Decât Cantitatea în Dezvoltarea Modelelor

Unul dintre cele mai importante învățăminte din cercetările recente este că calitatea și diversitatea datelor de antrenament determină fundamental performanța modelului, mai mult decât simpla cantitate. Acest principiu, adesea rezumat prin expresia “gunoi intrat, gunoi ieșit”, este tot mai validat prin cercetare empirică și experiență practică. Când modelele sunt antrenate pe date slab curățate, duplicate sau de calitate scăzută, ele învață tipare false și nu se generalizează eficient la sarcini noi. În schimb, seturile de date atent selectate, deduplicate și filtrate permit modelelor să învețe mai eficient și să atingă performanțe mai bune cu mai puține iterații de antrenament. Implicațiile acestei perspective sunt profunde: înseamnă că organizațiile și cercetătorii ar trebui să investească masiv în curățarea și asigurarea calității datelor, nu doar în acumularea de date brute. Această schimbare de perspectivă a dus la apariția unor echipe și instrumente specializate dedicate exclusiv creării și rafinării seturilor de date. Setul de date FineWeb, care conține peste 18,5 trilioane de tokeni de date web englezești curate și deduplicate, exemplifică această abordare. În loc să folosească date brute CommonCrawl, echipa FineWeb a implementat tehnici sofisticate de filtrare, deduplicare și evaluare a calității pentru a crea un set de date care depășește constant alternativele mai mari, dar neprocesate. Acest lucru reprezintă o realizare fundamentală în domeniu: drumul către modele mai bune trece prin date mai bune, nu neapărat prin mai multe date.

Cei Cinci Piloni ai Optimizării Antrenării Modelelor

Preinstrucția modernă a modelelor poate fi înțeleasă prin prisma a cinci obiective interconectate, dar oarecum ortogonale, pe care cercetătorii trebuie să le optimizeze simultan. Înțelegerea acestor piloni oferă un cadru pentru a gândi întregul proces de antrenare și pentru a identifica unde pot fi aduse îmbunătățiri. Primul pilon implică maximizarea relevanței și calității informațiilor brute din datele de antrenament. Acest lucru include atât calitatea punctelor individuale de date, cât și diversitatea setului ca întreg. Un model antrenat pe date de calitate și diversitate ridicată va învăța tipare mai generalizabile decât unul antrenat pe date înguste sau de calitate scăzută, indiferent de alte optimizări. Al doilea pilon se concentrează pe designul arhitecturii modelului, care determină cât de eficient poate procesa modelul informația și ce constrângeri computaționale are. Alegerile arhitecturale influențează viteza de inferență, consumul de memorie, cerințele pentru cache-ul KV și abilitatea modelului de a rula pe anumite configurații hardware. Al treilea pilon implică maximizarea informației extrase din date la fiecare pas de antrenament. Acesta include tehnici precum distilarea de cunoștințe, unde modelele mici învață de la cele mari, și predicția multi-token, unde modelele prezic mai mulți tokeni viitori simultan. Al patrulea pilon se referă la calitatea gradientului și dinamica optimizării, incluzând alegerea optimizatorului, programul ratei de învățare și tehnici pentru menținerea stabilității în antrenament. Al cincilea pilon implică tuningul hiperparametrilor și strategiile de scalare care asigură menținerea stabilității odată cu creșterea modelelor și previn probleme precum explozia gradientului sau divergența activărilor. Acești cinci piloni nu sunt independenți—interacționează complex—dar abordarea lor separată ajută cercetătorii să identifice ce zone necesită atenție și unde pot fi aduse cele mai semnificative îmbunătățiri.

Abonează-te la newsletter-ul nostru

Primește cele mai recente sfaturi, tendințe și oferte gratuit.

FineWeb: Revoluționarea Curățării Datelor Web la Scară Mare

FineWeb reprezintă un moment de cotitură în crearea seturilor de date pentru preinstrucția modelelor de limbaj. În loc să accepte rezultatul brut al crawlerelor web precum CommonCrawl, echipa HuggingFace a implementat o linie completă de procesare pentru curățarea, filtrarea și deduplicarea datelor web la scară masivă. Setul de date rezultat conține peste 18,5 trilioane de tokeni de text englezesc de înaltă calitate, fiind unul dintre cele mai mari seturi curate disponibile comunității open-source. Crearea FineWeb a implicat mai multe etape de procesare, fiecare concepută pentru a elimina conținutul de calitate scăzută, păstrând informațiile valoroase. Echipa a implementat algoritmi sofisticați de deduplicare pentru a elimina conținutul redundant, filtre de calitate pentru a elimina spam-ul și paginile slabe, precum și detectarea limbii pentru a se asigura că setul conține preponderent text în engleză. Ce face FineWeb deosebit de valoros nu este doar dimensiunea sa, ci validarea empirică a faptului că produce performanțe mai bune ale modelelor decât alternativele mai mari și neprocesate. Atunci când este combinat cu alte seturi de date, FineWeb depășește constant seturi brute mult mai mari, demonstrând că într-adevăr calitatea bate cantitatea. Curbele de performanță arată că modelele antrenate pe FineWeb obțin rezultate mai bune pe benchmarkuri standard comparativ cu modele antrenate pe seturi de dimensiuni similare din alte surse. Acest succes a inspirat comunitatea de cercetare să investească mai mult în curățarea datelor, recunoscând că aici se pot obține câștiguri semnificative de performanță. Setul FineWeb este disponibil gratuit cercetătorilor, democratizând accesul la date de antrenament de calitate și permițând organizațiilor mici și echipelor academice să antreneze modele competitive.

FinePDF: Valorificarea Potențialului Datelor din PDF-uri

În timp ce FineWeb s-a concentrat pe date web, echipa HuggingFace a recunoscut că o altă sursă uriașă de text de calitate a fost în mare parte ignorată: documentele PDF. PDF-urile conțin cantități vaste de informații structurate, de calitate, incluzând articole academice, documentație tehnică, cărți și rapoarte profesionale. Totuși, extragerea textului din PDF-uri este o provocare tehnică, iar abordările anterioare nu au explorat sistematic această sursă la scară. FinePDF reprezintă primul efort cuprinzător de a extrage, curăța și curata date PDF pentru preinstrucția modelelor de limbaj. Echipa a implementat o linie sofisticată care abordează provocările unice ale procesării PDF-urilor, inclusiv gestionarea layout-urilor complexe, extragerea corectă a textului din documente multi-coloană și tratarea imaginilor și tabelelor încorporate. Un aspect inovator al liniei FinePDF este pasul de “refetch din internet”, care rezolvă o problemă critică: PDF-urile stocate în CommonCrawl sunt adesea slab extrase sau depășite. Prin refetch-ul PDF-urilor din sursele originale online, echipa asigură accesul la cele mai calitative versiuni ale documentelor. Rezultatele de performanță sunt impresionante—în combinație cu alte seturi de date, FinePDF demonstrează performanțe foarte solide comparativ cu baseline-uri recente precum NeoTron B2. Setul oferă o sursă nouă de date de antrenament calitative care completează datele web și permite modelelor să învețe din informații mai diverse și structurate. Această muncă deschide noi posibilități pentru crearea de seturi de date, sugerând că și alte surse de date insuficient explorate pot aduce beneficii similare. Linia FinePDF este documentată detaliat în postări pe blog și documentație tehnică, permițând altor cercetători să construiască peste această muncă și să aplice tehnici similare altor surse de date.

SmolLM 3: Inteligență Eficientă la Scară

SmolLM 3 reprezintă culminarea aplicării acestor tehnici de curățare a datelor și optimizare a antrenamentului pentru a crea un model de limbaj extrem de eficient. Cu 3 miliarde de parametri, SmolLM 3 este semnificativ mai mic decât multe modele contemporane, dar obține performanțe competitive prin optimizare atentă pe toți cei cinci piloni ai antrenării modelelor. Modelul suportă raționament dual-mode, capabilități multilingve în șase limbi și înțelegere pe context lung, ceea ce îl face remarcabil de versatil în ciuda dimensiunii modeste. Dezvoltarea SmolLM 3 a presupus alegeri arhitecturale atente menite să maximizeze eficiența. Echipa a selectat o arhitectură transformer care echilibrează eficiența computațională cu capacitatea de modelare, implementând tehnici precum grouped query attention pentru a reduce consumul de memorie și latența de inferență. Modelul a fost antrenat folosind o abordare de preinstrucție în trei etape care crește progresiv performanța pe diferite domenii, permițând optimizarea unor capabilități specifice la fiecare etapă. Ce face SmolLM 3 deosebit de important este faptul că demonstrează că și comunitatea open-source poate produce modele care rivalizează cu cele mai mari modele proprietare pe multe sarcini. Acest lucru pune sub semnul întrebării presupunerea că “mai mare” înseamnă întotdeauna “mai bun” și sugerează că domeniul a atins un platou în ceea ce privește beneficiile simplei scalări. În schimb, accentul se mută spre eficiență, interpretabilitate și capacități practice de implementare. SmolLM 3 poate rula pe hardware de consum, dispozitive edge și în medii cu resurse restrânse, făcând capabilitățile AI avansate accesibile unui public mult mai larg. Funcțiile multilingve și pe context lung demonstrează că eficiența nu presupune sacrificarea caracteristicilor esențiale.

Distilarea de Cunoștințe: Învățarea de la Modele Mai Mari

Distilarea de cunoștințe este o tehnică puternică ce permite modelelor mai mici să beneficieze de cunoștințele dobândite de modelele mai mari. În loc să antrenezi un model mic de la zero pe date brute, distilarea presupune antrenarea modelului mic pentru a imita ieșirile unui model mai mare și mai capabil. Această abordare este deosebit de valoroasă în preinstrucție pentru că permite modelului mic să învețe tipare deja descoperite de cel mare, accelerând învățarea și îmbunătățind performanța finală. Mecanica distilării implică antrenarea modelului “student” (cel mic) să potrivească distribuțiile de probabilitate produse de modelul “teacher” (cel mare). Acest lucru se face de obicei minimizând divergența dintre distribuțiile de ieșire ale studentului și profesorului, adesea folosind tehnici precum divergența KL. Parametrul de temperatură controlează cât de “netede” sunt distribuțiile—temperaturi mai mari le netezesc, oferind mai multă informație despre gradul de încredere relativă a predicțiilor. Distilarea s-a dovedit deosebit de eficientă în contextul preinstrucției modelelor de limbaj, deoarece permite transferul cunoștințelor învățate de modelele mari către unele mai mici și eficiente. Acest lucru este valoros mai ales pentru organizațiile care doresc să implementeze modele pe dispozitive edge sau în medii cu resurse limitate, dar vor totuși să beneficieze de capabilitățile modelelor mari. Tehnica a devenit tot mai sofisticată, cu cercetări recente explorând metode precum transferul de atenție (studentul învață și tiparele de atenție ale profesorului) și distilarea bazată pe feature (potrivirea reprezentărilor intermediare ale straturilor).

Predicția Multi-Token: Dincolo de Predicția Următorului Token

Antrenamentul tradițional al modelelor de limbaj se concentrează pe predicția următorului token—modelul învață să prezică următorul token ținând cont de toți tokenii anteriori. Totuși, cercetări recente au arătat că antrenarea modelelor să prezică simultan mai mulți tokeni viitori poate îmbunătăți semnificativ performanța, în special pe sarcini de programare și probleme complexe de raționament. Predicția multi-token forțează modelul să învețe dependențe pe termen mai lung și să dezvolte o înțelegere mai profundă a tiparelor din date. Abordarea presupune adăugarea mai multor capete de predicție la model, fiecare responsabil pentru a prezice un token la mai multe poziții în viitor. În timpul antrenamentului, modelul primește semnale de pierdere de la toate aceste capete simultan, fiind încurajat să învețe reprezentări utile pentru predicții pe mai mulți pași înainte. Este mai dificil decât predicția următorului token, dar duce la reprezentări mai bune. Beneficiile predicției multi-token depășesc îmbunătățirea obiectivului de antrenament. Modelele antrenate astfel performează mai bine la sarcini ulterioare, se generalizează mai bine la domenii noi și au abilități de raționament superioare. Tehnica este deosebit de eficientă pentru generarea de cod, unde înțelegerea dependențelor pe distanță lungă este esențială pentru generarea de cod sintactic și semantic corect. Cercetările arată că predicția multi-token poate îmbunătăți performanța cu 5-15% pe diferite benchmarkuri, fiind una dintre cele mai impactante tehnici de antrenament descoperite recent. Implementarea este relativ simplă, dar necesită tuning atent al numărului de capete de predicție și ponderarea pierderilor.

Inovație în Optimizatori: Dincolo de AdamW

Ani la rând, AdamW a fost alegerea implicită pentru antrenarea modelelor mari de limbaj. AdamW combină actualizările pe bază de moment cu regularizare prin weight decay, oferind antrenamente stabile și proprietăți bune de convergență. Totuși, studii recente arată că AdamW nu este optim pentru orice scenariu, în special la scalarea către modele foarte mari. Optimizatori noi precum Muon și King K2 explorează abordări alternative ce pot oferi dinamici de antrenament mai bune și performanță superioară. Ideea de bază este că matricea Hessian—care captează curbura funcției de pierdere—poate fi mai bine aproximată folosind tehnici precum Newton-Schulz. Menținând o aproximare mai bună a Hessianului, acești optimizatori pot furniza actualizări de gradient mai informative, ducând la convergență mai rapidă și performanță finală mai bună. Muon, de exemplu, folosește iterația Newton-Schulz pentru a ortogonaliza matricea gradientului, ceea ce răspândește învățarea pe mai multe dimensiuni decât abordările clasice pe bază de moment. Rezultatul este antrenament mai stabil și încurajează modelul să exploreze spații noi de parametri, nu doar traiectoria tradițională a AdamW. King K2 abordează problema diferit, urmărind cantități precum log-maximul pe cap și ajustând adaptiv ratele de învățare și clipping-ul gradientului. Implicațiile inovației în optimizatori sunt semnificative. Mulți practicieni folosesc AdamW cu hiperparametri optimizați pentru modele mult mai mici, chiar și când antrenează modele cu mult mai mulți parametri. Asta sugerează că s-ar putea obține câștiguri notabile doar prin actualizarea alegerilor de optimizator și a hiperparametrilor pentru modelele moderne mari. Comunitatea de cercetare recunoaște tot mai mult că alegerea optimizatorului nu e o problemă rezolvată, iar inovația continuă în acest domeniu poate aduce îmbunătățiri substanțiale în eficiența antrenamentului și performanța finală.

Calitatea Gradientului și Stabilitatea Antrenamentului

Menținerea calității gradientului pe parcursul antrenamentului este esențială pentru obținerea unor performanțe bune ale modelului. Pe măsură ce modelele ajung la miliarde sau trilioane de parametri, antrenamentul devine tot mai instabil, cu gradienti predispuși la explozie sau dispariție. Rezolvarea acestor probleme necesită atenție la calitatea gradientului și implementarea unor tehnici care să mențină stabilitatea pe tot parcursul antrenamentului. O abordare implică tehnici precum gradient clipping, care previne ca gradientul să devină prea mare și să destabilizeze antrenamentul. Totuși, clipping-ul naiv poate elimina informații valoroase. Abordările mai sofisticate normalizează gradientul astfel încât să păstreze informația, prevenind totodată instabilitatea. O altă considerație importantă este alegerea funcțiilor de activare și a tehnicilor de normalizare pe straturi. Fiecare funcție de activare are proprietăți diferite privind fluxul de gradient, iar selecția atentă poate impacta semnificativ stabilitatea. Layer normalization, care normalizează activările pe dimensiunea feature, a devenit standard la modelele transformer pentru că oferă proprietăți mai bune decât batch normalization. Programul ratei de învățare joacă, de asemenea, un rol crucial: o rată prea mare duce la explozie, una prea mică la convergență lentă sau blocare în minime locale. Antrenamentul modern folosește adesea programe cu warm-up (creștere treptată a ratei la început) urmate de fază de decay. Optimizarea acestor aspecte este crucială pentru succesul antrenării modelelor mari, domeniu unde se desfășoară și în prezent cercetări intense.

FlowHunt și Automatizarea Fluxurilor de Antrenare a Modelelor

Complexitatea preinstrucției moderne—cu multiple obiective de optimizare, linii sofisticate de date și tuning atent al hiperparametrilor—creează provocări majore pentru echipele care încearcă să implementeze aceste tehnici. FlowHunt abordează aceste provocări oferind o platformă pentru automatizarea și orchestrarea fluxurilor complexe de antrenare. În loc să gestioneze manual procesarea datelor, antrenarea și evaluarea modelelor, echipele pot folosi FlowHunt pentru a defini fluxuri care gestionează automat aceste sarcini, reducând erorile și îmbunătățind reproductibilitatea. Automatizarea FlowHunt este deosebit de valoroasă pentru pașii de curățare și procesare a datelor, critici pentru performanța modelelor. Platforma poate implementa automat linii sofisticate precum cele din FineWeb și FinePDF, incluzând deduplicare, filtrare de calitate și conversie de format. Astfel, echipele se pot concentra pe deciziile mari despre ce date să folosească și cum să le proceseze, nu pe detalii de implementare. De asemenea, FlowHunt ajută la gestionarea tuningului și experimentării cu hiperparametri, necesare pentru optimizarea antrenamentului. Automatizând rularea mai multor experimente cu hiperparametri diferiți și colectarea rezultatelor, FlowHunt permite explorarea mai eficientă a spațiului de parametri și identificarea rapidă a configurațiilor optime. Platforma oferă și instrumente de monitorizare a progresului, detectare automată a problemelor precum explozia gradientului sau divergență și ajustare automată a parametrilor pentru menținerea stabilității. Pentru organizațiile care își construiesc propriile modele sau ajustează modele existente, FlowHunt poate reduce semnificativ timpul și efortul necesar, îmbunătățind totodată calitatea rezultatelor.

Scalarea de la Modele Mici la Modele Mari

Unul dintre cele mai dificile aspecte ale antrenamentului este înțelegerea modului de a scala de la modele mici la modele mari fără a sacrifica stabilitatea sau performanța. Relația dintre dimensiunea modelului și hiperparametrii optimi nu este liniară—parametrii buni pentru modele mici necesită adesea ajustări pentru modelele mari. Acest lucru este valabil mai ales pentru rata de învățare, care de obicei trebuie redusă pe măsură ce modelele cresc. Înțelegerea legilor de scalare este crucială pentru a prezice performanța la diferite dimensiuni și a lua decizii privind alocarea resurselor. Cercetările arată că performanța modelelor urmează legi de scalare predictibile, unde aceasta crește ca o funcție de tip putere a dimensiunii modelului, dimensiunii setului de date și bugetului de calcul. Aceste legi permit estimarea îmbunătățirilor posibile la creșterea modelului sau a datelor, ajutând la decizii informate privind investițiile. Totuși, legile nu sunt universale—depind de arhitectura, procedura de antrenare și setul de date folosit. Asta înseamnă că echipele trebuie să facă propriile experimente de scalare pentru a înțelege cum răspunde setup-ul lor specific. Scalarea presupune și atenție la stabilitatea antrenamentului: modelele mari sunt mai predispuse la explozie de gradient sau divergență. Rezolvarea acestor probleme necesită tehnici precum clipping-ul gradientului, programare atentă a ratei de învățare și, uneori, ajustări la arhitectură sau optimizator. Comunitatea recunoaște tot mai mult că scalarea nu înseamnă doar modele mai mari, ci și gestionarea atentă a procesului de antrenare pentru a asigura eficiență.

Învățarea de caracteristici se referă la procesul prin care modelele extrag automat trăsături utile din datele brute în timpul antrenamentului. În contextul preinstrucției modelelor de limbaj, aceasta înseamnă învățarea de către model a conceptelor lingvistice, relațiilor semantice și tiparelor sintactice în reprezentările sale interne. Maximizarea învățării de caracteristici—adică asigurarea că modelul extrage cât mai multă informație utilă la fiecare pas—este unul din obiectivele cheie ale antrenamentului modern. O modalitate de a privi acest proces este să observi cât de mult se schimbă reprezentările modelului la fiecare update de gradient. Dacă modelul învață eficient, fiecare update trebuie să aducă schimbări semnificative care să-i îmbunătățească capacitatea de predicție. Dacă nu, actualizările pot produce doar schimbări minore sau irelevante pentru performanță. Tehnicile de îmbunătățire includ inițializarea atentă a greutăților, care poate accelera învățarea caracteristicilor utile la începutul antrenamentului. O altă tehnică este folosirea unor programe de rată de învățare care permit învățare rapidă la început (pentru caracteristici de bază), încetinind apoi pe măsură ce modelul rafinează tiparele subtile. Conceptul de învățare de caracteristici este apropiat de cel de “colaps de caracteristici”, când modelul ajunge să ignore anumite trăsături sau dimensiuni din input. Asta poate apărea când modelul găsește scurtături pentru performanță bună fără să învețe tot ce ar trebui. Tehnici precum regularizarea și designul atent al funcției de pierdere pot preveni colapsul și asigura învățarea de caracteristici diverse și utile.

{{ cta-dark-panel

heading=“Accelerează-ți Fluxul de Lucru cu FlowHunt”

description=“Experimentează cum FlowHunt automatizează fluxurile AI și SEO — de la cercetare și generare de conținut, la publicare și analize — totul într-un singur loc.”

ctaPrimaryText=“Programează un Demo”

ctaPrimaryURL=“https://calendly.com/liveagentsession/flowhunt-chatbot-demo"

ctaSecondaryText=“Încearcă FlowHunt Gratuit”

ctaSecondaryURL=“https://app.flowhunt.io/sign-in"

gradientStartColor="#123456”

gradientEndColor="#654321”

gradientId=“827591b1-ce8c-4110-b064-7cb85a0b1217”

}}

Îndepărtarea de la Scalare Pură: De ce Mai Mare Nu Înseamnă Întotdeauna Mai Bun

Ani la rând, narațiunea dominantă în cercetarea AI a fost că modelele mai mari sunt automat mai bune. A urmat astfel o cursă pentru construirea unor modele tot mai mari, companiile concurând pentru a anunța modele cu cât mai mulți parametri. Totuși, evoluțiile recente sugerează o schimbare a acestei perspective. Succesul SmolLM 3 și al altor modele eficiente demonstrează că performanță excepțională se poate obține și cu modele cu ordine de mărime mai mici decât cele mai mari existente. Această schimbare reflectă o înțelegere mai profundă: performanța depinde de mai mulți factori decât doar numărul de parametri. Un model cu 3 miliarde de parametri, antrenat pe date de calitate și cu tehnici sofisticate de optimizare, poate depăși un model mult mai mare antrenat pe date slabe sau cu optimizare superficială. Această realizare are implicații profunde pentru domeniu. Sugerează că cea mai valoroasă cercetare nu este neapărat în construirea de modele mai mari, ci în îmbunătățirea calității datelor, dezvoltarea tehnicilor de antrenament și crearea unor arhitecturi eficiente. De asemenea, democratizează dezvoltarea AI, făcând posibilă crearea de modele competitive și pentru organizații mici sau echipe academice, fără acces la resurse uriașe de calcul. Schimbarea de la scalarea pură are și implicații practice pentru implementare. Modelele mici pot rula pe dispozitive edge, în medii cu resurse reduse și cu latență și consum energetic scăzut. Astfel, capabilitățile AI avansate devin accesibile unui spectru mult mai larg de aplicații și utilizatori. Comunitatea de cercetare recunoaște tot mai mult că viitorul