Introducere

Peisajul inteligenței artificiale trece printr-o accelerare fără precedent, cu tehnologii revoluționare care apar simultan în mai multe domenii. De la ochelari AI purtabili care amplifică percepția umană la modele de raționament ce depășesc performanța umană în rezolvarea problemelor complexe, convergența acestor inovații remodelează fundamental modul în care interacționăm cu tehnologia și ne automatizăm fluxurile de lucru. Această analiză cuprinzătoare examinează cele mai semnificative evoluții AI din 2025, inclusiv ochelarii avansați Ray-Ban de la Meta, capabilitățile de raționament supranatural ale OpenAI, tehnologia revoluționară de generare a lumilor 3D și infrastructura emergentă care permite agenților autonomi să colaboreze și să tranzacționeze între ei. Înțelegerea acestor evoluții este esențială pentru companiile și indivizii care doresc să valorifice potențialul transformator al AI în operațiunile și planificarea lor strategică.

Înțelegerea Stadiului Actual al Hardware-ului și Purtabilelor AI

Evoluția inteligenței artificiale a fost, istoric, limitată de interfețele prin care oamenii interacționează cu sistemele inteligente. Timp de decenii, am folosit tastaturi, mouse-uri și ecrane pentru a comunica cu calculatoarele, creând o deconectare fundamentală între modurile noastre naturale de percepție și instrumentele digitale pe care le folosim. Apariția AI-ului purtabil reprezintă o schimbare de paradigmă în această relație, mutând computația din dispozitive staționare în forme care se integrează perfect în viața noastră de zi cu zi. Investiția Meta în ochelarii Ray-Ban exemplifică această tranziție, bazându-se pe decenii de cercetare în realitate augmentată și pe experiența vastă a companiei cu platforma Oculus. Semnificația acestei schimbări nu poate fi supraestimată—aproximativ o treime din populația globală poartă ochelari zilnic, reprezentând o piață uriașă pentru ochelari cu AI integrat. Prin încorporarea directă a capabilităților AI într-un dispozitiv deja purtat de oameni, Meta se poziționează la intersecția dintre computația personală și inteligența artificială, creând o platformă în care AI poate observa, înțelege și interacționa cu lumea în timp real alături de utilizator.

Pregătit să îți dezvolți afacerea?

Începe perioada de probă gratuită astăzi și vezi rezultate în câteva zile.

De ce Contează Purtabilele cu AI pentru Viitorul Muncii și al Interacțiunii

Implicațiile purtabilor îmbunătățiți cu AI depășesc cu mult confortul consumatorului, atingând aspecte fundamentale ale modului în care muncim, învățăm și comunicăm. Când un sistem AI poate vedea ce vezi tu, aude ce auzi tu și proiectează informația direct în câmpul tău vizual, natura interacțiunii om-calculator se schimbă fundamental. În loc să-ți întrerupi concentrarea pentru a verifica un dispozitiv, informația curge natural în câmpul tău vizual. În loc să tastezi întrebări, poți pur și simplu vorbi cu asistentul AI păstrând angajamentul cu mediul fizic. Pentru aplicații profesionale, acest lucru reprezintă o îmbunătățire uriașă a productivității—imaginează-ți un tehnician purtând ochelari AI care pot identifica echipamente, accesa proceduri de mentenanță și ghida reparații în timp real sau un chirurg al cărui asistent AI oferă informații anatomice și ghidare procedurală în timpul operațiilor. Îmbunătățirile bateriei din ultima generație de ochelari Ray-Ban, cu 42% mai multă capacitate care permite până la cinci ore de utilizare continuă, răspund uneia dintre principalele bariere de adoptare. Pe măsură ce aceste dispozitive devin mai practice și mai capabile, probabil vor deveni la fel de omniprezente ca smartphone-urile, schimbând fundamental modul în care accesăm informația și interacționăm cu AI pe parcursul vieții de zi cu zi.

Una dintre cele mai semnificative evoluții în inteligența artificială din 2025 este atingerea unei performanțe supranaturale în sarcini complexe de raționament. Finala Mondială a International Collegiate Programming Contest (ICPC) reprezintă apogeul programării competitive, unde cele mai bune echipe universitare din lume rezolvă probleme algoritmice extrem de dificile sub presiunea timpului. Aceste probleme necesită nu doar cunoștințe de programare, ci și raționament matematic profund, rezolvare creativă de probleme și abilitatea de a gestiona cazuri limită și constrângeri complexe. Sistemul de raționament al OpenAI a obținut scorul perfect de 12 din 12 probleme la Finala Mondială ICPC 2025, depășind toți competitorii umani care au participat la aceeași competiție. Metodologia folosită a fost remarcabilă—sistemul a primit problemele exact în același format PDF ca participanții umani, a avut aceeași limită de timp de cinci ore și a făcut trimiteri fără niciun tip de testare sau optimizare specifică competiției. Pentru unsprezece din cele douăsprezece probleme, primul răspuns trimis de sistem a fost corect, demonstrând nu doar capacitate de rezolvare, ci și calibrare a încrederii și verificare a soluțiilor. Pentru cea mai dificilă problemă, sistemul a avut nevoie de nouă trimiteri pentru a ajunge la soluția corectă, depășind totuși cea mai bună echipă umană care a rezolvat unsprezece probleme din douăsprezece.

Abordarea tehnică din spatele acestei realizări a implicat un ansamblu de modele de raționament, inclusiv GPT-5 și un model experimental, lucrând împreună pentru a genera și evalua soluții. Aceasta reprezintă o schimbare fundamentală în modul în care sistemele AI abordează probleme complexe—în loc să rezolve totul din prima încercare, aceste sisteme folosesc rafinarea iterativă, adaptarea la testare și metode ensemble pentru a îmbunătăți progresiv soluțiile. Implicațiile sunt profunde: dacă sistemele AI pot acum depăși cei mai buni programatori umani din lume la rezolvarea unor probleme algoritmice noi și complexe, acest lucru sugerează că multe sarcini de muncă intelectuală care păreau a necesita expertiză umană pot fi automatizate sau augmentate cu ajutorul AI. Realizarea a fost validată de experți din industrie, inclusiv Scott Woo, CEO Cognition și fost campion la competiții de matematică, care a subliniat dificultatea extraordinară a acestei performanțe. Mark Chen, Chief Research Officer la OpenAI, a pus această realizare în contextul unei traiectorii mai largi a capacităților AI, subliniind că inteligența de bază a acestor modele este acum suficientă—ce mai rămâne este construirea infrastructurii pentru a implementa eficient aceste capacități.

Abonează-te la newsletter-ul nostru

Primește cele mai recente sfaturi, tendințe și oferte gratuit.

În timp ce capabilitățile de raționament reprezintă o frontieră a progresului AI, implementarea practică a sistemelor AI necesită infrastructură robustă pentru gestionarea informațiilor și a contextului. Retrieval Augmented Generation (RAG) a devenit o tehnologie esențială pentru a permite sistemelor AI să acceseze și să utilizeze surse externe de cunoaștere—fie că sunt documente de companie, lucrări de cercetare sau baze de date proprietare. Sistemele RAG tradiționale se confruntă cu o provocare fundamentală: pe măsură ce cantitatea de informații recuperabile crește, costul computațional pentru căutare și procesare crește dramatic. Super Intelligence Labs de la Meta a abordat această provocare prin ReRAG, o optimizare inovatoare care îmbunătățește viteza RAG de 30x și permite utilizarea de contexte de 16x mai lungi fără pierderi de acuratețe. Inovația funcționează prin înlocuirea majorității tokenilor recuperați cu embedding-uri de fragmente pre-calculate și reutilizabile, schimbând fundamental modul de stocare și regăsire a informației. În loc să proceseze textul brut de fiecare dată când se face o interogare, sistemul folosește embedding-uri pre-calculate care captează semnificația semantică a fragmentelor, permițând regăsire mai rapidă și utilizarea eficientă a ferestrei de context a modelului.

Această optimizare are implicații practice imediate pentru implementarea AI în mediul enterprise. Companiile pot oferi acum sistemelor AI acces la baze de cunoștințe mult mai vaste, fără creșteri proporționale de cost computațional sau latență. Un AI pentru suport clienți poate avea acces la milioane de pagini de documentație și totuși răspunde la interogări în milisecunde. Un asistent de cercetare poate căuta în biblioteci întregi de articole și sintetiza concluzii fără costul computațional care anterior ar fi făcut astfel de sarcini impracticabile. Îmbunătățirea de 30x a vitezei este deosebit de importantă deoarece transformă RAG dintr-o tehnică specializată într-o abordare implicită pentru orice sistem AI care trebuie să acceseze informații externe. Combinate cu îmbunătățiri ale lungimii ferestrei de context, ReRAG permite sistemelor AI să mențină o înțelegere coerentă pe documente mult mai lungi și ierarhii informaționale complexe, esențial pentru aplicații precum analiza documentelor juridice, sinteza cercetărilor științifice și business intelligence comprehensiv.

FlowHunt și Orchestrarea Fluxurilor AI

Convergența capabilităților AI avansate—modele de raționament, sisteme de regăsire a informațiilor și agenți autonomi—creează atât oportunități, cât și provocări pentru organizațiile care doresc să valorifice aceste tehnologii. Valoarea reală nu provine din capabilitățile individuale ale AI izolate, ci din orchestrarea lor în fluxuri coerente care rezolvă probleme reale de business. FlowHunt răspunde acestei nevoi oferind o platformă pentru construirea și gestionarea fluxurilor complexe de automatizare AI care conectează mai multe instrumente, surse de date și modele AI în procese unificate. Să luăm un exemplu practic: conversia știrilor în conținut formatat pentru rețele sociale. Această sarcină aparent simplă necesită orchestrarea mai multor capabilități AI și instrumente externe. Fluxul începe prin captarea unui URL de știre și crearea de înregistrări în sistemele de management de proiect, declanșând automat procesări paralele pentru diferite platforme sociale. Pentru fiecare platformă, fluxul folosește AI pentru a genera titluri specifice, recuperează active suplimentare și informații prin web scraping, generează imagini de antet personalizate cu suprapuneri de text și publică în final conținutul formatat pe platforme de programare. Fiecare pas implică instrumente și modele AI diferite ce lucrează împreună, ieșirea unui pas alimentând următorul.

Acest tip de orchestrare devine tot mai esențial pe măsură ce capabilitățile AI se înmulțesc. În loc să construiască integrări personalizate pentru fiecare combinație de instrumente și modele, platforme precum FlowHunt oferă infrastructura pentru dezvoltare și implementare rapidă a fluxurilor. Integrarea platformei cu peste 8.000 de instrumente înseamnă că aproape orice proces de business poate fi automatizat prin combinarea instrumentelor existente cu capabilități AI. Astfel, automatizarea AI este democratizată, permițând și organizațiilor fără echipe specializate de inginerie AI să construiască fluxuri automate sofisticate. Pe măsură ce agenții AI devin mai capabili și autonomi, abilitatea de a le orchestra activitățile, de a gestiona interacțiunea lor cu sisteme externe și de a asigura că ieșirile lor respectă cerințele de business devine tot mai critică. Abordarea FlowHunt, de a oferi constructori vizuali de flux combinat cu capabilități de orchestrare AI, îl poziționează ca strat de infrastructură cheie în economia emergentă condusă de AI.

Emergența Infrastructurii pentru Agenți Autonomi

Dincolo de capabilitățile AI individuale, 2025 marchează apariția unei infrastructuri concepute special pentru a permite agenților autonomi să interacționeze între ei și cu sisteme externe. Anunțul Google privind Agent Payment Protocol (AP2) reprezintă un punct de referință semnificativ în această evoluție. Bazându-se pe protocolul anterior Agent-to-Agent, care permitea agenților să comunice între ei, AP2 extinde această capacitate incluzând tranzacții financiare. Protocolul oferă un limbaj comun pentru tranzacții sigure și conforme între agenți și comercianți, permițând o nouă clasă de activitate economică autonomă. Imaginează-ți un agent AI care gestionează operațiunile afacerii tale și care poate achiziționa autonom servicii, negocia contracte și gestiona relațiile cu furnizorii fără intervenție umană. Sau optimizează lanțul de aprovizionare unde mai mulți agenți AI ai unor companii diferite pot tranzacționa între ei pentru a optimiza stocurile, prețurile și livrările în timp real.

Protocolul a atras deja parteneri majori din tehnologie și business, inclusiv Adobe, Accenture, OnePassword, Intuit, Red Hat, Salesforce și Okta. Acest nivel de susținere din industrie sugerează că tranzacțiile între agenți nu mai sunt o capacitate speculativă, ci o realitate emergentă pe care companiile se pregătesc să o integreze în operațiuni. Implicațiile depășesc tranzacțiile simple—AP2 permite formarea de rețele de agenți unde sistemele autonome pot colabora, concura și coordona pentru a atinge obiective complexe. Un agent AI din producție poate achiziționa automat materii prime de la agenți furnizori, coordona livrarea cu agenți de logistică și gestiona plățile prin protocol, totul fără intervenție umană. Aceasta reprezintă o schimbare fundamentală în modul de organizare a proceselor de business, de la fluxuri dirijate de oameni la ecosisteme coordonate de agenți unde AI acționează cu autonomie din ce în ce mai mare în limitele definite.

Atingerea unei performanțe supranaturale în programarea competitivă face parte dintr-un tipar mai larg al sistemelor AI care ating sau depășesc nivelul uman în domenii din ce în ce mai complexe. Realizarea de la ICPC se bazează pe repere anterioare, inclusiv locul șase la International Olympiad in Informatics (IOI), medalie de aur la International Mathematical Olympiad (IMO) și locul doi la AtCoder Heuristic Contest. Această evoluție demonstrează că abilitățile de raționament AI nu sunt limitate la domenii înguste, ci se generalizează pe tipuri diverse de probleme complexe. Implicațiile pentru munca intelectuală sunt semnificative—dacă sistemele AI pot rezolva probleme de programare noi ce necesită înțelegere algoritmică profundă, probabil pot asista sau automatiza multe alte sarcini de knowledge work cu tipare similare de raționament.

Totuși, este important să contextualizăm aceste realizări în peisajul mai larg al dezvoltării AI. Așa cum a subliniat Mark Chen, inteligența de bază a acestor modele este acum suficientă pentru multe sarcini—ce mai rămâne este construirea infrastructurii pentru a implementa eficient aceste capacități. Aceasta cuprinde nu doar infrastructura tehnică (precum RAG și protocoale de agenți), ci și procese organizaționale, măsuri de siguranță și cadre de integrare pentru implementarea responsabilă și eficientă a AI în structuri de business și sociale existente. Următoarea fază a dezvoltării AI se va concentra probabil mai puțin pe îmbunătățirea capacităților brute și mai mult pe implementarea practică, integrarea și orchestrarea capacităților existente.

Inteligența Spațială și Generarea de Lumi 3D

În timp ce raționamentul și infrastructura pentru agenți reprezintă o frontieră a dezvoltării AI, inteligența spațială reprezintă o alta. World Labs, fondată de Fei-Fei Li, este un pionier în dezvoltarea Large World Models (LWMs) care pot genera și înțelege medii tridimensionale. Tehnologia demonstrată de World Labs ia o singură imagine și generează o lume 3D interactivă pe care utilizatorii o pot explora și naviga. Aceasta reprezintă un progres fundamental în modul în care sistemele AI înțeleg și reprezintă informația spațială. În loc să trateze imaginile ca date statice 2D, aceste sisteme construiesc modele 3D coerente care mențin consistența pe măsură ce privitorul se deplasează prin spațiu. Lumea generată include detalii de mediu, iluminare și umbre corecte, precum și fizică realistă, creând experiențe captivante care par naturale și coerente.

Aplicațiile acestei tehnologii depășesc cu mult divertismentul și vizualizarea. În arhitectură și planificare urbană, proiectanții pot genera medii 3D complete pornind de la schițe de concept, permițând factorilor de decizie să exploreze și să evalueze designul înainte de construcție. În educație, elevii pot explora situri istorice, medii științifice sau sisteme complexe în spațiu 3D imersiv. În training și simulare, organizațiile pot genera medii realiste pentru scenarii de instruire fără costul și complexitatea construirii unor facilități fizice. Tehnologia are implicații și pentru robotică și sisteme autonome—dacă AI poate genera modele 3D coerente ale mediului, poate înțelege mai bine relațiile spațiale și planifica mișcări în spații complexe. Pe măsură ce această tehnologie se maturizează și devine mai accesibilă, probabil va deveni un instrument standard pentru vizualizare, design și simulare în numeroase industrii.

Agenți AI Open-Source și Benchmarking Competitiv

Peisajul competitiv al capabilităților AI se intensifică, cu mai multe organizații care dezvoltă sisteme avansate de raționament și agenți. Tongyi DeepResearch de la Alibaba reprezintă o contribuție open-source importantă, atingând performanțe de top pe mai multe benchmark-uri cu doar 30 de miliarde de parametri, dintre care doar 3 miliarde sunt activați la inferență. Această eficiență este remarcabilă—sistemul atinge performanțe comparabile cu modele proprietare mult mai mari, folosind o fracțiune din resursele computaționale. Sistemul obține scoruri de 32,9 la Humanity’s Last Exam, 45,3 la BrowseComp și 75 la XBench Deep Research, demonstrând performanță puternică pe sarcini diverse de raționament și cercetare.

Caracterul open-source al Tongyi DeepResearch este deosebit de important pentru că democratizează accesul la capabilități AI avansate. În loc să fie limitate la organizații cu resurse pentru antrenarea unor modele proprietare masive, cercetătorii și dezvoltatorii pot lucra acum cu sisteme de raționament de ultimă generație. Abordarea tehnică din spatele Tongyi DeepResearch implică o strategie automată multi-etapă pentru generarea de cantități mari de date de antrenament agentice de înaltă calitate fără a depinde de adnotare umană costisitoare. Aceasta rezolvă una dintre provocările fundamentale ale dezvoltării AI—nevoia de mari cantități de date de antrenament de calitate. Prin automatizarea generării de date, Tongyi DeepResearch demonstrează că se pot obține performanțe de top fără eforturi masive de adnotare umană.

Investiții în Infrastructura AI și Scalare

Avansul rapid al capabilităților AI stimulează investiții masive în infrastructura AI, în special în capacitatea de center de date și hardware specializat. GRQ, un producător de cipuri AI, a obținut 750 de milioane de dolari în finanțare la o evaluare post-investiție de 6,9 miliarde de dolari, cu planuri de extindere a capacității de center de date inclusiv în Asia-Pacific. Această rundă de finanțare, condusă de Disruptive și incluzând investitori majori precum BlackRock și Neuberger Berman, reflectă competiția intensă pentru capacitatea de inferență și recunoașterea faptului că infrastructura AI va fi un blocaj critic în anii următori. Cererea copleșitoare pentru capacitate de inferență—resursele computaționale necesare pentru a rula modele AI antrenate—determină companii precum Nvidia, GRQ și Cerebras să extindă producția cât mai rapid posibil.

Această construcție de infrastructură este esențială pentru valorificarea potențialului capabilităților AI avansate. Modelele de raționament, modelele mari de limbaj și agenții autonomi necesită resurse computaționale semnificative pentru a funcționa. Pe măsură ce aceste sisteme sunt implementate pe scară largă, cererea pentru capacitate de inferență va crește și mai mult. Investiția în infrastructură nu este speculativă—reflectă realitatea că organizațiile implementează deja sisteme AI la scară și au nevoie de infrastructură fiabilă și scalabilă pentru a susține aceste implementări. Extinderea geografică în Asia-Pacific reflectă caracterul global al implementării AI și recunoașterea faptului că resursele computaționale trebuie distribuite global pentru a servi utilizatorii cu latență acceptabilă și în conformitate cu cerințele locale de rezidență a datelor.

Tendințe Emergente în Dezvoltarea Modelelor AI

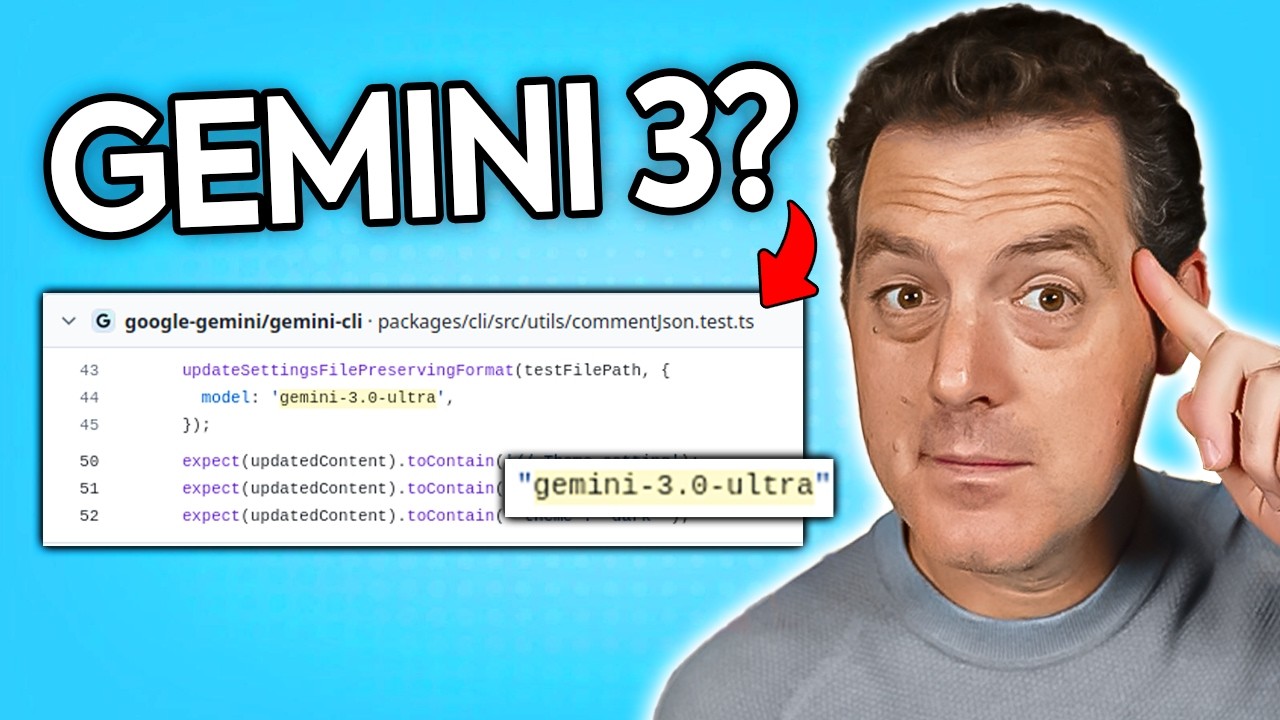

Peisajul competitiv al modelelor AI evoluează rapid, cu mai multe organizații care urmăresc abordări diferite pentru avansarea capabilităților AI. Dezvoltarea zvonită a Gemini 3.0 Ultra, detectată în repository-ul Gemini CLI de la Google, sugerează că Google se pregătește să lanseze o nouă generație a modelului lor de raționament. Descoperirea referințelor la Gemini 3.0 Ultra în codul publicat cu doar câteva zile înainte de apariția știrii indică faptul că lansările majore de modele sunt adesea precedate de schimbări de infrastructură și lucrări de pregătire. Tiparul de versiuni și cicluri de lansare sugerează că ne putem aștepta la actualizări regulate și îmbunătățiri ale principalelor sisteme AI, fiecare generație aducând îmbunătățiri incrementale sau uneori semnificative ale capabilităților.

Anunțul lui Elon Musk că antrenamentul pentru Grok 5 va începe în câteva săptămâni indică faptul că xAI își avansează, de asemenea, capabilitățile de raționament. Întrebarea ce constituie o creștere majoră de versiune în modelele AI—dacă reprezintă o nouă rundă de antrenament, modificări arhitecturale semnificative sau praguri de capabilitate—rămâne oarecum ambiguă, însă tiparul este clar: mai multe organizații investesc masiv în dezvoltarea de modele de raționament avansate și ne putem aștepta la lansări regulate de noi versiuni cu capabilități îmbunătățite. Această dinamică competitivă este benefică pentru ecosistemul AI mai larg, deoarece concurența stimulează inovația și asigură că nicio organizație nu deține monopolul asupra capabilităților AI avansate.

Vehicule Autonome și Implementarea AI în Lumea Reală

Deși o mare parte din discuția despre AI se concentrează pe modele de raționament și infrastructură pentru agenți, implementarea reală a sistemelor AI avansează rapid în domenii precum vehiculele autonome. Aprobarea permisului pilot Waymo pentru operarea de curse autonome la Aeroportul Internațional San Francisco reprezintă o etapă majoră în comercializarea tehnologiei vehiculelor autonome. Abordarea etapizată, începând cu operațiuni la aeroport și extinzându-se treptat spre alte zone de serviciu, reflectă abordarea atentă necesară pentru implementarea sistemelor AI critice pentru siguranță în medii reale. Competiția cu alte companii de vehicule autonome precum Zoox (deținută de Amazon) demonstrează că mai multe organizații fac progrese semnificative în acest domeniu.

Implementarea vehiculelor autonome în hub-uri majore de transport precum SFO este semnificativă deoarece marchează tranziția de la medii de testare controlate la operațiuni reale care deservesc clienți. Mediul aeroportuar, deși controlat în comparație cu traficul urban general, prezintă provocări reale, inclusiv variabilitatea vremii, tipare complexe de trafic și interacțiunea cu șoferi și pietoni umani. Implementarea cu succes în acest mediu demonstrează că tehnologia vehiculelor autonome a ajuns la maturitatea necesară pentru a funcționa fiabil în condiții reale. Pe măsură ce aceste sisteme acumulează mai multă experiență operațională și date, probabil se vor îmbunătăți și mai mult, permițând în cele din urmă implementarea pe scară largă în medii de conducere tot mai complexe.

Integrarea Capabilităților AI în Procesele de Business

Convergența capabilităților AI avansate, infrastructurii pentru agenți și platformelor de automatizare permite organizațiilor să integreze AI în procesele de business de bază în moduri anterior imposibile. Exemplul practic al conversiei știrilor în conținut pentru social media, deși aparent simplu, ilustrează complexitatea automatizării reale cu AI. Fluxul necesită coordonarea mai multor modele AI (pentru generarea titlurilor și crearea imaginilor), instrumente externe (pentru web scraping și programarea conținutului) și logică de business (pentru formatare și programare specifică platformei). Implementarea cu succes a unor astfel de fluxuri necesită nu doar capabilități AI individuale, ci și platforme de orchestrare care pot gestiona interacțiunile dintre diferitele componente.

Abordarea FlowHunt, de a oferi constructori vizuali de flux combinate cu capabilități de orchestrare AI, răspunde acestei nevoi. Prin abstractizarea complexității tehnice a integrării diverselor instrumente și modele, aceste platforme permit utilizatorilor de business să construiască fluxuri automate sofisticate fără a necesita expertiză tehnică AI specializată. Pe măsură ce capabilitățile AI devin mai puternice și mai accesibile, abilitatea de a orchestra aceste capabilități în procese coerente de business devine tot mai valoroasă. Organizațiile care pot integra eficient AI în fluxurile lor de lucru vor obține avantaje competitive semnificative prin eficiență crescută, costuri reduse și lansare mai rapidă a produselor și serviciilor noi.

Viitorul Automatizării Alimentate de AI

Dezvoltările discutate pe parcursul acestui articol indică un viitor în care sistemele AI sunt profund integrate în procesele de business și viața de zi cu zi. În loc ca AI-ul să fie un instrument specializat folosit pentru anumite sarcini, devine abordarea implicită pentru automatizarea și optimizarea fluxurilor de lucru. Agenți autonomi se coordonează între ei pentru a gestiona procese complexe de business. Sisteme AI cu capabilități avansate de raționament rezolvă probleme noi și iau decizii strategice. AI purtabil oferă informații și asistență în timp real pe parcursul zilei. Inteligența spațială permite forme noi de vizualizare și simulare. Acest viitor nu este speculativ—tehnologiile care îl fac posibil sunt deja implementate și perfecționate.

Rolul platformelor precum FlowHunt devine tot mai important în acest context. Pe măsură ce capabilitățile AI se răspândesc și devin mai puternice, abilitatea de a orchestra aceste capabilități în fluxuri coerente devine un avantaj competitiv cheie. Organizațiile care pot integra eficient AI în operațiunile lor vor fi mai bine poziționate să concureze într-o economie tot mai condusă de AI. Investițiile masive în infrastructură făcute