Rata de adoptare a AI

Ratele de adoptare a AI indică procentul organizațiilor care au integrat inteligența artificială în operațiunile lor. Aceste rate variază în funcție de industri...

Ghidul KPMG pentru Riscurile și Controlul AI oferă organizațiilor o abordare structurată și etică pentru gestionarea riscurilor AI, susținând implementarea responsabilă și conformitatea cu standardele globale.

Această primă statistică ar putea fi din anul trecut, dar este mai relevantă ca niciodată. Conform KPMG’s 2024 U.S. CEO Outlook, un uimitor 68% dintre CEO au identificat AI ca o prioritate principală de investiții. Ei mizează pe AI pentru a crește eficiența, a îmbunătăți abilitățile angajaților și a stimula inovația în cadrul organizațiilor lor.

Este un vot uriaș de încredere pentru AI — dar ridică și o întrebare importantă: cu atât de mult în joc, cum se asigură organizațiile că folosesc AI în mod responsabil și etic?

Aici intervine Ghidul KPMG pentru Riscurile și Controlul AI. Acesta oferă un cadru clar și practic pentru a ajuta companiile să valorifice potențialul AI gestionând în același timp riscurile reale pe care le aduce. În peisajul actual, construirea unei AI de încredere nu este doar o bună practică — este o necesitate de business.

Inteligența artificială (AI) revoluționează industriile, dezlănțuind noi niveluri de eficiență, inovație și competitivitate. Totuși, această transformare aduce cu ea un set distinct de riscuri și provocări etice pe care organizațiile trebuie să le gestioneze cu atenție pentru a menține încrederea și a asigura utilizarea responsabilă. Ghidul KPMG pentru Riscurile și Controlul AI este conceput pentru a sprijini organizațiile în navigarea acestor complexități, oferind o abordare practică, structurată și bazată pe valori pentru guvernanța AI.

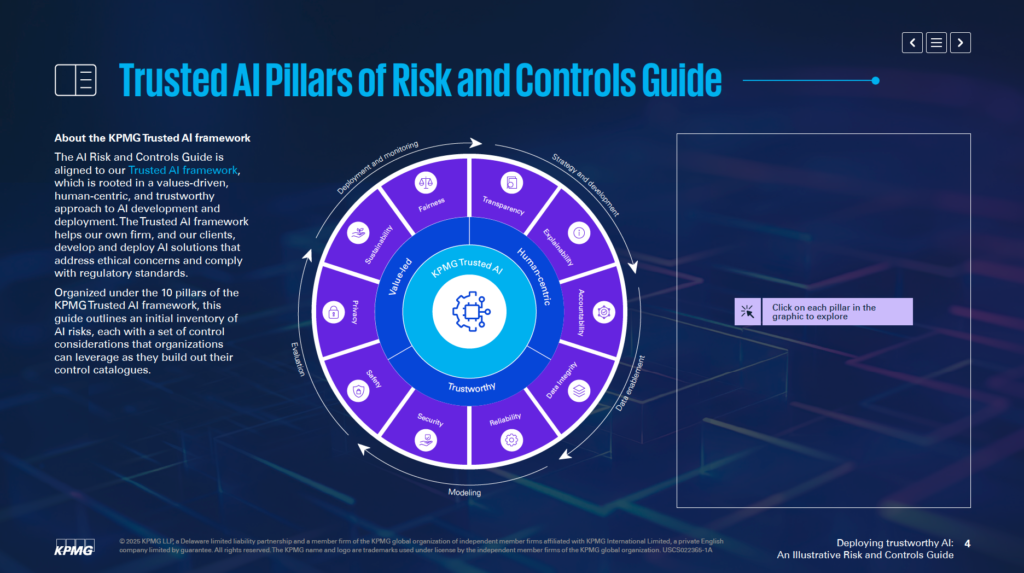

Aliniat la Cadrul AI de Încredere KPMG, acest ghid ajută companiile să dezvolte și să implementeze soluții AI etice, centrate pe om și conforme cu standardele globale de reglementare. Este organizat în jurul a 10 piloni fundamentali, fiecare abordând un aspect critic al managementului riscurilor AI:

Concentrându-se pe acești piloni, organizațiile pot integra principii etice în fiecare etapă a ciclului de viață AI—de la strategie și dezvoltare la implementare și monitorizare. Acest ghid nu doar întărește reziliența la risc, ci și stimulează inovația sustenabilă, de încredere și aliniată la așteptările societății.

Indiferent dacă ești profesionist în managementul riscului, lider executiv, data scientist sau consilier juridic, acest ghid oferă instrumente și perspective esențiale pentru a valorifica în mod responsabil puterea AI.

Ghidul KPMG pentru Riscurile și Controlul AI servește ca resursă specializată pentru a ajuta organizațiile să gestioneze riscurile specifice asociate inteligenței artificiale (AI). Recunoaște că, deși AI oferă un potențial semnificativ, complexitatea și aspectele sale etice necesită o abordare focalizată asupra managementului riscurilor. Ghidul oferă un cadru structurat pentru a aborda aceste provocări într-un mod responsabil și eficient.

Ghidul nu este conceput pentru a înlocui sistemele actuale, ci pentru a completa procesele existente de management al riscurilor. Scopul principal este de a integra considerații specifice AI în structurile de guvernanță ale organizației, asigurând o aliniere fluidă cu practicile operaționale curente. Această abordare permite organizațiilor să își consolideze capacitățile de management al riscului fără a fi nevoie să își reproiecteze complet cadrele.

Ghidul este construit pe cadrul AI de Încredere KPMG, care promovează o abordare centrată pe valori și pe om a AI. Integrează principii din standarde recunoscute la nivel mondial, inclusiv ISO 42001, Cadrul de Management al Riscurilor AI NIST și Actul AI al UE. Astfel, ghidul este atât practic, cât și aliniat la cele mai bune practici recunoscute global și la cerințele de reglementare pentru guvernanța AI.

Ghidul oferă perspective aplicabile și exemple practice adaptate pentru a aborda riscurile legate de AI. Încurajează organizațiile să adapteze aceste exemple la propriul context, luând în considerare variabile precum dacă sistemele AI sunt dezvoltate intern sau de furnizori, precum și tipurile de date și tehnici utilizate. Această adaptabilitate asigură relevanța ghidului pentru diverse industrii și aplicații AI.

Ghidul se concentrează pe permiterea organizațiilor să implementeze tehnologii AI într-un mod sigur, etic și transparent. Prin abordarea aspectelor tehnice, operaționale și etice ale riscurilor AI, ajută organizațiile să construiască încredere între părțile interesate, valorificând în același timp capacitățile transformative ale AI.

Ghidul acționează ca o resursă pentru a asigura că sistemele AI sunt aliniate la obiectivele de business, reducând potențialele riscuri. Susține inovația într-un mod care prioritizează responsabilitatea și răspunderea.

Ghidul KPMG pentru Guvernanța AI este conceput pentru profesioniștii care gestionează implementarea AI și asigură o utilizare sigură, etică și eficientă. Se adresează echipelor din diverse arii ale organizațiilor, inclusiv:

Directorii executivi și liderii de top, precum CEO, CIO și CTO, vor găsi acest ghid util pentru gestionarea AI ca prioritate strategică. Conform KPMG’s 2024 US CEO Outlook, 68% dintre CEO consideră AI o zonă cheie de investiții. Ghidul permite leadershipului să alinieze strategiile AI la obiectivele organizaționale, abordând în același timp riscurile asociate.

Inginerii software, data scientist-ii și alți responsabili de crearea și implementarea soluțiilor AI pot folosi ghidul pentru a integra principiile etice și controale robuste direct în sistemele lor. Se concentrează pe adaptarea practicilor de management al riscului la arhitectura și fluxurile de date specifice modelelor AI.

Ghidul este adaptabil pentru companiile care dezvoltă sisteme AI intern, le achiziționează de la furnizori sau utilizează seturi de date proprietare. Este deosebit de relevant pentru industrii precum financiar, sănătate și tehnologie, unde aplicațiile AI avansate și datele sensibile sunt critice pentru operațiuni.

Implementarea AI fără un cadru clar de guvernanță poate duce la riscuri financiare, de reglementare și de reputație. Ghidul KPMG funcționează împreună cu procesele existente pentru a oferi o abordare structurată și etică a gestionării AI. Promovează responsabilitatea, transparența și practicile etice, ajutând organizațiile să utilizeze AI responsabil și să valorifice potențialul său.

Organizațiile ar trebui să înceapă prin a lega riscurile specifice AI de taxonomia lor actuală de risc. O taxonomie a riscurilor este un cadru structurat folosit pentru a identifica, organiza și aborda potențialele vulnerabilități. Deoarece AI introduce provocări unice, taxonomiile tradiționale trebuie extinse pentru a include factori specifici AI. Acești factori pot implica acuratețea fluxului de date, logica din spatele algoritmilor și fiabilitatea surselor de date. Astfel, riscurile AI devin parte integrantă a eforturilor mai largi de management al riscului, nu sunt tratate separat.

Ghidul subliniază necesitatea evaluării întregului ciclu de viață al sistemelor AI. Zonele importante de analizat includ sursa datelor, modul în care acestea circulă prin procese și logica fundamentală a modelului AI. Această perspectivă largă ajută la identificarea vulnerabilităților care pot apărea în timpul dezvoltării și utilizării AI.

Sistemele AI diferă în funcție de scop, metode de dezvoltare și tipul de date utilizat. Fie că un model este creat intern sau obținut de la un furnizor extern, acest lucru influențează semnificativ riscurile implicate. De asemenea, tipul de date—proprietare, publice sau sensibile—împreună cu tehnicile folosite pentru dezvoltarea AI, necesită strategii de management al riscului personalizate.

Ghidul sugerează adaptarea măsurilor de control la nevoile specifice ale sistemelor AI. De exemplu, dacă folosești date proprietare, pot fi necesare controale mai stricte de acces. În schimb, utilizarea unui sistem AI de la un furnizor ar putea necesita evaluări detaliate ale riscurilor terților. Prin personalizarea acestor controale, poți aborda mai eficient provocările specifice ale sistemelor AI.

Ghidul recomandă includerea practicilor de management al riscului în fiecare etapă a ciclului de viață AI. Aceasta presupune planificarea riscurilor încă din faza de proiectare, implementarea unor sisteme solide de monitorizare la implementare și actualizarea regulată a evaluărilor de risc pe măsură ce sistemul AI evoluează. Prin abordarea riscurilor la fiecare pas, poți reduce vulnerabilitățile și asigura că sistemele AI sunt atât etice, cât și fiabile.

Alinierea inițială a riscurilor AI cu taxonomia existentă și personalizarea controalelor pe baza nevoilor creează o fundație solidă pentru AI de încredere. Aceste eforturi permit organizațiilor să identifice, să evalueze și să gestioneze sistematic riscurile, construind un cadru robust pentru guvernanța AI.

Cadrul AI de Încredere KPMG se bazează pe zece piloni cheie care abordează provocările etice, tehnice și operaționale ale inteligenței artificiale. Acești piloni ghidează organizațiile în proiectarea, dezvoltarea și implementarea responsabilă a sistemelor AI, asigurând încredere și responsabilitate pe tot parcursul ciclului de viață AI.

Supravegherea și responsabilitatea umană trebuie să fie prezente în fiecare etapă a ciclului de viață AI. Aceasta înseamnă definirea clară a responsabilității pentru gestionarea riscurilor AI, asigurarea conformității cu legile și reglementările și menținerea capacității de a interveni, anula sau inversa deciziile AI dacă este necesar.

Sistemele AI trebuie să reducă sau să elimine părtinirea care ar putea afecta negativ indivizi, comunități sau grupuri. Aceasta implică analizarea atentă a datelor pentru a asigura reprezentativitatea populațiilor diverse, aplicarea măsurilor de echitate în dezvoltare și monitorizarea continuă a rezultatelor pentru a promova tratamentul echitabil.

Transparența presupune comunicarea deschisă a modului în care funcționează sistemele AI și de ce iau anumite decizii. Include documentarea limitărilor sistemului, a rezultatelor performanței și a metodelor de testare. Utilizatorii trebuie informați când datele lor sunt colectate, conținutul generat de AI trebuie etichetat clar, iar aplicațiile sensibile precum clasificarea biometrică trebuie să ofere notificări clare utilizatorilor.

Sistemele AI trebuie să ofere motive ușor de înțeles pentru deciziile lor. Pentru a realiza acest lucru, organizațiile ar trebui să documenteze detaliat seturile de date, algoritmii și metricele de performanță, permițând părților interesate să analizeze și să reproducă eficient rezultatele.

Calitatea și fiabilitatea datelor pe tot parcursul ciclului de viață—colectare, etichetare, stocare și analiză—sunt esențiale. Trebuie implementate controale pentru a aborda riscuri precum coruperea sau părtinirea datelor. Verificarea regulată a calității datelor și testele de regresie la actualizările de sistem ajută la menținerea acurateței și fiabilității AI.

Soluțiile AI trebuie să respecte legile privind confidențialitatea și protecția datelor. Organizațiile trebuie să gestioneze corect solicitările persoanelor vizate, să efectueze evaluări de impact asupra confidențialității și să utilizeze metode avansate precum confidențialitatea diferențială pentru a echilibra utilizarea datelor cu protejarea intimității.

Sistemele AI trebuie să funcționeze constant conform scopului și acurateței necesare. Acest lucru implică testare riguroasă, mecanisme de detectare a anomaliilor și bucle de feedback continue pentru validarea rezultatelor sistemului.

Măsurile de siguranță protejează sistemele AI de a cauza daune indivizilor, organizațiilor sau proprietăților. Acestea includ proiectarea de mecanisme de siguranță, monitorizarea pentru probleme precum coruperea datelor sau atacuri de tip prompt injection și asigurarea alinierii la standarde etice și operaționale.

Practici solide de securitate sunt necesare pentru a proteja sistemele AI de amenințări și activități rău intenționate. Organizațiile ar trebui să efectueze audituri regulate, evaluări de vulnerabilitate și să utilizeze criptarea pentru a proteja datele sensibile.

Sistemele AI trebuie proiectate pentru a minimiza consumul de energie și a sprijini obiectivele de mediu. Considerațiile de sustenabilitate trebuie incluse încă din faza de proiectare, cu monitorizare continuă a consumului de energie, eficienței și emisiilor pe parcursul ciclului de viață AI.

Respectând acești zece piloni, organizațiile pot crea sisteme AI etice, de încredere și aliniate la așteptările societății. Acest cadru oferă o structură clară pentru gestionarea provocărilor AI și promovarea inovației responsabile.

Integritatea datelor este esențială pentru a asigura că sistemele AI rămân precise, echitabile și fiabile. O gestionare deficitară a datelor poate duce la riscuri precum părtinire, inexactitate și rezultate nesigure. Aceste probleme pot submina încrederea în rezultatele AI și pot cauza dificultăți operaționale și de reputație majore. Cadrul AI de Încredere KPMG subliniază necesitatea menținerii unei calități ridicate a datelor pe tot parcursul ciclului de viață pentru ca sistemele AI să funcționeze eficient și să respecte standardele etice.

Fără o guvernanță solidă a datelor, sistemele AI pot genera rezultate eronate. Probleme precum date incomplete, inexacte sau irelevante pot conduce la rezultate părtinitoare sau nesigure, crescând riscurile în diverse aplicații AI.

Datele circulă frecvent între sisteme pentru activități precum antrenare, testare sau operațiuni. Dacă aceste transferuri nu sunt gestionate corect, datele pot fi corupte, pierdute sau degradate, ceea ce afectează performanța sistemelor AI.

Pentru a îmbunătăți guvernanța datelor, organizațiile pot:

Pentru a minimiza riscurile în timpul transferurilor de date, organizațiile ar trebui:

Folosirea sistemelor de monitorizare continuă ajută la menținerea integrității datelor pe tot parcursul ciclului de viață AI. Aceste sisteme pot detecta probleme precum schimbări neașteptate în calitatea seturilor de date sau inconsistențe în gestionarea datelor, permițând acțiuni corective rapide.

Menținerea integrității datelor este esențială pentru implementarea unor sisteme AI de încredere. Organizațiile pot reduce riscurile prin stabilirea unor cadre solide de guvernanță, protejarea interacțiunilor cu datele și menținerea unor procese continue de validare. Aceste acțiuni îmbunătățesc fiabilitatea rezultatelor AI, asigurând respectarea standardelor etice și operaționale și ajutând la construirea încrederii în tehnologiile AI.

Gestionarea solicitărilor privind accesul persoanelor vizate la date reprezintă o provocare majoră de confidențialitate în AI. Organizațiile trebuie să se asigure că persoanele își pot exercita drepturile de acces, corectare sau ștergere a informațiilor personale conform legilor precum GDPR și CCPA. Dacă aceste cereri nu sunt gestionate corespunzător, pot apărea încălcări ale reglementărilor, pierderea încrederii consumatorilor și afectarea reputației organizației.

Pentru a reduce acest risc, companiile ar trebui să creeze programe de informare pentru utilizatori privind drepturile lor asupra datelor în interacțiunea cu AI. Sistemele trebuie să fie configurate pentru a procesa aceste solicitări rapid și transparent. De asemenea, organizațiile trebuie să păstreze evidențe detaliate despre modul în care gestionează aceste cereri pentru a demonstra conformitatea în timpul auditurilor.

Sistemele AI gestionează adesea informații personale sensibile, ceea ce le face ținte atractive pentru atacuri cibernetice. Dacă apare o breșă, aceasta poate conduce la amenzi semnificative, deteriorarea reputației companiei și pierderea încrederii clienților.

Pentru a combate acest risc, cadrul AI de Încredere KPMG sugerează realizarea de evaluări etice pentru sistemele AI care utilizează date personale, pentru a asigura respectarea reglementărilor de confidențialitate. Sunt necesare audituri periodice de protecție a datelor și evaluări de impact asupra confidențialității (PIA), mai ales atunci când date sensibile sunt folosite la antrenarea modelelor AI. În plus, metode precum confidențialitatea diferențială, care adaugă zgomot statistic datelor, pot ajuta la anonimizarea informațiilor menținând posibilitatea analizei.

Sistemele AI care nu includ măsuri de protecție a confidențialității încă din faza de dezvoltare pot genera probleme serioase. Fără principiile de confidențialitate prin proiectare, organizațiile riscă să expună date sensibile sau să nu respecte cerințele legale.

Companiile trebuie să implementeze măsuri de confidențialitate încă din stadiul de dezvoltare a sistemelor AI. Aceasta implică respectarea legislației și reglementărilor privind protecția datelor prin practici solide de management al datelor. Documentarea clară a modului în care datele sunt colectate, utilizate și stocate este crucială. Organizațiile trebuie să obțină și consimțământ explicit de la utilizatori pentru colectarea și procesarea datelor, în special în domenii sensibile precum datele biometrice.

Când sistemele AI nu explică clar modul în care sunt gestionate datele utilizatorilor, se poate ajunge la neîncredere și la examinări legale. Utilizatorii trebuie să știe când datele lor sunt colectate și cum sunt utilizate

Ghidul KPMG pentru Riscurile și Controlul AI este un cadru practic conceput pentru a ajuta organizațiile să gestioneze riscurile unice ale AI, asigurând o implementare responsabilă, etică și conformă a AI în toate industriile.

Ghidul este construit pe zece piloni cheie: Responsabilitate, Echitate, Transparență, Explicabilitate, Integritatea datelor, Fiabilitate, Securitate, Siguranță, Confidențialitate și Sustenabilitate—fiecare abordând aspecte esențiale ale gestionării riscurilor AI.

Ghidul se adresează profesioniștilor în managementul riscurilor, echipelor de conformitate, specialiștilor în securitate cibernetică, consilierilor juridici, directorilor executivi, dezvoltatorilor AI, inginerilor și organizațiilor de toate dimensiunile care doresc să gestioneze AI în mod responsabil.

Acesta este aliniat cu standarde globale precum ISO 42001, Cadrul de Management al Riscurilor AI NIST și Actul AI al UE, ajutând organizațiile să integreze controale specifice AI în procesele existente de guvernanță și să îndeplinească cerințele de reglementare.

Sugerează măsuri precum guvernanță solidă a datelor, confidențialitate prin proiectare, monitorizare continuă, transparență în deciziile AI, detectarea anomaliilor, bucle de feedback și obiective de sustenabilitate pentru reducerea riscurilor legate de AI.

Descoperă cum Ghidul KPMG pentru Riscurile și Controlul AI poate ajuta organizația ta să adopte inovația AI asigurând în același timp o implementare etică, sigură și conformă.

Ratele de adoptare a AI indică procentul organizațiilor care au integrat inteligența artificială în operațiunile lor. Aceste rate variază în funcție de industri...

Explorează de ce leadership-ul în AI este esențial pentru succesul organizațional, cum liderii puternici conduc transformarea AI și cum Workshop-ul de Leadershi...

Descoperă top 18 platforme AI în 2025, caracteristicile lor, cazuri de utilizare și sfaturi despre cum să o alegi pe cea potrivită pentru nevoile afacerii tale....

Consimțământ Cookie

Folosim cookie-uri pentru a vă îmbunătăți experiența de navigare și a analiza traficul nostru. See our privacy policy.