Cum să transformi crearea de conținut video cu Wan 2.2 & 2.5 Video Generation?

FlowHunt suportă acum modelele de generare video Wan 2.2 și 2.5 pentru text-la-video, imagine-la-video, înlocuire de personaje și animație. Transformă-ți proces...

Wan 2.1 este un model puternic open-source de generare video cu AI dezvoltat de Alibaba, care oferă videoclipuri de calitate de studio din text sau imagini, gratuit pentru toată lumea pentru folosire locală.

Wan 2.1 (numit și WanX 2.1) deschide noi orizonturi ca model complet open-source pentru generarea video cu AI, dezvoltat de Tongyi Lab din cadrul Alibaba. Spre deosebire de multe sisteme proprietare de generare video care necesită abonamente costisitoare sau acces API, Wan 2.1 oferă o calitate comparabilă sau superioară, rămânând gratuit și accesibil pentru dezvoltatori, cercetători și profesioniști creativi.

Ceea ce face Wan 2.1 cu adevărat special este combinația între accesibilitate și performanță. Varianta mai mică T2V-1.3B necesită doar ~8.2 GB memorie GPU, fiind compatibilă cu majoritatea GPU-urilor moderne de consum. În același timp, versiunea mai mare cu 14 miliarde de parametri oferă performanță de ultimă generație, depășind alternativele open-source și multe modele comerciale în benchmark-urile standard.

Wan 2.1 nu este limitat doar la generarea text-to-video. Arhitectura sa versatilă suportă:

Această flexibilitate înseamnă că poți începe cu un prompt text, o imagine sau chiar un video existent și îl poți transforma după propria viziune creativă.

Fiind primul model video capabil să redea text lizibil în engleză și chineză în videoclipurile generate, Wan 2.1 deschide noi oportunități pentru creatorii de conținut internațional. Această funcție este deosebit de valoroasă pentru crearea de subtitrări sau text pe scenă în videoclipuri multilingve.

În centrul eficienței Wan 2.1 stă un Video Variational Autoencoder cauzal 3D. Această inovație tehnologică comprimă eficient informația spațio-temporală, permițând modelului să:

Modelul mai mic, de 1.3B, necesită doar 8.19 GB VRAM și poate produce un videoclip de 5 secunde, 480p, în aproximativ 4 minute pe un RTX 4090. În ciuda acestei eficiențe, calitatea sa rivalizează sau depășește modele mult mai mari, reprezentând echilibrul perfect între viteză și fidelitate vizuală.

În evaluări publice, Wan 14B a obținut cel mai mare scor general la testele Wan-Bench, depășind concurenții la:

Spre deosebire de sistemele closed-source precum Sora de la OpenAI sau Gen-2 de la Runway, Wan 2.1 este disponibil gratuit pentru rulare locală. În general, depășește modelele open-source anterioare (precum CogVideo, MAKE-A-VIDEO și Pika) și chiar multe soluții comerciale în benchmark-urile de calitate.

Un studiu recent din industrie menționa că „dintre multele modele video AI, Wan 2.1 și Sora ies în evidență” – Wan 2.1 pentru deschidere și eficiență, iar Sora pentru inovația proprietară. În testele comunității, utilizatorii au raportat că funcția image-to-video a Wan 2.1 depășește competitorii în claritate și efect cinematic.

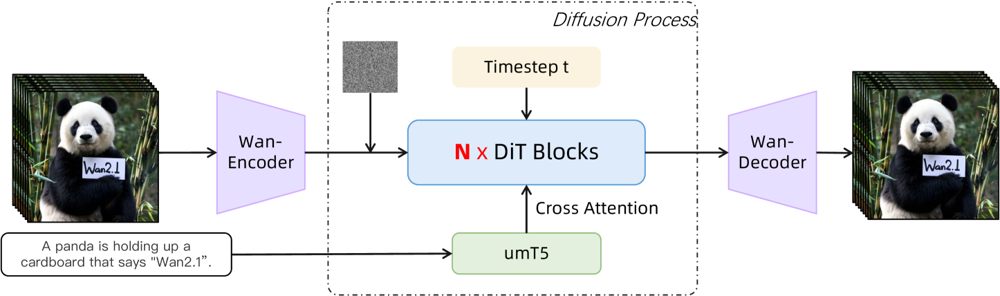

Wan 2.1 are la bază un backbone diffusion-transformer cu un VAE spațio-temporal inovator. Iată cum funcționează:

Figura: Arhitectura la nivel înalt a Wan 2.1 (cazul text-to-video). Un video (sau o imagine) este mai întâi codificat de encoderul Wan-VAE într-un latent. Acest latent trece apoi prin N blocuri diffusion transformer, care acordă atenție embedding-ului text (de la umT5) prin cross-attention. În final, decoderul Wan-VAE reconstruiește cadrele video. Acest design – care prezintă un „encoder/decoder VAE cauzal 3D în jurul unui diffusion transformer” (ar5iv.org ) – permite comprimarea eficientă a datelor spațio-temporale și suportă ieșiri video de calitate înaltă.

Această arhitectură inovatoare — cu un „encoder/decoder VAE cauzal 3D în jurul unui diffusion transformer” — permite comprimarea eficientă a datelor spațio-temporale și suportă generarea de videoclipuri de calitate înaltă.

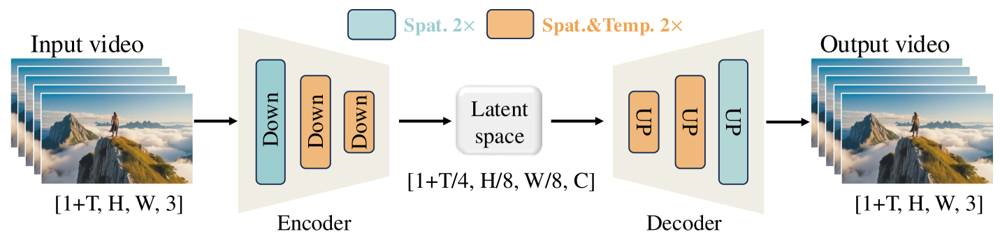

Wan-VAE este proiectat special pentru video. Comprimă intrarea cu factori impresionanți (temporal 4× și spațial 8×) într-un latent compact, înainte de a o decoda înapoi la video complet. Folosirea convoluțiilor 3D și a straturilor cauzale (ce păstrează timpul) asigură mișcare coerentă pe tot parcursul conținutului generat.

Figura: Framework-ul Wan-VAE al Wan 2.1 (encoder-decoder). Encoderul Wan-VAE (stânga) aplică o serie de straturi de down-sampling („Down”) asupra videoclipului de intrare (formă [1+T, H, W, 3] cadre) până ajunge la un latent compact ([1+T/4, H/8, W/8, C]). Decoderul Wan-VAE (dreapta) upscalează simetric („UP”) acest latent la cadrele video originale. Blocurile albastre indică comprimare spațială, iar cele portocalii comprimare spațială+temporală (ar5iv.org

). Prin comprimarea videoclipului de 256× (ca volum spațio-temporal), Wan-VAE face modelarea video high-res fezabilă pentru modelul diffusion ulterior.

Ești gata să încerci Wan 2.1? Iată cum poți începe:

Clonează repository-ul și instalează dependențele:

git clone https://github.com/Wan-Video/Wan2.1.git

cd Wan2.1

pip install -r requirements.txt

Descarcă greutățile modelului:

pip install "huggingface_hub[cli]"

huggingface-cli login

huggingface-cli download Wan-AI/Wan2.1-T2V-14B --local-dir ./Wan2.1-T2V-14B

Generează primul tău video:

python generate.py --task t2v-14B --size 1280*720 \

--ckpt_dir ./Wan2.1-T2V-14B \

--prompt "Un orizont al unui oraș futurist la apus, cu mașini zburătoare ce plutesc deasupra."

--offload_model True --t5_cpu pentru a muta părți ale modelului pe CPU--size (ex: 832*480 pentru 16:9 480p)De exemplu, un RTX 4090 poate genera un videoclip de 5 secunde la 480p în aproximativ 4 minute. Setările multi-GPU și diverse optimizări de performanță (FSDP, cuantizare etc.) sunt suportate pentru utilizare la scară largă.

Ca forță open-source ce provoacă giganții generării video AI, Wan 2.1 reprezintă o schimbare semnificativă în accesibilitate. Gratuitatea și deschiderea sa înseamnă că oricine cu un GPU decent poate explora generarea video de ultimă generație fără taxe de abonament sau costuri API.

Pentru dezvoltatori, licența open-source permite personalizarea și îmbunătățirea modelului. Cercetătorii îi pot extinde capabilitățile, iar profesioniștii creativi pot prototipa rapid și eficient conținut video.

Într-o eră în care modelele AI proprietare sunt tot mai mult blocate în spatele paywall-urilor, Wan 2.1 demonstrează că performanța de top poate fi democratizată și împărtășită cu întreaga comunitate.

Wan 2.1 este un model complet open-source de generare video cu AI dezvoltat de Tongyi Lab din cadrul Alibaba, capabil să creeze videoclipuri de înaltă calitate din prompturi text, imagini sau videoclipuri existente. Este gratuit, suportă multiple sarcini și rulează eficient pe GPU-uri de consum.

Wan 2.1 suportă generare video multi-task (text-to-video, image-to-video, editare video etc.), randare text multilingvistică în videoclipuri, eficiență ridicată prin 3D causal Video VAE și depășește multe modele comerciale și open-source în benchmark-uri.

Ai nevoie de Python 3.8+, PyTorch 2.4.0+ cu CUDA și un GPU NVIDIA (8GB+ VRAM pentru modelul mic, 16-24GB pentru modelul mare). Clonează repo-ul GitHub, instalează dependențele, descarcă greutățile modelului și folosește scripturile furnizate pentru a genera videoclipuri local.

Wan 2.1 democratizează accesul la generarea video de ultimă generație fiind open-source și gratuit, permițând dezvoltatorilor, cercetătorilor și creatorilor să experimenteze și să inoveze fără costuri sau restricții proprietare.

Spre deosebire de alternativele closed-source precum Sora sau Runway Gen-2, Wan 2.1 este complet open-source și poate fi rulat local. În general, depășește modelele open-source anterioare și se compară sau depășește multe soluții comerciale în benchmark-urile de calitate.

Arshia este Inginer de Fluxuri AI la FlowHunt. Cu o pregătire în informatică și o pasiune pentru inteligența artificială, el este specializat în crearea de fluxuri eficiente care integrează instrumente AI în sarcinile de zi cu zi, sporind productivitatea și creativitatea.

Începe să construiești propriile tale unelte AI și fluxuri de generare video cu FlowHunt sau programează o demonstrație pentru a vedea platforma în acțiune.

FlowHunt suportă acum modelele de generare video Wan 2.2 și 2.5 pentru text-la-video, imagine-la-video, înlocuire de personaje și animație. Transformă-ți proces...

Actualizarea FlowHunt din octombrie 2025 aduce modele revoluționare Wan 2.2 și 2.5 pentru generare video din text, imagine-în-video și animație, plus capabilită...

Explorează capabilitățile revoluționare ale Sora 2 în generarea de videoclipuri cu AI, de la recrearea realistă a personajelor la simularea fizicii, și descoper...

Consimțământ Cookie

Folosim cookie-uri pentru a vă îmbunătăți experiența de navigare și a analiza traficul nostru. See our privacy policy.