Observabilitatea FlowHunt în PowerBI

Învață cum să integrezi FlowHunt cu PowerBI, să configurezi setările de observabilitate și să vizualizezi metricile workspace-ului tău FlowHunt direct în dashbo...

Acest articol explică cum să conectezi FlowHunt cu Langfuse pentru o observabilitate cuprinzătoare, să urmărești performanța fluxurilor de lucru AI și să folosești dashboard-urile Langfuse pentru a monitoriza și optimiza workspace-ul tău FlowHunt.

Pe măsură ce fluxurile tale AI din FlowHunt cresc, înțelegerea a ceea ce se întâmplă în culise devine esențială. Întrebări precum „De ce este acest flux lent?”, „Câți tokeni consum?” sau „Unde apar erorile?” necesită vizibilitate detaliată asupra sistemului tău.

Fără observabilitate adecvată, depanarea fluxurilor AI este ca și cum ai zbura pe întuneric — vezi rezultatele, dar ratezi drumul. Instrumente de urmărire precum Langfuse rezolvă această problemă captând fiecare pas al execuției fluxului, oferind perspective detaliate despre performanță, costuri și comportament.

Acest articol explică cum să conectezi FlowHunt cu Langfuse rapid și ușor, activând observabilitatea completă pentru toate fluxurile tale AI. Vei învăța să urmărești căile de execuție, să monitorizezi consumul de tokeni, să identifici blocajele și să vizualizezi metrici de performanță — totul într-un singur dashboard centralizat.

La final, vei avea vizibilitate totală asupra workspace-ului tău FlowHunt, putând să optimizezi fluxurile, să reduci costurile și să asiguri fiabilitatea.

Observabilitatea este practica de a instrumenta sistemul pentru a-i înțelege starea internă prin ieșiri externe — în principal trasări, metrici și loguri.

Pentru utilizatorii FlowHunt care rulează fluxuri de lucru alimentate de AI, observabilitatea oferă vizibilitate asupra:

Fără observabilitate, diagnosticarea problemelor devine reactivă și consumatoare de timp. Cu observabilitate, obții perspective proactive care permit optimizare continuă și depanare rapidă.

Langfuse este o platformă open-source de observabilitate și analitice, construită special pentru aplicații LLM. Ea captează trasări detaliate ale execuțiilor fluxurilor AI, oferind dezvoltatorilor și echipelor informațiile necesare pentru a depana, monitoriza și optimiza sistemele AI.

Funcții cheie Langfuse:

Conectând Langfuse la FlowHunt, transformi datele brute de execuție în informații acționabile — identifici ce merge, ce nu merge și unde să te concentrezi pentru optimizare.

Urmând acest ghid vei:

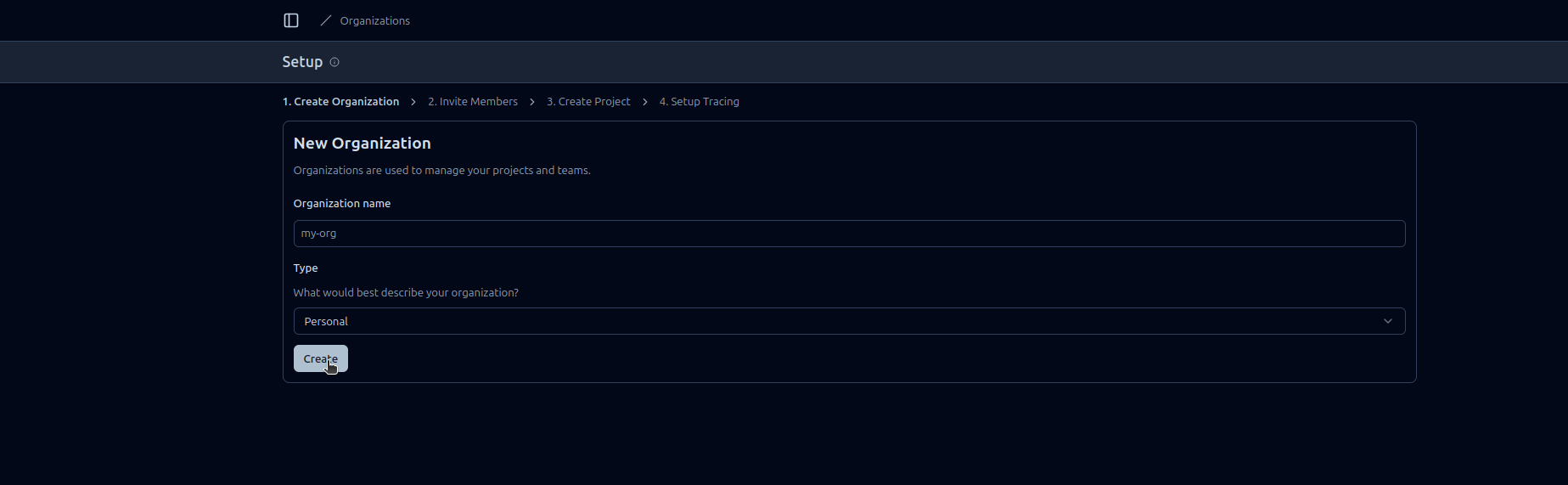

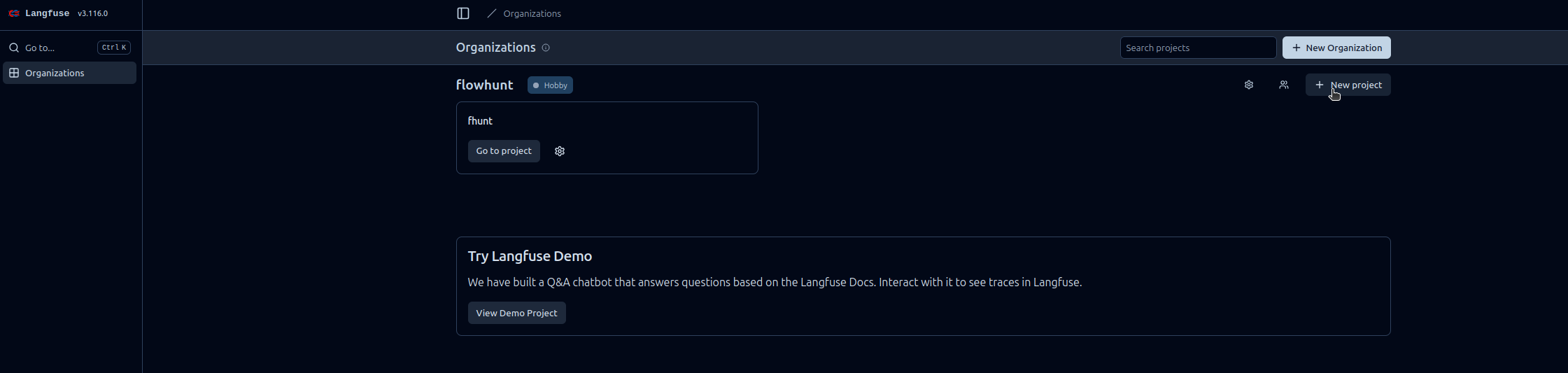

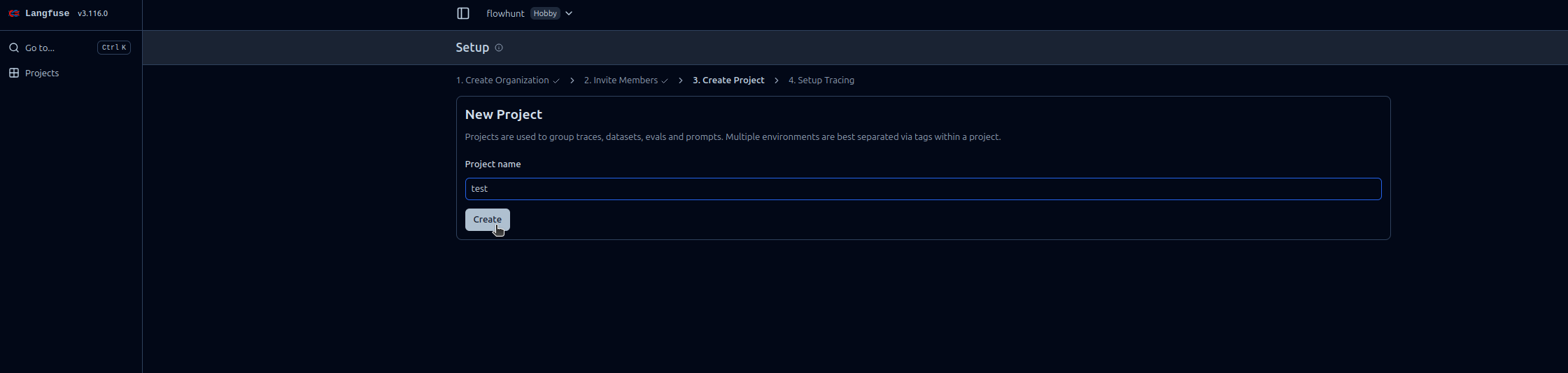

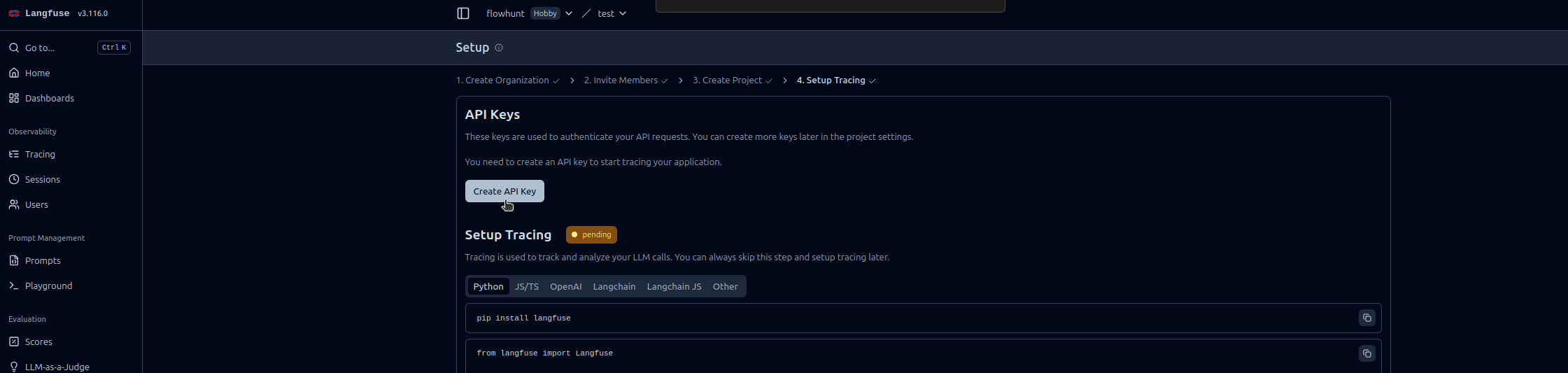

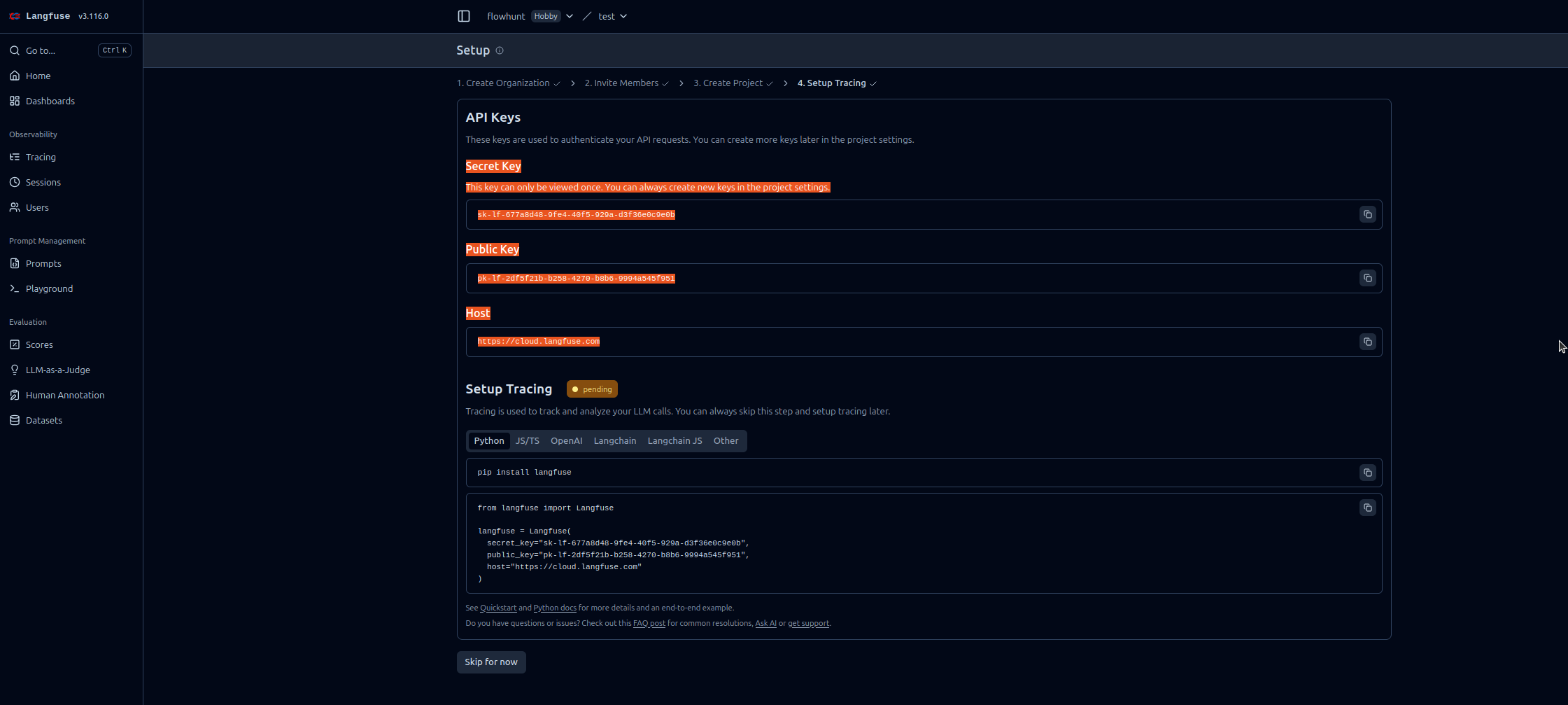

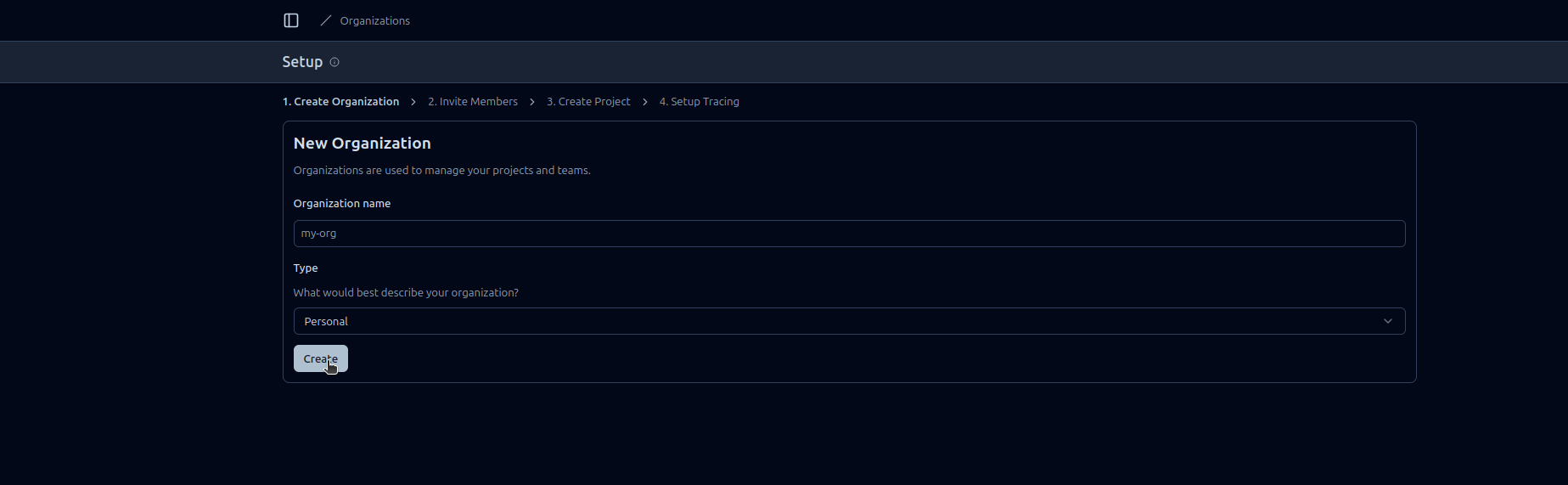

Urmează acești pași pentru a activa Observabilitatea FlowHunt în Langfuse:

https://cloud.langfuse.com)

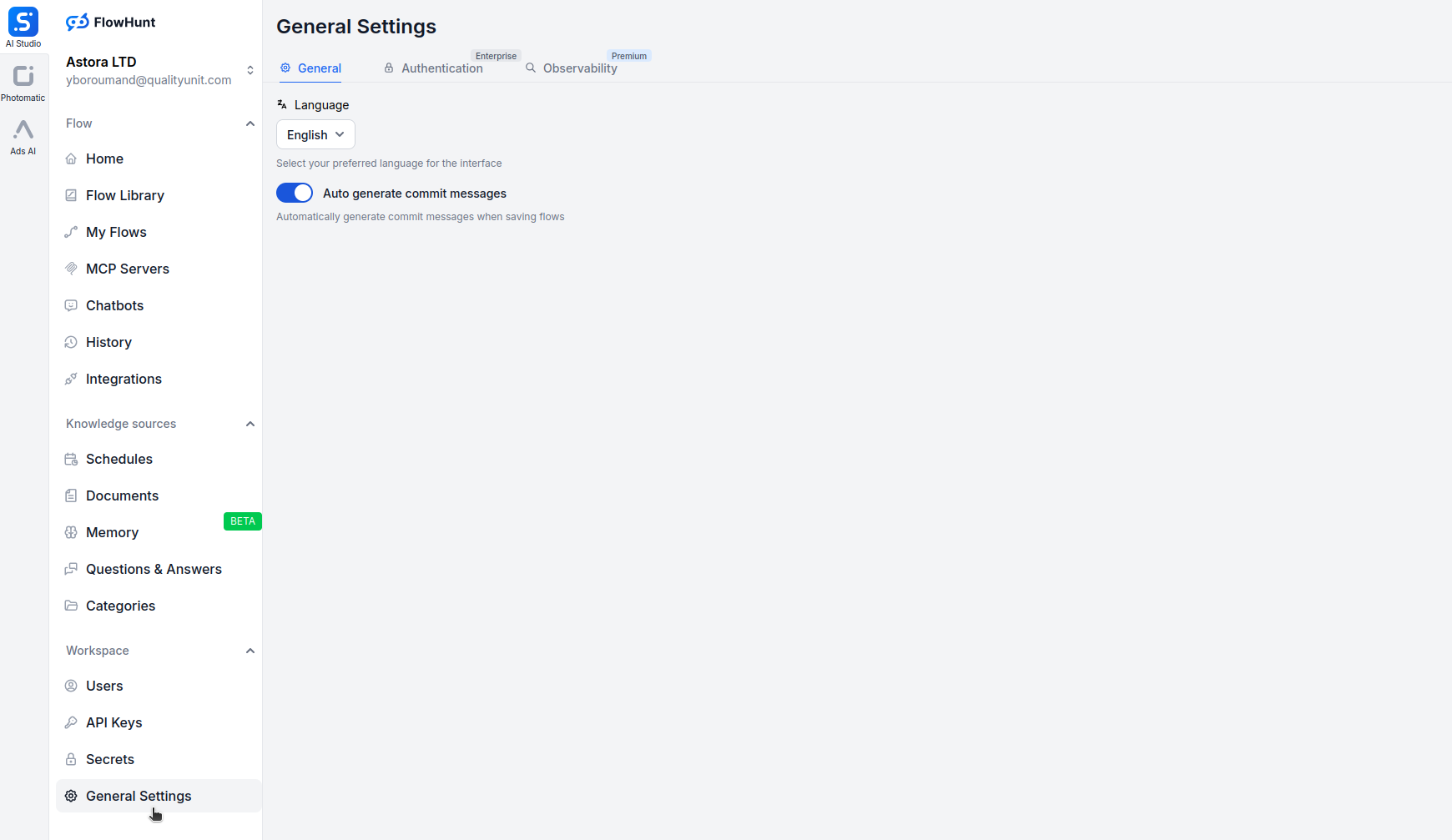

Deschide app.flowhunt.io în browser.

Navighează la General Settings (de obicei accesibile din sidebar sau meniul de sus).

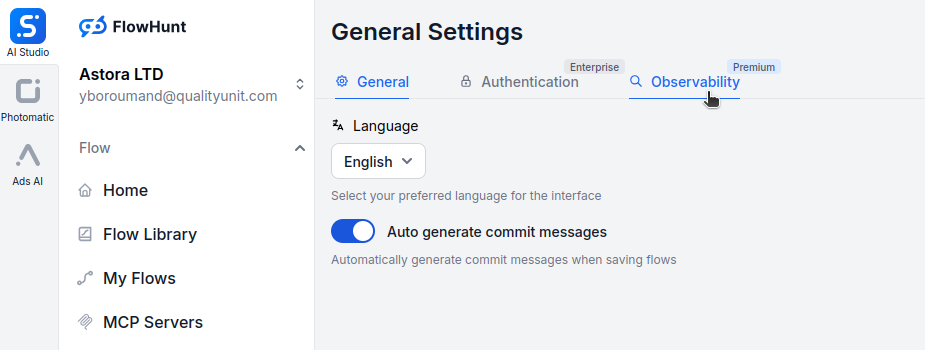

Derulează în jos și apasă pe tab-ul Observability.

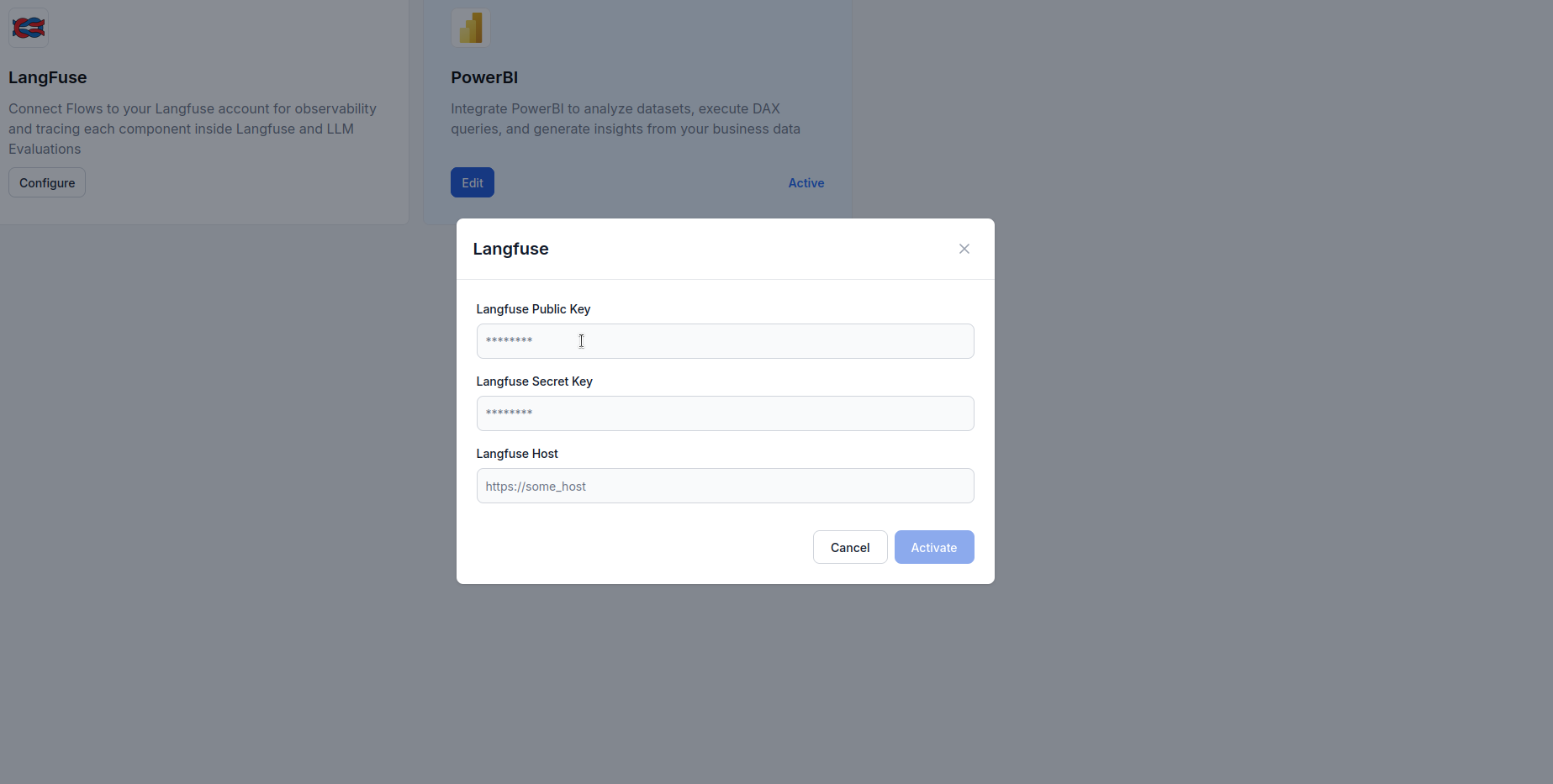

Găsește secțiunea Langfuse și apasă pe Configure.

https://cloud.langfuse.com)

Odată ce FlowHunt este conectat la Langfuse, ai acces la funcții puternice de vizualizare și analiză. Iată câteva exemple de perspective pe care le poți obține:

Vezi o cronologie detaliată a fiecărei execuții de flux, cu:

Acest lucru te ajută să identifici blocajele și să înțelegi comportamentul fluxului la un nivel detaliat.

Monitorizează consumul de tokeni în fluxuri:

Astfel poți optimiza costurile identificând operațiunile care consumă mulți tokeni.

Urmărește indicatorii cheie de performanță:

Aceste metrici ajută la menținerea SLA-urilor și optimizarea experienței utilizatorului.

Identifică și diagnostichează eșecurile:

Astfel accelerezi troubleshooting-ul și crești fiabilitatea.

Pentru agenții AI conversaționali, urmărește:

Astfel optimizezi comportamentul agentului și experiența utilizatorilor.

Compară performanța între diferiți provideri LLM:

Aceste date te ajută să alegi modelul potrivit pe baza utilizării reale.

Integrarea FlowHunt cu Langfuse transformă fluxurile tale AI din cutii negre în sisteme transparente și ușor de optimizat. Cu trasare completă, obții vizibilitate asupra fiecărui pas al execuției, permițând decizii informate privind performanța, costurile și fiabilitatea.

Integrarea de observabilitate Langfuse face monitorizarea simplă — de la o configurare rapidă cu chei API, la dashboard-uri bogate și acționabile care îți arată exact cum se comportă fluxurile tale în producție.

Acum că workspace-ul tău FlowHunt este conectat la Langfuse, ai fundația pentru îmbunătățire continuă: identifică blocajele, optimizează consumul de tokeni, reduce latența și asigură că sistemele tale AI oferă valoare maximă, cu încredere totală.

Observabilitatea în FlowHunt se referă la capacitatea de a monitoriza, urmări și analiza modul în care fluxurile AI, agenții și automatizările funcționează în timp real. Ajută utilizatorii să detecteze blocajele, să urmărească consumul de tokeni, să măsoare latența și să ia decizii de optimizare bazate pe date.

Langfuse este o platformă open-source de inginerie LLM concepută pentru urmărirea, monitorizarea și analizarea aplicațiilor AI. Când este integrat cu FlowHunt, oferă informații detaliate despre execuția fluxurilor, consumul de tokeni, performanța modelelor și urmărirea erorilor.

Nu, integrarea este simplă. Trebuie doar să-ți creezi un cont Langfuse, să generezi cheile API și să le inserezi în setările de observabilitate ale FlowHunt. Nu este necesară programarea.

După conectare, poți urmări trasabilitatea execuției, consumul de tokeni, costurile modelelor, metrici de latență, rate de erori, performanța fluxurilor în timp și detalii pas cu pas despre interacțiunile agenților AI.

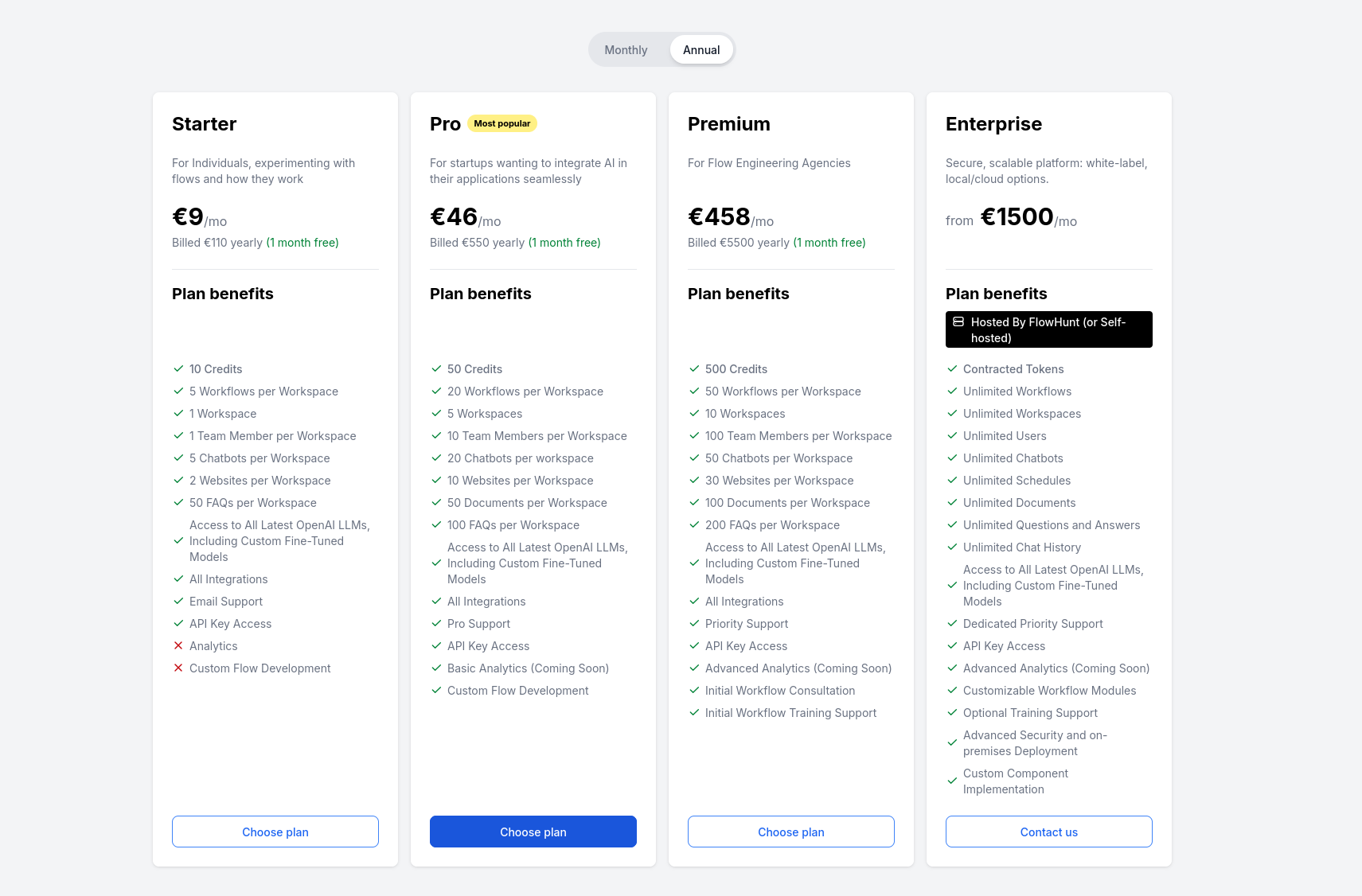

Langfuse oferă un plan gratuit care include funcții de bază de urmărire și observabilitate. Pentru echipe mai mari și analize avansate, Langfuse are planuri plătite cu capabilități suplimentare.

Învață cum să integrezi FlowHunt cu PowerBI, să configurezi setările de observabilitate și să vizualizezi metricile workspace-ului tău FlowHunt direct în dashbo...

Un ghid tehnic pentru stăpânirea integrării avansate FlowHunt cu LiveAgent, acoperind direcționarea limbii, suprimarea markdown-ului, filtrarea spamului, versio...

Un ghid cuprinzător despre prețurile FlowHunt, inclusiv cum funcționează creditele și interacțiunile, cum complexitatea influențează costurile și ce se întâmplă...