MCP Open Library MCP Server

Serverul MCP Open Library face legătura între asistenții AI și API-ul Open Library al Internet Archive, permițând căutarea și regăsirea fără efort a datelor des...

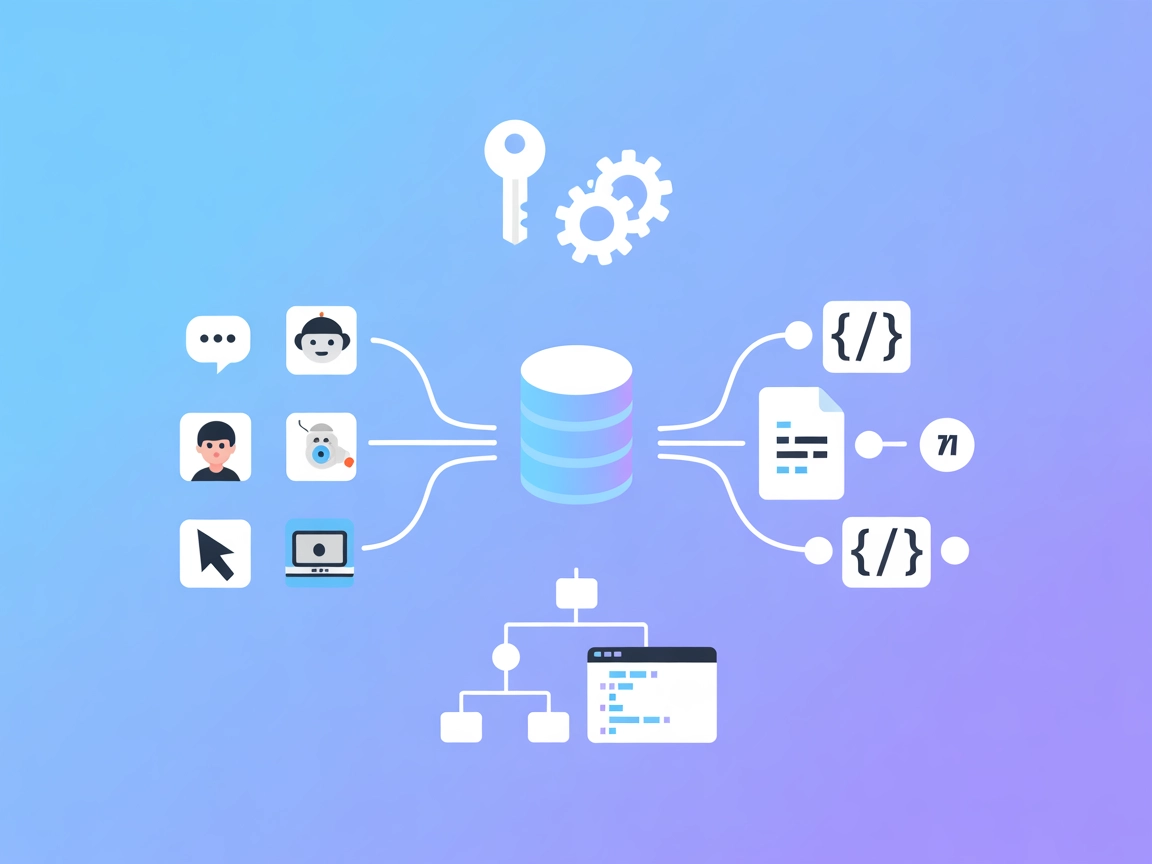

Permite asistenților AI să descopere, citească și să interacționeze semantic cu orice API compatibil OpenAPI. Perfect pentru integrarea dinamică a API-urilor private în FlowHunt.

FlowHunt oferă un strat suplimentar de securitate între sistemele dvs. interne și instrumentele AI, oferindu-vă control granular asupra instrumentelor care sunt accesibile de la serverele dvs. MCP. Serverele MCP găzduite în infrastructura noastră pot fi integrate fără probleme cu chatbotul FlowHunt, precum și cu platforme AI populare precum ChatGPT, Claude și diverși editori AI.

Serverul MCP “Orice OpenAPI” este un instrument conceput pentru a conecta asistenți AI—precum Claude—cu orice API extern care expune o specificație OpenAPI (Swagger). Permite căutarea semantică în documente OpenAPI extinse, fragmentând inteligent endpoint-urile pentru descoperire și interacțiune rapidă. Astfel, clienții AI pot descoperi endpoint-uri relevante prin întrebări în limbaj natural (ex: “listează produse”), pot accesa instant documentația completă a endpoint-ului și pot executa cereri API direct de pe server. Serverul este ideal pentru integrarea API-urilor private sau de dimensiuni mari în fluxuri de lucru AI, eficientizând operațiunile precum interogări de baze de date sau integrări API personalizate, fără actualizări manuale frecvente.

Nu există șabloane de prompt specificate în documentația sau codul disponibil.

Nu sunt listate sau descrise resurse MCP explicite în documentația sau codul disponibil.

@any-openapi/mcp-server@latest la obiectul mcpServers.OPENAPI_JSON_DOCS_URL).Exemplu JSON:

{

"mcpServers": {

"any-openapi": {

"command": "npx",

"args": ["@any-openapi/mcp-server@latest"],

"env": {

"OPENAPI_JSON_DOCS_URL": "https://yourapi.com/openapi.json"

}

}

}

}

Securizarea cheilor API:

{

"env": {

"API_KEY": "${ANY_OPENAPI_API_KEY}"

},

"inputs": {

"apiKey": "${ANY_OPENAPI_API_KEY}"

}

}

Exemplu JSON:

{

"mcpServers": {

"any-openapi": {

"command": "npx",

"args": ["@any-openapi/mcp-server@latest"],

"env": {

"OPENAPI_JSON_DOCS_URL": "https://yourapi.com/openapi.json"

}

}

}

}

@any-openapi/mcp-server@latest.Exemplu JSON:

{

"mcpServers": {

"any-openapi": {

"command": "npx",

"args": ["@any-openapi/mcp-server@latest"],

"env": {

"OPENAPI_JSON_DOCS_URL": "https://yourapi.com/openapi.json"

}

}

}

}

@any-openapi/mcp-server@latest.Exemplu JSON:

{

"mcpServers": {

"any-openapi": {

"command": "npx",

"args": ["@any-openapi/mcp-server@latest"],

"env": {

"OPENAPI_JSON_DOCS_URL": "https://yourapi.com/openapi.json"

}

}

}

}

Securizarea cheilor API:

Folosește variabile de mediu, așa cum este arătat mai sus, pentru a evita expunerea credențialelor sensibile.

Utilizarea MCP în FlowHunt

Pentru a integra servere MCP în fluxul tău FlowHunt, începe prin a adăuga componenta MCP în flux și conecteaz-o la agentul AI:

Apasă pe componenta MCP pentru a deschide panoul de configurare. În secțiunea de configurare MCP a sistemului, introdu detaliile serverului MCP folosind acest format JSON:

{

"any-openapi": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

După configurare, agentul AI poate folosi acest MCP ca unealtă cu acces la toate funcțiile și capabilitățile sale. Nu uita să schimbi “any-openapi” cu numele real al serverului MCP și să înlocuiești URL-ul cu endpoint-ul corect.

| Secțiune | Disponibilitate | Detalii/Note |

|---|---|---|

| Prezentare generală | ✅ | |

| Lista de Prompt-uri | ⛔ | Nu s-au găsit |

| Lista de Resurse | ⛔ | Nu s-au găsit |

| Lista de Unelte | ✅ | Două unelte: descoperire & execuție |

| Securizarea cheilor API | ✅ | Prin variabile de mediu |

| Suport pentru sampling (mai puțin important) | ⛔ | Nemenționat |

Suport roots: Nespecificat în documentația sau codul disponibil.

Bazându-ne pe documentația oferită și pe analiza de mai sus, acest server MCP este focusat, funcțional și foarte potrivit pentru integrarea API-urilor și descoperirea dinamică a endpoint-urilor, însă nu are prompt-uri/resurse explicite și nici documentație despre sampling sau roots. Configurarea și practicile de securitate sunt clare și standard.

Acest server MCP este foarte practic pentru dezvoltatorii care au nevoie să integreze API-uri mari sau private cu asistenți AI, în special Claude. Utilitatea sa este puternică pentru descoperirea semantică a endpoint-urilor și execuția directă a cererilor API, deși ar fi utilă mai multă documentație și definire de resurse. Per total, este un server solid, focusat, dar nu un exemplu complet al tuturor funcțiilor MCP.

Rating: 7/10

| Are o LICENȚĂ | ✅ (MIT) |

|---|---|

| Are cel puțin o unealtă | ✅ |

| Număr de Forks | 12 |

| Număr de Stele | 52 |

Permite asistenților AI precum Claude să se conecteze la orice API extern ce expune o specificație OpenAPI (Swagger). Permite descoperirea inteligentă, semantică a endpoint-urilor și execuția directă a cererilor API, făcând integrarea API-urilor private sau mari, fără întreruperi.

Serverul este proiectat pentru Claude, dar funcționează cu orice client AI care suportă servere MCP, inclusiv Windsurf, Cursor și Cline.

Folosește căutarea semantică în memorie (FAISS cu MiniLM-L3) pentru a găsi endpoint-uri relevante din documentele OpenAPI pe baza unor întrebări în limbaj natural.

Da. Folosește întotdeauna variabile de mediu pentru chei API și alte date sensibile, așa cum este arătat în exemplele de configurare.

Da. Odată ce un endpoint relevant este descoperit, serverul permite AI-ului să execute cereri API, obținând date live sau efectuând acțiuni prin API.

Integrarea API-urilor private, automatizarea fluxurilor de lucru precum listarea produselor sau administrarea utilizatorilor și descoperirea rapidă și utilizarea endpoint-urilor în API-urile mari.

Maximizează-ți fluxurile AI conectând Claude sau alți asistenți la orice API bazat pe OpenAPI. Experimentează integrarea API-urilor fără întreruperi, sigură și dinamică!

Serverul MCP Open Library face legătura între asistenții AI și API-ul Open Library al Internet Archive, permițând căutarea și regăsirea fără efort a datelor des...

OpenAPI MCP Server conectează asistenții AI cu capacitatea de a explora și înțelege specificațiile OpenAPI, oferind context detaliat despre API, rezumate și inf...

Serverul OpenAPI Schema MCP expune specificațiile OpenAPI către Modele Mari de Limbaj, permițând explorarea API-urilor, căutarea în scheme, generarea de cod și ...

Consimțământ Cookie

Folosim cookie-uri pentru a vă îmbunătăți experiența de navigare și a analiza traficul nostru. See our privacy policy.