OpenAI O3 Mini vs DeepSeek na agentívne použitie

Porovnajte OpenAI O3 Mini a DeepSeek pri úlohách z oblasti uvažovania, šachovej stratégie a agentívneho využitia nástrojov. Zistite, ktorý AI model vyniká v pre...

Hĺbková analýza modelu na uvažovanie EXAONE Deep 32B od LG, testovaného voči DeepSeek R1 a Alibaba QwQ, so zameraním na tvrdenia o nadpriemernom výkone a skutočné schopnosti logického uvažovania.

Oblasť modelov umelej inteligencie zameraných na logické uvažovanie je čoraz konkurenčnejšia – viaceré organizácie deklarujú prelomové výsledky pri zložitých matematických a logických úlohách. Nedávne uvedenie modelu EXAONE Deep od LG, modelu na uvažovanie so 32 miliardami parametrov, vzbudilo pozornosť tvrdeniami o prekonaní etablovaných konkurentov, ako je DeepSeek R1. Reálne testy však ukazujú komplexnejší obraz, než naznačuje marketing. Tento článok poskytuje hlbokú analýzu skutočného výkonu EXAONE Deep v porovnaní s ďalšími poprednými modelmi na uvažovanie, skúma rozdiel medzi deklarovanými benchmarkmi a praktickými výsledkami. Prostredníctvom praktického testovania a detailného porovnania preskúmame, čo tieto modely skutočne dokážu, ako zvládajú komplexné úlohy a čo to znamená pre organizácie, ktoré ich chcú nasadiť do produkcie.

Vzostup modelov na uvažovanie predstavuje zásadnú zmenu v tom, ako umelá inteligencia pristupuje k riešeniu zložitých problémov. Na rozdiel od tradičných jazykových modelov, ktoré generujú odpovede v jednom kroku, modely na uvažovanie využívajú techniku známy ako test-time decoding, pri ktorej počas inferencie prideľujú značné výpočtové zdroje na postupné premýšľanie nad problémom. Tento prístup napodobňuje ľudské uvažovanie, keď často potrebujeme prejsť viacerými úvahami, kým sa dopracujeme k riešeniu. Koncept sa stal známym vďaka modelu o1 od OpenAI a odvtedy ho prebrali viaceré organizácie vrátane DeepSeek, Alibaba a najnovšie LG. Tieto modely generujú tzv. „thinking“ alebo „reasoning“ tokeny, ktoré používateľ väčšinou nevidí vo finálnom výstupe, no reprezentujú vnútorný proces uvažovania modelu. Tieto tokeny majú kľúčový význam, pretože umožňujú modelu skúmať rôzne cesty riešenia, zachytiť chyby a vylepšiť prístup pred konečnou odpoveďou. To je zvlášť cenné pri matematických úlohách, logických zadaniach či komplexných viacstupňových scenároch, kde by jednorazové spracovanie mohlo dôležité detaily prehliadnuť alebo viesť k nesprávnym záverom.

Pre organizácie implementujúce AI systémy predstavujú modely na uvažovanie významný pokrok v spoľahlivosti a presnosti pri riešení zložitých úloh. Tradičné jazykové modely často zápasia s viacstupňovými matematickými problémami, logickou dedukciou a situáciami vyžadujúcimi detailnú analýzu obmedzení. Modely na uvažovanie tieto limity prekonávajú tým, že výslovne ukazujú svoj myšlienkový postup, čo zároveň poskytuje transparentnosť v tom, ako model k záveru dospel. Táto transparentnosť je obzvlášť dôležitá vo firemných prostrediach, kde sú rozhodnutia na základe odporúčaní AI auditovateľné a vysvetliteľné. Nevýhodou je však vyššia výpočtová náročnosť a latencia. Pretože modely generujú množstvo „thinking“ tokenov pred finálnou odpoveďou, vyžadujú viac výpočtového výkonu a odpovedajú pomalšie než štandardné jazykové modely. Výber modelu je preto kľúčový – organizácie musia chápať nielen výsledky benchmarkov, ale aj reálny výkon na ich konkrétnych úlohách. Pribúdajúce modely od rôznych dodávateľov, každý s tvrdeniami o nadpriemernom výkone, robia nezávislé testovanie a porovnávanie nevyhnutným pre kvalifikované rozhodnutia o nasadení.

Vstup LG na trh modelov na uvažovanie s EXAONE Deep vyvolal veľký záujem, najmä vzhľadom na výskumné kapacity spoločnosti a relatívne skromnú veľkosť modelu s 32 miliardami parametrov. Marketingové materiály LG prezentovali pôsobivé výsledky benchmarkov – EXAONE Deep mal dosiahnuť 90 % úspešnosť v súťaži AIME (American Invitational Mathematics Examination) pri len 64 pokusoch a 95 % na úlohách MATH-500. Ak by boli tieto čísla presné, výkon by bol porovnateľný alebo lepší než DeepSeek R1 a QwQ od Alibaby. Spoločnosť uviedla aj viacero veľkostí modelu, vrátane 2,4-miliardovej varianty určenej ako návrhový model v rámci špekulatívneho dekódovania – techniky, ktorá využíva menšie modely na predikciu tokenov väčšieho modelu a tým môže zrýchliť inferenciu. Pri praktickom testovaní na štandardných úlohách však EXAONE Deep vykazoval znepokojujúce správanie v rozpore s deklarovanými benchmarkmi. Model mal tendenciu upadnúť do zdĺhavých slučiek premýšľania bez dosiahnutia logického záveru, generoval tisícky tokenov, ktoré boli skôr opakujúce sa či nezmyselné ako produktívne uvažovanie. Toto správanie poukazuje na možné problémy s trénovaním modelu, metodikou hodnotenia benchmarkov alebo spôsobom, akým model spracováva niektoré typy promptov.

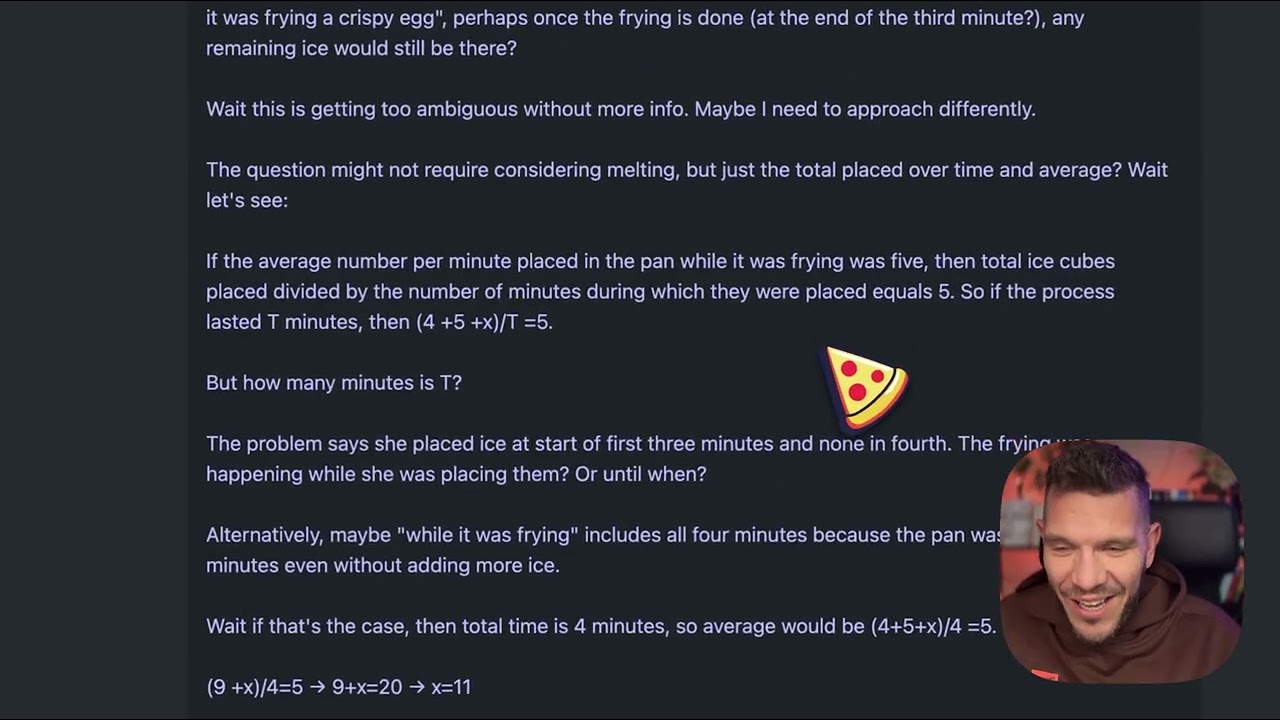

Na pochopenie praktických rozdielov medzi modelmi na uvažovanie si vezmime naoko jednoduchý problém, ktorý sa stal štandardným testom kvality týchto modelov: „Beth dá do panvice niekoľko celých kociek ľadu. Po minúte je v panvici 20 kociek, po dvoch minútach 10, po troch 0. Koľko celých kociek ľadu je v panvici na konci tretej minúty?“ Správna odpoveď je nula, keďže zadanie sa výslovne pýta na celé kocky na konci tretej minúty a problém uvádza, že vtedy sú nula. Problém je však koncipovaný tak, aby zmiatol modely, ktoré priveľmi premýšľajú alebo sa nechajú zmiasť príbehom o topiacich sa kockách. Niektoré modely môžu predpokladať, že kocky sa topia postupne a snažiť sa vypočítať ich úbytok, čím sa odklonia od jednoduchej odpovede. Pri testovaní EXAONE Deep na tomto probléme model vygeneroval asi 5 000 tokenov premýšľania bez toho, aby dospel k zmysluplnému záveru. Proces uvažovania modelu sa vymkol kontrole, generovaný text bol čoraz nezrozumiteľnejší, neboli jasne artikulované postupy ani finálna odpoveď. Generované úryvky často netvorili celistvé myšlienky a model nikdy jasne nevysvetlil svoj postup či záver. Tento výkon ostro kontrastuje s tým, ako by mal byť problém riešený – model na uvažovanie by mal rozpoznať „chyták“, jasne prejsť logikou a efektívne dospieť k správnej odpovedi.

Rovnaký problém s kockami ľadu bol testovaný na DeepSeek R1 a Alibaba QwQ, pričom oba modely podali výrazne lepší výkon. DeepSeek R1 vygeneroval jasný postup uvažovania, prešiel problémom systematicky a dospel k správnej odpovedi – nula. Jeho uvažovanie bolo transparentné a logické, ukazovalo, ako hodnotil problém, rozpoznal „chyták“ a určil správnu odpoveď. QwQ tiež ukázal silný výkon, hoci generoval dlhší postup uvažovania. Zaujímavé je, že QwQ najprv zvažoval, či kocky topia fyzikálne alebo matematicky, ale napokon dospel ku správnemu záveru. Kľúčový rozdiel bol, že oba modely vykazovali zrozumiteľné uvažovanie počas celého procesu, aj pri skúmaní viacerých možností. Vedeli rozpoznať, kedy už majú dosť informácií na odpoveď a tú aj vyslovili. EXAONE Deep, naopak, nikdy tento bod nedosiahol – pokračoval v generovaní tokenov bez jasného cieľa, nikdy sa neustálil na odpovedi, ani nepreukázal konzistentný logický postup. To naznačuje zásadné problémy v spôsoboch, akými model zvláda úlohy uvažovania, napriek pôsobivým benchmarkovým tvrdeniam.

Zaujímavým technickým aspektom uvedenia EXAONE Deep je zahrnutie viacerých veľkostí modelu na spoločné použitie prostredníctvom špekulatívneho dekódovania. 2,4-miliardová verzia môže slúžiť ako návrhový model, ktorý predikuje tokeny, ktoré by vygeneroval väčší 32-miliardový model. Ak sa predikcie návrhového modelu zhodujú s generovaním hlavného modelu, systém môže preskočiť výpočet hlavného modelu a použiť návrhovú predikciu, čím sa efektívne zrýchli inferencia. Ide o sofistikovanú optimalizačnú techniku, ktorá môže výrazne znížiť latenciu a výpočtové nároky. Pri testovaní implementácia ukazovala zelené tokeny ako indikátor úspešných návrhových predikcií, čo naznačuje, že technika fungovala podľa očakávania. Táto optimalizácia však nerieši základný problém kvality uvažovania hlavného modelu – rýchlejšia inferencia zlého uvažovania je stále len zlé uvažovanie. Prítomnosť tejto optimalizácie navyše vyvoláva otázky, či LG nedosiahlo benchmarkové výsledky práve pomocou konfigurácií či techník, ktoré sa v reálnych podmienkach nedajú plnohodnotne replikovať.

Pre organizácie, ktoré zápasia s hodnotením a porovnávaním viacerých AI modelov, poskytuje FlowHunt komplexnú automatizačnú platformu, ktorá zjednodušuje proces testovania a benchmarkovania. Namiesto manuálneho testovania jednotlivých modelov a porovnávania výsledkov umožňuje FlowHunt tímom nastaviť automatizované pracovné postupy na systematické hodnotenie výkonu modelov v rôznych dimenziách. Je to obzvlášť cenné pri porovnávaní modelov na uvažovanie, kde môže výkon výrazne závisieť od typu úlohy, zložitosti či konkrétneho promptu. Automatizačné možnosti FlowHunt umožňujú testovať modely na štandardizovaných sadách problémov, sledovať výkonnostné metriky v čase a generovať komplexné porovnávacie reporty. Platforma sa dokáže integrovať s viacerými poskytovateľmi modelov a API, takže je možné hodnotiť modely od rôznych dodávateľov v rámci jednotného workflowu. Pre tímy zvažujúce nasadenie modelov ako EXAONE Deep, DeepSeek R1 či QwQ poskytuje FlowHunt infraštruktúru na rozhodovanie založené na skutočnom výkone, nie len na tvrdeniach predajcu. Automatizácia opakovaných testovacích úloh zároveň uvoľňuje kapacity inžinierov na integráciu a optimalizáciu namiesto manuálneho benchmarkingu.

Rozdiel medzi deklarovaným výkonom EXAONE Deep a jeho skutočným správaním v testoch poukazuje na dôležitú lekciu pre adopciu AI: výsledky prezentované dodávateľom je vždy potrebné overiť nezávislým testovaním. Výsledky benchmarkov môže ovplyvniť mnoho faktorov, vrátane konkrétnej testovacej sady, metodiky hodnotenia, hardvérovej konfigurácie či parametrov inferencie. Model môže podávať vynikajúci výkon na určitom benchmarci, ale zlyhávať na iných typoch úloh alebo v reálnych scenároch. Preto majú organizácie ako Weights & Biases a nezávislí výskumníci v AI ekosystéme kľúčovú úlohu – poskytujú nestranné testovanie a analýzu, ktoré komunite umožňujú pochopiť skutočné možnosti modelov. Pri hodnotení modelov na uvažovanie pre produkčné nasadenie by organizácie mali vykonať vlastné testy na reprezentatívnych úlohách zo svojho doménového prostredia. Model vynikajúci v matematickom uvažovaní môže zlyhávať v logickej dedukcii či generovaní kódu. Problém s kockami ľadu, hoci na pohľad jednoduchý, je užitočný diagnostický test – ukáže, či model zvláda „chytáky“ a dokáže sa vyhnúť premýšľaniu do prázdna. Modely, ktoré na takýchto úlohách zlyhajú, budú pravdepodobne zápasiť aj so zložitejšími úlohami uvažovania.

Pozorované dlhé slučky premýšľania pri EXAONE Deep môžu mať niekoľko možných príčin. Jednou je, že model počas trénovania nebol dostatočne naučený, kedy prestať premýšľať a vysloviť odpoveď. Modely na uvažovanie vyžadujú pri trénovaní citlivú kalibráciu, aby sa vyvážili výhody rozšíreného premýšľania s rizikom „prepremýšľania“ a generovania neproduktívnych tokenov. Ak trénovanie neobsahovalo dostatok príkladov, kedy skončiť, model môže generovať tokeny až do dosiahnutia maxima. Ďalšou možnosťou je problém so spracovaním promptov, najmä so spôsobom, akým model interpretuje niektoré typy otázok či pokynov. Niektoré modely sú citlivé na špecifické formulácie promptov a môžu sa podľa toho správať rozdielne. Skutočnosť, že EXAONE Deep generoval nezrozumiteľné sekvencie tokenov, naznačuje, že model mohol upadnúť do stavu, keď generuje tokeny bez zmysluplného obsahu, čo môže poukazovať na problémy s mechanizmami pozornosti alebo logikou predikcie tokenov. Treťou možnosťou je, že metodika hodnotenia benchmarkov využívala iné konfigurácie alebo stratégie promptovania, než boli použité v reálnom testovaní, čo mohlo viesť k veľkému rozdielu medzi deklarovanými a skutočnými výsledkami.

Pozorované problémy s výkonom EXAONE Deep majú širšie dôsledky pre trh modelov na uvažovanie. S rastúcim počtom modelov hrozí trhu presýtenie modelmi s pôsobivými deklarovanými výsledkami, no pochybným reálnym výkonom. Pre organizácie vyberajúce modely na produkčné použitie to znamená náročné prostredie. Riešením je dôraz na nezávislé testovanie, štandardizované metodiky hodnotenia a transparentnosť ohľadom limitov modelov. Priestor modelov na uvažovanie by profitoval zo zavedenia priemyselných štandardov na hodnotenie a porovnávanie, podobne ako sa vyvíjali iné AI benchmarky. Zároveň by si organizácie mali dávať pozor na modely, ktoré deklarujú výrazne lepší výkon než etablovaná konkurencia, najmä ak taký rozdiel nezodpovedá architektúre alebo trénovaniu modelu. DeepSeek R1 a QwQ opakovane preukázali konzistentný výkon v rôznych scenároch, čo posilňuje dôveru v ich schopnosti. Nekonzistentný výkon EXAONE Deep – výborné benchmarkové tvrdenia, no slabé reálne výsledky – naznačuje buď problémy samotného modelu, alebo spôsobu vykonania benchmarkov.

Zažite, ako FlowHunt automatizuje vaše AI a SEO pracovné toky — od výskumu a generovania obsahu až po publikovanie a analytiku — všetko na jednom mieste.

Organizácie, ktoré zvažujú nasadenie modelov na uvažovanie, by mali postupovať podľa štruktúrovaného procesu hodnotenia. Najskôr si vytvorte reprezentatívnu testovaciu sadu s úlohami z vašej domény alebo prípadu použitia. Generické benchmarky nemusia odrážať, ako bude model fungovať na vašich reálnych úlohách. Následne testujte viacero modelov na rovnakých úlohách pre priame porovnanie – to si vyžaduje štandardizáciu testovacieho prostredia, vrátane hardvéru, parametrov inferencie a formulácie promptov. Hodnoťte nielen presnosť, ale aj metriky efektivity ako latencia a počet generovaných tokenov. Model, ktorý síce odpovie správne, ale potrebuje na to 10 000 „thinking“ tokenov, nie je praktický, ak potrebujete odpovede v reálnom čase. Skúmajte aj samotný proces uvažovania modelu, nielen finálnu odpoveď – model, ktorý dosiahne správnu odpoveď chybným postupom, môže zlyhať na podobných úlohách s inými parametrami. Testujte aj hraničné prípady a „chytáky“, aby ste pochopili, ako model zvláda zmätočné scenáre. Nakoniec zvážte celkové náklady na vlastníctvo – nielen licenčné alebo API poplatky, ale aj výpočtové zdroje potrebné na inferenciu a inžinierske úsilie na integráciu.

EXAONE Deep so svojimi 32 miliardami parametrov je výrazne menší než niektoré konkurenčné modely na uvažovanie, čo vyvoláva otázku, či problémy modelu nesúvisia s nedostatočnou kapacitou. Veľkosť modelu však sama o sebe neurčuje schopnosti uvažovania – QwQ, ktorý sa pohybuje v podobnom rozsahu parametrov, vykazuje silný výkon. To naznačuje, že problémy EXAONE Deep sú pravdepodobnejšie spôsobené metodikou trénovania, návrhom architektúry alebo konfiguráciou inferencie, nie samotnou veľkosťou modelu. Zahrnutie 2,4-miliardového návrhového modelu v rámci EXAONE Deep ukazuje, že LG myslí na efektivitu, čo je chvályhodné. Efektivita však má zmysel len vtedy, ak základný model produkuje správne výsledky – rýchla nesprávna odpoveď je vo väčšine produkčných scenárov horšia než pomalá správna. Trh modelov na uvažovanie bude pravdepodobne aj naďalej klásť dôraz na efektivitu pri nasadzovaní týchto modelov v rozsahu, no táto optimalizácia nesmie byť na úkor kvality uvažovania.

Priestor modelov na uvažovanie je stále v ranom štádiu a môžeme očakávať zásadný vývoj v najbližších mesiacoch a rokoch. Ako budú pribúdať nové modely a nezávislé testy, trh sa pravdepodobne konsoliduje okolo modelov s konzistentným a spoľahlivým výkonom. Organizácie ako DeepSeek a Alibaba si vybudovali dôveru vďaka stabilným výsledkom, zatiaľ čo noví hráči ako LG budú musieť najskôr vyriešiť pozorované problémy s výkonom, aby získali prijatie na trhu. Môžeme tiež očakávať ďalšie inovácie v trénovaní a hodnotení modelov na uvažovanie. Súčasný prístup s generovaním rozsiahlych „thinking“ tokenov je účinný, ale výpočtovo náročný. Budúce modely môžu priniesť efektívnejšie mechanizmy uvažovania, ktoré dosiahnu podobnú presnosť s menším počtom tokenov. Pravdepodobne sa objaví aj väčšia špecializácia – modely optimalizované na konkrétne domény, ako sú matematika, generovanie kódu alebo logické uvažovanie. Integrácia modelov na uvažovanie s inými AI technikami, ako je generovanie s podporou vyhľadávania (retrieval-augmented generation) či využívanie nástrojov, ešte viac rozšíri ich možnosti a použiteľnosť.

LG EXAONE Deep predstavuje ambiciózny vstup na trh modelov na uvažovanie, no reálne testy odhaľujú výrazné rozdiely medzi deklarovaným výkonom a skutočnými schopnosťami modelu. Hoci benchmarkové výsledky naznačujú konkurencieschopnosť s DeepSeek R1 a QwQ od Alibaby, praktické testovanie na štandardných úlohách ukazuje, že EXAONE Deep má problém aj so základnými úlohami – generuje nadmerné množstvo tokenov bez dosiahnutia zrozumiteľného záveru. DeepSeek R1 aj QwQ podali na rovnakých úlohách lepší výkon, pričom k správnym odpovediam dospeli jasným, logickým uvažovaním. Pre organizácie hodnotiace modely na uvažovanie pre produkčné nasadenie táto analýza zdôrazňuje kľúčový význam nezávislého testovania a overovania. Benchmarky od dodávateľa treba vnímať len ako východisko na hodnotenie, nie ako konečné meradlo schopností modelu. Trh modelov na uvažovanie bude profitovať z väčšej transparentnosti, štandardizovaných metodík hodnotenia a pokračujúceho nezávislého testovania výskumnou komunitou. S dozrievaním tejto technológie budú organizácie, ktoré investujú do dôsledného hodnotenia a porovnávania modelov, lepšie pripravené vybrať a nasadiť modely na uvažovanie, ktoré prinesú skutočnú hodnotu pre ich špecifické použitia.

EXAONE Deep je model na uvažovanie s 32 miliardami parametrov vyvinutý spoločnosťou LG, ktorý využíva techniku test-time decoding na riešenie zložitých úloh. Na rozdiel od štandardných jazykových modelov prideľuje počas inferencie viac výpočtových zdrojov, aby postupne premýšľal nad problémami, podobne ako modely DeepSeek R1 a QwQ od Alibaby.

V praktickom testovaní na úlohách uvažovania, ako je problém s kockami ľadu, EXAONE Deep vykazoval výrazné problémy s "prepremýšľaním" a generovaním nadmerného počtu tokenov bez dosiahnutia logických záverov. DeepSeek R1 aj QwQ podali lepší výkon, keďže k správnym odpovediam dospeli efektívnejšie.

Test-time decoding je technika, pri ktorej modely AI počas inferencie prideľujú viac výpočtových zdrojov na premyslenie zložitých problémov. Modely tak môžu ukázať svoj myšlienkový postup a dospieť k presnejším odpovediam, hoci si to vyžaduje citlivé nastavenie, aby sa predišlo premýšľaniu do prázdna.

FlowHunt automatizuje pracovný postup testovania, porovnávania a hodnotenia viacerých AI modelov, čo tímom umožňuje systematicky porovnávať výkonnosť, sledovať metriky a robiť rozhodnutia na základe dát o tom, ktoré modely nasadiť pre konkrétne použitia.

Arshia je inžinierka AI workflowov v spoločnosti FlowHunt. S pozadím v informatike a vášňou pre umelú inteligenciu sa špecializuje na tvorbu efektívnych workflowov, ktoré integrujú AI nástroje do každodenných úloh, čím zvyšuje produktivitu a kreativitu.

Využite FlowHunt na zjednodušenie testovania, porovnávania a sledovania výkonu AI modelov pomocou inteligentnej automatizácie.

Porovnajte OpenAI O3 Mini a DeepSeek pri úlohách z oblasti uvažovania, šachovej stratégie a agentívneho využitia nástrojov. Zistite, ktorý AI model vyniká v pre...

Objavte, ako malý model s 7 miliónmi parametrov prekonáva Gemini, DeepSeek a Claude vďaka rekurzívnemu uvažovaniu a hlbokému dozoru. Spoznajte revolučný prístup...

Preskúmajte svet modelov AI agentov prostredníctvom komplexnej analýzy 20 špičkových systémov. Objavte, ako premýšľajú, uvažujú a plnia rôzne úlohy a pochopte n...

Súhlas s cookies

Používame cookies na vylepšenie vášho prehliadania a analýzu našej návštevnosti. See our privacy policy.