Umelé neurónové siete (ANNs)

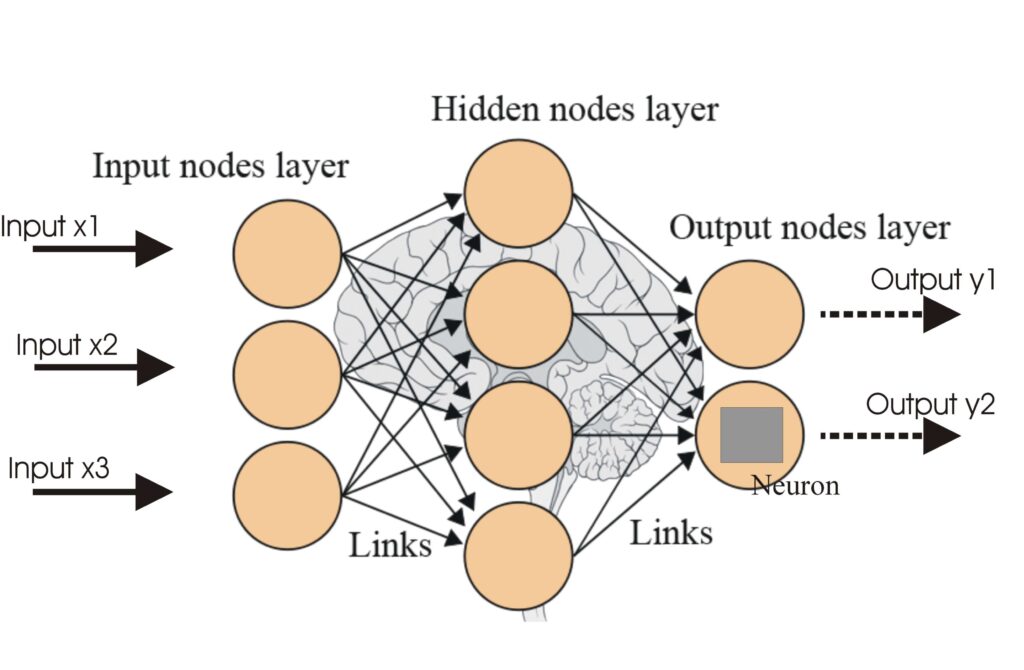

Umelé neurónové siete (ANNs) sú podmnožinou algoritmov strojového učenia inšpirovaných ľudským mozgom. Tieto výpočtové modely pozostávajú z prepojených uzlov al...

Aktivačné funkcie vnášajú nelinearitu do neurónových sietí, čím im umožňujú učiť sa zložité vzorce nevyhnutné pre AI a hlboké učenie.

Aktivačné funkcie sú základným prvkom architektúry umelých neurónových sietí (ANN), ktoré významne ovplyvňujú schopnosť siete učiť sa a vykonávať zložité úlohy. Tento slovníkový článok sa venuje zložitostiam aktivačných funkcií, skúma ich účel, typy a aplikácie, najmä v oblasti AI, hlbokého učenia a neurónových sietí.

Aktivačná funkcia v neurónovej sieti je matematická operácia aplikovaná na výstup neurónu. Určuje, či má byť neurón aktivovaný, a vnáša do modelu nelinearitu, ktorá umožňuje sieti učiť sa zložité vzorce. Bez týchto funkcií by sa neurónová sieť v podstate správala ako lineárny regresný model, bez ohľadu na jej hĺbku alebo počet vrstiev.

Sigmoid

Tanh

ReLU (Rectified Linear Unit)

Leaky ReLU

Softmax

Swish

Aktivačné funkcie sú neoddeliteľnou súčasťou viacerých AI aplikácií, vrátane:

Aktivačná funkcia je matematická operácia aplikovaná na výstup neurónu, ktorá vnáša nelinearitu a umožňuje neurónovým sieťam učiť sa zložité vzorce nad rámec jednoduchých lineárnych vzťahov.

Aktivačné funkcie umožňujú neurónovým sieťam riešiť zložité, nelineárne problémy tým, že umožňujú učenie zložitých vzorcov, vďaka čomu sú nevyhnutné pre úlohy ako klasifikácia obrázkov, spracovanie jazyka a automatizácia.

Bežné typy zahŕňajú Sigmoid, Tanh, ReLU, Leaky ReLU, Softmax a Swish, pričom každá má jedinečné vlastnosti a využitie v rôznych vrstvách neurónových sietí.

Bežné výzvy zahŕňajú problém miznúcich gradientov (najmä pri Sigmoid a Tanh), 'umierajúce' ReLU a výpočtovú náročnosť funkcií ako Softmax v aplikáciách v reálnom čase.

Inteligentné chatboty a AI nástroje pod jednou strechou. Prepojte intuitívne bloky a premeňte svoje nápady na automatizované Flows.

Umelé neurónové siete (ANNs) sú podmnožinou algoritmov strojového učenia inšpirovaných ľudským mozgom. Tieto výpočtové modely pozostávajú z prepojených uzlov al...

Neuronová sieť, alebo umelá neuronová sieť (ANN), je výpočtový model inšpirovaný ľudským mozgom, ktorý je nevyhnutný v AI a strojovom učení na úlohy ako rozpozn...

Hlboko-veriaca sieť (DBN) je sofistikovaný generatívny model využívajúci hlboké architektúry a obmedzené Boltzmannove stroje (RBM) na učenie hierarchických repr...

Súhlas s cookies

Používame cookies na vylepšenie vášho prehliadania a analýzu našej návštevnosti. See our privacy policy.