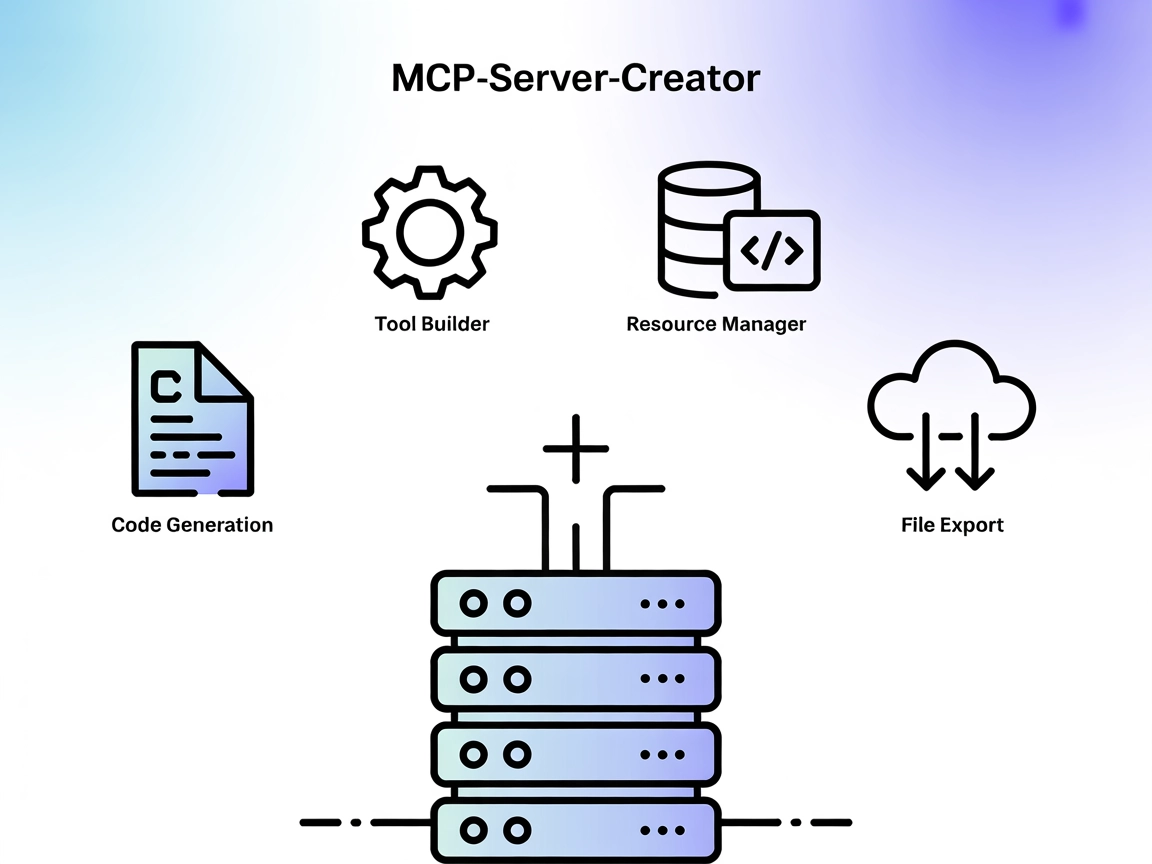

MCP-Server-Creator MCP-server

MCP-Server-Creator är en meta-server som möjliggör snabb skapande och konfiguration av nya Model Context Protocol (MCP) servrar. Med dynamisk kodgenerering, ver...

Kör Python-kod, installera beroenden och hantera isolerade miljöer direkt i dina FlowHunt-flöden med MCP Code Executor MCP Server.

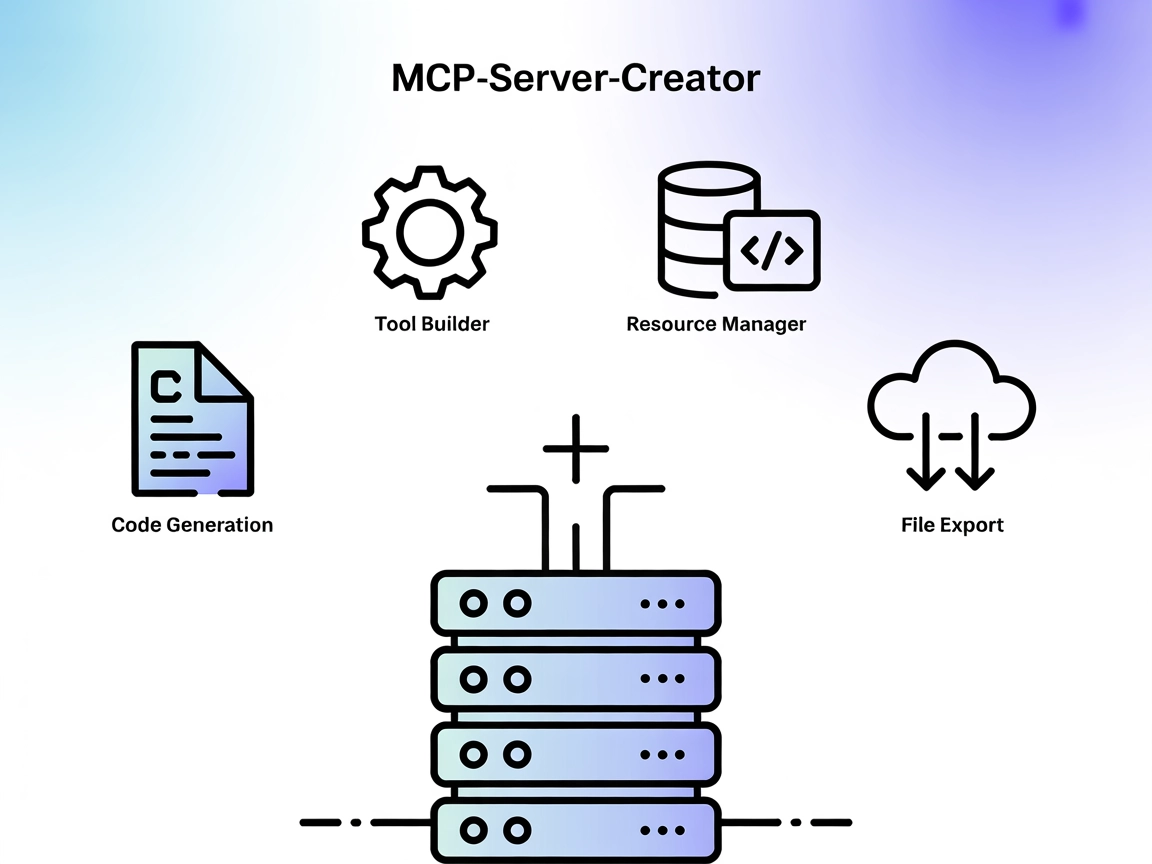

FlowHunt erbjuder ett extra säkerhetslager mellan dina interna system och AI-verktyg, vilket ger dig granulär kontroll över vilka verktyg som är tillgängliga från dina MCP-servrar. MCP-servrar som hostas i vår infrastruktur kan sömlöst integreras med FlowHunts chatbot samt populära AI-plattformar som ChatGPT, Claude och olika AI-redigerare.

MCP Code Executor är en MCP (Model Context Protocol)-server som gör det möjligt för språkmodeller (LLMs) att köra Pythonkod inom en angiven Pythonmiljö, såsom Conda, virtualenv eller UV virtualenv. Genom att koppla AI-assistenter till verkliga, körbara Pythonmiljöer ger den dem möjlighet att utföra en mängd olika utvecklingsuppgifter som kräver kodkörning, bibliotekshantering och dynamisk miljöuppsättning. Denna server stöder inkrementell kodgenerering för att kringgå tokenbegränsningar, möjliggör installation av beroenden i farten och underlättar körningskonfiguration av exekveringsmiljön. Utvecklare kan använda detta verktyg för att automatisera kodevaluering, experimentera med nya paket och hantera beräkningar i en kontrollerad och säker miljö.

Inga explicita promptmallar listas i arkivet eller dokumentationen.

Inga specifika resurser beskrivs i arkivet eller dokumentationen.

{

"mcpServers": {

"mcp-code-executor": {

"command": "node",

"args": [

"/path/to/mcp_code_executor/build/index.js"

],

"env": {

"CODE_STORAGE_DIR": "/path/to/code/storage",

"ENV_TYPE": "conda",

"CONDA_ENV_NAME": "your-conda-env"

}

}

}

}

{

"mcpServers": {

"mcp-code-executor": {

"env": {

"CODE_STORAGE_DIR": "/path/to/code/storage",

"ENV_TYPE": "conda",

"CONDA_ENV_NAME": "your-conda-env",

"MY_SECRET_API_KEY": "${MY_SECRET_API_KEY}"

},

"inputs": {

"apiKey": "${MY_SECRET_API_KEY}"

}

}

}

}

{

"mcpServers": {

"mcp-code-executor": {

"command": "node",

"args": [

"/path/to/mcp_code_executor/build/index.js"

],

"env": {

"CODE_STORAGE_DIR": "/path/to/code/storage",

"ENV_TYPE": "conda",

"CONDA_ENV_NAME": "your-conda-env"

}

}

}

}

{

"mcpServers": {

"mcp-code-executor": {

"command": "node",

"args": [

"/path/to/mcp_code_executor/build/index.js"

],

"env": {

"CODE_STORAGE_DIR": "/path/to/code/storage",

"ENV_TYPE": "conda",

"CONDA_ENV_NAME": "your-conda-env"

}

}

}

}

{

"mcpServers": {

"mcp-code-executor": {

"command": "node",

"args": [

"/path/to/mcp_code_executor/build/index.js"

],

"env": {

"CODE_STORAGE_DIR": "/path/to/code/storage",

"ENV_TYPE": "conda",

"CONDA_ENV_NAME": "your-conda-env"

}

}

}

}

Obs! Du kan även använda Docker. Den medföljande Dockerfilen är testad för

venv-uvmiljötyp:

{

"mcpServers": {

"mcp-code-executor": {

"command": "docker",

"args": [

"run",

"-i",

"--rm",

"mcp-code-executor"

]

}

}

}

Att använda MCP i FlowHunt

För att integrera MCP-servrar i ditt FlowHunt-arbetsflöde, börja med att lägga till MCP-komponenten i ditt flöde och koppla den till din AI-agent:

Klicka på MCP-komponenten för att öppna konfigurationspanelen. I systemets MCP-konfigurationssektion, ange dina MCP-serveruppgifter enligt detta JSON-format:

{

"mcp-code-executor": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

När det är konfigurerat kan AI-agenten nu använda denna MCP som ett verktyg med tillgång till alla dess funktioner och kapaciteter. Kom ihåg att ändra “mcp-code-executor” till det faktiska namnet på din MCP-server och ersätta URL:en med din egen MCP-server-URL.

| Sektion | Tillgänglighet | Detaljer/Noteringar |

|---|---|---|

| Översikt | ✅ | |

| Lista över Promptar | ⛔ | Inga promptmallar hittades |

| Lista över Resurser | ⛔ | Inga explicita resurser beskrivna |

| Lista över Verktyg | ✅ | execute_code, install_dependencies, check_installed_packages |

| Skydda API-nycklar | ✅ | Exempel ges med env-inputs |

| Samplingstöd (mindre viktigt vid utvärdering) | ⛔ | Ej specificerat |

Denna MCP-server erbjuder grundläggande och robust funktionalitet för kodkörning med LLM-integration, samt tydliga installationsinstruktioner och verktyg. Dock saknas promptmallar, explicita resurser och information om rötter eller samplingstöd. För en kodkörningsfokuserad MCP är den mycket solid, får höga poäng för praktisk nytta och lätt att integrera, men tappar några poäng för avsaknad av avancerade MCP-funktioner och dokumentationskomplettering.

| Har LICENSE | ✅ (MIT) |

|---|---|

| Har minst ett verktyg | ✅ |

| Antal Forks | 25 |

| Antal Stjärnor | 144 |

Det är en Model Context Protocol (MCP)-server som gör det möjligt för språkmodeller att köra Pythonkod i säkra, isolerade miljöer (såsom Conda eller venv), hantera beroenden och konfigurera körmiljöer. Perfekt för kodevaluering, data science, automatiserade arbetsflöden och dynamisk miljöuppsättning med FlowHunt.

Den tillhandahåller verktyg för att köra Pythonkod (`execute_code`), installera beroenden vid behov (`install_dependencies`) och kontrollera installerade paket (`check_installed_packages`).

Lägg till MCP Code Executor som en MCP-komponent i ditt flöde och konfigurera den med din servers URL och transportmetod. Detta gör det möjligt för dina AI-agenter att använda dess kodkörnings- och miljöhanteringsfunktioner i FlowHunt.

Ja, servern stöder att köra kod i isolerade Conda- eller virtualenv-miljöer, vilket säkerställer reproducerbarhet och förhindrar konflikter mellan beroenden.

Ja, servern kan köra kod inkrementellt, vilket är användbart för att hantera kod som överskrider LLM:s tokenbegränsningar.

Ja, du kan använda den medföljande Dockerfilen och konfigurera MCP-servern så att den körs inuti en Docker-container för extra isolering.

Stärk dina flöden med säker, automatiserad Pythonkodkörning. Integrera MCP Code Executor MCP Server och lås upp dynamiska arbetsflöden för data science, automatisering och mer.

MCP-Server-Creator är en meta-server som möjliggör snabb skapande och konfiguration av nya Model Context Protocol (MCP) servrar. Med dynamisk kodgenerering, ver...

CodeLogic MCP-servern kopplar samman FlowHunt och AI-programmeringsassistenter med CodeLogic:s detaljerade programvaruberoendedata, vilket möjliggör avancerad k...

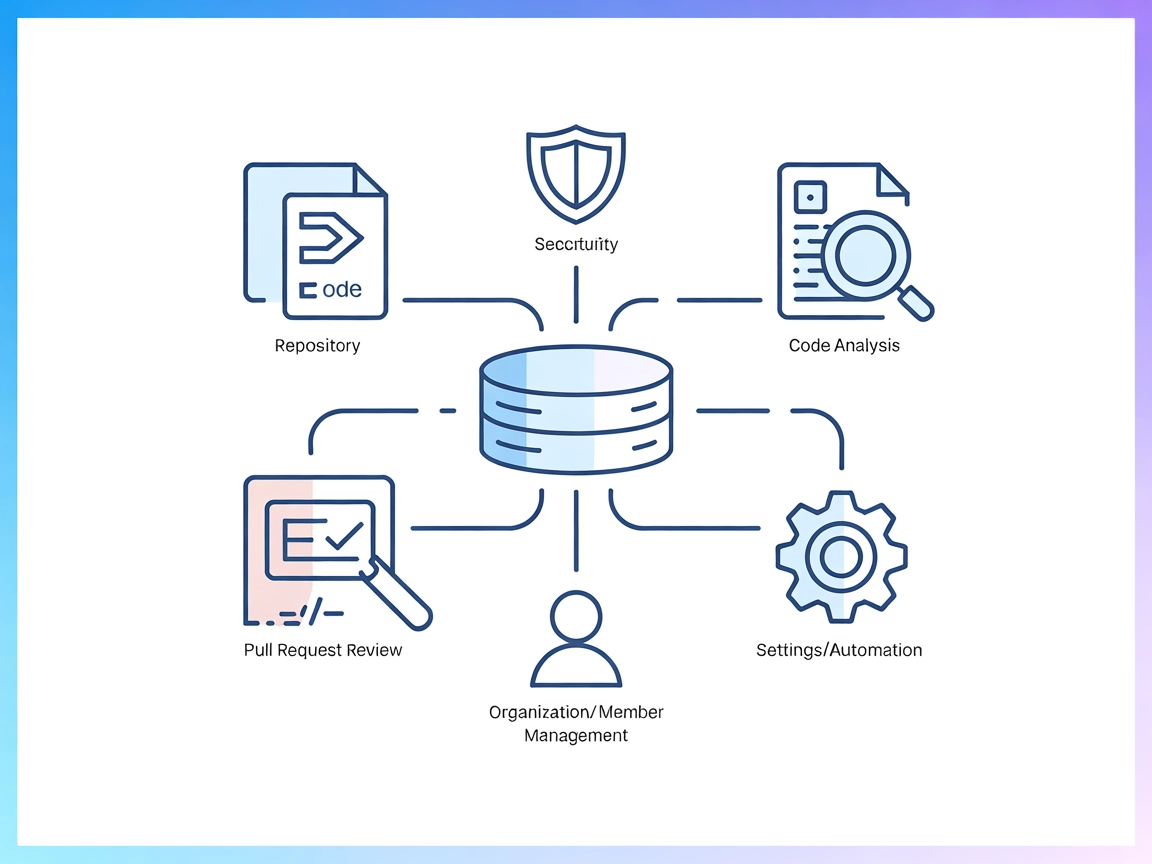

Codacy MCP Server fungerar som en brygga mellan AI-assistenter och Codacy-plattformen, vilket möjliggör automatiserad kodkvalitet, säkerhetsanalys, repository-h...

Cookie-samtycke

Vi använder cookies för att förbättra din surfupplevelse och analysera vår trafik. See our privacy policy.