lingo.dev MCP-server

lingo.dev MCP-servern fungerar som en brygga mellan AI-assistenter och externa datakällor, API:er och tjänster, vilket möjliggör strukturerad resursåtkomst, pro...

Koppla dina AI-arbetsflöden till externa data, API:er eller tjänster med Defang MCP-servern och möjliggör kontextmedvetna och robusta AI-lösningar.

FlowHunt erbjuder ett extra säkerhetslager mellan dina interna system och AI-verktyg, vilket ger dig granulär kontroll över vilka verktyg som är tillgängliga från dina MCP-servrar. MCP-servrar som hostas i vår infrastruktur kan sömlöst integreras med FlowHunts chatbot samt populära AI-plattformar som ChatGPT, Claude och olika AI-redigerare.

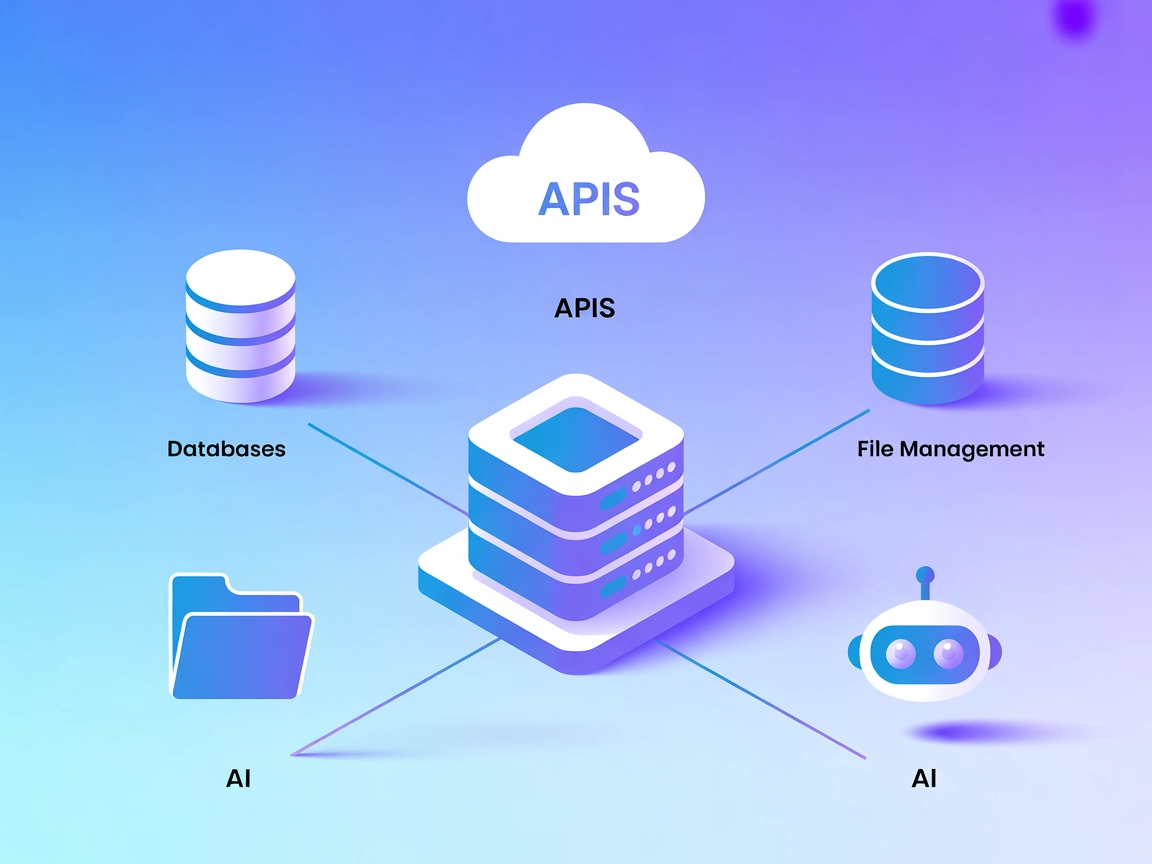

Defang MCP (Model Context Protocol) servern är utformad för att fungera som en brygga mellan AI-assistenter och externa datakällor, API:er eller tjänster, vilket förbättrar och effektiviserar utvecklingsarbetsflöden. Genom att agera som mellanhand gör den det möjligt för AI-system att utföra uppgifter såsom databasfrågor, filhantering eller interaktioner med olika API:er på ett standardiserat sätt. Detta protokollstyrda tillvägagångssätt gör det möjligt för utvecklare att bygga kraftfulla, kontextmedvetna AI-funktioner som kan komma åt, manipulera och dra nytta av extern information och resurser, vilket gör utvecklingsprocessen mer effektiv och robust.

Att använda MCP i FlowHunt

För att integrera MCP-servrar i ditt FlowHunt-arbetsflöde, börja med att lägga till MCP-komponenten i ditt flöde och koppla den till din AI-agent:

Klicka på MCP-komponenten för att öppna konfigurationspanelen. I systemets MCP-konfigurationssektion, ange uppgifterna för din MCP-server enligt detta JSON-format:

{ “MCP-name”: { “transport”: “streamable_http”, “url”: “https://yourmcpserver.example/pathtothemcp/url" } }

När den är konfigurerad kan AI-agenten nu använda denna MCP som ett verktyg med tillgång till alla dess funktioner och möjligheter. Kom ihåg att ändra “MCP-name” till det faktiska namnet på din MCP-server (t.ex. “github-mcp”, “weather-api”, etc.) och ersätta URL:en med din egen MCP-server-URL.

| Sektion | Tillgänglighet | Detaljer/Noteringar |

|---|---|---|

| Översikt | ✅ | |

| Lista över prompts | ⛔ | |

| Lista över resurser | ⛔ | |

| Lista över verktyg | ⛔ | |

| Skydd av API-nycklar | ⛔ | |

| Stöd för sampling (mindre viktigt vid utvärdering) | ⛔ |

Mellan båda tabellerna:

Baserat på tillgänglig information är denna MCP-servers dokumentation minimal eller obefintlig, vilket leder till ett lågt nyttevärde för praktisk implementering eller utvärdering.

| Har en LICENS | |

|---|---|

| Har minst ett verktyg | |

| Antal förgreningar | |

| Antal stjärnor |

Defang MCP-servern fungerar som en mellanhand mellan AI-agenter och externa datakällor, API:er eller tjänster. Den möjliggör standardiserade, protokollstyrda arbetsflöden för att bygga robusta och kontextmedvetna AI-automationer.

Lägg till MCP-komponenten i ditt FlowHunt-flöde, öppna dess konfiguration och ange serveruppgifterna med det rekommenderade JSON-formatet. Detta gör att dina AI-agenter kan använda alla funktioner som exponeras av din Defang MCP-server.

Vanliga användningsområden inkluderar databasfrågor, filhantering och integrering av tredjeparts-API:er i dina AI-drivna automationer, vilket gör dem mer flexibla och kraftfulla.

I nuläget är dokumentationen minimal. För avancerad användning, se FlowHunt’s allmänna MCP-integrationsguide eller kontakta supporten för hjälp.

Använd alltid miljövariabler eller hemlighetshanteringsfunktioner i din distributionsplattform för att undvika att exponera känslig information i konfigurationsfiler.

Integrera enkelt externa data och tjänster i dina AI-agenter med Defang MCP-servern i FlowHunt. Bygg kraftfulla, kontextuella automationer med minimal installation.

lingo.dev MCP-servern fungerar som en brygga mellan AI-assistenter och externa datakällor, API:er och tjänster, vilket möjliggör strukturerad resursåtkomst, pro...

DevRev MCP-servern tar DevRev’s kraftfulla projektlednings- och förbättringsverktyg direkt in i FlowHunt och AI-assistentarbetsflöden. Den möjliggör programmati...

Skyvern MCP (Model Context Protocol) Server fungerar som en brygga mellan AI-assistenter och externa system, vilket möjliggör sömlös integrering med databaser, ...

Cookie-samtycke

Vi använder cookies för att förbättra din surfupplevelse och analysera vår trafik. See our privacy policy.