py-mcp-mssql MCP-server

py-mcp-mssql MCP-servern erbjuder en säker och effektiv brygga för AI-agenter att programmässigt interagera med Microsoft SQL Server-databaser via Model Context...

Aktivera säker, automatiserad och parallell Python-körning inom dina AI-arbetsflöden med FlowHunt’s pydanticpydantic-aimcp-run-python MCP-server.

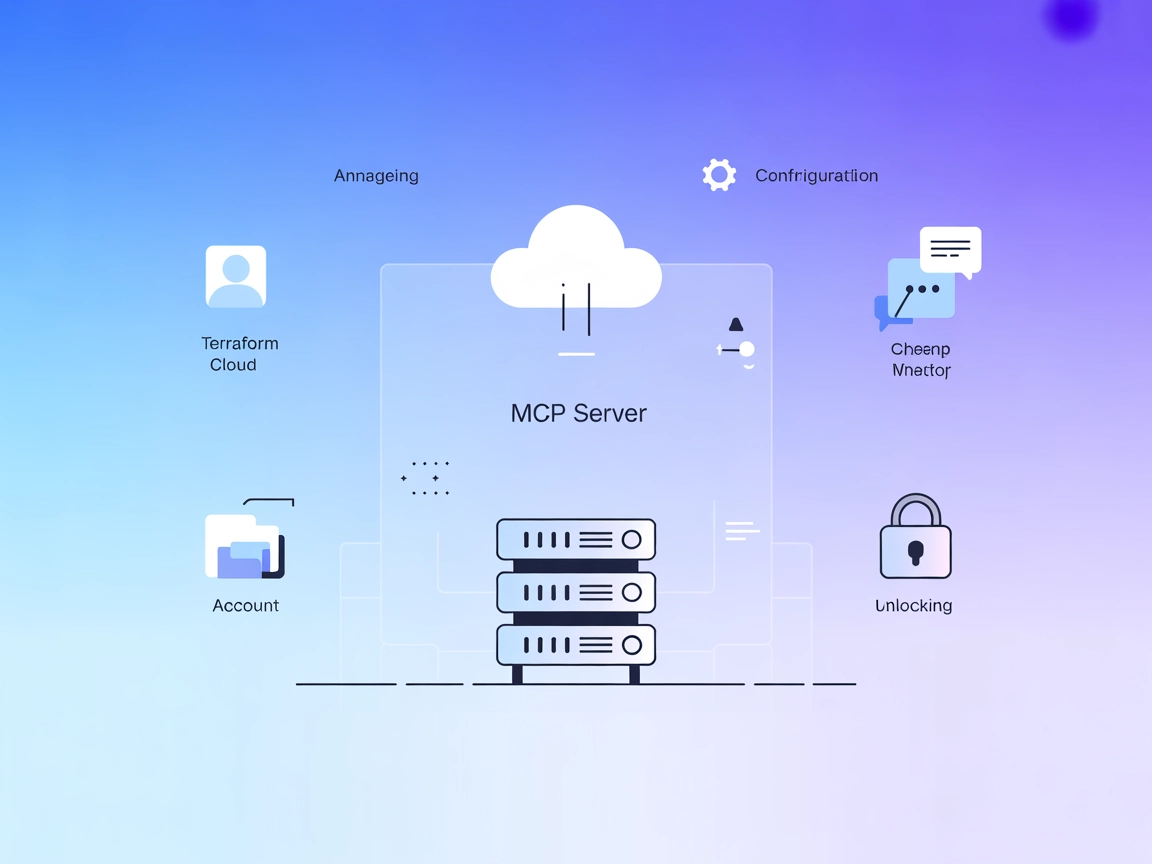

FlowHunt erbjuder ett extra säkerhetslager mellan dina interna system och AI-verktyg, vilket ger dig granulär kontroll över vilka verktyg som är tillgängliga från dina MCP-servrar. MCP-servrar som hostas i vår infrastruktur kan sömlöst integreras med FlowHunts chatbot samt populära AI-plattformar som ChatGPT, Claude och olika AI-redigerare.

pydanticpydantic-aimcp-run-python MCP-servern är utformad för att fungera som en brygga mellan AI-assistenter och Python-körningsmiljöer. Genom att exponera ett säkert och kontrollerat gränssnitt för att köra Python-skript möjliggör denna MCP-server att AI-klienter kan interagera programmatiskt med Python-funktioner, automatisera beräkningsarbetsflöden och hämta resultat som en del av bredare utvecklingspipelines. Denna funktion är särskilt värdefull för uppgifter som dynamisk kodutvärdering, snabb prototypframtagning eller integrering av Python-baserad analys inom LLM-driven automation. Servern ger utvecklare möjlighet att effektivisera kodning, felsökning och databehandling genom att ansluta sina AI-verktyg till live Python-körning – samtidigt som tydliga säkerhets- och driftgränser bibehålls.

Inga promptmallar nämns i arkivets filer eller dokumentation.

Inga specifika resursprimitiver nämns i det tillgängliga arkivinnehållet.

functions finns, men inga explicita verktyg är definierade inom den enligt repo-innehållet.functions-namnrymden och kan köras samtidigt. Användbart för arbetsfördelning eller batchbearbetning inom MCP-kontexten.multi_tool_use.parallel-funktionen för att köra flera Python-funktioner parallellt och optimera arbetsflöden som gynnas av parallellism.mcpServers:{

"mcpServers": {

"pydanticpydantic-aimcp-run-python": {

"command": "npx",

"args": [

"@pydanticpydantic-aimcp-run-python@latest",

"start"

]

}

}

}

{

"mcpServers": {

"pydanticpydantic-aimcp-run-python": {

"command": "npx",

"args": [

"@pydanticpydantic-aimcp-run-python@latest",

"start"

]

}

}

}

{

"mcpServers": {

"pydanticpydantic-aimcp-run-python": {

"command": "npx",

"args": [

"@pydanticpydantic-aimcp-run-python@latest",

"start"

]

}

}

}

{

"mcpServers": {

"pydanticpydantic-aimcp-run-python": {

"command": "npx",

"args": [

"@pydanticpydantic-aimcp-run-python@latest",

"start"

]

}

}

}

För säkerhet, definiera dina API-nycklar och hemligheter i miljövariabler, inte direkt i konfigurationsfiler. Referera till dem med hjälp av env-fältet och skicka dem vid behov i inputs-sektionen. Exempel:

{

"mcpServers": {

"pydanticpydantic-aimcp-run-python": {

"command": "npx",

"args": [

"@pydanticpydantic-aimcp-run-python@latest",

"start"

],

"env": {

"PYTHON_API_KEY": "${PYTHON_API_KEY}"

},

"inputs": {

"api_key": "${PYTHON_API_KEY}"

}

}

}

}

Använd MCP i FlowHunt

För att integrera MCP-servrar i ditt FlowHunt-arbetsflöde, börja med att lägga till MCP-komponenten i ditt flöde och anslut den till din AI-agent:

Klicka på MCP-komponenten för att öppna konfigurationspanelen. I systemets MCP-konfigurationssektion, infoga dina MCP-serveruppgifter enligt detta JSON-format:

{

"pydanticpydantic-aimcp-run-python": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

När det är konfigurerat kan AI-agenten nu använda denna MCP som ett verktyg med tillgång till alla dess funktioner och kapaciteter. Kom ihåg att ändra “pydanticpydantic-aimcp-run-python” till det faktiska namnet på din MCP-server och byt ut URL:en mot din egen MCP-server-URL.

| Sektion | Tillgänglighet | Detaljer/Noteringar |

|---|---|---|

| Översikt | ✅ | |

| Lista över promptar | ⛔ | Inga promptmallar hittades |

| Lista över resurser | ⛔ | Inga resursprimitiver hittades |

| Lista över verktyg | ✅ | multi_tool_use.parallel och functions-namnrymd; inga explicit definierade |

| Säkra API-nycklar | ✅ | Exempel finns i installationssektionen |

| Stöd för sampling (mindre viktigt vid utvärdering) | ⛔ | Ej nämnt |

Baserat på tillgänglig information erbjuder denna MCP-server grundläggande Python-körning och parallell verktygsorkestrering, men saknar promptmallar, resursprimitiver och explicit sampling- eller root-stöd. Dess största styrkor är enkel integration och tydliga säkerhetsrekommendationer. Förbättringar kan göras genom att lägga till fler verktyg, promptar och dokumentation om avancerade MCP-funktioner.

Denna MCP-server är funktionellt användbar för Python-kodkörning och parallellism, men avsaknaden av promptar, resurser och explicita avancerade MCP-funktioner gör den mer till en grundläggande integration. Kodbasen är minimal och dokumentationen om nyanserade funktioner är begränsad.

| Har en LICENSE | ⛔ (Ej hittad i repo-roten för detta delprojekt) |

|---|---|

| Har åtminstone ett verktyg | ✅ (multi_tool_use.parallel) |

| Antal forkar | (Kolla på GitHub-repo) |

| Antal stjärnor | (Kolla på GitHub-repo) |

Överlag skulle jag ge denna MCP-server 4/10 för grundläggande nytta men begränsad funktionsuppsättning och dokumentation.

Den tillhandahåller ett säkert gränssnitt för att köra Python-skript och funktioner från AI-agenter, vilket möjliggör automation, live kodutvärdering och parallell körning inom AI-drivna arbetsflöden.

Den stödjer dynamisk Python-körning och inkluderar ett parallellt körningsverktyg (multi_tool_use.parallel) för att köra flera Python-funktioner samtidigt.

Lagra känsliga autentiseringsuppgifter i miljövariabler och referera till dem i din MCP-serverkonfigurations 'env'- och 'inputs'-sektioner, istället för att hårdkoda dem i konfigurationsfiler.

Användningsområden inkluderar AI-driven Python-skriptning, automatiserad dataanalys, parallell uppgiftskörning, integration med CI/CD-pipelines och tillhandahållande av en kod-sandbox för utbildning eller experiment.

Nej, det finns inga promptmallar eller specifika resursprimitiver definierade för denna MCP-server.

Lägg till MCP-komponenten i ditt flöde, öppna dess konfiguration och infoga serverinformationen med det angivna JSON-formatet. Kontrollera att serverns URL och namn matchar din distribution.

Effektivisera din AI-automation med säker Python-körning, parallell uppgiftsorkestrering och smidig integration. Upplev live Python-skriptning i dina flöden!

py-mcp-mssql MCP-servern erbjuder en säker och effektiv brygga för AI-agenter att programmässigt interagera med Microsoft SQL Server-databaser via Model Context...

Integrera AI-assistenter med Terraform Cloud API genom Terraform Cloud MCP-servern. Hantera infrastruktur via naturligt språk, automatisera arbetsytor och proje...

Dumpling AI MCP-servern för FlowHunt möjliggör att AI-assistenter kan ansluta till en mängd olika externa datakällor, API:er och utvecklarverktyg. Den ger kraft...

Cookie-samtycke

Vi använder cookies för att förbättra din surfupplevelse och analysera vår trafik. See our privacy policy.