خادم OpenCV MCP

يعمل خادم OpenCV MCP كجسر بين أدوات معالجة الصور والفيديو القوية في OpenCV ومساعدي الذكاء الاصطناعي ومنصات المطورين عبر بروتوكول Model Context Protocol (MCP). ي...

أضف الرؤية الحاسوبية إلى تدفقات الذكاء الاصطناعي الخاصة بك مع mcp-vision: اكتشاف الأجسام وتحليل الصور مدعوم بـ HuggingFace كخادم MCP لـ FlowHunt والمساعدين متعددي الوسائط.

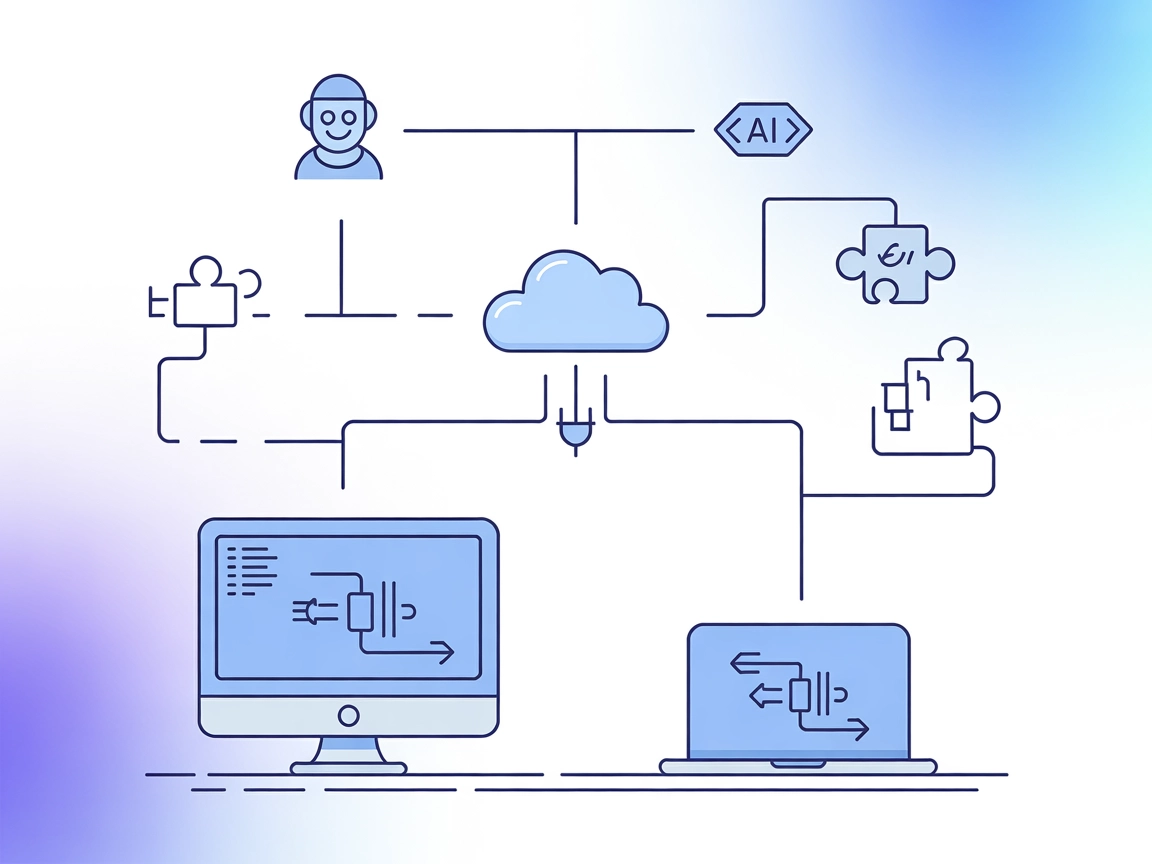

يوفر FlowHunt طبقة أمان إضافية بين أنظمتك الداخلية وأدوات الذكاء الاصطناعي، مما يمنحك تحكماً دقيقاً في الأدوات التي يمكن الوصول إليها من خوادم MCP الخاصة بك. يمكن دمج خوادم MCP المستضافة في بنيتنا التحتية بسلاسة مع روبوت الدردشة الخاص بـ FlowHunt بالإضافة إلى منصات الذكاء الاصطناعي الشائعة مثل ChatGPT وClaude ومحررات الذكاء الاصطناعي المختلفة.

يُعد خادم “mcp-vision” MCP خادم بروتوكول سياق النموذج (MCP) يتيح نماذج الرؤية الحاسوبية من HuggingFace — مثل اكتشاف الأجسام بدون تدريب مسبق — كأدوات تعزز القدرات البصرية لنماذج اللغة الكبيرة أو نماذج اللغة البصرية. من خلال ربط المساعدين الذكيين بنماذج الرؤية الحاسوبية القوية، يتيح mcp-vision مهاماً مثل اكتشاف الأجسام وتحليل الصور مباشرة ضمن تدفقات التطوير. يسمح هذا لنماذج اللغة الكبيرة والعملاء الذكيين الآخرين باستعلام الصور ومعالجتها وتحليلها برمجياً، مما يسهل أتمتة وتوحيد وتوسيع التفاعلات البصرية في التطبيقات. الخادم مناسب لبيئات GPU وCPU ومصمم لسهولة التكامل مع منصات الذكاء الاصطناعي الشائعة.

لا توجد قوالب برمجية محددة مذكورة في التوثيق أو ملفات المستودع.

لا توجد موارد MCP صريحة موثقة أو مدرجة في المستودع.

locate_objects

اكتشف وحدد الأجسام في صورة باستخدام إحدى خطوط اكتشاف الأجسام بدون تدريب مسبق المتوفرة عبر HuggingFace. المدخلات تشمل مسار الصورة، قائمة التسميات المرشحة، واسم النموذج (اختياري). تُرجع قائمة بالأجسام المكتشفة بتنسيق قياسي.

zoom_to_object

قم بالتكبير إلى جسم معين في صورة عن طريق قص الصورة إلى صندوق تحديد الجسم الذي حصل على أفضل نتيجة. المدخلات تشمل مسار الصورة، تسمية للبحث عنها، واسم النموذج (اختياري). تُرجع صورة مقصوصة أو None.

لم يتم توفير تعليمات إعداد Windsurf في المستودع.

git clone git@github.com:groundlight/mcp-vision.git

cd mcp-vision

make build-docker

claude_desktop_config.json وأضف التالي تحت mcpServers:"mcpServers": {

"mcp-vision": {

"command": "docker",

"args": ["run", "-i", "--rm", "--runtime=nvidia", "--gpus", "all", "mcp-vision"],

"env": {}

}

}

"mcpServers": {

"mcp-vision": {

"command": "docker",

"args": ["run", "-i", "--rm", "mcp-vision"],

"env": {}

}

}

"mcpServers": {

"mcp-vision": {

"command": "docker",

"args": ["run", "-i", "--rm", "--runtime=nvidia", "--gpus", "all", "groundlight/mcp-vision:latest"],

"env": {}

}

}

لم يتم توفير تعليمات إعداد Cursor في المستودع.

لم يتم توفير تعليمات إعداد Cline في المستودع.

استخدام MCP في FlowHunt

لدمج خوادم MCP في تدفق عمل FlowHunt الخاص بك، ابدأ بإضافة مكون MCP إلى التدفق وربطه بوكيل الذكاء الاصطناعي لديك:

انقر على مكون MCP لفتح لوحة الإعدادات. في قسم إعدادات MCP للنظام، أدخل تفاصيل خادم MCP باستخدام هذا التنسيق JSON:

{

"mcp-vision": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

بمجرد الإعداد، يصبح بإمكان وكيل الذكاء الاصطناعي استخدام هذا MCP كأداة مع الوصول إلى جميع وظائفه وقدراته. تذكر تغيير “mcp-vision” إلى اسم خادم MCP الفعلي الخاص بك واستبدال الرابط بالرابط الخاص بك.

| القسم | متوفر | التفاصيل / ملاحظات |

|---|---|---|

| نظرة عامة | ✅ | نماذج الرؤية الحاسوبية من HuggingFace كأدوات لـ LLMs عبر MCP |

| قائمة القوالب البرمجية | ⛔ | لا توجد قوالب برمجية موثقة |

| قائمة الموارد | ⛔ | لا توجد موارد صريحة مدرجة |

| قائمة الأدوات | ✅ | locate_objects, zoom_to_object |

| تأمين مفاتيح API | ⛔ | لا توجد تعليمات لمفاتيح API |

| دعم أخذ العينات (أقل أهمية في التقييم) | ⛔ | لم يذكر |

بشكل عام، يوفر mcp-vision تكاملاً مباشراً ومفيداً مع نماذج الرؤية من HuggingFace، لكنه يفتقر إلى التوثيق حول الموارد أو القوالب البرمجية أو ميزات MCP المتقدمة مثل الجذور أو أخذ العينات. إعداده موثق جيداً لـ Claude Desktop، ولكنه ليس كذلك للمنصات الأخرى.

mcp-vision هو خادم MCP مركز وعملي لإضافة الذكاء البصري إلى تدفقات الذكاء الاصطناعي، خاصة في البيئات التي تدعم Docker. قوته الرئيسية في وضوح الأدوات وسهولة الإعداد لـ Claude Desktop، لكنه بحاجة إلى توثيق أغنى، خاصة فيما يتعلق بالموارد، القوالب البرمجية، ودعم المزيد من المنصات وميزات MCP المتقدمة.

| لديه رخصة | ✅ MIT |

|---|---|

| يحتوي على أداة واحدة على الأقل | ✅ |

| عدد الاشتقاقات | 0 |

| عدد النجوم | 23 |

mcp-vision هو خادم بروتوكول سياق النموذج مفتوح المصدر يتيح نماذج الرؤية الحاسوبية من HuggingFace كأدوات للمساعدين الذكيين ونماذج اللغة الكبيرة، مما يمكّن من اكتشاف الأجسام، قص الصور، والمزيد ضمن تدفقات الذكاء الاصطناعي الخاصة بك.

يقدم mcp-vision أدوات مثل locate_objects (لاكتشاف الأجسام بدون تدريب مسبق في الصور) و zoom_to_object (لقص الصور إلى الأجسام المكتشفة)، ويمكن الوصول إليها عبر واجهة MCP.

استخدم mcp-vision للاكتشاف الآلي للأجسام، أتمتة تدفقات العمل المبنية على الرؤية، الاستكشاف التفاعلي للصور، وتعزيز وكلاء الذكاء الاصطناعي بقدرات التحليل البصري والمنطقي.

أضف مكون MCP إلى تدفق FlowHunt الخاص بك وأدخل تفاصيل خادم mcp-vision في لوحة الإعداد باستخدام تنسيق JSON المقدم. تأكد من أن خادم MCP يعمل وقابل للوصول من FlowHunt.

لا يتطلب mcp-vision مفتاح API أو بيانات اعتماد خاصة وفقًا للتوثيق الحالي. فقط تأكد من إعداد بيئة Docker وأن الخادم متاح.

عزز وكلاء الذكاء الاصطناعي لديك باكتشاف الأجسام وتحليل الصور باستخدام mcp-vision. قم بربطه بتدفقات FlowHunt لتحقيق استنتاج متعدد الوسائط بكل سلاسة.

يعمل خادم OpenCV MCP كجسر بين أدوات معالجة الصور والفيديو القوية في OpenCV ومساعدي الذكاء الاصطناعي ومنصات المطورين عبر بروتوكول Model Context Protocol (MCP). ي...

يصل خادم MCP من نوع mcp-hfspace بين المساعدين الذكاء الاصطناعي و HuggingFace Spaces، مما يتيح تكاملًا سلسًا، وأتمتة، وإدارة للنماذج والتجارب وواجهات برمجة التطب...

عزز سير عمل الذكاء الاصطناعي لديك مع تكامل mcp-vision من FlowHunt. استعن باكتشاف الأجسام بدون تدريب مسبق المدعوم من HuggingFace، وأدوات التكبير والقص المتقدمة ل...

الموافقة على ملفات تعريف الارتباط

نستخدم ملفات تعريف الارتباط لتعزيز تجربة التصفح وتحليل حركة المرور لدينا. See our privacy policy.