ChatGPT-5: Vše, co potřebujete vědět o průlomovém AI modelu od OpenAI

Objevte přelomové možnosti ChatGPT-5, jeho využití, výkonnost, bezpečnost, ceny a budoucí směry v tomto komplexním průvodci FlowHunt.

Objevte, jak Jamba 3B od AI21 kombinuje transformer attention s modely state space, aby dosáhla bezprecedentní efektivity a dlouhého kontextu na edge zařízeních a mění tím budoucnost velkých jazykových modelů.

Oblast velkých jazykových modelů prošla v posledních letech dramatickou proměnou – výzkumníci i firmy neustále hledají cesty, jak zvýšit efektivitu bez obětování výkonu. Představení Jamba 3B od AI21 představuje významný milník v tomto vývoji: hybridní model, který kombinuje silné stránky transformer attention mechanismů s modely state space a tím dosahuje bezprecedentních zisků v efektivitě. Tento průlom přichází v době, kdy výpočetní nároky na trénování a nasazení velkých jazykových modelů představují pro firmy po celém světě zásadní úzké hrdlo. V tomto komplexním průvodci prozkoumáme technické inovace za Jamba 3B, pochopíme, proč právě hybridní architektury představují budoucnost jazykových modelů, a podíváme se, jak tento přístup mění možnosti AI napříč různými výpočetními prostředími.

AI21 byla založena před více než sedmi lety Ori Levyem, Yoavem Shohamem a Amnonem Shashuou s vizionářským cílem, který určoval směr veškeré jejich další práce: hluboké učení, ačkoliv je nesmírně silné a užitečné, samo o sobě nestačí. Základní filozofie firmy spočívala v propojení klasické umělé inteligence s moderními přístupy hlubokého učení a vytváření systémů, které dokážou využít silné stránky obou těchto paradigmat. Tato mise se ukázala jako velmi předvídavá – firma začala pracovat těsně před vydáním GPT-3 a byla tak v ideální pozici stát se součástí převratných změn v celém AI odvětví. Již od svých počátků v roce 2018 se AI21 zavázala k trénování modelů při zachování dvojího důrazu na vědeckou přesnost i praktické aplikace. Tento vyvážený přístup se stal určujícím rysem práce firmy a odlišil ji od konkurence, která často upřednostňovala buď čistý výzkum, nebo okamžitou komercializaci.

Během své historie AI21 trvale uplatňovala kombinaci špičkového výzkumu s reálným nasazením. Firma vyvinula aplikaci Wordtune, která jí zajistila cennou pozici na trhu a zároveň sloužila jako testovací půda pro výzkum jazykových modelů. Když se objevil GPT-3, AI21 reagovala trénováním vlastního modelu Jurassic-1, který dosáhl obdobných nebo mírně lepších výsledků než nabídka OpenAI. Tento raný úspěch potvrdil AI21 jako vážného hráče v oblasti velkých jazykových modelů, ale ambice firmy šly mnohem dál než jen vyrovnat se existujícím modelům. Tým si uvědomil, že budoucnost AI nebude jen o větších modelech, ale hlavně o chytřejších architekturách, které nabídnou vyšší výkon s větší efektivitou. Tento postřeh nakonec vedl ke vzniku Jamba – průlomové řady hybridních modelů, které zpochybňují dosavadní představy o konstrukci jazykových modelů.

Hybridní jazykové modely představují zásadní odklon od čistě transformerové architektury, která dominovala oboru od vydání GPT-2 a následných modelů. Klasické transformerové jazykové modely spoléhají výhradně na attention mechanismy, kdy každý token v sekvenci může sledovat všechny ostatní tokeny. Tento přístup je sice extrémně efektivní pro porozumění a generování textu, ale přináší velkou výpočetní náročnost: attention má kvadratickou složitost vůči délce sekvence – zdvojení kontextového okna tedy zčtyřnásobí výpočetní požadavky. Navíc key-value cache potřebná pro attention roste lineárně s délkou sekvence, což vytváří paměťová úzká hrdla, která jsou stále větším problémem při rozšiřování kontextu. Tyto limity jsou dnes zásadní překážkou především pro aplikace, které vyžadují dlouhý kontext, personalizaci, paměť a agentní dedukci.

Hybridní modely tato omezení řeší kombinací transformer attention se state space modely, zejména Mamba, která nabízí lineární složitost vzhledem k délce sekvence. Nejde přitom o úplné nahrazení attention – tím by se ztratila dedukční schopnost transformerů – ale o selektivní využití attention, typicky v poměru 1:8, kdy pouze jedna z osmi vrstev využívá plnou attention a ostatní vrstvy efektivnější state space model. Tato strategie zachovává schopnost modelu řešit složité úlohy vyžadující globální kontext, přičemž dramaticky snižuje výpočetní náklady a požadavky na paměť v drtivé většině výpočetních kroků. Výsledný model si udrží nebo dokonce zlepší výkon v benchmarkech a současně spotřebuje podstatně méně výpočetních zdrojů při trénování i inferenci. Tyto zisky nejsou jen marginální – znamenají zásadní posun v možnostech nasazení AI, umožňují běh modelů na edge zařízeních, v paměťově omezených prostředích a v měřítku, které bylo dříve nepředstavitelné.

Cesta k hybridní architektuře Jamba nevznikla plánovaně, ale vyplynula z pečlivého experimentování a ochoty zkoušet netradiční přístupy. Tým AI21 původně pracoval na J3, třetí verzi modelové řady Jurassic, s plánem implementovat mixture-of-experts (MoE) architekturu. Hlavním důvodem bylo snížení trénovacích nákladů tím, že se výpočty rozdělí mezi více expertních sítí, což činí rozpočet na trénování lépe zvládnutelný. Tým však zároveň chtěl, aby byl model efektivně nasaditelný i při inferenci, proto navrhl J3 v několika variantách – jednu, která se vejde na jedno GPU s 80 GB paměti (např. A100 nebo H100), a větší variantu pro jeden pod. Od začátku tedy kladl důraz na efektivitu inference, což bylo klíčové pro následný průlom.

V ablačních studiích narazil CTO AI21 Barak Lenz na článek o Mamba, který mu doporučilo několik kolegů. Na rozdíl od předchozích state space modelů, které neměly přesvědčivé výsledky, Mamba vynikala důsledným srovnáváním – autoři neporovnávali s dávno překonanými baseline modely, ale přímo s nejnovějšími attention architekturami (zejména s vylepšeními od Llama, která přinesla významné optimalizace v layer normalization, aktivacích a dalších detailech, čímž eliminovala nestability při trénování). Článek o Mamba navíc poskytoval vlastní jádra i kód, což ukázalo skutečný závazek k praktické implementaci. Lenz proto motivoval inženýrský tým k experimentům s Mamba a porovnání s vlastním dashboardem, který už tehdy obsahoval stovky různých úloh a benchmarků.

První výsledky byly slibné, ale odhalily i důležitá omezení. Mamba si vedla srovnatelně s attention modely v perplexity i většině úloh, ale v některých typech úloh, zejména ve few-shot learningu, zaostávala. Důvodem byla absence attention mechanismu – některé dedukční a rozpoznávací úlohy vyžadují globální kontext, který attention poskytuje. Namísto smíření se s tímto limitem začal tým experimentovat s hybridními architekturami, kde střídal attention vrstvy s vrstvami Mamba, aby získal výhody obou přístupů. Výsledky předčily očekávání: hybridní přístup nejen odstranil pokles výkonu čisté Mamba, ale přinesl zlepšení i oproti běžným transformerům. Tento objev byl katalyzátorem vývoje Jamba.

Vývoj Jamba znamenal řešení řady technických výzev v dosud nevyzkoušeném měřítku. Když AI21 začala trénovat Jamba Mini, první model své hybridní řady, Mamba nikdy předtím nebyla škálována přes 3 miliardy parametrů. Hybridní model týmu však nakonec dosáhl 13 miliard aktivních parametrů a přibližně 52 miliard celkových parametrů se započítáním MoE komponent. To představovalo masivní škálovací výzvu, která vyžadovala ladění a optimalizaci architektury způsobem, jaký dosud nikdo nezkoušel. Samotná optimalizace byla fascinujícím inženýrským úkolem – tým musel podrobně analyzovat chování modelu, hledat úzká hrdla a implementovat řešení, která umožní efektivní trénování hybridní architektury v takovém měřítku.

Jedním z nejdůležitějších rozhodnutí v architektuře Jamba bylo určit optimální poměr attention a state space vrstev a jejich umístění v modelu. AI21 rozsáhlými ablačními studiemi zjistila, že poměr 1:8 – jedna z osmi vrstev s attention, zbytek s Mamba – nabízí ideální rovnováhu mezi výkonem a efektivitou. Důležité je i samotné umístění attention vrstev – testováním různých pozic (na začátku, uprostřed, na konci) tým zjistil, že nejlepších výsledků dosáhl při umístění attention vrstev do středu modelu. Ačkoliv agresivnější poměry jako 1:6 ukázaly mírná zlepšení, jednalo se o změny v rámci standardní odchylky a neospravedlňovaly dodatečné výpočetní náklady, protože každá attention vrstva zvyšuje kvadratickou složitost key-value cache při dlouhém kontextu.

Efektivita této architektury je výrazná a mnohostranná. Při trénování hybridní přístup snižuje výpočetní nároky oproti čistým transformerům, což umožňuje škálovat modely levněji. Při inferenci jsou přínosy ještě výraznější, zejména pro aplikace s dlouhým kontextem. Mamba má sice vyšší fixní náklady pro krátké sekvence než attention, ale tento handicap mizí a obrací se ve výhodu s rostoucí délkou sekvence. Pro aplikace s dlouhým kontextem – agentní AI, enterprise RAG systémy, personalizace s pamětí a mnoho dalších – poskytuje hybridní architektura dramaticky lepší výkonnostní charakteristiky. Lineární škálování paměti s Mamba znamená, že zdvojnásobením kontextového okna se zdvojnásobí paměťová náročnost, zatímco u attention je to čtyřnásobek. Tento rozdíl je zásadní s rostoucími nároky na udržení kontextu a paměti v dlouhých interakcích.

S rostoucím nasazováním pokročilých jazykových modelů jako Jamba 3B se stává klíčovou výzvou jejich integrace do produkčních workflow. FlowHunt tuto výzvu řeší komplexní platformou pro automatizaci AI workflow – od volby modelu, přes testování, až po nasazení a monitoring. Efektivita hybridních modelů jako Jamba 3B se naplno projeví až při propojení s inteligentní automatizací workflow, která optimalizuje nasazení, testování i monitoring v produkci. FlowHunt umožňuje týmům stavět sofistikované AI systémy, které využívají modely jako Jamba 3B a zároveň zachovat přehled a kontrolu nad celým procesem. Automatizací rutinních částí nasazení a monitoringu umožňuje FlowHunt týmům soustředit se na strategické aspekty integrace AI a zajistit, že efektivita pokročilých architektur bude znamenat i reálnou byznysovou hodnotu.

Kombinace efektivních modelů a inteligentní automatizace workflow vytváří silnou synergii. Týmy mohou nasazovat Jamba 3B na edge zařízení či v prostředích s omezenou pamětí s jistotou, že monitoring a optimalizace FlowHunt zajistí konzistentní výkon. Pro podniky, které budují AI systémy vyžadující dlouhý kontext, personalizaci a agentní dedukci, poskytuje FlowHunt infrastrukturu pro efektivní správu těchto komplexních workflow. Schopnost platformy automatizovat testování, nasazení i monitoring znamená, že organizace mohou rychle experimentovat s různými konfiguracemi modelu a strategií nasazení bez manuální zátěže. To je zvláště přínosné pro firmy zkoumající možnosti hybridních modelů, protože jim to umožňuje benchmarkovat různé architektury a konfigurace a najít optimální řešení pro konkrétní potřeby.

Vydání Jamba 3B je významným krokem k zpřístupnění pokročilých AI schopností širšímu spektru aplikací a scénářů nasazení. Na rozdíl od předchozích modelů řady Jamba, které byly navrženy pro maximální výkon ve velkém měřítku, je Jamba 3B optimalizována přímo pro edge zařízení a prostředí s omezenou pamětí. Označení “3B” odkazuje na velikost modelu – přibližně 3 miliardy parametrů – což jej činí dostatečně malým pro běh na běžném spotřebitelském hardwaru a přitom zachovává efektivitu hybridní architektury. Tento vývoj je zásadní, protože demokratizuje přístup k pokročilým schopnostem jazykových modelů a umožňuje aplikace, které byly dříve kvůli výpočetním omezením nemožné. Vývojáři nyní mohou nasazovat sofistikované jazykové modely na mobilních, IoT a embedded zařízeních či jiných edge platformách, aniž by obětovali dedukční schopnosti a dlouhý kontext, které moderní jazykové modely přináší.

Nejdůležitější vlastností Jamba 3B je schopnost zpracovávat dlouhá kontextová okna i při nasazení na edge zařízeních. To bylo s čistě transformerovými architekturami nemožné – kvadratická složitost attention způsobovala, že rozšíření kontextu na edge zařízení rychle vyčerpalo dostupnou paměť. Hybridní architektura Jamba 3B toto zásadně mění. Lineární složitost vrstev Mamba znamená, že kontext lze zvětšovat bez exponenciálního růstu paměťových nároků, který trápí čisté attention modely. Pro aplikace vyžadující personalizaci, uchování paměti, retrieval-augmented generation a agentní dedukci je tato schopnost zásadní. Edge zařízení s Jamba 3B si může udržet koherentní kontext v dlouhých interakcích, což umožňuje pokročilé aplikace, které byly dosud možné jen s cloudovými modely. Tento posun má zásadní dopad na soukromí, latenci i náklady – aplikace nyní mohou zpracovávat citlivá data lokálně bez odesílání do cloudu, reagovat s minimální latencí a fungovat bez nákladů na cloudové výpočty.

Při pohledu na současnou nabídku mini modelů na trhu vyniká Jamba 3B jako jediný hybridní model v této velikostní kategorii. Většina mini modelů spoléhá na čistě transformerovou architekturu a tak čelí stejným limitům efektivity jako jejich větší protějšky. Hybridní přístup Jamba 3B jí dává výraznou výhodu v dlouhém kontextu a výpočetní efektivitě. Model toho dosahuje ne kompromisy v architektuře, ale díky zásadním ziskům efektivity hybridního přístupu. Díky tomu je Jamba 3B ideální volbou pro aplikace, které potřebují vyvážit velikost modelu a schopnosti, zejména pokud vyžadují dlouhý kontext na edge zařízeních.

Navzdory jasným výhodám hybridních modelů přetrvávají významné překážky jejich masového nasazení. AI průmysl věnoval roky optimalizaci hardwaru a softwaru specificky pro transformer attention mechanismy. Každá hlavní hardwarová platforma – od NVIDIA GPU po specializované AI akcelerátory – má vlastní jádra a optimalizace pro attention operace. Tyto optimalizace jsou výsledkem let inženýrské práce a představují značné investice do co nejefektivnějšího běhu attention na konkrétních zařízeních. Naproti tomu state space modely jako Mamba jsou relativně nové a ačkoli mají vlastní optimalizovaná jádra, tyto optimalizace nejsou zatím tak vyspělé ani široce rozšířené. To vytváří tzv. “hardwarovou loterii” – výhody hybridních modelů mohou být výrazně menší, pokud hardware nemá optimalizované implementace operací state space modelů.

Tato mezera v optimalizaci hardwaru je skutečnou bariérou adopce, ale není nepřekonatelná a bude se časem zmenšovat. S rostoucím zájmem firem o hybridní a state space architektury budou mít výrobci hardwaru větší motivaci investovat do jejich optimalizace. NVIDIA již začala vydávat hybridní modely a další firmy ji následují, což naznačuje, že odvětví si uvědomuje dlouhodobou důležitost těchto architektur. Navíc jsou efektivní zisky hybridních modelů tak výrazné, že i bez dokonalé hardwarové optimalizace často překonají čisté attention modely. Kvadratická složitost attention je natolik zásadním limitem, že ani roky optimalizací ji neumožní u dlouhého kontextu konkurovat lineární složitosti state space modelů. S rostoucí délkou sekvencí – což je nevyhnutelný trend s rostoucími nároky aplikací na kontext a personalizaci – bude převaha hybridních modelů stále zjevnější.

Mimo AI21 a její hybridní modely se v celém odvětví prosazuje trend využívat attention selektivně, nikoliv v každé vrstvě. I firmy, které nenasazují plně hybridní architekturu, uznávají, že plná attention v každé vrstvě je zbytečná a neefektivní. Mnoho nových modelů využívá sliding window attention, kdy každý token může sledovat jen omezené okolí místo celé sekvence. Tento přístup snižuje složitost attention z kvadratické na lineární vzhledem k velikosti okna, přesto však vyžaduje více výpočtů než state space modely. Skutečnost, že i výzkumníci jako Noam Shazir nezávisle dospěli ke stejnému optimálnímu poměru attention (konkrétně k poměru 1:8 mezi lokální a globální attention), ukazuje, že nejde o náhodný výsledek, ale o fundamentální vlastnost správně navržených jazykových modelů.

Tato shoda výsledků mezi různými týmy a firmami naznačuje, že odvětví směřuje k novému konsenzu ohledně optimální architektury modelů. Namísto čistě transformerového přístupu, který vládl od dob GPT-2, se budoucnost rýsuje v podobě modelů, které využívají attention selektivně – ať už formou hybridních architektur, nebo sliding window attention. Detaily implementace se mohou lišit, ale základní princip je stejný: plná attention v každé vrstvě je neefektivní a zbytečná. Tento posun znamená dospívání oboru – od počátečního nadšení z transformerů k promyšlenějšímu chápání, kdy a kde je attention skutečně potřeba. Pro vývojáře a firmy budující AI systémy to znamená, že modely, které budou v budoucnu stavět a nasazovat, budou pravděpodobně efektivnější, což otevře nové možnosti pro aplikace, které jsou dnes kvůli výpočetním limitům nepraktické.

Zažijte, jak FlowHunt automatizuje vaše AI a SEO workflow – od výzkumu a generování obsahu po publikování a analytiku – vše na jednom místě.

Mimo samostatné modely AI21 průkopnicky rozvíjí také AI systémy, které jdou dál než jen inference jazykového modelu. Firma vydala Jarvis, raný AI systém, který se snažil využívat externí nástroje a zdroje k rozšíření schopností jazykových modelů. Tato práce předcházela masovému rozšíření tool-use v jazykových modelech a inspirovala i pozdější frameworky typu LangChain. Základní postřeh AI systémů je, že samotné jazykové modely, ačkoliv jsou výkonné, pro mnohé reálné aplikace nestačí. Aby se překlenula propast mezi deep learningem a klasickou AI, systémy musejí umět volat externí nástroje, přistupovat k databázím, spouštět kód a dělat další operace vyžadující větší rigoróznost a determinismus, než jaký nabízí čistě neuronová inference.

Maestro, podnikové řešení AI21, představuje vývoj tohoto myšlení v produkčně připravený systém pro byznys aplikace. Namísto pouhého nasazení jazykového modelu a doufání ve smysluplné výstupy poskytuje Maestro framework pro stavbu AI systémů, které spolehlivě zvládají komplexní úlohy kombinací schopností jazykového modelu s využitím nástrojů, retrievalu a dalších klasických AI technik. Tento přístup je zvláště důležitý pro podnikové aplikace, kde je spolehlivost, přesnost a auditovatelnost zásadní. Jazykový model může generovat přesvědčivě znějící, ale nesprávné informace, zatímco AI systém, který dokáže ověřovat výstupy proti externím zdrojům a využívat nástroje na konkrétní úkony, přináší nesrovnatelně vyšší spolehlivost. Nasazování AI systémů ve firmách bylo sice pomalejší, než někteří předpokládali, ale to se mění, jak firmy uznávají hodnotu AI pro automatizaci složitých workflow a rozhodovacích procesů.

Načasování tohoto posunu k AI systémům je důležité. S nástupem generativní AI se firmy soustředily především na jednoduché aplikace, jako je generování obsahu či zákaznické chatboty. Tyto úlohy bylo často možné zvládnout jazykovým modelem s minimální infrastrukturou. S nabývajícími zkušenostmi s AI a rostoucími požadavky na složitější aplikace se však limity čistých jazykových modelů ukázaly zřetelněji. Úlohy vyžadující dlouhý kontext, personalizaci, paměť a agentní dedukci jednoznačně profitují ze strukturovaného přístupu AI systémů. Navíc efektivita modelů jako Jamba 3B činí sofistikované AI systémy na edge zařízeních i v omezených prostředích stále praktičtějšími. Konvergence efektivnějších modelů a pokročilejších systémových architektur vytváří nové možnosti nasazení AI v podnicích.

Pro vývojáře a firmy, které zvažují využití pokročilých jazykových modelů ve svých aplikacích, má příchod Jamba 3B a hybridních architektur několik zásadních důsledků. Za prvé – naznačuje, že doba čistě transformerových modelů může pro novou výstavbu končit. Ačkoliv stávající transformery se budou dále používat a vylepšovat, nové modely budou stále častěji obsahovat hybridní architektury nebo selektivní attention. Vývojáři by se tedy měli začít seznamovat s těmito novými architekturami, poznat jejich vlastnosti, výhody i limity. Za druhé, efektivita hybridních modelů umožňuje nasazovat sofistikované jazykové modely i tam, kde to dříve nebylo možné – na edge, v mobilech a v dalších prostředích s omezenými prostředky. To otevírá nové možnosti pro aplikace, které mohou zpracovávat data lokálně, chránit soukromí a reagovat s minimální latencí.

Za třetí, dlouhý kontext modelů jako Jamba 3B umožňuje nové aplikační vzory, které dříve nebyly praktické. Aplikace nyní mohou udržet konzistentní kontext přes dlouhé interakce, což umožňuje pokročilou personalizaci, paměť a agentní dedukci. To je zvlášť cenné pro firemní aplikace, kde je klíčová schopnost udržet kontext přes více interakcí a integrovat se s externími systémy. Za čtvrté, kombinace efektivních modelů a platformy pro inteligentní automatizaci workflow jako FlowHunt přináší nové možnosti pro rychlou iteraci a experimentování. Firmy mohou nyní testovat různé konfigurace modelu, strategie nasazení i architektury systémů bez extrémních výpočetních nákladů. Tato demokratizace AI experimentování pravděpodobně urychlí inovace a povede ke vzniku nových aplikací a scénářů, které si dnes ještě nedokážeme představit.

Důkazy stále více naznačují, že hybridní modely nejsou dočasným trendem, ale představují budoucí směr vývoje jazykových modelů. Efektivita je jednoduše příliš výrazná, aby ji bylo možné ignorovat, a výkonnostní charakteristiky jsou ve většině benchmarků srovnatelné nebo lepší než u čistě transformerových modelů. S tím, jak výrobci hardwaru investují do optimalizací pro state space modely a další efektivní architektury, budou praktické výhody hybridních modelů jen narůstat. Navíc obecný trend v odvětví směrem k selektivní attention – ať už skrze hybridní architektury, sliding window attention nebo jiné přístupy – ukazuje zásadní posun v přemýšlení o architektuře modelů. Čistě transformerový přístup, který dominoval poslední léta, ustupuje promyšlenějším architekturám využívajícím různé mechanismy pro různé účely.

Pro firmy budující AI systémy má tento posun strategický význam. Investice do poznání a práce s hybridními modely nyní firmy připravuje na zisk efektivity a schopností, které tyto modely přináší. Kombinace efektivních modelů jako Jamba 3B, sofistikovaných AI systémů a inteligentní automatizace workflow tvoří silný základ pro stavbu nové generace AI aplikací. Jak se obor dále vyvíjí, firmy, které investovaly do poznání nových architektur a stavby systémů kolem nich, budou nejlépe připraveny využít vznikající příležitosti. Budoucnost AI není jen o větších modelech nebo více datech – je o chytřejších architekturách, které přináší lepší výkon s vyšší efektivitou a umožňují nové aplikace a scénáře, které byly dosud nemožné.

Vývoj Jamba 3B a obecný posun k hybridním modelům znamená dospívání oboru velkých jazykových modelů. Namísto pouhého škálování stávajících architektur nyní výzkumníci i praktikové přemýšlejí pečlivěji o návrhu modelů, které jsou zároveň výkonné a efektiv

Hybridní LLM kombinuje transformer attention mechanismy s modely state space jako je Mamba. Na rozdíl od čistě transformerových modelů, které spoléhají výhradně na attention (která má kvadratickou výpočetní složitost), hybridní modely využívají attention selektivně – obvykle v poměru 1:8 – a většinu vrstev tvoří efektivní state space modely s lineární složitostí. Tento přístup zachovává kvalitu výstupů při výrazném snížení nákladů na výpočty a paměťových požadavků.

Jamba 3B je optimalizována pro edge zařízení, protože zvládá zpracovávat dlouhý kontext a přitom má tak malou paměťovou stopu, že může běžet v prostředích s omezenou pamětí. Efektivita hybridní architektury umožňuje modelu fungovat na jednotlivých GPU nebo edge zařízeních bez ztráty schopnosti zpracovávat rozšířená kontextová okna, což ji činí ideální pro AI aplikace přímo na zařízení.

Díky rozsáhlým ablačním studiím AI21 zjistilo, že použití attention pouze v 1 z každých 8 vrstev (a Mamba v ostatních 7) představuje optimální rovnováhu mezi výkonem a efektivitou. Attention vrstvy jsou strategicky umístěny ve středu modelu a ne na začátku či konci, což se empiricky ukázalo jako nejlepší řešení. Tento poměr minimalizuje kvadratické náklady attention a přitom zachovává schopnost modelu řešit komplexní úlohy.

Hybridní modely nabízí několik klíčových výhod: výrazně nižší náklady na trénování díky menším výpočetním nárokům, vyšší efektivitu pro aplikace s dlouhým kontextem, lineární škálování paměti namísto kvadratického a zachování nebo zlepšení výkonu v drtivé většině benchmarků. Umožňují také nasazení na edge zařízení a do prostředí s omezenými prostředky, přičemž neztrácí schopnosti dedukce, které dělají velké jazykové modely hodnotnými.

Arshia je inženýr AI pracovních postupů ve FlowHunt. Sxa0vzděláním vxa0oboru informatiky a vášní pro umělou inteligenci se specializuje na vytváření efektivních workflow, které integrují AI nástroje do každodenních úkolů a zvyšují tak produktivitu i kreativitu.

Zjednodušte nasazení, testování a optimalizaci AI modelů díky inteligentní automatizační platformě FlowHunt.

Objevte přelomové možnosti ChatGPT-5, jeho využití, výkonnost, bezpečnost, ceny a budoucí směry v tomto komplexním průvodci FlowHunt.

Prozkoumejte pokročilé schopnosti modelu Llama 3.3 70B Versatile 128k jako AI agenta. Tato detailní recenze zkoumá jeho schopnosti v oblasti úsudku, řešení prob...

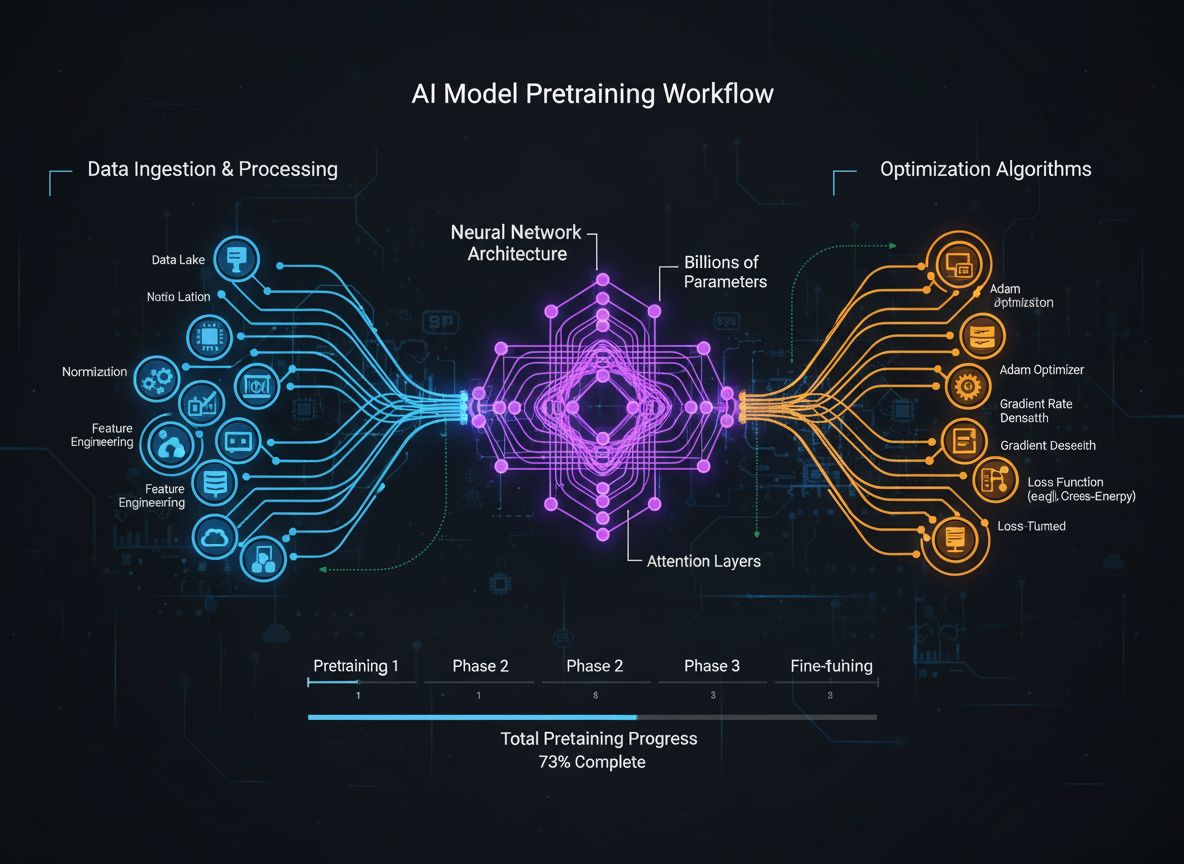

Komplexní průvodce moderními strategiemi pretrénování jazykových modelů, technikami kurace dat a optimalizačními metodami používanými v HuggingFace pro tvorbu e...

Souhlas s cookies

Používáme cookies ke zlepšení vašeho prohlížení a analýze naší návštěvnosti. See our privacy policy.