Hvor og hvordan man begynder med AI i e-handel: En praktisk køreplan

En praktisk ramme for implementering af AI i e-handel fra Quality Units CMO. Lær hvor du skal starte, almindelige udfordringer, strategier til indholdsforberede...

En teknisk grundlæggers guide til implementering af AI-handelsprotokoller (UCP, ACP, AP2), mestring af tekniske SEO-grundprincipper og generering af indhold optimeret til både traditionel søgning og AI-citationer.

Viktor Zeman var medstifter af Quality Unit for over to årtier siden og har ledet udviklingen og den globale vækst af produktpakken, herunder FlowHunt. Siden 2024 har han fokuseret specifikt på FlowHunt og på at hjælpe virksomheder med at implementere praktiske AI-løsninger, automatisering og moderne AI-drevne arbejdsmiljøer. Hans E-commerce Mastermind-præsentation dykkede dybt ned i tre kritiske områder af teknisk implementering af AI i e-handel.

Præsentationen detaljerede specifikke protokoller, tekniske implementeringer og indholdsstrategier testet på tværs af Quality Units produkter og kundebase. Det følgende er Viktors tekniske køreplan for at gøre e-handelssider synlige gennem AI-systemer, funktionelle inden for AI-medieret handel og konkurrencedygtige, når søgning skifter fra søgeord til AI-citationer.

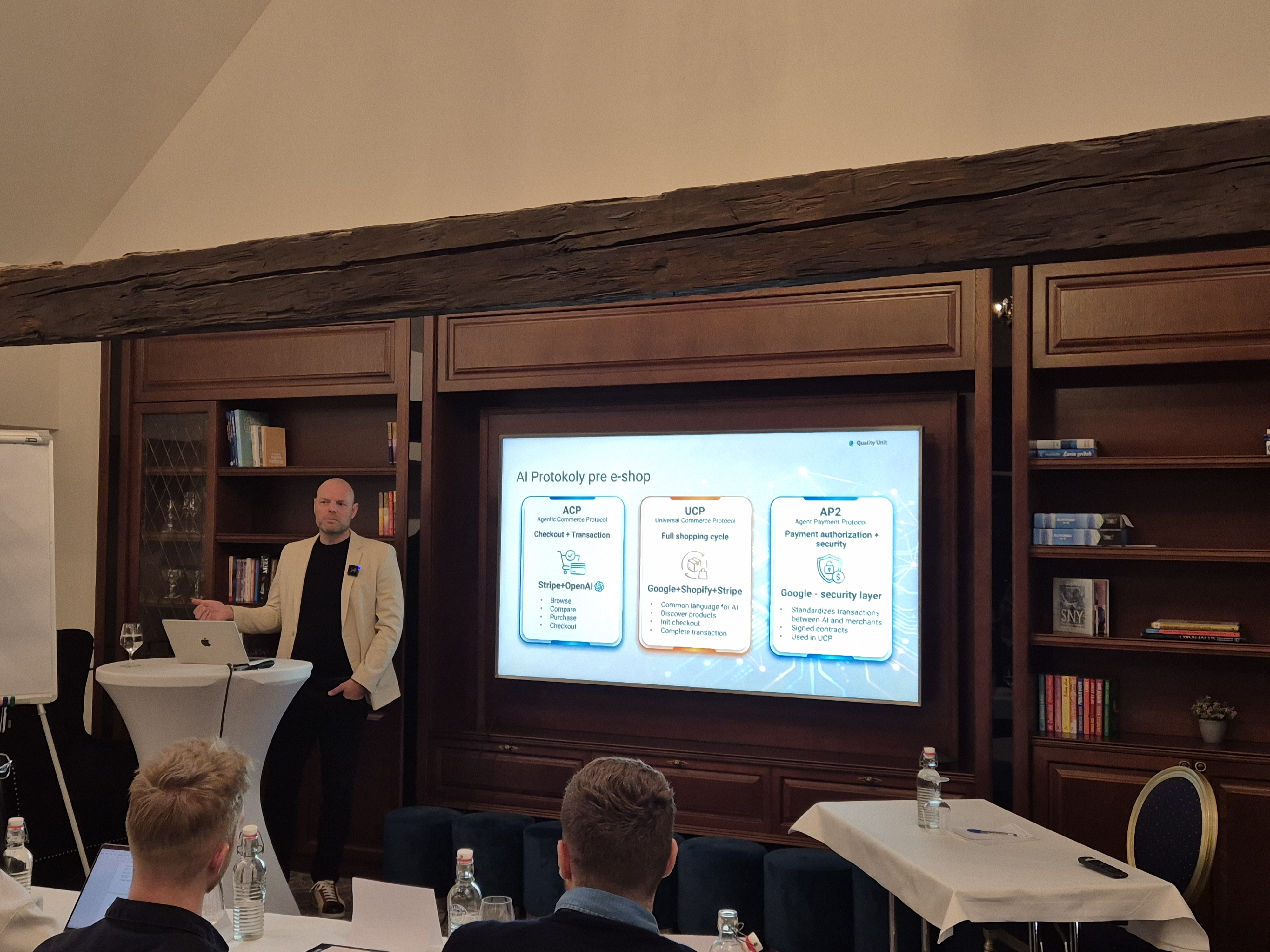

Viktor lagde grundlaget ved at introducere de standardiserede protokoller, der gør det muligt for AI at interagere med e-handelssystemer på vegne af brugerne.

Store platforme som Shopify, Salesforce Commerce Cloud eller BigCommerce er allerede begyndt at implementere dele af disse protokoller. Det samme gælder betalingsprocessorerne Stripe, PayPal og Checkout.com. Dette viser tydeligt, at AI-handelskompatibilitet er ved at blive en konkurrencemæssig baseline.

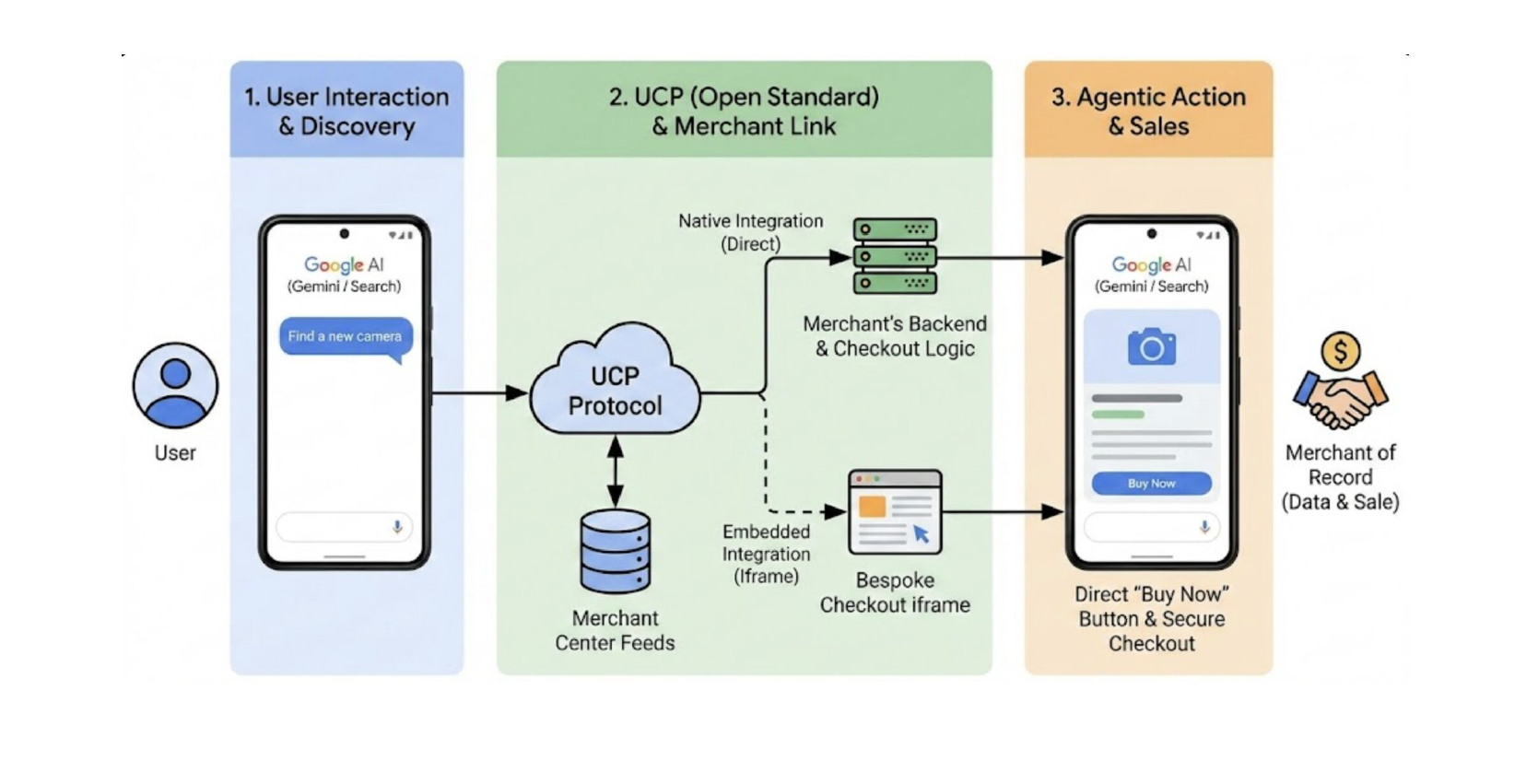

Universal Commerce Protocol (UCP) gør det muligt for AI-assistenter at opdage produkter, sammenligne muligheder, påbegynde betaling og gennemføre transaktioner uden at brugerne forlader AI-grænsefladen. UCP er allerede implementeret i Shopify, Salesforce Commerce Cloud, BigCommerce og større betalingsprocessorer.

Agentic Commerce Protocol (ACP), et samarbejde mellem Stripe og OpenAI, fokuserer specifikt på transaktionssikkerhed og enkelhed inden for samtalebaserede grænseflader. Mens UCP adresserer den bredere shoppingcyklus, specialiserer ACP sig i købsprocessen, da den muliggør betaling direkte inden for chatgrænseflader.

Agent Payment Protocol (AP2), udviklet af Google, leverer sikkerhedsrammen, der gør AI-medierede transaktioner troværdige gennem transaktionssignering, forhandlergodkendelse og betalingsautorisation. AP2 integreres med UCP for at levere det tillidslag, der gør autonom AI-køb til en realitet.

For at din e-shop kan blive kompatibel med AI-drevet shopping og dermed anbefalet af AI-platforme, skal du eksponere maskinlæsbare data på flere niveauer:

Produkter skal beskrives ved hjælp af standarder som:

schema.org: Giv AI strukturerede data, den kan læse og forståDette gør det muligt for AI-systemer at fortolke produkter uden tvetydighed, herunder varianterne, priser, tilgængelighed og forsendelsesbegrænsninger. Det er det fundament, AI-systemer bruger til at forstå, hvad du sælger.

AI-agenter evaluerer ikke kun produkterne, de evaluerer også, om forhandlerne er troværdige og et godt match for brugeren. Derfor skal nøgleinformation om din virksomhed være eksplicit og tilgængelig:

Meget af disse data eksisterer allerede i systemer som Google Merchant Center, men de skal være komplette, nøjagtige og konsekvent vedligeholdt.

En af de mindre synlige, men kritiske komponenter er handelsmanifestet. Det er typisk en JSON-fil hostet på forhandlerens domæne.

Dette manifest definerer understøttede protokolversioner, tilgængelige tjenester, betalingshåndterere og betalingsfunktioner, hvilket hjælper AI-agenter med at forstå, hvordan din butik fungerer.

Implementer tre kritiske endepunkter:

Implementer den førnævnte Agent Payment Protocol til sikker transaktionshåndtering.

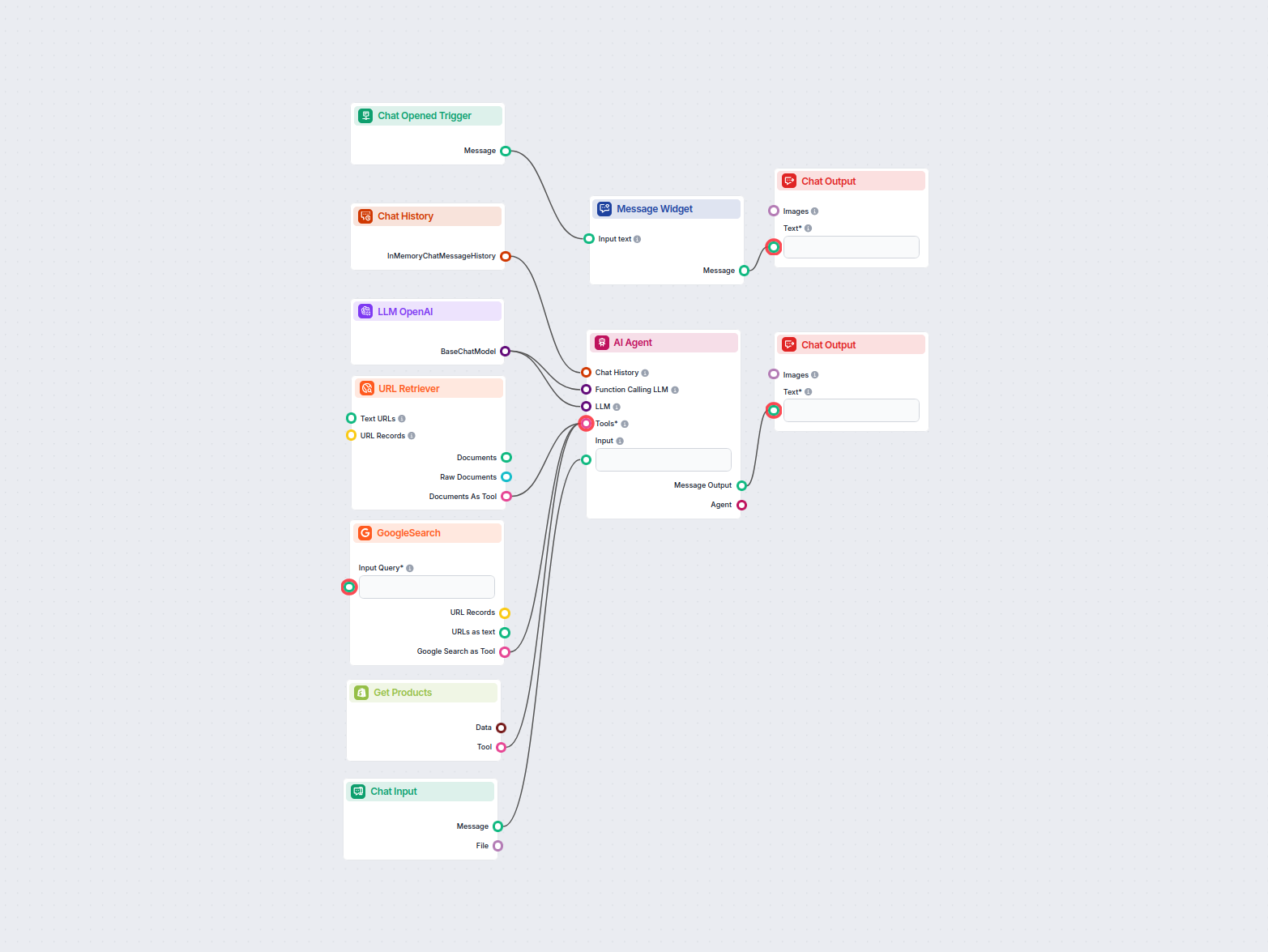

For platforme uden native UCP-understøttelse giver MCP en integrationssti. Zeman understregede MCP’s voksende betydning som forbindelseslag mellem AI-agenter og eksisterende systemer.

Udvikling af en tilpasset MCP-server gør det muligt for dig at skabe præcise prompts skræddersyet til dine specifikke use cases og sende isolerede API-kald med korrekt hastighedsbegrænsning. På denne måde kan du være sikker på, at din AI-implementering vil være sikker, kontrolleret og så billig som muligt.

Eksempel: En chatbot integreret med e-handels-MCP og en forsendelsesleverandør (f.eks. Chameleon) gør det muligt for kunder at forespørge ikke kun ordrestatus, men spore levering i realtid, alt sammen inden for en enkelt samtale.

Det andet implementeringsemne, Viktor dækkede, var teknisk SEO. Han lagde stor vægt på at understrege, at hjørnestenen i SEO ikke er søgeord. Det er “en infrastruktur, som både søgemaskiner og AI-systemer kan få adgang til og stole på”. For langsomme og upålidelige sider bliver forladt af både brugere og crawlere.

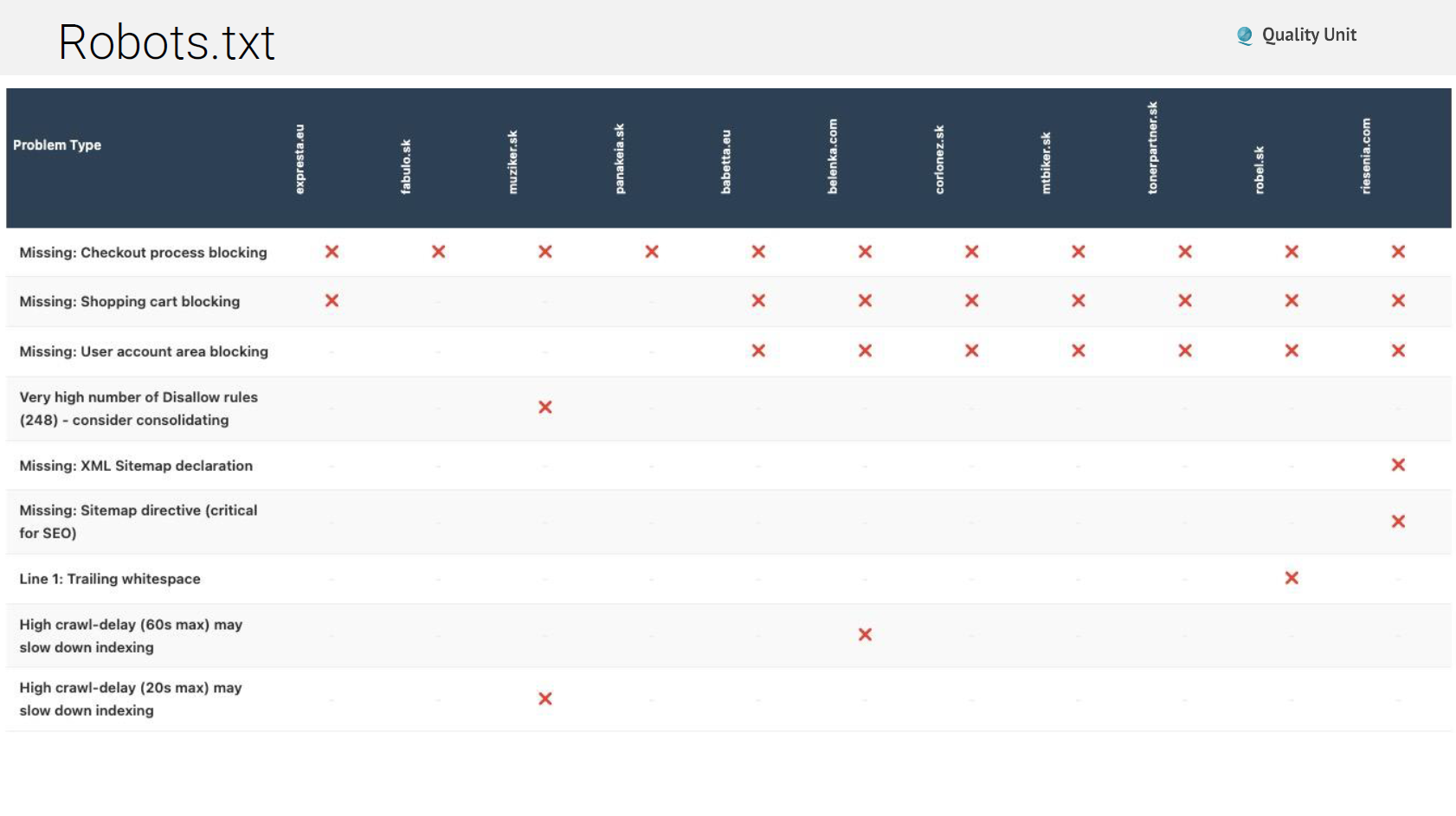

På trods af at være en 30 år gammel standard forbliver robots.txt hyppigt fejlkonfigureret. De almindelige problemer omfatter:

Ikke-eksisterende robots.txt: Nogle sider returnerer fejlsider eller vedligeholdelsesmeddelelser i stedet for korrekte robots.txt-filer, hvilket forvirrer crawlere om, hvad der er tilladt.

Blokerede AI-bots: Blokering af AI-crawlere forhindrer dit indhold i at blive citeret i AI-svar. Selvom du måske ønsker at blokere nogle bots, eliminerer generel blokering AI-synlighed.

Manglende sitemap-direktiver: Robots.txt bør referere til dine XML-sitemaps og guide crawlere til komplet indholdsopdagelse.

Syntaksfejl: Efterstillede kommaer i wildcards (Disallow: /?pv=*,) forårsager parsing-fejl i nogle crawlere og skaber utilsigtet blokering.

Blokeret værdifuldt indhold: Nogle gange blokerer sider indhold, de faktisk ønsker indekseret, normalt gennem alt for brede wildcard-regler.

XML-sitemaps fortæller søgemaskiner og AI-systemer, hvilket indhold der eksisterer, og hvordan det er organiseret. Almindelige problemer på dette område omfatter:

Cache-header-problemer: Forkerte cache-headere kan forhindre sitemaps i at opdatere korrekt, hvilket efterlader crawlere med forældede indholdslister.

Ufuldstændig URL-dækning: Plugin-genererede sitemaps mangler ofte brugerdefinerede posttyper, taksonomier eller dynamiske sider, hvilket efterlader betydeligt indhold uopdaget.

Hastighedsbegrænsningsproblemer: Nogle sider implementerer aggressiv hastighedsbegrænsning, der blokerer sitemap-hentning helt og returnerer 429-fejl efter blot 10 URL’er.

Links til 404-sider: Sitemaps, der indeholder døde links, spilder crawler-budget og signalerer dårlig sitevedligeholdelse.

Korrekte HTTP-cache-headere forbedrer dramatisk ydeevnen for tilbagevendende besøgende og reducerer serverbelastningen. Alligevel fejlkonfigurerer mange sider dette fuldstændigt. Cache-Control-direktiver betyder noget:

Viktor understregede vigtigheden af at tjekke cache-headere for alle aktivtyper: HTML, CSS, JavaScript, billeder, skrifttyper og API-svar.

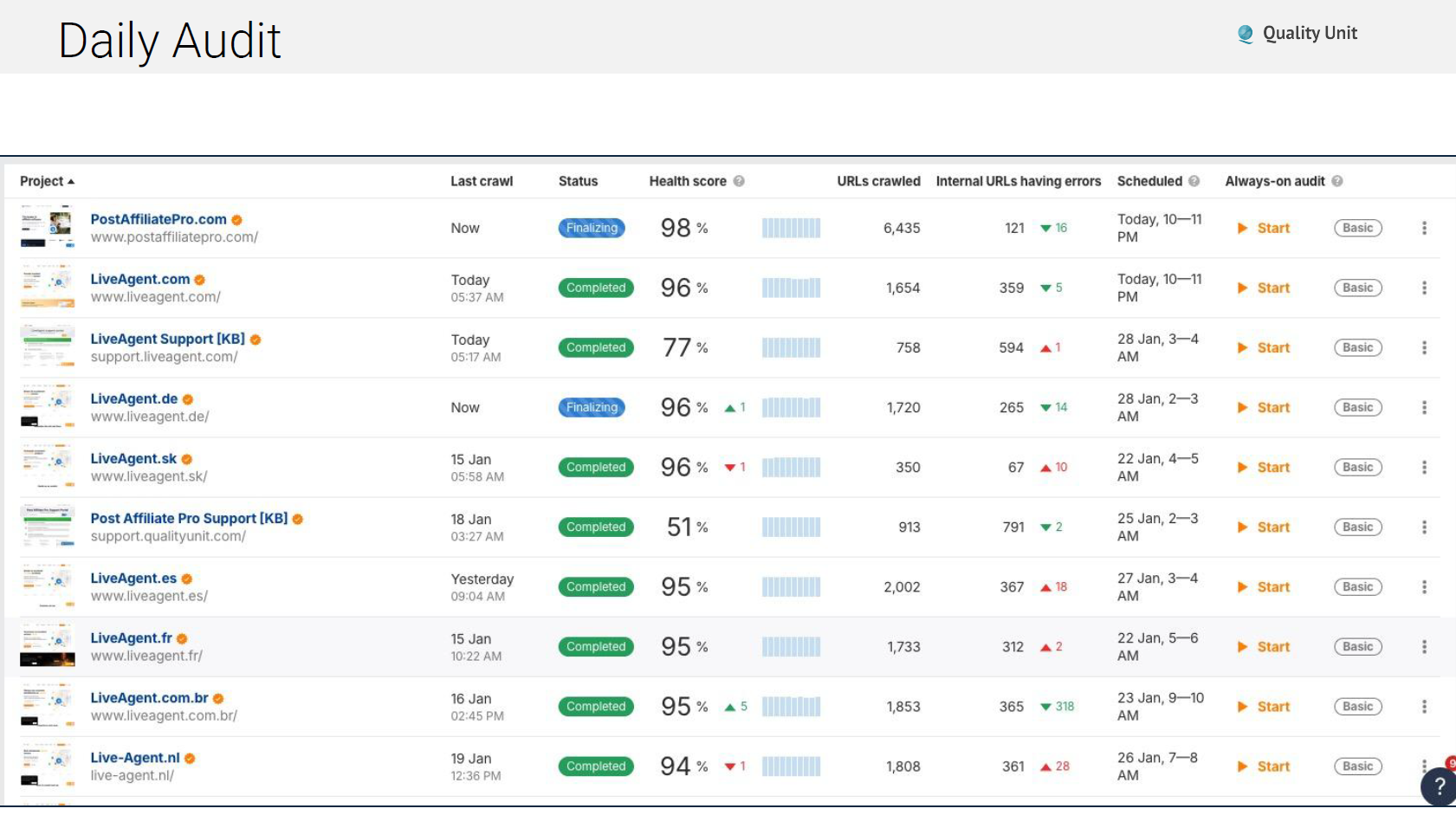

Tekniske problemer opstår konstant, og derfor kører vores team automatiserede daglige audits, der tjekker:

Brug af værktøjer som Ahrefs til automatiseret overvågning sikrer, at problemer bliver fanget og løst, før de akkumuleres til større trafiktab:

Googles Core Web Vitals påvirker direkte rangeringer. Du bør hovedsageligt fokusere på disse to kritiske værktøjer: PageSpeed Insights giver laboratoriedata, der viser potentiel ydeevne under kontrollerede forhold. Chrome User Experience Report (CrUX) giver virkelige data fra faktiske brugere, der besøger dit site.

De tre kritiske målinger at holde øje med er:

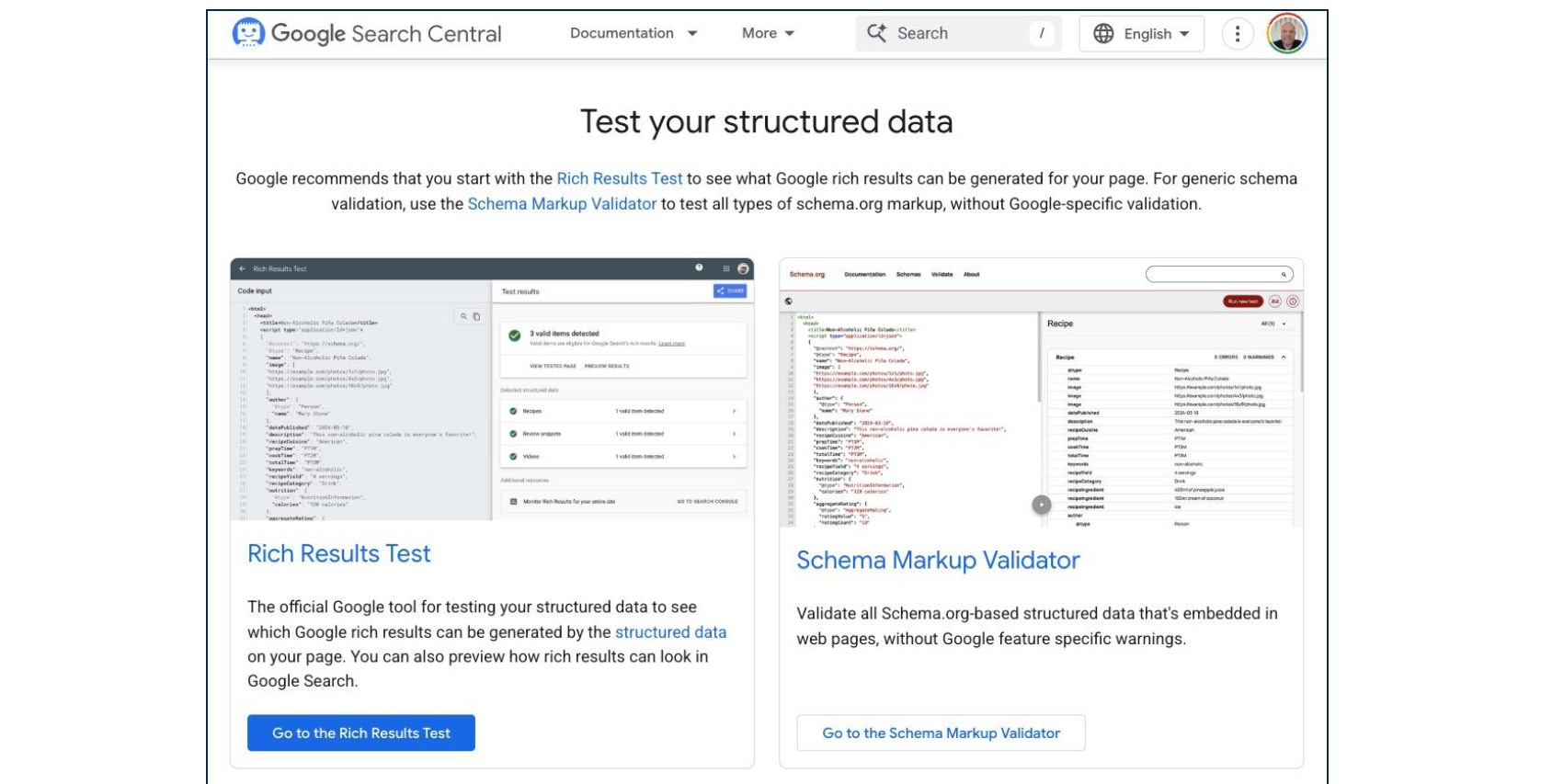

Schema.org-markup transformerer HTML til maskinlæsbare strukturerede data. Både traditionelle søgemaskiner og AI-systemer er afhængige af schema for at forstå indholdskontekst og relationer.

Væsentlige schema-typer til e-handel:

Almindelige schema-implementeringsfejl omfatter:

Regelmæssig validering gennem Googles Rich Results Test sikrer, at schema forbliver korrekt struktureret og komplet.

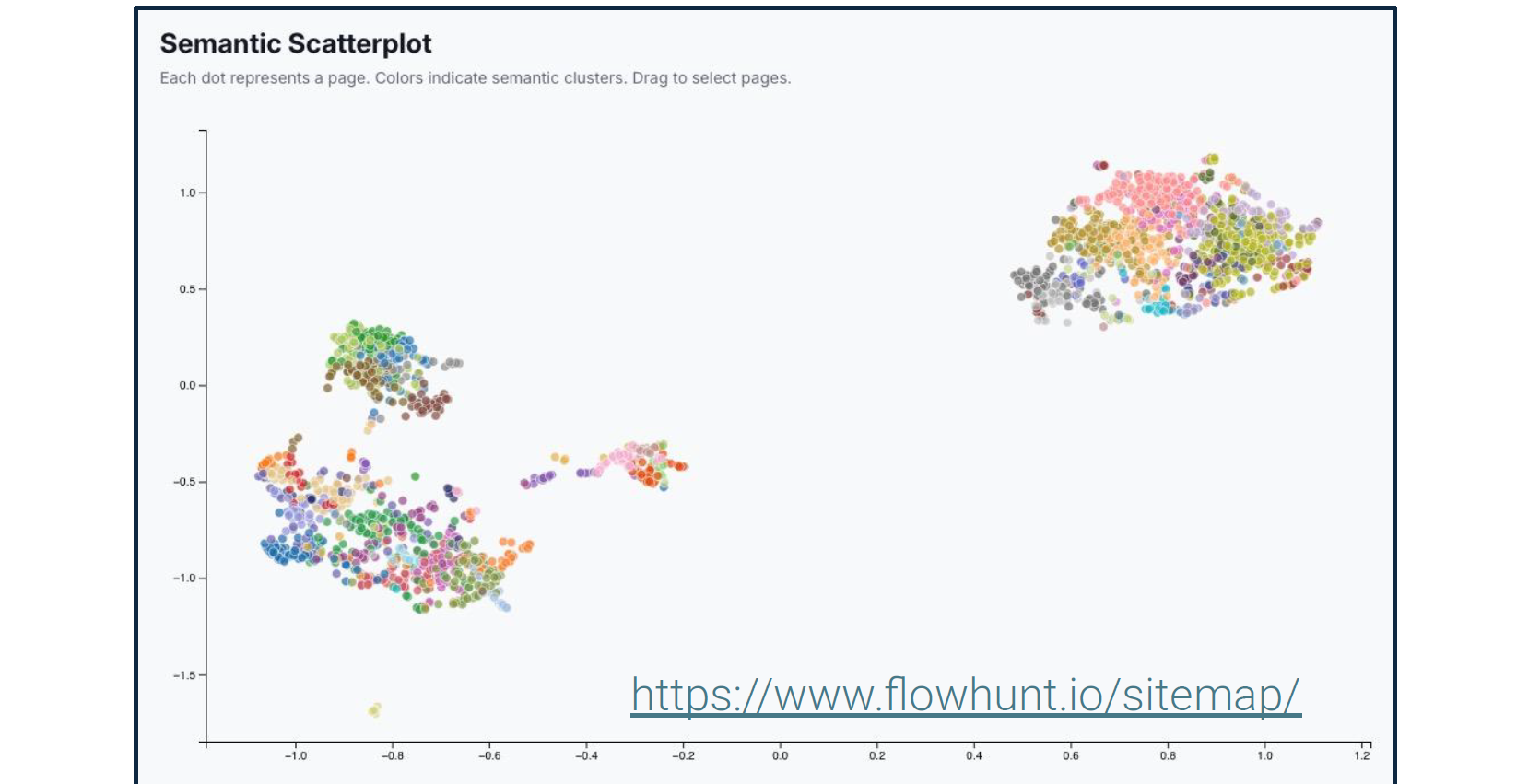

Viktor understregede gentagne gange, at SEO ikke længere handler om søgeord. Han detaljerede semantiske analyseværktøjer, der afslører, hvordan søgemaskiner og AI-systemer forstår dit indholds betydning snarere end blot ordene.

Disse værktøjer visualiserer entitetsrelationer, emnedækning og semantiske forbindelser inden for dit indhold. AI-systemer bruger disse relationer til at bestemme, hvornår dit indhold besvarer specifikke forespørgsler, selv når nøjagtige søgeord ikke vises.

Mens traditionel SEO spurgte: “Indeholder denne side de rigtige søgeord?” Moderne SEO spørger: “Demonstrerer denne side ekspertise om relevante entiteter og deres relationer?”

“Google er ligeglad med, om du siger, du er ‘Den hurtigste telefonreparationsbutik i Bratislava’. Den spørger, om dit websted viser ekspertise om entiteten ’telefon’ i forhold til entiteterne ‘reparation’ og ‘Bratislava’. Validerer andre kilder ekspertise om disse entiteter? For eksempel anmeldelser eller native annoncer. Signalerer brugeradfærd, såsom tid brugt på sitet, at indholdet er relevant?” - Viktor Zeman

Han understreger yderligere, at du bør starte med hurtige gevinster, såsom at rette nogle af dine tekniske SEO-problemer. Resultaterne burde vise sig på ingen tid. Først når AI og søgemaskiner korrekt kan læse og forstå dit site, vil det være tid til at begynde at skabe søgeordsrigt indhold.

Viktor udfordrede konventionel visdom om linkbuilding og argumenterede for, at intern linkstruktur fortjener langt mere opmærksomhed, end de fleste sider giver den.

PageRank-distribution: Google (og i stigende grad AI-systemer) flyder autoritet gennem links. Din interne linkstruktur bestemmer, hvilke sider der modtager denne autoritet.

Link juice-koncentration: Links fra sider med høj trafik bærer mere værdi end links fra sjældent besøgte sider. Strategisk intern linking forstærker virkningen af dit mest populære indhold.

Kontekst gennem ankertekst: De ord, der bruges i links, signalerer emnerelationer til både søgemaskiner og AI-systemer.

Placeringshierarki: Links i hovedindhold bærer mere vægt end footer- eller navigationslinks.

På vores websteder kæmper vi ikke mod vindmøller, der forsøger at skalere og vedligeholde konsistente manuelle interne links. I stedet har vi implementeret automatiseret intern linking i stor skala. Denne automatisering overvejer:

Resultatet er en omfattende intern linkstruktur, der ville være umulig at vedligeholde manuelt, samtidig med at det sikres, at hvert stykke indhold forbinder logisk til relaterede emner.

Viktors tilgang til AI-indholdsproduktion fokuserer på systematisk struktur snarere end ad hoc-artikeloprettelse.

Før du genererer indhold, skal du forstå, hvordan AI-systemer i øjeblikket diskuterer din branche: Trin 1: Generer testprompts - Opret 500+ spørgsmål, der repræsenterer, hvordan brugere måske forespørger AI-systemer om emner i dit domæne. Trin 2: Analyser AI-svar - Brug værktøjer som AmICited.com til at se, hvilke kilder AI-systemer i øjeblikket citerer, når de besvarer disse prompts.

Dette vil afsløre:

Trin 3: Identificer huller - Find spørgsmål, hvor AI-systemer giver svage svar eller citerer dårlige kilder. Disse repræsenterer muligheder for at blive den autoritative citation.

AI-optimerede produktbeskrivelser gavner tre kritiske kanaler:

I stedet for generisk “blogindhold” går Viktor ind for at skabe specialiserede AI-agenter til at generere hver distinkt posttype, hver med definerede elementer og struktur. For eksempel ordliste, tjeklister, how-to-indlæg, funktionsdokumentation, men også genanvendelige blogrammer såsom analyse, insights, branchekommentarer.

Mens en generel AI-agent med en virkelig god prompt måske slår guld første gang, er det ikke, hvad du har brug for. Du leder efter skala og gentagelige nøjagtige workflows. At skrive nye prompts til agenter hver gang, håbe på, at de virker, og derefter gemme promptsne i en notesblok vil ikke give dig det. Manuel kopiering af den samme prompt for at få et enkelt output vil ikke skalere.

Hvad du skal gøre, er at skabe en højt specialiseret AI-agent, der vil præstere fejlfrit konsekvent og i skala. Hver posttype kræver en dedikeret AI-agent konfigureret med specifikke prompt-skabeloner, formateringsregler og strukturelle krav.

Dette inkluderer klart at definere hvert afsnit af posttypen. For eksempel for titelelementet anbefaler Viktor at tilføje denne struktur til din prompt:

Viktor skitserede kort den nøjagtige proces, vores team bruger:

Generer prompt-bibliotek: Opret 500+ prompts, der repræsenterer brugerforespørgsler på tværs af dit domæne ved hjælp af AmICited.com eller lignende værktøjer.

Analyser citationsmønstre: Forstå nuværende AI-adfærd for disse prompts og find muligheder. Find ud af, hvad der citeres, hvad der mangler, hvad der er svagt.

Byg specialiserede agenter: Opret AI-agenter i FlowHunt (eller lignende platforme) til hver posttype med definerede elementer og begrænsninger.

Generer systematisk: Producér indhold i stor skala ved hjælp af specialiserede agenter til hver posttype, der opretholder konsistent struktur og kvalitet.

Implementer semantisk linking: Brug semantiske lighedsalgoritmer til automatisk at foreslå og skabe relaterede artikelforbindelser.

Overvåg og forfinr: Spor hvilket indhold der bliver citeret af AI-systemer, og forfinr din tilgang baseret på reelle citationsdata.

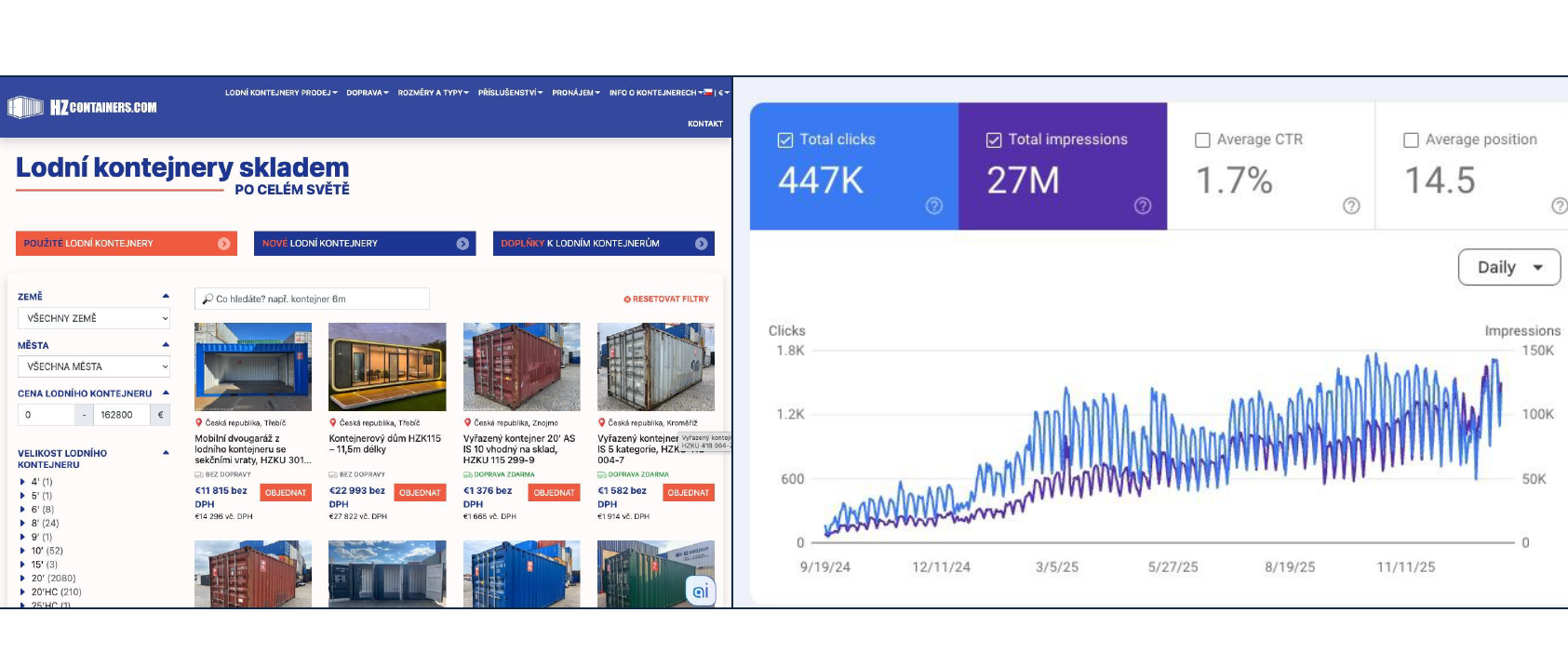

18.000% trafikstigning (180x) fra januar-september 2025, der leverer 2.000 containere. Tilgangen er bygget på tekniske SEO-fundamenter, omfattende indhold, der besvarer alle spørgsmål, korrekt schema-markup, strukturerede posttyper og automatiseret intern linking. Ingen søgeordsstopning eller linkordninger.

Viktor understregede en fundamental overgang, der sker i, hvordan folk finder og evaluerer produkter online. Google overvejer hundredvis af rangfaktorer. Her er kun en delvis liste for at illustrere kompleksiteten:

Virkeligheden er, at hver forbedring kun bidrager med promille (tusindedele) af gevinst. At opnå meningsfulde rangforbedringer tager måneder med kontinuerlig optimering på tværs af snesevis af faktorer samtidigt. Traditionel SEO forbliver vigtig, men repræsenterer en slibende, trinvis tilgang til synlighed.

Generative Engine Optimization fokuserer på at blive citeret af AI-systemer, når brugere stiller spørgsmål, der er relevante for din virksomhed.

Nøgleforskelle fra traditionel SEO:

Her er en hurtig oversigt over nøgleværktøjerne og implementeringskøreplan.

Viktor anbefalede en specifik sekvens for implementering: Fase 1: Teknisk fundament (Uge 1-4) • Infrastruktur-audit og optimering • Robots.txt- og sitemap-konfiguration • Cache-header-implementering • Core Web Vitals-forbedring • Schema.org-markup for eksisterende sider Fase 2: Indholdsstruktur (Uge 5-8) • Definer posttyper og deres elementer • Opret specialiserede AI-agenter til hver type • Etabler automatisering af intern linking • Implementer semantiske lighedssystemer Fase 3: Indholdsproduktion (Uge 9-16) • Generer prompt-bibliotek (500+ prompts) • Analyser nuværende citationsmønstre • Begynd systematisk indholdsoprettelse • Overvåg AI-citationsydeevne • Forfinr baseret på data Fase 4: Protokolimplementering (Løbende) • Implementer UCP/ACP/AP2, hvis relevant • Udvikl tilpassede MCP-servere til integrationer • Test AI-handelsfunktionalitet • Udvid baseret på adoption

Dette er ikke en hurtig-gevinst-strategi. Teknisk SEO, omfattende indhold og AI-protokolimplementering kræver vedvarende investering over måneder.

Imidlertid sammensættes resultaterne. Hvert stykke korrekt struktureret indhold øger din autoritet. Hver teknisk forbedring forbedrer effektiviteten af alt dit indhold. Hver citation af AI-systemer øger sandsynligheden for fremtidige citationer. Spørgsmålet er ikke, om man skal investere i denne infrastruktur—det er, om man skal lede overgangen eller følge senere, når konkurrenter allerede har etableret autoritet i AI-medieret opdagelse.

For tekniske ledere inden for e-handel tilbyder denne ramme klarhed. Du skal starte med at bygge ordentlige tekniske fundamenter, implementere AI-handelsprotokoller, strukturere indhold systematisk og optimere til både traditionel søgning og AI-citationer samtidigt. Den infrastruktur, du bygger i dag, bestemmer synlighed, når brugere spørger AI-systemer om anbefalinger i morgen.

Viktors tekniske præsentation komplementerer de strategiske og operationelle perspektiver fra tidligere i konferenceserien.

Michal Lichners implementeringskøreplan etablerede, hvor man skal fokusere AI-implementering, og hvordan man forbereder indhold systematisk. Zemans præsentation giver den tekniske infrastruktur, der gør dette indhold synligt og funktionelt.

Jozef Štofiras supportautomatisering viser det nøjagtige sæt værktøjer, vi bruger til at automatisere support-gruntwork, fra filtrering og kategorisering til databerigelse, svarassistent og menneskelig overdragelse.

Tilsammen danner disse tre perspektiver et komplet billede: strategisk planlægning, teknisk infrastruktur og operationel udførelse for e-handel i et AI-medieret handelsmiljø.

AI-handelsprotokoller som UCP (Universal Commerce Protocol), ACP (Agentic Commerce Protocol) og AP2 (Agent Payment Protocol) standardiserer, hvordan AI-systemer interagerer med e-handelsplatforme. De gør det muligt for AI-assistenter at gennemse produkter, sammenligne muligheder, påbegynde betaling og gennemføre transaktioner på vegne af brugere, hvilket gør din butik tilgængelig gennem AI-medierede shoppingoplevelser.

SEO (søgemaskineoptimering) fokuserer på at rangere i traditionelle søgemaskiner som Google gennem søgeordsoptimering og backlinks. GEO (Generative Engine Optimization) fokuserer på at blive citeret af AI-systemer som ChatGPT og Perplexity gennem struktureret indhold, klare entitetsdefinitioner og omfattende svar. Moderne e-handel har brug for begge dele: SEO til nuværende trafik, GEO til fremtidig AI-medieret opdagelse.

Prioriterede grundprincipper omfatter: hurtig, sikker infrastruktur med CDN; korrekt konfigureret robots.txt og sitemaps; korrekte cache-headere; regelmæssige tekniske audits; Core Web Vitals-optimering; omfattende schema.org-markup for entiteter; semantisk indholdsstruktur; og automatiseret intern linking. Disse skaber det fundament, som både traditionelle søgemaskiner og AI-systemer har brug for for at forstå og indeksere dit indhold korrekt.

Start med at generere 500+ prompts ved hjælp af værktøjer som AmICited.com for at forstå, hvordan AI-systemer i øjeblikket diskuterer din branche. Opret specialiserede AI-agenter til hver indholdstype (ordliste, how-to, tjeklister, produktbeskrivelser) med definerede elementer og formateringsregler. Brug semantisk lighed til forslag til relaterede artikler. Generer indhold, der besvarer alle potentielle besøgendes spørgsmål omfattende i stedet for at målrette snævre søgeord.

Arshia er AI Workflow Engineer hos FlowHunt. Med en baggrund inden for datalogi og en passion for AI, specialiserer han sig i at skabe effektive workflows, der integrerer AI-værktøjer i daglige opgaver og øger produktivitet og kreativitet.

Byg AI-agenter, der genererer SEO-optimeret indhold, implementerer tekniske SEO-forbedringer og skaber AI-protokolintegrationer—alt sammen inden for FlowHunts visuelle workflow-builder.

En praktisk ramme for implementering af AI i e-handel fra Quality Units CMO. Lær hvor du skal starte, almindelige udfordringer, strategier til indholdsforberede...

Lær hvordan du opretter en AI-drevet Shopify manager ved hjælp af FlowHunts MCP server-integration til at automatisere produktstyring, ordrer, kunder og lagerko...

Dette AI-drevne workflow hjælper Shopify-forhandlere med at analysere konkurrentprodukter, undersøge markedstendenser og udarbejde optimerede prisstrategier. Ve...

Cookie Samtykke

Vi bruger cookies til at forbedre din browsingoplevelse og analysere vores trafik. See our privacy policy.