Inde i sindet på Llama 3.3 70B Versatile 128k som en AI-agent

Udforsk de avancerede evner hos Llama 3.3 70B Versatile 128k som en AI-agent. Denne dybdegående anmeldelse undersøger dens evner inden for ræsonnement, probleml...

Udforsk hvordan AI21’s Jamba 3B kombinerer transformer attention med state space models for at opnå hidtil uset effektivitet og lang-kontekst-evner på edge-enheder og derved omforme fremtiden for store sprogmodeller.

Landskabet for store sprogmodeller har gennemgået en dramatisk forvandling i de seneste år, hvor forskere og virksomheder konstant søger måder at forbedre effektiviteten uden at gå på kompromis med ydeevnen. AI21’s introduktion af Jamba 3B udgør en vigtig milepæl i denne udvikling—en hybridmodel, der kombinerer styrkerne fra transformer attention-mekanismer med state space models for at opnå hidtil usete effektivitetsgevinster. Dette gennembrud kommer på et kritisk tidspunkt, hvor de beregningsmæssige krav til træning og udrulning af store sprogmodeller er blevet en væsentlig flaskehals for organisationer verden over. I denne omfattende guide udforsker vi de tekniske innovationer bag Jamba 3B, forstår hvorfor hybride arkitekturer repræsenterer fremtiden for sprogmodeller, og ser nærmere på, hvordan denne tilgang omformer mulighederne for AI-udrulning på tværs af forskellige computermiljøer.

AI21 blev grundlagt for over syv år siden af Ori Levy, Yoav Shoham og Amnon Shashua med et visionært udgangspunkt, der skulle guide alt deres efterfølgende arbejde: Deep learning, selvom det er utroligt kraftfuldt og nyttigt, er ikke tilstrækkeligt alene. Virksomhedens grundlæggende filosofi centrerede sig om at bygge bro mellem klassisk kunstig intelligens og moderne deep learning-metoder og skabe systemer, der kunne udnytte styrkerne fra begge paradigmer. Denne mission viste sig at være fremsynet, da virksomheden begyndte sit arbejde lige før udgivelsen af GPT-3, hvilket placerede dem perfekt til at observere og deltage i de revolutionerende forandringer, der skulle omforme hele AI-industrien. Fra de tidligste dage i 2018 forpligtede AI21 sig til at træne modeller med et dobbelt fokus på både videnskabelig stringens og praktiske anvendelser. Denne balancerede tilgang blev et kendetegn for virksomhedens arbejde og adskilte dem fra konkurrenter, der ofte prioriterede enten ren forskning eller øjeblikkelig kommercialisering.

Gennem hele sin historie har AI21 fastholdt denne forpligtelse til at kombinere banebrydende forskning med anvendelser i den virkelige verden. Virksomheden udviklede Wordtune, en applikation, der gav værdifuldt fodfæste på markedet og fungerede som en testplatform for deres sprogmodel-forskning. Da GPT-3 udkom, reagerede AI21 ved at træne deres egen model, Jurassic-1, som opnåede ydeevnemålinger på niveau med eller lidt bedre end OpenAI’s tilbud. Denne tidlige succes etablerede AI21 som en seriøs aktør på markedet for store sprogmodeller, men virksomhedens ambitioner rakte langt ud over blot at matche eksisterende modeller. Holdet indså, at fremtidens AI ikke kun ville kræve større modeller, men smartere arkitekturer, der kunne levere bedre ydeevne med større effektivitet. Denne indsigt førte til udviklingen af Jamba—deres banebrydende hybridmodellinje, der udfordrede den gængse opfattelse af, hvordan sprogmodeller bør konstrueres.

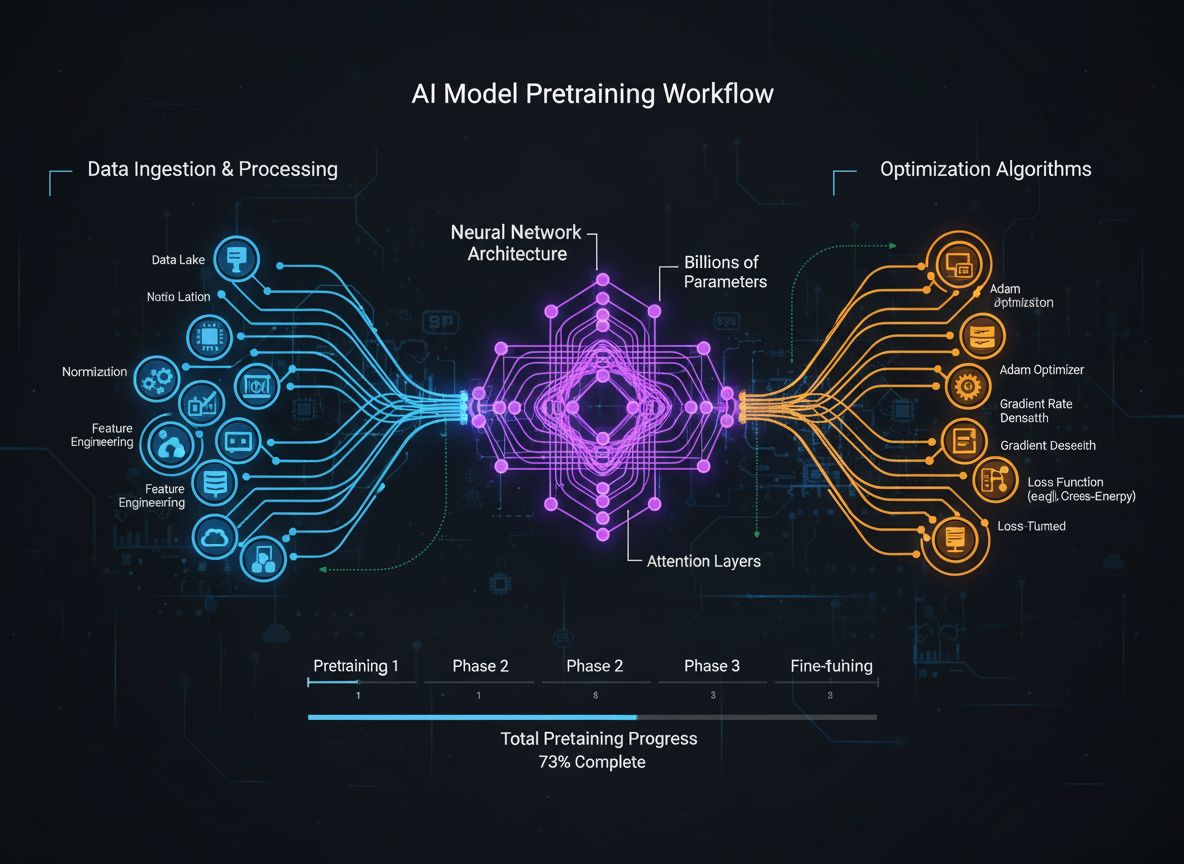

Hybride sprogmodeller repræsenterer et fundamentalt brud med den rene transformerarkitektur, der har domineret feltet siden udgivelsen af GPT-2 og senere modeller. Traditionelle transformerbaserede sprogmodeller er udelukkende afhængige af attention-mekanismer, hvor hvert token i en sekvens kan fokusere på alle andre tokens. Selvom denne tilgang har vist sig yderst effektiv til sprogforståelse og -generering, har den en betydelig beregningsmæssig pris: Attention-mekanismen har kvadratisk kompleksitet i forhold til sekvenslængden, hvilket betyder, at fordobling af kontekstvinduet firedobler beregningskravene. Derudover vokser key-value-cachen, der kræves til attention, lineært med sekvenslængden, hvilket skaber hukommelsesflaskehalse, der bliver stadig mere problematiske, efterhånden som kontekstvinduerne udvides. Disse begrænsninger er blevet kritiske udfordringer for moderne applikationer—særligt dem, der kræver lang-kontekst-behandling, personalisering, hukommelsesfastholdelse og agentisk ræsonnement.

Hybride modeller adresserer disse begrænsninger ved at kombinere transformer attention med state space models, især Mamba, der tilbyder lineær kompleksitet i forhold til sekvenslængden. I stedet for helt at erstatte attention—hvilket ville gå ud over de ræsonnementsevner, der gør transformers så effektive—benytter hybride arkitekturer attention selektivt, typisk i et 1:8-forhold, hvor kun ét ud af hver otte lag bruger fuld attention, mens de øvrige lag benytter den mere effektive state space-modeltilgang. Denne strategiske kombination bevarer modellens evne til at udføre komplekse ræsonnementer, der kræver global kontekstforståelse, samtidig med at de beregningsmæssige omkostninger og hukommelseskrav reduceres markant for størstedelen af modellens behandling. Resultatet er en model, der bevarer eller endda forbedrer ydeevnen på de fleste benchmarks, mens den bruger væsentligt færre ressourcer under både træning og inferens. Denne effektivitetsgevinst er ikke blot en marginal forbedring—det repræsenterer et grundlæggende skift i, hvad der bliver muligt for AI-udrulning, og gør det muligt at køre modeller på edge-enheder, i hukommelsesbegrænsede miljøer og i skalaer, der tidligere blev anset for upraktiske.

Vejen til Jambas hybride arkitektur var ikke forudbestemt, men opstod gennem omhyggelig eksperimentering og vilje til at udforske utraditionelle tilgange. AI21’s team arbejdede oprindeligt på J3, den tredje version af deres Jurassic-modelserie, med planer om at implementere en mixture-of-experts (MoE)-arkitektur. Hovedmotivet for MoE var enkelt: Det ville markant reducere træningsomkostningerne ved at fordele beregningerne på flere ekspertnetværk, hvilket gjorde træningsbudgettet mere overskueligt. Holdet ønskede dog også at sikre, at deres model kunne udrulles effektivt under inferens, så de designede J3 med flere versioner—en der kunne være på en enkelt GPU med 80 gigabyte hukommelse (som en A100 eller H100) og en større version, der kunne være inden for en enkelt pod. Dette fokus på inferenseffektivitet fra starten skulle vise sig afgørende for det endelige gennembrud.

Under ablation-studierne i modeludviklingen stødte Barak Lenz, CTO for AI21, på Mamba-papiret, som var blevet anbefalet til ham af flere kolleger. I modsætning til tidligere state space model-artikler, der havde vist begrænset potentiale, skilte Mamba-papiret sig ud ved sin stringente tilgang til sammenligning og evaluering. I stedet for at sammenligne med forældede baselines sammenlignede forfatterne Mamba direkte med de nyeste attention-arkitekturer, navnlig forbedringerne fra Llama, som havde optimeret lag-normalisering, aktiveringsfunktioner og andre arkitektoniske detaljer, der forhindrede træningsinstabiliteter. Mamba-papiret sammenlignede ikke kun retfærdigt med disse topmoderne baselines, men frigav også egne kerner og kode, hvilket viste ægte engagement i praktisk implementering. Fascineret af denne grundighed opfordrede Lenz sit ingeniørteam til at eksperimentere med Mamba og se, hvordan den klarede sig i forhold til deres eksisterende evalueringsdashboard, som på det tidspunkt indeholdt hundredvis af forskellige opgaver og benchmarks.

De første resultater var lovende, men afslørede vigtige begrænsninger. Mamba klarede sig konkurrencedygtigt med attention-baserede modeller på perplexity-målinger og de fleste opgaver, men der var specifikke områder, hvor den underpræsterede—særligt på få-skudslæringsopgaver, der krævede hurtig tilpasning til nye mønstre. Ved nærmere undersøgelse konkluderede holdet, at disse mangler skyldtes Manglen på attention-mekanismer—visse typer ræsonnement og mønstergenkendelse drager fordel af den globale kontekst, attention giver. I stedet for at acceptere denne begrænsning begyndte holdet at eksperimentere med hybride arkitekturer, hvor attention- og Mamba-lag vekslede, for at se, om de kunne opnå fordelene fra begge tilgange. Resultaterne overgik forventningerne: Ikke alene eliminerede den hybride tilgang performance-tabet fra rene Mamba-modeller, men den viste også forbedringer over hele linjen sammenlignet med standard transformerarkitekturer. Denne opdagelse blev den katalysator, der førte til udviklingen af Jamba.

Udviklingen af Jamba krævede, at der blev løst adskillige tekniske udfordringer, som aldrig tidligere var blevet adresseret i denne skala. Da AI21 begyndte at træne Jamba Mini, den første model i deres hybrideserie, var Mamba aldrig blevet skaleret ud over 3 milliarder parametre. Teamets hybride model nåede derimod op på 13 milliarder aktive parametre og cirka 52 milliarder samlede parametre, når man medregner mixture-of-experts-komponenterne. Dette udgjorde en enorm skaleringsudfordring, og krævede, at teamet debuggede og optimerede modelarkitekturen på måder, der ikke tidligere var forsøgt. Selve optimeringsprocessen blev en fascinerende ingeniørmæssig udfordring—holdet måtte nøje analysere modellens adfærd, identificere flaskehalse og implementere løsninger, der gjorde det muligt for den hybride arkitektur at træne effektivt i denne hidtil usete skala.

En af de mest afgørende beslutninger i Jambas arkitektur var at fastlægge det optimale forhold mellem attention- og state space-lag samt placeringen af disse lag i modellen. Gennem omfattende ablation-studier opdagede AI21, at et 1:8-forhold—hvor ét ud af hver otte lag bruger attention, mens de øvrige syv bruger Mamba—gav den bedste balance mellem ydeevne og effektivitet. Interessant nok havde placeringen af attention-lagene også stor betydning. Holdet testede at placere attention-lagene i starten, midten og slutningen af modellen og fandt, at placering midt i arkitekturen gav markant bedre resultater end i yderpunkterne. Selv mere aggressive forhold som 1:6 gav kun marginale forbedringer, som lå inden for standardafvigelsen, og retfærdiggjorde ikke de ekstra beregningsomkostninger ved flere attention-lag, især da hvert transformerlag tilføjer kvadratiske omkostninger til key-value-cachen under lang-kontekst-behandling.

Effektivitetsgevinsterne fra denne arkitektur er betydelige og mangesidige. Under træning reducerer den hybride tilgang de beregningsmæssige krav sammenlignet med rene transformer-modeller, hvilket gør det mere omkostningseffektivt at træne modeller i stor skala. Under inferens bliver fordelene endnu mere udtalte, især for applikationer med lange kontekster. Mens Mamba har en større fast omkostning for kortere sekvenser sammenlignet med attention, forsvinder og vender denne ulempe sig, efterhånden som sekvenslængden øges. Til applikationer, der kræver lang kontekst—herunder agentiske use cases, enterprise retrieval-augmented generation-systemer, personalisering med hukommelse og mange andre nye applikationer—giver den hybride arkitektur dramatisk bedre performance-karakteristika. Den lineære hukommelsesskalering fra Mamba betyder, at en fordobling af kontekstvinduet fordobler hukommelseskravet, mens det for ren attention firedobler det. Denne grundlæggende forskel bliver stadig vigtigere, efterhånden som applikationer kræver længere kontekstvinduer for at opretholde sammenhængende ræsonnement og hukommelse gennem længere interaktioner.

Efterhånden som organisationer i stigende grad tager avancerede sprogmodeller som Jamba 3B i brug, bliver udfordringen med at integrere disse modeller i produktionsworkflows kritisk. FlowHunt løser denne udfordring ved at tilbyde en omfattende platform til automatisering af AI-workflows—fra modelvalg og test til udrulning og overvågning. De effektivitetsgevinster, der opnås med hybride modeller som Jamba 3B, realiseres først fuldt ud, når de kombineres med intelligent workflow-automatisering, der kan optimere, hvordan modellerne udrulles, testes og overvåges i produktionsmiljøer. FlowHunt gør det muligt for teams at opbygge sofistikerede AI-systemer, der udnytter modeller som Jamba 3B, samtidig med at de bevarer overblik og kontrol over hele pipeline’en. Ved at automatisere rutineopgaver i forbindelse med udrulning og overvågning af modeller, giver FlowHunt teams mulighed for at fokusere på de strategiske aspekter af AI-integration, så de beregningsmæssige effektivitetsgevinster fra avancerede arkitekturer omsættes til reel forretningsværdi.

Kombinationen af effektive modeller og intelligent workflow-automatisering skaber en stærk synergi. Teams kan udrulle Jamba 3B på edge-enheder eller i hukommelsesbegrænsede miljøer med ro i sindet, velvidende at FlowHunts overvågnings- og optimeringsværktøjer sikrer ensartet ydeevne. For virksomheder, der bygger AI-systemer med behov for lang-kontekst-behandling, personalisering og agentisk ræsonnement, leverer FlowHunt infrastrukturen til at håndtere disse komplekse workflows effektivt. Platformens evne til at automatisere test, udrulning og overvågning betyder, at organisationer hurtigt kan iterere på deres AI-systemer og eksperimentere med forskellige modelkonfigurationer og udrulningsstrategier uden manuelt besvær. Det er særligt værdifuldt for organisationer, der udforsker mulighederne med hybride modeller, da det giver mulighed for at benchmarke forskellige arkitekturer og konfigurationer for at finde den optimale balance til deres konkrete use cases.

Lanceringen af Jamba 3B markerer en vigtig milepæl i at gøre avancerede AI-evner tilgængelige for et bredere spektrum af applikationer og udrulningsscenarier. I modsætning til tidligere modeller i Jamba-serien, der var designet til maksimal ydeevne i større skala, er Jamba 3B specifikt optimeret til edge-enheder og hukommelsesbegrænsede miljøer. “3B”-betegnelsen henviser til modellens størrelse—omkring 3 milliarder parametre—hvilket gør den lille nok til at køre på forbrugshardware, mens den bevarer fordelene ved den hybride arkitekturs effektivitet. Dette er en afgørende udvikling, fordi det demokratiserer adgangen til avancerede sprogmodelevner og muliggør applikationer, der tidligere var umulige på grund af beregningsbegrænsninger. Udviklere kan nu udrulle avancerede sprogmodeller på mobile enheder, IoT-devices, indlejrede systemer og andre edge computing-platforme uden at gå på kompromis med de ræsonnementsevner og lang-kontekst-behandling, der gør moderne sprogmodeller værdifulde.

Den mest markante egenskab ved Jamba 3B er dens evne til at håndtere lange kontekstvinduer og samtidig kunne udrulles på edge-enheder. Denne kombination var tidligere umulig med rene transformerarkitekturer—den kvadratiske kompleksitet i attention betød, at en udvidelse af kontekstvinduer på edge-enheder hurtigt ville udtømme den tilgængelige hukommelse. Jamba 3B’s hybride arkitektur ændrer fundamentalt på dette. Den lineære kompleksitet i Mamba-lagene betyder, at konteksten kan udvides uden den eksponentielle hukommelsesvækst, der plager rene attention-modeller. For applikationer, der kræver personalisering, hukommelsesfastholdelse, retrieval-augmented generation og agentisk ræsonnement, er denne evne transformerende. En edge-enhed, der kører Jamba 3B, kan fastholde sammenhængende kontekst gennem længere interaktioner og muliggøre avancerede applikationer, der tidligere kun var mulige med cloud-baserede modeller. Dette skifte har dybtgående konsekvenser for privatliv, latenstid og omkostninger—applikationer kan nu behandle følsomme data lokalt uden at sende dem til cloud-servere, svare på brugerforespørgsler med minimal latenstid og fungere uden at pådrage sig cloud-omkostninger.

Ser man på markedet for mini-modeller, skiller Jamba 3B sig ud som den eneste hybride model i sin størrelseskategori. De fleste eksisterende mini-modeller er baseret på rene transformerarkitekturer, hvilket betyder, at de står over for de samme effektivitetsbegrænsninger som deres større modstykker. Jamba 3B’s hybride tilgang giver den en betydelig fordel, når det gælder lang-kontekst-evner og beregningsmæssig effektivitet. Modellen opnår denne særstilling ikke gennem arkitektoniske kompromiser, der reducerer evnerne, men gennem de grundlæggende effektivitetsgevinster ved den hybride tilgang. Det gør Jamba 3B til et ideelt valg for applikationer, der skal balancere modelstørrelse og evner—særligt dem, der kræver lang-kontekst-behandling på edge-enheder.

På trods af de klare fordele ved hybride modeller er der fortsat betydelige forhindringer for deres udbredte adoption. AI-branchen har brugt år på at optimere hardware og software specifikt til transformer attention-mekanismer. Alle større hardwareplatforme—fra NVIDIA GPU’er til specialiserede AI-acceleratorer—har specialkerner og optimeringer til attention-operationer. Disse optimeringer er resultatet af mange års ingeniørarbejde og repræsenterer store investeringer i at gøre attention så effektivt som muligt på bestemte hardwareplatforme. Til sammenligning er state space models som Mamba relativt nye, og selvom de har egne specialkerner, er disse optimeringer ikke lige så modne eller udbredte på tværs af hardwareplatforme. Det skaber det, Barak Lenz omtaler som “hardware-lotteriet”—de effektivitetsfordele, hybride modeller giver, kan blive væsentligt mindre, hvis hardwareplatformen ikke har optimerede implementationer af state space model-operationer.

Denne mangel på hardwareoptimering udgør en reel barriere, men den er ikke uoverstigelig og sandsynligvis på vej til at svinde ind. Efterhånden som flere virksomheder anerkender værdien af hybride modeller og state space-arkitekturer, får hardwareproducenter større incitamenter til at investere i optimering af disse operationer. NVIDIA er allerede begyndt at udgive hybride modeller, og andre selskaber følger trop, hvilket tyder på, at branchen anerkender de langsigtede perspektiver i disse arkitekturer. Desuden er effektivitetsfordelene ved hybride modeller så markante, at de ofte overgår rene attention-modeller, selv uden perfekt hardwareoptimering. Den kvadratiske kompleksitet i attention er en så grundlæggende begrænsning, at selv med mange års optimering kan den ikke matche state space models lineære kompleksitet til lang-kontekst-applikationer. Efterhånden som sekvenslængderne øges—hvilket er en uundgåelig tendens, efterhånden som applikationer kræver mere kontekst for bedre ræsonnement og personalisering—vil fordelene ved hybride modeller blive stadig mere åbenlyse.

Udover AI21’s arbejde med hybride modeller ses en bredere tendens i branchen mod at bruge attention mere selektivt i stedet for i hvert lag. Selv virksomheder, der ikke implementerer fulde hybride arkitekturer, erkender, at fuld attention i hvert lag er unødvendigt og spild af ressourcer. Mange nyere modeller benytter sliding window attention, hvor hvert token kun kan fokusere på et begrænset vindue af omkringliggende tokens frem for hele sekvensen. Denne tilgang reducerer attention-kompleksiteten fra kvadratisk til lineær i forhold til vinduesstørrelsen, selvom det stadig kræver mere beregning end state space models. Det faktum, at forskere som Noam Shazir uafhængigt er nået frem til lignende konklusioner om optimale attention-forhold—specifikt 1:8-forholdet mellem lokal og global attention—tyder på, at dette ikke er et særpræget fund, men snarere en grundlæggende egenskab ved, hvordan sprogmodeller bør struktureres.

Denne konvergens af resultater på tværs af forskellige forskergrupper og firmaer indikerer, at branchen bevæger sig mod en ny konsensus om optimal modelarkitektur. I stedet for den rene transformer-tilgang, der har domineret siden GPT-2, vil fremtiden sandsynligvis involvere modeller, der bruger attention selektivt—enten gennem hybride arkitekturer som Jamba eller andre tilgange som sliding window attention. De konkrete implementeringsdetaljer kan variere, men det underliggende princip er det samme: Fuld attention i hvert lag er ineffektivt og unødvendigt. Dette skift repræsenterer en modning af feltet, hvor man bevæger sig ud over transformers første succes til en mere nuanceret forståelse af, hvornår og hvor attention reelt er nødvendigt. For praktikere og organisationer, der bygger AI-systemer, har dette vigtige konsekvenser—det antyder, at de modeller, de bygger og udruller i fremtiden, sandsynligvis vil være mere effektive end nuværende tilgange og muliggøre nye applikationer og use cases, som i dag er upraktiske på grund af beregningsbegrænsninger.

Oplev hvordan FlowHunt automatiserer dine AI- og SEO-workflows—fra research og indholdsgenerering til publicering og analyse—alt samlet ét sted.

Udover individuelle modeller har AI21 været pionerer inden for udviklingen af AI-systemer, der rækker ud over simpel sprogmodel-inferens. Virksomheden udgav Jarvis, et tidligt AI-system, der forsøgte at bruge værktøjer og eksterne ressourcer til at forstærke sprogmodellens kapaciteter. Dette arbejde gik forud for den udbredte anvendelse af værktøjsbrug i sprogmodeller og var med til at inspirere senere frameworks som LangChain. Den grundlæggende indsigt bag AI-systemer er, at sprogmodeller alene—selv om de er kraftfulde—ikke er tilstrækkelige for mange virkelige applikationer. For at bygge bro mellem deep learning og klassisk AI skal systemerne kunne kalde eksterne værktøjer, få adgang til databaser, eksekvere kode og udføre andre operationer, der kræver mere stringens og determinisme end ren neuralt netværk-inferens kan tilbyde.

Maestro, AI21’s enterprise-tilbud, repræsenterer udviklingen af denne tankegang til et produktionsklart system designet til forretningsapplikationer. I stedet for blot at udrulle en sprogmodel og håbe, den leverer nyttige outputs, tilbyder Maestro en ramme for at bygge AI-systemer, der pålideligt kan udføre komplekse opgaver ved at kombinere sprogmodellens evner med værktøjsbrug, retrieval og andre klassiske AI-teknikker. Denne tilgang er særlig vigtig i enterprise-applikationer, hvor pålidelighed, nøjagtighed og auditérbarhed er kritiske krav. En sprogmodel kan generere plausible, men forkerte oplysninger, mens et AI-system, der kan verificere sine outputs mod eksterne datakilder og bruge værktøjer til at udføre specifikke opgaver, kan levere langt højere pålidelighed. Adoptionen af AI-systemer i virksomheder har været langsommere end nogle forudsagde, men dette er ved at ændre sig, efterhånden som organisationer anerkender værdien af AI til at automatisere komplekse workflows og beslutningsprocesser.

Timingen af dette skift mod AI-systemer er vigtig. Da generativ AI først blev mainstream, fokuserede mange organisationer på enkle applikationer som indholdsgenerering og kundeservice-chatbots. Disse applikationer kunne ofte understøttes tilstrækkeligt af en sprogmodel med minimal yderligere infrastruktur. Men efterhånden som organisationer har fået erfaring med AI og identificeret mere avancerede use cases, er begrænsningerne ved rene sprogmodeller blevet tydelige. Applikationer, der kræver lang-kontekst-behandling, personalisering, hukommelsesfastholdelse og agentisk ræsonnement, drager alle fordel af den strukturerede tilgang, AI-systemer tilbyder. Derudover gør effektivitetsgevinsterne fra modeller som Jamba 3B det stadig mere praktisk at udrulle avancerede AI-systemer på edge-enheder og i ressourcebegrænsede miljøer. Sammenfaldet mellem mere effektive modeller og mere sofistikerede systemarkitekturer skaber nye muligheder for AI-udrulning i virksomheder.

For udviklere og organisationer, der overvejer hvordan de kan udnytte avancerede sprogmodeller i deres applikationer, har fremkomsten af Jamba 3B og hybride arkitekturer flere vigtige konsekvenser. For det første antyder det, at æraen med rene transformer-modeller kan være på vej mod enden—i hvert fald for nyudvikling. Mens eksisterende transformer-modeller fortsat vil blive brugt og forbedret, vil nye modeller i stigende grad inkorporere hybride arkitekturer eller selektive attention-mekanismer. Det betyder, at udviklere bør begynde at sætte sig ind i disse nye arkitekturer og forstå deres karakteristika, fordele og begrænsninger. For det andet gør effektivitetsgevinsterne fra hybride modeller det praktisk muligt at udrulle avancerede sprogmodeller i scenarier, der tidligere var umulige—på edge-enheder, i mobilapplikationer og andre ressourcebegrænsede miljøer. Dette åbner nye muligheder for applikationer, der kan behandle data lokalt, opretholde privatliv og reagere med minimal latenstid.

For det tredje gør lang-kontekst-evnerne i modeller som Jamba 3B det muligt at understøtte nye applikationsmønstre, der tidligere var upraktiske. Applikationer kan nu opretholde sammenhængende kontekst gennem længere interaktioner og dermed muliggøre mere avanceret personalisering, hukommelsesfastholdelse og agentisk ræsonnement. Dette er især værdifuldt for enterprise-applikationer, hvor det er kritisk at bevare kontekst på tværs af mange interaktioner og integrationer med eksterne systemer. For det fjerde skaber kombinationen af effektive modeller og intelligente workflow-automatiseringsplatforme som FlowHunt nye muligheder for hurtig iteration og eksperimentering. Organisationer kan nu teste forskellige modelkonfigurationer, udrulningsstrategier og systemarkitekturer uden at pådrage sig uoverkommelige beregningsomkostninger. Denne demokratisering af AI-eksperimentation vil sandsynligvis accelerere innovation og føre til nye applikationer og use cases, vi endnu ikke har forestillet os.

Det bliver mere og mere tydeligt, at hybride modeller ikke blot er en forbigående trend, men snarere repræsenterer fremtidens retning for udvikling af sprogmodeller. Effektivitetsfordelene er ganske enkelt for store til at ignorere, og ydeevnen er konkurrencedygtig med eller bedre end rene transformer-modeller på de fleste benchmarks. Efterhånden som hardwareproducenter investerer i optimeringer til state space models og andre effektive arkitekturer, vil de praktiske fordele ved hybride modeller kun vokse. Desuden indikerer den bredere tendens i branchen mod selektiv attention—hvad enten det er gennem hybride arkitekturer, sliding window attention eller andre tilgange—et grundlæggende skift i, hvordan man tænker modelarkitektur. Den rene transformer-tilgang, der har domineret de seneste år, viger nu for mere nuancerede arkitekturer, der anvender forskellige mekanismer til forskellige formål.

For organisationer, der bygger AI-systemer, har dette skift vigtige strategiske konsekvenser. At investere i forståelse og arbejde med hybride modeller nu, positionerer organisationer til at drage fordel af de effektivitets- og kapabilitetsgevinster, disse modeller tilbyder. Kombinationen af effektive modeller som Jamba 3B med avancerede AI-systemer og intelligent workflow-automatisering skaber et solidt fundament for at bygge næste generations AI-applikationer. Efterhånden som feltet fortsætter med at udvikle sig, vil de organisationer, der har investeret i at forstå disse nye arkitekturer og bygge systemer omkring dem, stå bedst rustet til at udnytte de muligheder, der opstår. Fremt

En hybrid LLM kombinerer transformer attention-mekanismer med state space models som Mamba. I modsætning til rene transformer-modeller, der udelukkende benytter attention (hvilket har kvadratisk beregningskompleksitet), bruger hybride modeller attention selektivt—typisk i et 1:8-forhold—samtidig med at de udnytter den lineære kompleksitet fra state space models i størstedelen af lagene. Denne tilgang fastholder ydeevnen, men reducerer markant de beregningsmæssige omkostninger og hukommelseskrav.

Jamba 3B er optimeret til edge-enheder, fordi den opnår lang-kontekst-behandlingsevner samtidig med, at den bevarer en lille nok størrelse til at køre i hukommelsesbegrænsede miljøer. Den hybride arkitekturs effektivitet betyder, at modellen kan være på enkelt-GPU'er eller edge-enheder uden at miste evnen til at håndtere udvidede kontekstvinduer, hvilket gør den ideel til AI-applikationer på enheden.

Gennem omfattende ablation-studier fandt AI21, at brug af attention i kun 1 ud af hver 8 lag (med Mamba i de resterende 7 lag) giver den bedste balance mellem ydeevne og effektivitet. Attention-lagene placeres strategisk midt i modellen frem for i starten eller slutningen, hvilket empirisk viste sig at give bedre resultater. Dette forhold minimerer de kvadratiske omkostninger ved attention, samtidig med at modellens evne til at håndtere komplekse ræsonnementer bevares.

Hybride modeller giver flere centrale fordele: markant lavere træningsomkostninger på grund af reducerede beregningskrav, bedre effektivitet ved lang-kontekst-applikationer, lineær hukommelsesskalering i stedet for kvadratisk samt fastholdt eller forbedret ydeevne på de fleste benchmarks. De muliggør også udrulning på edge-enheder og i hukommelsesbegrænsede miljøer, samtidig med at de bevarer de ræsonnementsevner, der gør store sprogmodeller værdifulde.

Arshia er AI Workflow Engineer hos FlowHunt. Med en baggrund inden for datalogi og en passion for AI, specialiserer han sig i at skabe effektive workflows, der integrerer AI-værktøjer i daglige opgaver og øger produktivitet og kreativitet.

Strømlin udrulning, test og optimering af dine AI-modeller med FlowHunts intelligente automatiseringsplatform.

Udforsk de avancerede evner hos Llama 3.3 70B Versatile 128k som en AI-agent. Denne dybdegående anmeldelse undersøger dens evner inden for ræsonnement, probleml...

Udforsk ChatGPT-5’s banebrydende fremskridt, anvendelsesmuligheder, benchmarks, sikkerhed, priser og fremtidige retning i denne definitive FlowHunt-guide.

En omfattende guide til moderne pretraining-strategier for sprogsmodeller, datakurations-teknikker og optimeringsmetoder brugt af HuggingFace til at bygge effek...

Cookie Samtykke

Vi bruger cookies til at forbedre din browsingoplevelse og analysere vores trafik. See our privacy policy.