Hvad er en MCP-server? En komplet guide til Model Context Protocol

Lær, hvad MCP (Model Context Protocol) servere er, hvordan de fungerer, og hvorfor de revolutionerer AI-integration. Opdag, hvordan MCP forenkler forbindelsen m...

Lær hvordan du udvikler en Model Context Protocol (MCP) server, der sømløst integrerer med OpenAI’s API og muliggør kraftfuld AI-drevet værktøjsudførelse og intelligent automatisering.

Model Context Protocol (MCP) repræsenterer et paradigmeskifte i, hvordan kunstig intelligens interagerer med eksterne værktøjer og datakilder. Kombineret med OpenAI’s kraftfulde sprogmodeller bliver en MCP-server porten til intelligent automatisering, hvor AI-systemer kan udføre komplekse operationer, hente realtidsdata og integrere sømløst med din eksisterende infrastruktur. Denne komplette guide fører dig igennem hele processen med at udvikle en MCP-server, der forbinder til OpenAI – fra grundlæggende koncepter til en produktionsegnet implementering.

Uanset om du bygger en platform for automatiseret kundeservice, et intelligent databehandlingssystem eller et avanceret business intelligence-værktøj, er forståelse for arkitektur og implementering af en MCP-server essentielt for moderne AI-udvikling. Integration mellem MCP-servere og OpenAI skaber et kraftfuldt økosystem, hvor AI-modeller kan ræsonnere over problemer, beslutte hvilke værktøjer der skal bruges, og udføre disse værktøjer præcist – alt sammen med fokus på sikkerhed, pålidelighed og skalerbarhed.

Model Context Protocol er en åben standard, der definerer, hvordan AI-modeller kan opdage og interagere med eksterne værktøjer, services og datakilder. I stedet for at indlejre al funktionalitet direkte i AI-modellen, gør MCP det muligt for udviklere at skabe specialiserede servere, som udstiller funktioner gennem et standardiseret interface. Denne opdeling giver bedre modularitet, sikkerhed og skalerbarhed i AI-applikationer.

Kernen i MCP bygger på et simpelt princip: AI-modellen (her OpenAI’s GPT) fungerer som en intelligent orkestrator, der kan forstå, hvilke værktøjer der er tilgængelige, vurdere hvornår de skal bruges og fortolke deres resultater. MCP-serveren fungerer som udbyder af disse værktøjer og eksponerer dem gennem et veldefineret API, som AI-modellen kan opdage og kalde. Dette skaber en klar kontrakt mellem AI-systemet og din tilpassede forretningslogik.

Skønheden ved MCP ligger i dets fleksibilitet. Din server kan udstille værktøjer til alt fra databaseforespørgsler, API-kald til tredjepartsservices, filbehandling, beregninger eller endda udløsning af komplekse workflows. AI-modellen lærer om disse muligheder og bruger dem intelligent i samtaler, og træffer beslutninger om, hvilke værktøjer der skal kaldes baseret på brugerens forespørgsel og samtalekontekst.

Integration af MCP-servere med OpenAI adresserer en grundlæggende begrænsning hos store sprogmodeller: de har en viden cutoff og kan ikke direkte interagere med realtidssystemer eller proprietære data. Ved at implementere en MCP-server udvider du OpenAI’s modellers kapabiliteter langt ud over deres grundtræning og gør det muligt for dem at tilgå aktuelle informationer, udføre forretningslogik og integrere med dine eksisterende systemer.

Overvej disse praktiske scenarier, hvor MCP-servere er uvurderlige:

Arkitekturen giver også betydelige fordele for udviklingsteams. Flere teams kan udvikle og vedligeholde deres egne MCP-servere uafhængigt, som herefter sammensættes til avancerede AI-applikationer. Denne modulære tilgang skalerer godt i takt med, at din organisation vokser og dine AI-evner bliver mere komplekse.

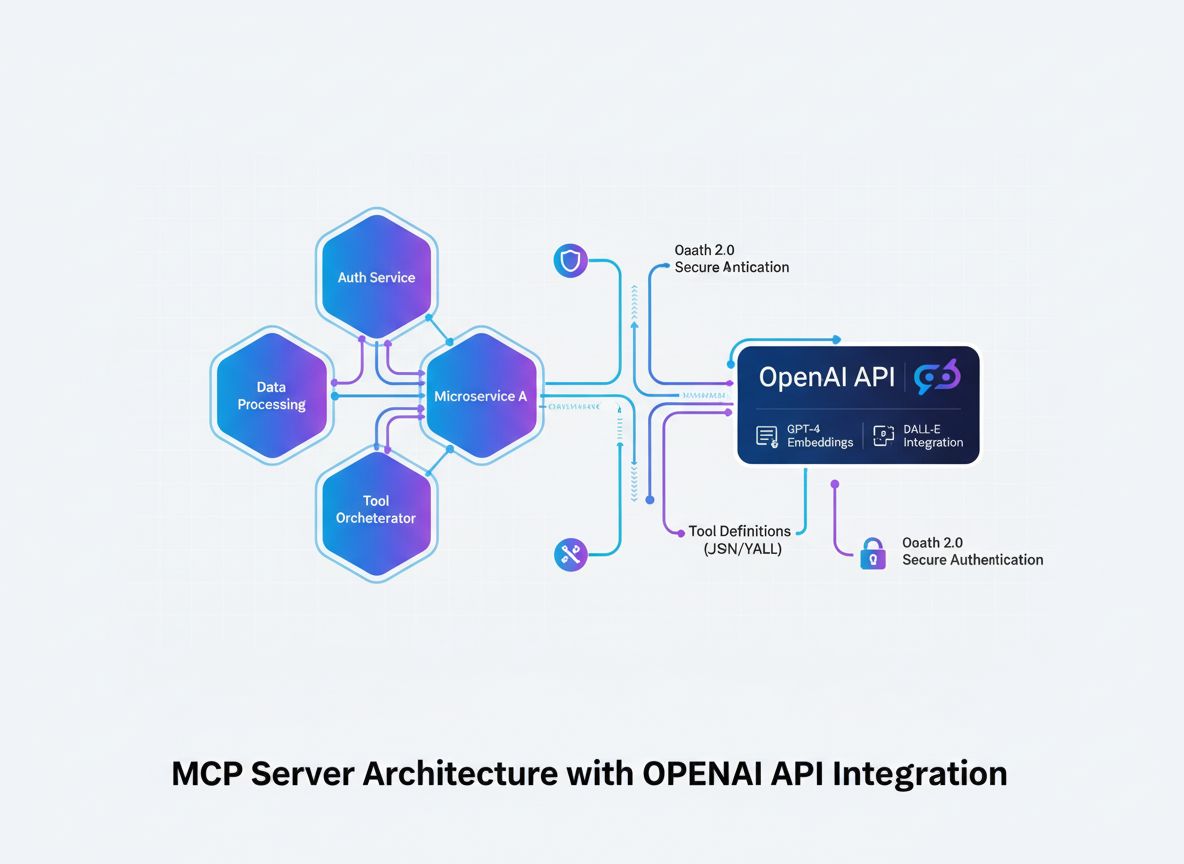

Inden du går i gang med implementeringen, er det vigtigt at forstå det arkitektoniske flow, når en MCP-server integreres med OpenAI. Processen involverer flere nøglekomponenter, der arbejder sammen:

AI-modellen (OpenAI) initierer samtaler og træffer beslutninger om, hvilke værktøjer der skal kaldes. Når modellen afgør, at et værktøj skal bruges, genererer den en struktureret anmodning med værktøjsnavn og parametre.

MCP-klienten fungerer som oversætter og mellemled. Den modtager værktøjskald fra OpenAI, oversætter dem til det format, MCP-serveren forventer, sender anmodningen til den relevante server og returnerer resultaterne til OpenAI i det format, modellen forventer.

MCP-serveren er din tilpassede applikation, der udstiller værktøjer og funktioner. Den modtager anmodninger fra MCP-klienten, udfører de ønskede operationer (som kan inkludere databaseforespørgsler, API-kald eller beregninger) og returnerer strukturerede resultater.

Værktøjsdefinitioner er kontrakter, der definerer, hvilke værktøjer der findes, hvilke parametre de accepterer, og hvad de returnerer. Disse definitioner opdages af MCP-klienten og registreres hos OpenAI, så modellen ved, hvad der er tilgængeligt.

Denne arkitektur skaber en klar opdeling: OpenAI står for ræsonnement og beslutningstagning, din MCP-server for domænespecifik logik og dataadgang, og MCP-klienten for kommunikationsprotokollen imellem dem.

Fundamentet for enhver succesfuld MCP-server er en klar definition af de værktøjer, du ønsker at udstille. Dette er ikke kun en teknisk øvelse – det er en strategisk beslutning om, hvilke funktioner dit AI-system skal kunne udføre.

Start med at identificere de konkrete problemer, dit AI-system skal løse. Bygger du en kundeservice-chatbot, der skal slå ordrer op? En dataanalyseassistent, der skal forespørge databaser? Et indholdsværktøj, der skal tilgå virksomhedens vidensbase? Hver use case har sine egne værktøjsbehov.

For hvert værktøj skal du definere:

get_customer_order_history, search_knowledge_base, execute_sql_query)Her er et eksempel på veldokumenterede værktøjsdefinitioner:

| Værktøjsnavn | Formål | Inputparametre | Outputformat | Use Case |

|---|---|---|---|---|

get_customer_info | Hent kundedetaljer | customer_id (string) | JSON-objekt med navn, e-mail, account_status | Kundeserviceforespørgsler |

search_orders | Find ordrer efter kriterier | customer_id, date_range, status | Array af ordreobjekter | Ordreopslag og historik |

create_support_ticket | Opret en ny supportsag | customer_id, issue_description, priority | Ticket-objekt med ID og bekræftelse | Eskalering af sager |

check_inventory | Forespørg produktbeholdning | product_id, warehouse_location | Lagerantal og lokationsdetaljer | Lagerforespørgsler |

process_refund | Initier refusionstransaktion | order_id, amount, reason | Transaktionsbekræftelse med referencenummer | Refusionsbehandling |

Denne tabelbaserede tilgang hjælper dig med at tænke hele værktøjsøkosystemet igennem, inden du skriver kode. Det sikrer konsistens, klarhed og fuldstændighed i dine definitioner.

Oprettelsen af en MCP-server kræver et solidt udviklingsfundament. MCP-servere kan bygges i flere sprog, men vi fokuserer her på de mest populære: TypeScript/Node.js og Python, da disse har de mest modne MCP-biblioteker og størst community-support.

For TypeScript/Node.js-udvikling:

Start med at oprette et nyt Node.js-projekt og installér nødvendige afhængigheder:

mkdir mcp-server-openai

cd mcp-server-openai

npm init -y

npm install @modelcontextprotocol/sdk openai dotenv express cors

npm install --save-dev typescript @types/node ts-node

Opret en tsconfig.json til TypeScript-konfiguration:

{

"compilerOptions": {

"target": "ES2020",

"module": "commonjs",

"lib": ["ES2020"],

"outDir": "./dist",

"rootDir": "./src",

"strict": true,

"esModuleInterop": true,

"skipLibCheck": true,

"forceConsistentCasingInFileNames": true

}

}

For Python-udvikling:

Opret et virtuelt miljø og installér afhængigheder:

python -m venv venv

source venv/bin/activate # På Windows: venv\Scripts\activate

pip install mcp openai python-dotenv fastapi uvicorn

Uanset sprogvalg skal du bruge:

.env-fil til sikker opbevaring af følsomme nøglerKernen i din MCP-server er selve serverapplikationen, der udstiller værktøjerne via MCP-protokollen. Det indebærer at oprette endpoints til værktøjsopdagelse og -udførelse.

TypeScript/Node.js-implementering:

Opret en basal MCP-serverstruktur:

import { Server } from "@modelcontextprotocol/sdk/server/index.js";

import { StdioServerTransport } from "@modelcontextprotocol/sdk/server/stdio.js";

import {

CallToolRequestSchema,

ListToolsRequestSchema,

} from "@modelcontextprotocol/sdk/types.js";

const server = new Server({

name: "openai-mcp-server",

version: "1.0.0",

});

// Definér dine værktøjer

const tools = [

{

name: "get_customer_info",

description: "Hent kundeoplysninger via ID",

inputSchema: {

type: "object",

properties: {

customer_id: {

type: "string",

description: "Det unikke kunde-ID",

},

},

required: ["customer_id"],

},

},

// Tilføj flere værktøjer her

];

// Håndter forespørgsler om værktøjsliste

server.setRequestHandler(ListToolsRequestSchema, async () => {

return { tools };

});

// Håndter udførelse af værktøj

server.setRequestHandler(CallToolRequestSchema, async (request) => {

const { name, arguments: args } = request.params;

if (name === "get_customer_info") {

// Implementér værktøjslogik her

const customerId = args.customer_id;

// Forespørg din database eller API

return {

content: [

{

type: "text",

text: JSON.stringify({

id: customerId,

name: "John Doe",

email: "john@example.com",

}),

},

],

};

}

return {

content: [{ type: "text", text: `Ukendt værktøj: ${name}` }],

isError: true,

};

});

// Start serveren

const transport = new StdioServerTransport();

server.connect(transport);

Python-implementering:

from mcp.server import Server

from mcp.types import Tool, TextContent, ToolResult

import json

app = Server("openai-mcp-server")

# Definér dine værktøjer

TOOLS = [

Tool(

name="get_customer_info",

description="Hent kundeoplysninger via ID",

inputSchema={

"type": "object",

"properties": {

"customer_id": {

"type": "string",

"description": "Det unikke kunde-ID"

}

},

"required": ["customer_id"]

}

)

]

@app.list_tools()

async def list_tools():

return TOOLS

@app.call_tool()

async def call_tool(name: str, arguments: dict):

if name == "get_customer_info":

customer_id = arguments.get("customer_id")

# Implementér værktøjslogik

result = {

"id": customer_id,

"name": "John Doe",

"email": "john@example.com"

}

return ToolResult(

content=[TextContent(type="text", text=json.dumps(result))]

)

return ToolResult(

content=[TextContent(type="text", text=f"Ukendt værktøj: {name}")],

isError=True

)

if __name__ == "__main__":

import uvicorn

uvicorn.run(app, host="0.0.0.0", port=8000)

Den reelle styrke i din MCP-server ligger i selve implementeringen af værktøjerne. Her forbinder du til databaser, kalder eksterne API’er, behandler data og udfører forretningslogik.

Eksempel på databaseintegration:

import { Pool } from "pg"; // PostgreSQL-eksempel

const pool = new Pool({

connectionString: process.env.DATABASE_URL,

});

async function getCustomerInfo(customerId: string) {

try {

const result = await pool.query(

"SELECT id, name, email, account_status FROM customers WHERE id = $1",

[customerId]

);

if (result.rows.length === 0) {

return {

error: "Kunde ikke fundet",

status: 404,

};

}

return result.rows[0];

} catch (error) {

return {

error: "Databaseforespørgsel fejlede",

details: error.message,

status: 500,

};

}

}

Eksempel på integration til eksternt API:

import axios from "axios";

async function searchExternalDatabase(query: string) {

try {

const response = await axios.get(

"https://api.external-service.com/search",

{

params: { q: query },

headers: {

Authorization: `Bearer ${process.env.EXTERNAL_API_KEY}`,

},

}

);

return response.data;

} catch (error) {

return {

error: "Eksternt API-kald fejlede",

details: error.message,

};

}

}

Fejlhåndtering og validering:

Robust fejlhåndtering er kritisk for produktionsklare MCP-servere. Implementer omfattende validering og fejlhåndtering:

function validateInput(args: any, schema: any): { valid: boolean; error?: string } {

// Valider påkrævede felter

for (const required of schema.required || []) {

if (!(required in args)) {

return { valid: false, error: `Mangler påkrævet parameter: ${required}` };

}

}

// Valider felttyper

for (const [key, property] of Object.entries(schema.properties || {})) {

if (key in args) {

const value = args[key];

const expectedType = (property as any).type;

if (typeof value !== expectedType) {

return {

valid: false,

error: `Parameter ${key} skal være af typen ${expectedType}`,

};

}

}

}

return { valid: true };

}

MCP-klienten er broen mellem OpenAI og din MCP-server. Den håndterer oversættelsen mellem OpenAI’s function-calling-format og MCP-protokollen.

TypeScript/Node.js MCP-klient:

import { Client } from "@modelcontextprotocol/sdk/client/index.js";

import { StdioClientTransport } from "@modelcontextprotocol/sdk/client/stdio.js";

import OpenAI from "openai";

class MCPOpenAIBridge {

private mcpClient: Client;

private openaiClient: OpenAI;

private availableTools: any[] = [];

constructor() {

this.openaiClient = new OpenAI({

apiKey: process.env.OPENAI_API_KEY,

});

}

async initialize() {

// Forbind til MCP-server

const transport = new StdioClientTransport({

command: "node",

args: ["dist/server.js"],

});

this.mcpClient = new Client({

name: "openai-mcp-client",

version: "1.0.0",

});

await this.mcpClient.connect(transport);

// Opdag tilgængelige værktøjer

const toolsResponse = await this.mcpClient.listTools();

this.availableTools = toolsResponse.tools;

}

async executeWithOpenAI(userMessage: string) {

const messages = [{ role: "user" as const, content: userMessage }];

// Konverter MCP-værktøjer til OpenAI function-format

const tools = this.availableTools.map((tool) => ({

type: "function" as const,

function: {

name: tool.name,

description: tool.description,

parameters: tool.inputSchema,

},

}));

let response = await this.openaiClient.chat.completions.create({

model: "gpt-4",

messages,

tools,

});

// Håndter værktøjskald i loop

while (response.choices[0].finish_reason === "tool_calls") {

const toolCalls = response.choices[0].message.tool_calls || [];

for (const toolCall of toolCalls) {

const toolName = toolCall.function.name;

const toolArgs = JSON.parse(toolCall.function.arguments);

// Udfør værktøj på MCP-server

const toolResult = await this.mcpClient.callTool({

name: toolName,

arguments: toolArgs,

});

// Tilføj værktøjsresultat til messages

messages.push({

role: "assistant",

content: response.choices[0].message.content || "",

});

messages.push({

role: "tool",

content: JSON.stringify(toolResult),

tool_call_id: toolCall.id,

});

}

// Hent næste svar fra OpenAI

response = await this.openaiClient.chat.completions.create({

model: "gpt-4",

messages,

tools,

});

}

return response.choices[0].message.content;

}

}

// Brug

const bridge = new MCPOpenAIBridge();

await bridge.initialize();

const result = await bridge.executeWithOpenAI(

"Hvad er ordreoversigten for kunde 12345?"

);

console.log(result);

Sikkerhed er altafgørende, når MCP-servere skal håndtere følsomme data og eksterne API’er. Implementér flere sikkerhedslag:

API-nøglehåndtering:

import crypto from "crypto";

class APIKeyManager {

private validKeys: Set<string> = new Set();

constructor() {

// Indlæs gyldige API-nøgler fra miljø eller sikker lagring

const keys = process.env.VALID_API_KEYS?.split(",") || [];

this.validKeys = new Set(keys);

}

validateRequest(apiKey: string): boolean {

return this.validKeys.has(apiKey);

}

generateNewKey(): string {

return crypto.randomBytes(32).toString("hex");

}

}

Signering og verifikation af forespørgsler:

import crypto from "crypto";

function signRequest(payload: any, secret: string): string {

return crypto

.createHmac("sha256", secret)

.update(JSON.stringify(payload))

.digest("hex");

}

function verifySignature(payload: any, signature: string, secret: string): boolean {

const expectedSignature = signRequest(payload, secret);

return crypto.timingSafeEqual(

Buffer.from(signature),

Buffer.from(expectedSignature)

);

}

Rate limiting:

import rateLimit from "express-rate-limit";

const limiter = rateLimit({

windowMs: 15 * 60 * 1000, // 15 minutter

max: 100, // maks 100 requests pr. IP pr. windowMs

message: "For mange forespørgsler fra denne IP, prøv igen senere.",

});

app.use("/api/", limiter);

Input-sanitization:

function sanitizeInput(input: string): string {

// Fjern potentielt farlige tegn

return input

.replace(/[<>]/g, "")

.trim()

.substring(0, 1000); // Begræns længde

}

function validateCustomerId(customerId: string): boolean {

// Kun tillad alfanumeriske tegn og bindestreger

return /^[a-zA-Z0-9-]+$/.test(customerId);

}

Omfattende test sikrer, at din MCP-server fungerer korrekt og håndterer edge cases elegant.

Eksempel på unit tests (Jest):

import { getCustomerInfo } from "../tools/customer";

describe("Kundeværktøjer", () => {

test("skal returnere kundeinfo for gyldigt ID", async () => {

const result = await getCustomerInfo("cust_123");

expect(result).toHaveProperty("id");

expect(result).toHaveProperty("name");

expect(result).toHaveProperty("email");

});

test("skal returnere fejl for ugyldigt ID", async () => {

const result = await getCustomerInfo("invalid");

expect(result).toHaveProperty("error");

});

test("skal håndtere databasefejl elegant", async () => {

// Mock databasefejl

const result = await getCustomerInfo("cust_error");

expect(result).toHaveProperty("error");

expect(result.status).toBe(500);

});

});

Integrationstests:

describe("MCP-server integration", () => {

let server: Server;

beforeAll(async () => {

server = new Server({ name: "test-server", version: "1.0.0" });

// Initialisér server

});

test("skal liste alle tilgængelige værktøjer", async () => {

const tools = await server.listTools();

expect(tools.length).toBeGreaterThan(0);

expect(tools[0]).toHaveProperty("name");

expect(tools[0]).toHaveProperty("description");

});

test("skal udføre værktøj og returnere resultat", async () => {

const result = await server.callTool({

name: "get_customer_info",

arguments: { customer_id: "cust_123" },

});

expect(result).toBeDefined();

});

});

FlowHunt tilbyder en komplet platform til at automatisere hele livscyklussen for MCP-serverudvikling, test og deployment. I stedet for manuelt at håndtere hvert trin i din MCP-server-workflow kan FlowHunt lade dig oprette intelligente automationsflows, der håndterer gentagelsesopgaver og sikrer ensartethed i hele udviklingsprocessen.

Automatiseret test og validering:

FlowHunt kan orkestrere dit testpipeline, køre unit tests, integrationstests og end-to-end tests automatisk, hver gang du committer kode. Det sikrer, at dine MCP-serverværktøjer altid fungerer korrekt, før de deployes i produktion.

Continuous integration og deployment:

Opsæt FlowHunt-workflows til automatisk at bygge, teste og deploye din MCP-server, hver gang der pushes ændringer til dit repository. Det eliminerer manuelle deploymenttrin og reducerer risikoen for menneskelige fejl.

Overvågning og alarmering:

FlowHunt kan overvåge din MCP-servers sundhed, spore API-responstider og alarmere dig om eventuelle problemer. Hvis et værktøj fejler eller performance falder, får du besked med det samme.

Dokumentationsgenerering:

Generér automatisk API-dokumentation for dine MCP-serverværktøjer og hold dokumentationen opdateret med den faktiske implementering. Det sikrer, at udviklere altid har adgang til korrekt og opdateret information.

Performanceoptimering:

FlowHunt analytics hjælper dig med at identificere flaskehalse i værktøjsudførelser. Du kan se, hvilke værktøjer der kaldes hyppigst, hvor latenstiden er højest, og hvor optimeringsindsatsen vil have størst effekt.

Deployment af en MCP-server til produktion kræver grundig planlægning. Overvej disse deployment-strategier:

Docker-containerisering:

Opret en Dockerfile til din MCP-server:

FROM node:18-alpine

WORKDIR /app

COPY package*.json ./

RUN npm ci --only=production

COPY dist ./dist

EXPOSE 8000

CMD ["node", "dist/server.js"]

Byg og push til container registry:

docker build -t my-mcp-server:1.0.0 .

docker push myregistry.azurecr.io/my-mcp-server:1.0.0

Kubernetes-deployment:

Deploy din containeriserede MCP-server til Kubernetes:

apiVersion: apps/v1

kind: Deployment

metadata:

name: mcp-server

spec:

replicas: 3

selector:

matchLabels:

app: mcp-server

template:

metadata:

labels:

app: mcp-server

spec:

containers:

- name: mcp-server

image: myregistry.azurecr.io/my-mcp-server:1.0.0

ports:

- containerPort: 8000

env:

- name: OPENAI_API_KEY

valueFrom:

secretKeyRef:

name: openai-secrets

key: api-key

- name: DATABASE_URL

valueFrom:

secretKeyRef:

name: db-secrets

key: connection-string

resources:

requests:

memory: "256Mi"

cpu: "250m"

limits:

memory: "512Mi"

cpu: "500m"

Miljøkonfiguration:

Brug miljøvariabler til al konfiguration:

# .env.production

OPENAI_API_KEY=sk-...

DATABASE_URL=postgresql://user:pass@host:5432/db

MCP_SERVER_PORT=8000

LOG_LEVEL=info

ENABLE_METRICS=true

Efterhånden som din MCP-server vokser i kompleksitet, bør du overveje disse avancerede mønstre:

Værktøjskomposition:

Opret højere niveau-værktøjer, der kombinerer flere lavniveau-værktøjer:

async function processCustomerRefund(customerId: string, orderId: string, amount: number) {

// Hent kundeinfo

const customer = await getCustomerInfo(customerId);

// Hent ordredetaljer

const order = await getOrderDetails(orderId);

// Verificér at ordre tilhører kunde

if (order.customerId !== customerId) {

throw new Error("Ordre tilhører ikke kunden");

}

// Behandl refusion

const refund = await createRefund(orderId, amount);

// Send notifikation

await sendNotification(customer.email, `Refusion på ${amount} kr. er behandlet`);

return refund;

}

Caching-strategi:

Implementér caching for at reducere latenstid og API-kald:

import NodeCache from "node-cache";

const cache = new NodeCache({ stdTTL: 600 }); // 10 minutters TTL

async function getCustomerInfoWithCache(customerId: string) {

const cacheKey = `customer_${customerId}`;

// Tjek cache først

const cached = cache.get(cacheKey);

if (cached) {

return cached;

}

// Hent fra database

const customer = await getCustomerInfo(customerId);

// Gem i cache

cache.set(cacheKey, customer);

return customer;

}

Async jobbehandling:

For langvarige operationer, implementér asynkron jobbehandling:

import Bull from "bull";

const jobQueue = new Bull("mcp-jobs");

jobQueue.process(async (job) => {

const { toolName, arguments: args } = job.data;

// Udfør værktøj

const result = await executeTool(toolName, args);

return result;

});

async function executeToolAsync(toolName: string, args: any) {

const job = await jobQueue.add(

{ toolName, arguments: args },

{ attempts: 3, backoff: { type: "exponential", delay: 2000 } }

);

return job.id;

}

Produktionsklare MCP-servere kræver grundig overvågning og logging:

Struktureret logging:

import winston from "winston";

const logger = winston.createLogger({

format: winston.format.json(),

transports: [

new winston.transports.File({ filename: "error.log", level: "error" }),

new winston.transports.File({ filename: "combined.log" }),

],

});

logger.info("Værktøj udført", {

toolName: "get_customer_info",

customerId: "cust_123",

duration: 145,

status: "success",

});

Metrikindsamling:

import prometheus from "prom-client";

const toolExecutionDuration = new prometheus.Histogram({

name: "mcp_tool_execution_duration_ms",

help: "Varighed af værktøjsudførelse i millisekunder",

labelNames: ["tool_name", "status"],

});

const toolExecutionCounter = new prometheus.Counter({

name: "mcp_tool_executions_total",

help: "Samlet antal værktøjsudførelser",

labelNames: ["tool_name", "status"],

});

async function executeToolWithMetrics(toolName: string, args: any) {

const startTime = Date.now();

try {

const result = await executeTool(toolName, args);

const duration = Date.now() - startTime;

toolExecutionDuration.labels(toolName, "success").observe(duration);

toolExecutionCounter.labels(toolName, "success").inc();

return result;

} catch (error) {

const duration = Date.now() - startTime;

Model Context Protocol er en standardiseret ramme, der gør det muligt for AI-modeller som OpenAI's GPT at opdage, forstå og udføre værktøjer og funktioner leveret af eksterne servere. Den fungerer som en bro mellem AI-modeller og tilpasset forretningslogik.

Du skal have en gyldig OpenAI API-nøgle med passende tilladelser. MCP-serveren kræver ikke særlige tilladelser fra OpenAI – den kommunikerer via standard API-kald. Du bør dog implementere korrekt autentificering og autorisation på din MCP-server.

MCP-servere kan bygges i ethvert sprog, der understøtter HTTP/REST API'er eller WebSocket-forbindelser. Populære valg inkluderer Python, TypeScript/Node.js, Java, C#/.NET og Go. Valget af sprog afhænger af din eksisterende infrastruktur og teamets ekspertise.

Implementér rate limiting på din MCP-server, cache ofte forespurgte resultater, brug eksponentiel backoff til gentagne forsøg, og overvåg dit OpenAI API-forbrug. Overvej at implementere et køsystem til værktøjsforespørgsler for effektiv belastningsstyring.

Arshia er AI Workflow Engineer hos FlowHunt. Med en baggrund inden for datalogi og en passion for AI, specialiserer han sig i at skabe effektive workflows, der integrerer AI-værktøjer i daglige opgaver og øger produktivitet og kreativitet.

Strømlin din udvikling, test og implementering af MCP-servere med FlowHunt's intelligente automatiseringsplatform.

Lær, hvad MCP (Model Context Protocol) servere er, hvordan de fungerer, og hvorfor de revolutionerer AI-integration. Opdag, hvordan MCP forenkler forbindelsen m...

Lær at bygge og implementere en Model Context Protocol (MCP) server til at forbinde AI-modeller med eksterne værktøjer og datakilder. Trin-for-trin guide for bå...

Udforsk omfattende eksempler på MCP-servere og lær, hvordan du bygger, implementerer og integrerer Model Context Protocol-servere for at styrke AI-agenters kapa...

Cookie Samtykke

Vi bruger cookies til at forbedre din browsingoplevelse og analysere vores trafik. See our privacy policy.