Webflow

Integrer FlowHunt med Webflow MCP for at automatisere styring af hjemmeside og CMS, opdatere indhold og orkestrere intelligente arbejdsgange ved hjælp af AI-dre...

En omfattende guide til integration af kunstig intelligens med eksterne applikationer via API’er og webhooks, herunder autentificering, realtidskommunikation og praktiske implementeringsstrategier.

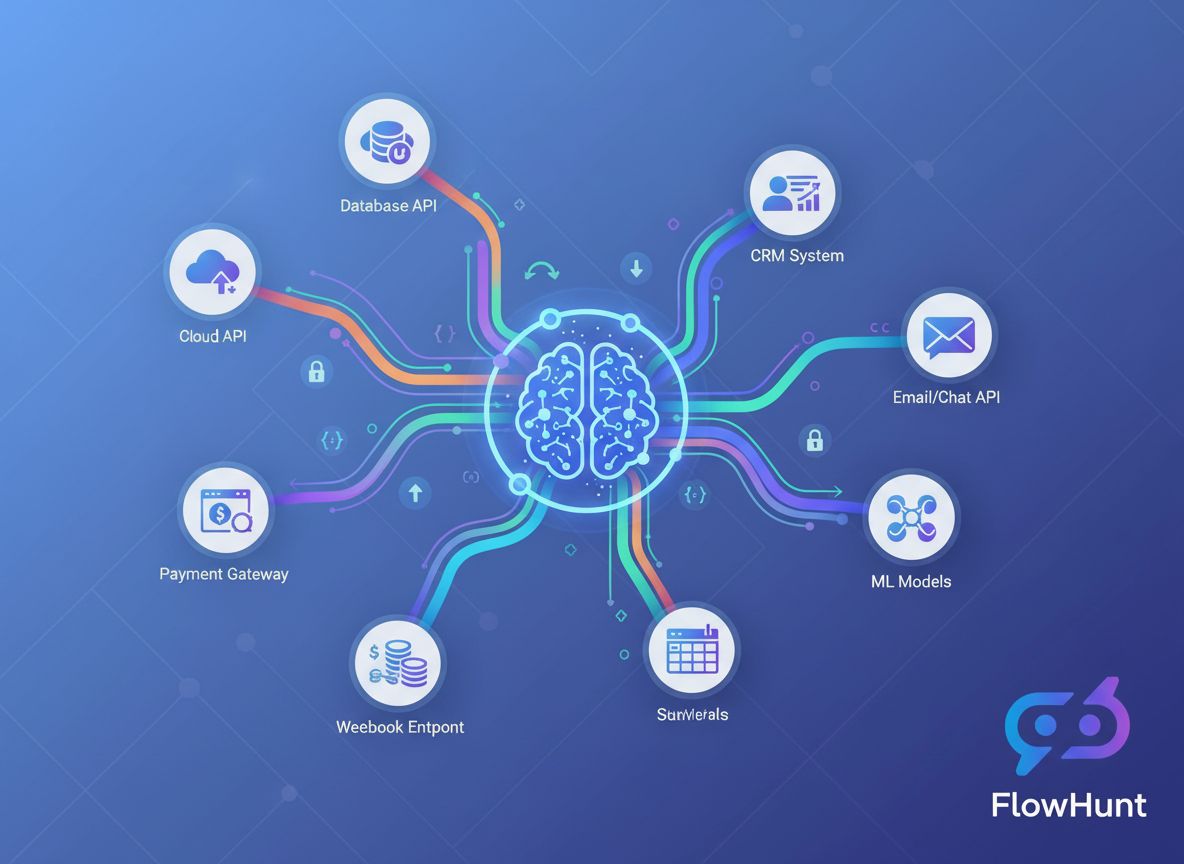

Sammensmeltningen af kunstig intelligens og eksterne applikationer har fundamentalt ændret den måde, virksomheder opererer på. Nutidens virksomheder arbejder ikke længere med isolerede AI-systemer – i stedet orkestrerer de avancerede integrationer, der forbinder AI-modeller med CRM-platforme, betalingsgateways, kommunikationsværktøjer og utallige andre tjenester. Denne omfattende guide udforsker de tekniske og strategiske tilgange til at integrere AI med eksterne værktøjer via API’er og webhooks, så du får den viden, du har brug for til at bygge robuste, skalerbare og sikre AI-drevne workflows.

Uanset om du er udvikler og bygger din første AI-integration eller enterprise-arkitekt, der designer komplekse automatiseringssystemer, er forståelsen af nuancerne i API-baseret og webhook-drevet AI-integration essentiel. Denne artikel guider dig gennem hele processen – fra grundlæggende begreber til avancerede implementeringsmønstre – så du trygt kan tilkoble AI-funktioner til din eksisterende teknologistak.

Før vi dykker ned i integrationsstrategier, er det vigtigt at forstå den grundlæggende forskel mellem disse to kommunikationsparadigmer. Et API (Application Programming Interface) er et sæt protokoller og værktøjer, der tillader forskellige softwareapplikationer at kommunikere med hinanden. API’er fungerer på en pull-baseret model, hvilket betyder, at din applikation aktivt anmoder om data eller tjenester fra et eksternt system. Når du har brug for information, initierer du anmodningen, venter på et svar og behandler de returnerede data.

En webhook fungerer derimod på en push-baseret model. I stedet for at din applikation konstant spørger efter opdateringer, tillader webhooks eksterne systemer proaktivt at sende data til din applikation, når specifikke hændelser indtræffer. Tænk på det som forskellen mellem at tjekke din postkasse flere gange om dagen versus at få posten leveret direkte til døren, når den ankommer.

API’er bruges typisk til on-demand-operationer – indhentning af brugerinformation, behandling af betalinger, generering af AI-forudsigelser eller indhentning af realtidsdata. Webhooks derimod er stærke i hændelsesdrevne scenarier, hvor du har brug for øjeblikkelig notifikation, når noget sker: en betaling gennemføres, en formular indsendes, en fil uploades eller en bruger foretager en bestemt handling.

Valget mellem API’er og webhooks afhænger ofte af dit use case. Mange avancerede integrationer bruger faktisk begge dele: API’er til at forespørge data og webhooks til at modtage realtidsnotifikationer. Denne hybride tilgang giver den fleksibilitet og reaktionsdygtighed, moderne applikationer kræver.

Forretningsargumentet for at integrere AI med eksterne værktøjer er overbevisende og mangefacetteret. Organisationer, der lykkes med disse integrationer, opnår betydelige konkurrencefordele på flere områder.

Operationel effektivitet og omkostningsreduktion: Når AI-systemer er isolerede fra dine eksisterende værktøjer, skaber du datasiloer og manuelle overdragelsespunkter. Ved at integrere AI direkte med dit CRM, e-mailplatform, projektstyringsværktøjer og andre applikationer eliminerer du disse friktionspunkter. I stedet for at kopiere data manuelt mellem systemer kan AI automatisk behandle information, generere indsigter og udløse handlinger på tværs af hele din teknologistak. Denne automatisering reducerer driftsomkostninger, minimerer menneskelige fejl og frigør dit team til at fokusere på mere værdiskabende arbejde.

Realtidsbeslutningstagning: Webhooks gør det muligt for AI-systemer at reagere øjeblikkeligt på forretningshændelser. Når en kunde indsender en supportticket, kan et AI-system straks analysere tone og sende den til det rette team. Når salgsdata opdateres, kan AI øjeblikkeligt genberegne forecasts. Når lageret falder under tærskelværdier, kan AI automatisk generere indkøbsordrer. Denne realtidsreaktion ændrer, hvor hurtigt organisationer kan tilpasse sig markedet og kundernes behov.

Forbedret kundeoplevelse: Integrerede AI-systemer skaber sømløse og personlige oplevelser. En AI-chatbot integreret med dit CRM kan tilgå kundehistorik og give relevante svar. En AI-anbefalingsmotor integreret med din e-handelsplatform kan vise personlige produktforslag. En AI-planlægningsassistent integreret med dit kalendersystem kan automatisk finde mødetidspunkter. Disse integrationer skaber gnidningsfri oplevelser, som kunderne sætter pris på og som øger loyaliteten.

Datadrevne indsigter i stor skala: Ved at forbinde AI til flere datakilder via API’er kan organisationer bygge omfattende analytiske systemer, der bearbejder information fra hele forretningen. Dette helhedsbillede muliggør mere præcise forudsigelser, bedre mønstergenkendelse og indsigter, der ville være umulige med isolerede data.

Overvej disse nøglefordele:

API’er udgør rygraden i de fleste AI-integrationer. For effektivt at integrere AI med eksterne værktøjer skal du forstå, hvordan API’er fungerer, og hvordan du interagerer med dem programmæssigt.

Moderne API’er findes i flere varianter med forskellige karakteristika. REST (Representational State Transfer) API’er er den mest almindelige type, du møder. De bruger standard HTTP-metoder (GET, POST, PUT, DELETE) til at udføre operationer på ressourcer, der identificeres via URL’er. REST API’er er stateless, hvilket betyder, at hver anmodning indeholder alle nødvendige oplysninger til behandling – det gør dem simple at forstå og implementere.

GraphQL API’er tilbyder et mere fleksibelt alternativ, hvor klienten kan anmode om præcis de data, der er behov for, i stedet for at modtage faste svarstrukturer. Det kan være mere effektivt ved komplekse forespørgsler, men kræver mere avancerede klientimplementeringer.

SOAP (Simple Object Access Protocol) API’er er ældre, XML-baserede protokoller, der stadig bruges i erhvervslivet. De er mere komplekse end REST, men tilbyder robuste funktioner til enterprise-integration.

RPC (Remote Procedure Call) API’er lader dig kalde funktioner på fjernservere, som var de lokale. Nogle blockchain- og kryptovaluta-API’er bruger dette mønster.

Til de fleste AI-integrationer vil du arbejde med REST API’er, da de tilbyder en god balance mellem enkelhed og funktionalitet.

Hver API-interaktion kræver autentificering for at verificere, at din applikation har adgangstilladelse til tjenesten. Forståelse af autentificeringsmekanismer er kritisk for sikker AI-integration.

API-nøgler er den simpleste autentificeringsmetode. Du får en unik nøgle, når du registrerer dig til en API-tjeneste, og denne nøgle medsendes i dine anmodninger. Selvom det er nemt at implementere, har API-nøgler begrænsninger – de udløber ikke automatisk og giver adgang til alt eller intet. De er velegnede til udvikling og mindre følsomme operationer, men bør ikke være eneste sikkerhedslag i produktionssystemer.

OAuth 2.0 er industristandarden for delegeret autorisation. I stedet for at dele dine legitimationsoplysninger direkte, kan brugere via OAuth autorisere din applikation til at tilgå deres data på deres vegne. Det er det, du oplever, når en applikation beder om tilladelse til at “tilgå din Google-konto” eller “forbinde til din Slack workspace”. OAuth er mere kompleks at implementere, men giver bedre sikkerhed og bruger-kontrol.

Bearer tokens og JWT (JSON Web Tokens) kombinerer enkelheden fra API-nøgler med ekstra sikkerhed. JWT’er er kryptografisk signerede tokens, der indeholder oplysninger (claims) om brugeren eller applikationen. De kan inkludere udløbstider, specifikke rettigheder og metadata – ideelt til mikrotjenester og distribuerede systemer.

Mutual TLS (mTLS) bruger certifikater til både klient- og serverautentificering og giver det højeste sikkerhedsniveau. Det bruges ofte i enterprise-miljøer og til følsomme operationer.

Interaktion med API’er indebærer opbygning af HTTP-anmodninger med relevante headere, parametre og body-indhold. Her er et praktisk eksempel på et AI API-kald:

import requests

import json

# Opsæt autentificering

headers = {

'Authorization': 'Bearer YOUR_API_KEY',

'Content-Type': 'application/json',

}

# Forbered request payload

data = {

'model': 'gpt-4',

'messages': [

{

'role': 'user',

'content': 'Analyser denne kundefeedback for tone'

}

],

'temperature': 0.7,

'max_tokens': 500,

}

# Foretag API-kaldet

response = requests.post(

'https://api.openai.com/v1/chat/completions',

headers=headers,

json=data

)

# Håndter svaret

if response.status_code == 200:

result = response.json()

ai_response = result['choices'][0]['message']['content']

print(f"AI-analyse: {ai_response}")

else:

print(f"Fejl: {response.status_code} - {response.text}")

Dette eksempel viser det grundlæggende mønster: autentificér, opbyg en anmodning, send den til API-endpointet, og behandl svaret. De fleste AI API-integrationer følger denne grundstruktur, dog med forskellige parametre og svarformater afhængigt af tjenesten.

Hvor API’er henter data efter behov, gør webhooks realtids push-baseret kommunikation mulig. Forståelse af webhook-arkitektur er essentielt for at bygge responsive AI-systemer.

En webhook fungerer reelt som en callback-mekanisme. Du registrerer en URL hos en ekstern tjeneste, og når specifikke hændelser opstår, sender tjenesten en HTTP POST-anmodning til din URL med hændelsesdata. Din applikation modtager disse data, behandler dem og udfører relevante handlinger.

Forløbet ser typisk således ud:

At bygge en webhook-modtager kræver oprettelse af et HTTP-endpoint, der kan acceptere POST-anmodninger. Her er et praktisk eksempel med Flask:

from flask import Flask, request, jsonify

import hmac

import hashlib

import json

app = Flask(__name__)

WEBHOOK_SECRET = 'your_webhook_secret_key'

def verify_webhook_signature(payload, signature):

"""Verificér at webhook'en kommer fra den forventede kilde"""

expected_signature = hmac.new(

WEBHOOK_SECRET.encode(),

payload,

hashlib.sha256

).hexdigest()

return hmac.compare_digest(signature, expected_signature)

@app.route('/webhook/payment', methods=['POST'])

def handle_payment_webhook():

# Hent det rå payload til signatur-verificering

payload = request.get_data()

signature = request.headers.get('X-Signature')

# Verificér at webhooken er autentisk

if not verify_webhook_signature(payload, signature):

return jsonify({'error': 'Ugyldig signatur'}), 401

# Parse JSON-data

data = request.json

# Behandl webhook-hændelsen

try:

if data['event_type'] == 'payment.completed':

# Start AI-analyse af transaktionen

analyze_transaction(data['transaction_id'], data['amount'])

# Opdater din database

update_payment_status(data['transaction_id'], 'completed')

# Send bekræftelse

send_confirmation_email(data['customer_email'])

# Returnér altid 200 for at kvittere for modtagelse

return jsonify({'status': 'received'}), 200

except Exception as e:

# Log fejl, men returnér stadig 200 for at undgå genforsøg

log_error(f"Webhook-behandlingsfejl: {str(e)}")

return jsonify({'status': 'received'}), 200

if __name__ == '__main__':

app.run(port=5000)

Dette eksempel viser flere vigtige best practices: signaturverificering for at sikre ægthed, korrekt fejlhåndtering og altid at returnere et succes-svar for at forhindre gentagne forsøg fra den eksterne tjeneste.

Webhooks introducerer særlige sikkerhedsudfordringer, fordi eksterne tjenester sender data til din applikation. Flere sikkerhedsforanstaltninger er nødvendige:

Signaturverificering: De fleste webhook-udbydere vedlægger en signatur i request-headere, beregnet ud fra en delt hemmelighed. Verificér altid denne signatur for at sikre, at webhooken kommer fra den forventede kilde og ikke er blevet manipuleret.

Kun HTTPS: Brug altid HTTPS til webhook-endpoints. Det krypterer data under transport og forhindrer man-in-the-middle-angreb.

IP-whitelisting: Hvis muligt, whitelist de IP-adresser, som webhooks sendes fra. Det forhindrer uautoriserede kilder i at sende anmodninger til din webhook-endpoint.

Rate limiting: Implementér rate limiting på dine webhook-endpoints for at undgå misbrug eller utilsigtet overbelastning.

Idempotens: Design dine webhook-handlere, så de er idempotente – behandling af den samme webhook flere gange skal give samme resultat. Det er vigtigt, da webhook-udbydere kan forsøge at levere igen ved fejl.

Nu hvor vi forstår grundprincipperne, kan vi udforske, hvordan AI-modeller integreres med eksterne tjenester. Det er her, AI-integrationens egentlige styrke for alvor kommer til udtryk.

AI-landskabet byder på mange muligheder med forskellige funktioner, prismodeller og integrationsmetoder. OpenAI’s API giver adgang til GPT-4, GPT-3.5 og andre modeller til sprogforståelse, kodegenerering og ræsonnement. Google Cloud AI tilbyder tjenester som Vertex AI, Document AI og Vision AI. AWS leverer SageMaker til egne modeller og forskellige færdige AI-tjenester. Anthropic’s Claude API har fokus på sikker, fortolkbar AI. Hugging Face tilbyder open source-modeller og en modelhub.

Dit valg afhænger af flere faktorer: de specifikke AI-evner, du har brug for, budget, svartider, dataprivacy og om du foretrækker managed services eller selvhostede løsninger.

Et typisk AI-integrationspipeline involverer flere trin: dataindsamling fra eksterne kilder via API, forbehandling og berigelse, AI-modelinference, resultatbehandling og handlingstriggere. Her er et praktisk eksempel, der integrerer flere komponenter:

import requests

import json

from datetime import datetime

import logging

class AIIntegrationPipeline:

def __init__(self, ai_api_key, crm_api_key):

self.ai_api_key = ai_api_key

self.crm_api_key = crm_api_key

self.logger = logging.getLogger(__name__)

def fetch_customer_data(self, customer_id):

"""Hent kundedata fra CRM API"""

headers = {'Authorization': f'Bearer {self.crm_api_key}'}

response = requests.get(

f'https://api.crm.example.com/customers/{customer_id}',

headers=headers

)

return response.json()

def analyze_with_ai(self, text_content):

"""Send indhold til AI API for analyse"""

headers = {

'Authorization': f'Bearer {self.ai_api_key}',

'Content-Type': 'application/json'

}

payload = {

'model': 'gpt-4',

'messages': [

{

'role': 'system',

'content': 'Du er kundeserviceanalytiker. Analyser følgende kundedialog og giv indsigter.'

},

{

'role': 'user',

'content': text_content

}

],

'temperature': 0.5,

'max_tokens': 1000

}

response = requests.post(

'https://api.openai.com/v1/chat/completions',

headers=headers,

json=payload

)

if response.status_code == 200:

return response.json()['choices'][0]['message']['content']

else:

self.logger.error(f"AI API-fejl: {response.status_code}")

raise Exception("AI-analyse mislykkedes")

def update_crm_with_insights(self, customer_id, insights):

"""Opdater CRM med AI-genererede indsigter"""

headers = {

'Authorization': f'Bearer {self.crm_api_key}',

'Content-Type': 'application/json'

}

payload = {

'ai_insights': insights,

'last_analyzed': datetime.now().isoformat(),

'analysis_status': 'completed'

}

response = requests.put(

f'https://api.crm.example.com/customers/{customer_id}',

headers=headers,

json=payload

)

return response.status_code == 200

def process_customer(self, customer_id):

"""Komplet pipeline: hent, analyser, opdater"""

try:

# Hent kundedata

customer_data = self.fetch_customer_data(customer_id)

# Forbered indhold til AI-analyse

content_to_analyze = f"""

Kunde: {customer_data['name']}

Seneste interaktioner: {customer_data['recent_interactions']}

Købshistorik: {customer_data['purchase_history']}

"""

# Få AI-analyse

insights = self.analyze_with_ai(content_to_analyze)

# Opdater CRM med indsigter

success = self.update_crm_with_insights(customer_id, insights)

if success:

self.logger.info(f"Succesfuldt behandlet kunde {customer_id}")

return {'status': 'success', 'insights': insights}

else:

self.logger.error(f"CRM-opdatering mislykkedes for kunde {customer_id}")

return {'status': 'error', 'message': 'CRM-opdatering mislykkedes'}

except Exception as e:

self.logger.error(f"Pipeline-fejl: {str(e)}")

return {'status': 'error', 'message': str(e)}

Dette eksempel viser en komplet integrationspipeline, der henter data fra et CRM, sender dem til AI-analyse og opdaterer CRM med resultaterne. Mønstret kan tilpasses utallige forretningsscenarier.

Forskellige integrationsscenarier kræver forskellige arkitekturmønstre. Forståelse af fordele og ulemper hjælper dig med at vælge den rette strategi til dit behov.

| Metode | Bedst til | Fordele | Ulemper | Latens |

|---|---|---|---|---|

| Synkrone API-kald | Realtidsoperationer, brugerrettede funktioner | Simpelt, øjeblikkeligt feedback, nem fejlfinding | Langsommere hvis AI-modellen er langsom, blokerer eksekvering | Lav til middel |

| Asynkront med webhooks | Hændelsesdrevne workflows, høj volumen | Ikke-blokerende, skalerbar, responsiv | Mere kompleks, eventual consistency | Middel til høj |

| Message Queues | Løskoblede systemer, batch-behandling | Pålidelig levering, load balancing, retry-logik | Ekstra infrastruktur, eventual consistency | Middel til høj |

| Planlagte jobs | Periodisk analyse, batch-behandling | Enkel, forudsigeligt ressourceforbrug | Ikke realtid, kan misse akutte hændelser | Høj |

| Streaming-integration | Realtidsdatabehandling, kontinuerlig analyse | Øjeblikkelige indsigter, håndterer høj volumen | Kompleks infrastruktur, kræver specialiserede værktøjer | Meget lav |

Hver metode har sin berettigelse. Et kundesupportsystem kan bruge synkrone API-kald til øjeblikkelige chatbot-svar, men asynkron behandling til dybere toneanalyse. En e-handelsplatform kan bruge webhooks til ordre-hændelser, men planlagte jobs til natlig lageranalyse.

At administrere flere API-integrationer og webhooks manuelt kan hurtigt blive uoverskueligt, efterhånden som dit system vokser. Her revolutionerer FlowHunt din integrationsstrategi.

FlowHunt er en omfattende workflow-automatiseringsplatform designet specifikt til AI-drevne integrationer. I stedet for at bygge og vedligeholde specialkode til integration, giver FlowHunt en visuel grænseflade til at forbinde AI-modeller med eksterne værktøjer, håndtere autentificering, fejl og overvåge performance.

Visuel workflow-builder: Design komplekse integrationsworkflows uden at skrive kode. Forbind AI-modeller, API’er og webhooks via intuitiv drag-and-drop. FlowHunt håndterer de underliggende HTTP-anmodninger, autentificering og datatransformation.

Forudbyggede connectors: FlowHunt inkluderer connectors til populære AI-tjenester (OpenAI, Google Cloud AI, Anthropic) og hundreder af eksterne værktøjer (Salesforce, HubSpot, Slack, Stripe m.fl.). Disse connectors håndterer autentificering og API-specifikke detaljer, så du kan fokusere på forretningslogik.

Webhook-håndtering: FlowHunt gør opsætning og håndtering af webhooks enkel. Registrér webhooks hos eksterne tjenester, modtag hændelser og start AI-analyse – alt via FlowHunt. Du behøver ikke selv bygge og vedligeholde webhook-modtagere.

Fejlhåndtering og genforsøg: Automatisk genforsøg af fejlede API-kald med eksponentiel backoff. Opsæt fejlnotifikationer og fallback-workflows. FlowHunt sikrer, at dine integrationer er robuste og pålidelige.

Datatransformation: Transformér data mellem forskellige formater og strukturer. Map felter fra dit CRM til input til AI-modeller, og transformer AI-output til formater, som dine andre værktøjer forventer.

Overvågning og logning: Spor alle API-kald, webhook-hændelser og workflow-eksekveringer. Identificér flaskehalse, fejlret problemer og optimer ydeevne med omfattende logning og analyse.

Rate limiting og throttling: FlowHunt håndterer automatisk API-rate limits, køer anmodninger og fordeler dem over tid, så du holder dig inden for servicegrænser.

Forestil dig, at du vil analysere kundefeedback automatisk fra dit supportsystem, kategorisere tone og opdatere dit CRM. I FlowHunt ville workflowet se således ud:

Hvad der ville kræve mange kodelinjer og omhyggelig fejlhåndtering i en specialløsning, bliver til et visuelt workflow i FlowHunt. Du kan ændre workflowet, tilføje trin eller skifte AI-model uden at røre kode.

Efterhånden som dine AI-integrationsbehov vokser, bliver flere avancerede mønstre og best practices vigtige.

De fleste API’er har rate limits – maksimalt antal forespørgsler pr. minut eller time. Overskrides disse, får du fejl og kan risikere suspendering. Effektiv styring af rate limits er afgørende for stabile integrationer.

Implementér eksponentiel backoff: Når du rammer en rate limit, vent før du forsøger igen, og forøg ventetiden for hvert forsøg. De fleste API-svar inkluderer rate limit-information i headers, så du kan styre dit anmodningsflow proaktivt.

import time

import requests

def call_api_with_backoff(url, headers, data, max_retries=5):

"""Kald API med eksponentiel backoff for rate limiting"""

for attempt in range(max_retries):

try:

response = requests.post(url, headers=headers, json=data)

# Tjek om vi ramte rate limit

if response.status_code == 429:

# Hent retry-after header hvis tilgængelig

retry_after = int(response.headers.get('Retry-After', 2 ** attempt))

print(f"Rate limited. Venter {retry_after} sekunder...")

time.sleep(retry_after)

continue

# Tjek for andre fejl

response.raise_for_status()

return response.json()

except requests.exceptions.RequestException as e:

if attempt == max_retries - 1:

raise

wait_time = 2 ** attempt

print(f"Request fejlede: {e}. Prøver igen om {wait_time} sekunder...")

time.sleep(wait_time)

raise Exception("Maks antal forsøg overskredet")

Nogle AI-operationer tager tid at gennemføre. I stedet for at blokere din applikation, mens du venter på svar, brug asynkrone mønstre, hvor AI-tjenesten returnerer et job-ID, og du enten poller for resultatet eller modtager en webhook, når behandlingen er færdig.

def submit_async_ai_job(content):

"""Indsend indhold til asynkron AI-behandling"""

headers = {'Authorization': f'Bearer {AI_API_KEY}'}

response = requests.post(

'https://api.ai.example.com/async-analyze',

headers=headers,

json={'content': content}

)

job_data = response.json()

return job_data['job_id']

def check_job_status(job_id):

"""Tjek status for asynkront job"""

headers = {'Authorization': f'Bearer {AI_API_KEY}'}

response = requests.get(

f'https://api.ai.example.com/jobs/{job_id}',

headers=headers

)

job_data = response.json()

if job_data['status'] == 'completed':

return {'status': 'completed', 'result': job_data['result']}

elif job_data['status'] == 'failed':

return {'status': 'failed', 'error': job_data['error']}

else:

return {'status': 'processing'}

At kalde AI-API’er gentagne gange med identiske input spilder ressourcer og øger omkostninger. Implementér caching for at gemme resultater ved ofte forekommende forespørgsler.

import hashlib

import json

from functools import wraps

import redis

# Forbind til Redis-cache

cache = redis.Redis(host='localhost', port=6379, db=0)

def cache_ai_result(ttl=3600):

"""Decorator til caching af AI API-resultater"""

def decorator(func):

@wraps(func)

def wrapper(content, *args, **kwargs):

# Opret cache-nøgle ud fra content hash

content_hash = hashlib.md5(content.encode()).hexdigest()

cache_key = f"ai_result:{content_hash}"

# Tjek cache

cached_result = cache.get(cache_key)

if cached_result:

return json.loads(cached_result)

# Kald AI API

result = func(content, *args, **kwargs)

# Gem i cache

cache.setex(cache_key, ttl, json.dumps(result))

return result

return wrapper

return decorator

@cache_ai_result(ttl=86400) # Cache i 24 timer

def analyze_sentiment(text):

"""Analyser tone med caching"""

# AI API-kald her

pass

Integrationer i produktion kræver omfattende overvågning. Spor API-responstider, fejlrater og webhook-leveringssukses. Opsæt alarmer ved afvigelser.

import logging

from datetime import datetime

import json

class IntegrationMonitor:

def __init__(self, log_file='integration.log'):

self.logger = logging.getLogger(__name__)

handler = logging.FileHandler(log_file)

formatter = logging.Formatter(

'%(asctime)s - %(name)s - %(levelname)s - %(message)s'

)

handler.setFormatter(formatter)

self.logger.addHandler(handler)

def log_api_call(self, service, endpoint, status_code, response_time, error=None):

"""Log API-kalds-metrics"""

log_entry = {

'timestamp': datetime.now().isoformat(),

'service': service,

'endpoint': endpoint,

'status_code': status_code,

'response_time_ms': response_time,

'error': error

}

self.logger.info(json.dumps(log_entry))

def log_webhook_event(self, event_type, source, success, processing_time):

"""Log webhook-hændelse"""

log_entry = {

'timestamp': datetime.now().isoformat(),

'event_type': event_type,

'source': source,

'success': success,

'processing_time_ms': processing_time

}

self.logger.info(json.dumps(log_entry))

Lad os se på et praktisk eksempel, der viser, hvordan disse koncepter samles i en reel virksomhed.

Udfordringen: En

API'er er pull-baserede systemer, hvor du anmoder om data fra en ekstern tjeneste, mens webhooks er push-baserede systemer, hvor eksterne tjenester sender data til din applikation, når specifikke hændelser opstår. API'er er ideelle til datahentning efter behov, mens webhooks er stærke til realtidsnotifikationer om hændelser.

Opbevar API-nøgler i miljøvariabler, brug dedikerede værktøjer til hemmelighedshåndtering som HashiCorp Vault eller AWS Secrets Manager, undlad at gemme nøgler i versionskontrol, roter nøgler regelmæssigt, og anvend princippet om mindst privilegium ved kun at give nødvendige rettigheder til nøgler.

Almindelige autentificeringsmetoder inkluderer API-nøgler (simple token-baserede), OAuth 2.0 (delegeret autorisation), Bearer tokens (JWT-baserede) og mutual TLS (certifikat-baserede). Valget afhænger af API-udbyderens sikkerhedskrav og din applikations behov.

Implementer eksponentielle backoff-strategier for genforsøg, overvåg rate limit-headere i API-svar, brug køsystemer til anmodninger, cache svar hvor det er muligt, og overvej opgradering til højere API-planer, hvis du ofte rammer grænser. Mange biblioteker tilbyder indbyggede funktioner til genforsøg.

Arshia er AI Workflow Engineer hos FlowHunt. Med en baggrund inden for datalogi og en passion for AI, specialiserer han sig i at skabe effektive workflows, der integrerer AI-værktøjer i daglige opgaver og øger produktivitet og kreativitet.

FlowHunt forenkler AI-integration med eksterne værktøjer, automatiserer API-kald, webhook-håndtering og databehandling på én samlet platform.

Integrer FlowHunt med Webflow MCP for at automatisere styring af hjemmeside og CMS, opdatere indhold og orkestrere intelligente arbejdsgange ved hjælp af AI-dre...

Forbind FlowHunt med Createve AI Nexus for at samle AI-agenter, automatisere virksomhedens arbejdsgange og muliggøre realtids systemintegration ved hjælp af Mod...

Integrer FlowHunts WayStation med dine foretrukne produktivitetsværktøjer og førende AI-klienter for problemfri, sikker automatisering uden kode. Forbind Notion...

Cookie Samtykke

Vi bruger cookies til at forbedre din browsingoplevelse og analysere vores trafik. See our privacy policy.