Introduktion

Rejsen fra at bygge en fungerende AI-prototype til at implementere et produktionsklart system har længe været en af de mest udfordrende aspekter af udviklingen inden for kunstig intelligens. Det, der ofte føles som en ligetil proces i demoer — at hente relevant information, udvide prompts og generere svar — bliver eksponentielt mere komplekst, når det skal skaleres til produktionsmiljøer. Denne kompleksitet har ført til, at mange i branchen beskriver processen som “alkymi” snarere end engineering: en mystisk proces, hvor udviklere justerer konfigurationer, ændrer parametre og håber, at deres systemer fortsat fungerer pålideligt. Fremkomsten af kontekst engineering som disciplin repræsenterer et fundamentalt skifte i vores tilgang til at bygge AI-systemer, væk fra denne trial-and-error-metodologi og hen imod en mere systematisk, ingeniørmæssig tilgang. I denne dybdegående gennemgang vil vi undersøge, hvordan moderne vektordatabaser og principper for kontekst engineering forandrer landskabet for udvikling af AI-applikationer og gør det muligt for teams at bygge systemer, der ikke blot er funktionelle, men reelt pålidelige og vedligeholdelsesvenlige i stor skala.

Hvad er kontekst engineering, og hvorfor er det vigtigt?

Kontekst engineering har udviklet sig til at være en af de mest kritiske discipliner inden for moderne AI-udvikling, men er stadig dårligt forstået af mange udviklere, der træder ind i feltet. I sin kerne er kontekst engineering praksissen med systematisk at håndtere, organisere og optimere den kontekstuelle information, som AI-systemer bruger til at træffe beslutninger og generere output. I modsætning til traditionel Retrieval-Augmented Generation (RAG), der snævert fokuserer på at hente relevante dokumenter for at udvide en prompt, inden den sendes til en sprogmodel, tager kontekst engineering et langt bredere syn på hele pipelinen. Det omfatter, hvordan data flyder gennem systemet, hvordan information lagres og indekseres, hvordan hentning sker, hvordan resultater rangeres og filtreres, og i sidste ende hvordan denne kontekst præsenteres for modellen. Dette holistiske perspektiv anerkender, at kvaliteten af et AI-systems output grundlæggende begrænses af kvaliteten og relevansen af den kontekst, det modtager. Når konteksten håndteres dårligt — når irrelevant information hentes, vigtige detaljer overses, eller den samme information behandles flere gange — forringes hele systemet. Kontekst engineering løser disse udfordringer ved at behandle konteksthåndtering som en ingeniørmæssig disciplin på linje med andre kritiske infrastrukturkomponenter.

Vigtigheden af kontekst engineering bliver straks tydelig, når man betragter den skala, moderne AI-systemer opererer i. En sprogmodel kan blive bedt om at behandle hundredtusindvis af dokumenter, sammenfatte information fra flere kilder og generere sammenhængende svar baseret på denne syntese. Uden korrekt kontekst engineering bliver denne proces kaotisk. Irrelevante dokumenter fylder i kontekstvinduet, vigtig information går tabt i støjen, og modellens ydeevne forringes. Efterhånden som AI-systemer bliver mere sofistikerede og udbredte i kritiske applikationer — fra kundeservice til medicinsk diagnose til finansiel analyse — stiger konsekvenserne af dårlig kontekst engineering dramatisk. Et system, der af og til returnerer irrelevant information, kan være acceptabelt til underholdningsformål, men bliver uacceptabelt, når det træffer beslutninger, der påvirker menneskers liv eller levebrød. Kontekst engineering sikrer, at informationen i systemet ikke blot er rigelig, men også ægte relevant, korrekt organiseret og optimeret til den specifikke opgave.

Klar til at vokse din virksomhed?

Start din gratis prøveperiode i dag og se resultater inden for få dage.

Udviklingen fra demo til produktion: Alkimiproblemet

En af de mest vedvarende udfordringer i AI-udvikling har været det, branchens veteraner kalder “demo-til-produktions-gabet”. At bygge en fungerende prototype, der demonstrerer AI-evner, er relativt ligetil. En udvikler kan hurtigt samle en sprogmodel, forbinde den til et simpelt hentningssystem og skabe noget, der imponerer i et kontrolleret miljø. Men i det øjeblik systemet skal håndtere virkelige data i stor skala, opretholde pålidelighed over tid og tilpasse sig ændrede krav, bliver alt markant sværere. Dette gab er historisk blevet broget med det, der kun kan beskrives som alkymi — en mystisk kombination af konfigurationsjusteringer, parameterændringer og empirisk trial-and-error, der på en eller anden måde resulterer i et fungerende system. Problemet med denne tilgang er, at den ikke er reproducerbar, ikke skalerbar og ikke vedligeholdelsesvenlig. Når noget bryder sammen i produktion, er det ofte uklart hvorfor, og reparationen kræver den samme mystiske proces igen.

Roden til alkimiproblemet ligger i, at de fleste AI-infrastrukturer ikke blev designet med produktion for øje. Tidlige vektordatabaser og hentningssystemer blev primært bygget for at demonstrere muligheden for semantisk søgning og embedding-baseret hentning. De fungerede godt i kontrollerede miljøer med små datasæt og forudsigelige forespørgselsmønstre. Men når disse systemer skaleres til at håndtere millioner af dokumenter, tusindvis af samtidige brugere og uforudsigelige forespørgsler, bryder de ofte sammen. Datakonsistens bliver et problem. Forespørgselsydelsen forringes. Systemet bliver svært at fejlfinde og overvåge. Udviklerne befinder sig i en situation, hvor de ikke reelt ingeniørmæssigt bygger et system — de vedligeholder et komplekst, skrøbeligt artefakt, der fungerer gennem held og konstant indgriben. Det er her, moderne kontekst engineering og formålsbyggede infrastrukturer kommer ind. Ved at behandle overgangen fra demo til produktion som en reel ingeniørmæssig udfordring og ved at bygge systemer specifikt designet til produktionsarbejdsbyrder, kan vi forvandle denne mystiske alkymi til ægte engineering-praksis.

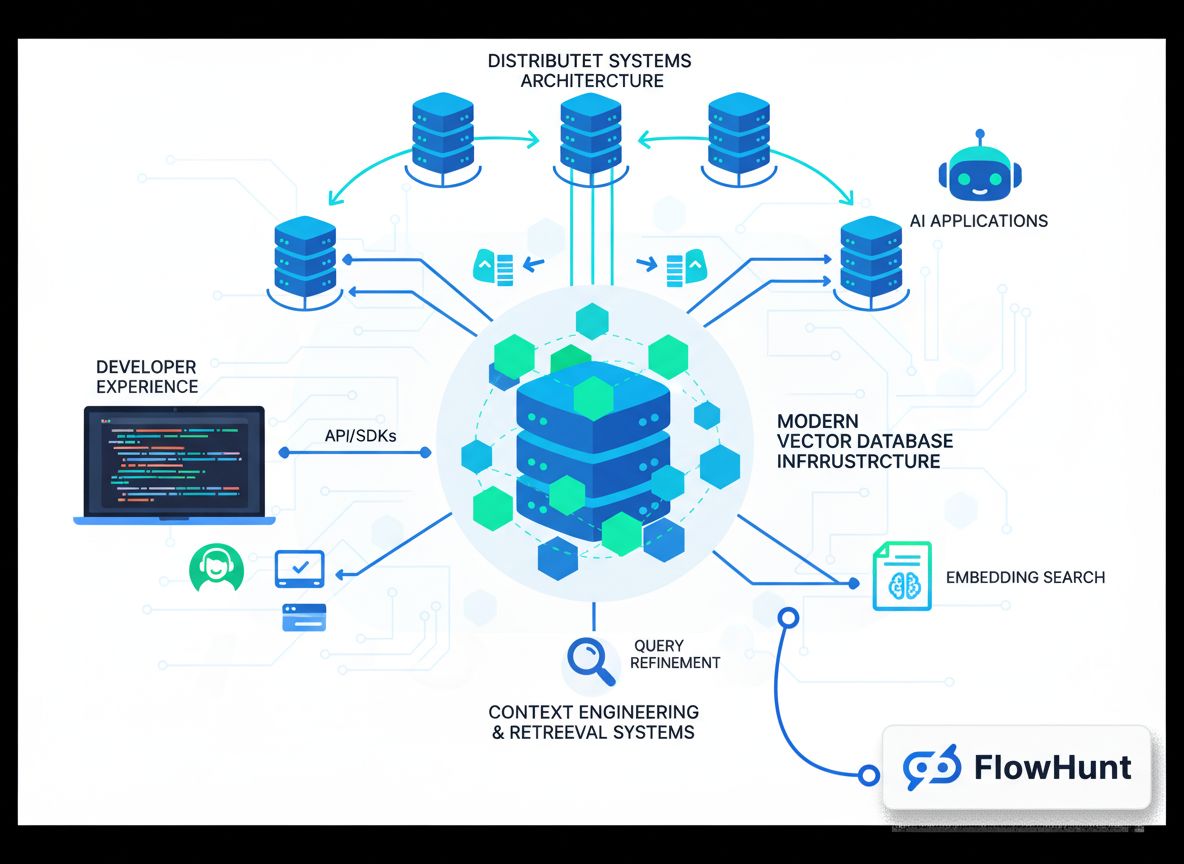

Forståelse af moderne søgeinfrastruktur til AI

Traditionel søgeinfrastruktur, som den der driver Google og andre søgemaskiner, blev designet ud fra specifikke antagelser om, hvordan søgning ville blive brugt. Disse systemer blev bygget til at håndtere søgninger baseret på nøgleord fra menneskelige brugere, der gennemgår resultaterne og beslutter, hvilke links de vil følge. Infrastrukturen blev optimeret til dette: hurtig nøgleordsmatchning, rangeringsalgoritmer tilpasset menneskers relevansvurdering og præsentation i form af “ti blå links”, som mennesker nemt kunne overskue. Men AI-systemer har fundamentalt andre behov. Når en sprogmodel forbruger søgeresultater, ser den ikke på ti links — den kan behandle uendeligt mere information. Modellen behøver ikke resultaterne formateret til menneskelig læsning; den har brug for strukturerede data, den kan ræsonnere over. Forespørgslerne er ikke nøgleordsbaserede, men semantiske, baseret på embeddings og vektorsimilitet. Disse forskelle betyder, at traditionel søgeinfrastruktur er dårligt egnet til AI-applikationer.

Moderne søgeinfrastruktur til AI adresserer disse forskelle på flere centrale måder. Først og fremmest er værktøjerne og teknologien fundamentalt anderledes. I stedet for nøgleordsindekser og rangeringsalgoritmer optimeret til menneskelig relevans, bruger moderne systemer vektorembeddings og semantisk lighed. I stedet for eksplicitte nøgleord forstår de betydningen og intentionen bag forespørgsler. Dernæst er arbejdsbyrdemønstrene anderledes. Traditionelle systemer håndterer simple forespørgsler, der returnerer få resultater. AI-systemer henter ofte store mængder dokumenter og behandler dem på sofistikerede måder. Udviklerne, der bruger systemerne, har også andre behov; AI-udviklere har brug for systemer, der er nemme at integrere, har god udvikleroplevelse og ikke kræver dyb ekspertise i søgeinfrastruktur. Endelig — og måske vigtigst — er forbrugerne af søgeresultaterne anderledes. I traditionel søgning er det mennesker, der foretager den sidste vurdering. I AI-systemer er det sprogmodellen, og den kan håndtere langt mere information. Dette fundamentale skifte i, hvem der konsumerer søgeresultaterne, ændrer alt i forhold til, hvordan infrastrukturen bør designes.

Tilmeld dig vores nyhedsbrev

Få de seneste tips, trends og tilbud gratis.

FlowHunt og fremtiden for AI-workflow-automatisering

Efterhånden som organisationer i stigende grad anerkender vigtigheden af kontekst engineering og moderne søgeinfrastruktur, opstår udfordringen med at integrere disse muligheder i eksisterende workflows og udviklingsprocesser. Her kommer platforme som FlowHunt ind i billedet og leverer et samlet miljø til at bygge, teste og implementere AI-applikationer, der er afhængige af avanceret kontekststyring og hentningssystemer. FlowHunt anerkender, at kontekst engineering ikke kun handler om at have den rette database — det handler om at have de rigtige værktøjer og workflows til at håndtere kontekst i hele AI-udviklingslivscyklussen. Fra dataindsamling og indeksering over hentning og rangering til endelig modelinference og outputgenerering skal hvert trin i pipelinen orkestreres og overvåges nøje. FlowHunt tilbyder automatiseringsmuligheder, der gør denne orkestrering gnidningsfri, så udviklere kan fokusere på at bygge gode AI-applikationer fremfor at kæmpe med infrastrukturdetaljer.

Platformens tilgang til automatisering af kontekst engineering er særlig værdifuld for teams, der bygger flere AI-applikationer eller skal styre komplekse, flertrins-hentningspipelines. I stedet for at bygge skræddersyet infrastruktur for hver applikation kan teams udnytte FlowHunts færdige komponenter og workflows til at accelerere udviklingen. Platformen håndterer det kedelige arbejde med dataindsamling, embedding-generering, indeksstyring og hentningsorkestrering, så udviklere kan fokusere på det unikke ved deres applikationer. Derudover giver FlowHunt synlighed og overvågningsmuligheder, så det er let at forstå, hvordan kontekst flyder gennem systemet, identificere flaskehalse og optimere ydeevnen. Denne kombination af automatisering og synlighed gør kontekst engineering til en systematisk og målbar disciplin i stedet for en mystisk trial-and-error-proces.

Arkitekturen bag produktionsklare vektordatabaser

At bygge en vektordatabase, der fungerer i en demo, er én ting; at bygge én, der pålideligt kan håndtere produktionsarbejdsbyrder, er noget helt andet. Produktionsklare vektordatabaser skal håndtere flere samtidige brugere, opretholde datakonsistens, sikre pålidelig persistens og skalere elegant, efterhånden som datamængderne vokser. De skal være fejlfindbare, overvågelige og vedligeholdelsesvenlige, så teams kan videreudvikle systemet over tid. Disse krav har ført til udviklingen af moderne vektordatabasearkitekturer, der inkorporerer principper fra distribuerede systemer, som har bevist deres værd gennem årtiers brug.

Et af de vigtigste arkitektoniske principper i moderne vektordatabaser er adskillelse af storage og compute. I traditionelle monolitiske databaser er storage og compute tæt koblet — den samme server, der lagrer data, håndterer også forespørgsler. Dette skaber problemer i stor skala. Har man brug for mere processorkraft, skal man også tilføje mere storage. Har man brug for mere storage, skal man tilføje mere compute. Denne ineffektivitet fører til spildte ressourcer og højere omkostninger. Ved at adskille storage og compute kan moderne vektordatabaser skalere hver del uafhængigt. Storage kan håndteres via omkostningseffektive objektlagringsløsninger som Amazon S3, mens compute-ressourcer kan skaleres efter behov. Dette giver stor fleksibilitet og omkostningseffektivitet. Et andet vigtigt princip er multi-tenancy, som gør det muligt for én databaseinstans at betjene flere uafhængige applikationer eller teams. Multi-tenancy kræver omhyggelig isolation, så én brugers data og forespørgsler ikke påvirker andres, men når det er implementeret korrekt, øger det ressourceudnyttelsen og reducerer den operationelle kompleksitet markant.

Moderne vektordatabaser inkorporerer også principper fra distribuerede systemer, som er blevet standard i det seneste årti. Dette omfatter read-write-separation, hvor læse- og skriveoperationer håndteres af forskellige komponenter optimeret til deres respektive arbejdsbyrder; asynkron replikering, der sikrer datadurabilitet uden at gå på kompromis med skriveydelsen; og distribuerede konsensusmekanismer, der sikrer konsistens på tværs af noder. Disse principper, kombineret med moderne programmeringssprog som Rust, der både giver performance og sikkerhed, gør det muligt for vektordatabaser at opnå den pålidelighed og ydeevne, der kræves i produktionssystemer. Resultatet er infrastruktur, der ikke føles som alkymi — men som engineering.

Chroma’s tilgang til udvikleroplevelse

Da Chroma blev grundlagt, havde teamet en klar tese: afstanden mellem at bygge en fungerende AI-demo og at implementere et produktionssystem føltes mere som alkymi end engineering, og dette gab skulle lukkes. Teamets tilgang var at starte med et ekstremt fokus på udvikleroplevelse. I stedet for at forsøge at bygge det mest funktionsrige eller skalerbare system fokuserede de på at gøre det utrolig nemt for udviklere at komme i gang med vektordatabaser og semantisk søgning. Dette førte til en af Chromas mest markante egenskaber: muligheden for at installere det med en enkelt pip-kommando og begynde at bruge det med det samme, uden kompleks konfiguration eller infrastruktursetup. Denne enkelhed var revolutionerende i vektordatabasefeltet. De fleste databaser kræver betydelig opsætning, før man kan køre en simpel forespørgsel. Chroma fjernede denne friktion, så udviklere kunne eksperimentere med vektordatabaser og semantisk søgning på få minutter fremfor timer eller dage.

Engagementet i udvikleroplevelse rakte videre end den første opsætning. Chroma-teamet investerede massivt i at sikre, at systemet fungerede pålideligt på tværs af forskellige arkitekturer og deployments. I de tidlige dage rapporterede brugere, at de kørte Chroma på alt fra standard Linux-servere til Arduinos og Power PC-arkitekturer. I stedet for at affeje disse brugsscenarier som edge cases, gik Chroma-teamet den ekstra mil for at sikre, at systemet fungerede pålideligt overalt. Dette engagement i universel kompatibilitet og pålidelighed opbyggede tillid i udviklersamfundet og bidrog til Chromas hurtige udbredelse. Teamet anerkendte, at udvikleroplevelse ikke kun handler om brugervenlighed — det handler om pålidelighed, konsistens og tillid til, at systemet virker som forventet på tværs af miljøer.

Efterhånden som Chroma udviklede sig, og teamet begyndte at bygge Chroma Cloud, stod de over for en kritisk beslutning. De kunne hurtigt have lanceret en hosted version af single-node-produktet og hurtigt udnyttet efterspørgslen efter managed vektordatabaser. Mange virksomheder i feltet tog denne beslutning og kunne dermed rejse betydelige kapitalmængder og gøre store markedsindtryk. Men Chroma-teamet traf et andet valg. De erkendte, at blot at hoste single-node-produktet som en service ikke ville opfylde deres krav til udvikleroplevelse. Et virkelig godt cloud-produkt skulle designes fra bunden med cloud-native principper for øje. Det skulle levere samme brugervenlighed og pålidelighed som single-node-produktet, men med den skalerbarhed og robusthed, som produktion kræver. Denne beslutning betød, at det tog længere tid at bygge Chroma Cloud, men resulterede i et produkt, der reelt leverer på løftet om at få kontekst engineering til at føles som engineering — ikke alkymi.

De fire dimensioner af “AI” i moderne søgeinfrastruktur

Når man taler om moderne søgeinfrastruktur til AI, er det vigtigt at erkende, at “AI” betyder forskellige ting i forskellige sammenhænge. Der er faktisk fire forskellige dimensioner, hvor moderne søgeinfrastruktur adskiller sig fra traditionelle systemer, og det er afgørende at forstå disse for at bygge effektive AI-applikationer. Den første dimension er teknologisk. Værktøjerne og teknologien i moderne søgeinfrastruktur er fundamentalt forskellige fra dem i traditionelle systemer. I stedet for inverterede indekser og nøgleordsmatch bruger moderne systemer vektorembeddings og semantisk lighed. I stedet for TF-IDF-rangering bruger de neurale netværk og lærte rangeringsfunktioner. Disse teknologiske forskelle afspejler både problemstillingerne og mulighederne i moderne AI-systemer.

Den anden dimension er arbejdsbyrdemønstre. Traditionelle søgesystemer var designet til at håndtere relativt simple, tilstandsløse forespørgsler, der returnerer et lille antal resultater. Moderne AI-systemer håndterer ofte komplekse, flertrins-hentningspipelines med flere runder af rangering, filtrering og gen-rangering. De kan skulle hente tusindvis af dokumenter og behandle dem avanceret. Arbejdsbyrdemønstrene er fundamentalt anderledes, hvilket betyder, at infrastrukturen også skal designes anderledes for at håndtere disse mønstre effektivt. Den tredje dimension er udvikleren. Traditionelle søgesystemer blev typisk bygget og vedligeholdt af specialiserede søgeingeniører med dyb ekspertise inden for informationshentning. Moderne AI-udviklere er ofte generalister uden dyb søgeinfrastrukturviden, men skal bygge applikationer, der kræver avanceret hentning. Det betyder, at moderne søgeinfrastruktur skal være designet til brugervenlighed og tilgængelighed, ikke kun kraft og fleksibilitet.

Den fjerde og måske vigtigste dimension er forbrugeren af søgeresultaterne. I traditionelle systemer er det mennesker, der bruger resultaterne. Mennesker kan kun overskue et begrænset antal resultater — typisk omkring ti links — og de udfører den sidste vurdering af relevans og syntese af information. I moderne AI-systemer er det sprogmodeller, der forbruger resultaterne, og de kan nemt behandle hundredvis eller tusindvis af dokumenter og sammenfatte information fra dem alle. Denne grundlæggende forskel i forbrugeren af resultater ændrer alt ved, hvordan infrastrukturen bør designes. Det betyder, at rangeringsalgoritmer kan optimeres for maskinforbrug snarere end menneskelig læsning. Resultatpræsentationen kan optimeres til maskinbehandling frem for menneskelig overskuelighed. Hele pipelinen kan designes ud fra, at en avanceret AI vil udføre det sidste arbejde.

At fastholde visionen i et støjende marked

Markedet for vektordatabaser i 2023 var et af de hotteste felter inden for AI-infrastruktur. Virksomheder rejste enorme kapitalbeløb, gjorde store markedsindtryk og konkurrerede om at bygge de mest funktionsrige systemer. I dette miljø ville det have været let for Chroma at miste fokus, jagte enhver trend og forsøge at være alt for alle. I stedet valgte teamet bevidst at holde fokus på deres kernevision: at bygge en hentningsmotor til AI-applikationer med en exceptionel udvikleroplevelse, der reelt lukker gabet mellem demo og produktion. Dette fokus krævede disciplin og overbevisning, især når andre virksomheder i feltet rejste større runder og lavede flere markedsudmeldinger.

Nøglen til at fastholde dette fokus var en klar, kontrolleret tese om, hvad der virkelig betød noget. Chroma-teamet mente, at det ikke var antallet af funktioner eller mængden af kapital, der talte, men kvaliteten af udvikleroplevelsen og systemets pålidelighed. De mente, at hvis de gjorde én ting — bygge en god hentningsmotor — på verdensklasseniveau, ville de få ret til at gøre mere senere. Denne filosofi om manisk fokus på én kernekompetence er ikke unik for Chroma, men bliver stadig mere sjælden i venturefinansierede startups, hvor presset for hurtigt vækst og kapital ofte fører til, at virksomheder spreder sig for bredt. Chroma-teamets engagement i denne filosofi, selv når det betød at bruge længere tid på at lancere Chroma Cloud og potentielt miste kortsigtede markedsmuligheder, viste sig i sidste ende at være den rigtige beslutning.

At fastholde visionen kræver også omhyggelighed i rekruttering og teamopbygning. De mennesker, du ansætter, former organisationens kultur, og kulturen bestemmer, hvad og hvordan du bygger. Chroma-teamet anerkendte dette og valgte at ansætte langsomt og være meget selektive med, hvem de bragte ind. I stedet for at vokse så hurtigt som muligt fokuserede de på at ansætte folk, der var på linje med visionen, som gik op i kvalitet og kunne arbejde selvstændigt på højt niveau. Denne tilgang betød, at teamet voksede langsommere, men sikrede, at alle var engageret i missionen og kunne bidrage meningsfuldt. Denne type kulturel tilpasning er svær at opnå i hurtigt voksende startups, men er afgørende for at fastholde fokus og vision på lang sigt.

Værdien af håndværk og kvalitet i infrastruktur

Et af de mest markante aspekter ved Chroma-teamets tilgang er deres vægt på håndværk og kvalitet. I infrastrukturbranchen er det let at tro, at flere funktioner, mere performance eller større skala altid er bedre. Men Chroma-teamet indså, at det vigtigste er at bygge systemer, der fungerer pålideligt, er lette at bruge og reelt løser udviklernes problemer. Denne vægt på håndværk og kvalitet viser sig på mange måder. Det ses i valget af at skrive Chroma i Rust, et sprog der giver både ydeevne og sikkerhed, i stedet for et mere bekvemt, men mindre pålideligt sprog. Det ses i engagementet i at få systemet til at fungere på tværs af forskellige arkitekturer og deployments, selv når de er usædvanlige. Det ses i beslutningen om at tage sig tid til at bygge Chroma Cloud rigtigt frem for at haste et halvdårligt produkt på markedet.

Denne vægt på håndværk og kvalitet gælder også for, hvordan teamet betragter problemområdet. I stedet for at se kontekst engineering som et snævert teknisk problem, der skal løses med smarte algoritmer, ser teamet det som en bredere udfordring, der omfatter udvikleroplevelse, pålidelighed, skalerbarhed og vedligeholdelse. Dette helhedssyn fører til bedre løsninger, fordi det anerkender, at et system kun er så godt som dets svageste led. Et system kan have de mest avancerede hentningsalgoritmer i verden, men hvis det er svært at bruge eller upålideligt i produktion, løser det ikke reelt problemet. Ved at fokusere på håndværk og kvalitet på alle områder har Chroma bygget noget, der reelt virker for udviklere og reelt lukker gabet mellem demo og produktion.

Praktiske implikationer for AI-udviklingsteams

For teams, der bygger AI-applikationer, har indsigterne fra Chromas tilgang flere praktiske implikationer. For det første er det vigtigt at indse, at kontekst engineering ikke er en sidequest i AI-udvikling — det er hovedquesten. Kvaliteten af dit AI-system begrænses fundamentalt af kvaliteten af den kontekst, det modtager, så investering i ordentlig kontekst engineering-infrastruktur er ikke valgfrit. Det er essentielt. For det andet bør man være skeptisk over for systemer, der lover at gøre alt. De mest pålidelige og effektive systemer er ofte dem, der gør én ting virkelig godt og bygger videre derfra. Hvis du vurderer vektordatabaser eller hentningssystemer, så vælg dem med et klart fokus og et engagement i at gøre netop det på verdensklasseniveau. For det tredje betyder udvikleroplevelse noget. Et system, der er teoretisk stærkere, men svært at bruge, vil i sidste ende være mindre værd end et, der er lidt mindre kraftfuldt, men let at bruge. Det er fordi udviklere faktisk bruger det lette system og bygger gode løsninger med det, mens de kæmper med det svære og måske giver op.

For det fjerde betyder pålidelighed og konsistens mere, end man tror. I AI-udviklingens tidlige faser kan det være fristende at sætte funktioner og performance over pålidelighed. Men når dine systemer kommer i produktion og håndterer virkelige arbejdsbyrder, bliver pålidelighed altafgørende. Et system, der er 95 % pålideligt, kan lyde acceptabelt, men hvis du kører millioner af forespørgsler dagligt, betyder 5 % fejlrate hundredtusindvis af fejl. At investere i pålidelighed fra starten er langt billigere end at forsøge at indføre det senere. Endelig er det vigtigt at tænke på dit systems langsigtede udvikling. Den infrastruktur, du vælger i dag, former, hvad du kan bygge i morgen. At vælge infrastruktur, der er designet til produktion fra starten, skalerer elegant og giver god synlighed og overvågning, betaler sig, efterhånden som dine systemer vokser.

{{ cta-dark-panel

heading=“Boost dit workflow med FlowHunt”

description=“Oplev hvordan FlowHunt automatiserer dine AI-indholds- og SEO-workflows — fra research og indholdsgenerering til publicering og analyse — alt samlet ét sted.”

ctaPrimaryText=“Book en demo”

ctaPrimaryURL=“https://calendly.com/liveagentsession/flowhunt-chatbot-demo"

ctaSecondaryText=“Prøv FlowHunt gratis”

ctaSecondaryURL=“https://app.flowhunt.io/sign-in"

gradientStartColor="#123456”

gradientEndColor="#654321”

gradientId=“827591b1-ce8c-4110-b064-7cb85a0b1217”

}}

Open source’ens rolle i opbygning af tillid og fællesskab

En af de vigtigste beslutninger, Chroma-teamet traf, var at open-source kerneproduktet. Denne beslutning havde flere vigtige konsekvenser. For det første opbyggede det tillid i udviklermiljøet. Når udviklere kan se koden, forstå hvordan systemet fungerer og bidrage med forbedringer, er de langt mere tilbøjelige til at stole på systemet og tage det i brug. Open source skaber også en positiv spiral, hvor fællesskabsbidrag forbedrer produktet, hvilket tiltrækker flere brugere og giver endnu flere bidrag. For det andet skabte open sourcing af produktet et stærkt fællesskab omkring Chroma. Udviklere, der bruger produktet, bliver engagerede i dets succes og er mere tilbøjelige til at bidrage, give feedback og anbefale det til andre. Dette fællesskab bliver en værdifuld ressource, der er svær for konkurrenter at kopiere.

For det tredje giver open source en naturlig vej til kommercialisering gennem hostede services. Ved at open-source kerneproduktet har Chroma skabt en situation, hvor udviklere kan bruge produktet gratis, hvis de vil selvhoste, men hvor mange foretrækker en managed, hosted version, der håndterer drift, skalering og vedligeholdelse. Det er denne model, Chroma Cloud repræsenterer. Ved at tilbyde en overlegen hosted oplevelse, samtidig med at kerneproduktet forbliver open source, kan Chroma betjene både selvhostede brugere og markedet for managed services. Denne tilgang har vist sig at være mere bæredygtig og bedre tilpasset udviklernes præferencer end at forsøge at holde kerneproduktet proprietært og lukket.

At måle succes: De vigtige metrics

Når man evaluerer succes for infrastrukturprojekter som Chroma, er det vigtigt at fokusere på metrics, der faktisk afspejler den leverede værdi. Chroma har opnået imponerende metrics efter enhver målestok: over 21.000 GitHub-stjerner, over 5 millioner månedlige downloads og over 60-70 millioner downloads i alt. Disse tal afspejler den brede udbredelse af projektet i udviklermiljøet. Men ud over disse overskriftsmetrics er det, der virkelig tæller, om projektet løser udviklernes problemer. Gør det det lettere at bygge AI-applikationer? Reducerer det tiden og indsatsen fra demo til produktion? Muliggør det mere pålidelige systemer? Svaret på alle disse spørgsmål ser ud til at være ja, baseret på feedback fra fællesskabet og projektets hurtige udbredelse.

En anden vigtig metric er kvaliteten af fællesskabet og bidragene. Chroma har tiltrukket bidrag fra udviklere over hele branchen, herunder integrationer med populære frameworks som LangChain og Llama Index. Denne brede udbredelse og integration med andre værktøjer i økosystemet er et tegn på, at Chroma løser reelle problemer og giver ægte værdi. Det faktum, at Chroma er blevet default-valget for vektordatabasefunktionalitet i mange populære AI-frameworks, er et vidnesbyrd om produktets kvalitet og fællesskabets styrke. Disse kvalitative metrics — fællesskabsadoption, integration med andre værktøjer og positiv brugerfeedback — er ofte mere meningsfulde end rå downloadtal.

Fremtiden for kontekst engineering og AI-infrastruktur

Efterhånden som AI-systemer bliver mere sofistikerede og udbredte, vil vigtigheden af kontekst engineering kun vokse. De systemer, der bygges i dag, er blot begyndelsen. I fremtiden vil vi sandsynligvis se endnu mere avancerede til