Bygning af en MCP-server, der forbinder til OpenAI: En komplet udviklerguide

Lær hvordan du udvikler en Model Context Protocol (MCP) server, der sømløst integrerer med OpenAI's API og muliggør kraftfuld AI-drevet værktøjsudførelse og int...

Lær, hvad MCP (Model Context Protocol) servere er, hvordan de fungerer, og hvorfor de revolutionerer AI-integration. Opdag, hvordan MCP forenkler forbindelsen mellem AI-agenter og værktøjer, datakilder og API’er.

Den hurtige udvikling inden for kunstig intelligens har skabt en hidtil uset efterspørgsel efter problemfri integration mellem AI-modeller og eksterne systemer. Udviklere og virksomheder har dog længe kæmpet med en grundlæggende udfordring: At forbinde flere store sprogmodeller (LLM’er) til utallige værktøjer, API’er og datakilder kræver opbygning og vedligeholdelse af et utal af brugerdefinerede integrationer. Denne kompleksitet har hæmmet udviklingen af virkelig kapable AI-agenter, der kan tilgå information fra den virkelige verden og udføre meningsfulde handlinger. Her kommer Model Context Protocol (MCP) ind i billedet—en revolutionerende open source-standard, der fundamentalt ændrer, hvordan AI-applikationer forbinder sig til verden omkring dem. I denne omfattende guide udforsker vi, hvad MCP-servere er, hvordan de fungerer, hvorfor de er vigtige, og hvordan de er ved at transformere landskabet for AI-automatisering og integration.

Model Context Protocol repræsenterer et paradigmeskifte i, hvordan kunstige intelligenssystemer interagerer med eksterne data og værktøjer. Grundlæggende er MCP en open source-standard, der giver en samlet, standardiseret måde for AI-applikationer at forbinde til eksterne systemer. Tænk på det som en universel adapter eller, som mange i branchen beskriver det, en “USB-C-port for AI-applikationer”. Ligesom USB-C giver en standardiseret forbindelse, der virker på tværs af utallige enheder uanset producent, leverer MCP en standardiseret protokol, der virker på tværs af forskellige AI-modeller og eksterne systemer. Denne standardisering eliminerer behovet for brugerdefinerede, enkeltstående integrationer mellem hver LLM og hvert værktøj eller datakilde. Før MCP stod udviklere over for en eksponentiel vækst i kompleksiteten, efterhånden som de tilføjede flere AI-modeller eller eksterne systemer til deres applikationer. MCP forenkler grundlæggende denne arkitektur ved at skabe et enkelt, konsistent interface, som alle AI-applikationer og eksterne systemer kan bruge til at kommunikere med hinanden.

Protokollen blev udviklet af Anthropic og udgivet som et open source-initiativ for at løse et kritisk smertepunkt i AI-udviklingsøkosystemet. I stedet for at tvinge udviklere til at genopfinde den dybe tallerken for hver ny kombination af AI-model og eksternt system, tilbyder MCP en standardiseret ramme, der dramatisk reducerer udviklingstid, vedligeholdelsesbyrde og integrationskompleksitet. Denne tilgang har fået stor opbakning blandt udviklere, fordi den anerkender en grundlæggende sandhed: Fremtiden for AI handler ikke om isolerede chatbots, men om intelligente agenter, der problemfrit kan tilgå information, interagere med systemer og handle på tværs af en organisations samlede teknologistak.

Før vi dykker dybere ned i, hvordan MCP fungerer, er det vigtigt at forstå det problem, den løser—en udfordring, der har plaget AI-udvikling siden de kraftfulde sprogmodellers opståen. Dette problem kendes som “NxM-problemet”, hvor N repræsenterer antallet af forskellige LLM’er og M repræsenterer antallet af forskellige værktøjer, API’er og datakilder, organisationer ønsker at forbinde til disse modeller. Uden en standardiseret protokol kræver hver LLM brugerdefineret integrationskode til hvert værktøj, hvilket resulterer i N gange M integrationspunkter. Dette skaber en eksponentiel eksplosion i kompleksitet, som bliver sværere og sværere at håndtere, efterhånden som organisationer skalerer deres AI-initiativer.

Overvej et praktisk scenarie: En virksomhed ønsker at bruge både Claude og ChatGPT til at interagere med deres WordPress-side, Notion-arbejdsområde, Google Kalender og interne database. Uden MCP ville udviklere skulle lave otte separate integrationer—én for Claude til WordPress, én for Claude til Notion, én for Claude til Google Kalender, én for Claude til databasen, og derefter det samme for ChatGPT. Hver integration kræver brugerdefineret kode, test og løbende vedligeholdelse. Hvis virksomheden senere vil tilføje en tredje AI-model eller en femte datakilde, vokser antallet af integrationer eksponentielt. Denne redundans skaber flere kritiske problemer: Udviklingsteam løser de samme integrationsudfordringer igen og igen, vedligeholdelse bliver et mareridt, efterhånden som værktøjer og API’er udvikler sig, og inkonsistente implementeringer på tværs af forskellige integrationer leder til uforudsigelig adfærd og dårlige brugeroplevelser.

MCP løser dette problem ved at bryde NxM-forholdet. I stedet for at kræve N×M integrationer muliggør MCP, at organisationer kan bygge N+M forbindelser. Hver LLM forbinder sig til MCP-protokollen én gang, og hvert værktøj eller datakilde eksponerer sig selv gennem en MCP-server én gang. Dette lineære forhold reducerer kompleksiteten og vedligeholdelsesbyrden dramatisk. Når en ny AI-model bliver tilgængelig, behøver den kun at implementere MCP-understøttelse én gang for at få adgang til alle eksisterende MCP-servere. Tilsvarende, når et nyt værktøj eller en datakilde skal integreres, behøver det kun at eksponere et MCP-serverinterface for at blive tilgængeligt for alle MCP-kompatible AI-applikationer. Denne elegante løsning har dybtgående konsekvenser for, hvordan organisationer kan bygge og skalere deres AI-infrastruktur.

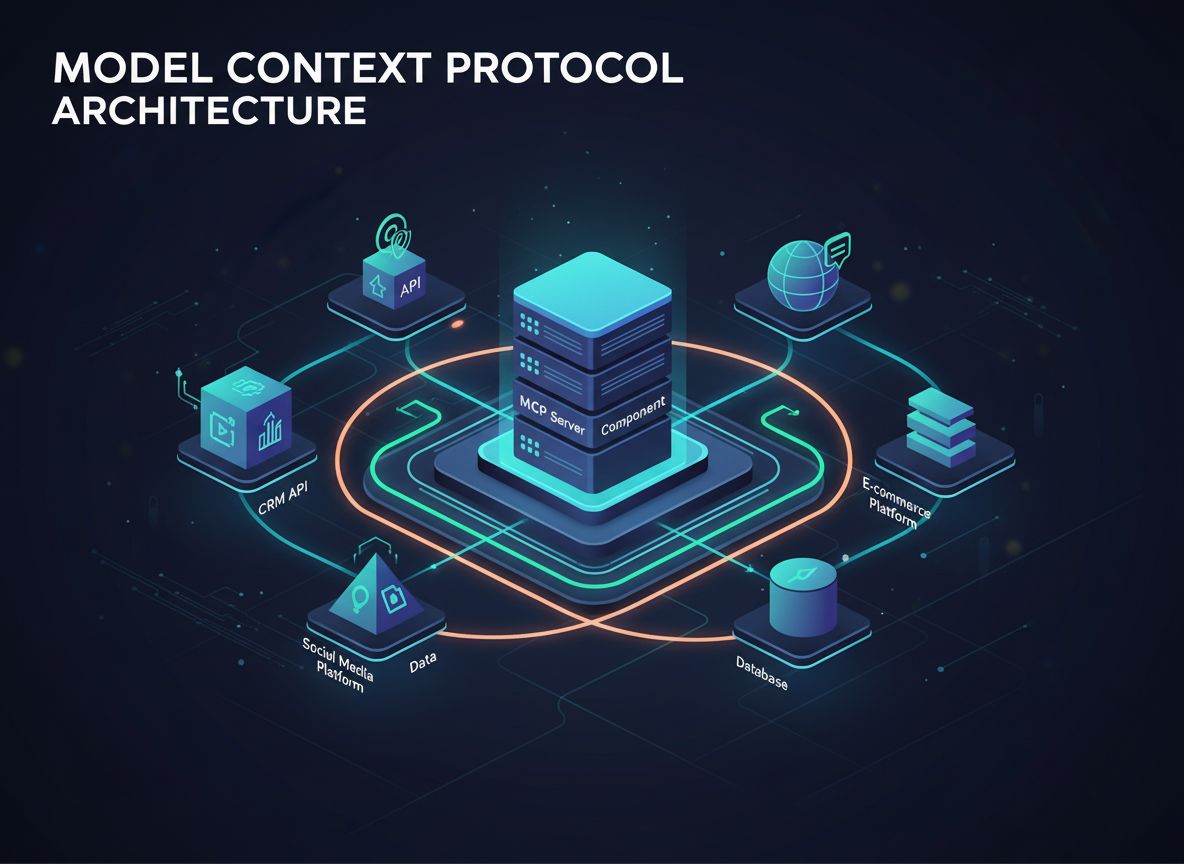

En MCP-server er grundlæggende en samling af værktøjer, API’er og vidensbaser samlet under ét standardiseret interface. I stedet for at en AI-agent skal forbinde sig til tyve forskellige API-endpoints og håndtere tyve separate autentificeringsmetoder, samler en MCP-server alt dette i én sammenhængende komponent. Denne arkitektoniske tilgang forenkler integrationsprocessen dramatisk og gør AI-agenter langt mere effektive til at opdage og bruge de nødvendige værktøjer.

For at forstå, hvordan dette fungerer i praksis, kan du forestille dig en WordPress MCP-server. I stedet for at en AI-agent skal kende til og forbinde sig til separate WordPress REST API-endpoints for indlæg, sider, medier, brugere, kategorier, tags, kommentarer og plugins, eksponerer WordPress MCP-serveren alle disse funktioner gennem ét interface. MCP-serveren indeholder flere værktøjer—opret indlæg, list indlæg, hent indlæg, slet indlæg, opret side, list sider osv.—hver med en tydelig titel og beskrivelse. Når en AI-agent skal udføre en handling, forespørger den MCP-serveren, som returnerer en liste over tilgængelige værktøjer med beskrivelser. Agenten kan så intelligent vælge det relevante værktøj baseret på brugerens forespørgsel og udføre det uden at skulle forstå den bagvedliggende API-kompleksitet.

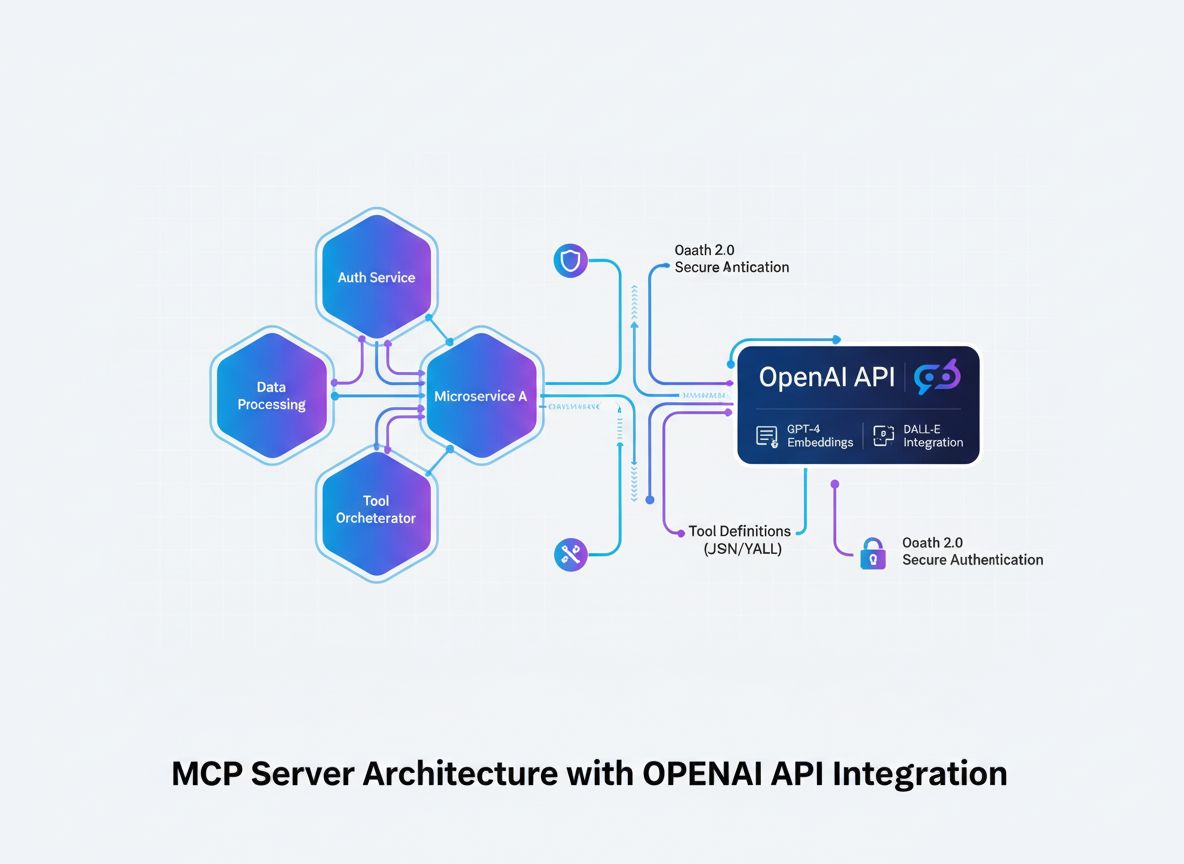

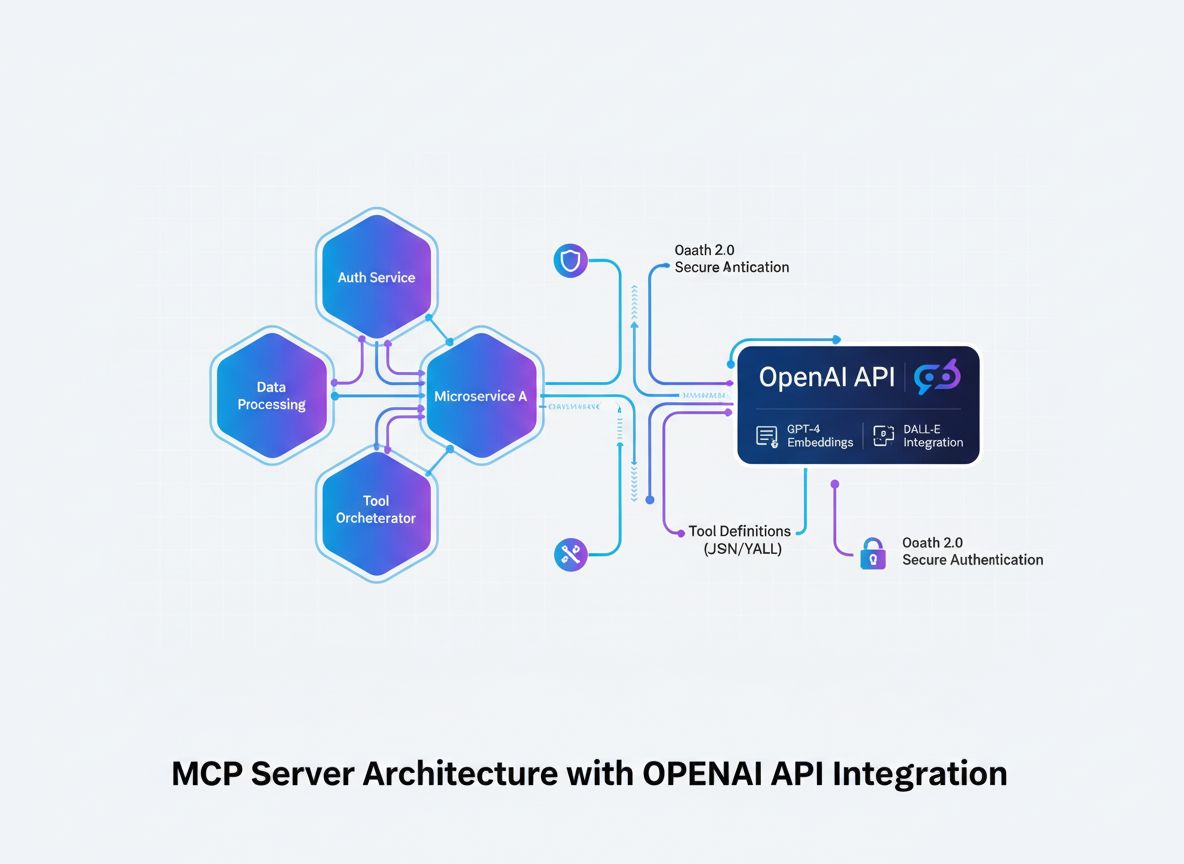

Arkitekturen i MCP består af flere centrale komponenter, der arbejder sammen. Først er der MCP-klienten, som typisk er AI-applikationen eller agenten, der skal tilgå eksterne værktøjer og data. Klienten initierer forbindelser og anmoder om værktøjer og ressourcer. Dernæst er der MCP-serveren, som eksponerer værktøjer, ressourcer og funktioner gennem det standardiserede MCP-interface. Serveren håndterer den faktiske integration med eksterne systemer og administrerer udførelsen af værktøjerne. Endelig er der selve protokollen, som definerer, hvordan klienter og servere kommunikerer, herunder formatet for forespørgsler, svar og fejlhåndtering. Denne tredelte arkitektur skaber en klar adskillelse af ansvar, hvilket gør hele systemet lettere at vedligeholde og skalere.

En af de mest elegante aspekter ved MCP’s design er måden, hvorpå den håndterer værktøjsopdagelse og -udførelse. Hvert værktøj, der eksponeres gennem en MCP-server, indeholder ikke kun selve værktøjet, men også metadata om værktøjet—navn, beskrivelse, parametre og forventede output. Når en AI-agent forbinder sig til en MCP-server, modtager den disse metadata, hvilket gør det muligt for agenten at forstå, hvilke værktøjer der er tilgængelige, og hvornår de skal bruges. Dette adskiller sig fundamentalt fra traditionel API-integration, hvor udviklere manuelt skal konfigurere hvert API-endpoint og lære AI-modellen om dets muligheder. Med MCP er opdagelsesprocessen automatisk og standardiseret, hvilket gør det langt lettere for AI-agenter at finde og bruge de rette værktøjer til enhver opgave.

FlowHunt anerkender det transformerende potentiale i MCP-servere inden for AI-automatisering og har opbygget omfattende understøttelse af MCP-integration i sin platform. Ved at udnytte MCP-servere gør FlowHunt det muligt for brugere at opbygge sofistikerede AI-arbejdsgange, der problemfrit kan tilgå flere værktøjer og datakilder uden den traditionelle kompleksitet med manuel API-konfiguration. Denne integration repræsenterer et markant fremskridt i, hvordan organisationer kan automatisere deres forretningsprocesser ved hjælp af AI-agenter.

Inden for FlowHunt kan brugere nemt tilføje MCP-servere til deres arbejdsgange og få øjeblikkelig adgang til alle de værktøjer og funktioner, som disse servere tilbyder. For eksempel, ved at tilføje en WordPress MCP-server til et FlowHunt-flow, får brugerne straks mulighed for at oprette indlæg, administrere sider, håndtere medier, styre brugere og udføre dusinvis af andre WordPress-operationer—alt sammen uden manuelt at konfigurere hvert enkelt API-endpoint. Dette accelererer udviklingen af arbejdsgange markant og reducerer de tekniske barrierer for at opbygge kraftfuld AI-automatisering. FlowHunts tilgang til MCP-integration demonstrerer, hvordan protokollen muliggør en ny generation af AI-automatiseringsplatforme, der prioriterer brugervenlighed og hurtig udvikling uden at gå på kompromis med styrke eller fleksibilitet.

Platformens understøttelse af MCP-servere rækker ud over simpel adgang til værktøjer. FlowHunt gør det muligt for brugere at kæde flere MCP-servere sammen i komplekse arbejdsgange, så AI-agenter kan orkestrere handlinger på tværs af flere systemer som svar på brugerforespørgsler eller automatiske triggere. Denne kapabilitet forvandler mulighederne inden for AI-automatisering og gør det muligt for scenarier som automatisk oprettelse af WordPress-indlæg baseret på AI-genereret indhold, opdatering af Notion-databaser med information indsamlet fra flere kilder eller synkronisering af data på tværs af flere platforme i realtid. Ved at abstrahere kompleksiteten ved MCP-serverintegration væk, giver FlowHunt brugerne mulighed for at fokusere på at designe intelligente arbejdsgange i stedet for at kæmpe med tekniske integrationsdetaljer.

De teoretiske fordele ved MCP-servere omsættes til konkrete, målbare gevinster i virkelige situationer. Organisationer, der implementerer MCP-baserede arkitekturer, rapporterer om markante reduktioner i udviklingstid, hvor nogle teams oplever 50-70% hurtigere integrationsforløb sammenlignet med traditionelle metoder med brugerdefineret API-integration. Denne acceleration skyldes elimineringen af overflødigt udviklingsarbejde og den standardiserede karakter af MCP-implementeringer. Når en udvikler skal tilføje et nyt værktøj til et AI-flow, starter de ikke forfra med brugerdefineret kode; i stedet udnytter de en eksisterende MCP-server, der allerede er bygget, testet og dokumenteret af værktøjets skabere eller fællesskabet.

Vedligeholdelsesbyrden er et andet område, hvor MCP giver betydelige fordele. I traditionelle arkitekturer, når en API ændrer sig eller der udkommer en ny version, skal udviklere opdatere brugerdefineret integrationskode på tværs af potentielt mange applikationer og AI-modeller. Med MCP falder vedligeholdelsesbyrden primært på MCP-serverens vedligeholdere, som opdaterer serveren én gang for at afspejle API-ændringer. Alle applikationer, der bruger den MCP-server, får automatisk fordel af opdateringerne uden at skulle ændre deres egen kode. Denne centraliserede vedligeholdelsesmodel reducerer løbende den operationelle byrde ved at administrere AI-integrationer og giver udviklingsteams mulighed for at fokusere på at bygge nye funktioner i stedet for at vedligeholde eksisterende integrationer.

Fra slutbrugerens perspektiv muliggør MCP-servere mere kompetente og responsive AI-applikationer. Brugere kan bede deres AI-agenter om at udføre komplekse opgaver, der spænder over flere systemer—“Opret et nyt blogindlæg i WordPress baseret på dette Notion-dokument og del det på sociale medier”—og agenten kan udføre disse opgaver problemfrit, fordi alle nødvendige værktøjer er tilgængelige gennem standardiserede MCP-interfaces. Denne evne skaber en mere naturlig og kraftfuld brugeroplevelse, hvor AI-agenter opfører sig som ægte assistenter, der forstår og kan interagere med hele brugerens teknologiske økosystem, snarere end isolerede værktøjer, der kun virker inden for snævre domæner.

For udviklere, der er interesserede i at skabe deres egne MCP-servere, giver protokollen en klar, veldokumenteret ramme for at eksponere værktøjer og ressourcer. At bygge en MCP-server indebærer at definere de værktøjer, du vil eksponere, specificere deres parametre og returværdier og implementere den faktiske logik, der udføres, når værktøjerne kaldes. MCP-specifikationen giver detaljeret vejledning i, hvordan denne kode skal struktureres, og hvordan kommunikationen med MCP-klienter skal håndteres. Denne standardisering betyder, at udviklere ikke behøver at opfinde nye mønstre for hver server, de bygger; i stedet kan de følge etablerede best practices og fokusere på at implementere den specifikke funktionalitet, deres server skal levere.

Udrulningsmodellen for MCP-servere er fleksibel og understøtter forskellige arkitekturer. Servere kan køre som selvstændige processer på en udviklers maskine, implementeres i skyen eller indlejres i større applikationer. Denne fleksibilitet gør det muligt for organisationer at vælge implementeringsstrategier, der passer til deres eksisterende infrastruktur og sikkerhedskrav. Nogle organisationer kører måske MCP-servere lokalt til udvikling og test og udruller dem derefter til cloud-platforme til produktion. Andre integrerer MCP-servere direkte i deres applikationer for at levere lokal værktøjsadgang uden at kræve eksterne netværkskald. Denne arkitektoniske fleksibilitet er en af grundene til, at MCP har vundet så hurtig udbredelse blandt udviklere.

Sikkerhedsovervejelser er afgørende ved opbygning og udrulning af MCP-servere, især når disse servere giver adgang til følsomme systemer eller data. MCP-specifikationen indeholder retningslinjer for autentificering, autorisation og sikker kommunikation mellem klienter og servere. Udviklere, der bygger MCP-servere, skal nøje overveje, hvem der skal have adgang til hvilke værktøjer og implementere passende adgangskontrol. For eksempel kan en WordPress MCP-server begrænse visse handlinger som sletning af indlæg eller ændring af brugerrettigheder til autentificerede brugere med passende roller. På samme måde kan en database MCP-server begrænse forespørgselsfunktioner for at forhindre uautoriseret adgang til data. Disse sikkerhedsovervejelser er ikke unikke for MCP, men den standardiserede karakter af protokollen gør det lettere at implementere sikkerheds-best-practices på tværs af forskellige servere.

MCP-økosystemet er vokset hurtigt siden protokollens introduktion, og udviklere og organisationer har skabt MCP-servere til et imponerende udvalg af værktøjer og platforme. Det officielle MCP-register viser servere for populære platforme som WordPress, Notion, Google Kalender, GitHub, Slack og mange andre. Dette voksende økosystem betyder, at organisationer ofte kan finde færdigbyggede MCP-servere til de værktøjer, de allerede bruger, og dermed undgå at skulle bygge brugerdefinerede integrationer fra bunden. For værktøjer, hvor MCP-servere endnu ikke findes, gør protokollens standardiserede karakter det enkelt for udviklere at skabe dem.

Mangfoldigheden af tilgængelige MCP-servere demonstrerer protokollens alsidighed. Nogle servere giver simpel, skrivebeskyttet adgang til data—for eksempel en server, der lader AI-agenter søge og hente information fra en vidensbase. Andre tilbyder fuld CRUD (Create, Read, Update, Delete)-funktionalitet og gør det muligt for AI-agenter at foretage væsentlige ændringer i eksterne systemer. Andre igen eksponerer specialiserede funktioner som billedgenerering, dataanalyse eller kodeeksekvering. Denne diversitet afspejler realiteten, at forskellige organisationer har forskellige behov, og MCP’s fleksible arkitektur tilgodeser denne variation, samtidig med at den opretholder et konsistent interface.

Fællesskabsbidrag har spillet en afgørende rolle i udbygningen af MCP-økosystemet. Udviklere har bygget servere til nicheværktøjer og platforme, idet de har erkendt, at selv hvis et værktøj ikke er udbredt, gør eksistensen af en MCP-server det meget lettere for organisationer, der bruger værktøjet, at integrere det med AI-applikationer. Denne fællesskabsdrevne tilgang har skabt en positiv spiral, hvor tilgængeligheden af MCP-servere motiverer flere organisationer til at tage MCP-baserede arkitekturer i brug, hvilket igen ansporer flere udviklere til at skabe yderligere servere. Resultatet er et hurtigt ekspanderende økosystem, der gør MCP stadig mere værdifuld, efterhånden som flere værktøjer og platforme får MCP-understøttelse.

Efterhånden som organisationer bliver mere avancerede i deres brug af AI, muliggør MCP-servere stadig mere komplekse og kraftfulde arbejdsgange. Et overbevisende anvendelsestilfælde involverer orkestrering på tværs af systemer, hvor AI-agenter koordinerer handlinger på tværs af flere platforme som svar på brugerforespørgsler eller automatiske triggere. For eksempel kan et marketingteam bruge en AI-agent, der overvåger sociale medier, opretter blogindlæg i WordPress baseret på trends, opdaterer en Notion-database med indholdskalendere og planlægger opslag på flere platforme—alt sammen koordineret via én AI-agent, der tilgår flere MCP-servere.

Et andet avanceret anvendelsestilfælde er dataaggregering og -analyse. Organisationer kan oprette MCP-servere, der eksponerer data fra flere interne systemer, hvilket gør det muligt for AI-agenter at indsamle information fra forskellige kilder, analysere det og generere indsigter. For eksempel kan et finansielt firma oprette MCP-servere, der eksponerer data fra deres regnskabssystem, CRM og markedsdataleverandører, så en AI-agent kan analysere kundelønsomhed, markedstendenser og økonomisk performance på integreret vis. Denne kapabilitet forvandler AI fra et værktøj, der arbejder med isolerede data, til en ægte business intelligence-platform, der kan syntetisere information på tværs af hele organisationen.

Personalisering og kontekstbevidsthed repræsenterer et andet område for MCP-baserede applikationer. Ved at eksponere brugerdata, præferencer og historik gennem MCP-servere kan applikationer give AI-agenter rigt kontekst om individuelle brugere. Dette gør det muligt for AI-agenter at levere stærkt personaliserede oplevelser, huske brugerpræferencer, forstå deres mål og tilpasse svarene derefter. For eksempel kan en kundeservice-AI-agent tilgå MCP-servere, der eksponerer kundens købs- og supportsager samt præferencer, så den kan yde personlig assistance baseret på kundens unikke situation og historik.

For fuldt ud at forstå værdien af MCP er det nyttigt at sammenligne det med traditionelle metoder til integration af AI-applikationer med eksterne systemer. I traditionelle arkitekturer konfigurerer udviklere manuelt hver enkelt API-integration, skriver brugerdefineret kode til autentificering, forespørgselsformatering, fejlhåndtering og svarparsing. Denne tilgang fungerer for simple integrationer, men bliver stadigt mere uhåndterlig, efterhånden som antallet af integrerede systemer vokser. Hver ny integration kræver, at udviklere lærer den specifikke API’s dokumentation, forstår dens særheder og begrænsninger og skriver brugerdefineret kode til dens krav.

Traditionel API-integration skaber også betydelige vedligeholdelsesudfordringer. Når en API ændrer sig, skal udviklere opdatere deres brugerdefinerede integrationskode. Når en ny version af en API udgives, skal de beslutte, om de vil opgradere og håndtere eventuelle brud. Når en organisation ønsker at tilføje en ny AI-model til deres stack, skal udviklerne genskabe alle API-integrationer for den nye model. Disse udfordringer akkumuleres over tid og skaber teknisk gæld, der bremser udviklingen og øger de operationelle omkostninger.

MCP adresserer disse udfordringer gennem standardisering og abstraktion. I stedet for at skrive brugerdefineret kode for hver API implementerer udviklere MCP-protokollen én gang for hvert værktøj eller datakilde. Denne standardisering betyder, at alle AI-applikationer automatisk får adgang til alle MCP-servere uden at kræve brugerdefineret integrationskode. Når en API ændrer sig, opdaterer MCP-serverens vedligeholdere serveren, og alle applikationer, der bruger den server, får automatisk fordel af opdateringen. Når en ny AI-model tilføjes, skal den kun implementere MCP-understøttelse én gang for at få adgang til alle eksisterende MCP-servere. Denne arkitektoniske tilgang ændrer fundamentalt økonomien i AI-integration og gør det dramatisk mere effektivt og skalerbart.

MCP-økosystemet udvikler sig hurtigt med løbende udvikling, der fokuserer på at udvide funktionaliteten, forbedre ydeevnen og imødekomme nye anvendelser. Et område med aktiv udvikling er forbedring af protokollens understøttelse af realtidsdatastreaming og hændelsesdrevne arkitekturer. Efterhånden som AI-applikationer bliver mere avancerede, bliver det stadig mere værdifuldt, at MCP-servere kan sende opdateringer til klienterne i realtid. Forestil dig en AI-agent, der får realtidsnotifikationer, når visse hændelser sker i eksterne systemer, så den kan reagere øjeblikkeligt i stedet for at vente på næste polling-cyklus. Denne funktionalitet vil åbne op for nye muligheder for reaktive, hændelsesdrevne AI-flows.

Et andet udviklingsområde er forbedret understøttelse af komplekse, flertrinsoperationer. Selvom nuværende MCP-implementeringer håndterer enkeltværktøjskald glimrende, er der voksende interesse for at gøre det muligt for MCP-servere at eksponere højere niveau-operationer, der involverer flere trin og kompleks logik. Dette ville gøre det muligt for AI-agenter at anmode om komplekse operationer som “migrér denne WordPress-side til en ny hostingudbyder” eller “konsolider disse tre databaser i et samlet datalager”, hvor MCP-serveren håndterer al den underliggende kompleksitet. Denne udvikling vil yderligere abstrahere tekniske detaljer væk og gøre det muligt for AI-agenter at arbejde på et højere abstraktionsniveau.

Sikkerhed og governance er et andet vigtigt fokusområde for MCP-fællesskabet. Efterhånden som MCP-servere får adgang til stadig mere følsomme systemer og data, stiger behovet for robust sikkerhed, logning og governance. Fællesskabet arbejder aktivt på standarder for autentificering, autorisation, kryptering og audit-trails, som gør det muligt for organisationer at udrulle MCP-servere i enterprise-miljøer med tillid. Disse initiativer vil være afgørende for MCP’s udbredelse i stærkt regulerede brancher som finans, sundhed og det offentlige.

For organisationer, der overvejer MCP, bør flere praktiske overvejelser guide implementeringsstrategien. Start med at vurdere din nuværende teknologistak og identificer, hvilke værktøjer og systemer der vil have størst fordel af MCP-integration. Prioritér systemer, der ofte tilgås af flere applikationer, eller som kræver komplekse integrationer. Det er her, MCP vil give den mest umiddelbare værdi. Undersøg dernæst, om der allerede findes MCP-servere til dine prioriterede systemer. Hvis de gør, kan du tage dem i brug med det samme. Hvis ikke, vurder om det er realistisk at bygge egne MCP-servere med de udviklerressourcer og den ekspertise, du har til rådighed.

Overvej dernæst din implementeringsarkitektur og sikkerhedskrav. Beslut, om MCP-servere skal køre lokalt, i skyen eller indlejret i dine applikationer. Overvej, hvordan du vil håndtere autentificering og autorisation, især hvis MCP-servere skal tilgå følsomme systemer eller data. Planlæg også for gradvis indfasning i stedet for at forsøge at migrere hele din integrationsarkitektur til MCP på én gang. Start med et pilotprojekt, der bruger MCP-servere til et specifikt workflow eller brugsscenarie. Det giver dit team erfaring med protokollen, identificerer eventuelle udfordringer og giver mulighed for at justere tilgangen, inden I skalerer op.

Endelig bør du investere i træning og dokumentation for dit udviklingsteam. Selvom MCP er designet til at være udviklervenlig, vil dit team have gavn af at forstå protokollens arkitektur, best practices for opbygning af MCP-servere, og hvordan MCP-servere integreres i applikationer. Mange ressourcer er tilgængelige online, herunder officiel dokumentation, fællesskabsguides og eksempler. At opbygge denne viden vil accelerere jeres evne til effektivt at udnytte MCP i organisationen.

Model Context Protocol repræsenterer et grundlæggende skift i, hvordan AI-applikationer forbinder sig til eksterne systemer og datakilder. Ved at levere et standardiseret, universelt interface til AI-system-integration eliminerer MCP den eksponentielle kompleksitet ved traditionelle brugerdefinerede API-integrationer. Protokollen løser NxM-problemet, reducerer udviklingstid og vedligeholdelsesbyrde dramatisk og gør det muligt for organisationer at bygge mere kapable AI-applikationer, der problemfrit kan tilgå hele deres teknologiske økosystem. Efterhånden som MCP-økosystemet fortsætter med at vokse og modnes, med et stigende antal tilgængelige servere og løbende protokolforbedringer, er MCP på vej til at blive standarden for AI-integration på tværs af brancher. Organisationer, der tidligt tager MCP i brug, vil opnå væsentlige konkurrencefordele gennem evnen til hurtigt at udvikle og implementere sofistikerede AI-automatiseringsløsninger. Uanset om du bygger AI-applikationer, skaber værktøjer og platforme eller administrerer virksomhedens teknologiinfrastruktur, vil forståelse for og udnyttelse af MCP-servere blive stadig vigtigere for at forblive konkurrencedygtig i den AI-drevne fremtid.

Oplev hvordan FlowHunt automatiserer dine AI-indholds- og SEO-arbejdsgange — fra research og indholdsgenerering til udgivelse og analyse — alt samlet ét sted. Udnyt MCP-servere til at forbinde hele din teknologistak problemfrit.

MCP står for Model Context Protocol. Det er en open source-standard udviklet af Anthropic, der giver en standardiseret måde for AI-applikationer som Claude og ChatGPT at forbinde sig med eksterne systemer, datakilder og værktøjer.

NxM-problemet refererer til kompleksiteten ved at integrere N forskellige LLM'er med M forskellige værktøjer og datakilder. MCP løser dette ved at tilbyde en universel standard, som eliminerer behovet for brugerdefinerede integrationer mellem hver kombination af LLM og værktøj. I stedet for N×M integrationer behøver du kun N+M forbindelser.

MCP-servere reducerer udviklingstid og kompleksitet, giver adgang til et økosystem af datakilder og værktøjer, eliminerer overflødige integrationsopgaver, reducerer vedligeholdelsesbyrden og muliggør mere kapable AI-applikationer, der kan tilgå realtidsdata og udføre handlinger på vegne af brugerne.

Ja, MCP er designet til at være model-agnostisk. Det fungerer med forskellige AI-applikationer, herunder Claude, ChatGPT og andre LLM'er. Denne universelle kompatibilitet er en af de vigtigste fordele ved MCP-standarden.

MCP-servere kan integrere stort set ethvert eksternt system, herunder API'er, databaser, vidensbaser, filsystemer, webtjenester og specialiserede værktøjer. Almindelige eksempler inkluderer WordPress, Google Kalender, Notion, Figma, Blender og virksomhedsdatabaser.

Arshia er AI Workflow Engineer hos FlowHunt. Med en baggrund inden for datalogi og en passion for AI, specialiserer han sig i at skabe effektive workflows, der integrerer AI-værktøjer i daglige opgaver og øger produktivitet og kreativitet.

Integrér MCP-servere problemfrit i dine AI-automatiseringsflows. Forbind dine værktøjer, datakilder og API'er uden komplekse konfigurationer.

Lær hvordan du udvikler en Model Context Protocol (MCP) server, der sømløst integrerer med OpenAI's API og muliggør kraftfuld AI-drevet værktøjsudførelse og int...

Udforsk omfattende eksempler på MCP-servere og lær, hvordan du bygger, implementerer og integrerer Model Context Protocol-servere for at styrke AI-agenters kapa...

Lær at bygge og implementere en Model Context Protocol (MCP) server til at forbinde AI-modeller med eksterne værktøjer og datakilder. Trin-for-trin guide for bå...

Cookie Samtykke

Vi bruger cookies til at forbedre din browsingoplevelse og analysere vores trafik. See our privacy policy.