ModelContextProtocol (MCP) Server Integration

ModelContextProtocol (MCP) Server fungerer som et bindeled mellem AI-agenter og eksterne datakilder, API’er og tjenester, så FlowHunt-brugere kan bygge kontekst...

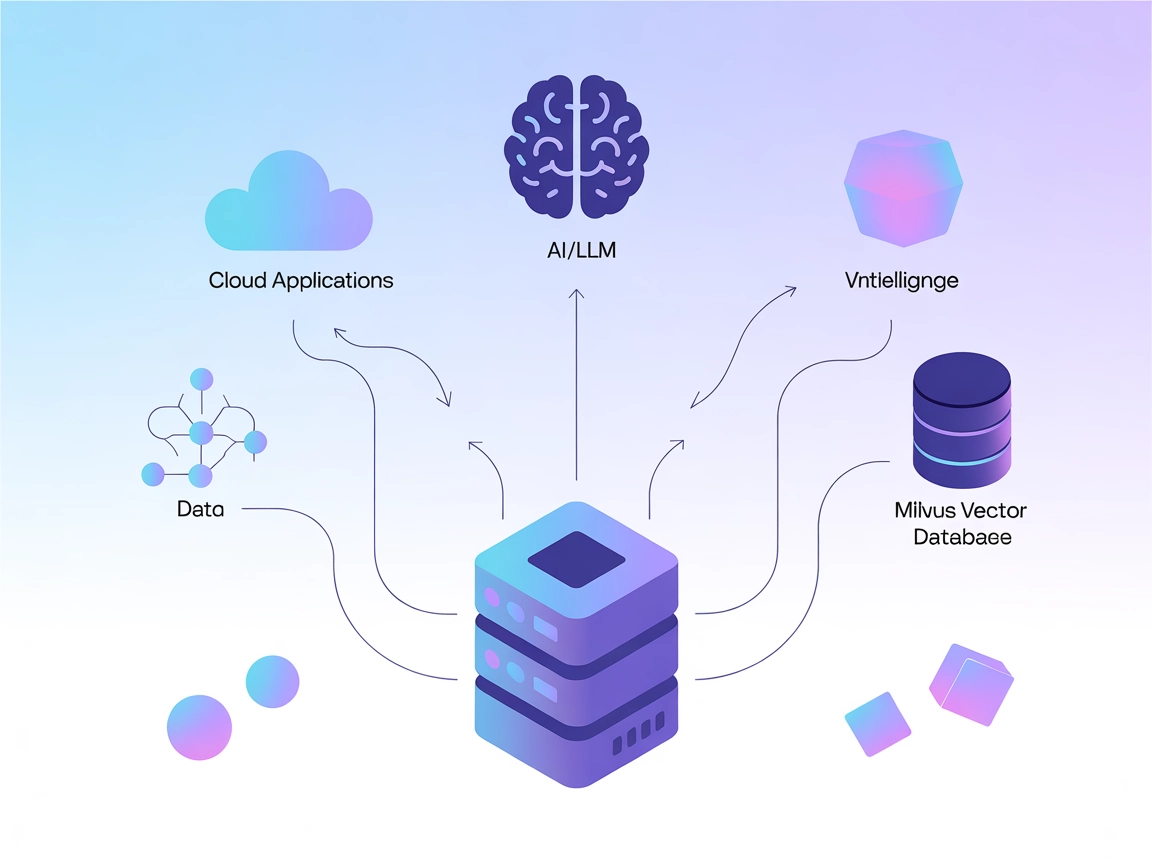

Forbind LLM’er og AI-agenter til Milvus for kraftfuld vektorsøgning, kontekstuel hukommelse og datadrevne anbefalinger direkte i dine FlowHunt-workflows.

FlowHunt giver et ekstra sikkerhedslag mellem dine interne systemer og AI-værktøjer, hvilket giver dig granulær kontrol over hvilke værktøjer der er tilgængelige fra dine MCP-servere. MCP-servere hostet i vores infrastruktur kan problemfrit integreres med FlowHunts chatbot samt populære AI-platforme som ChatGPT, Claude og forskellige AI-editorer.

Milvus MCP (Model Context Protocol) Server forbinder AI-assistenter og LLM-drevne applikationer med Milvus vektordatabase. Dette muliggør problemfri interaktion mellem sprogmodeller og store mængder vektordata og giver en standardiseret måde at tilgå, forespørge og håndtere Milvus fra AI-workflows. Ved at bruge Milvus MCP Server kan udviklere integrere Milvus-baseret søgning, datahentning og -håndtering direkte i deres AI-agenter, IDE’er eller chatgrænseflader. Serveren understøtter flere kommunikationsformer (stdio og Server-Sent Events), så den kan tilpasses forskellige implementeringsscenarier og udviklingsmiljøer. Ved at bygge bro mellem LLM’er og Milvus forbedres AI-systemers evne til at udføre kontekstbevidste operationer på høj-dimensionelle data betydeligt, hvilket åbner for rigere og mere intelligente LLM-drevne oplevelser.

Ingen information om prompt-skabeloner er angivet i depotet.

Ingen eksplicit liste over Model Context Protocol “ressourcer” er beskrevet i den tilgængelige dokumentation eller kode.

Der er ikke dokumenteret nogen eksplicit værktøjsliste eller funktionsnavne i den tilgængelige dokumentation eller kodefiler, inklusive server.py.

git clone https://github.com/zilliztech/mcp-server-milvus.gituv run src/mcp_server_milvus/server.py --milvus-uri http://localhost:19530{

"mcpServers": {

"milvus-mcp": {

"command": "uv",

"args": ["run", "src/mcp_server_milvus/server.py", "--milvus-uri", "http://localhost:19530"]

}

}

}

Sikring af API-nøgler:

Hvis serveren kræver følsomme oplysninger, brug miljøvariabler:

{

"env": {

"MILVUS_URI": "http://localhost:19530"

},

"inputs": {}

}

{

"mcpServers": {

"milvus-mcp": {

"command": "uv",

"args": ["run", "src/mcp_server_milvus/server.py", "--milvus-uri", "http://localhost:19530"]

}

}

}

Sikre legitimationsoplysninger via miljøvariabler som ovenfor.

uv.uv run src/mcp_server_milvus/server.py --milvus-uri http://localhost:19530{

"mcpServers": {

"milvus-mcp": {

"command": "uv",

"args": ["run", "src/mcp_server_milvus/server.py", "--milvus-uri", "http://localhost:19530"]

}

}

}

Sikring af API-nøgler:

Brug miljøvariabler som vist ovenfor.

uv.{

"mcpServers": {

"milvus-mcp": {

"command": "uv",

"args": ["run", "src/mcp_server_milvus/server.py", "--milvus-uri", "http://localhost:19530"]

}

}

}

Miljøvariabler:

{

"env": {

"MILVUS_URI": "http://localhost:19530"

}

}

Brug af MCP i FlowHunt

For at integrere MCP-servere i dit FlowHunt-workflow skal du starte med at tilføje MCP-komponenten til dit flow og forbinde den til din AI-agent:

Klik på MCP-komponenten for at åbne konfigurationspanelet. I systemets MCP-konfigurationssektion indsættes dine MCP-serveroplysninger i dette JSON-format:

{

"milvus-mcp": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

Når det er konfigureret, kan AI-agenten nu bruge denne MCP som et værktøj med adgang til alle dens funktioner og kapaciteter. Husk at ændre “milvus-mcp” til det faktiske navn på din MCP-server og udskift URL’en med din egen MCP-server-URL.

| Sektion | Tilgængelighed | Detaljer/Noter |

|---|---|---|

| Oversigt | ✅ | |

| Liste over Prompts | ⛔ | Ingen prompt-skabeloner dokumenteret |

| Liste over Ressourcer | ⛔ | Ingen eksplicit MCP-ressourceliste |

| Liste over Værktøjer | ⛔ | Ingen eksplicitte værktøjer listet i tilgængelige filer |

| Sikring af API-nøgler | ✅ | Bruger miljøvariabler, dokumenteret i opsætningseksempler |

| Sampling-support (mindre vigtig i evaluering) | ⛔ | Ikke nævnt |

Roots-support: Ikke nævnt

Sampling-support: Ikke nævnt

Milvus MCP Server er en praktisk og fokuseret bro mellem LLM’er og Milvus, med tydelige opsætningsvejledninger til populære udviklerværktøjer. Dog mangler dokumentationen detaljer om MCP-ressourcer, prompts og handlingsorienterede værktøjs-API’er, hvilket begrænser mulighederne for at opdage alt fra starten. Alligevel er det et solidt fundament for vektorbaserede AI-integrationer.

| Har en LICENSE | ✅ (Apache-2.0) |

|---|---|

| Har mindst ét værktøj | ⛔ |

| Antal forks | 32 |

| Antal stjerner | 139 |

Samlet: 4/10

Serveren er nyttig inden for sit felt, men ville have stor fordel af mere eksplicit dokumentation om ressourcer, prompt-skabeloner og værktøjs-API’er for maksimal interoperabilitet og brugervenlighed.

Milvus MCP Server forbinder AI-assistenter og LLM-applikationer med Milvus vektordatabase, hvilket muliggør problemfri vektorsøgning, kontekstuel hukommelse og datahåndtering til avancerede AI-workflows.

Vigtige anvendelser inkluderer vektorsøgning, embedding-håndtering, kontekstuel chatbot-hukommelse, AI-drevne anbefalinger og realtidsdataanalyse med Milvus i FlowHunt.

Brug miljøvariabler (f.eks. MILVUS_URI) til at gemme følsomme forbindelsesoplysninger, som vist i opsætningsvejledningerne for hver understøttet klient.

Der er ikke dokumenteret eksplicitte prompt-skabeloner eller værktøjs-API'er. Serveren fokuserer på at tilbyde en bro til vektoroperationer og embedding-håndtering.

Det er et solidt fundament til at forbinde LLM'er med vektordatabaser med tydelige opsætningsinstruktioner, men ville have fordel af mere dokumentation om prompt- og værktøjs-API'er for lettere at finde og integrere mulighederne.

Forstærk dine AI-agenter med problemfri adgang til vektordatabaser, så du får smartere søgninger, anbefalinger og kontekstuel hukommelse. Integrér Milvus MCP Server med FlowHunt nu!

ModelContextProtocol (MCP) Server fungerer som et bindeled mellem AI-agenter og eksterne datakilder, API’er og tjenester, så FlowHunt-brugere kan bygge kontekst...

Couchbase MCP Server forbinder AI-agenter og LLM’er direkte til Couchbase-klynger, hvilket muliggør problemfri databaseoperationer med naturligt sprog, automati...

Patronus MCP Server forenkler evaluering og eksperimentering med LLM for udviklere og forskere og giver automatisering, batchbehandling og et robust setup til A...

Cookie Samtykke

Vi bruger cookies til at forbedre din browsingoplevelse og analysere vores trafik. See our privacy policy.