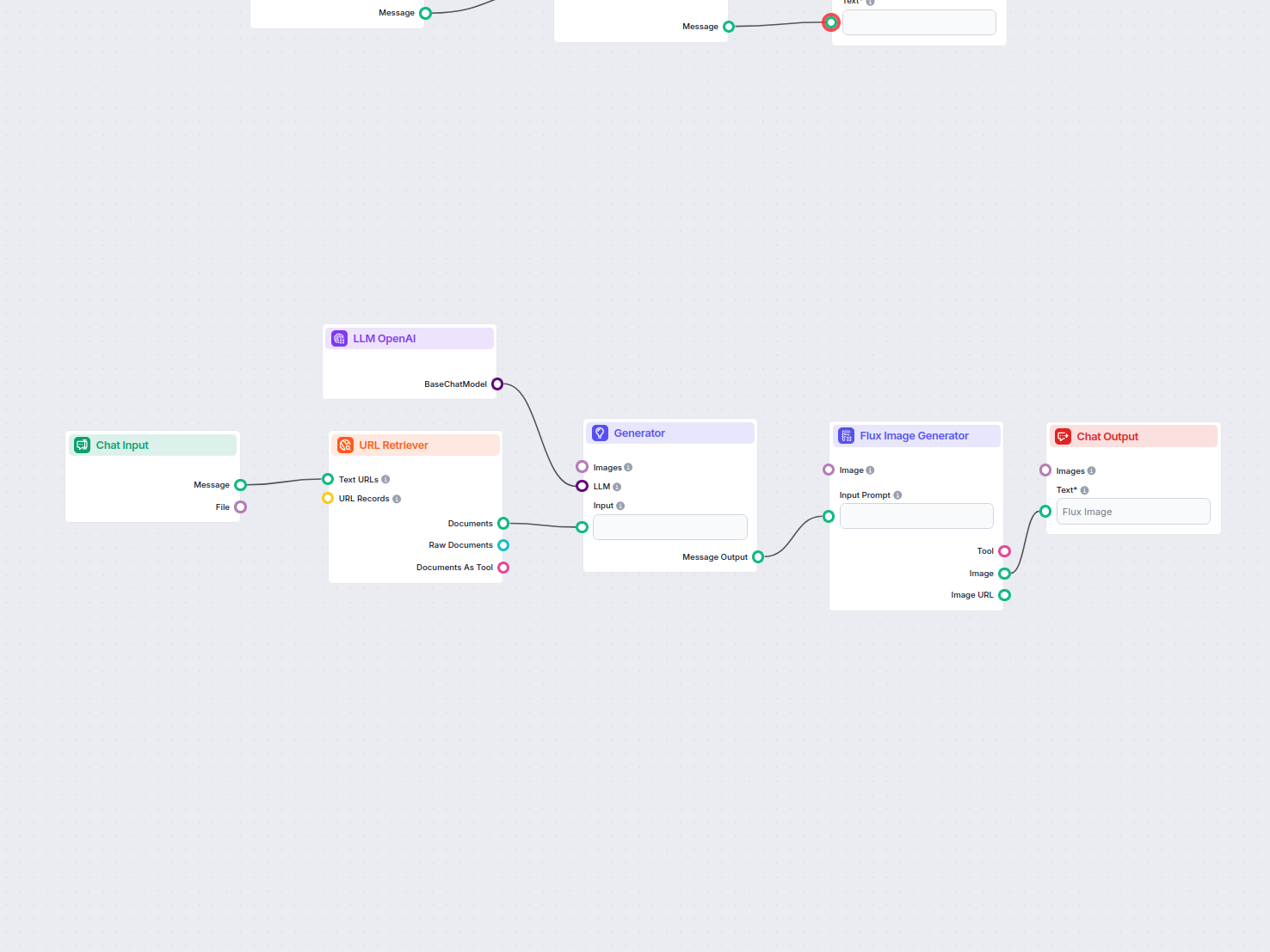

Blog-Feature-Bild aus URL

Erzeugt automatisch ein ansprechendes Feature-Bild für jeden Blogbeitrag, indem der Inhalt analysiert wird. Gib einfach die Blog-URL an, und der Workflow nutzt ...

Die LLM OpenAI-Komponente in FlowHunt verbindet ChatGPT-Modelle mit Ihren Flows und ermöglicht die Kontrolle über Modellauswahl und Ausgabeeinstellungen für vielseitige KI-Chatbot-Anwendungen.

Komponentenbeschreibung

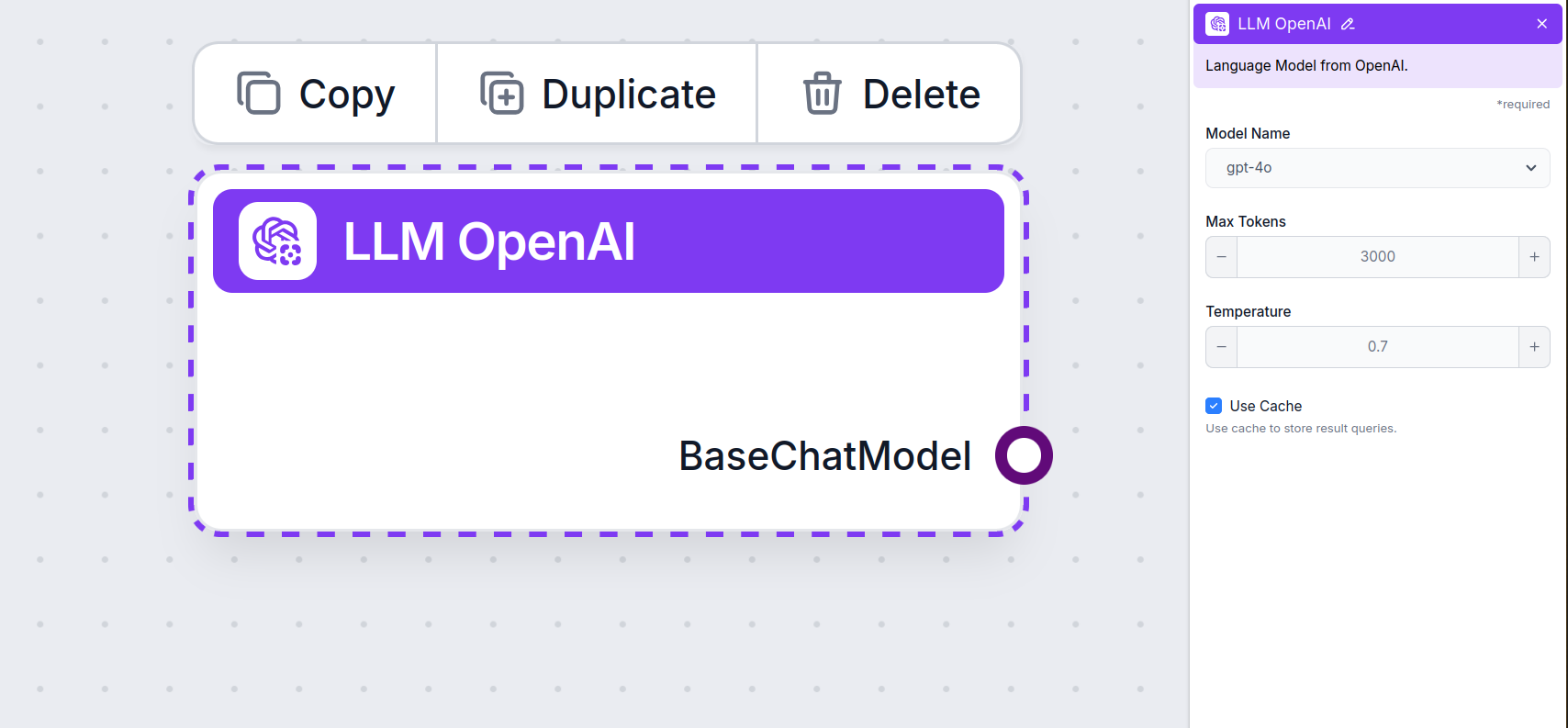

The LLM OpenAI component connects ChatGPT models to your flow. While the Generators and Agents are where the actual magic happens, LLM components allow you to control the model used. All components come with ChatGPT-4 by default. You can connect this component if you wish to change the model or gain more control over it.

This is the model picker. Here, you’ll find all OpenAI models FlowHunt supports. ChatGPT offers a full list of differently capable and differently priced models. For example, using the less advanced and older GPT-3.5 will cost less than using the newest 4o, but the quality and speed of the output will suffer.

OpenAI models available in FlowHunt:

When choosing the right model for the task, consider the quality and speed the task requires. Older models are great for saving money on simple bulk tasks and chatting. If you’re generating content or searching the web, we suggest you opt for a newer, more refined model.

Tokens represent the individual units of text the model processes and generates. Token usage varies with models, and a single token can be anything from words or subwords to a single character. Models are usually priced in millions of tokens.

The max tokens setting limits the total number of tokens that can be processed in a single interaction or request, ensuring the responses are generated within reasonable bounds. The default limit is 4,000 tokens, which is the optimal size for summarizing documents and several sources to generate an answer.

Temperature controls the variability of answers, ranging from 0 to 1.

A temperature of 0.1 will make the responses very to the point but potentially repetitive and deficient.

A high temperature of 1 allows for maximum creativity in answers but creates the risk of irrelevant or even hallucinatory responses.

For example, the recommended temperature for a customer service bot is between 0.2 and 0.5. This level should keep the answers relevant and to the script while allowing for a natural level of variation in responses.

You’ll notice that all LLM components only have an output handle. Input doesn’t pass through the component, as it only represents the model, while the actual generation happens in AI Agents and Generators.

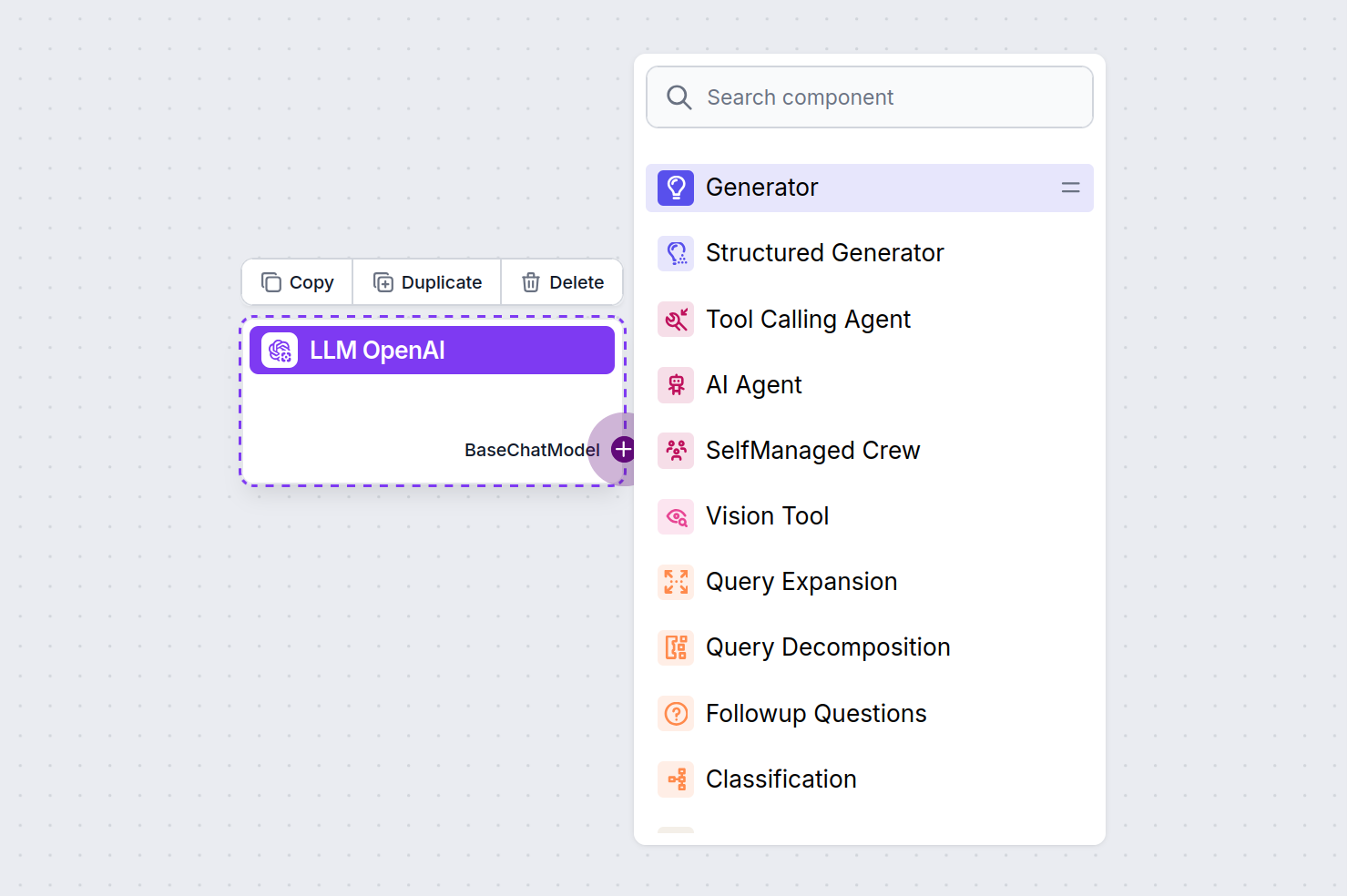

The LLM handle is always purple. The LLM input handle is found on any component that uses AI to generate text or process data. You can see the options by clicking the handle:

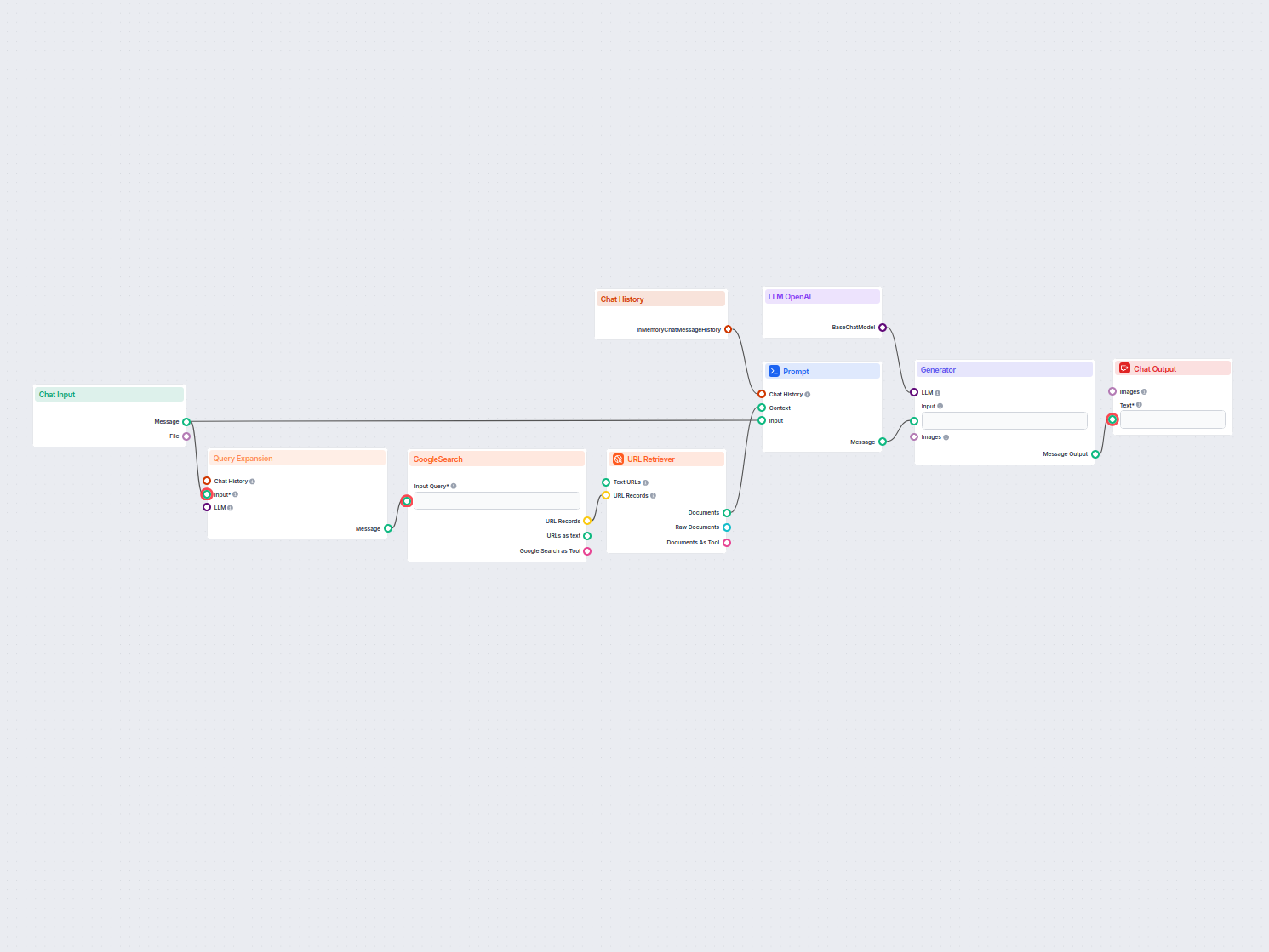

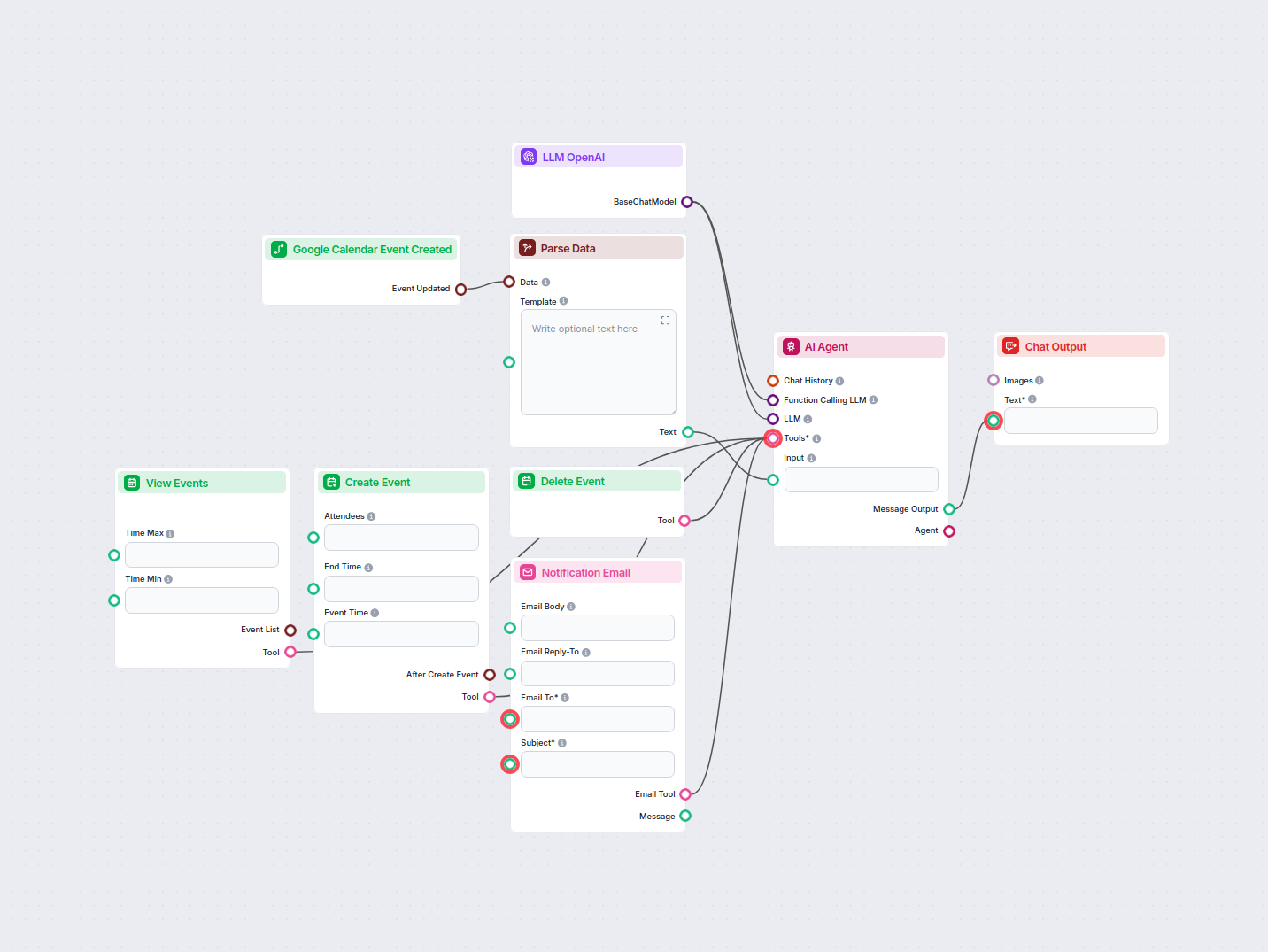

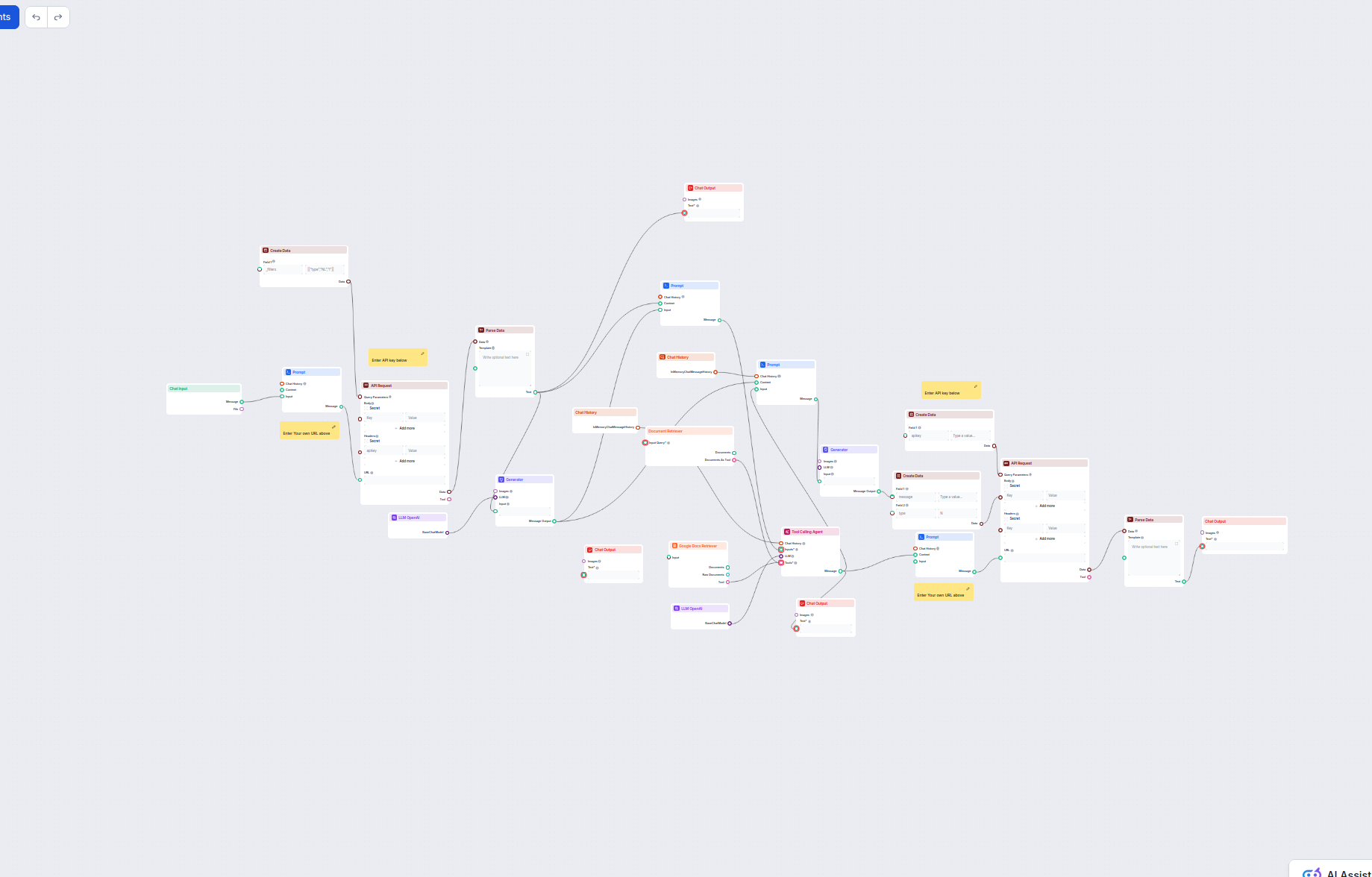

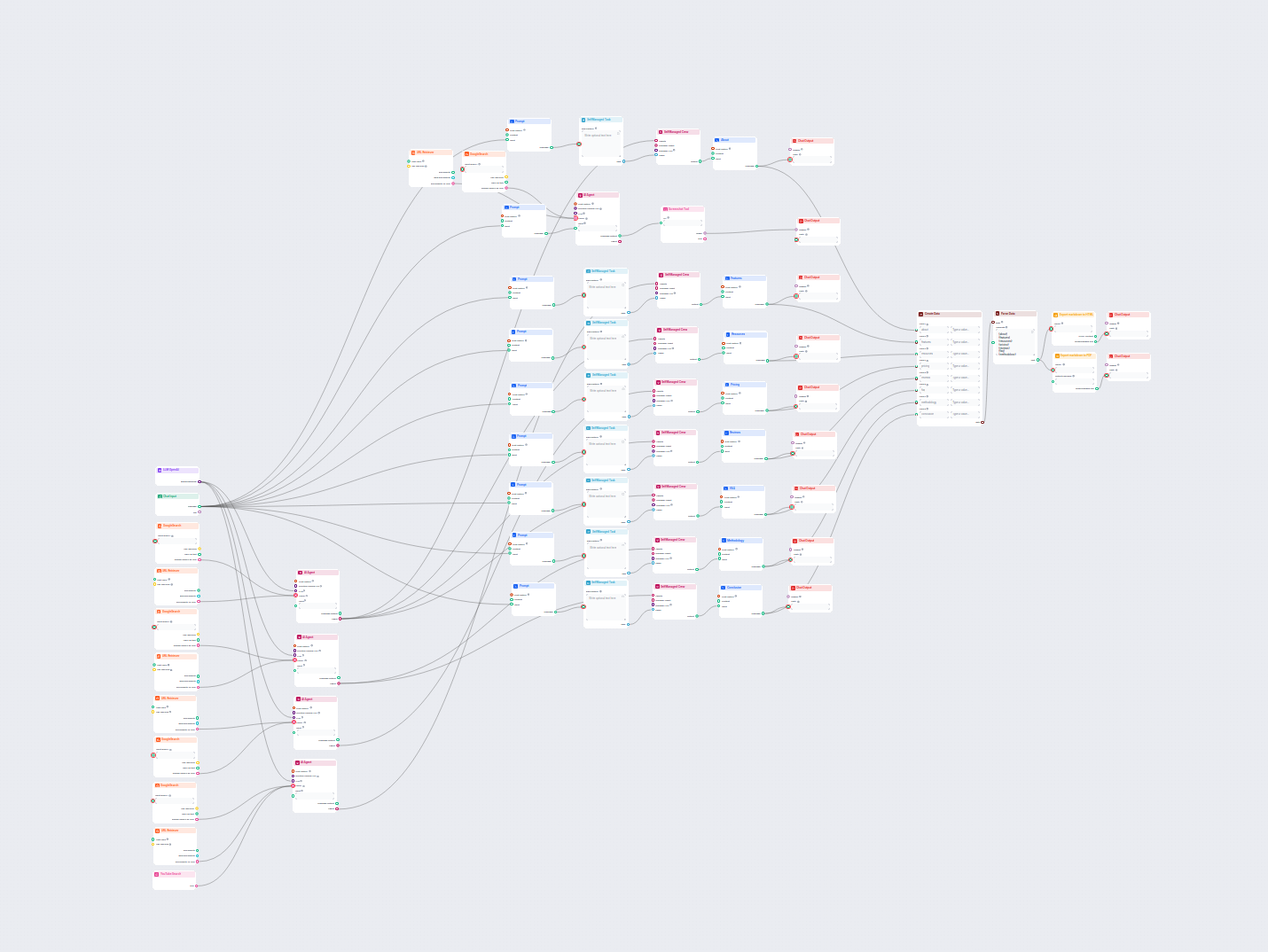

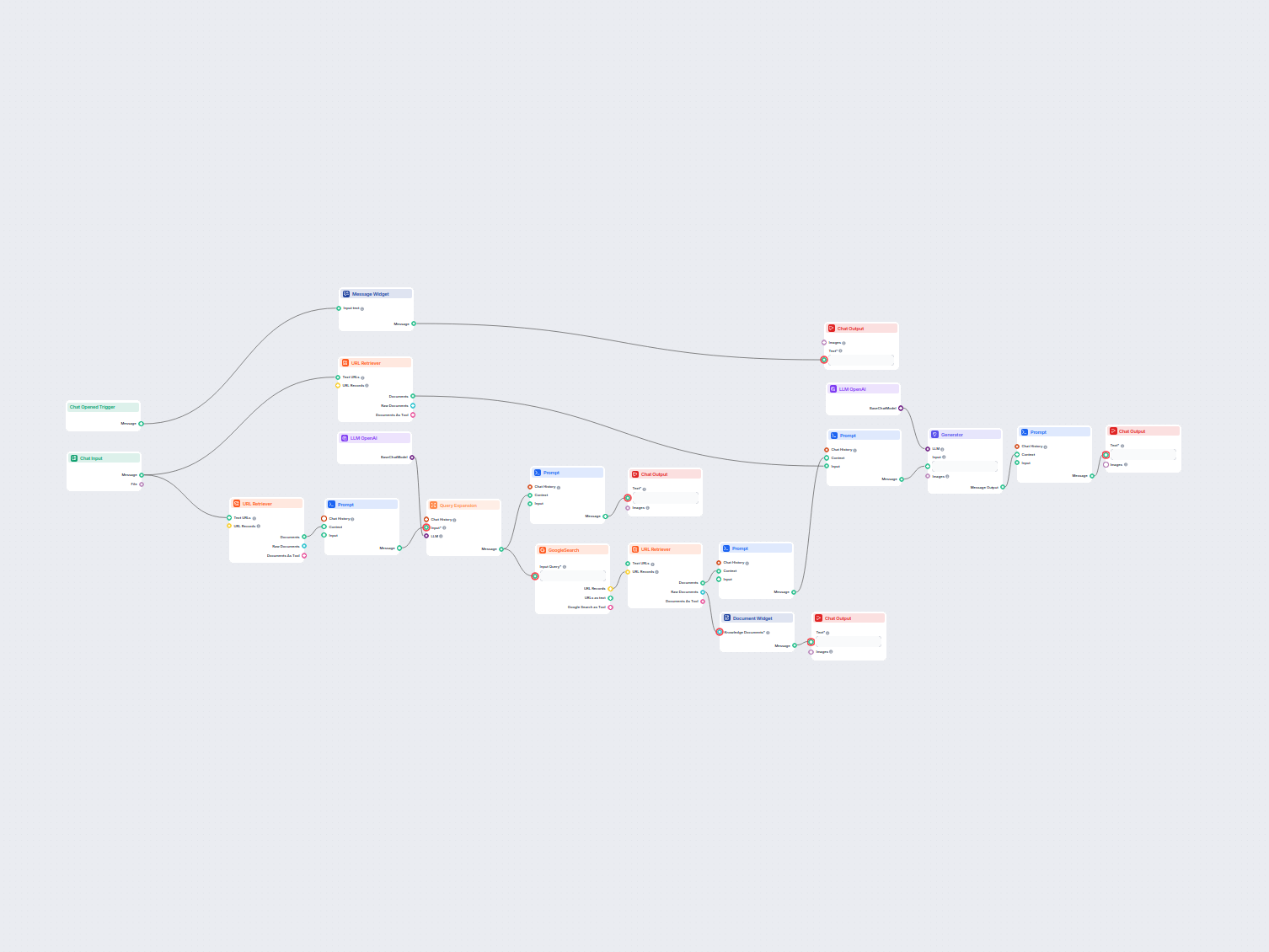

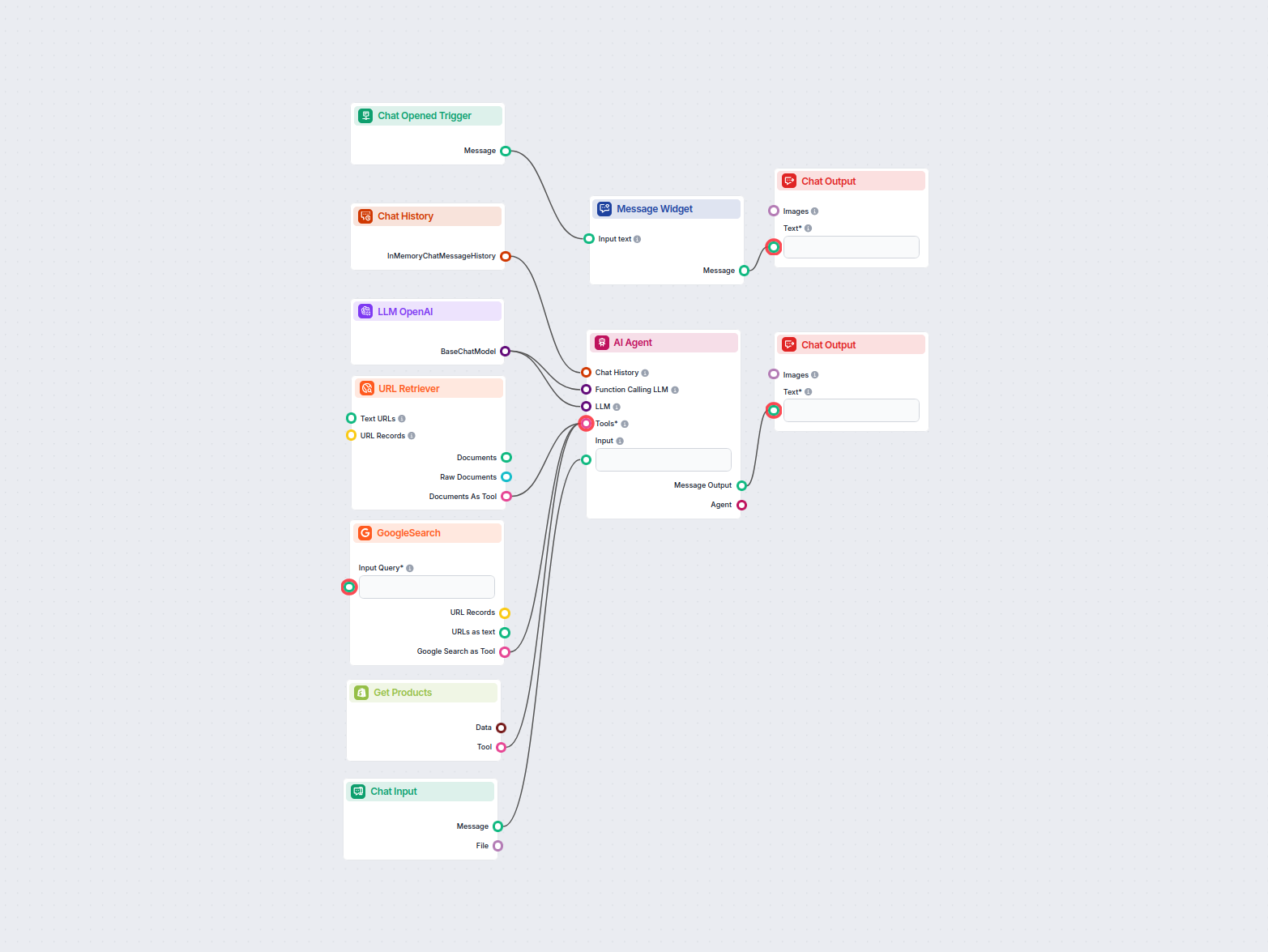

This allows you to create all sorts of tools. Let’s see the component in action. Here’s a simple Agent-powered chatbot Flow using o1 Preview to generate responses. You can think of it as a basic ChatGPT chatbot.

This simple Chatbot Flow includes:

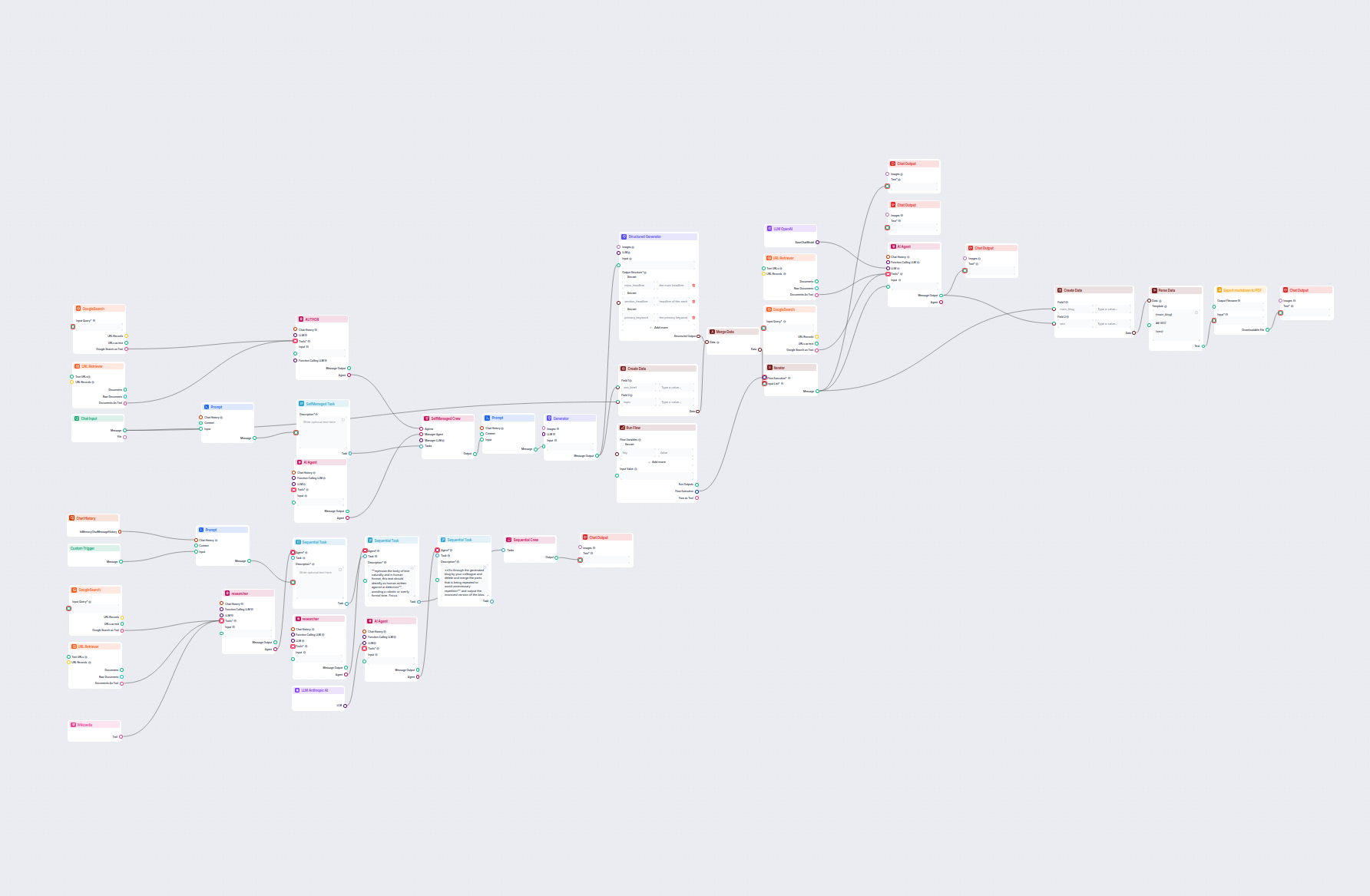

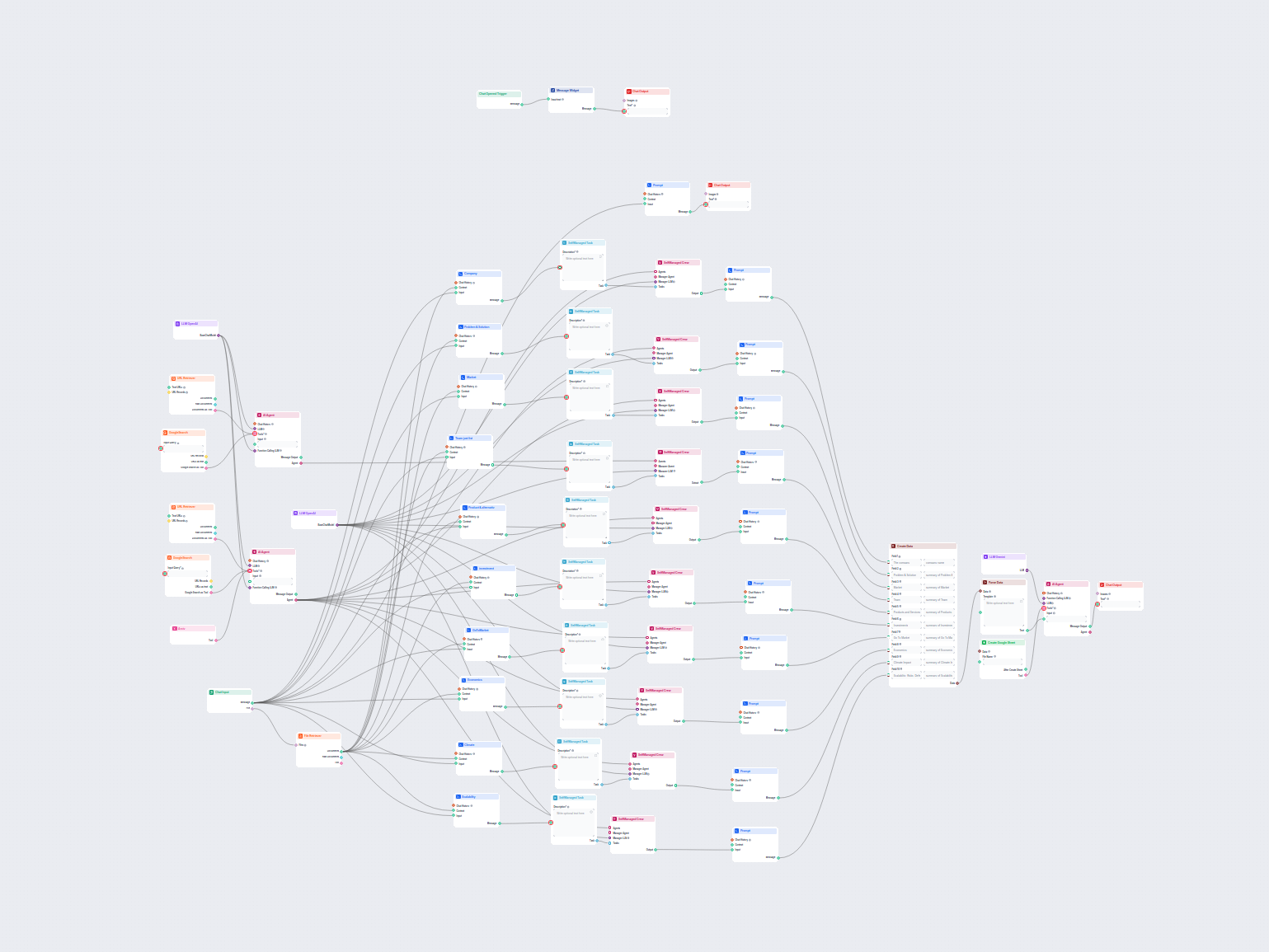

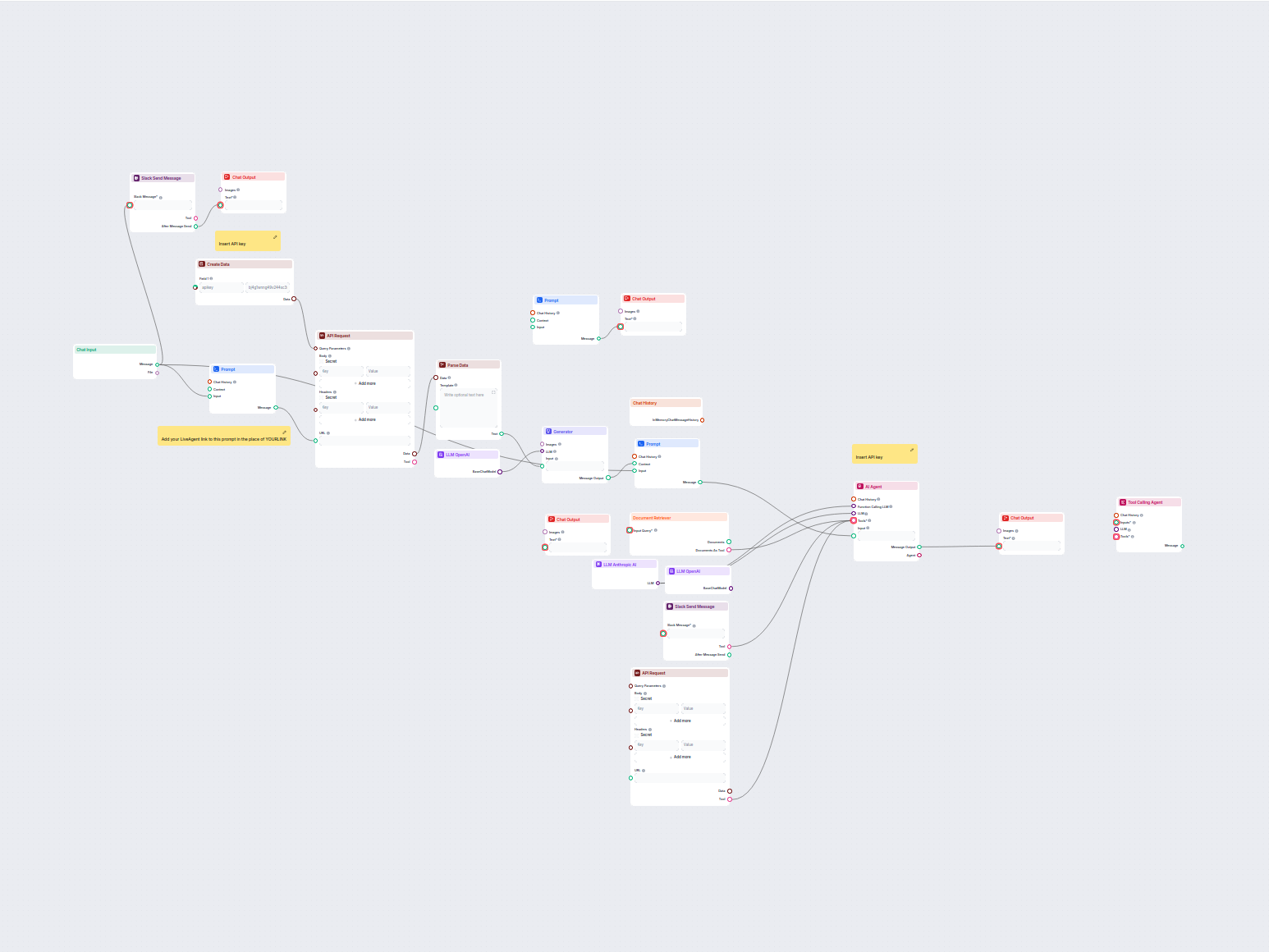

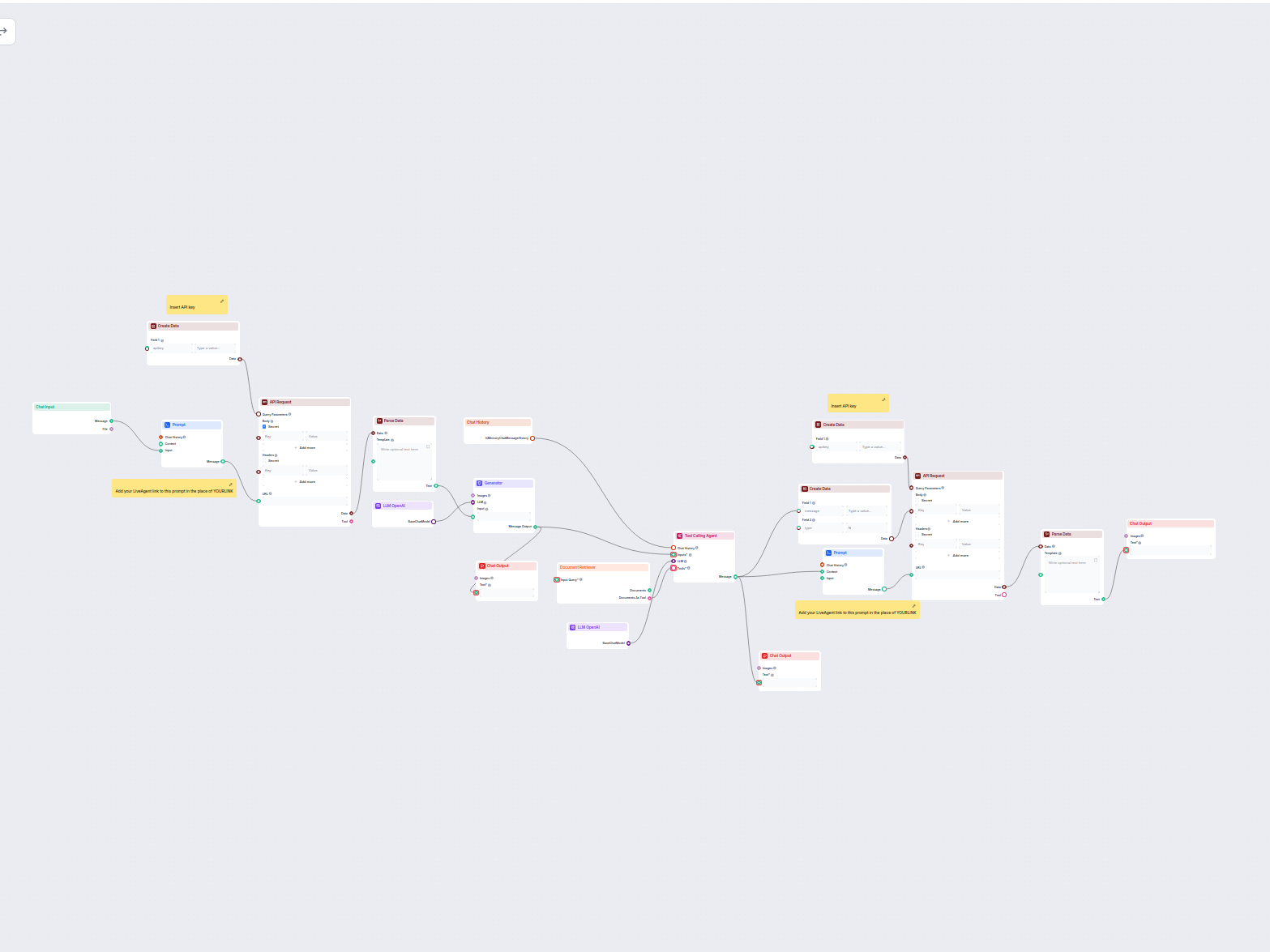

Um Ihnen den schnellen Einstieg zu erleichtern, haben wir mehrere Beispiel-Flow-Vorlagen vorbereitet, die zeigen, wie die LLM OpenAI-Komponente effektiv genutzt wird. Diese Vorlagen präsentieren verschiedene Anwendungsfälle und Best Practices und erleichtern Ihnen das Verständnis und die Implementierung der Komponente in Ihren eigenen Projekten.

Erzeugt automatisch ein ansprechendes Feature-Bild für jeden Blogbeitrag, indem der Inhalt analysiert wird. Gib einfach die Blog-URL an, und der Workflow nutzt ...

Ein Echtzeit-Chatbot, der Google Search auf Ihre eigene Domain beschränkt, relevante Webinhalte abruft und das OpenAI LLM nutzt, um Benutzeranfragen mit aktuell...

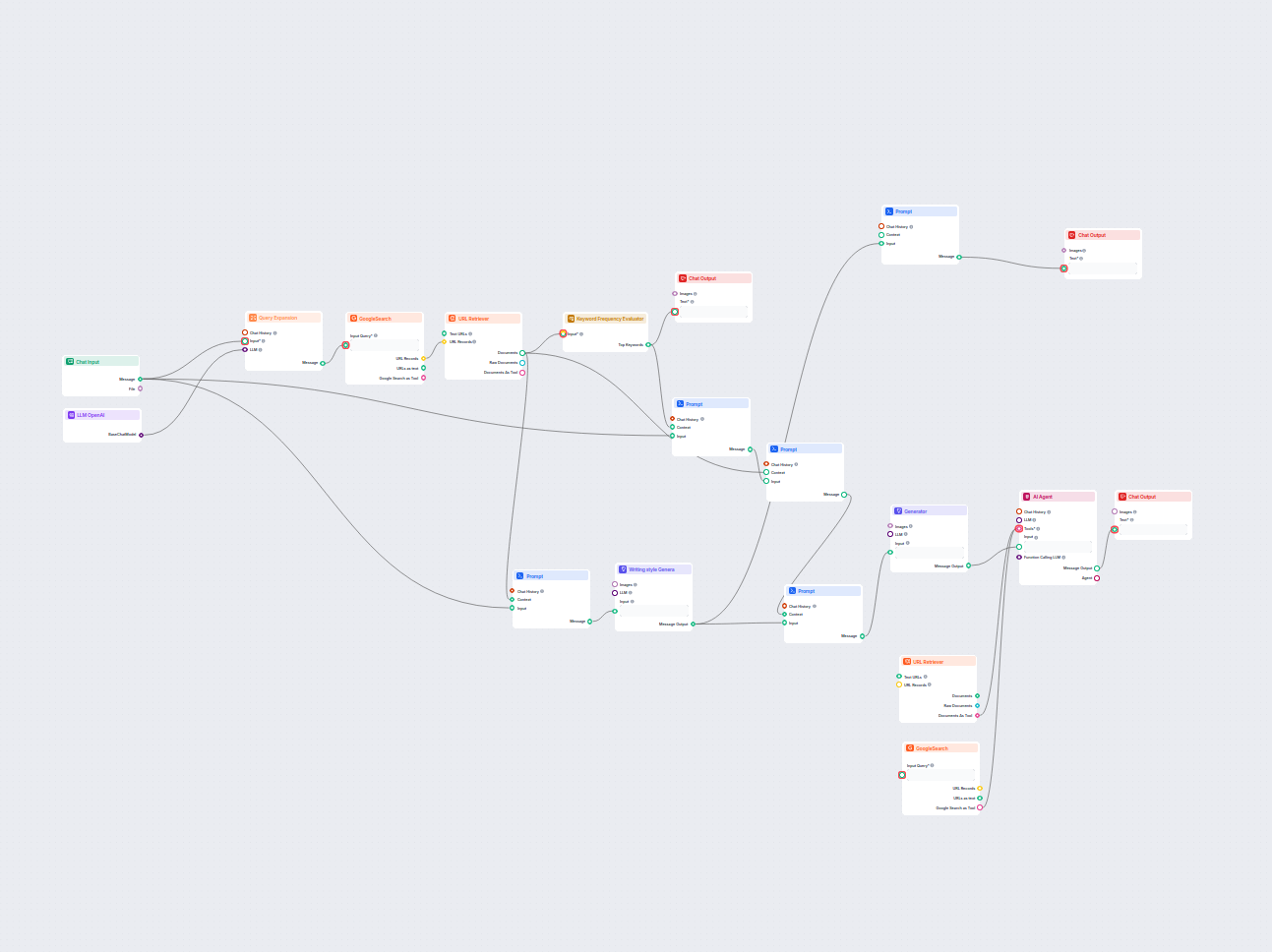

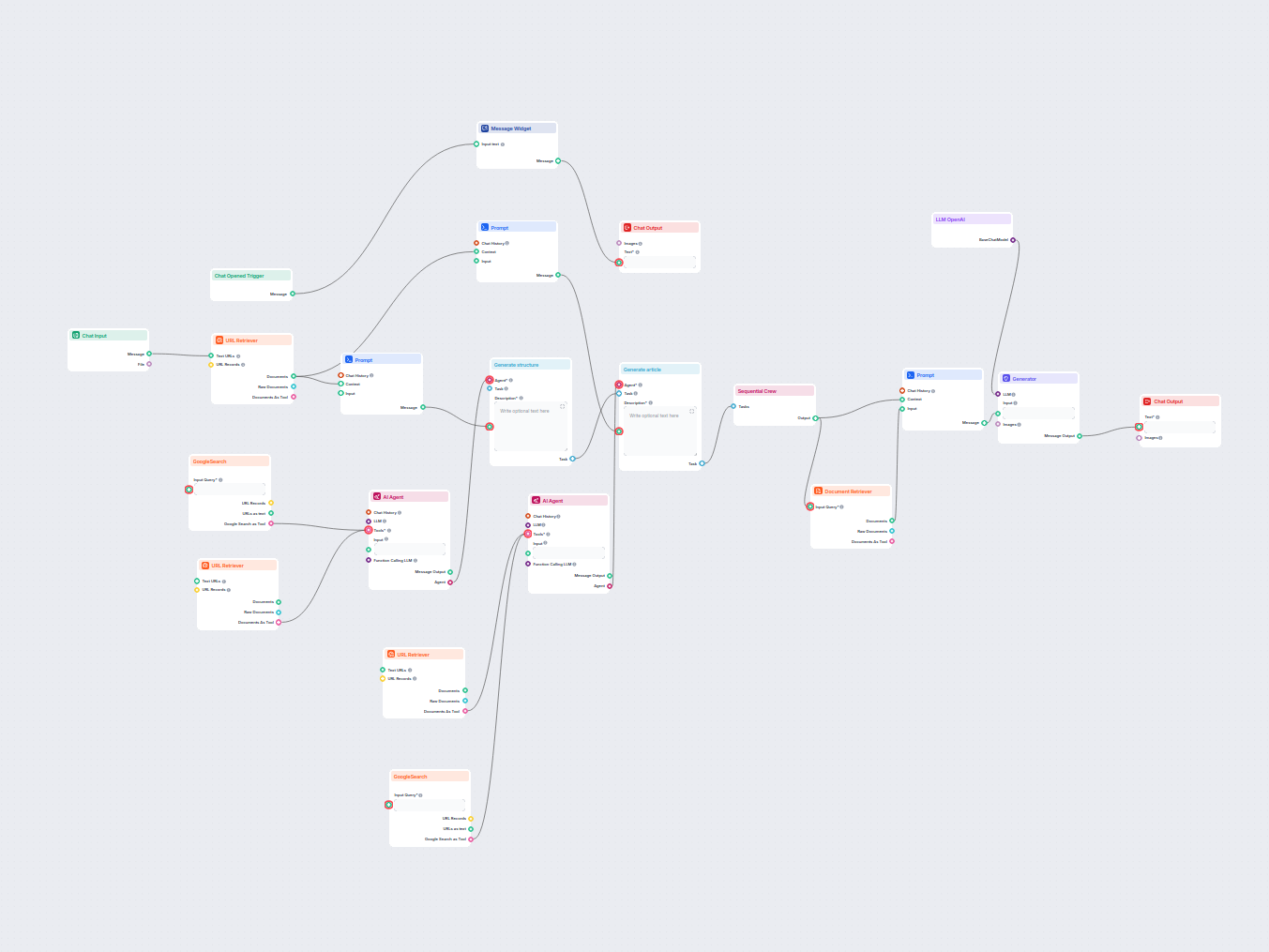

Erstellen Sie umfassende, SEO-optimierte Blogposts mit fortschrittlicher Struktur und hoher Wortanzahl mithilfe mehrerer KI-Agenten. Der Workflow umfasst automa...

Erstellen Sie umfassende, SEO-optimierte Glossarartikel mithilfe von KI und Echtzeit-Webrecherche. Dieser Flow analysiert die bestplatzierten Inhalte und Schrei...

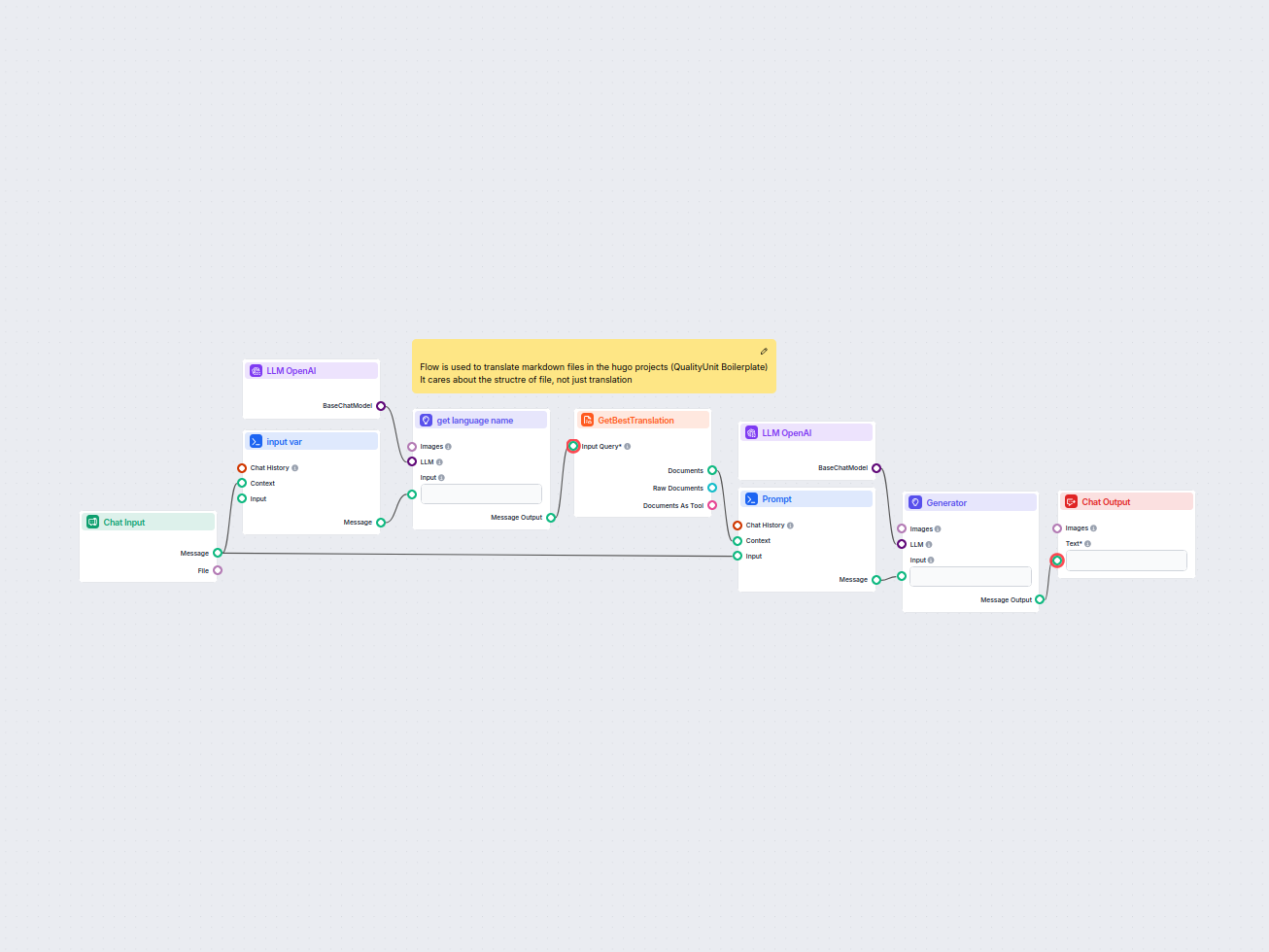

Dieser Workflow optimiert die Übersetzung von HUGO-Markdown-Dateien in Zielsprache, wobei die Dateistruktur und das Format erhalten bleiben. Durch den Einsatz v...

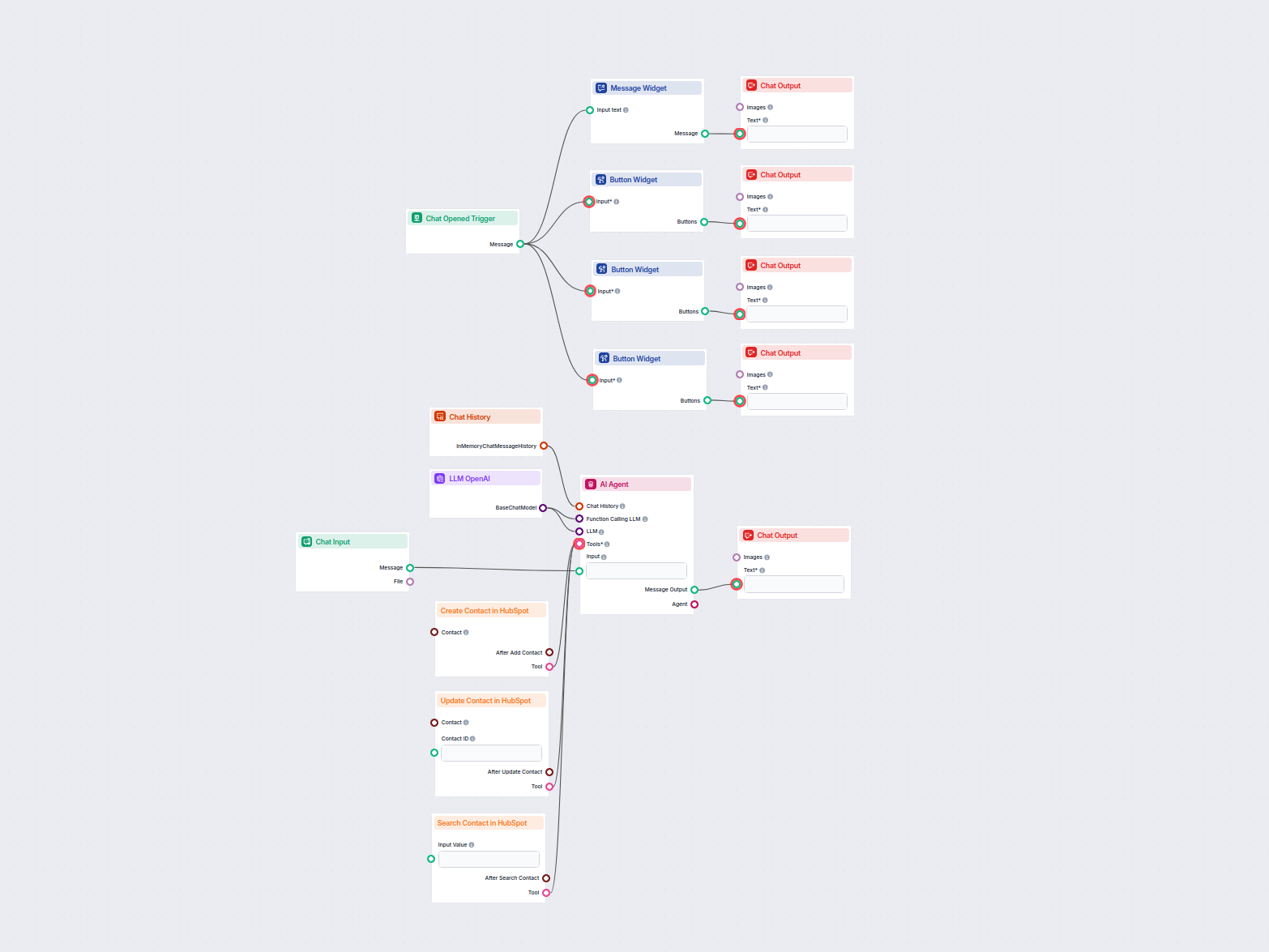

Dieser KI-gestützte Workflow automatisiert das Kontaktmanagement im HubSpot CRM. Nutzer können Kontakte ganz einfach suchen, anlegen oder aktualisieren – über e...

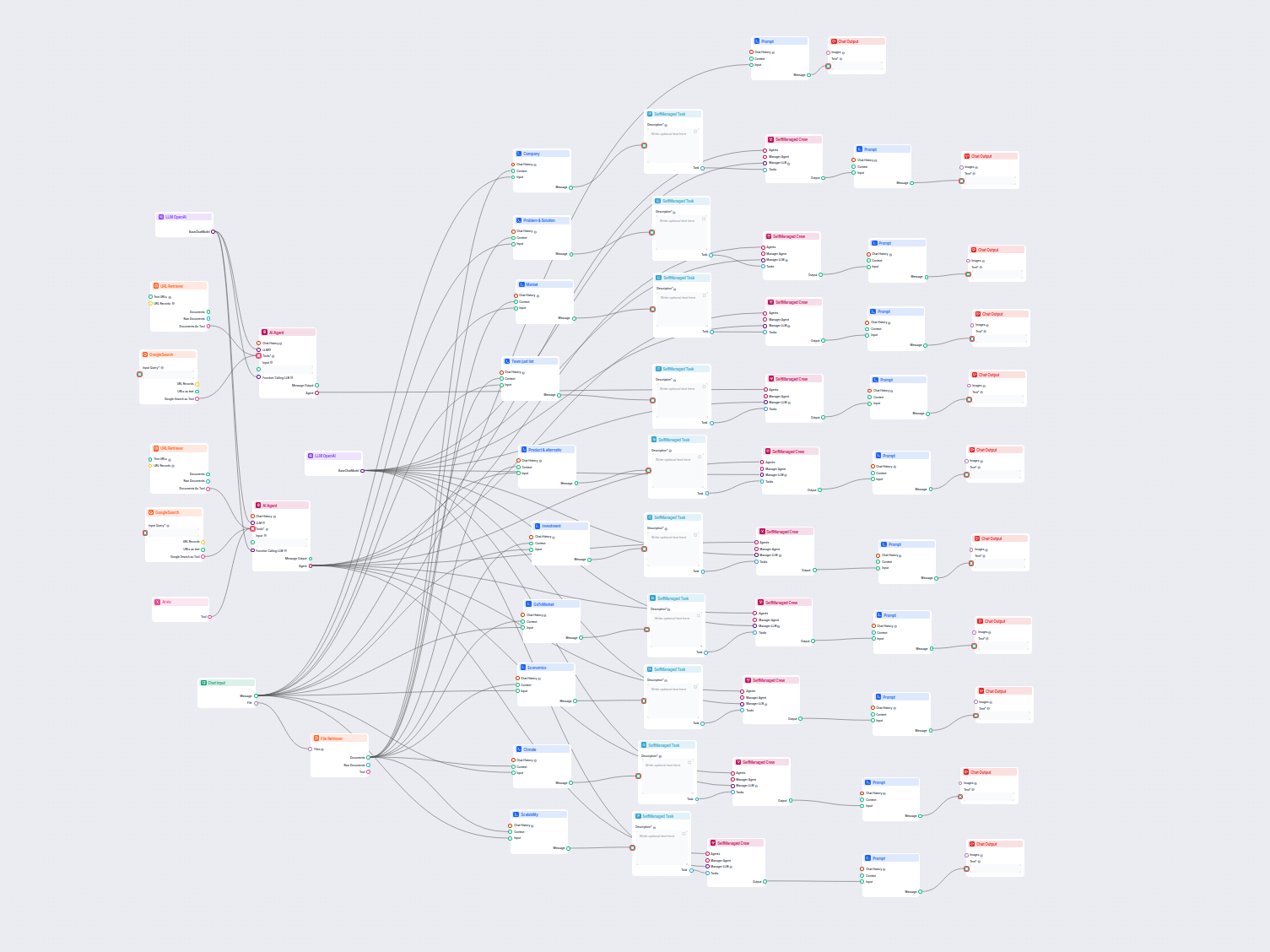

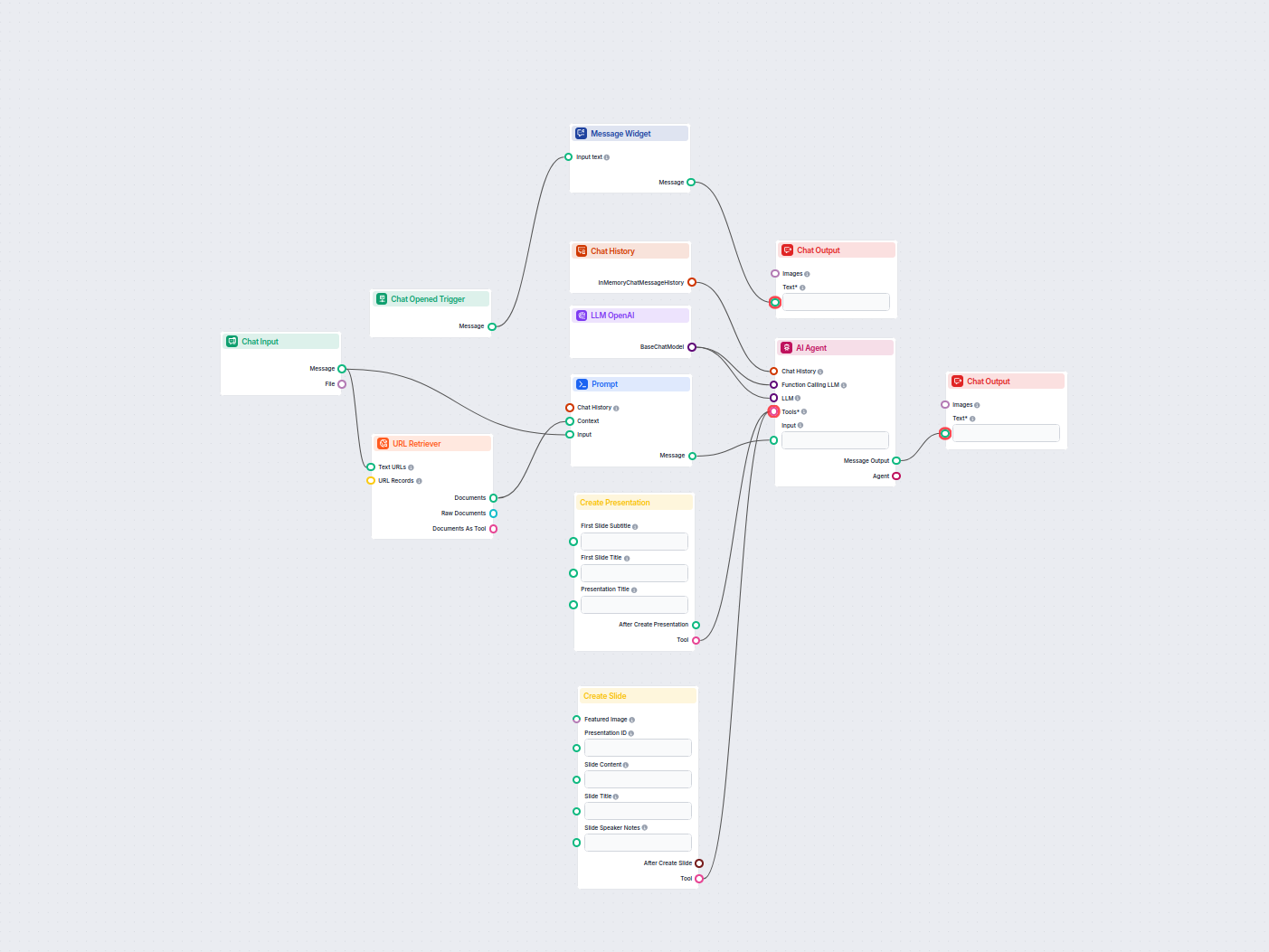

Erstellen Sie automatisch professionelle Pitch Decks in Google Slides mithilfe von KI und aktueller Webrecherche. Dieser Workflow sammelt Benutzereingaben, durc...

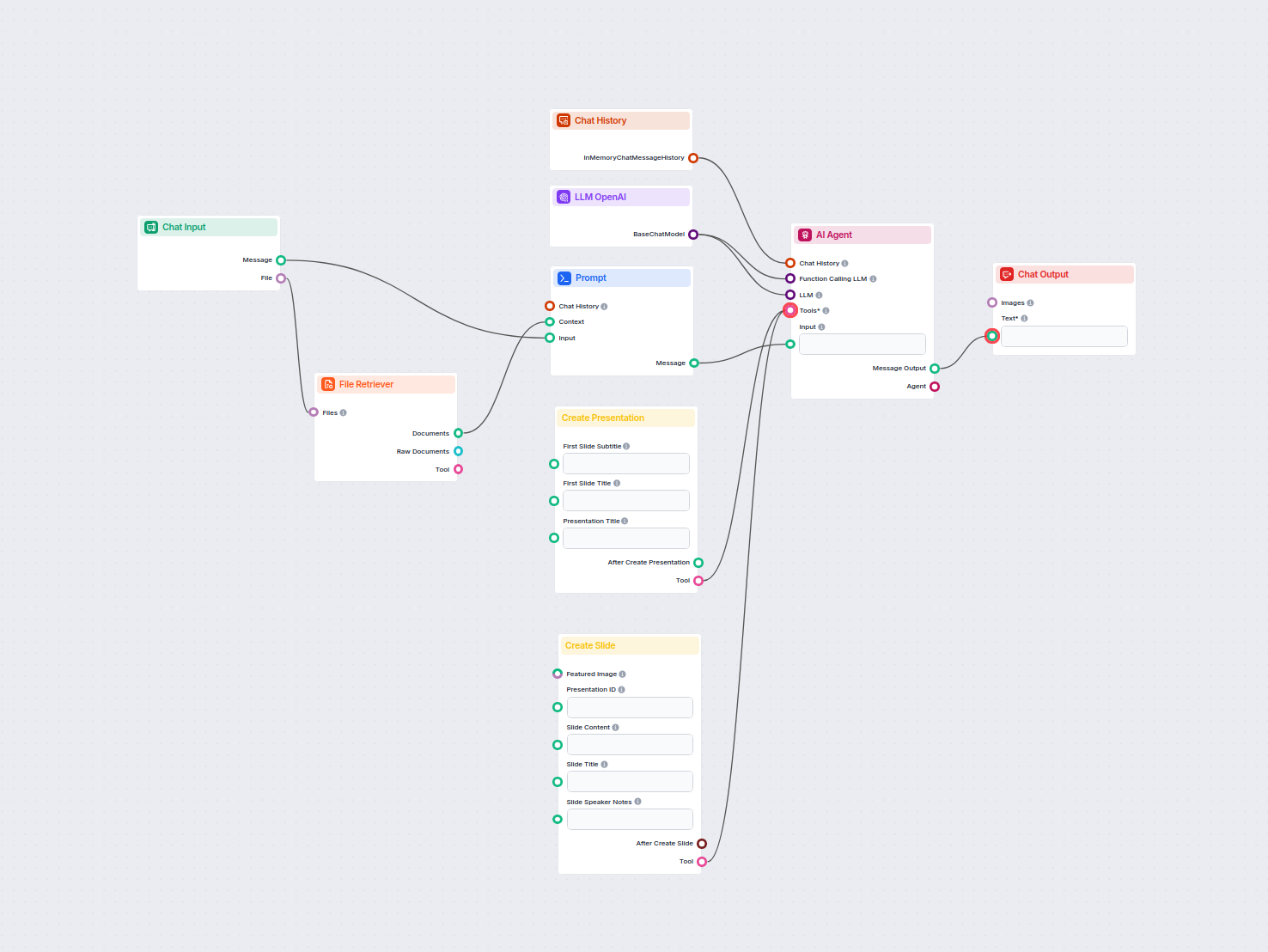

Automatisieren Sie die Erstellung professioneller Google Slides-Präsentationen aus beliebigen hochgeladenen Dokumenten mit KI. Dieser Workflow extrahiert den Do...

Automatisieren und optimieren Sie die Genehmigung von Urlaubsanträgen in Google Calendar mit einem KI-Agenten. Dieser Workflow erkennt neue Urlaubsanfragen, bew...

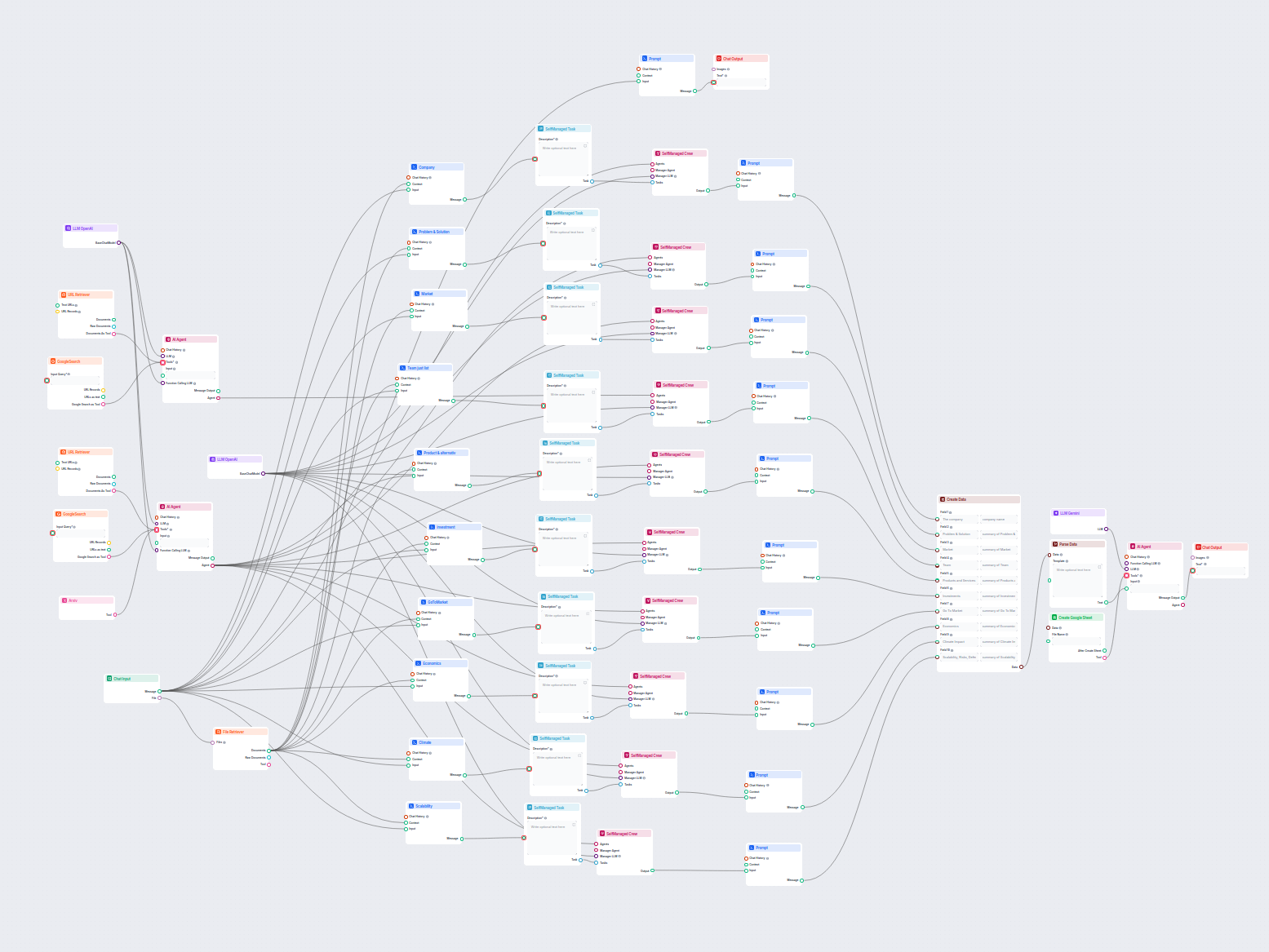

Dieser KI-Workflow analysiert jedes Unternehmen eingehend durch Recherche öffentlicher Daten und Dokumente und deckt Markt, Team, Produkte, Investitionen und me...

Dieser Workflow automatisiert den Kundensupport für Ihr Unternehmen, indem er LiveAgent-Konversationen integriert, relevante Konversationsdaten extrahiert, Antw...

Dieser KI-gestützte Workflow automatisiert den Kundensupport, indem er Benutzeranfragen mit Wissensquellen des Unternehmens, externen APIs (wie LiveAgent) und e...

Dieser KI-gestützte Workflow automatisiert den Kundensupport durch die Kombination aus interner Wissensdatenbank-Suche, Google Docs-Wissensabruf, API-Integratio...

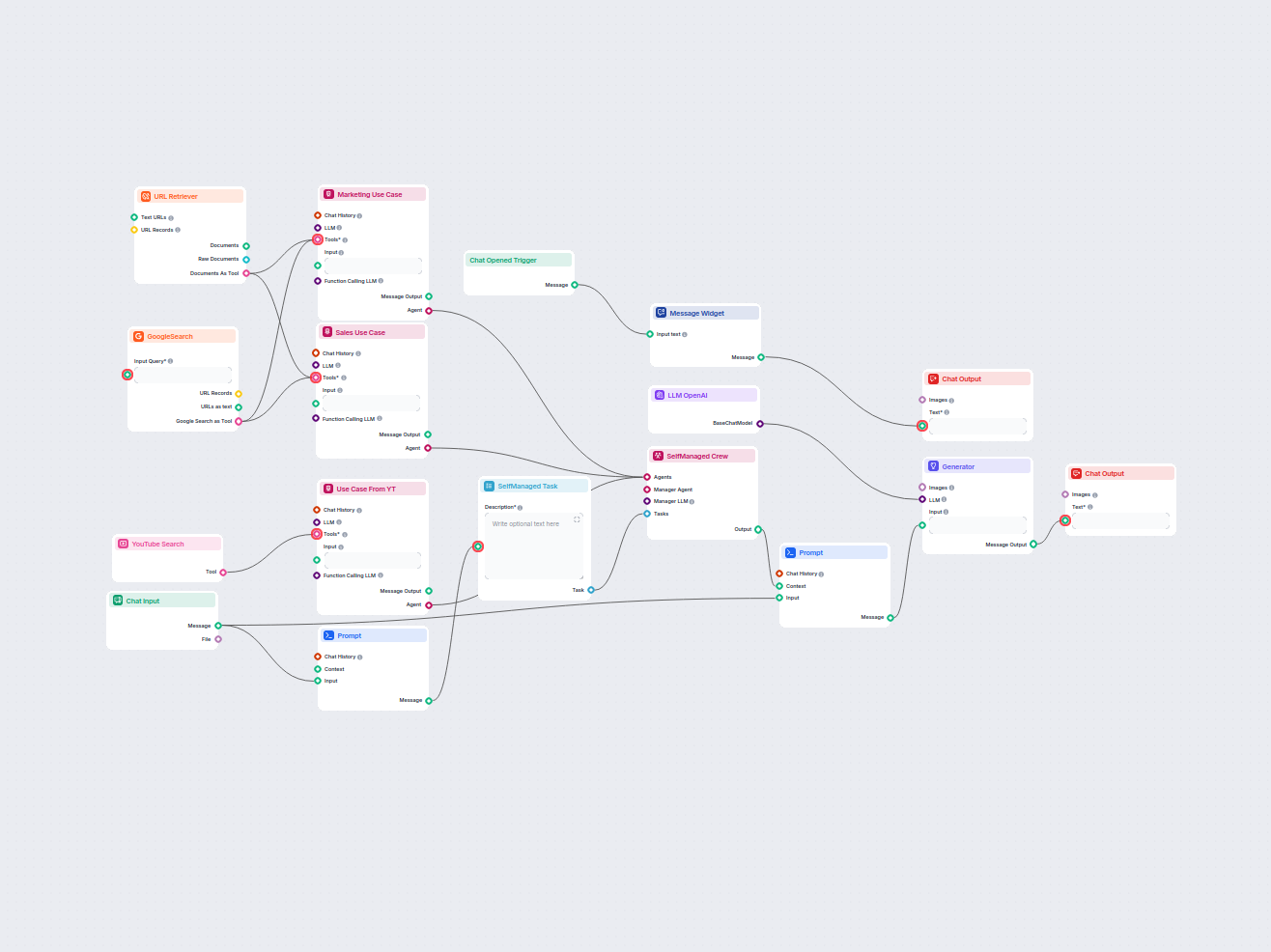

Erstellen Sie umfassende, KI-gesteuerte Berichte zu Anwendungsfällen von Softwareprodukten für Marketing und Vertrieb. Dieser Workflow recherchiert das Produkt ...

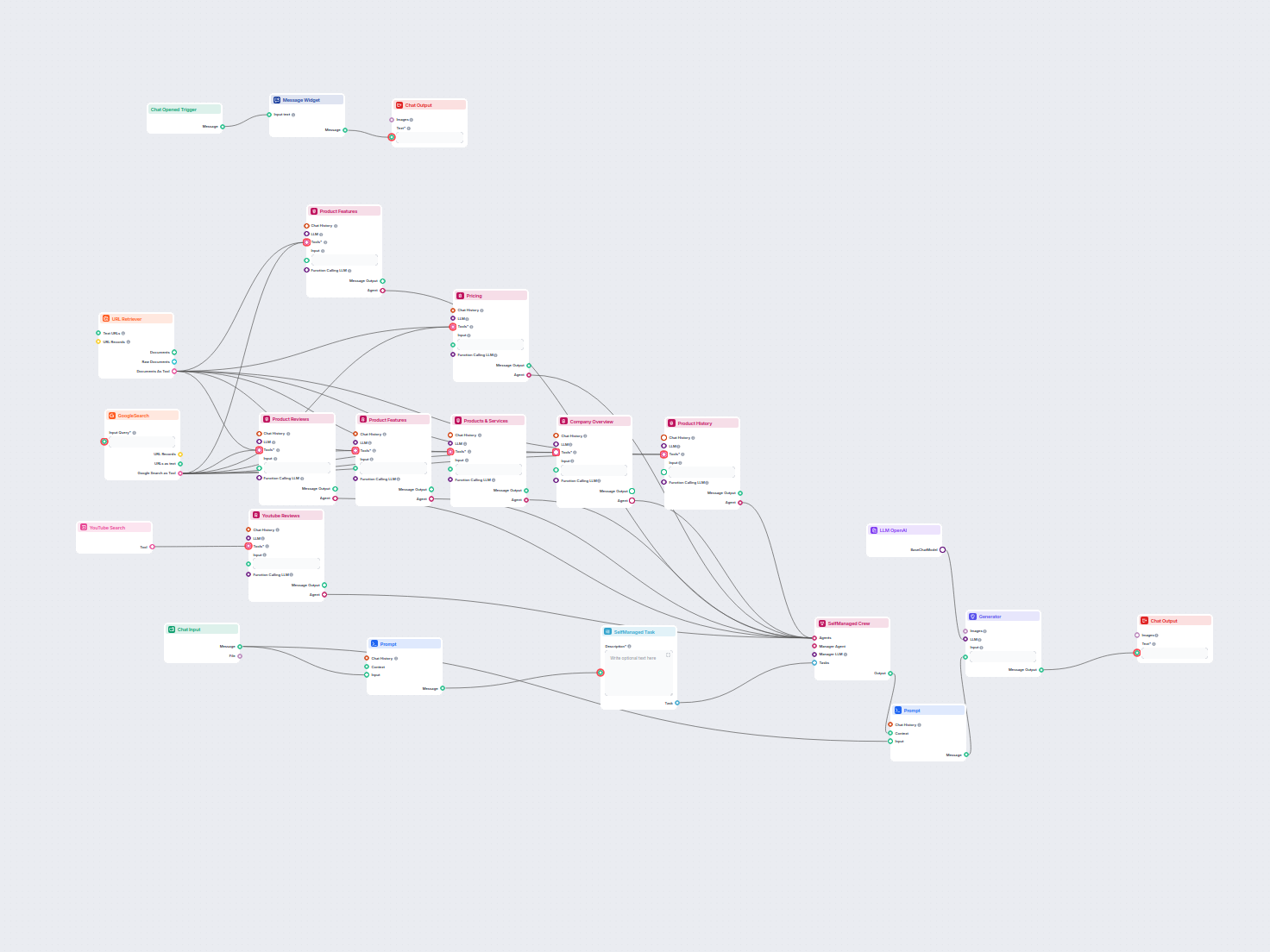

Erstellen Sie umfassende Produktanalysen mit KI-Agenten, die Produktinformationen, Preise, Funktionen, Bewertungen, Alternativen und mehr aus öffentlichen Inter...

Erzeugen Sie einzigartige, SEO-optimierte Webseitentitel mit KI und aktuellen Google-Suchdaten. Geben Sie Ihre Ziel-Keywords ein und erhalten Sie einen auf aktu...

Erstellen Sie umfassende, SEO-optimierte Produktbewertungsartikel für Software-Tools, einschließlich detaillierter Funktionen, Preisgestaltung, Nutzerbewertunge...

Umfassender KI-gesteuerter Workflow zur Unternehmensanalyse und Marktforschung. Sammelt und analysiert automatisch Daten zum Unternehmenshintergrund, zur Marktp...

Dieser KI-gestützte Workflow liefert eine umfassende, datenbasierte Unternehmensanalyse. Er sammelt Informationen zum Unternehmenshintergrund, Marktumfeld, Team...

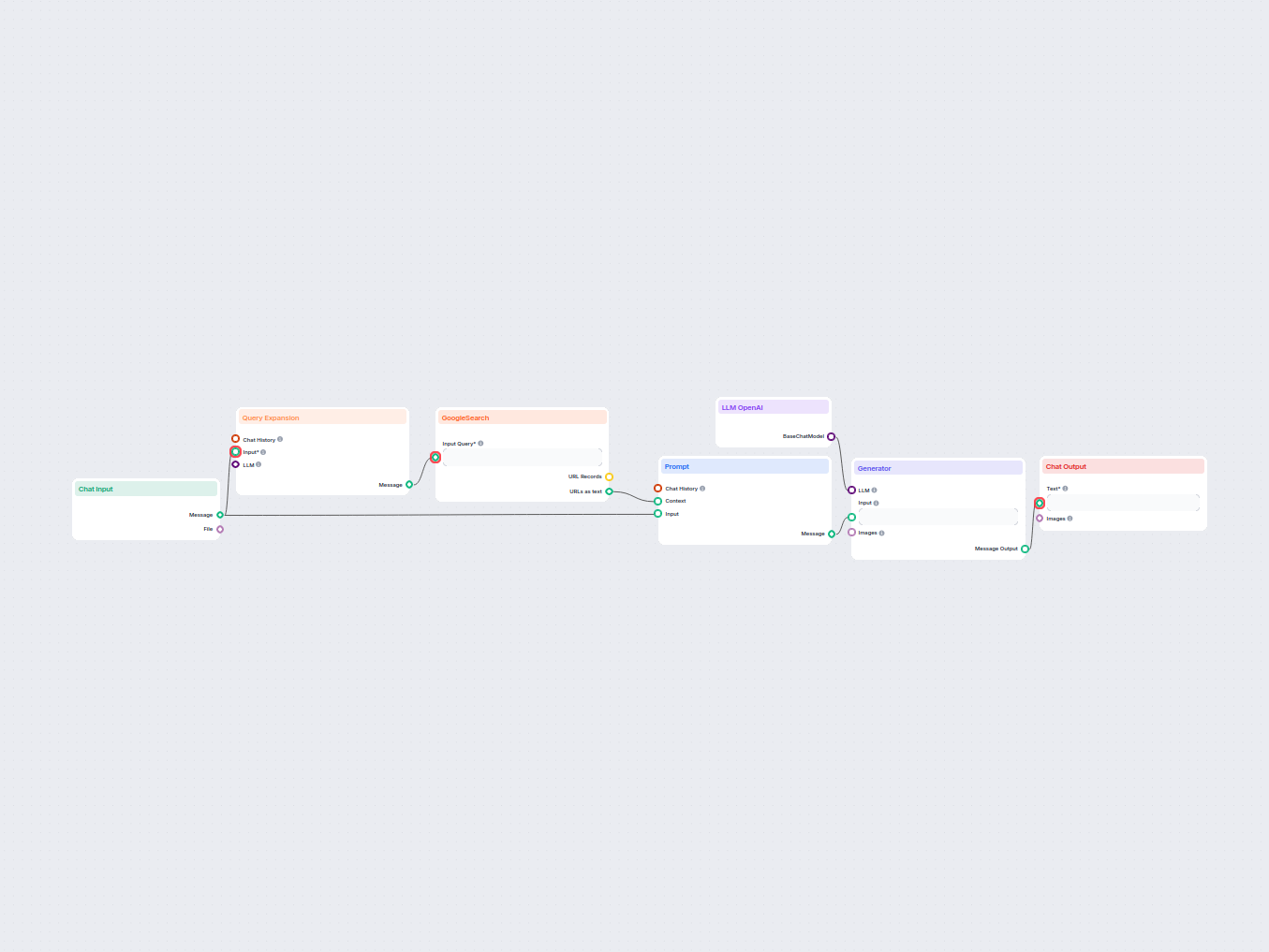

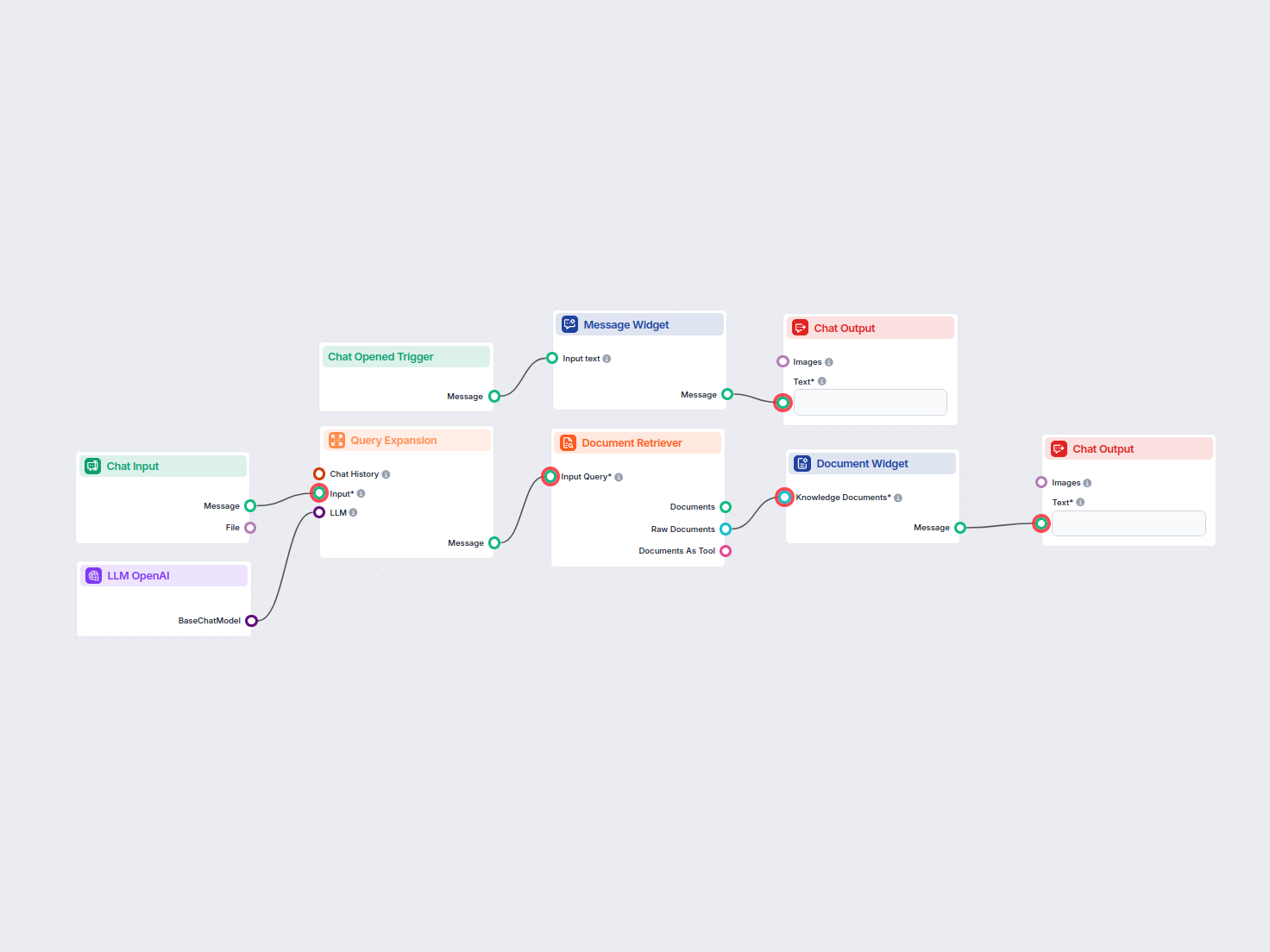

Durch semantische Suche mit KI können Sie ganz einfach Informationen aus privaten Wissensdatenbank-Dokumenten suchen und abrufen. Der Ablauf erweitert Benutzera...

Dieser KI-gestützte Workflow analysiert die Inhaltsstruktur Ihrer Webseite, vergleicht sie mit den bestplatzierten Wettbewerberseiten und liefert maßgeschneider...

Dieser KI-gestützte Workflow hilft Shopify-Händlern, Wettbewerberprodukte zu analysieren, Markttrends zu recherchieren und optimierte Preisstrategien zu erstell...

Verwandeln Sie technische Dokumentation von einer URL in einen überzeugenden, SEO-optimierten Artikel für Ihre Website. Dieser Flow analysiert die bestplatziert...

Verwandeln Sie jedes YouTube-Video in wenigen Minuten in eine professionelle Google Slides Präsentation. Dieser KI-gestützte Workflow extrahiert Inhalte aus ein...

Large Language Models sind Arten von KI, die darauf trainiert wurden, menschenähnlichen Text zu verarbeiten, zu verstehen und zu generieren. Ein bekanntes Beispiel ist ChatGPT, das auf nahezu jede Anfrage ausführlich antworten kann.

Nein, die LLM-Komponente ist nur eine Repräsentation des KI-Modells. Sie ändert das Modell, das der Generator verwendet. Das Standard-LLM im Generator ist ChatGPT-4o.

Derzeit ist nur die OpenAI-Komponente verfügbar. In Zukunft planen wir, weitere hinzuzufügen.

Nein, Flows sind eine vielseitige Funktion mit vielen Anwendungsfällen – auch ohne LLM. Sie fügen ein LLM hinzu, wenn Sie einen konversationellen Chatbot bauen möchten, der frei Textantworten generiert.

Nicht wirklich. Die Komponente repräsentiert nur das Modell und erstellt Regeln, denen es folgen soll. Die Generator-Komponente verbindet es mit der Eingabe und führt die Anfrage durch das LLM, um eine Ausgabe zu erstellen.

Intelligente Chatbots und KI-Tools unter einem Dach. Verbinden Sie intuitive Bausteine, um Ihre Ideen in automatisierte Flows zu verwandeln.

FlowHunt unterstützt Dutzende von KI-Modellen, einschließlich der Claude-Modelle von Anthropic. Erfahren Sie, wie Sie Claude in Ihren KI-Tools und Chatbots mit ...

FlowHunt unterstützt Dutzende von Textgenerierungsmodellen, darunter Metas Llama-Modelle. Erfahren Sie, wie Sie Llama in Ihre KI-Tools und Chatbots integrieren,...

FlowHunt unterstützt Dutzende von Textgenerierungsmodellen, einschließlich der Modelle von xAI. Hier erfahren Sie, wie Sie die xAI-Modelle in Ihren KI-Tools und...

Cookie-Zustimmung

Wir verwenden Cookies, um Ihr Surferlebnis zu verbessern und unseren Datenverkehr zu analysieren. See our privacy policy.