Redes Neuronales

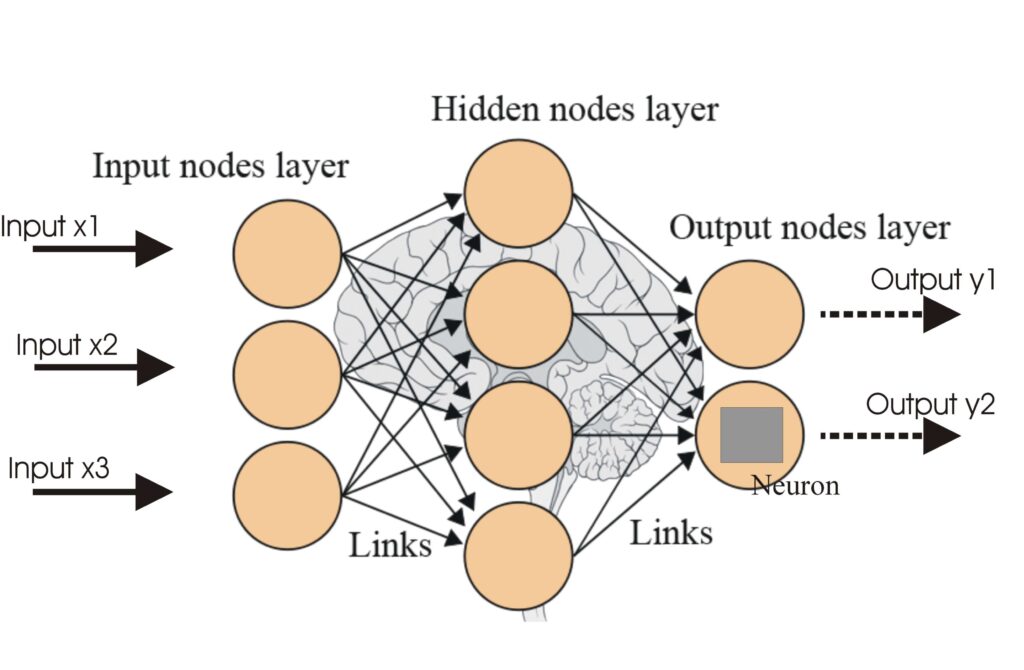

Una red neuronal, o red neuronal artificial (ANN), es un modelo computacional inspirado en el cerebro humano, esencial en la IA y el aprendizaje automático para...

Las funciones de activación introducen no linealidad en las redes neuronales, permitiendo que aprendan patrones complejos esenciales para aplicaciones de IA y deep learning.

Las funciones de activación son fundamentales para la arquitectura de las redes neuronales artificiales (RNA), influyendo significativamente en la capacidad de la red para aprender y ejecutar tareas complejas. Este artículo del glosario profundiza en las complejidades de las funciones de activación, examinando su propósito, tipos y aplicaciones, especialmente dentro de los ámbitos de la IA, el deep learning y las redes neuronales.

Una función de activación en una red neuronal es una operación matemática que se aplica a la salida de una neurona. Determina si una neurona debe activarse o no, introduciendo no linealidad en el modelo, lo que permite a la red aprender patrones complejos. Sin estas funciones, una red neuronal actuaría esencialmente como un modelo de regresión lineal, independientemente de su profundidad o número de capas.

Función Sigmoide

Función Tanh

ReLU (Unidad Lineal Rectificada)

Leaky ReLU

Función Softmax

Función Swish

Las funciones de activación son parte integral de diversas aplicaciones de IA, incluyendo:

Una función de activación es una operación matemática que se aplica a la salida de una neurona, introduciendo no linealidad y permitiendo que las redes neuronales aprendan patrones complejos más allá de relaciones lineales simples.

Las funciones de activación permiten que las redes neuronales resuelvan problemas complejos y no lineales al posibilitar el aprendizaje de patrones intrincados, haciéndolas cruciales para tareas como la clasificación de imágenes, el procesamiento del lenguaje y la automatización.

Los tipos más comunes incluyen Sigmoide, Tanh, ReLU, Leaky ReLU, Softmax y Swish, cada uno con características y casos de uso únicos en diferentes capas de redes neuronales.

Los desafíos comunes incluyen el problema del gradiente que desaparece (especialmente con Sigmoide y Tanh), la muerte del ReLU y el coste computacional de funciones como Softmax en aplicaciones en tiempo real.

Chatbots inteligentes y herramientas de IA bajo un mismo techo. Conecta bloques intuitivos para convertir tus ideas en Flujos automatizados.

Una red neuronal, o red neuronal artificial (ANN), es un modelo computacional inspirado en el cerebro humano, esencial en la IA y el aprendizaje automático para...

Las Redes Neuronales Artificiales (ANNs) son un subconjunto de algoritmos de aprendizaje automático modelados a partir del cerebro humano. Estos modelos computa...

Las redes neuronales recurrentes (RNN) son una sofisticada clase de redes neuronales artificiales diseñadas para procesar datos secuenciales utilizando la memor...

Consentimiento de Cookies

Usamos cookies para mejorar tu experiencia de navegación y analizar nuestro tráfico. See our privacy policy.