Redes Bayesianas

Una Red Bayesiana (BN) es un modelo gráfico probabilístico que representa variables y sus dependencias condicionales mediante un Gráfico Acíclico Dirigido (DAG)...

Las Redes de Creencias Profundas (DBNs) son modelos generativos de aprendizaje profundo compuestos por Máquinas de Boltzmann Restringidas apiladas, destacando en el aprendizaje de representaciones jerárquicas de datos para diversas tareas de IA.

Una Red de Creencias Profundas (DBN) es un sofisticado modelo generativo que utiliza una arquitectura profunda para aprender representaciones jerárquicas de los datos. Las DBNs están compuestas por múltiples capas de variables latentes estocásticas, utilizando principalmente Máquinas de Boltzmann Restringidas (RBMs) como bloques fundamentales. Estas redes están diseñadas para abordar los desafíos que enfrentan las redes neuronales tradicionales, como tasas de aprendizaje lentas y quedar atrapadas en mínimos locales debido a una mala selección de parámetros. Las DBNs destacan tanto en tareas de aprendizaje no supervisado como supervisado, lo que las convierte en herramientas versátiles para diversas aplicaciones en aprendizaje profundo.

Las DBNs operan a través de dos fases principales: preentrenamiento y ajuste fino.

Las DBNs son especialmente aptas para manejar tareas que involucran datos de alta dimensión o situaciones donde los datos etiquetados son escasos. Algunas aplicaciones destacadas incluyen:

Considera el siguiente ejemplo usando Python, que demuestra el entrenamiento y la evaluación de una DBN en el conjunto de datos MNIST, un banco de pruebas para tareas de clasificación de imágenes:

import numpy as np

from sklearn.datasets import fetch_openml

from sklearn.model_selection import train_test_split

from sklearn.preprocessing import StandardScaler

from sklearn.neural_network import BernoulliRBM

from sklearn.pipeline import Pipeline

from sklearn.linear_model import LogisticRegression

# Load dataset

mnist = fetch_openml('mnist_784', version=1)

X, y = mnist['data'], mnist['target']

# Split dataset into training and test sets

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# Preprocess data by scaling

scaler = StandardScaler()

X_train_scaled = scaler.fit_transform(X_train)

X_test_scaled = scaler.transform(X_test)

# Initialize the RBM model

rbm = BernoulliRBM(n_components=256, learning_rate=0.01, n_iter=20)

# Initialize the logistic regression model

logistic = LogisticRegression(max_iter=1000)

# Create a pipeline for feature extraction and classification

dbn_pipeline = Pipeline(steps=[('rbm', rbm), ('logistic', logistic)])

# Train the DBN

dbn_pipeline.fit(X_train_scaled, y_train)

# Evaluate the model

dbn_score = dbn_pipeline.score(X_test_scaled, y_test)

print(f"DBN Classification score: {dbn_score}")

Este código en Python ilustra cómo emplear una DBN para la clasificación de imágenes usando el conjunto de datos MNIST. El pipeline combina una RBM para la extracción de características con regresión logística para la clasificación, mostrando la aplicación práctica de las DBNs en tareas de aprendizaje automático.

Redes de Creencias Profundas (DBNs) y sus aplicaciones

Las Redes de Creencias Profundas (DBNs) son una clase de modelos de aprendizaje profundo que han ganado una atención significativa por su capacidad para modelar distribuciones de probabilidad complejas. Estas redes están compuestas por múltiples capas de variables latentes estocásticas y generalmente se entrenan utilizando técnicas de aprendizaje no supervisado. A continuación se resume algunos artículos científicos clave sobre DBNs:

Learning the Structure of Deep Sparse Graphical Models

Distinction between features extracted using deep belief networks

Feature versus Raw Sequence: Deep Learning Comparative Study on Predicting Pre-miRNA

Estos artículos reflejan la versatilidad y evolución constante de las DBNs, desde sus procesos de aprendizaje estructural hasta su aplicación en la extracción de características y tareas de predicción de secuencias. Destacan la importancia de las DBNs en el avance de las técnicas de aprendizaje automático y su adaptabilidad a diversas representaciones de datos.

Una Red de Creencias Profundas es un modelo generativo de aprendizaje profundo compuesto por múltiples capas de variables latentes estocásticas, utilizando principalmente Máquinas de Boltzmann Restringidas. Las DBNs aprenden representaciones jerárquicas de datos y pueden aplicarse tanto a tareas supervisadas como no supervisadas.

Las DBNs se utilizan para reconocimiento de imágenes, reconocimiento de voz y generación de datos. Sobresalen en el manejo de datos de alta dimensión y en situaciones con datos etiquetados limitados.

Las DBNs se entrenan en dos fases: preentrenamiento no supervisado, donde cada capa se entrena de forma independiente como una RBM, y ajuste fino supervisado, donde la red se optimiza utilizando datos etiquetados mediante retropropagación.

Las DBNs utilizan un enfoque de entrenamiento codicioso por capas y emplean unidades estocásticas, lo que les permite inicializar mejor los pesos y superar desafíos como tasas de aprendizaje lentas y mínimos locales que afectan a las redes neuronales tradicionales.

Comienza a construir soluciones de IA utilizando modelos avanzados como las Redes de Creencias Profundas. Experimenta la plataforma fluida de FlowHunt para tus necesidades de aprendizaje automático.

Una Red Bayesiana (BN) es un modelo gráfico probabilístico que representa variables y sus dependencias condicionales mediante un Gráfico Acíclico Dirigido (DAG)...

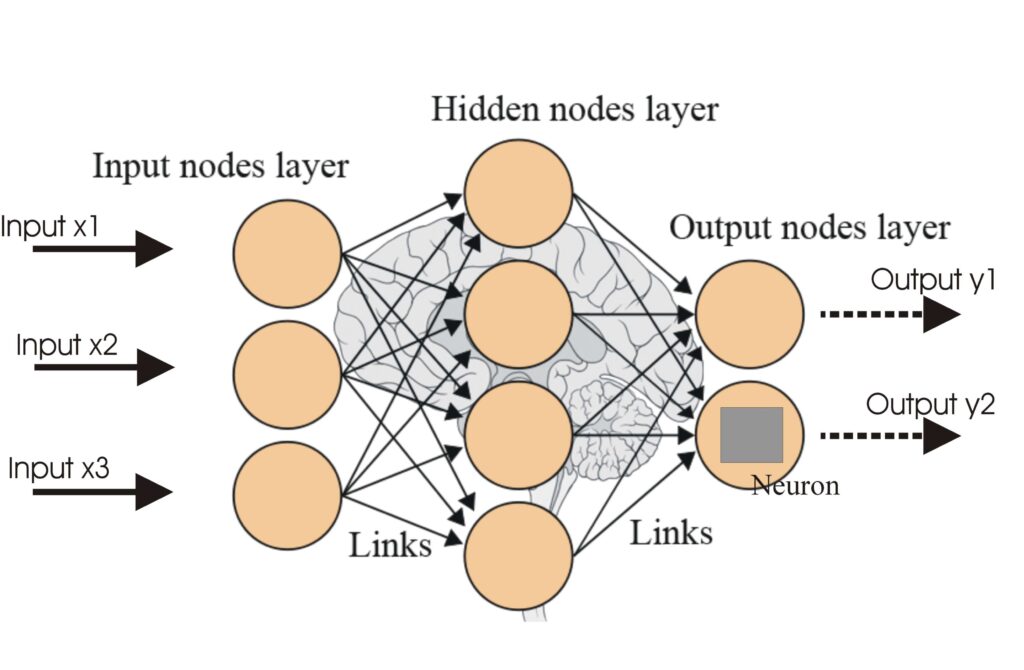

Una red neuronal, o red neuronal artificial (ANN), es un modelo computacional inspirado en el cerebro humano, esencial en la IA y el aprendizaje automático para...

Las Redes Neuronales Artificiales (ANNs) son un subconjunto de algoritmos de aprendizaje automático modelados a partir del cerebro humano. Estos modelos computa...

Consentimiento de Cookies

Usamos cookies para mejorar tu experiencia de navegación y analizar nuestro tráfico. See our privacy policy.