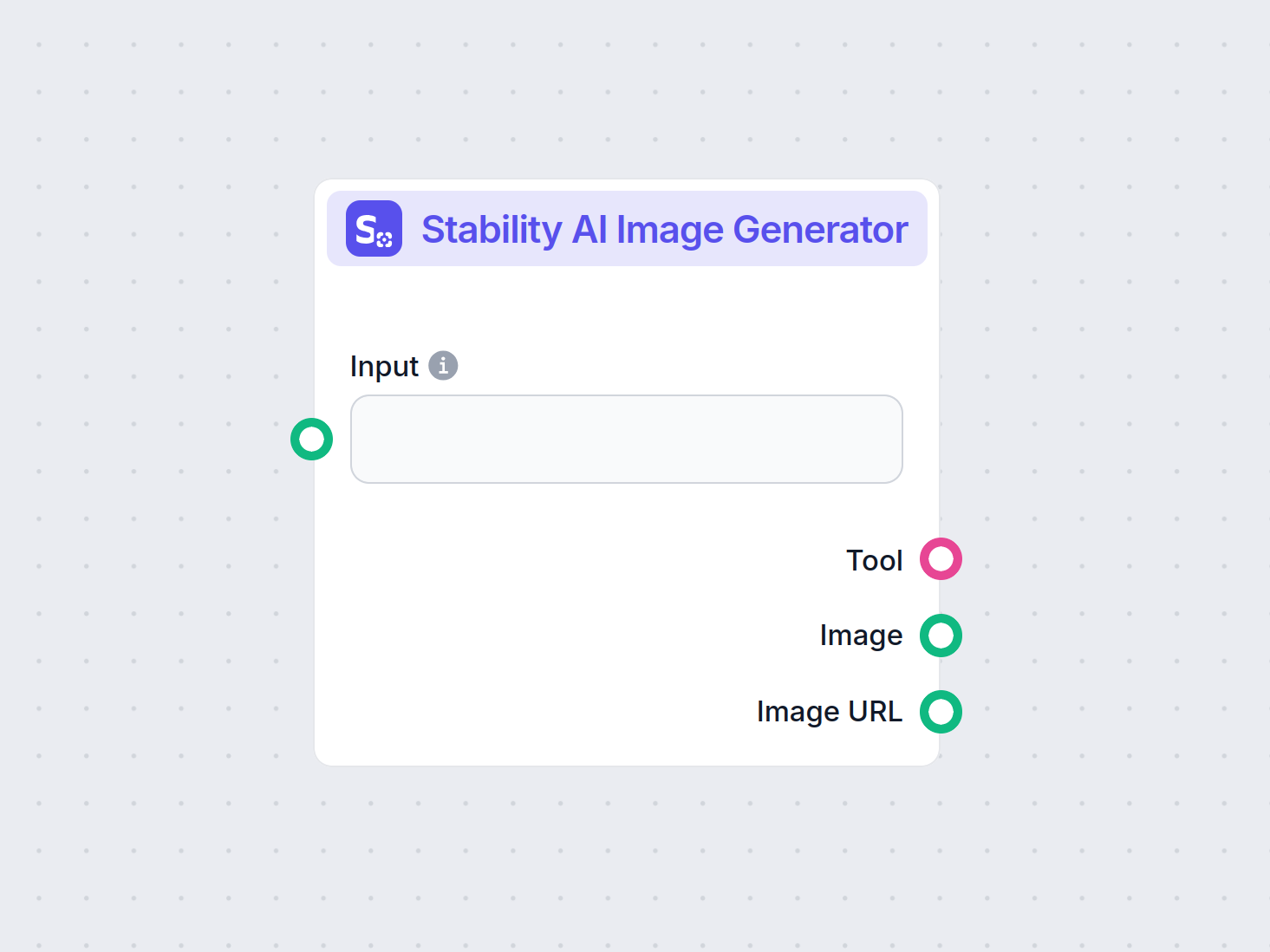

Generador de Imágenes de Stability AI

Genera imágenes de alta calidad a partir de indicaciones de texto con el componente Generador de Imágenes de Stability AI. Impulsado por modelos Stable Diffusio...

Stable Diffusion es un modelo líder de IA de texto a imagen que permite a los usuarios generar imágenes fotorrealistas a partir de prompts utilizando técnicas avanzadas de difusión latente y aprendizaje profundo.

Stable Diffusion es un modelo de IA de texto a imagen que crea imágenes de alta calidad a partir de descripciones usando aprendizaje profundo. Emplea técnicas como prompts negativos e imágenes de referencia para obtener mejores resultados, especialmente con elementos complejos como las manos.

Stable Diffusion es un modelo avanzado de generación de imágenes a partir de texto que utiliza técnicas de aprendizaje profundo para producir imágenes fotorrealistas y de alta calidad a partir de descripciones textuales. Desarrollado como un modelo de difusión latente, representa un avance significativo en el campo de la inteligencia artificial generativa, combinando los principios de los modelos de difusión y el aprendizaje automático para crear imágenes que coinciden estrechamente con los prompts de texto dados.

Stable Diffusion utiliza aprendizaje profundo y modelos de difusión para generar imágenes refinando ruido aleatorio hasta crear visuales coherentes. A pesar de su amplio entrenamiento con millones de imágenes, tiene dificultades con elementos complejos como las manos. Con el tiempo, a medida que los modelos se entrenan con conjuntos de datos cada vez más grandes, estos problemas se minimizan y la calidad de las imágenes es cada vez más realista.

Un método eficaz para abordar el problema de las manos es utilizar prompts negativos. Al añadir frases como (-bad anatomy) o (-bad hands -unnatural hands) a tus prompts, puedes indicar a la IA que evite producir características distorsionadas. Ten cuidado de no abusar de los prompts negativos, ya que pueden limitar la creatividad del modelo.

Otra técnica consiste en usar imágenes de referencia para guiar a la IA. Al incluir una etiqueta {image} con un enlace a una imagen de referencia en tu prompt, le das a la IA una plantilla visual para lograr una representación precisa de las manos. Esto es especialmente útil para mantener proporciones y poses correctas.

Para obtener los mejores resultados, combina tanto prompts negativos como imágenes de referencia. Este enfoque dual asegura que la IA evite errores comunes mientras se adhiere a ejemplos de alta calidad.

(-bent fingers) o (realistic perspectives) para aumentar aún más la calidad de las manos.Dominando estas técnicas, puedes mejorar significativamente la representación de manos en tus creaciones con Stable Diffusion, logrando obras con el arte de un artista experimentado. ¡Reúne tus imágenes de referencia, crea prompts precisos y observa cómo evoluciona tu arte con IA!

En su núcleo, Stable Diffusion opera transformando prompts de texto en representaciones visuales a través de una serie de procesos computacionales. Comprender su funcionamiento implica profundizar en los conceptos de modelos de difusión, espacios latentes y redes neuronales.

Los modelos de difusión son una clase de modelos generativos en aprendizaje automático que aprenden a crear datos invirtiendo un proceso de difusión. El proceso de difusión implica añadir gradualmente ruido a los datos —como imágenes— hasta que se vuelven indistinguibles del ruido aleatorio. Luego, el modelo aprende a invertir este proceso, eliminando el ruido paso a paso para recuperar los datos originales. Este proceso de difusión inversa es clave para generar nuevos datos coherentes a partir de ruido aleatorio.

Stable Diffusion utiliza específicamente un modelo de difusión latente. A diferencia de los modelos de difusión tradicionales que operan directamente en el espacio de píxeles de alta dimensión de las imágenes, los modelos de difusión latente trabajan en un espacio latente comprimido. Este espacio latente es una representación de menor dimensión de los datos, capturando las características esenciales y reduciendo la complejidad computacional. Al operar en el espacio latente, Stable Diffusion puede generar imágenes de alta resolución de manera más eficiente.

El mecanismo principal de Stable Diffusion implica el proceso de difusión inversa en el espacio latente. Comenzando con un vector latente de ruido aleatorio, el modelo refina iterativamente esta representación latente prediciendo y eliminando el ruido en cada paso. Este refinamiento está guiado por la descripción textual proporcionada por el usuario. El proceso continúa hasta que el vector latente converge a un estado que, al ser decodificado, produce una imagen consistente con el prompt de texto.

La arquitectura de Stable Diffusion integra varios componentes clave que trabajan en conjunto para transformar prompts de texto en imágenes.

El VAE actúa como el sistema codificador-decodificador que comprime imágenes en el espacio latente y las reconstruye de nuevo en imágenes. El codificador transforma una imagen en su representación latente, capturando las características fundamentales en una forma reducida. El decodificador toma esta representación latente y la reconstruye en la imagen detallada.

Este proceso es crucial porque permite al modelo trabajar con datos de menor dimensión, reduciendo significativamente los recursos computacionales en comparación con operar en el espacio completo de píxeles.

La U-Net es una arquitectura de red neuronal especializada utilizada dentro de Stable Diffusion para tareas de procesamiento de imágenes. Consiste en una ruta de codificación y una de decodificación con conexiones de salto entre capas espejo. En el contexto de Stable Diffusion, la U-Net funciona como el predictor de ruido durante el proceso de difusión inversa.

En cada paso del proceso de difusión, la U-Net predice la cantidad de ruido presente en la representación latente. Esta predicción se utiliza para refinar el vector latente restando el ruido estimado, descomponiendo progresivamente el espacio latente hasta una imagen acorde al prompt de texto.

Para incorporar información textual, Stable Diffusion emplea un codificador de texto basado en el modelo CLIP (Contrastive Language-Image Pretraining). CLIP está diseñado para comprender y relacionar información textual y visual mapeándolas en un espacio latente compartido.

Cuando un usuario proporciona un prompt de texto, el codificador de texto convierte este prompt en una serie de embeddings —representaciones numéricas de los datos textuales—. Estas embeddings condicionan la U-Net durante el proceso de difusión inversa, guiando la generación de la imagen para reflejar el contenido del prompt.

Stable Diffusion ofrece versatilidad en la generación de imágenes y puede utilizarse de diversas maneras según las necesidades del usuario.

El uso principal de Stable Diffusion es la generación de imágenes a partir de prompts de texto. Los usuarios ingresan una descripción y el modelo genera una imagen que representa dicha descripción. Por ejemplo, un usuario podría ingresar “Una playa serena al atardecer con palmeras” y recibir una imagen que muestre esa escena.

Esta capacidad es especialmente valiosa en industrias creativas, creación de contenido y diseño, donde la visualización rápida de conceptos es esencial.

Además de generar imágenes desde cero, Stable Diffusion también puede modificar imágenes existentes basándose en instrucciones textuales. Al proporcionar una imagen inicial y un prompt de texto, el modelo puede producir una nueva imagen que incorpore los cambios descritos en el texto.

Por ejemplo, un usuario puede ingresar una imagen de una ciudad durante el día con el prompt “cambiar a noche con luces de neón”, obteniendo una imagen que refleje estas modificaciones.

El inpainting consiste en rellenar partes faltantes o dañadas de una imagen. Stable Diffusion sobresale en esta área usando prompts de texto para guiar la reconstrucción de áreas específicas. Los usuarios pueden enmascarar partes de una imagen y proporcionar descripciones textuales de lo que debería rellenar el espacio.

Esta función es útil en restauración fotográfica, eliminación de objetos no deseados o alteración de elementos específicos dentro de una imagen mientras se mantiene la coherencia general.

Mediante la generación de secuencias de imágenes con ligeras variaciones, Stable Diffusion puede extenderse para crear animaciones o contenido de video. Herramientas como Deforum amplían las capacidades de Stable Diffusion para producir contenido visual dinámico guiado por prompts de texto a lo largo del tiempo.

Esto abre posibilidades en animación, efectos visuales y generación dinámica de contenido sin la necesidad de técnicas tradicionales de animación cuadro por cuadro.

La capacidad de Stable Diffusion de generar imágenes a partir de descripciones textuales lo convierte en una herramienta poderosa para la automatización con IA y el desarrollo de chatbots.

Incorporar Stable Diffusion en chatbots permite la generación de contenido visual en respuesta a consultas de usuarios. Por ejemplo, en un escenario de atención al cliente, un chatbot podría proporcionar guías visuales o ilustraciones generadas al instante para asistir a los usuarios.

Los prompts de texto se convierten en embeddings mediante el codificador de texto CLIP. Estas embeddings son fundamentales para condicionar el proceso de generación de imágenes, asegurando que la imagen resultante se alinee con la descripción textual del usuario.

El proceso de difusión inversa consiste en refinar iterativamente la representación latente eliminando el ruido predicho. En cada paso, el modelo considera las embeddings de texto y el estado actual del vector latente para predecir con precisión el componente de ruido.

La habilidad del modelo para manejar imágenes ruidosas proviene de su entrenamiento con grandes conjuntos de datos, donde aprende a distinguir y descomponer imágenes de manera efectiva. Este entrenamiento le permite generar imágenes claras incluso partiendo de ruido aleatorio.

Trabajar en el espacio latente ofrece eficiencia computacional. Dado que el espacio latente tiene menos dimensiones que el espacio de píxeles, las operaciones son menos exigentes en recursos. Esta eficiencia permite a Stable Diffusion generar imágenes de alta resolución sin demandas computacionales excesivas.

Artistas y diseñadores pueden usar Stable Diffusion para prototipar rápidamente visuales a partir de descripciones conceptuales, ayudando en el proceso creativo y reduciendo el tiempo desde la idea hasta la visualización.

Los equipos de marketing pueden generar imágenes personalizadas para campañas, redes sociales y anuncios sin necesidad de recursos extensos de diseño gráfico.

Los desarrolladores pueden crear recursos, entornos y arte conceptual proporcionando prompts descriptivos, agilizando la creación de recursos.

Los minoristas pueden generar imágenes de productos en diferentes escenarios o configuraciones, mejorando la visualización de productos y la experiencia del cliente.

Educadores y creadores de contenido pueden producir ilustraciones y diagramas para explicar conceptos complejos, haciendo los materiales educativos más atractivos.

Investigadores en inteligencia artificial y visión por computadora pueden utilizar Stable Diffusion para explorar las capacidades de los modelos de difusión y espacios latentes.

Para usar Stable Diffusion de manera efectiva, se deben tener en cuenta ciertos aspectos técnicos.

Para comenzar a usar Stable Diffusion, sigue estos pasos:

Para desarrolladores que crean sistemas de automatización IA y chatbots, Stable Diffusion puede integrarse para mejorar la funcionalidad.

Al usar Stable Diffusion, es importante tener en cuenta las implicaciones éticas.

La difusión estable es un tema relevante en el campo de los modelos generativos, especialmente para la ampliación de datos y la síntesis de imágenes. Estudios recientes han explorado diversos aspectos de la difusión estable, destacando sus aplicaciones y efectividad.

Diffusion Least Mean P-Power Algorithms for Distributed Estimation in Alpha-Stable Noise Environments de Fuxi Wen (2013):

Presenta un algoritmo de difusión de mínima potencia media-p (LMP) diseñado para la estimación distribuida en entornos caracterizados por ruido alfa-estable. El estudio compara el método de difusión LMP con el algoritmo de difusión de mínimos cuadrados (LMS) y demuestra un mejor rendimiento en condiciones de ruido alfa-estable. Esta investigación es clave para desarrollar técnicas robustas de estimación en entornos ruidosos. Leer más

Stable Diffusion for Data Augmentation in COCO and Weed Datasets de Boyang Deng (2024):

Investiga el uso de modelos de difusión estable para generar imágenes sintéticas de alta resolución y mejorar conjuntos de datos pequeños. Mediante técnicas como traducción de imagen a imagen, Dreambooth y ControlNet, la investigación evalúa la eficiencia de la difusión estable en tareas de clasificación y detección. Los hallazgos sugieren aplicaciones prometedoras de la difusión estable en varios campos. Leer más

Diffusion and Relaxation Controlled by Tempered α-stable Processes de Aleksander Stanislavsky, Karina Weron y Aleksander Weron (2011):

Deriva propiedades de la difusión anómala y la relajación no exponencial utilizando procesos α-estables templados. Aborda la dificultad de los momentos infinitos asociada al tiempo operacional aleatorio α-estable y proporciona un modelo que incluye la subdifusión como caso especial. Leer más

Evaluating a Synthetic Image Dataset Generated with Stable Diffusion de Andreas Stöckl (2022):

Evalúa imágenes sintéticas generadas por el modelo Stable Diffusion utilizando la taxonomía Wordnet. Analiza la capacidad del modelo para producir imágenes correctas para varios conceptos, ilustrando diferencias en la precisión de representación. Estas evaluaciones son vitales para comprender el papel de la difusión estable en la ampliación de datos. Leer más

Comparative Analysis of Generative Models: Enhancing Image Synthesis with VAEs, GANs, and Stable Diffusion de Sanchayan Vivekananthan (2024):

Explora tres marcos generativos: VAEs, GANs y modelos de Stable Diffusion. La investigación destaca las fortalezas y limitaciones de cada modelo, señalando que aunque los VAEs y GANs tienen sus ventajas, la difusión estable sobresale en ciertas tareas de síntesis. Leer más

Veamos cómo implementar un modelo Stable Diffusion en Python usando la librería Diffusers de Hugging Face.

Instala las librerías necesarias:

pip install torch transformers diffusers accelerate

pip install xformers # Opcional

La librería Diffusers ofrece una forma conveniente de cargar modelos preentrenados:

from diffusers import StableDiffusionPipeline

import torch

# Cargar el modelo Stable Diffusion

model_id = "stabilityai/stable-diffusion-2-1"

pipe = StableDiffusionPipeline.from_pretrained(model_id, torch_dtype=torch.float16)

pipe = pipe.to("cuda") # Mueve el modelo a la GPU para inferencia más rápida

Para generar imágenes, simplemente proporciona un prompt de texto:

prompt = "Un paisaje sereno con montañas y un lago, fotorrealista, resolución 8K"

image = pipe(prompt).images[0]

# Guardar o mostrar la imagen

image.save("generated_image.png")

model_id.torch.float16 reduce el uso de memoria.Puedes personalizar varios parámetros:

image = pipe(

prompt=prompt,

num_inference_steps=50, # Número de pasos de descomposición de ruido

guidance

Stable Diffusion es un modelo avanzado de IA diseñado para generar imágenes fotorrealistas y de alta calidad a partir de prompts de texto. Utiliza difusión latente y aprendizaje profundo para transformar descripciones textuales en imágenes.

Stable Diffusion funciona convirtiendo los prompts de texto en incrustaciones de imagen utilizando un codificador de texto CLIP, luego elimina el ruido iterativamente de una representación latente guiada por el prompt, dando como resultado una imagen coherente.

Stable Diffusion se utiliza para la generación creativa de contenido, materiales de marketing, creación de recursos para videojuegos, visualización de productos para comercio electrónico, ilustraciones educativas y chatbots impulsados por IA.

Sí, Stable Diffusion admite la traducción de imagen a imagen y el inpainting, lo que permite a los usuarios modificar imágenes existentes o rellenar partes faltantes basándose en prompts de texto.

Se recomienda una computadora con una GPU moderna para una generación eficiente de imágenes con Stable Diffusion. El modelo también requiere Python y librerías como PyTorch y Diffusers.

Sí, Stable Diffusion se publica bajo una licencia permisiva de código abierto, lo que fomenta las contribuciones de la comunidad, la personalización y la amplia accesibilidad.

Desata tu creatividad con Stable Diffusion y descubre cómo la IA puede transformar tus ideas en imágenes impresionantes.

Genera imágenes de alta calidad a partir de indicaciones de texto con el componente Generador de Imágenes de Stability AI. Impulsado por modelos Stable Diffusio...

Explora nuestra revisión en profundidad de Stability AI SD3 Large. Analiza sus fortalezas, debilidades y resultados creativos en diversos prompts de texto a ima...

El Modelo Flux AI de Black Forest Labs es un avanzado sistema de generación de texto a imagen que convierte indicaciones en lenguaje natural en imágenes fotorre...

Consentimiento de Cookies

Usamos cookies para mejorar tu experiencia de navegación y analizar nuestro tráfico. See our privacy policy.