Servidor DeepSeek MCP

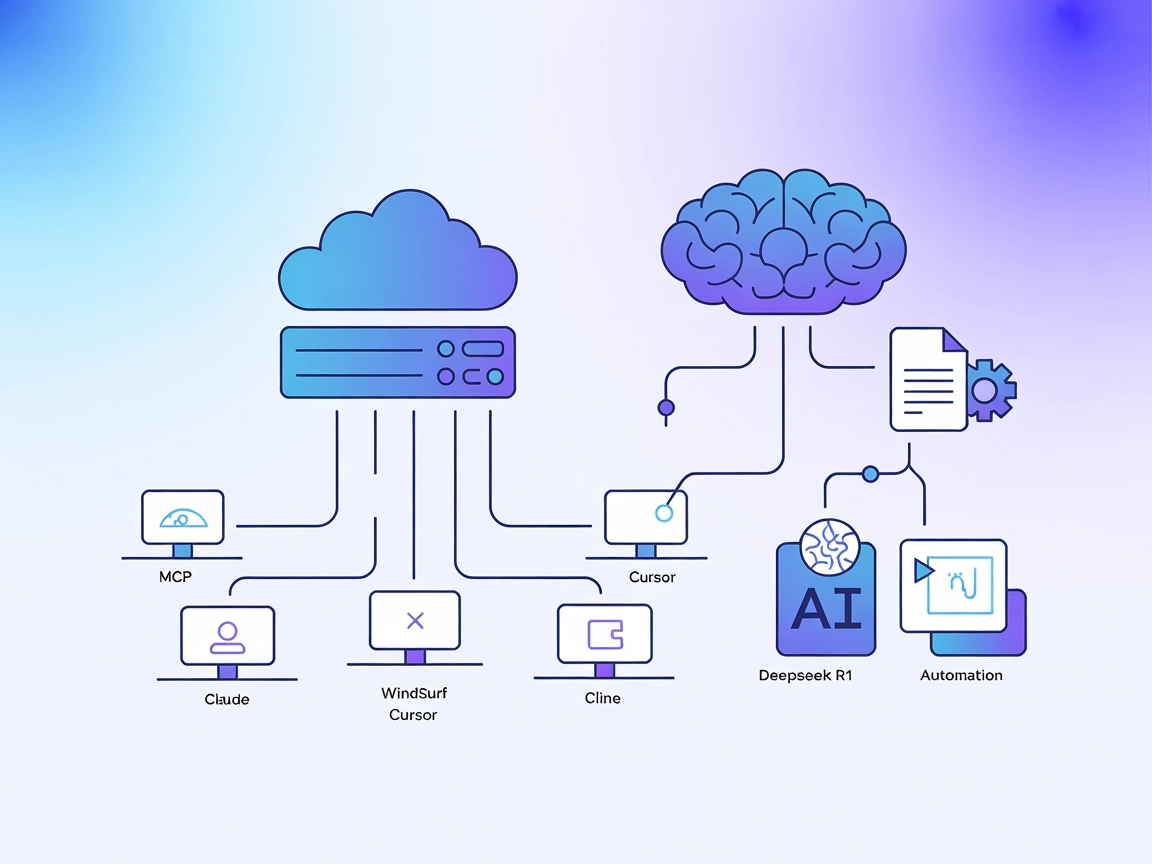

El Servidor DeepSeek MCP actúa como un proxy seguro, conectando los avanzados modelos de lenguaje de DeepSeek con aplicaciones compatibles con MCP como Claude D...

Lleva el razonamiento transparente y las salidas de cadena de pensamiento de Deepseek a tus asistentes habilitados para MCP con soporte para implementaciones en la nube y locales.

FlowHunt proporciona una capa de seguridad adicional entre tus sistemas internos y las herramientas de IA, dándote control granular sobre qué herramientas son accesibles desde tus servidores MCP. Los servidores MCP alojados en nuestra infraestructura pueden integrarse perfectamente con el chatbot de FlowHunt, así como con plataformas de IA populares como ChatGPT, Claude y varios editores de IA.

El Servidor Deepseek Thinker MCP actúa como un proveedor de Model Context Protocol (MCP), entregando contenido de razonamiento del modelo Deepseek a clientes de IA habilitados para MCP, como Claude Desktop. Permite que los asistentes de IA accedan a los procesos de pensamiento y salidas de razonamiento de Deepseek, ya sea a través del servicio API de Deepseek o desde un servidor Ollama local. Al integrarse con este servidor, los desarrolladores pueden mejorar sus flujos de trabajo de IA con razonamiento enfocado, aprovechando la inferencia en la nube o local. Este servidor es especialmente útil en escenarios donde se requieren cadenas de razonamiento detalladas o salidas de cadena de pensamiento (CoT) para informar tareas posteriores de IA, siendo valioso para desarrollo avanzado, depuración y enriquecimiento de agentes de IA.

No se mencionan plantillas de prompts explícitas en el repositorio ni en la documentación.

No se detallan recursos MCP explícitos en la documentación o el código fuente.

originPrompt (string) — El prompt original del usuario.windsurf_config.json).mcpServers:{

"deepseek-thinker": {

"command": "npx",

"args": [

"-y",

"deepseek-thinker-mcp"

],

"env": {

"API_KEY": "<Your API Key>",

"BASE_URL": "<Your Base URL>"

}

}

}

claude_desktop_config.json.{

"mcpServers": {

"deepseek-thinker": {

"command": "npx",

"args": [

"-y",

"deepseek-thinker-mcp"

],

"env": {

"API_KEY": "<Your API Key>",

"BASE_URL": "<Your Base URL>"

}

}

}

}

{

"mcpServers": {

"deepseek-thinker": {

"command": "npx",

"args": [

"-y",

"deepseek-thinker-mcp"

],

"env": {

"API_KEY": "<Your API Key>",

"BASE_URL": "<Your Base URL>"

}

}

}

}

{

"mcpServers": {

"deepseek-thinker": {

"command": "npx",

"args": [

"-y",

"deepseek-thinker-mcp"

],

"env": {

"API_KEY": "<Your API Key>",

"BASE_URL": "<Your Base URL>"

}

}

}

}

Para todas las plataformas, las claves API y valores sensibles deben proporcionarse usando variables de entorno en la sección env. Ejemplo:

{

"mcpServers": {

"deepseek-thinker": {

"command": "npx",

"args": [

"-y",

"deepseek-thinker-mcp"

],

"env": {

"API_KEY": "<Your API Key>",

"BASE_URL": "<Your Base URL>"

}

}

}

}

Para el modo Ollama local, establece USE_OLLAMA en "true" en el objeto env:

"env": {

"USE_OLLAMA": "true"

}

Uso de MCP en FlowHunt

Para integrar servidores MCP en tu flujo de trabajo de FlowHunt, comienza añadiendo el componente MCP a tu flujo y conectándolo a tu agente de IA:

Haz clic en el componente MCP para abrir el panel de configuración. En la sección de configuración del sistema MCP, inserta los detalles de tu servidor MCP usando este formato JSON:

{

"deepseek-thinker": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

Una vez configurado, el agente de IA podrá usar este MCP como herramienta con acceso a todas sus funciones y capacidades. Recuerda cambiar “deepseek-thinker” por el nombre real de tu servidor MCP y establecer la URL correcta.

| Sección | Disponibilidad | Detalles/Notas |

|---|---|---|

| Resumen | ✅ | |

| Lista de Prompts | ⛔ | No se documentan plantillas de prompts |

| Lista de Recursos | ⛔ | No se encontraron recursos MCP explícitos |

| Lista de Herramientas | ✅ | Herramienta get-deepseek-thinker |

| Protección de claves API | ✅ | Variables de entorno en la configuración |

| Soporte de sampling (menos relevante aquí) | ⛔ | No mencionado |

Según las dos tablas siguientes, el Servidor Deepseek Thinker MCP proporciona una herramienta enfocada para la integración de razonamiento, es fácil de configurar, pero carece de plantillas de prompts detalladas y definiciones explícitas de recursos. El proyecto es open source, tiene una comunidad moderada y soporta gestión segura de credenciales. Su puntuación es de 6/10 en cuanto a completitud y utilidad como servidor MCP.

| ¿Tiene LICENSE? | ⛔ (No se detectó archivo LICENSE) |

|---|---|

| Tiene al menos una herramienta | ✅ |

| Número de forks | 12 |

| Número de estrellas | 51 |

Es un servidor Model Context Protocol que lleva el razonamiento del modelo Deepseek a clientes de IA habilitados para MCP, ofreciendo salidas de cadena de pensamiento y razonamiento transparente del modelo para flujos de trabajo avanzados de IA y depuración.

Ofrece la herramienta 'get-deepseek-thinker' para realizar razonamiento con el modelo Deepseek y devolver salidas estructuradas de razonamiento.

Sí, Deepseek Thinker soporta inferencias tanto en la nube como locales (Ollama). Establece la variable de entorno 'USE_OLLAMA' en 'true' para el modo local.

Las claves API y valores sensibles deben guardarse en la sección 'env' de la configuración de tu servidor MCP como variables de entorno, y no codificadas directamente en los archivos fuente.

Los límites los determina el modelo Deepseek o la API subyacente; si los superas, pueden truncarse las respuestas o producirse errores, así que ajusta tu configuración y entradas según sea necesario.

No se proporcionan plantillas de prompts explícitas ni recursos MCP adicionales como parte de la documentación actual del Servidor Deepseek Thinker MCP.

Integra el Servidor Deepseek Thinker MCP para dotar a tus agentes de IA de capacidades de razonamiento detalladas y mejorar los flujos de desarrollo.

El Servidor DeepSeek MCP actúa como un proxy seguro, conectando los avanzados modelos de lenguaje de DeepSeek con aplicaciones compatibles con MCP como Claude D...

El servidor DeepSeek MCP integra los avanzados modelos de lenguaje de DeepSeek con aplicaciones compatibles con MCP, proporcionando acceso API seguro y anonimiz...

El servidor Deepseek R1 MCP permite la integración fluida de los avanzados modelos de lenguaje de DeepSeek, como Deepseek R1 y V3, en Claude Desktop y otras pla...

Consentimiento de Cookies

Usamos cookies para mejorar tu experiencia de navegación y analizar nuestro tráfico. See our privacy policy.