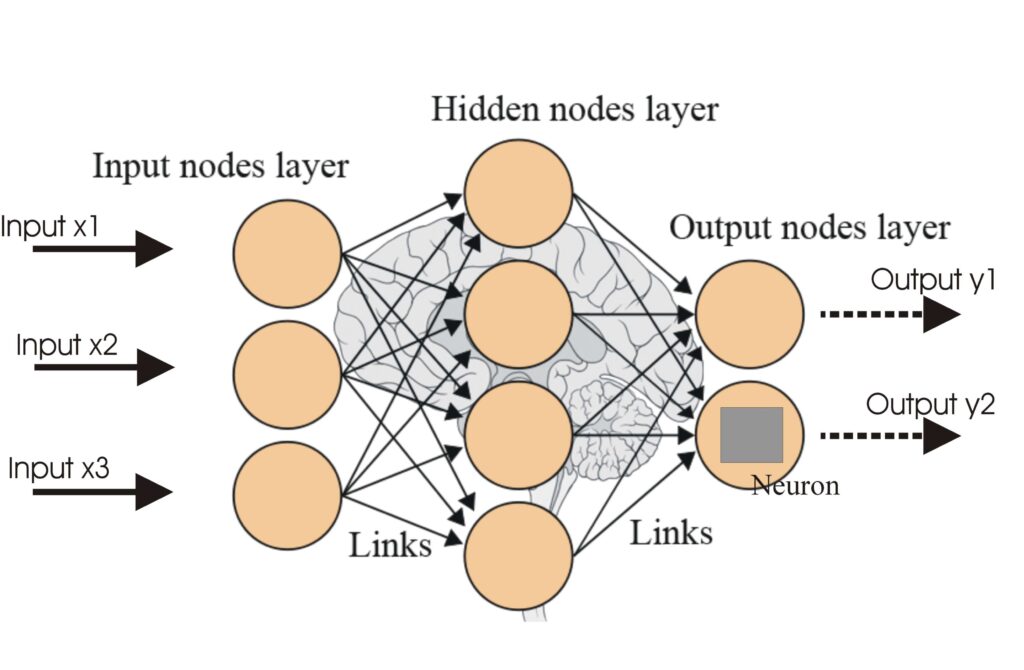

Réseaux de neurones artificiels (ANNs)

Les réseaux de neurones artificiels (ANNs) sont un sous-ensemble des algorithmes d'apprentissage automatique inspirés du cerveau humain. Ces modèles computation...

Les fonctions d’activation introduisent la non-linéarité dans les réseaux de neurones, leur permettant d’apprendre des motifs complexes essentiels aux applications d’IA et d’apprentissage profond.

Les fonctions d’activation sont fondamentales dans l’architecture des réseaux de neurones artificiels (ANN), influençant de manière significative la capacité du réseau à apprendre et à effectuer des tâches complexes. Cet article du glossaire explore les complexités des fonctions d’activation, en examinant leur objectif, leurs types et leurs applications, notamment dans les domaines de l’IA, de l’apprentissage profond et des réseaux de neurones.

Une fonction d’activation dans un réseau de neurones est une opération mathématique appliquée à la sortie d’un neurone. Elle détermine si un neurone doit être activé ou non, introduisant de la non-linéarité dans le modèle, ce qui permet au réseau d’apprendre des motifs complexes. Sans ces fonctions, un réseau de neurones se comporterait essentiellement comme un modèle de régression linéaire, quel que soit son nombre de couches ou sa profondeur.

Fonction sigmoïde

Fonction Tanh

ReLU (Rectified Linear Unit)

Leaky ReLU

Fonction Softmax

Fonction Swish

Les fonctions d’activation sont essentielles pour diverses applications de l’IA, notamment :

Une fonction d’activation est une opération mathématique appliquée à la sortie d’un neurone, introduisant de la non-linéarité et permettant aux réseaux de neurones d’apprendre des motifs complexes au-delà des simples relations linéaires.

Les fonctions d’activation permettent aux réseaux de neurones de résoudre des problèmes complexes et non linéaires en leur donnant la capacité d’apprendre des motifs sophistiqués, ce qui les rend essentielles pour des tâches telles que la classification d’images, le traitement du langage et l’automatisation.

Les types courants incluent Sigmoïde, Tanh, ReLU, Leaky ReLU, Softmax et Swish, chacun présentant des caractéristiques et des cas d’utilisation uniques selon les couches des réseaux de neurones.

Les défis courants incluent le problème du gradient qui disparaît (notamment avec Sigmoïde et Tanh), le ReLU mourant, et le coût computationnel pour des fonctions comme Softmax dans les applications en temps réel.

Les réseaux de neurones artificiels (ANNs) sont un sous-ensemble des algorithmes d'apprentissage automatique inspirés du cerveau humain. Ces modèles computation...

Un réseau de neurones, ou réseau de neurones artificiel (ANN), est un modèle computationnel inspiré du cerveau humain, essentiel en IA et en apprentissage autom...

Les réseaux de neurones récurrents (RNN) sont une classe sophistiquée de réseaux de neurones artificiels conçus pour traiter des données séquentielles en utilis...

Consentement aux Cookies

Nous utilisons des cookies pour améliorer votre expérience de navigation et analyser notre trafic. See our privacy policy.