Recherche d'Information

La recherche d'information exploite l'IA, le traitement du langage naturel (NLP) et l'apprentissage automatique pour récupérer efficacement et précisément les d...

La recherche IA exploite l’apprentissage automatique et les embeddings vectoriels pour comprendre l’intention et le contexte de la recherche, fournissant des résultats hautement pertinents au-delà des correspondances exactes de mots-clés.

La recherche IA utilise l’apprentissage automatique pour comprendre le contexte et l’intention des requêtes de recherche, les transformant en vecteurs numériques pour des résultats plus précis. Contrairement aux recherches traditionnelles par mots-clés, la recherche IA interprète les relations sémantiques, ce qui la rend efficace pour divers types de données et de langues.

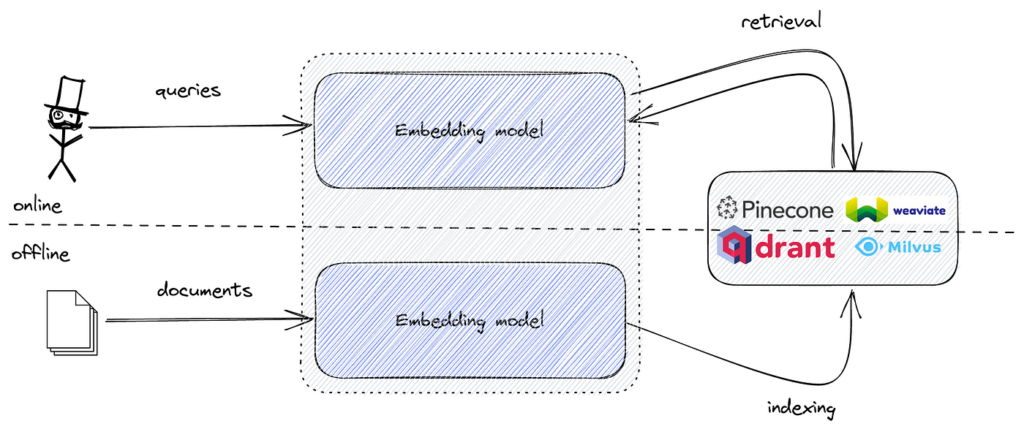

La recherche IA, souvent appelée recherche sémantique ou vectorielle, est une méthodologie de recherche qui exploite des modèles d’apprentissage automatique pour comprendre l’intention et le sens contextuel derrière les requêtes. Contrairement à la recherche traditionnelle basée sur les mots-clés, la recherche IA transforme les données et les requêtes en représentations numériques appelées vecteurs ou embeddings. Cela permet au moteur de recherche de comprendre les relations sémantiques entre différentes données, fournissant des résultats plus pertinents et précis même lorsque les mots-clés exacts sont absents.

La recherche IA représente une évolution significative des technologies de recherche. Les moteurs de recherche traditionnels reposent fortement sur la correspondance de mots-clés, où la présence de termes spécifiques dans la requête et les documents détermine la pertinence. La recherche IA, cependant, utilise des modèles d’apprentissage automatique pour saisir le contexte et le sens sous-jacents des requêtes et des données.

En convertissant des textes, images, audios et autres données non structurées en vecteurs de haute dimension, la recherche IA peut mesurer la similarité entre différents contenus. Cette approche permet au moteur de recherche de fournir des résultats contextuellement pertinents, même s’ils ne contiennent pas exactement les mots-clés utilisés dans la requête.

Composants clés :

Au cœur de la recherche IA se trouve le concept d’embeddings vectoriels. Les embeddings vectoriels sont des représentations numériques de données qui capturent la signification sémantique de textes, d’images ou d’autres types de données. Ces embeddings positionnent des données similaires à proximité les unes des autres dans un espace vectoriel multidimensionnel.

Comment cela fonctionne :

Exemple :

Les moteurs de recherche traditionnels reposent sur la correspondance des termes de la requête avec les documents contenant ces termes. Ils utilisent des techniques telles que les index inversés et la fréquence des termes pour classer les résultats.

Limites de la recherche par mots-clés :

Avantages de la recherche IA :

| Aspect | Recherche par mots-clés | Recherche IA (sémantique/vectorielle) |

|---|---|---|

| Correspondance | Correspondances exactes de mots-clés | Similarité sémantique |

| Compréhension du contexte | Limitée | Élevée |

| Gestion des synonymes | Listes de synonymes manuelles requises | Automatique via les embeddings |

| Fautes d’orthographe | Peut échouer sans recherche floue | Plus tolérante grâce au contexte sémantique |

| Compréhension de l’intention | Minimale | Importante |

La recherche sémantique est une application centrale de la recherche IA qui se concentre sur la compréhension de l’intention de l’utilisateur et du sens contextuel des requêtes.

Processus :

Techniques clés :

Scores de similarité :

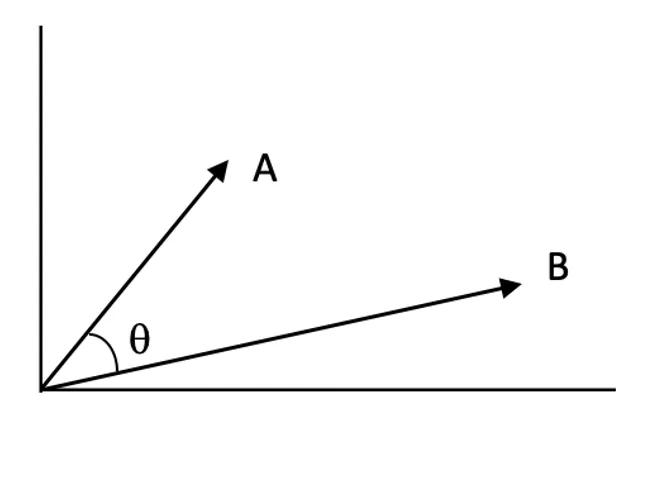

Les scores de similarité quantifient le degré de proximité de deux vecteurs dans l’espace vectoriel. Un score élevé indique une forte pertinence entre la requête et un document.

Algorithmes Approximate Nearest Neighbor (ANN) :

Trouver les plus proches voisins exacts dans des espaces de haute dimension est coûteux en calcul. Les algorithmes ANN fournissent des approximations efficaces.

La recherche IA ouvre un large éventail d’applications dans divers secteurs grâce à sa capacité à comprendre et interpréter les données au-delà de la simple correspondance de mots-clés.

Description : La recherche sémantique améliore l’expérience utilisateur en interprétant l’intention derrière les requêtes et en fournissant des résultats contextuels pertinents.

Exemples :

Description : En comprenant les préférences et comportements utilisateurs, la recherche IA peut fournir des recommandations personnalisées de contenus ou produits.

Exemples :

Description : La recherche IA permet aux systèmes de comprendre et répondre aux requêtes par des informations précises extraites de documents.

Exemples :

Description : La recherche IA peut indexer et rechercher dans des données non structurées comme images, audio et vidéos en les convertissant en embeddings.

Exemples :

Intégrer la recherche IA dans l’automatisation et les chatbots améliore significativement leurs capacités.

Bénéfices :

Étapes de mise en œuvre :

Exemple d’usage :

Bien que la recherche IA offre de nombreux avantages, certains défis doivent être considérés :

Stratégies d’atténuation :

La recherche sémantique et vectorielle en IA s’impose comme une alternative puissante à la recherche traditionnelle par mots-clés et floue, améliorant nettement la pertinence et la précision des résultats en comprenant le contexte et le sens des requêtes.

Lors de la mise en œuvre d’une recherche sémantique, les données textuelles sont converties en embeddings vectoriels qui capturent la signification du texte. Ces embeddings sont des représentations numériques de haute dimension. Pour rechercher efficacement les embeddings et trouver les plus similaires à une requête, un outil optimisé pour la recherche de similarité dans des espaces de haute dimension est nécessaire.

FAISS fournit les algorithmes et structures de données nécessaires pour accomplir cette tâche efficacement. En combinant des embeddings sémantiques et FAISS, on peut créer un moteur de recherche sémantique performant capable de gérer de grands ensembles de données avec une faible latence.

La mise en œuvre d’une recherche sémantique avec FAISS en Python se déroule en plusieurs étapes :

Détaillons chaque étape.

Préparez votre jeu de données (ex : articles, tickets de support, descriptions produits).

Exemple :

documents = [

"Comment réinitialiser votre mot de passe sur notre plateforme.",

"Dépannage des problèmes de connectivité réseau.",

"Guide d'installation des mises à jour logicielles.",

"Bonnes pratiques pour la sauvegarde et la récupération des données.",

"Configurer l'authentification à deux facteurs pour une sécurité accrue."

]

Nettoyez et formatez les textes selon les besoins.

Convertissez les textes en embeddings vectoriels à l’aide de modèles Transformer pré-entraînés (librairies transformers ou sentence-transformers).

Exemple :

from sentence_transformers import SentenceTransformer

import numpy as np

# Charger un modèle pré-entraîné

model = SentenceTransformer('sentence-transformers/all-MiniLM-L6-v2')

# Générer les embeddings pour tous les documents

embeddings = model.encode(documents, convert_to_tensor=False)

embeddings = np.array(embeddings).astype('float32')

float32 comme l’exige FAISS.Créez un index FAISS pour stocker les embeddings et permettre une recherche efficace.

Exemple :

import faiss

embedding_dim = embeddings.shape[1]

index = faiss.IndexFlatL2(embedding_dim)

index.add(embeddings)

IndexFlatL2 effectue une recherche exhaustive selon la distance L2 (euclidienne).Convertissez la requête utilisateur en embedding et trouvez les voisins les plus proches.

Exemple :

query = "Comment puis-je changer mon mot de passe de compte ?"

query_embedding = model.encode([query], convert_to_tensor=False)

query_embedding = np.array(query_embedding).astype('float32')

k = 3

distances, indices = index.search(query_embedding, k)

Utilisez les indices pour afficher les documents les plus pertinents.

Exemple :

print("Meilleurs résultats pour votre requête :")

for idx in indices[0]:

print(documents[idx])

Sortie attendue :

Meilleurs résultats pour votre requête :

Comment réinitialiser votre mot de passe sur notre plateforme.

Configurer l'authentification à deux facteurs pour une sécurité accrue.

Bonnes pratiques pour la sauvegarde et la récupération des données.

FAISS propose plusieurs types d’index :

Utilisation d’un index à fichiers inversés (IndexIVFFlat) :

nlist = 100

quantizer = faiss.IndexFlatL2(embedding_dim)

index = faiss.IndexIVFFlat(quantizer, embedding_dim, nlist, faiss.METRIC_L2)

index.train(embeddings)

index.add(embeddings)

Normalisation et recherche par produit scalaire :

L’utilisation de la similarité cosinus peut être plus efficace pour les données textuelles

La recherche IA est une méthodologie de recherche moderne qui utilise l'apprentissage automatique et les embeddings vectoriels pour comprendre l'intention et le sens contextuel des requêtes, fournissant des résultats plus précis et pertinents que la recherche traditionnelle basée sur les mots-clés.

Contrairement à la recherche basée sur les mots-clés, qui repose sur des correspondances exactes, la recherche IA interprète les relations sémantiques et l'intention derrière les requêtes, ce qui la rend efficace pour le langage naturel et les entrées ambiguës.

Les embeddings vectoriels sont des représentations numériques de textes, d'images ou d'autres types de données qui capturent leur signification sémantique, permettant au moteur de recherche de mesurer la similarité et le contexte entre différentes données.

La recherche IA alimente la recherche sémantique dans le e-commerce, les recommandations personnalisées dans le streaming, les systèmes de questions-réponses dans le support client, la navigation dans les données non structurées et la recherche documentaire dans la recherche et l'entreprise.

Les outils populaires incluent FAISS pour la recherche efficace de similarité vectorielle, et des bases de données vectorielles comme Pinecone, Milvus, Qdrant, Weaviate, Elasticsearch et Pgvector pour le stockage et la récupération évolutifs des embeddings.

En intégrant la recherche IA, les chatbots et systèmes d'automatisation peuvent comprendre les requêtes des utilisateurs plus en profondeur, récupérer des réponses contextuellement pertinentes et fournir des réponses dynamiques et personnalisées.

Les défis incluent des besoins computationnels élevés, la complexité de l'interprétabilité des modèles, la nécessité de données de haute qualité et la garantie de la confidentialité et de la sécurité des informations sensibles.

FAISS est une bibliothèque open source pour la recherche efficace de similarité sur des embeddings vectoriels de haute dimension, largement utilisée pour construire des moteurs de recherche sémantique capables de gérer des jeux de données à grande échelle.

Découvrez comment la recherche sémantique alimentée par l'IA peut transformer votre recherche d'information, vos chatbots et vos flux d'automatisation.

La recherche d'information exploite l'IA, le traitement du langage naturel (NLP) et l'apprentissage automatique pour récupérer efficacement et précisément les d...

Découvrez ce qu'est un moteur d'Insight — une plateforme avancée, pilotée par l'IA, qui améliore la recherche et l'analyse de données en comprenant le contexte ...

Perplexity AI est un moteur de recherche avancé alimenté par l'IA et un outil conversationnel qui exploite le traitement du langage naturel et l'apprentissage a...

Consentement aux Cookies

Nous utilisons des cookies pour améliorer votre expérience de navigation et analyser notre trafic. See our privacy policy.