Génération augmentée par récupération vs génération augmentée par cache (CAG vs. RAG)

Découvrez les principales différences entre la génération augmentée par récupération (RAG) et la génération augmentée par cache (CAG) en IA. Apprenez comment RA...

Les questions-réponses avec RAG améliorent les LLM en intégrant la récupération de données en temps réel et la génération de langage naturel pour des réponses précises et contextuellement pertinentes.

Les questions-réponses avec la génération augmentée par récupération (RAG) améliorent les modèles de langage en intégrant des données externes en temps réel pour des réponses précises et pertinentes. Cette approche optimise les performances dans des domaines dynamiques, offrant une meilleure précision, un contenu dynamique et une pertinence accrue.

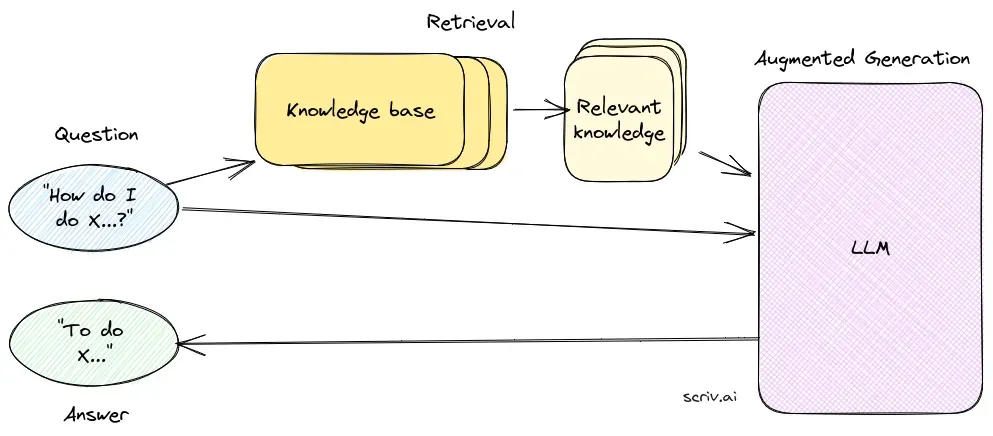

Les questions-réponses avec la génération augmentée par récupération (RAG) représentent une méthode innovante combinant les forces de la recherche d’informations et de la génération de langage naturel (qui crée un texte de type humain à partir des données, améliorant l’IA, les chatbots, les rapports et la personnalisation des expériences). Cette approche hybride renforce les capacités des grands modèles de langage (LLM) en complétant leurs réponses par des informations pertinentes et à jour récupérées depuis des sources de données externes. Contrairement aux méthodes traditionnelles qui reposent uniquement sur des modèles pré-entraînés, la RAG intègre dynamiquement des données externes, permettant aux systèmes de fournir des réponses plus précises et contextuelles, en particulier dans les domaines nécessitant les informations les plus récentes ou des connaissances spécialisées.

La RAG optimise les performances des LLM en veillant à ce que les réponses ne soient pas seulement générées à partir d’un ensemble de données internes, mais aussi enrichies par des sources externes, fiables et en temps réel. Cette approche est cruciale pour les tâches de questions-réponses dans des domaines où l’information évolue constamment.

Le composant de récupération est responsable de la recherche d’informations pertinentes dans de vastes ensembles de données, généralement stockés dans une base de données vectorielle. Ce composant utilise des techniques de recherche sémantique pour identifier et extraire les segments de texte ou les documents les plus pertinents pour la requête de l’utilisateur.

Le composant de génération, généralement un LLM tel que GPT-3 ou BERT, synthétise une réponse en combinant la requête originale de l’utilisateur avec le contexte récupéré. Ce composant est essentiel pour générer des réponses cohérentes et appropriées au contexte.

La mise en place d’un système RAG implique plusieurs étapes techniques :

Recherches sur les questions-réponses avec la génération augmentée par récupération (RAG)

La génération augmentée par récupération (RAG) est une méthode qui améliore les systèmes de questions-réponses en combinant des mécanismes de récupération et des modèles génératifs. Des recherches récentes ont exploré l’efficacité et l’optimisation de la RAG dans divers contextes.

La RAG est une méthode qui combine la recherche d'informations et la génération de langage naturel pour fournir des réponses précises et à jour en intégrant des sources de données externes dans les grands modèles de langage.

Un système RAG se compose d'un composant de récupération, qui recherche des informations pertinentes dans des bases de données vectorielles à l'aide de la recherche sémantique, et d'un composant de génération, généralement un LLM, qui synthétise les réponses à partir de la requête utilisateur et du contexte récupéré.

La RAG améliore la précision en récupérant des informations contextuellement pertinentes, prend en charge la mise à jour dynamique des contenus à partir de bases de connaissances externes et améliore la pertinence et la qualité des réponses générées.

Les cas d'utilisation courants incluent les chatbots IA, le support client, la création automatisée de contenu et les outils éducatifs nécessitant des réponses précises, contextuelles et à jour.

Les systèmes RAG peuvent être gourmands en ressources, nécessitent une intégration soignée pour des performances optimales, et doivent garantir l'exactitude factuelle des informations récupérées pour éviter des réponses trompeuses ou obsolètes.

Découvrez comment la génération augmentée par récupération peut améliorer vos solutions de chatbot et de support avec des réponses en temps réel et précises.

Découvrez les principales différences entre la génération augmentée par récupération (RAG) et la génération augmentée par cache (CAG) en IA. Apprenez comment RA...

La Génération augmentée par récupération (RAG) est un cadre d'IA avancé qui combine les systèmes traditionnels de récupération d'information avec des modèles de...

LazyGraphRAG est une approche innovante de la génération augmentée par la récupération (RAG), optimisant l'efficacité et réduisant les coûts de la récupération ...

Consentement aux Cookies

Nous utilisons des cookies pour améliorer votre expérience de navigation et analyser notre trafic. See our privacy policy.