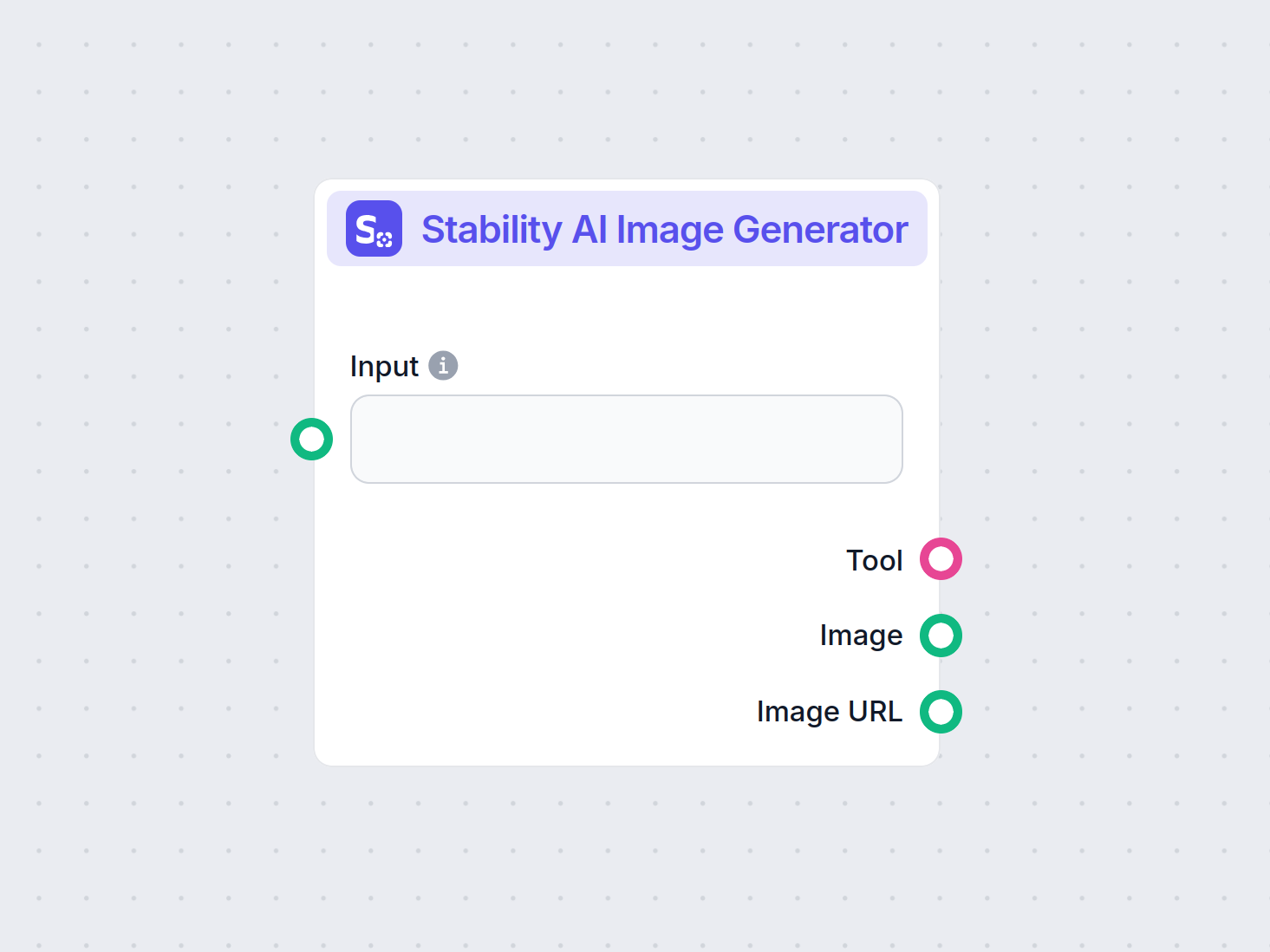

Générateur d’Images Stability AI

Générez des images de haute qualité à partir de prompts textuels avec le composant Générateur d’Images Stability AI. Propulsé par les modèles Stable Diffusion, ...

Stable Diffusion est un modèle IA texte-vers-image de pointe permettant aux utilisateurs de générer des visuels photoréalistes à partir d’invites grâce à des techniques avancées de diffusion latente et d’apprentissage profond.

Stable Diffusion est un modèle IA texte-vers-image qui crée des images de haute qualité à partir de descriptions en utilisant l’apprentissage profond. Il emploie des techniques comme les invites négatives et les images de référence pour de meilleurs résultats, notamment avec des éléments complexes comme les mains.

Stable Diffusion est un modèle avancé de génération d’images à partir de texte qui utilise des techniques d’apprentissage profond pour produire des images photoréalistes de haute qualité à partir de descriptions textuelles. Développé comme un modèle de diffusion latente, il représente une avancée significative dans le domaine de l’intelligence artificielle générative, combinant les principes des modèles de diffusion et de l’apprentissage automatique pour créer des images correspondant étroitement aux invites textuelles fournies.

Stable Diffusion utilise l’apprentissage profond et les modèles de diffusion pour générer des images en raffinant un bruit aléatoire afin de créer des visuels cohérents. Malgré son entraînement massif sur des millions d’images, il rencontre des difficultés avec des éléments complexes comme les mains. Avec le temps, à mesure que les modèles sont entraînés sur des ensembles de données de plus en plus importants, ces problèmes se réduisent et la qualité des images devient de plus en plus réaliste.

Une méthode efficace pour résoudre le problème des mains consiste à utiliser des invites négatives. En ajoutant des phrases comme (-bad anatomy) ou (-bad hands -unnatural hands) à vos invites, vous pouvez indiquer à l’IA d’éviter de produire des caractéristiques déformées. Faites attention à ne pas surutiliser les invites négatives, car elles pourraient limiter la créativité du modèle.

Une autre technique consiste à utiliser des images de référence pour guider l’IA. En incluant une balise {image} avec un lien vers une image de référence dans votre invite, vous fournissez à l’IA un modèle visuel pour un rendu précis des mains. Cela est particulièrement utile pour maintenir des proportions et des poses correctes.

Pour de meilleurs résultats, combinez les invites négatives et les images de référence. Cette approche duale permet à l’IA d’éviter les erreurs courantes tout en s’inspirant de bons exemples.

(-bent fingers) ou (realistic perspectives) pour améliorer encore la qualité des mains.En maîtrisant ces techniques, vous pouvez considérablement améliorer le rendu des mains dans vos créations avec Stable Diffusion et obtenir des œuvres dignes d’un artiste chevronné. Rassemblez vos images de référence, rédigez des invites précises et regardez votre art IA évoluer !

Au cœur de son fonctionnement, Stable Diffusion transforme des invites textuelles en représentations visuelles à travers une série de processus informatiques. Comprendre son fonctionnement implique de se plonger dans les concepts de modèles de diffusion, d’espaces latents et de réseaux de neurones.

Les modèles de diffusion sont une classe de modèles génératifs en apprentissage automatique qui apprennent à créer des données en inversant un processus de diffusion. Ce dernier consiste à ajouter progressivement du bruit aux données — telles que des images — jusqu’à ce qu’elles deviennent indiscernables du bruit aléatoire. Le modèle apprend ensuite à inverser ce processus, en supprimant le bruit étape par étape pour récupérer les données originales. Ce processus de diffusion inverse est essentiel pour générer de nouvelles données cohérentes à partir de bruit aléatoire.

Stable Diffusion utilise spécifiquement un modèle de diffusion latente. Contrairement aux modèles de diffusion traditionnels qui opèrent directement dans l’espace pixel de haute dimension des images, les modèles de diffusion latente travaillent dans un espace latent compressé. Cet espace latent est une représentation des données en plus faible dimension, capturant les caractéristiques essentielles tout en réduisant la complexité informatique. En opérant dans l’espace latent, Stable Diffusion peut générer des images haute résolution plus efficacement.

Le mécanisme central de Stable Diffusion repose sur le processus de diffusion inverse dans l’espace latent. En partant d’un vecteur latent aléatoire, le modèle affine itérativement cette représentation latente en prédisant et supprimant le bruit à chaque étape. Ce raffinement est guidé par la description textuelle fournie par l’utilisateur. Le processus se poursuit jusqu’à ce que le vecteur latent converge vers un état qui, une fois décodé, produit une image conforme à l’invite textuelle.

L’architecture de Stable Diffusion intègre plusieurs composants clés qui travaillent ensemble pour transformer les invites textuelles en images.

Le VAE sert de système encodeur-décodeur qui compresse les images dans l’espace latent et les reconstruit en images. L’encodeur transforme une image en sa représentation latente, capturant les caractéristiques fondamentales sous une forme réduite. Le décodeur prend cette représentation latente et la reconstruit en image détaillée.

Ce processus est crucial car il permet au modèle de travailler avec des données de plus faible dimension, réduisant ainsi significativement les ressources informatiques par rapport à un traitement dans l’espace pixel complet.

Le U-Net est une architecture de réseau de neurones spécialisée utilisée dans Stable Diffusion pour les tâches de traitement d’images. Il se compose d’un chemin d’encodage et d’un chemin de décodage avec des connexions de saut entre les couches miroirs. Dans le cadre de Stable Diffusion, le U-Net agit comme prédicteur de bruit durant le processus de diffusion inverse.

À chaque étape de la diffusion, le U-Net prédit la quantité de bruit présente dans la représentation latente. Cette prédiction est ensuite utilisée pour affiner le vecteur latent en soustrayant le bruit estimé, débruitant progressivement l’espace latent vers une image conforme à l’invite texte.

Pour intégrer l’information textuelle, Stable Diffusion utilise un encodeur de texte basé sur le modèle CLIP (Contrastive Language-Image Pretraining). CLIP est conçu pour comprendre et relier les informations textuelles et visuelles en les mappant dans un espace latent commun.

Lorsqu’un utilisateur saisit une invite textuelle, l’encodeur de texte convertit cette invite en une série d’embeddings — des représentations numériques des données textuelles. Ces embeddings conditionnent le U-Net lors du processus de diffusion inverse, guidant la génération d’image pour refléter le contenu de l’invite.

Stable Diffusion offre une grande polyvalence dans la génération d’images et peut être utilisé de différentes manières selon les besoins.

L’utilisation principale de Stable Diffusion est la génération d’images à partir d’invites textuelles. Les utilisateurs saisissent un texte descriptif, et le modèle génère une image qui illustre la description. Par exemple, un utilisateur peut entrer « Une plage paisible au coucher du soleil avec des palmiers » et obtenir une image représentant cette scène.

Cette capacité est particulièrement précieuse dans les industries créatives, la création de contenu et le design, où la visualisation rapide des concepts est essentielle.

Au-delà de la génération d’images à partir de zéro, Stable Diffusion peut également modifier des images existantes selon des instructions textuelles. En fournissant une image de départ et une invite, le modèle peut produire une nouvelle image incorporant les changements décrits.

Par exemple, un utilisateur peut soumettre une image d’un paysage urbain de jour avec l’invite « changer en nuit avec des lumières néon », et obtenir une image reflétant ces modifications.

L’inpainting consiste à remplir des parties manquantes ou corrompues d’une image. Stable Diffusion excelle dans ce domaine grâce à l’utilisation d’invites textuelles pour guider la reconstruction des zones spécifiques. Les utilisateurs peuvent masquer des portions d’image et fournir une description textuelle de ce qui doit remplir l’espace.

Cette fonctionnalité est utile pour la restauration de photos, la suppression d’objets indésirables ou la modification de certains éléments tout en gardant l’image cohérente.

En générant des séquences d’images avec de légères variations, Stable Diffusion peut être étendu pour créer des animations ou du contenu vidéo. Des outils comme Deforum améliorent les capacités de Stable Diffusion pour produire du contenu visuel dynamique guidé par des invites textuelles dans le temps.

Cela ouvre des perspectives en animation, effets visuels et génération dynamique de contenu sans avoir recours aux techniques traditionnelles d’animation image par image.

La capacité de Stable Diffusion à générer des images à partir de descriptions textuelles en fait un outil puissant pour l’automatisation IA et le développement de chatbots.

L’intégration de Stable Diffusion dans les chatbots permet de générer du contenu visuel en réponse aux requêtes des utilisateurs. Par exemple, dans un service client, un chatbot pourrait fournir des guides visuels ou illustrations générés à la volée pour aider les utilisateurs.

Les invites textuelles sont converties en embeddings à l’aide de l’encodeur de texte CLIP. Ces embeddings sont essentiels pour conditionner le processus de génération d’image, assurant que l’image produite correspond à la description fournie.

Le processus de diffusion inverse consiste à affiner de façon itérative la représentation latente en supprimant le bruit prédit. À chaque étape, le modèle prend en compte les embeddings textuels et l’état actuel du vecteur latent pour prédire précisément la composante de bruit.

L’efficacité du modèle dans la gestion des images bruitées provient de son entraînement sur de grands ensembles de données où il apprend à distinguer et débruiter efficacement les images. Cet entraînement lui permet de générer des images nettes même à partir de bruit aléatoire.

Travailler dans l’espace latent offre une efficacité informatique. Comme l’espace latent comporte moins de dimensions que l’espace pixel, les opérations sont moins gourmandes en ressources. Cette efficacité permet à Stable Diffusion de générer des images haute résolution sans exigences informatiques excessives.

Les artistes et designers peuvent utiliser Stable Diffusion pour prototyper rapidement des visuels à partir de descriptions conceptuelles, facilitant le processus créatif et réduisant le délai entre l’idée et la visualisation.

Les équipes marketing peuvent générer des visuels personnalisés pour les campagnes, les réseaux sociaux et la publicité sans avoir besoin de ressources graphiques importantes.

Les développeurs de jeux peuvent créer des assets, des environnements et de l’art conceptuel en fournissant des invites descriptives, optimisant ainsi la création de ressources.

Les commerçants peuvent générer des images de produits dans divers contextes ou configurations, améliorant la visualisation et l’expérience client.

Les enseignants et créateurs de contenu peuvent produire des illustrations et schémas pour expliquer des concepts complexes, rendant les supports pédagogiques plus attractifs.

Les chercheurs en intelligence artificielle et vision par ordinateur peuvent utiliser Stable Diffusion pour approfondir l’exploration des modèles de diffusion et des espaces latents.

Pour utiliser efficacement Stable Diffusion, certaines considérations techniques sont à prendre en compte.

Pour commencer avec Stable Diffusion, suivez ces étapes :

Pour les développeurs construisant des systèmes d’automatisation IA et des chatbots, Stable Diffusion peut être intégré pour enrichir les fonctionnalités.

Lors de l’utilisation de Stable Diffusion, il est important de prendre en compte les implications éthiques.

La diffusion stable est un sujet majeur dans le domaine des modèles génératifs, notamment pour l’augmentation de données et la synthèse d’images. Des études récentes ont exploré divers aspects de la diffusion stable, mettant en avant ses applications et son efficacité.

Diffusion Least Mean P-Power Algorithms for Distributed Estimation in Alpha-Stable Noise Environments par Fuxi Wen (2013) :

Présente un algorithme de diffusion least mean p-power (LMP) conçu pour l’estimation distribuée dans des environnements caractérisés par un bruit alpha-stable. L’étude compare la méthode de diffusion LMP à l’algorithme de diffusion least mean squares (LMS) et démontre une performance améliorée dans des conditions de bruit alpha-stable. Cette recherche est cruciale pour développer des techniques d’estimation robustes dans des environnements bruités. Lire la suite

Stable Diffusion for Data Augmentation in COCO and Weed Datasets par Boyang Deng (2024) :

Étudie l’utilisation de modèles de diffusion stable pour générer des images synthétiques haute résolution afin d’améliorer de petits jeux de données. En s’appuyant sur des techniques comme la traduction image-à-image, Dreambooth et ControlNet, la recherche évalue l’efficacité de la diffusion stable dans les tâches de classification et de détection. Les résultats suggèrent des applications prometteuses de la diffusion stable dans divers domaines. Lire la suite

Diffusion and Relaxation Controlled by Tempered α-stable Processes par Aleksander Stanislavsky, Karina Weron et Aleksander Weron (2011) :

Détaille les propriétés de la diffusion anormale et de la relaxation non exponentielle à partir de processus α-stable tempérés. L’article traite la difficulté des moments infinis associés au temps opérationnel aléatoire α-stable et propose un modèle qui inclut la subdiffusion comme cas particulier. Lire la suite

Evaluating a Synthetic Image Dataset Generated with Stable Diffusion par Andreas Stöckl (2022) :

Évalue les images synthétiques générées par le modèle Stable Diffusion à l’aide de la taxonomie Wordnet. L’étude examine la capacité du modèle à produire des images correctes pour divers concepts, illustrant les différences de précision de représentation. Ces évaluations sont essentielles pour comprendre le rôle de la diffusion stable dans l’augmentation de données. Lire la suite

Comparative Analysis of Generative Models: Enhancing Image Synthesis with VAEs, GANs, and Stable Diffusion par Sanchayan Vivekananthan (2024) :

Explore trois cadres génératifs : VAE, GAN et modèles de diffusion stable. L’étude met en lumière les forces et faiblesses de chaque modèle, notant que, bien que les VAE et GAN aient leurs avantages, la diffusion stable excelle dans certaines tâches de synthèse. Lire la suite

Voyons comment implémenter un modèle Stable Diffusion en Python à l’aide de la bibliothèque Diffusers de Hugging Face.

Installez les bibliothèques nécessaires :

pip install torch transformers diffusers accelerate

pip install xformers # Optionnel

La bibliothèque Diffusers permet de charger facilement des modèles pré-entraînés :

from diffusers import StableDiffusionPipeline

import torch

# Charger le modèle Stable Diffusion

model_id = "stabilityai/stable-diffusion-2-1"

pipe = StableDiffusionPipeline.from_pretrained(model_id, torch_dtype=torch.float16)

pipe = pipe.to("cuda") # Déplacer le modèle sur GPU pour une inférence plus rapide

Pour générer une image, fournissez simplement une invite textuelle :

prompt = "Un paysage serein avec des montagnes et un lac, photoréaliste, résolution 8K"

image = pipe(prompt).images[0]

# Sauvegarder ou afficher l’image

image.save("generated_image.png")

model_id.torch.float16 réduit l’utilisation mémoire.Vous pouvez personnaliser divers paramètres :

image = pipe(

prompt=prompt,

num_inference_steps=50, # Nombre d’étapes de débruitage

guidance

Stable Diffusion est un modèle d’IA avancé conçu pour générer des images photoréalistes de haute qualité à partir d’invites textuelles. Il utilise la diffusion latente et l’apprentissage profond pour transformer les descriptions textuelles en visuels.

Stable Diffusion fonctionne en convertissant les invites textuelles en embeddings d’image à l’aide d’un encodeur de texte CLIP, puis en débruitant de manière itérative une représentation latente guidée par l’invite, produisant ainsi une image cohérente.

Stable Diffusion est utilisé pour la création de contenus créatifs, le matériel marketing, la création d’assets pour les jeux vidéo, la visualisation de produits pour l’e-commerce, les illustrations éducatives et les chatbots alimentés par l’IA.

Oui, Stable Diffusion prend en charge la traduction image-à-image et l’inpainting, permettant aux utilisateurs de modifier des images existantes ou de compléter des parties manquantes à l’aide d’invites textuelles.

Un ordinateur équipé d’un GPU moderne est recommandé pour générer efficacement des images avec Stable Diffusion. Le modèle nécessite également Python et des bibliothèques telles que PyTorch et Diffusers.

Oui, Stable Diffusion est diffusé sous une licence open source permissive, encourageant les contributions de la communauté, la personnalisation et l’accessibilité large.

Libérez votre créativité avec Stable Diffusion et voyez comment l’IA peut transformer vos idées en visuels époustouflants.

Générez des images de haute qualité à partir de prompts textuels avec le composant Générateur d’Images Stability AI. Propulsé par les modèles Stable Diffusion, ...

Le Modèle Flux AI de Black Forest Labs est un système avancé de génération d'images à partir de texte qui convertit des instructions en langage naturel en image...

Découvrez notre analyse approfondie de Stability AI SD3 Large. Analysez ses points forts, ses faiblesses et ses résultats créatifs à travers divers prompts text...

Consentement aux Cookies

Nous utilisons des cookies pour améliorer votre expérience de navigation et analyser notre trafic. See our privacy policy.