Observabilité de FlowHunt dans PowerBI

Apprenez à intégrer FlowHunt avec PowerBI, à configurer les paramètres d'observabilité et à visualiser les métriques de votre espace de travail FlowHunt directe...

Cet article explique comment connecter FlowHunt à Langfuse pour une observabilité complète, tracer les performances des workflows IA et exploiter les tableaux de bord Langfuse pour surveiller et optimiser votre espace de travail FlowHunt.

À mesure que vos workflows IA dans FlowHunt montent en charge, comprendre ce qui se passe en coulisses devient essentiel. Des questions comme « Pourquoi ce workflow est-il lent ? », « Combien de tokens suis-je en train de consommer ? » ou « Où se produisent les erreurs ? » nécessitent une visibilité détaillée sur votre système.

Sans une bonne observabilité, déboguer des workflows IA revient à piloter à l’aveugle : vous voyez le résultat mais ratez tout le chemin. Des outils de tracing comme Langfuse résolvent ce problème en capturant chaque étape de l’exécution de vos workflows, offrant des informations fines sur la performance, les coûts et le comportement.

Cet article explique comment connecter FlowHunt à Langfuse en toute transparence, permettant une observabilité complète sur tous vos workflows IA. Vous apprendrez à tracer les chemins d’exécution, surveiller la consommation de tokens, identifier les goulets d’étranglement et visualiser les métriques de performance — tout cela depuis un tableau de bord centralisé.

À la fin de cet article, vous bénéficierez d’une visibilité totale sur votre espace de travail FlowHunt, ce qui vous permettra d’optimiser vos workflows, de réduire les coûts et d’assurer la fiabilité.

L’observabilité consiste à instrumenter votre système pour comprendre son état interne via des sorties externes — principalement les traces, métriques et logs.

Pour les utilisateurs de FlowHunt exploitant des workflows propulsés par l’IA, l’observabilité permet de visualiser :

Sans observabilité, diagnostiquer un problème devient réactif et chronophage. Avec elle, vous obtenez des informations proactives qui favorisent l’optimisation continue et des résolutions rapides.

Langfuse est une plateforme open-source d’observabilité et d’analytics pensée pour les applications LLM. Elle capture des traces détaillées des exécutions de workflows IA, fournissant aux développeurs et aux équipes les informations nécessaires pour déboguer, surveiller et optimiser leurs systèmes d’IA.

Parmi les principales fonctionnalités de Langfuse :

En connectant Langfuse à FlowHunt, vous transformez des données brutes d’exécution en intelligence exploitable — pour identifier ce qui fonctionne, ce qui ne fonctionne pas, et où concentrer les efforts d’optimisation.

En suivant ce guide, vous allez :

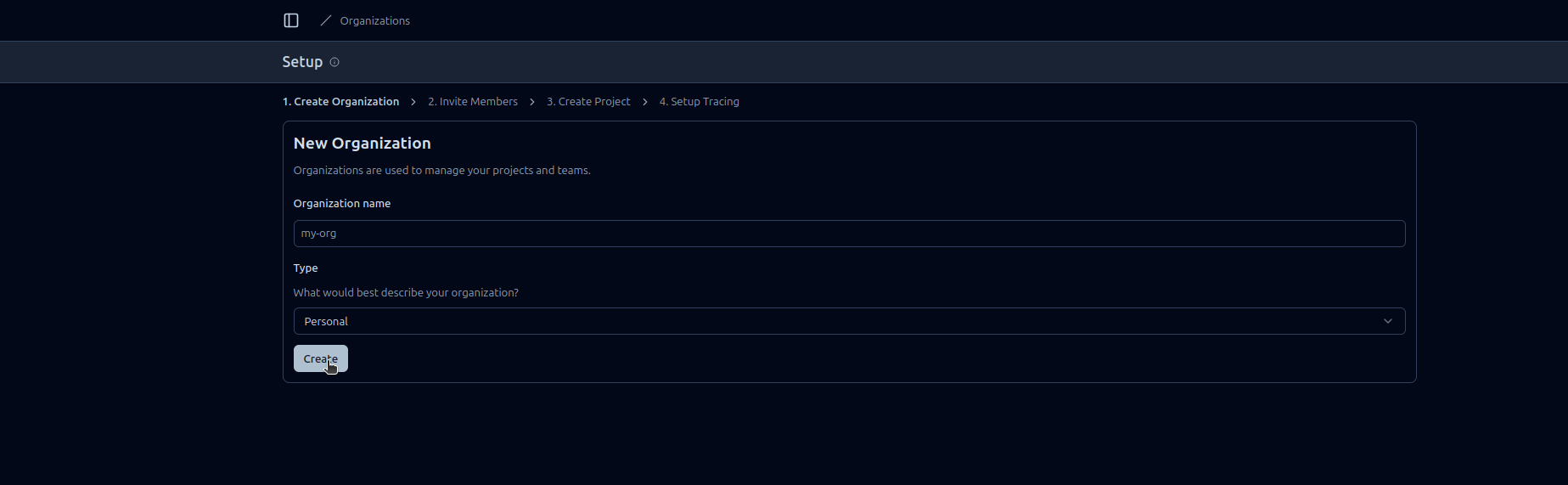

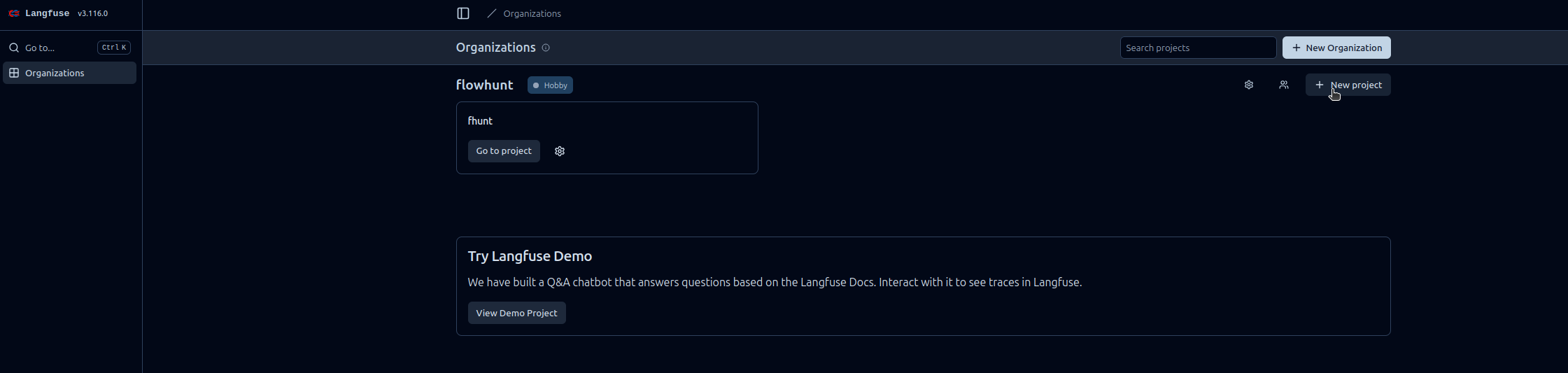

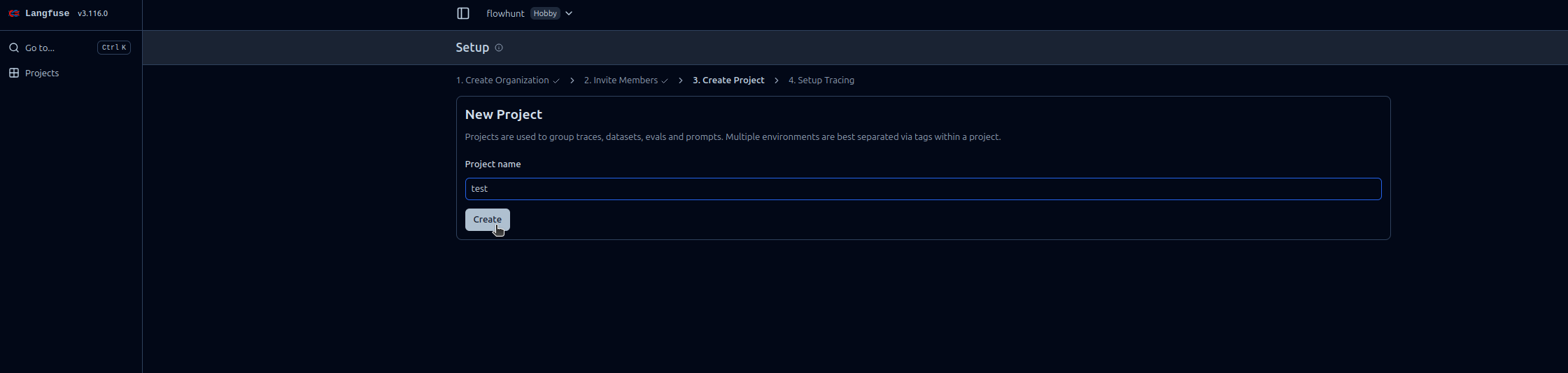

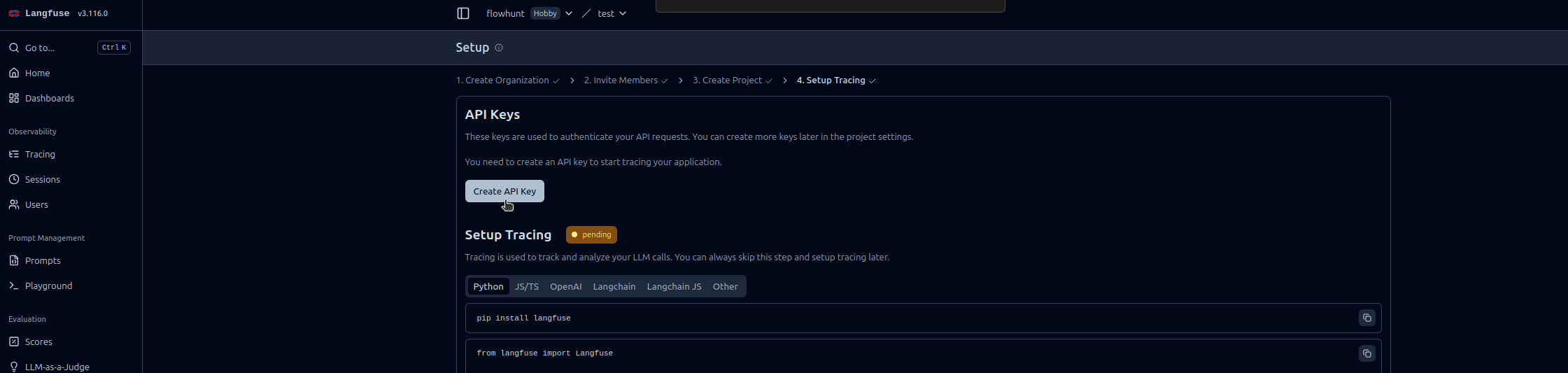

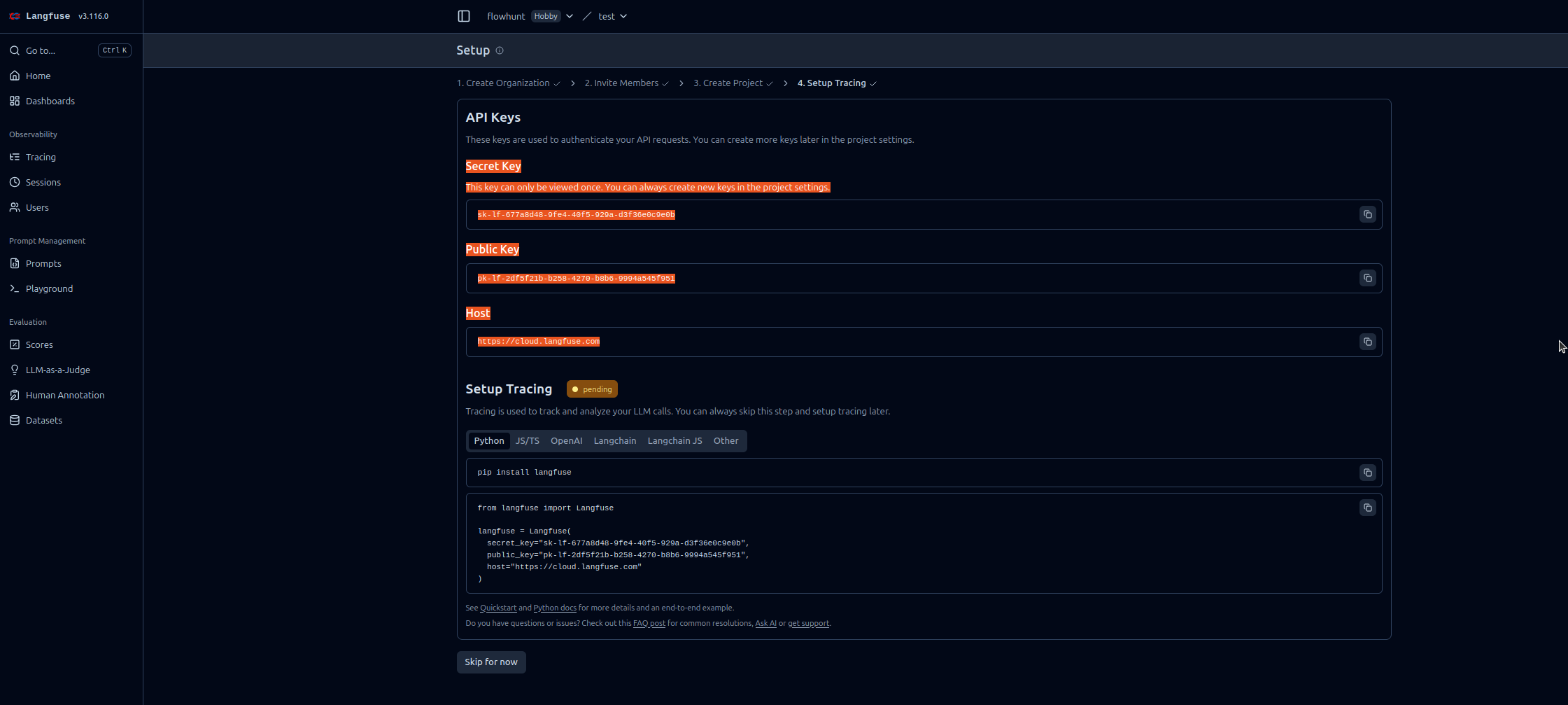

Suivez ces instructions étape par étape pour activer l’observabilité FlowHunt dans Langfuse :

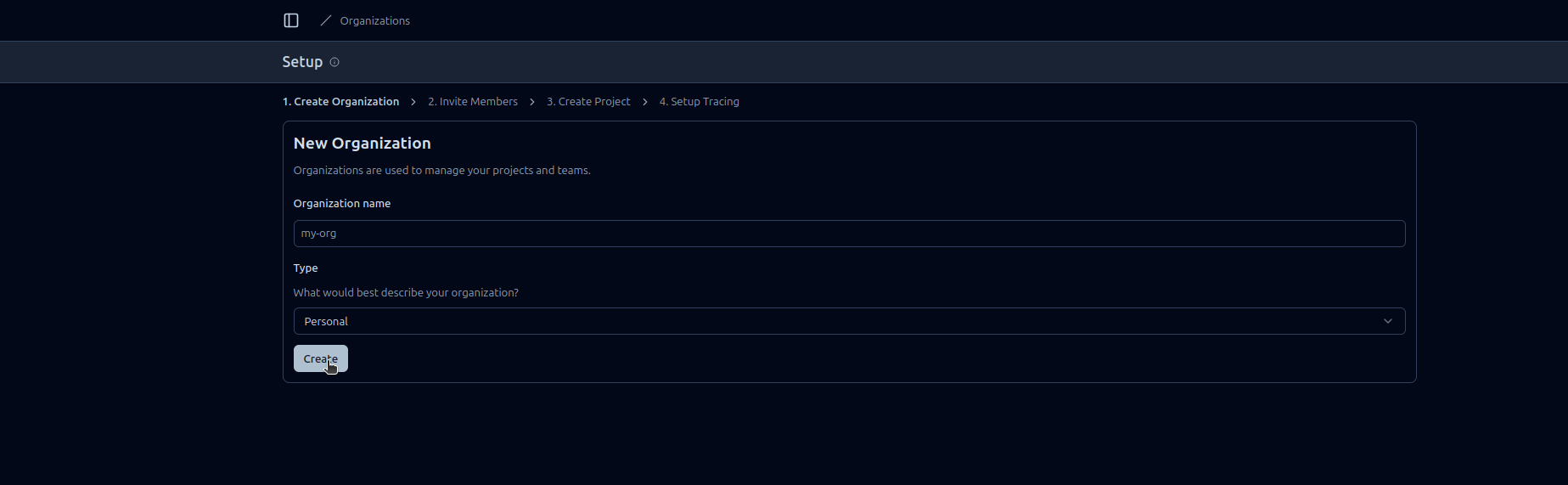

https://cloud.langfuse.com)

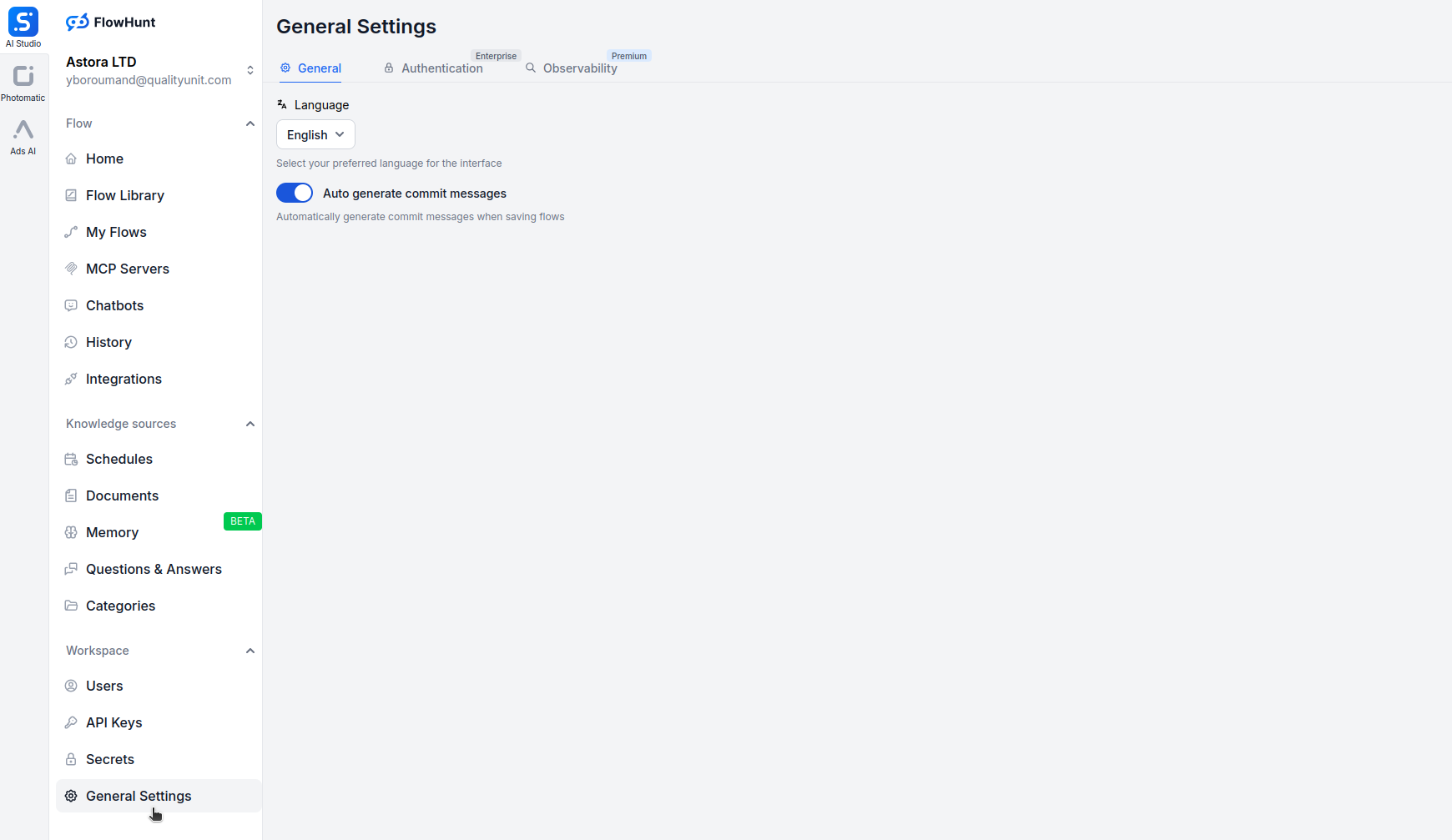

Ouvrez app.flowhunt.io dans votre navigateur.

Accédez aux Paramètres généraux (généralement via la barre latérale ou le menu supérieur).

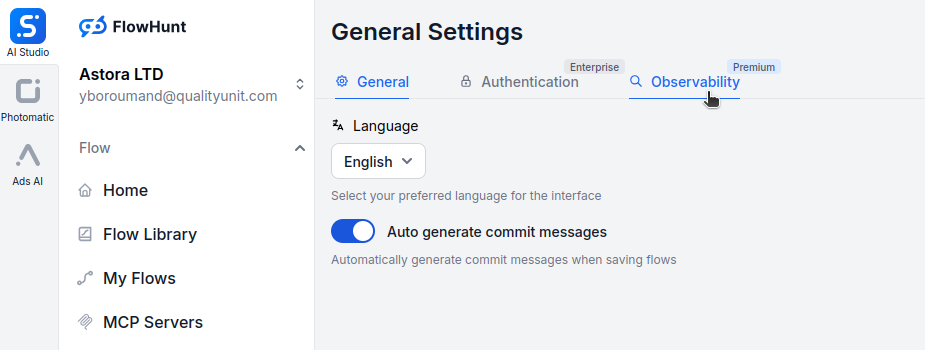

Faites défiler vers le bas et cliquez sur l’onglet Observability.

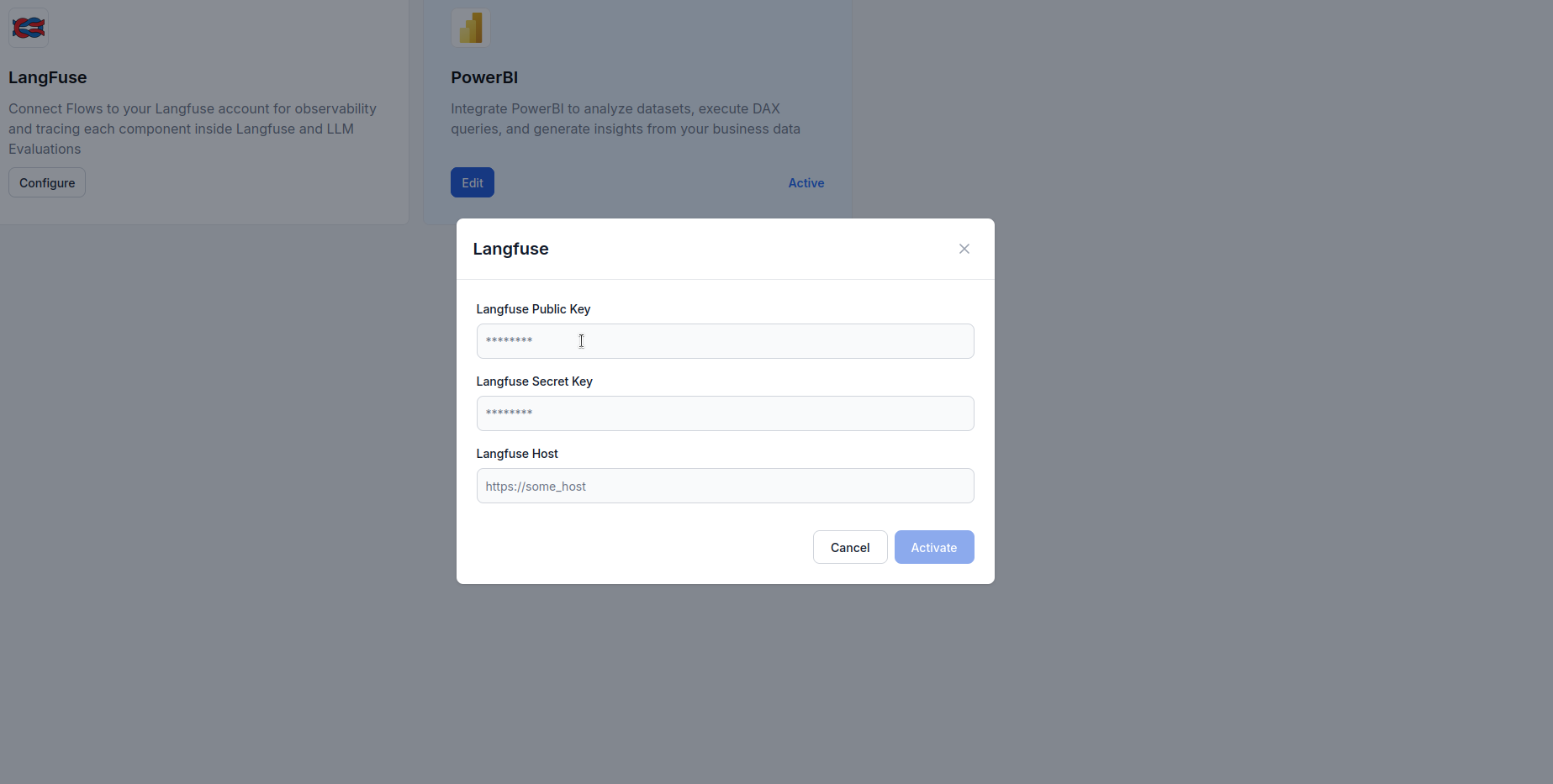

Repérez la boîte Langfuse et cliquez sur Configure.

https://cloud.langfuse.com)

Une fois FlowHunt connecté à Langfuse, vous bénéficiez de puissantes capacités de visualisation et d’analyse. Voici des exemples d’insights générés :

Visualisez une chronologie détaillée de chaque exécution de workflow, montrant :

Cela permet d’identifier les goulets d’étranglement et de comprendre le comportement des workflows en détail.

Surveillez la consommation de tokens sur vos workflows :

Cela permet d’optimiser les coûts en repérant les opérations les plus consommatrices.

Suivez les indicateurs clés :

Ces métriques aident à maintenir les SLA et optimiser l’expérience utilisateur.

Identifiez et diagnostiquez les défaillances :

Cela accélère le dépannage et améliore la fiabilité.

Pour les agents conversationnels IA, suivez :

Cela aide à optimiser le comportement des agents et l’expérience utilisateur.

Comparez les performances entre différents fournisseurs LLM :

Cela guide le choix des modèles sur la base de données réelles d’utilisation.

L’intégration de FlowHunt avec Langfuse transforme vos workflows IA de boîtes noires en systèmes transparents et optimisables. Grâce au tracing complet, vous obtenez une visibilité sur chaque étape d’exécution, permettant des décisions fondées sur la donnée en matière de performance, de coûts et de fiabilité.

L’intégration d’observabilité Langfuse rend la surveillance simple — d’une configuration par clé API à des tableaux de bord riches et actionnables révélant précisément le comportement de vos workflows en production.

Désormais, avec votre espace FlowHunt connecté à Langfuse, vous avez une base solide pour l’amélioration continue : repérez les goulets d’étranglement, optimisez l’usage des tokens, réduisez la latence, et assurez que vos systèmes IA délivrent leur pleine valeur en toute confiance.

L’observabilité dans FlowHunt désigne la capacité à surveiller, tracer et analyser en temps réel la performance des workflows IA, des agents et des automatisations. Elle aide les utilisateurs à détecter les goulets d’étranglement, suivre la consommation de tokens, mesurer la latence et prendre des décisions d’optimisation basées sur la donnée.

Langfuse est une plateforme open-source d’ingénierie LLM conçue pour tracer, surveiller et analyser les applications d’IA. Lorsqu’il est intégré à FlowHunt, il fournit des informations détaillées sur l'exécution des workflows, la consommation de tokens, la performance des modèles et le suivi des erreurs.

Non, l’intégration est simple. Il suffit de créer un compte Langfuse, de générer des clés API et de les coller dans les paramètres d’observabilité de FlowHunt. Aucune compétence en codage n’est requise.

Une fois connecté, vous pouvez suivre les traces d’exécution, la consommation de tokens, les coûts de modèles, les métriques de latence, les taux d’erreur, la performance des workflows dans le temps et des analyses détaillées étape par étape des interactions de vos agents IA.

Langfuse propose un forfait gratuit incluant les fonctions de tracing et d’observabilité de base. Pour les équipes plus importantes ou des analyses avancées, Langfuse offre des plans payants avec des fonctionnalités supplémentaires.

Apprenez à intégrer FlowHunt avec PowerBI, à configurer les paramètres d'observabilité et à visualiser les métriques de votre espace de travail FlowHunt directe...

Guide technique pour maîtriser l’intégration avancée de FlowHunt avec LiveAgent, couvrant le ciblage linguistique, la suppression du markdown, le filtrage anti-...

Découvrez comment un audit de workflow IA peut aider votre entreprise à passer du chaos à la clarté en cartographiant les processus réels, en identifiant les op...

Consentement aux Cookies

Nous utilisons des cookies pour améliorer votre expérience de navigation et analyser notre trafic. See our privacy policy.