Lara Translate MCP

Intégrez FlowHunt avec Lara Translate MCP pour offrir des traductions avancées et contextuelles dans vos flux de travail IA. Automatisez la gestion de contenus ...

Connectez vos agents IA à une traduction professionnelle avec le serveur MCP Lara Translate—pour des services linguistiques sécurisés, de haute qualité et contextuels dans vos workflows FlowHunt.

FlowHunt fournit une couche de sécurité supplémentaire entre vos systèmes internes et les outils d'IA, vous donnant un contrôle granulaire sur les outils accessibles depuis vos serveurs MCP. Les serveurs MCP hébergés dans notre infrastructure peuvent être intégrés de manière transparente avec le chatbot de FlowHunt ainsi qu'avec les plateformes d'IA populaires comme ChatGPT, Claude et divers éditeurs d'IA.

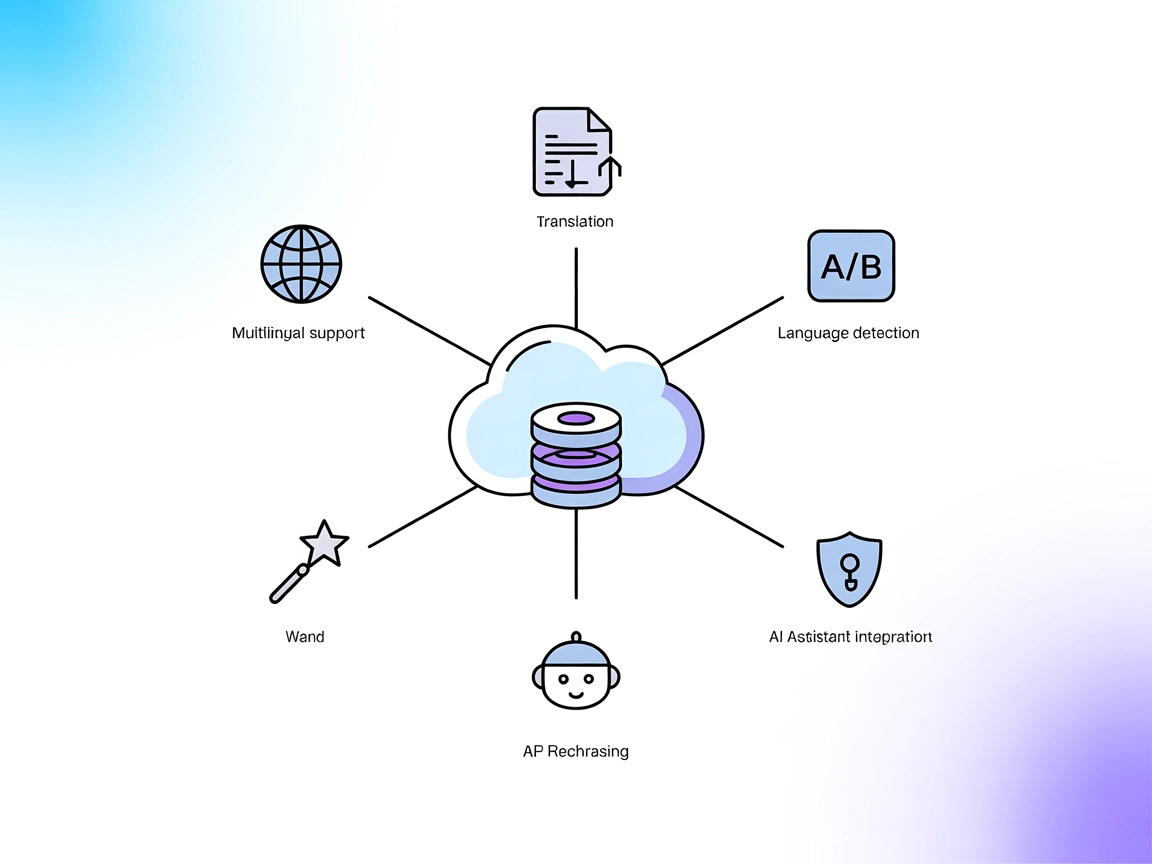

Le serveur MCP Lara Translate est un serveur Model Context Protocol (MCP) qui connecte les assistants IA et les applications à l’API Lara Translate, offrant des capacités de traduction professionnelle. Faisant office de passerelle entre les modèles IA et le service de traduction, il permet une intégration transparente pour des tâches telles que la détection de langue, les traductions contextuelles et l’exploitation de mémoires de traduction. Le serveur permet aux applications IA de réaliser des traductions de manière sécurisée et flexible, de découvrir les outils et ressources disponibles, et de traiter les demandes de traduction avec des paramètres structurés. Cette approche améliore les workflows de développement, permettant aux applications d’offrir des traductions de haute qualité sans gérer directement l’API sous-jacente, tout en conservant la sécurité des identifiants API et en prenant en charge les fonctionnalités avancées pour les langues autres que l’anglais.

Aucun modèle de prompt explicite n’est listé dans la documentation ou les fichiers du dépôt disponibles.

Aucune ressource MCP explicite n’est décrite dans la documentation ou les fichiers du dépôt disponibles.

windsurf.json ou équivalent.mcpServers :{

"mcpServers": {

"lara-mcp": {

"command": "npx",

"args": ["@translated/lara-mcp@latest"]

}

}

}

Sécurisation des clés API :

{

"lara-mcp": {

"env": {

"LARA_API_KEY": "votre-api-key"

},

"inputs": {

"apiKey": "${LARA_API_KEY}"

}

}

}

mcpServers :{

"mcpServers": {

"lara-mcp": {

"command": "npx",

"args": ["@translated/lara-mcp@latest"]

}

}

}

Sécurisation des clés API :

{

"lara-mcp": {

"env": {

"LARA_API_KEY": "votre-api-key"

},

"inputs": {

"apiKey": "${LARA_API_KEY}"

}

}

}

{

"mcpServers": {

"lara-mcp": {

"command": "npx",

"args": ["@translated/lara-mcp@latest"]

}

}

}

Sécurisation des clés API :

{

"lara-mcp": {

"env": {

"LARA_API_KEY": "votre-api-key"

},

"inputs": {

"apiKey": "${LARA_API_KEY}"

}

}

}

mcpServers :{

"mcpServers": {

"lara-mcp": {

"command": "npx",

"args": ["@translated/lara-mcp@latest"]

}

}

}

Sécurisation des clés API :

{

"lara-mcp": {

"env": {

"LARA_API_KEY": "votre-api-key"

},

"inputs": {

"apiKey": "${LARA_API_KEY}"

}

}

}

Utiliser MCP dans FlowHunt

Pour intégrer des serveurs MCP dans votre workflow FlowHunt, commencez par ajouter le composant MCP à votre flux et connectez-le à votre agent IA :

Cliquez sur le composant MCP pour ouvrir le panneau de configuration. Dans la section de configuration système MCP, insérez les détails de votre serveur MCP en utilisant ce format JSON :

{

"lara-mcp": {

"transport": "streamable_http",

"url": "https://votreserveurmcp.exemple/cheminverslemcp/url"

}

}

Une fois configuré, l’agent IA pourra utiliser ce MCP comme outil, avec accès à toutes ses fonctions et capacités. N’oubliez pas de remplacer “lara-mcp” par le nom réel de votre serveur MCP et de saisir l’URL de votre propre serveur MCP.

| Section | Disponibilité | Détails/Remarques |

|---|---|---|

| Présentation | ✅ | Introduction détaillée disponible |

| Liste des prompts | ⛔ | Aucun modèle de prompt explicite listé |

| Liste des ressources | ⛔ | Aucune ressource MCP explicite décrite |

| Liste des outils | ✅ | Outil de traduction décrit |

| Sécurisation des clés API | ✅ | Instructions via variables d’environnement |

| Prise en charge du sampling (moins important) | ⛔ | Non mentionné |

D’après la documentation, Lara Translate MCP fournit un outil de traduction robuste et des instructions de configuration claires, mais ne propose ni modèles de prompts explicites, ni ressources MCP listées, ni documentation sur le sampling/root. Dans l’ensemble, il s’agit d’un serveur MCP spécialisé et pratique pour les tâches de traduction.

| Possède une LICENCE | ✅ (MIT) |

|---|---|

| Au moins un outil | ✅ |

| Nombre de Forks | 9 |

| Nombre d’étoiles | 57 |

Le serveur MCP Lara Translate est un pont entre les assistants IA et l'API Lara Translate, permettant des traductions sécurisées, contextuelles, la détection de langue et la génération de contenus multilingues professionnels dans les workflows IA.

Il fournit un outil de traduction, qui offre un accès structuré aux fonctionnalités principales de Lara Translate, notamment la traduction de texte, la détection de langue et la traduction contextuelle.

Stockez votre clé API comme variable d'environnement dans la configuration de votre serveur MCP. Cela garde vos identifiants sensibles sécurisés, hors du code côté client.

Oui, Lara Translate MCP permet des traductions contextuelles et peut exploiter des mémoires de traduction pour renforcer la précision dans des scénarios spécifiques à un domaine.

Les cas d'usage courants incluent la génération de contenus multilingues, l'intégration de la traduction dans des workflows pilotés par l'IA, la détection de langue pour les agents IA, et la gestion sécurisée des identifiants de traduction.

Aucun modèle de prompt explicite ni support du sampling n'est fourni dans la documentation actuelle.

Renforcez vos workflows IA grâce à une traduction linguistique transparente, sécurisée et professionnelle avec le serveur MCP Lara Translate.

Intégrez FlowHunt avec Lara Translate MCP pour offrir des traductions avancées et contextuelles dans vos flux de travail IA. Automatisez la gestion de contenus ...

Le serveur DeepL MCP intègre la traduction avancée, la reformulation et la détection de langue dans les flux de travail IA via l’API DeepL. Il offre à FlowHunt ...

Le serveur Riza MCP fait le lien entre les assistants IA et l’interpréteur de code isolé de la plateforme Riza, permettant une exécution sécurisée du code, la g...

Consentement aux Cookies

Nous utilisons des cookies pour améliorer votre expérience de navigation et analyser notre trafic. See our privacy policy.