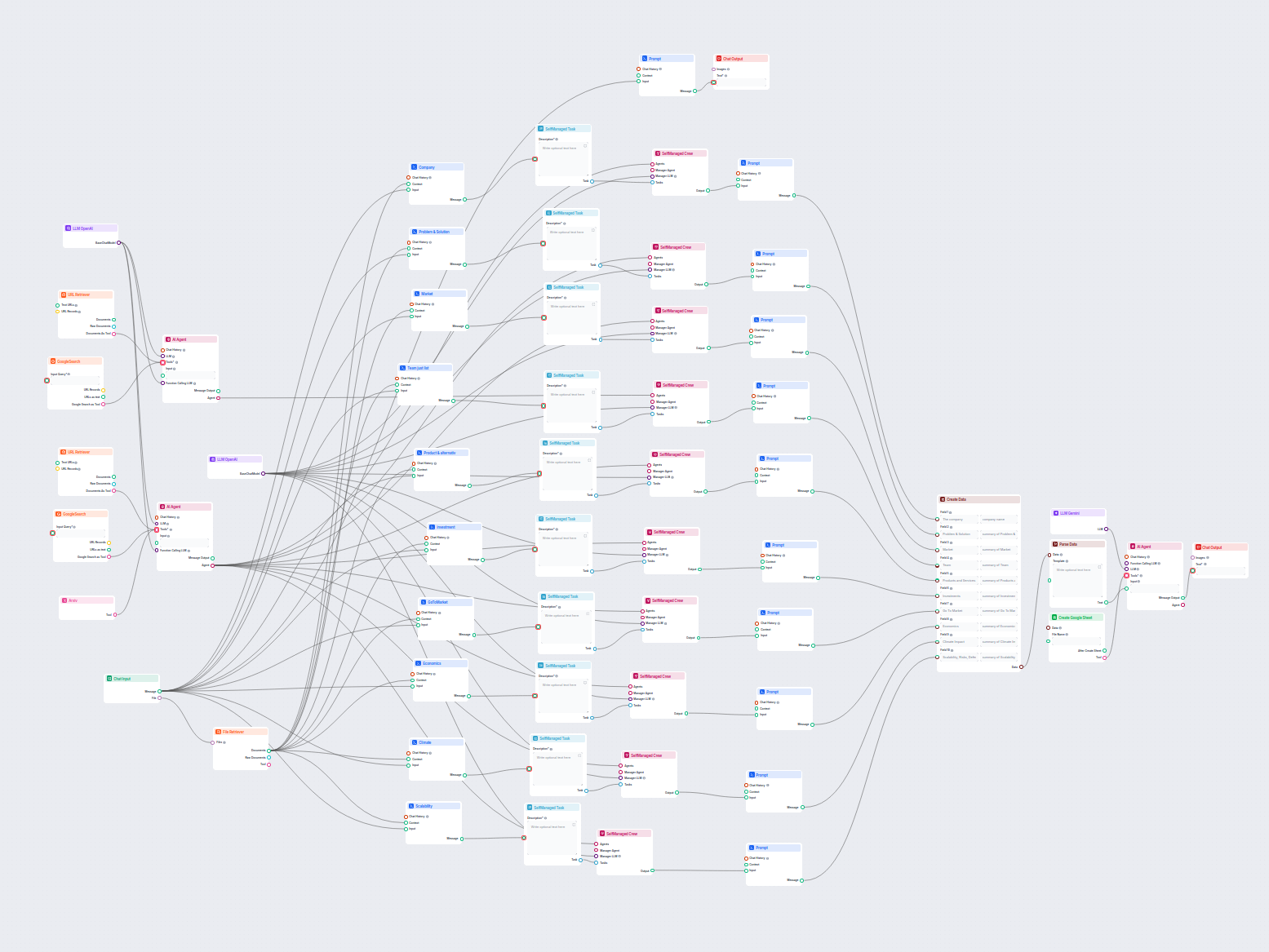

Analisi Aziendale AI esportata su Google Sheets

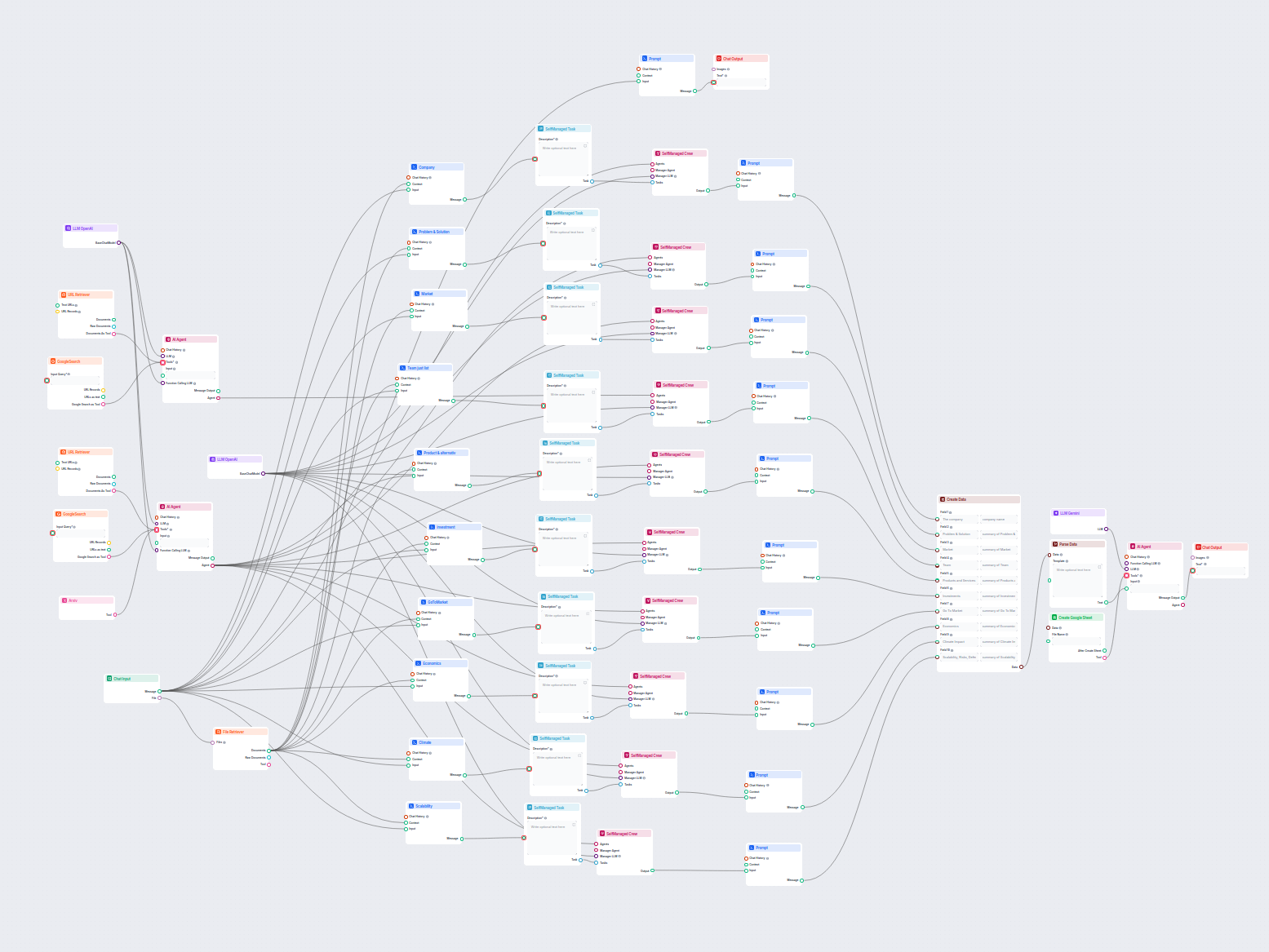

Questo workflow potenziato dall'AI fornisce un'analisi aziendale completa e basata sui dati. Raccoglie informazioni sul background aziendale, panorama di mercat...

Sblocca la potenza dei modelli Gemini di Google in FlowHunt—scambia modelli AI, controlla le impostazioni e costruisci chatbot AI più intelligenti con facilità.

Descrizione del componente

The LLM Gemini component connects the Gemini models from Google to your flow. While the Generators and Agents are where the actual magic happens, LLM components allow you to control the model used. All components come with ChatGPT-4 by default. You can connect this component if you wish to change the model or gain more control over it.

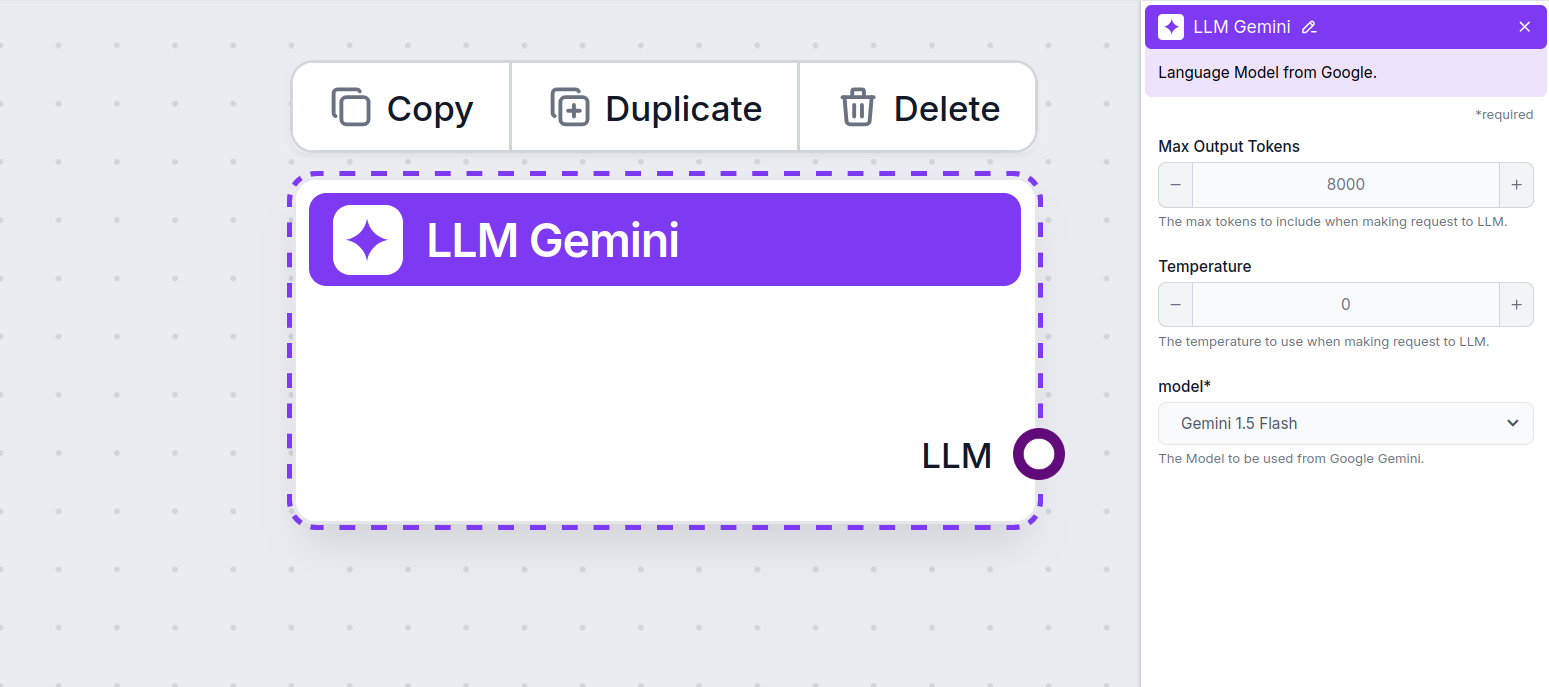

Remember that connecting an LLM Component is optional. All components that use an LLM come with ChatGPT-4o as the default. The LLM components allow you to change the model and control model settings.

Tokens represent the individual units of text the model processes and generates. Token usage varies with models, and a single token can be anything from words or subwords to a single character. Models are usually priced in millions of tokens.

The max tokens setting limits the total number of tokens that can be processed in a single interaction or request, ensuring the responses are generated within reasonable bounds. The default limit is 4,000 tokens, the optimal size for summarizing documents and several sources to generate an answer.

Temperature controls the variability of answers, ranging from 0 to 1.

A temperature of 0.1 will make the responses very to the point but potentially repetitive and deficient.

A high temperature of 1 allows for maximum creativity in answers but creates the risk of irrelevant or even hallucinatory responses.

For example, the recommended temperature for a customer service bot is between 0.2 and 0.5. This level should keep the answers relevant and to the script while allowing for a natural response variation.

This is the model picker. Here, you’ll find all the supported Gemini models from Google. We support all the latest Gemini models:

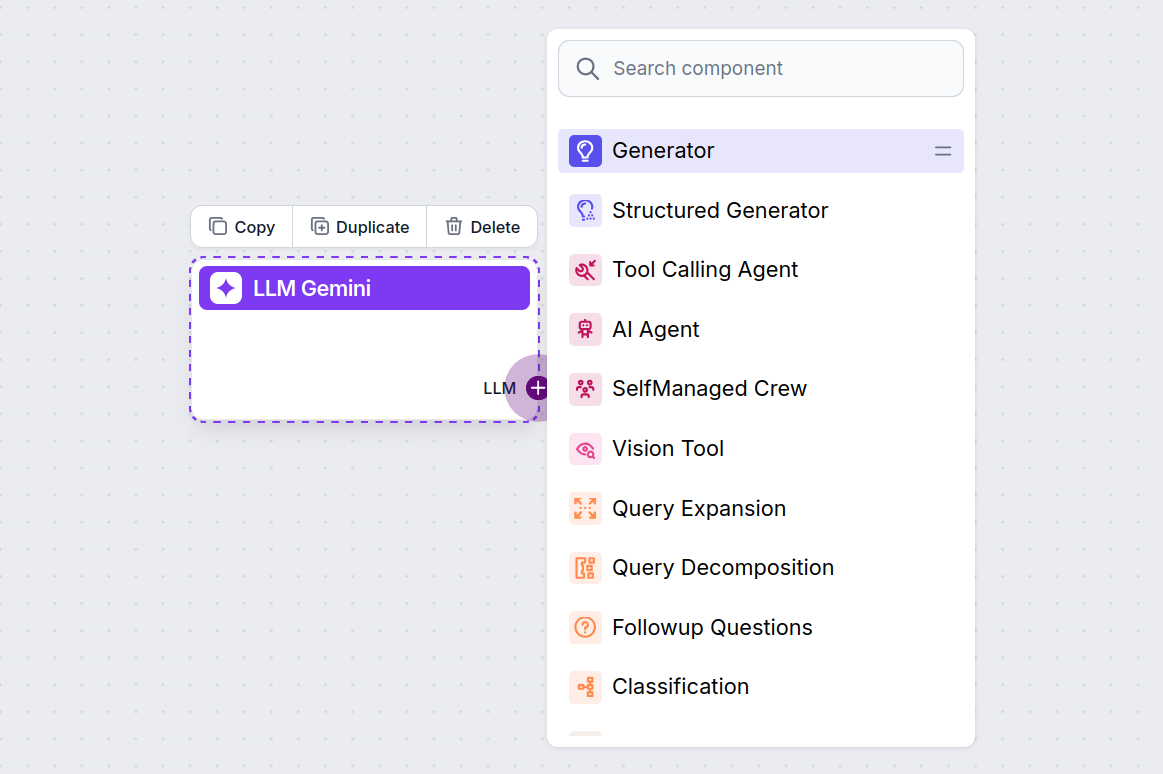

You’ll notice that all LLM components only have an output handle. Input doesn’t pass through the component, as it only represents the model, while the actual generation happens in AI Agents and Generators.

The LLM handle is always purple. The LLM input handle is found on any component that uses AI to generate text or process data. You can see the options by clicking the handle:

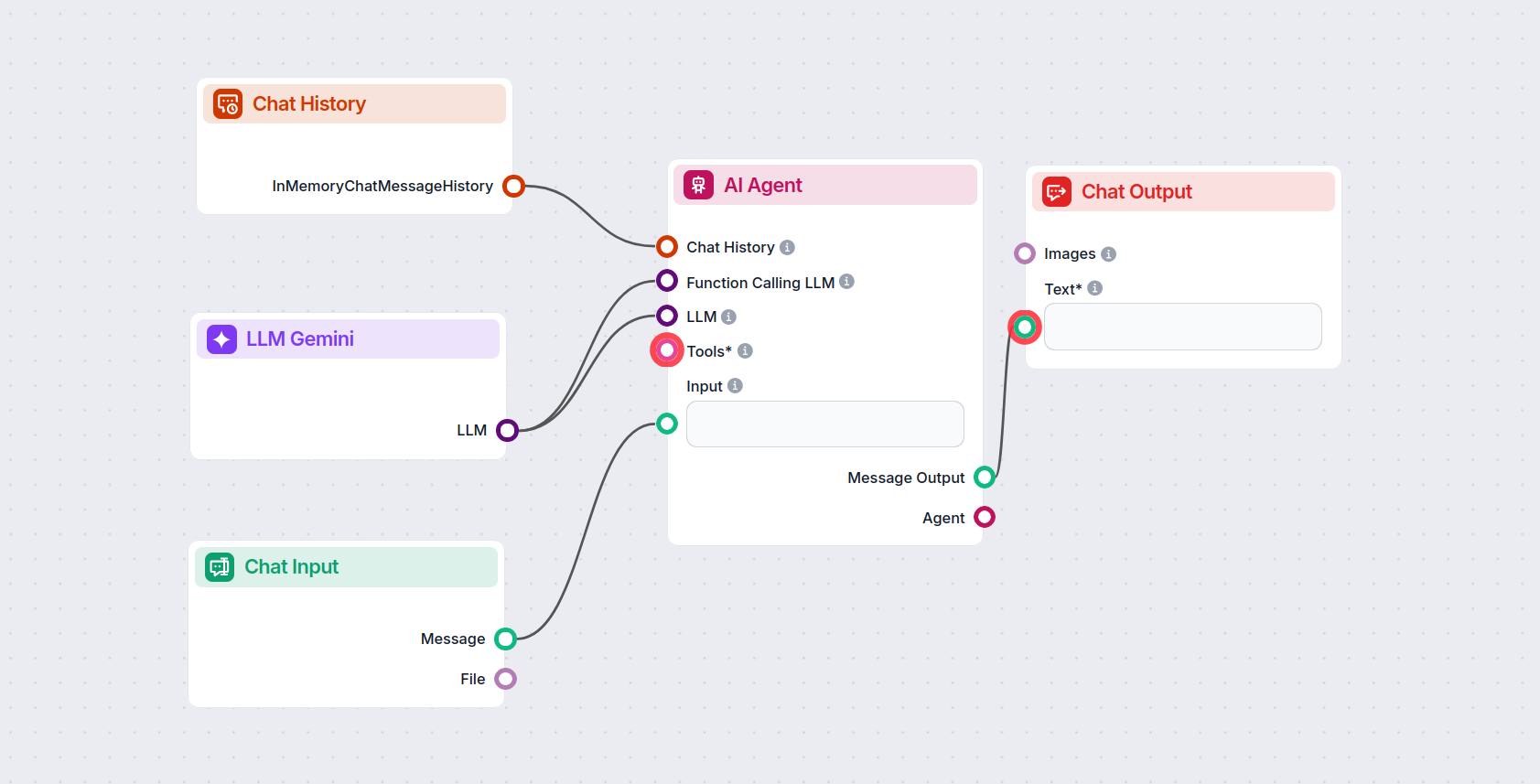

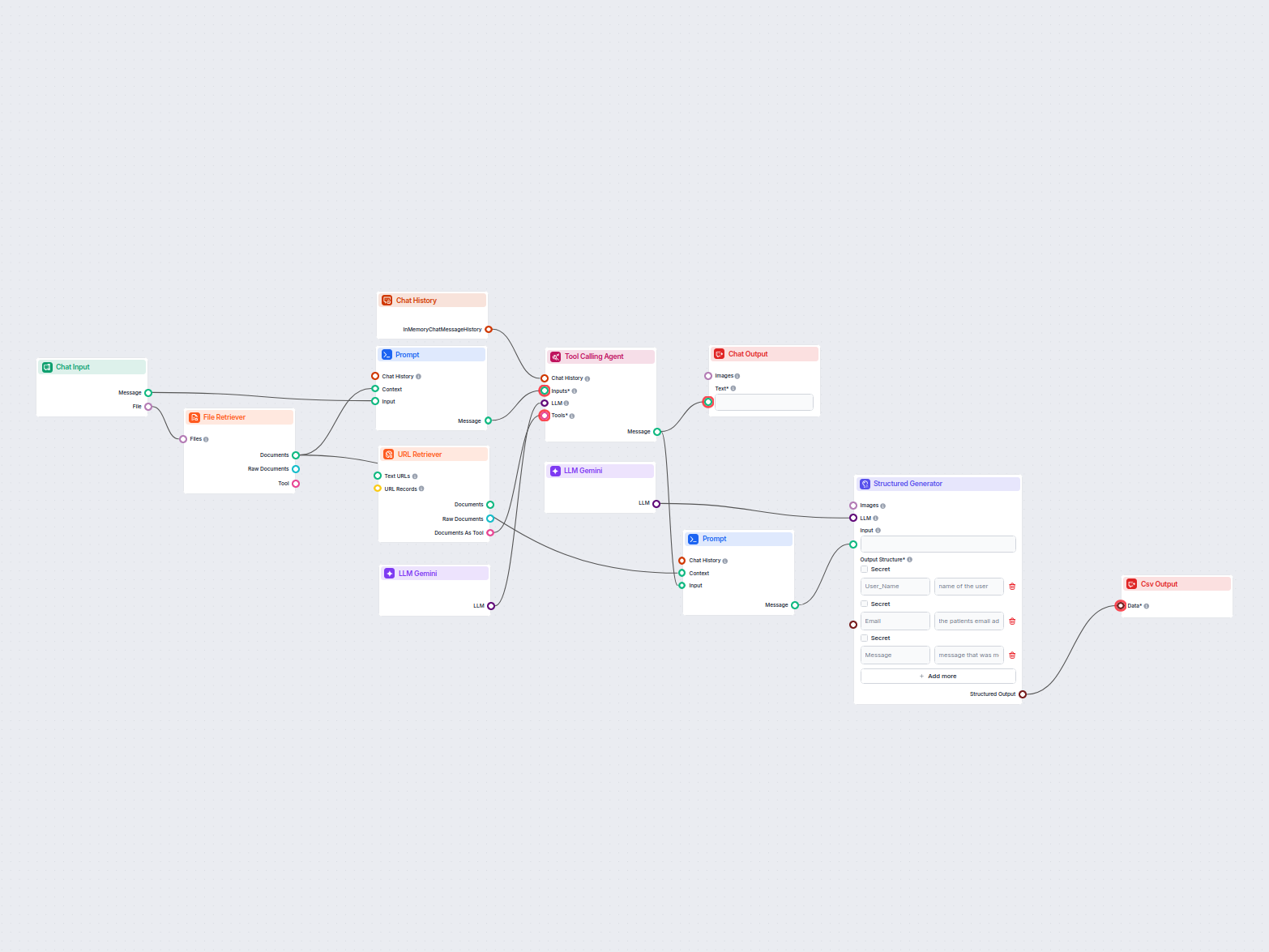

This allows you to create all sorts of tools. Let’s see the component in action. Here’s a simple AI Agent chatbot Flow that’s using Gemini 2.0 Flash Experimental to generate responses. You can think of it as a basic Gemini chatbot.

This simple Chatbot Flow includes:

Per aiutarti a iniziare rapidamente, abbiamo preparato diversi modelli di flusso di esempio che mostrano come utilizzare efficacemente il componente LLM Gemini. Questi modelli presentano diversi casi d'uso e best practice, rendendo più facile per te comprendere e implementare il componente nei tuoi progetti.

Questo workflow potenziato dall'AI fornisce un'analisi aziendale completa e basata sui dati. Raccoglie informazioni sul background aziendale, panorama di mercat...

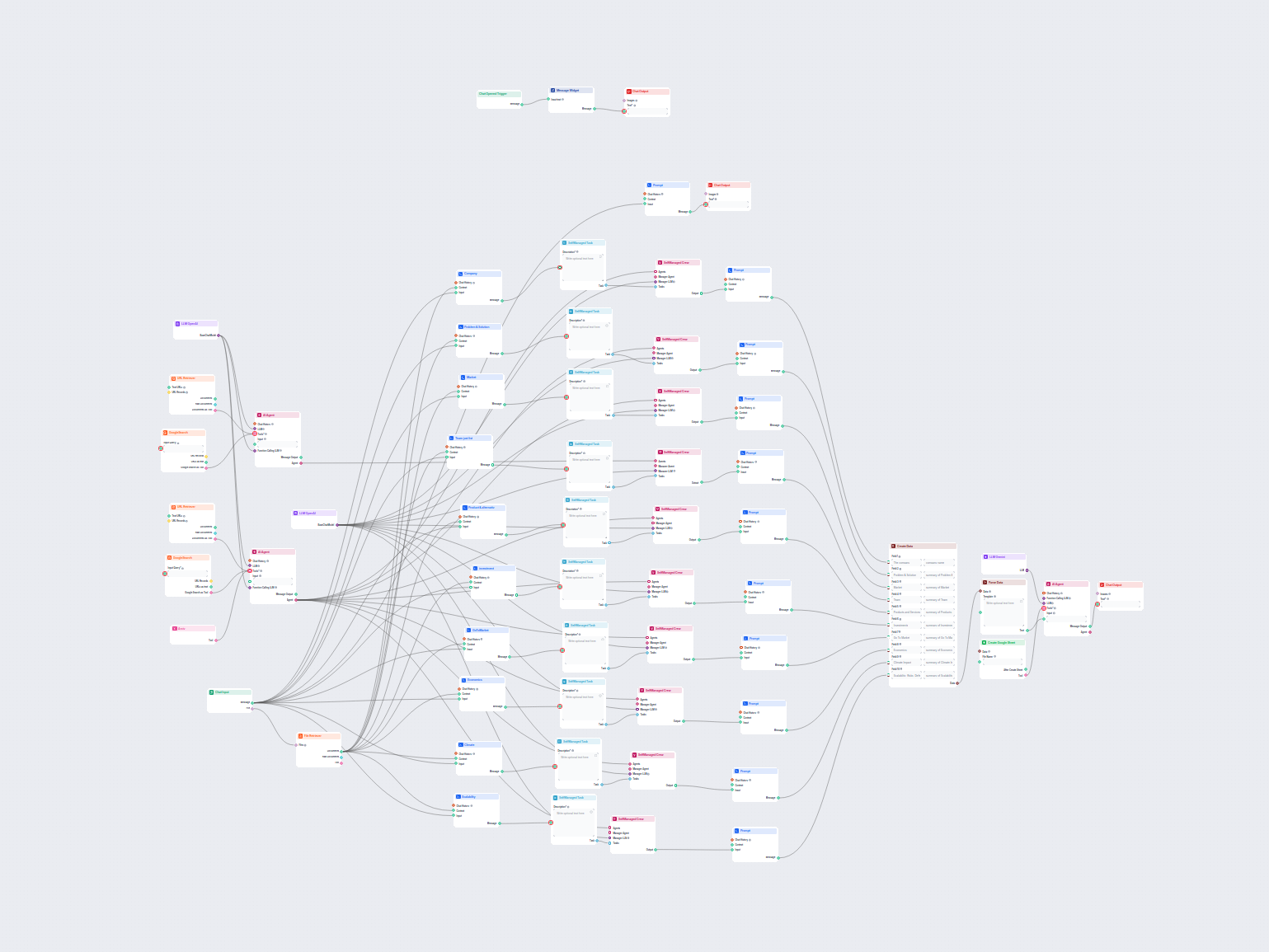

Questo workflow AI analizza in profondità qualsiasi azienda ricercando dati e documenti pubblici, coprendo mercato, team, prodotti, investimenti e altro ancora....

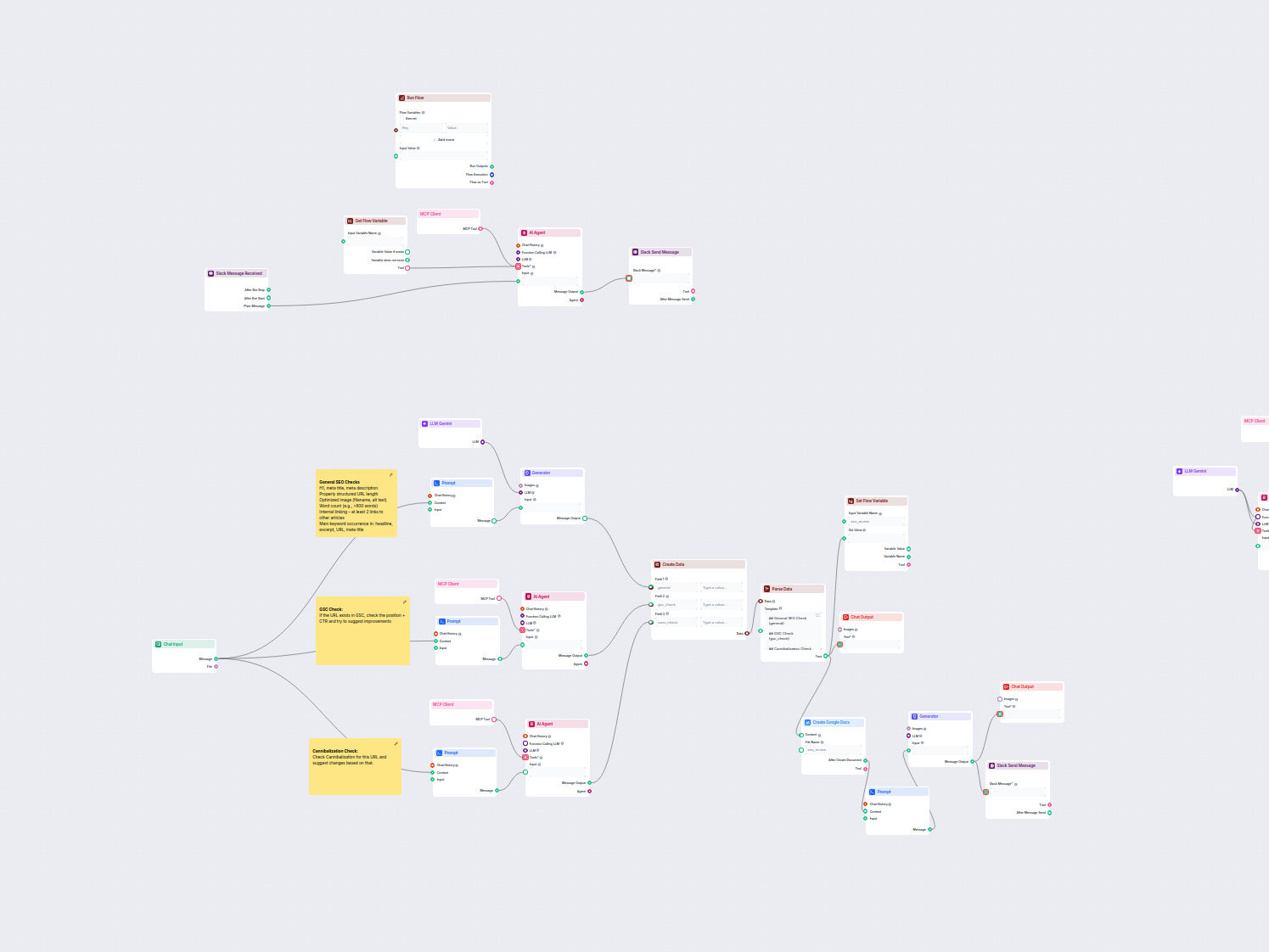

Questo workflow automatizza il processo di revisione e audit SEO per le pagine web. Analizza i contenuti delle pagine secondo le migliori pratiche SEO, effettua...

Questo workflow estrae e organizza le informazioni chiave da email e file allegati, utilizza l'AI per elaborare e strutturare i dati, e restituisce i risultati ...

LLM Gemini collega i modelli Gemini di Google ai tuoi flussi AI di FlowHunt, permettendoti di scegliere tra le ultime varianti Gemini per la generazione di testi e personalizzare il loro comportamento.

FlowHunt supporta Gemini 2.0 Flash Experimental, Gemini 1.5 Flash, Gemini 1.5 Flash-8B e Gemini 1.5 Pro—ognuno offre capacità uniche per input di testo, immagini, audio e video.

Max Token limita la lunghezza della risposta, mentre Temperatura controlla la creatività—valori bassi danno risposte più mirate, valori alti consentono maggiore varietà. Entrambi possono essere impostati per ogni modello in FlowHunt.

No, l'utilizzo dei componenti LLM è facoltativo. Tutti i flussi AI hanno di default ChatGPT-4o, ma aggiungendo LLM Gemini puoi passare ai modelli Google e perfezionare le impostazioni.

Inizia a creare chatbot AI avanzati e strumenti con Gemini e altri modelli di punta—tutto in una sola dashboard. Cambia modello, personalizza le impostazioni e semplifica i tuoi flussi di lavoro.

Consenso Cookie

Usiamo i cookie per migliorare la tua esperienza di navigazione e analizzare il nostro traffico. See our privacy policy.