Come Generare Pagine Glossario Ottimizzate SEO con l’IA in FlowHunt

Scopri come generare automaticamente pagine glossario complete e ottimizzate per la SEO utilizzando agenti IA e automazione dei flussi di lavoro in FlowHunt. Da...

Scopri come impostare pianificazioni automatiche per la scansione di siti web, sitemap, domini e canali YouTube per mantenere aggiornata la knowledge base del tuo Agente AI.

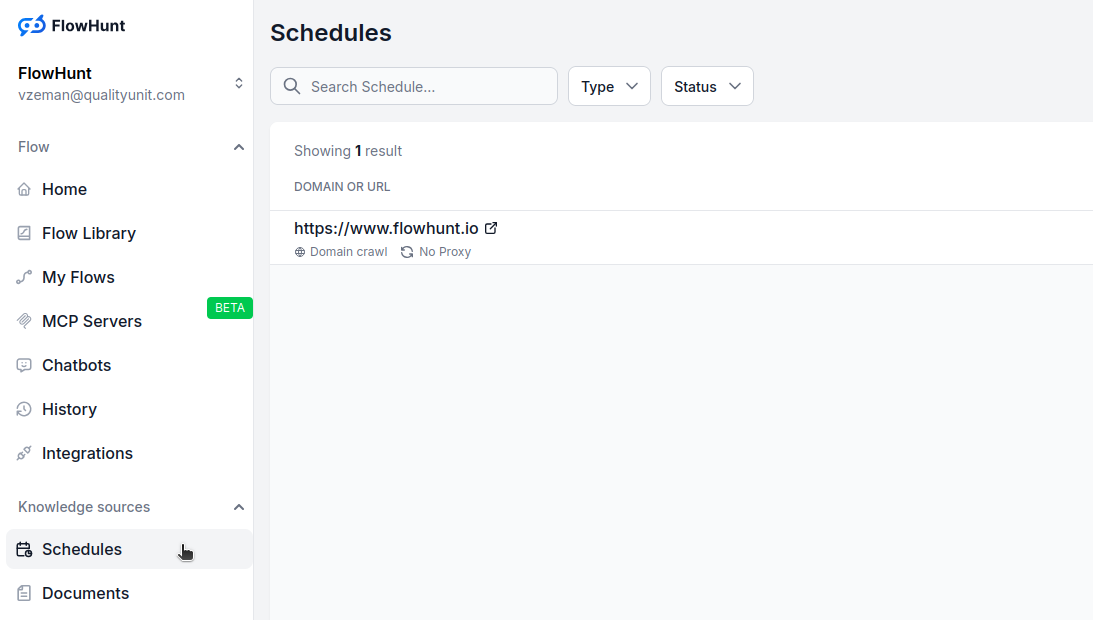

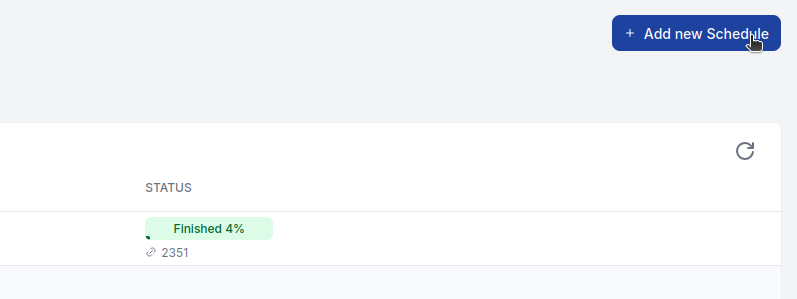

La funzione Pianificazioni di FlowHunt ti permette di automatizzare la scansione e l’indicizzazione di siti web, sitemap, domini e canali YouTube. In questo modo la knowledge base del tuo Agente AI resta aggiornata con contenuti freschi senza interventi manuali.

Scansione automatica:

Imposta scansioni ricorrenti che si eseguono ogni giorno, settimana, mese o anno per mantenere aggiornata la knowledge base.

Tipi di scansione multipli:

Scegli tra scansione del dominio, scansione della sitemap, scansione di URL o scansione di canale YouTube in base alla fonte dei tuoi contenuti.

Opzioni avanzate:

Configura rendering del browser, inseguimento dei link, screenshot, rotazione proxy e filtraggio degli URL per risultati ottimali.

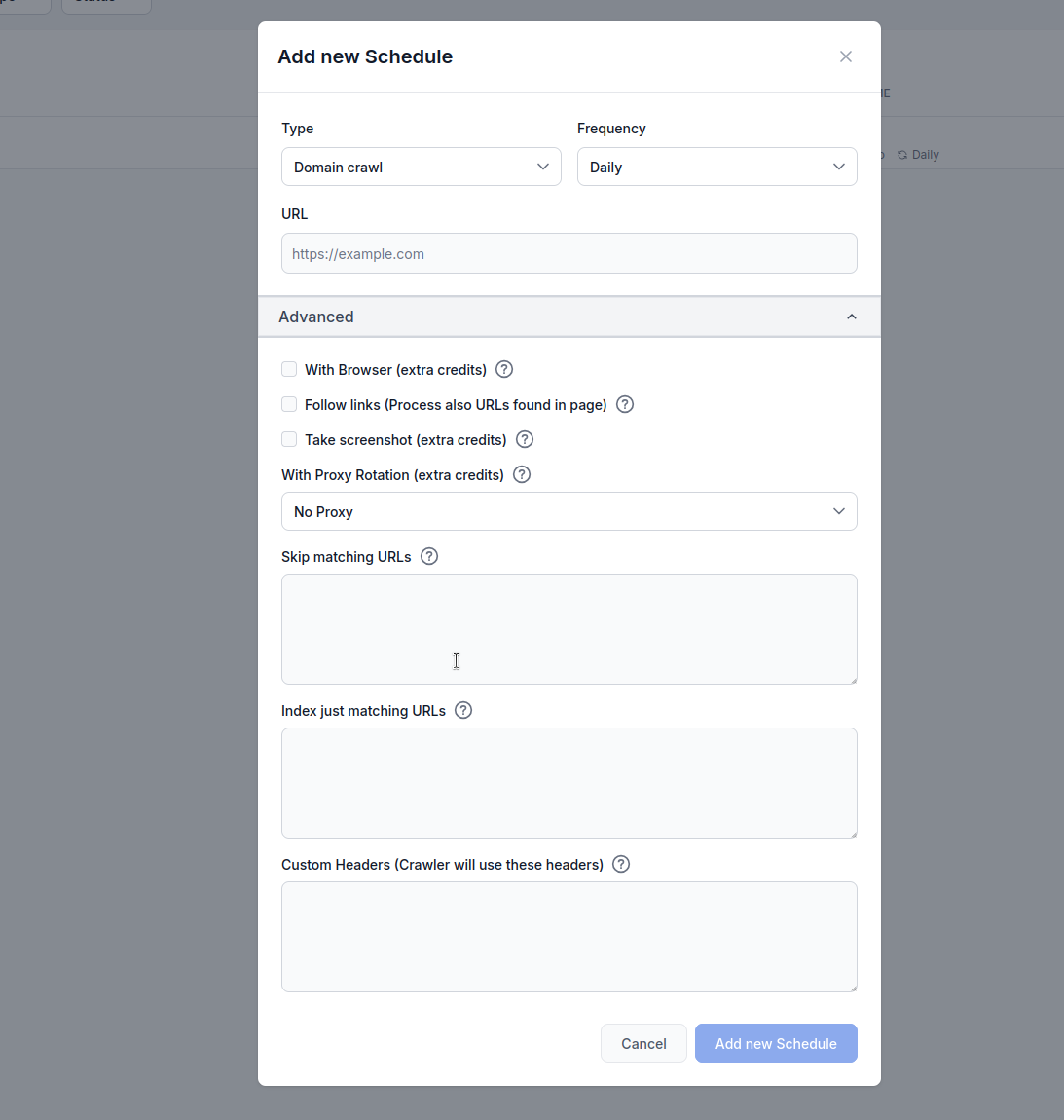

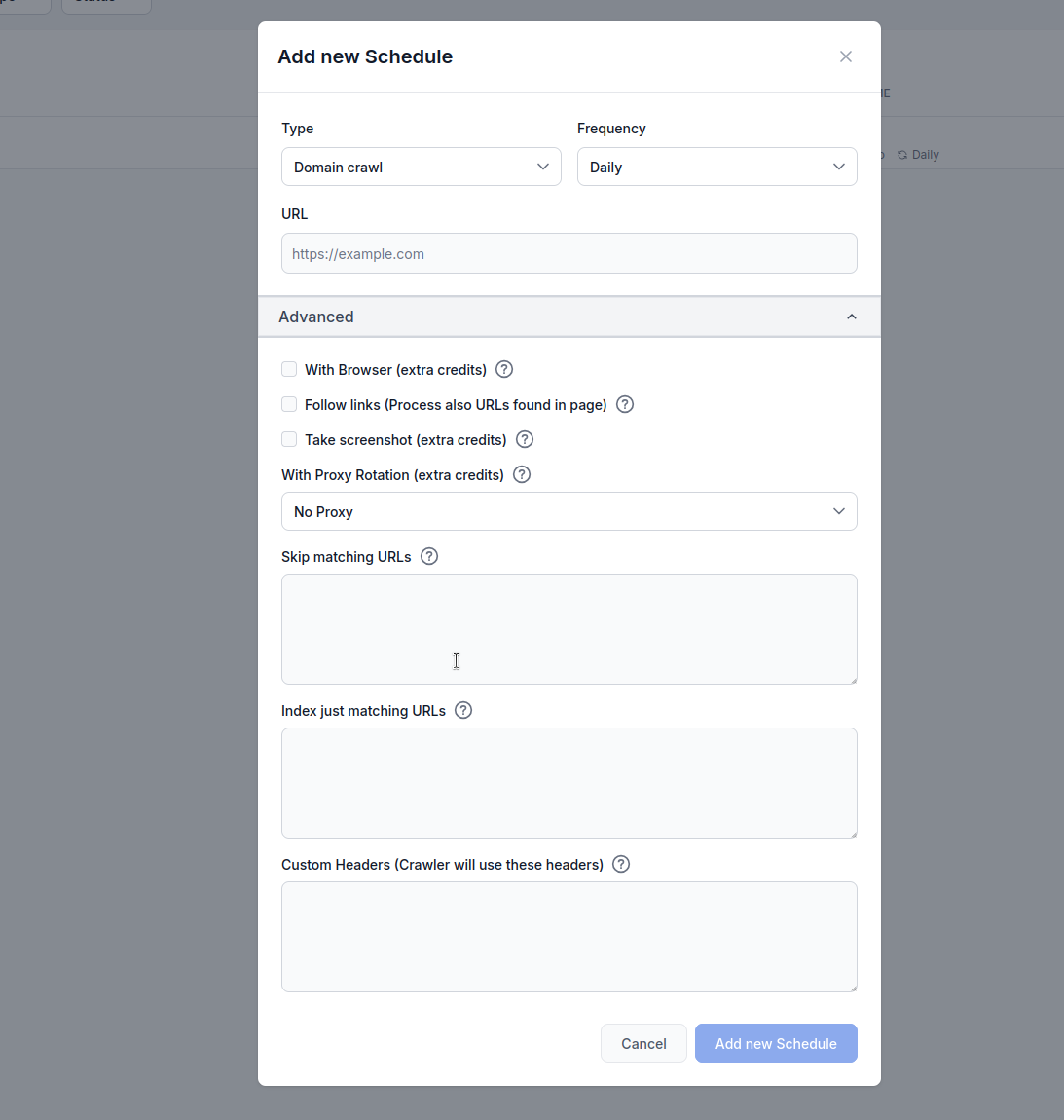

Tipo: Scegli il metodo di scansione:

Frequenza: Imposta ogni quanto eseguire la scansione:

URL: Inserisci l’URL di destinazione, dominio o canale YouTube da scansionare

Con Browser (crediti extra): Attiva questa opzione quando scansioni siti web ricchi di JavaScript che richiedono il rendering completo del browser. È più lenta e costosa, ma necessaria per siti che caricano i contenuti in modo dinamico.

Segui i link (crediti extra): Processa ulteriori URL trovati all’interno delle pagine. Utile quando le sitemap non contengono tutti gli URL, ma può consumare molti crediti poiché scansiona anche i link scoperti.

Cattura screenshot (crediti extra): Acquisisci screenshot visivi durante la scansione. Utile per siti senza og:images o che richiedono contesto visivo per l’elaborazione AI.

Con rotazione proxy (crediti extra): Ruota gli indirizzi IP per ogni richiesta per evitare i Web Application Firewall (WAF) o sistemi anti-bot.

Salta URL corrispondenti: Inserisci stringhe (una per riga) per escludere dalla scansione gli URL che contengono questi pattern. Esempio:

/admin/

/login

.pdf

Questo esempio spiega cosa succede quando usi la funzione Pianificazioni di FlowHunt per scansionare il dominio flowhunt.io impostando /blog come pattern di URL da saltare nelle impostazioni di filtraggio URL.

Configurazione

flowhunt.io/blogCosa succede

Inizio scansione:

flowhunt.io, targetizzando tutte le pagine accessibili del dominio (es. flowhunt.io, flowhunt.io/features, flowhunt.io/pricing, ecc.).Applicazione filtraggio URL:

/blog./blog (es. flowhunt.io/blog, flowhunt.io/blog/post1, flowhunt.io/blog/category) viene escluso dalla scansione.flowhunt.io/about, flowhunt.io/contact o flowhunt.io/docs, vengono scansionati perché non corrispondono al pattern /blog.Esecuzione scansione:

flowhunt.io, indicizzando i loro contenuti nella knowledge base del tuo Agente AI.Risultato:

flowhunt.io, escludendo tutto ciò che è sotto il percorso /blog./blog) senza intervento manuale.Indicizza solo URL corrispondenti: Inserisci stringhe (una per riga) per scansionare solo gli URL che contengono questi pattern. Esempio:

/blog/

/articles/

/knowledge/

Configurazione

flowhunt.io/blog/

/articles/

/knowledge/

Inizio scansione:

flowhunt.io, targetizzando tutte le pagine accessibili del dominio (es. flowhunt.io, flowhunt.io/blog, flowhunt.io/articles, ecc.).Applicazione filtraggio URL:

/blog/, /articles/ e /knowledge/.flowhunt.io/blog/post1, flowhunt.io/articles/news, flowhunt.io/knowledge/guide) sono inclusi nella scansione.flowhunt.io/about, flowhunt.io/pricing o flowhunt.io/contact, sono esclusi perché non corrispondono ai pattern specificati.Esecuzione scansione:

/blog/, /articles/ o /knowledge/, indicizzando i loro contenuti nella knowledge base del tuo Agente AI.Risultato:

flowhunt.io sotto i percorsi /blog/, /articles/ e /knowledge/.Header personalizzati:

Aggiungi header HTTP personalizzati per le richieste di scansione. Il formato è HEADER=Valore (uno per riga):

Questa funzione è molto utile per adattare le scansioni alle esigenze specifiche di determinati siti web. Abilitando header personalizzati, gli utenti possono autenticare le richieste per accedere a contenuti riservati, simulare specifici comportamenti del browser o rispettare le policy API o di accesso di un sito. Ad esempio, impostando un header Authorization puoi ottenere accesso a pagine protette, mentre uno User-Agent personalizzato può aiutare a evitare il rilevamento come bot o garantire compatibilità con siti che limitano certi crawler. Questa flessibilità permette una raccolta dati più accurata e completa, facilitando l’indicizzazione di contenuti rilevanti nella knowledge base dell’Agente AI nel rispetto delle policy di sicurezza o accesso del sito.

MYHEADER=Qualsiasi valore

Authorization=Bearer token123

User-Agent=Custom crawler

Vai su Pianificazioni nella dashboard di FlowHunt

Clicca su “Aggiungi nuova pianificazione”

Configura le impostazioni di base:

Espandi le opzioni avanzate se necessario:

Clicca su “Aggiungi nuova pianificazione” per attivare

Per la maggior parte dei siti web:

Per siti pesanti in JavaScript:

Per siti di grandi dimensioni:

Per e-commerce o contenuti dinamici:

Le funzioni avanzate consumano crediti aggiuntivi:

Monitora il consumo crediti e regola le pianificazioni in base alle tue esigenze e al budget.

Errori di scansione:

Troppe/Poche pagine:

Contenuti mancanti:

Scopri come generare automaticamente pagine glossario complete e ottimizzate per la SEO utilizzando agenti IA e automazione dei flussi di lavoro in FlowHunt. Da...

Trasforma la tua strategia di contenuti con il nostro Pianificatore di Contenuti potenziato dall'Intelligenza Artificiale che combina capacità AI avanzate con r...

Distribuisci un agente AI intelligente che crea e pubblica automaticamente articoli sul blog, aggiorna le pagine con nuovi contenuti, gestisce i caricamenti mul...