DeepSeek MCP Server

Il DeepSeek MCP Server integra i modelli linguistici avanzati di DeepSeek con applicazioni compatibili MCP, fornendo accesso API sicuro e anonimizzato e abilita...

Integra i modelli DeepSeek ottimizzati per contesto e ragionamento nei tuoi flussi AI con Deepseek R1 MCP Server per attività linguistiche avanzate e automazione.

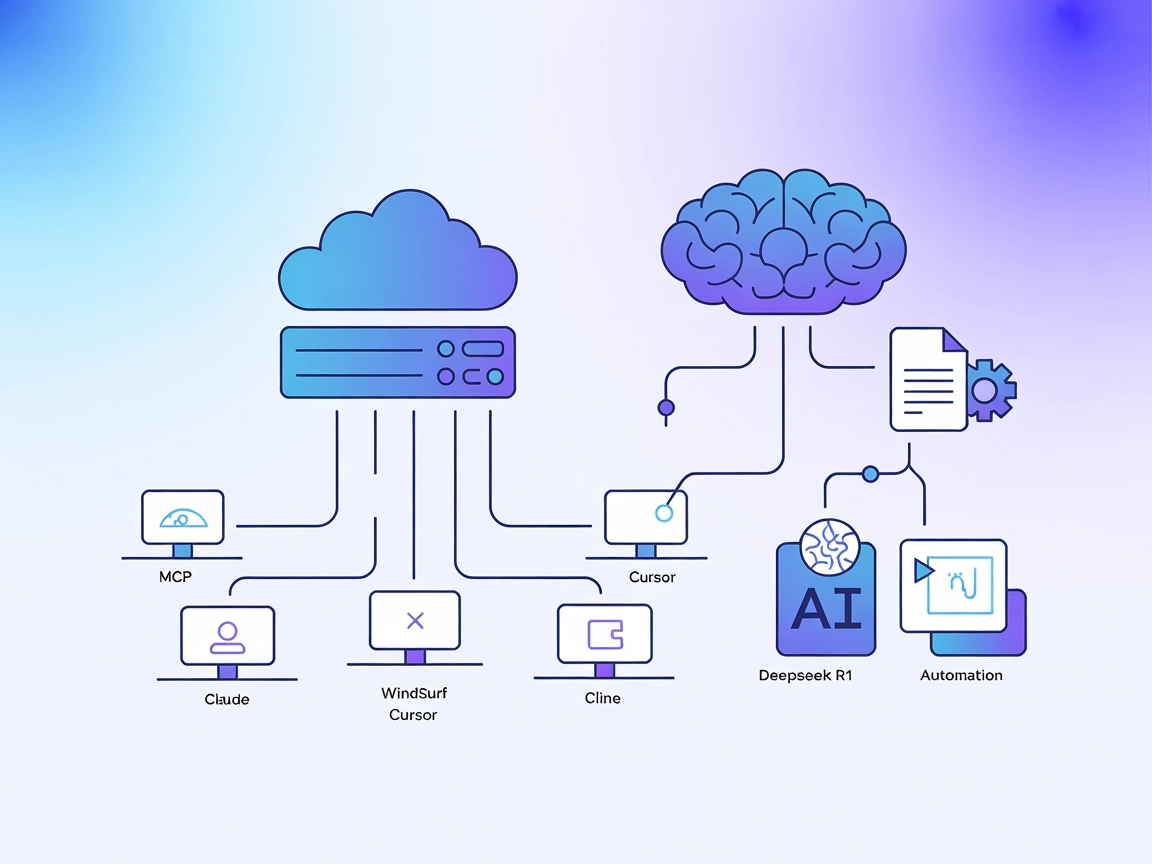

FlowHunt fornisce un livello di sicurezza aggiuntivo tra i tuoi sistemi interni e gli strumenti AI, dandoti controllo granulare su quali strumenti sono accessibili dai tuoi server MCP. I server MCP ospitati nella nostra infrastruttura possono essere integrati perfettamente con il chatbot di FlowHunt così come con le piattaforme AI popolari come ChatGPT, Claude e vari editor AI.

Il Deepseek R1 MCP Server è una implementazione di Model Context Protocol (MCP) progettata per connettere Claude Desktop con i modelli linguistici avanzati di DeepSeek, come Deepseek R1 e DeepSeek V3. Agendo da ponte tra assistenti AI e i potenti modelli ottimizzati per il ragionamento di DeepSeek (dotati di una finestra di contesto di 8192 token), questo server permette agli agenti AI di svolgere compiti avanzati di comprensione e generazione del linguaggio naturale. Gli sviluppatori possono integrare facilmente questi modelli nei propri flussi di lavoro tramite il Deepseek R1 MCP Server, facilitando generazione testuale avanzata, ragionamento e interazione con fonti di dati esterne o API su piattaforme supportate. L’implementazione è focalizzata su un’integrazione stabile, affidabile ed efficiente utilizzando Node.js/TypeScript per la massima compatibilità e sicurezza tipizzata.

Nessun template prompt è documentato nel repository.

Nessuna risorsa MCP esplicita è documentata nel repository.

git clone https://github.com/66julienmartin/MCP-server-Deepseek_R1.git

cd deepseek-r1-mcp

npm install

.env.exemple in .env e inserisci la tua chiave API DeepSeek.{

"mcpServers": {

"deepseek_r1": {

"command": "node",

"args": ["/path/to/deepseek-r1-mcp/build/index.js"],

"env": {

"DEEPSEEK_API_KEY": "your-api-key"

}

}

}

}

{

"mcpServers": {

"deepseek_r1": {

"command": "node",

"args": ["/path/to/deepseek-r1-mcp/build/index.js"],

"env": {

"DEEPSEEK_API_KEY": "your-api-key"

}

}

}

}

{

"mcpServers": {

"deepseek_r1": {

"command": "node",

"args": ["/path/to/deepseek-r1-mcp/build/index.js"],

"env": {

"DEEPSEEK_API_KEY": "your-api-key"

}

}

}

}

{

"mcpServers": {

"deepseek_r1": {

"command": "node",

"args": ["/path/to/deepseek-r1-mcp/build/index.js"],

"env": {

"DEEPSEEK_API_KEY": "your-api-key"

}

}

}

}

Utilizza variabili d’ambiente nella configurazione per mantenere sicure le chiavi API:

{

"mcpServers": {

"deepseek_r1": {

"command": "node",

"args": ["/path/to/deepseek-r1-mcp/build/index.js"],

"env": {

"DEEPSEEK_API_KEY": "your-api-key"

}

}

}

}

Utilizzo di MCP in FlowHunt

Per integrare server MCP nel tuo workflow FlowHunt, inizia aggiungendo il componente MCP al tuo flusso e collegandolo al tuo agente AI:

Clicca sul componente MCP per aprire il pannello di configurazione. Nella sezione di configurazione MCP di sistema, inserisci i dettagli del tuo server MCP usando questo formato JSON:

{

"deepseek_r1": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

Una volta configurato, l’agente AI potrà utilizzare questo MCP come strumento con accesso a tutte le sue funzioni e capacità. Ricorda di cambiare “deepseek_r1” con il nome effettivo del tuo server MCP e di sostituire l’URL con quello del tuo MCP server.

| Sezione | Disponibilità | Dettagli/Note |

|---|---|---|

| Panoramica | ✅ | |

| Elenco dei Prompt | ⛔ | Nessun template prompt documentato |

| Elenco delle Risorse | ⛔ | Nessuna risorsa MCP esplicita documentata |

| Elenco degli Strumenti | ✅ | Strumento avanzato di generazione testo |

| Sicurezza delle Chiavi API | ✅ | Usare variabili d’ambiente in config |

| Supporto Sampling (meno rilevante in valutazione) | ⛔ | Non documentato |

| Supporto Roots | ⛔ | Non documentato |

In base alla documentazione disponibile, il Deepseek R1 MCP Server offre un’implementazione pulita e mirata, facile da configurare e utilizzare, ma priva di documentazione su prompt, risorse o funzionalità MCP avanzate come roots e sampling. Ciò lo rende molto pratico per la generazione di testo, ma meno ricco di funzioni per flussi di lavoro complessi.

| Ha una LICENSE | ✅ (MIT) |

|---|---|

| Almeno uno strumento | ✅ |

| Numero di Fork | 12 |

| Numero di Stelle | 58 |

È un server Model Context Protocol (MCP) che funge da ponte tra Claude Desktop (o altre piattaforme) e i modelli linguistici avanzati di DeepSeek (R1, V3), abilitando generazione di testo avanzata, ragionamento e automazione nei tuoi flussi AI.

Il server supporta Deepseek R1 e DeepSeek V3—entrambi ottimizzati per grandi finestre di contesto e compiti di ragionamento complessi.

I casi d’uso includono generazione avanzata di testo (long-form, tecnico o creativo), ragionamento logico, potenziamento dell’assistente AI in Claude Desktop e automazione della creazione di contenuti o gestione della conoscenza tramite API.

Utilizza sempre variabili d'ambiente nella configurazione del server MCP per evitare l'esposizione accidentale della chiave API DeepSeek.

Nessun template prompt o risorsa MCP esplicita è documentata nel repository; il server è focalizzato sull’accesso diretto al modello e sull’integrazione.

DeepSeek R1 offre una finestra di contesto di 8192 token, permettendo la gestione di compiti lunghi e complessi.

Sì, è distribuito con licenza MIT ed è disponibile su GitHub.

Sblocca generazione di testo avanzata e ragionamento collegando FlowHunt o Claude Desktop ai potenti modelli di DeepSeek R1. Inizia oggi a costruire flussi di lavoro più intelligenti.

Il DeepSeek MCP Server integra i modelli linguistici avanzati di DeepSeek con applicazioni compatibili MCP, fornendo accesso API sicuro e anonimizzato e abilita...

Il DeepSeek MCP Server funge da proxy sicuro, collegando i modelli linguistici avanzati di DeepSeek ad applicazioni compatibili MCP come Claude Desktop o FlowHu...

Deepseek Thinker MCP Server integra il ragionamento del modello Deepseek nei client AI abilitati MCP come Claude Desktop, fornendo output avanzati di chain-of-t...

Consenso Cookie

Usiamo i cookie per migliorare la tua esperienza di navigazione e analizzare il nostro traffico. See our privacy policy.