Integrazione del Server ModelContextProtocol (MCP)

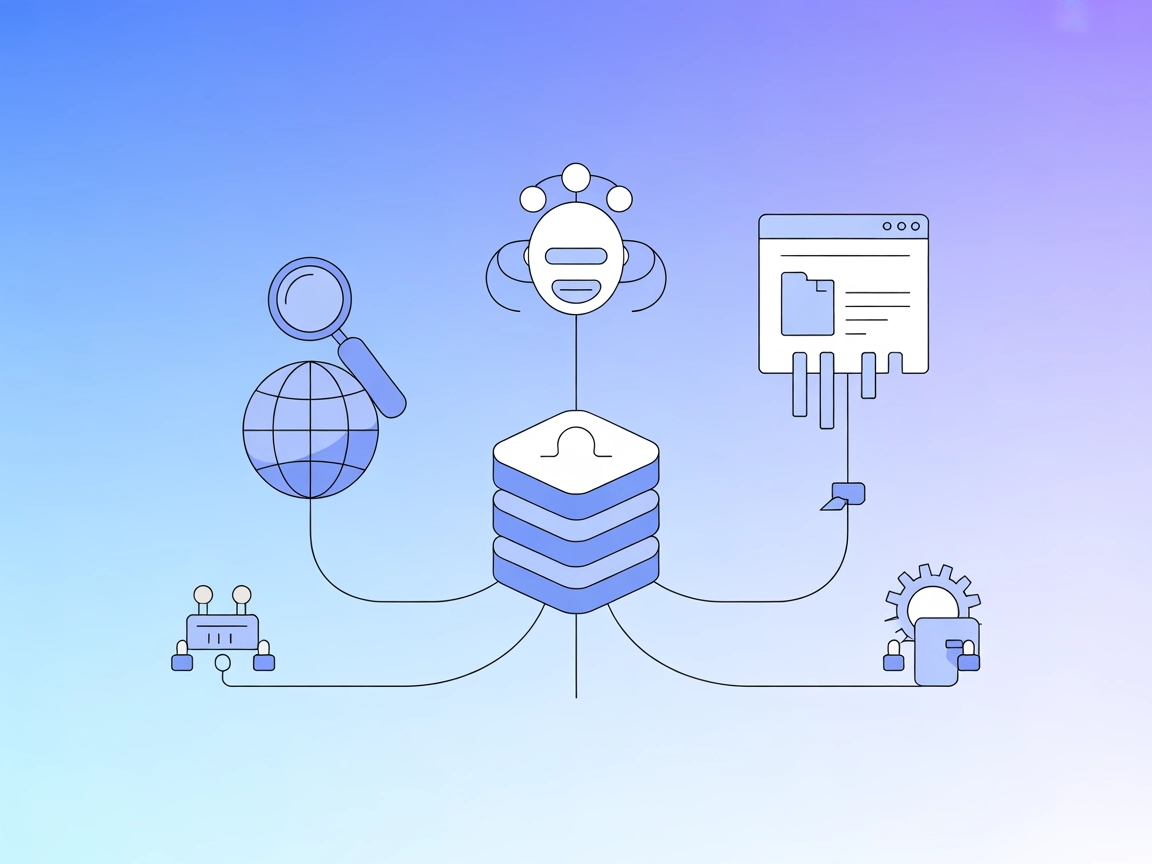

Il Server ModelContextProtocol (MCP) funge da ponte tra agenti AI e fonti dati esterne, API e servizi, consentendo agli utenti FlowHunt di costruire assistenti ...

Integra gestione documentale, ricerca semantica e recupero di conoscenza in tempo reale nei tuoi workflow AI utilizzando il Needle MCP Server per FlowHunt.

FlowHunt fornisce un livello di sicurezza aggiuntivo tra i tuoi sistemi interni e gli strumenti AI, dandoti controllo granulare su quali strumenti sono accessibili dai tuoi server MCP. I server MCP ospitati nella nostra infrastruttura possono essere integrati perfettamente con il chatbot di FlowHunt così come con le piattaforme AI popolari come ChatGPT, Claude e vari editor AI.

Il Needle MCP (Model Context Protocol) Server integra le capacità di gestione documentale e ricerca di Needle nell’ecosistema MCP. Agisce come ponte tra assistenti AI e fonti dati esterne, consentendo connessioni senza soluzione di continuità a repository documentali e migliorando i flussi di sviluppo. Con il Needle MCP Server, i client AI possono svolgere attività come acquisizione documenti, ricerca semantica e recupero, permettendo ai modelli linguistici di interagire direttamente con knowledge base o file system. Esporre queste funzioni tramite lo standard MCP consente agli sviluppatori di automatizzare il recupero delle informazioni, standardizzare i flussi di prompt e arricchire le attività guidate dall’AI con accesso in tempo reale a documentazione e contenuti aggiornati.

Non vengono menzionati template di prompt espliciti nella documentazione disponibile o nel README. Questa sezione è vuota per mancanza di informazioni.

Nessuna risorsa MCP esplicita è elencata o descritta nella documentazione disponibile o nei file del repository. Questa sezione è vuota per mancanza di informazioni.

Nessun elenco esplicito di strumenti (come quelli definiti in un server.py o equivalente) è fornito nei file disponibili del repository. Questa sezione è vuota per mancanza di informazioni.

mcpServers. Esempio:{

"mcpServers": {

"needle-mcp": {

"command": "npx",

"args": ["@needle/mcp-server@latest"]

}

}

}

Sicurezza delle API Key:

{

"mcpServers": {

"needle-mcp": {

"command": "npx",

"args": ["@needle/mcp-server@latest"],

"env": {

"NEEDLE_API_KEY": "${{ secrets.NEEDLE_API_KEY }}"

},

"inputs": {

"apiKey": "${{ secrets.NEEDLE_API_KEY }}"

}

}

}

}

mcpServers:{

"mcpServers": {

"needle-mcp": {

"command": "npx",

"args": ["@needle/mcp-server@latest"]

}

}

}

{

"mcpServers": {

"needle-mcp": {

"command": "npx",

"args": ["@needle/mcp-server@latest"]

}

}

}

{

"mcpServers": {

"needle-mcp": {

"command": "npx",

"args": ["@needle/mcp-server@latest"]

}

}

}

Nota: Proteggi sempre le API key utilizzando variabili d’ambiente come mostrato sopra per mantenere sicure le credenziali.

Utilizzo di MCP in FlowHunt

Per integrare i server MCP nel tuo workflow FlowHunt, inizia aggiungendo il componente MCP al tuo flusso e collegalo al tuo agente AI:

Clicca sul componente MCP per aprire il pannello di configurazione. Nella sezione di configurazione MCP di sistema, inserisci i dettagli del tuo server MCP utilizzando questo formato JSON:

{

"needle-mcp": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

Una volta configurato, l’agente AI sarà ora in grado di utilizzare questo MCP come strumento con accesso a tutte le sue funzioni e capacità. Ricorda di sostituire “needle-mcp” con il nome reale del tuo server MCP e di aggiornare la URL con quella del tuo server MCP.

| Sezione | Disponibilità | Dettagli/Note |

|---|---|---|

| Panoramica | ✅ | Basato su README e descrizione repository |

| Elenco dei Prompt | ⛔ | Nessun template di prompt trovato |

| Elenco delle Risorse | ⛔ | Nessuna risorsa MCP esplicita elencata |

| Elenco degli Strumenti | ⛔ | Nessun elenco strumenti trovato nei file disponibili |

| Sicurezza delle API Key | ✅ | Esempio fornito nelle istruzioni di setup |

| Supporto Sampling (meno importante in valutazione) | ⛔ | Non menzionato |

Il repository Needle MCP fornisce una panoramica chiara e istruzioni di configurazione, ma manca di dettagli su prompt, risorse e definizioni di strumenti nei file pubblici. Questo ne limita l’utilizzabilità immediata per deployment MCP avanzati o altamente personalizzati. Tuttavia, le istruzioni di integrazione e la chiara articolazione dei casi d’uso lo rendono una scelta ragionevole per esigenze di base di gestione documentale e ricerca.

| Ha una LICENSE | ✅ (MIT) |

|---|---|

| Ha almeno uno strumento | ⛔ |

| Numero di Fork | 17 |

| Numero di Stelle | 53 |

Valutazione: 4/10

Sebbene il Needle MCP Server sia sotto licenza e abbia una presenza comunitaria moderata, la mancanza di definizioni esplicite di strumenti, prompt e risorse nel repository ne limita profondità e usabilità immediata per scenari MCP rispetto a server più documentati.

Il Needle MCP Server integra la gestione documentale e la ricerca semantica nell'ecosistema MCP, consentendo agli assistenti AI di acquisire, cercare e recuperare documenti direttamente dalle fonti dati collegate.

I casi d'uso tipici includono la gestione documentale per agenti AI, integrazione della ricerca semantica, arricchimento della knowledge base e interrogazione automatizzata di documentazione tecnica o wiki.

Devi aggiungere il Needle MCP server alla configurazione del tuo client MCP, proteggere le API key utilizzando variabili d'ambiente e riavviare la piattaforma client. Le istruzioni dettagliate sono fornite per Windsurf, Claude, Cursor e Cline.

Sì. Aggiungi il componente MCP al tuo flusso FlowHunt, configura il Needle MCP server nelle impostazioni MCP di sistema e collegalo al tuo agente AI per funzionalità avanzate di gestione documentale e ricerca.

Non sono forniti esplicitamente template di prompt o definizioni di strumenti/risorse nei file pubblici del repository. La funzionalità è esposta tramite il protocollo MCP per l'interazione guidata dall'agente.

Potenzia i tuoi agenti AI con accesso in tempo reale a documenti e ricerca semantica tramite il Needle MCP Server.

Il Server ModelContextProtocol (MCP) funge da ponte tra agenti AI e fonti dati esterne, API e servizi, consentendo agli utenti FlowHunt di costruire assistenti ...

Il server MCP mcp-google-search collega assistenti AI e web, consentendo ricerca in tempo reale ed estrazione di contenuti tramite Google Custom Search API. Per...

Il connettore Replicate MCP Server di FlowHunt consente un accesso senza soluzione di continuità all'ampio hub di modelli AI di Replicate, permettendo agli svil...

Consenso Cookie

Usiamo i cookie per migliorare la tua esperienza di navigazione e analizzare il nostro traffico. See our privacy policy.