파이어프루프 MCP 서버

파이어프루프 MCP 서버는 AI 어시스턴트와 파이어프루프 데이터베이스를 연결하여 JSON 문서의 저장, 조회, 관리를 LLM 툴을 통해 원활하게 할 수 있도록 합니다. CRUD 작업을 간소화하고, 유연한 쿼리를 지원하며, 데이터 기반 AI 워크플로우의 프로토타입 제작을 가속화합니다....

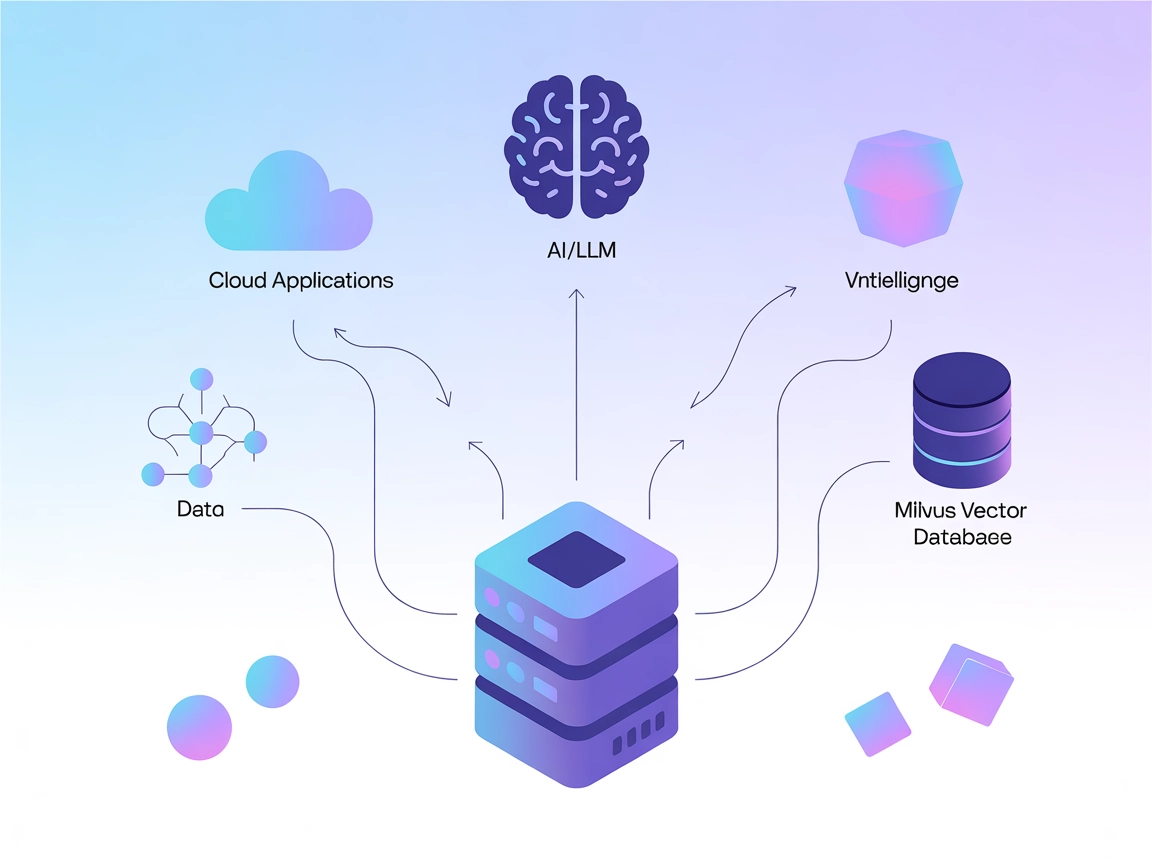

LLM과 AI 에이전트를 Milvus에 연결하여 FlowHunt 워크플로우에서 강력한 벡터 검색, 맥락 기억, 데이터 기반 추천을 바로 활용하세요.

Milvus MCP(Model Context Protocol) 서버는 AI 어시스턴트와 LLM 기반 애플리케이션을 Milvus 벡터 데이터베이스와 연결합니다. 이를 통해 언어 모델과 대규모 벡터 데이터 간의 원활한 상호작용이 가능해지며, AI 워크플로우 내에서 Milvus를 표준화된 방식으로 접근, 쿼리, 관리할 수 있습니다. Milvus MCP 서버를 사용하면 개발자는 Milvus 기반의 검색, 검색 결과 추출, 데이터 관리 기능을 AI 에이전트, IDE, 챗 인터페이스에 바로 통합할 수 있습니다. 서버는 다양한 통신 모드(stdio 및 Server-Sent Events)를 지원하여, 다양한 배포 시나리오와 개발 환경에 유연하게 적용됩니다. LLM과 Milvus를 연결함으로써 AI 시스템이 고차원 데이터에 대해 맥락 인지적 작업을 수행할 수 있어, 보다 풍부하고 지능적인 LLM 기반 경험을 실현할 수 있습니다.

저장소에 프롬프트 템플릿에 대한 정보가 제공되지 않습니다.

공식 문서나 코드에서 Model Context Protocol “리소스”에 대한 명시적 목록이 설명되어 있지 않습니다.

server.py를 포함한 문서나 코드 파일에서 명시적인 도구 목록이나 함수명이 문서화되어 있지 않습니다.

git clone https://github.com/zilliztech/mcp-server-milvus.gituv run src/mcp_server_milvus/server.py --milvus-uri http://localhost:19530{

"mcpServers": {

"milvus-mcp": {

"command": "uv",

"args": ["run", "src/mcp_server_milvus/server.py", "--milvus-uri", "http://localhost:19530"]

}

}

}

API 키 보안:

서버에 민감한 정보가 필요한 경우 환경 변수를 사용하세요:

{

"env": {

"MILVUS_URI": "http://localhost:19530"

},

"inputs": {}

}

{

"mcpServers": {

"milvus-mcp": {

"command": "uv",

"args": ["run", "src/mcp_server_milvus/server.py", "--milvus-uri", "http://localhost:19530"]

}

}

}

자격 증명 보안은 위와 같이 환경 변수로 관리하세요.

uv를 설치하세요.uv run src/mcp_server_milvus/server.py --milvus-uri http://localhost:19530{

"mcpServers": {

"milvus-mcp": {

"command": "uv",

"args": ["run", "src/mcp_server_milvus/server.py", "--milvus-uri", "http://localhost:19530"]

}

}

}

API 키 보안:

위 예시처럼 환경 변수를 사용하세요.

uv 설치.{

"mcpServers": {

"milvus-mcp": {

"command": "uv",

"args": ["run", "src/mcp_server_milvus/server.py", "--milvus-uri", "http://localhost:19530"]

}

}

}

환경 변수 사용:

{

"env": {

"MILVUS_URI": "http://localhost:19530"

}

}

FlowHunt에서 MCP 사용하기

FlowHunt 워크플로우에 MCP 서버를 통합하려면, 플로우에 MCP 컴포넌트를 추가하고 AI 에이전트와 연결하세요:

MCP 컴포넌트를 클릭하여 설정 패널을 엽니다. 시스템 MCP 설정 섹션에서 아래 JSON 형식으로 MCP 서버 정보를 입력하세요:

{

"milvus-mcp": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

설정이 완료되면 AI 에이전트가 MCP의 모든 기능과 역량을 도구로서 활용할 수 있습니다. “milvus-mcp"는 실제 사용하는 MCP 서버 명칭으로, URL은 본인의 MCP 서버 주소로 변경하세요.

| 섹션 | 제공 여부 | 세부 내용/비고 |

|---|---|---|

| 개요 | ✅ | |

| 프롬프트 목록 | ⛔ | 프롬프트 템플릿 문서 없음 |

| 리소스 목록 | ⛔ | 명시적 MCP 리소스 목록 없음 |

| 도구 목록 | ⛔ | 코드상에서 명시적 도구 없음 |

| API 키 보안 | ✅ | 환경 변수 사용, 설치 예제에 문서화 |

| 샘플링 지원(평가에 영향 적음) | ⛔ | 언급 없음 |

Roots 지원: 언급 없음

샘플링 지원: 언급 없음

Milvus MCP 서버는 LLM과 Milvus를 연결하는 실용적이고 집중된 브릿지로, 인기 개발 도구에 대한 설치 가이드가 명확합니다. 다만, MCP 리소스·프롬프트·활용 가능한 도구 API에 대한 문서가 부족해 즉시 활용성은 다소 제한적입니다. 그럼에도 벡터 기반 AI 통합의 탄탄한 기초를 제공합니다.

| 라이선스 보유 | ✅ (Apache-2.0) |

|---|---|

| 도구 최소 1개 | ⛔ |

| 포크 수 | 32 |

| 스타 수 | 139 |

총점: 4/10

특정 용도에는 유용하지만, 리소스·프롬프트·도구 API에 대한 명시적 문서가 보강된다면 상호운용성과 사용 편의성이 크게 향상될 것입니다.

Milvus MCP 서버는 AI 어시스턴트와 LLM 애플리케이션을 Milvus 벡터 데이터베이스와 연결하여, 고급 AI 워크플로우를 위한 벡터 검색, 맥락 기억, 데이터 관리를 손쉽게 지원합니다.

주요 활용 사례로는 벡터 검색, 임베딩 관리, 챗봇 맥락 기억, AI 기반 추천, FlowHunt 내 실시간 데이터 분석 등이 있습니다.

각 클라이언트별 설치 안내서에 나온 것처럼, 민감한 연결 정보를 환경 변수(예: MILVUS_URI)로 관리하세요.

명시적인 프롬프트 템플릿이나 도구 API는 문서화되어 있지 않습니다. 이 서버는 벡터 연산 및 임베딩 관리를 위한 브릿지 역할에 집중합니다.

LLM과 벡터 데이터베이스 연결의 탄탄한 기반을 제공하고, 설정 안내가 명확하지만, 프롬프트 및 도구 API에 대한 문서가 더 보강된다면 더 쉽게 활용하고 통합할 수 있을 것입니다.

파이어프루프 MCP 서버는 AI 어시스턴트와 파이어프루프 데이터베이스를 연결하여 JSON 문서의 저장, 조회, 관리를 LLM 툴을 통해 원활하게 할 수 있도록 합니다. CRUD 작업을 간소화하고, 유연한 쿼리를 지원하며, 데이터 기반 AI 워크플로우의 프로토타입 제작을 가속화합니다....

Lightdash MCP 서버는 AI 어시스턴트와 Lightdash(최신 비즈니스 인텔리전스 플랫폼)를 연결하여 AI가 분석 프로젝트, 공간, 차트에 프로그램 방식으로 접근할 수 있게 하여 자동화와 지능형 워크플로우를 지원합니다....

any-chat-completions-mcp MCP 서버는 FlowHunt 및 기타 도구를 OpenAI SDK 호환 Chat Completion API와 연결합니다. OpenAI, Perplexity, Groq, xAI, PyroPrompts 등 다양한 LLM 제공업체를 단일하고 간단한...

쿠키 동의

당사는 귀하의 브라우징 경험을 향상시키고 트래픽을 분석하기 위해 쿠키를 사용합니다. See our privacy policy.